إطلاق GLM-5، الذي كشفت عنه هذا الأسبوع شركة Zhipu AI الصينية (التي تحمل علنًا علامة Z.AI / zai-org في العديد من قنوات المطوّرين)، يمثل خطوة أخرى في وتيرة إصدارات النماذج الكبيرة المتسارعة. يُقدَّم النموذج الجديد على أنه الرائد لدى Zhipu: أكبر من حيث الحجم، ومضبوط لمهام وكيليّة بعيدة المدى، ومبني بخيارات هندسية تهدف إلى خفض كلفة الاستدلال مع الحفاظ على سياق طويل. تشير تقارير مبكرة من الصناعة وملاحظات مطوّرين من التجربة العملية إلى مكاسب ملموسة في الترميز، والاستدلال متعدد الخطوات، وتنظيم الوكلاء مقارنة بإصدارات GLM السابقة — وفي بعض الاختبارات يتحدّى حتى Claude 4.5.

ما هو GLM-5 ومن بناه؟

GLM-5 هو أحدث إصدار رئيسي في عائلة GLM: نموذج أساس كبير مفتوح المصدر طوّرته ونشرته Z.ai (الفريق وراء سلسلة GLM). أُعلن عنه في أوائل فبراير 2026، ويُقدَّم GLM-5 كنموذج من الجيل التالي مضبوط تحديدًا لمهام «وكيليّة» — أي سير عمل متعددة الخطوات وبعيدة المدى حيث يجب على النموذج التخطيط، واستدعاء الأدوات، والتنفيذ، والحفاظ على السياق في محادثات مطوّلة أو لوكلاء مؤتمتين. اللافت في الإصدار ليس تصميم النموذج فحسب بل أيضًا طريقة ومكان تدريبه: استخدمت Z.ai مزيجًا من عتاد وأدوات محلية صينية كجزء من توجه نحو الاكتفاء الذاتي.

تشمل الأرقام المعلَنة حول البنية والتدريب ما يلي:

- تحجيم المعاملات: يتوسع GLM-5 إلى نحو 744B parameters (مع عدد «خبراء نشطين» أصغر مذكور في بعض الملاحظات التقنية، مثل 40B active)، مقارنة بأحجام عائلة GLM-4 السابقة حوالي 355B/32B active.

- بيانات ما قبل التدريب: ازداد حجم متن التدريب من نحو ~23 trillion tokens (جيل GLM-4) إلى ~28.5 trillion tokens في GLM-5.

- Sparse attention / DeepSeek Sparse Attention (DSA): مخطط انتباه متناثر للحفاظ على السياق الطويل مع تقليل كلفة الحوسبة أثناء الاستدلال.

- تركيز التصميم: اختيارات هندسية تركز على تنظيم الوكلاء، والاستدلال طويل السياق، والاستدلال بتكلفة فعّالة.

الأصول والتموضع

يبني GLM-5 على خط شمل GLM-4.5 (أطلق في منتصف 2025) وبعض التحديثات التكرارية مثل 4.7. تضع Z.ai GLM-5 كقفزة من «vibe coding» (مخرجات ترميز سريعة أحادية الخطوة) نحو «الهندسة الوكيليّة»: استدلال مستدام، وتنظيم متعدد الأدوات، وتركيب نظمي فوق نوافذ سياق طويلة. تؤكد المواد العامة أن GLM-5 صُمم للتعامل مع مهام هندسة أنظمة معقدة — بناء سلوكيات وكلاء متعددة الخطوات وتنسيقها والحفاظ عليها بدلًا من مجرد الإجابة على استفسارات معزولة.

ما الميزات الجديدة في GLM-5؟

تغييرات معمارية كبرى

- تحجيم متناثر ضخم (MoE): ينتقل GLM-5 إلى بنية مزيج خبراء متناثرة أكبر بكثير. تُدرج مصادر عامة من صفحات المطوّرين وكتابات مستقلة النموذج بنحو 744B إجمالي معاملات مع ~40B نشطة لكل رمز — وهي قفزة مهمة من ضبط GLM-4.5 بنحو ~355B / 32B نشطة. يمكّن هذا التحجيم المتناثر من تقديم سعة كلية كبيرة جدًا مع إبقاء الحوسبة لكل رمز قابلة للتحمل.

- DeepSeek Sparse Attention (DSA): للحفاظ على قدرات السياق الطويل دون تحجيم خطي في كلفة الاستدلال، يدمج GLM-5 آلية انتباه متناثر (بعلامة DeepSeek) للاحتفاظ بالاعتمادات بعيدة المدى المهمة مع تقليم كلفة الانتباه عبر سياقات فائقة الطول.

الهندسة الوكيليّة كهدف تصميمي أساسي

إحدى أبرز ميزات GLM-5 أنه مصمم صراحةً للهندسة الوكيليّة — أي أن النموذج يُراد استخدامه ليس للدردشة الأحادية أو مهام التلخيص فحسب، بل كـ«عقل» لوكلاء متعدد الخطوات يمكنهم التخطيط، وإصدار استدعاءات أدوات، وإدارة الحالة، والاستدلال عبر سياقات طويلة. تضع Z.ai GLM-5 في خدمة حلقات orchestration: تفكيك المشكلات المعقدة، واستدعاء الأدوات/واجهات البرمجة الخارجية، وتتبع المهام الطويلة عبر العديد من الأدوار.

لماذا يهم التصميم الوكيلي

تعد سير العمل الوكيليّة مركزية للأتمتة الواقعية: مساعدين بحث مؤتمتين، مهندسين برمجيات ذاتيين، تنسيق العمليات، والتحكم في المحاكاة. يحتاج نموذج مبني لهذا العالم إلى تخطيط قوي، وسلوك مستقر في استدعاء الأدوات، ومتانة عبر آلاف الرموز من السياق.

تحسينات في البرمجة والاستدلال والسلوك «بعيد المدى»

يؤكد GLM-5 على تحسينات في توليد الشيفرة والاستدلال. تدّعي Z.ai تحسينات مستهدفة في قدرة النموذج على كتابة الشيفرة وإعادة هيكلتها وتنقيحها، إضافة إلى استدلال متعدد الخطوات أكثر اتساقًا عبر تفاعلات طويلة. وجدت تقارير وصول مبكر وتقييمات شركاء أن النموذج أقوى بشكل ملحوظ في المهام الموجهة للمطورين مقارنة بأجيال GLM السابقة.

مزايا عملية للمطورين

- نوافذ سياق أكبر لاحتواء التوثيق، وقواعد الشيفرة، وحالة المحادثة.

- مكوّنات أساسية لاستدعاء الأدوات بأمان والتعامل مع النتائج.

- أداء أفضل في قليل الأمثلة (few-shot) وسلسلة التفكير لتفكيك المهام المعقدة وتنفيذها.

- ميزات وكيليّة واستدعاء الأدوات: يؤكد GLM-5 دعمًا أصليًا للوكلاء: استدعاء الدوال/الأدوات، جلسات ذات حالة، وإدارة أفضل للحوارات الطويلة وتسلسلات استخدام الأدوات. هذا يجعل بناء وكلاء يدمجون البحث على الويب أو قواعد البيانات أو أتمتة المهام أسهل.

كيف يؤدي GLM-5 على المقاييس القياسية؟

أبرز النتائج على مقاييس محددة

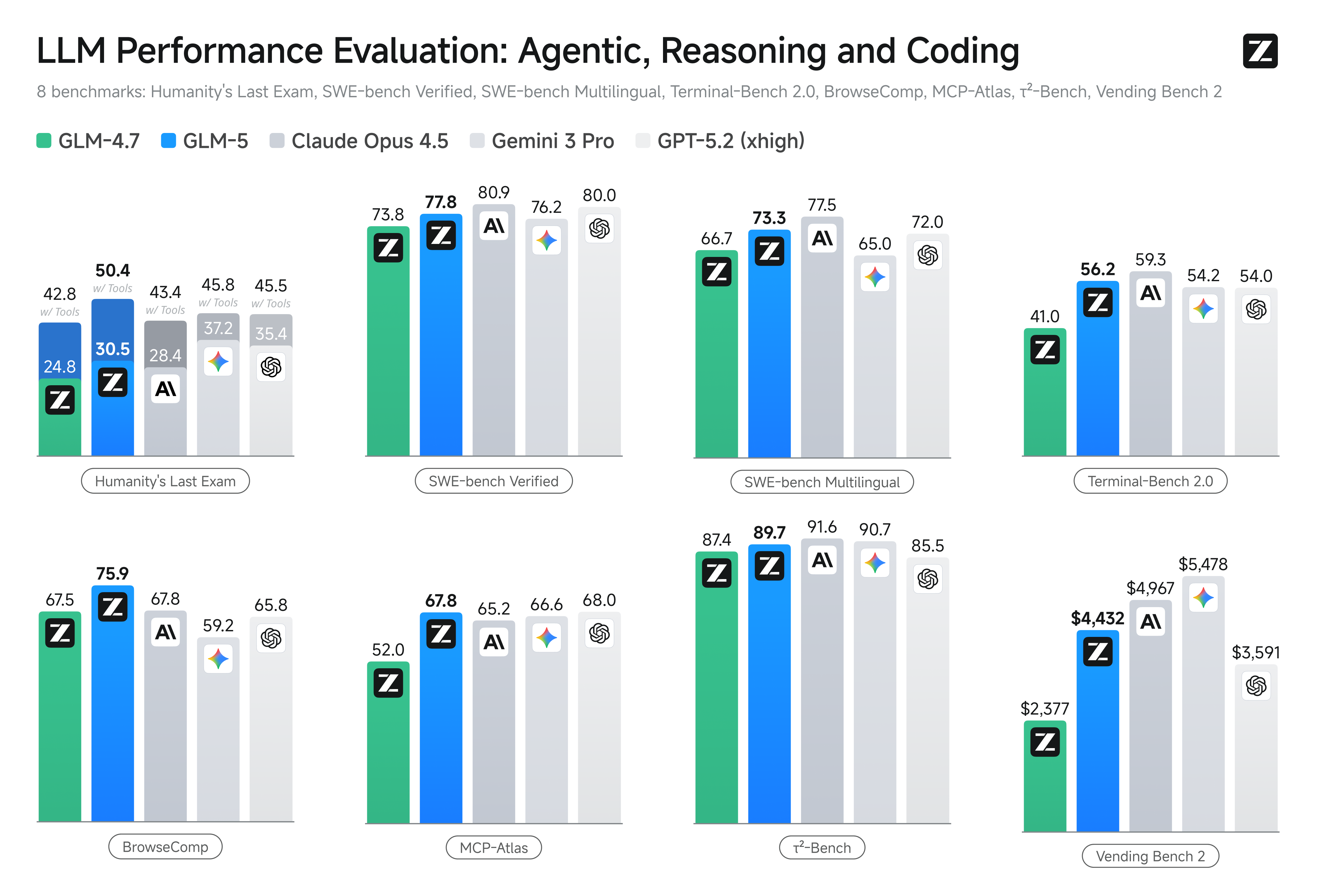

- مقاييس الترميز: يقترب GLM-5 (وفي بعض الحالات يطابق) أداء نماذج مملوكة ومحسّنة للغاية مثل Claude Opus 4.5 من Anthropic في مهام ترميز محددة. تختلف هذه النتائج بحسب المهمة (اختبارات وحدات، ترميز خوارزمي، استخدام API)، لكنها تمثل تحسنًا واضحًا على GLM-4.5.

- اختبارات الاستدلال والوكيلية: على أجنحة تقييم الاستدلال متعدد الخطوات والمهام الوكيليّة (مثل التخطيط متعدد الأدوار، ومقاييس تفكيك المهام)، حقق GLM-5 نتائج رائدة بين النماذج مفتوحة المصدر، وتفوّق في بعض المقاييس على نماذج مغلقة منافسة في مهام مستهدفة.

كيف أصل إلى GLM-5 وأجرّبه؟

GLM-5 هو الجيل الخامس من نماذج اللغة الكبيرة من Zhipu AI (Z.ai)، مبني على بنية مزيج خبراء (Mixture-of-Experts) (~745 B إجمالي، ~44 B نشطة) ويستهدف استدلالًا قويًا، وترميزًا، وسير عمل وكيلي. أُطلق رسميًا حوالي 12 Feb 2026.

حتى الآن هناك طريقتان رئيسيتان للوصول إليه:

A) الوصول الرسمي عبر API (Z.ai أو المجمِّعات)

تقدّم Zhipu AI واجهات API لنماذجها، ويمكنك استدعاء GLM-5 عبر تلك الواجهات.

الخطوات المعتادة:

- أنشئ حساب Z.ai/Open BigModel API.

- احصل على مفتاح API من لوحة التحكم.

- استخدم نقطة نهاية OpenAPI أو REST مع اسم النموذج (مثل

glm-5).

(مشابه لطريقة استدعاء نماذج GPT من OpenAI). - اضبط المطالبات وأرسل طلبات HTTP.

👉 تعرض صفحة تسعير Z.ai أسعار رموز GLM-5 الرسمية مثل:

- ~$1.0 لكل مليون رموز إدخال

- ~$3.2 لكل مليون رموز إخراج

B) أغلفة API من أطراف ثالثة —— CometAPI

واجهات مثل CometAPI أو WaveSpeed تغلّف عدة نماذج ذكاء (OpenAI، Claude، Z.ai وغيرها) خلف واجهة موحّدة.

- مع خدمات مثل CometAPI يمكنك استدعاء نماذج GLM بتبديل معرّف النموذج.

(يدعم CometAPI حاليًا GLM-5/GLM-4.7.) - تسعير glm-5 لدى CometAPI هو 20% من السعر الرسمي.

| Usage Type | Price |

|---|---|

| Input tokens | ~$0.8 per 1M tokens |

| Output tokens | ~$2.56 per 1M tokens |

لماذا يهم هذا: تحتفظ بشيفرة عميلك المتوافقة مع OpenAI وتغيّر فقط عنوان الأساس/معرّف النموذج.

C) الاستضافة الذاتية عبر Hugging Face / Weights

توجد مستودعات أوزان غير رسمية لـ GLM-5 (مثل نسخ باسم glm-5/glm-5-fp8) ظاهرة في قوائم نماذج Hugging Face.

باستخدامها يمكنك:

- تنزيل أوزان النموذج.

- استخدام أدوات مثل vLLM، SGLang، xLLM، أو Transformers للخدمة محليًا أو على أسطول وحدات GPU السحابي لديك.

الإيجابيات: تحكم أقصى، ولا كلفة API جارية.

السلبيات: متطلبات حوسبة ضخمة — على الأرجح عدة وحدات GPU عالية المستوى وذاكرة (عدة مئات من GB)، ما يجعلها غير عملية على الأنظمة الصغيرة.

إذن — هل يستحق GLM-5 ذلك، وهل ينبغي الاحتفاظ بـ GLM-4.7؟

الإجابة المختصرة (ملخص تنفيذي)

- إذا كان عملك يحتاج إلى سلوك وكيلي قوي متعدد الخطوات، وتوليد شيفرة بمستوى إنتاجي، أو أتمتة على مستوى الأنظمة: يستحق GLM-5 التقييم فورًا. تعطي بنيته وحجمه وضبطه الأولوية لهذه النتائج تحديدًا.

- إذا احتجت إلى خدمات دقيقة التكلفة وعالية الإنتاجية (دردشة قصيرة، تصنيف، مطالبات خفيفة): يظل GLM-4.7 الخيار الأكثر اقتصادية على الأرجح. يحتفظ GLM-4.7 بمجموعة قدرات قوية بكلفة أقل لكل رمز في كثير من قوائم المزوّدين وهو مُجرّب ميدانيًا.

الإجابة الأطول (توصية عملية)

اعتمد استراتيجية نماذج متعددة المستويات: استخدم GLM-4.7 للتفاعلات اليومية عالية الحجم، وخصص GLM-5 للمشكلات الهندسية عالية القيمة وتنظيم الوكلاء. نفّذ مشروعًا تجريبيًا صغيرًا على GLM-5 يمارس السياق الطويل، وتكامل الأدوات، وصحة الشيفرة؛ وقِس الوقت الهندسي المُوفَّر والكلفة الإضافية للنموذج. مع الوقت ستعرف ما إذا كان تحسّن القدرات في GLM-5 يبرر التوسّع في الاعتماد عليه.

مع CometAPI يمكنك التبديل بين GLM-4.7 وGLM-5 في أي وقت.

حالات استخدام واقعية يتألق فيها GLM-5

1. تنسيق وكلاء معقد

يركّز GLM-5 تصميميًا على التخطيط متعدد الخطوات واستدعاء الأدوات، ما يجعله مناسبًا للأنظمة التي يجب أن تنسّق البحث، واستدعاءات API، وتنفيذ البرامج (مثل: مساعدين بحث مؤتمتين، مولدات شيفرة تكرارية، أو وكلاء خدمة عملاء متعدد الخطوات يجب أن يستشيروا قواعد بيانات وواجهات خارجية).

2. هندسة مطوّلة واستدلال على قواعد شيفرة

عندما تحتاج أن يحلّل النموذج أو يعيد الهيكلة أو يركّب عبر العديد من الملفات أو قاعدة شيفرة كبيرة، تمنحك نوافذ السياق الممتدة والانتباه المتناثر في GLM-5 مزايا مباشرة — حالات فشل أقل بسبب اقتطاع السياق واتساق أطول مدى.

3. تركيب معرفي كثيف

يمكن للمحللين وفرق المنتج الذين ينتجون تقارير معقدة — موجزات بحث متعددة الأقسام، ملخصات قانونية، أو ملفات تنظيمية — الاستفادة من تحسينات النموذج في الاستدلال المتدرّج المستقر وتقليل الهلاوس وفقًا لاختبارات المورّد المبلغ عنها.

4. أتمتة وكيليّة لسير العمل

يمكن للفرق التي تبني أتمتة يجب أن تنسّق أنظمة متعددة (مثل التخطيط + التذاكر + سلاسل النشر) استخدام GLM-5 كالمخطّط والمنفّذ المركزي، مدعومًا بأطر استدعاء الأدوات وطبقات الأمان.

الخلاصة

GLM-5 إصدار مهم في مشهد النماذج الحدّية سريع التطور. يؤهله تركيزه على الهندسة الوكيليّة، وتحسينات الترميز والاستدلال، وتوفّر الأوزان المفتوحة ليكون جذابًا للفرق التي تبني أنظمة ذكاء بعيدة المدى ومدعومة بالأدوات. مكاسب حقيقية في مهام مختارة ومقايضات كلفة/أداء مشجعة — لكن على المشترين تقييم GLM-5 مقابل مهامهم الخاصة وإجراء مقارنات مضبوطة قبل الالتزام بالإنتاج.

يمكن للمطورين الوصول إلى GLM-5 عبر CometAPI الآن. للبدء، استكشف قدرات النموذج في Playground واطّلع على دليل API للحصول على تعليمات مفصلة. قبل الوصول، يُرجى التأكد من تسجيل الدخول إلى CometAPI والحصول على مفتاح API. يقدّم CometAPI سعرًا أقل بكثير من السعر الرسمي لمساعدتك على الدمج.

Ready to Go?→ Sign up for glm-5 today !

إذا أردت مزيدًا من النصائح والإرشادات والأخبار حول الذكاء الاصطناعي، تابعنا على VK، وX، وDiscord!