توفر واجهة برمجة التطبيقات Qwen2.5-Omni-7B للمطورين طرقًا متوافقة مع OpenAI للتفاعل مع النموذج، مما يتيح معالجة النصوص والصور والصوت والفيديو، وتوليد استجابات نصية وكلامية طبيعية في الوقت الفعلي.

ما هو Qwen2.5-Omni-7B؟

Qwen2.5-Omni-7B هو نموذج الذكاء الاصطناعي متعدد الوسائط الرائد من علي بابا، ويضم 7 مليارات معلمة. صُمم لمعالجة وفهم أنماط بيانات متعددة، ويدعم مدخلات النصوص والصور والصوت والفيديو. كما يُسهّل النموذج التفاعلات الصوتية والمرئية الفورية، مما يجعله أداة متعددة الاستخدامات لتطبيقات متنوعة.

الميزات الرئيسية لـ Qwen2.5-Omni-7B

- المعالجة المتعددة الوسائط: القدرة على التعامل مع المدخلات المتنوعة، بما في ذلك النصوص والصور والصوت والفيديو، مما يتيح فهم البيانات الشاملة.

- التفاعل في الوقت الفعلي: يدعم المعالجة ذات زمن الوصول المنخفض، مما يسمح بإجراء محادثات الكلام والفيديو في الوقت الفعلي.

- هندسة المفكر والمتحدث: يستخدم نظامًا ثنائي البنية حيث يتولى "المفكر" إدارة معالجة البيانات وفهمها، بينما يقوم "المتحدث" بتوليد مخرجات كلامية سلسة.

- حبل متعدد الوسائط متوافق مع الوقت (TMRoPE): يستخدم TMRoPE للمزامنة الدقيقة للبيانات الزمنية عبر الوسائط المختلفة، مما يضمن الفهم المتماسك وتوليد الاستجابة.

مقاييس الأداء

الإنجازات المعيارية

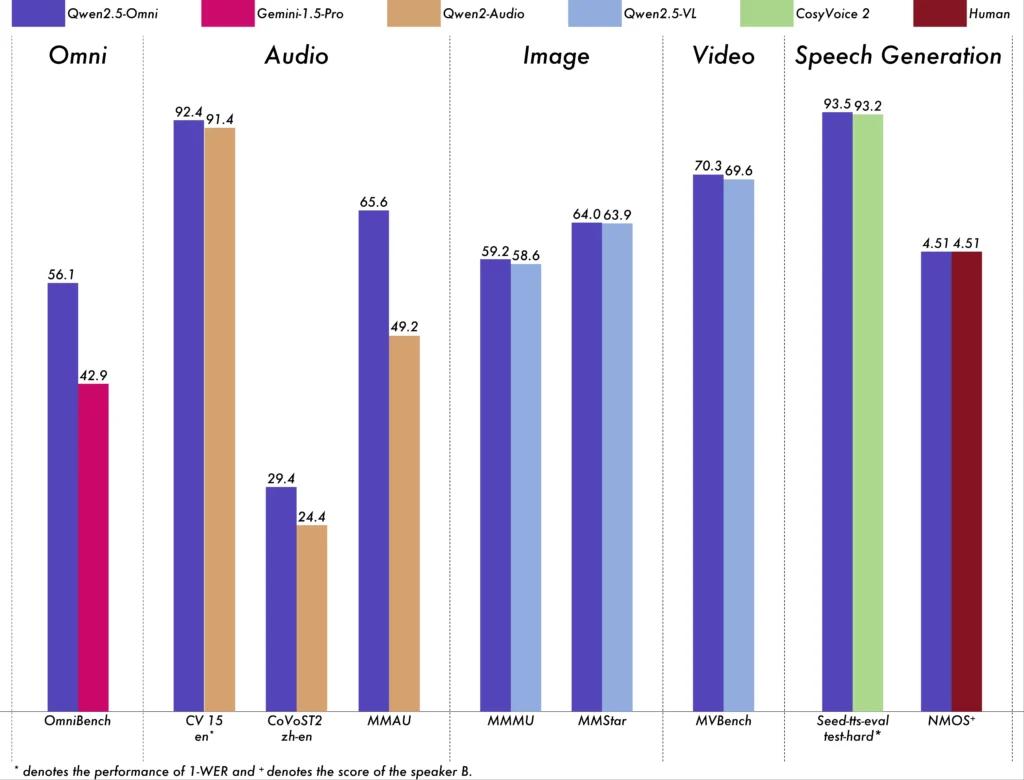

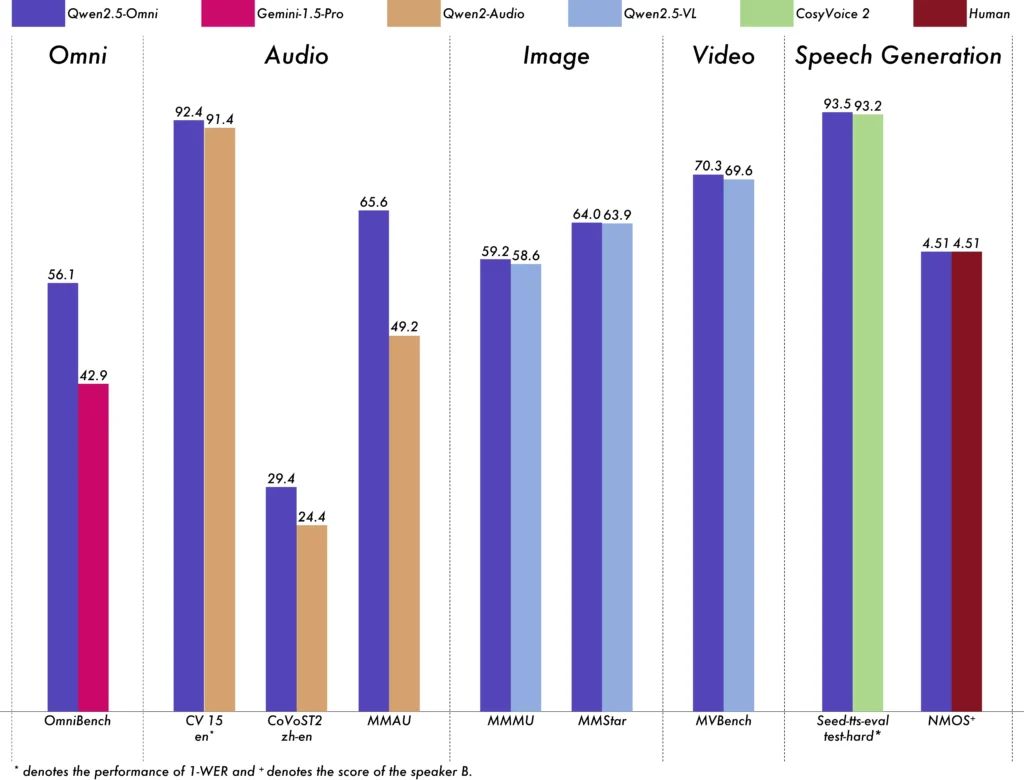

لقد أظهر Qwen2.5-Omni-7B أداءً استثنائيًا عبر معايير مختلفة:

- أومني بينش: حقق متوسط درجة 56.13%، متجاوزًا نماذج مثل Gemini-1.5-Pro (42.91%) وMIO-Instruct (33.80%).

- التعرف على الكلام: وفي مجموعة بيانات Librispeech، تم تحقيق معدلات خطأ في الكلمات تتراوح من 1.6% إلى 3.5%، وهي قابلة للمقارنة مع النماذج المتخصصة مثل Whisper-large-v3.

- التعرف على الحدث الصوتي: حصل على درجة 0.570 على مجموعة بيانات Meld، مما وضع معيارًا جديدًا في هذا المجال.

- فهم الموسيقى: حقق درجة 0.88 على معيار GiantSteps Tempo، مما يسلط الضوء على كفاءته في فهم الموسيقى.

إمكانيات المعالجة في الوقت الفعلي

صُمم Qwen2.5-Omni-7B لتطبيقات الوقت الفعلي، ويدعم البث المباشر، مما يتيح توليد الصوت فورًا بأقل زمن وصول. تُعد هذه الميزة مفيدة بشكل خاص للتطبيقات التي تتطلب استجابات سريعة، مثل المساعدين الافتراضيين وأنظمة الذكاء الاصطناعي التفاعلية.

بيانات المعدة

التصميم المعماري

- إطار المفكر والمتحدث: يعالج مُكوِّن "المُفكِّر" المُدخلات متعددة الوسائط ويفهمها، مُولِّدًا تمثيلات دلالية عالية المستوى ومُخرَجات نصية. يُحوِّل مُكوِّن "المُتحدِّث" هذه التمثيلات إلى كلام طبيعي وسلس، مما يضمن تواصلًا سلسًا بين نظام الذكاء الاصطناعي والمستخدمين.

- آلية TMRoPE: يتناول تحدي مزامنة البيانات الزمنية من مصادر مختلفة عن طريق محاذاة الطوابع الزمنية لمدخلات الفيديو والصوت، مما يسهل الفهم المتعدد الوسائط المتماسك.

منهجية التدريب

لقد خضع النموذج لعملية تدريب مكونة من ثلاث مراحل:

- المرحلة الأولى: معلمات نموذج اللغة الثابتة أثناء تدريب برامج ترميز الصوت والصورة باستخدام أزواج واسعة النطاق من الصوت والنص والصورة والنص لتعزيز الفهم المتعدد الوسائط.

- المرحلة الثانية: تم إلغاء تجميد جميع المعلمات وتم تدريبها على مجموعة بيانات متنوعة تضم الصور والفيديو والصوت والنص، مما أدى إلى تحسين الفهم المتعدد الوسائط الشامل بشكل أكبر.

- المرحلة الثالثة: التركيز على تدريب البيانات ذات التسلسل الطويل لتعزيز قدرة النموذج على التعامل مع المدخلات المعقدة والممتدة.

تطور نماذج Qwen

التقدم من Qwen إلى Qwen2.5

إن التطور من Qwen إلى Qwen2.5 يمثل قفزة كبيرة في تطوير نموذج الذكاء الاصطناعي:

- المعلمات المحسنة: تم توسيع Qwen2.5 ليشمل نماذج تحتوي على ما يصل إلى 72 مليار معلمة، مما يوفر حلولاً قابلة للتطوير لتطبيقات متنوعة.

- معالجة السياق الموسعة: تم تقديم القدرة على معالجة ما يصل إلى 128,000 رمز، مما يسهل التعامل مع المستندات الضخمة والمحادثات المعقدة.

- قدرات الترميز: يدعم إصدار Qwen2.5-Coder أكثر من 92 لغة برمجة، مما يساعد في مهام إنشاء التعليمات البرمجية واستكشاف الأخطاء وإصلاحها والتحسين.

مزايا Qwen2.5-Omni-7B

التكامل الشامل متعدد الوسائط

من خلال معالجة النصوص والصور والصوت والفيديو بشكل فعال، يوفر Qwen2.5-Omni-7B حلاً شاملاً للذكاء الاصطناعي مناسبًا لمجموعة واسعة من التطبيقات.

التفاعل في الوقت الحقيقي

تضمن معالجتها ذات زمن الوصول المنخفض استجابات فورية، مما يعزز تجربة المستخدم في التطبيقات التفاعلية.

إمكانية الوصول مفتوحة المصدر

باعتباره نموذجًا مفتوح المصدر، يعمل Qwen2.5-Omni-7B على تعزيز الشفافية ويسمح للمطورين بتخصيص النموذج ودمجه في منصات مختلفة دون قيود ملكية.

المؤشرات الفنية

- معلمات النموذج: 7 مليار

- طرق الإدخال: النص، الصورة، الصوت، الفيديو

- طرق الإخراج: النص، الكلام

- القدرة على المعالجة: التفاعل الصوتي والفيديو في الوقت الفعلي

- معايير الأداء:

- أومني بينش: 56.13% متوسط الدرجات

- Librispeech (معدل خطأ الكلمات): اختبار نظيف: 1.8%، اختبار آخر: 3.4%

سيناريوهات التطبيق

المساعدون الافتراضيون التفاعليون

إن معالجة Qwen2.5-Omni-7B في الوقت الفعلي والفهم المتعدد الوسائط يجعلها مثالية للمساعدين الافتراضيين الذين يمكنهم الرؤية والاستماع والاستجابة بشكل طبيعي.

إنشاء محتوى الوسائط المتعددة

يمكن لمنشئي المحتوى الاستفادة من النموذج لإنشاء محتوى الوسائط المتعددة الجذاب، من خلال الجمع بين النصوص والصور والصوت بسلاسة.

التقنيات المساعدة

يمكن أن تساعد قدرات النموذج الأفراد ذوي الإعاقة، مثل توفير الصوت الوصفي للمحتوى المرئي.

نصائح الاستخدام

تحسين الأداء

لتحقيق الأداء الأمثل، وخاصة في التطبيقات في الوقت الحقيقي، يوصى باستخدام مسرعات الأجهزة والتأكد من وجود ذاكرة كافية لوحدة معالجة الرسومات.

التكامل مع الأنظمة الموجودة

ينبغي للمطورين مراعاة تنسيقات الإدخال والإخراج الخاصة بالنموذج عند التكامل مع التطبيقات الحالية لضمان التوافق وتعظيم الكفاءة.

تحديث البقاء

قم بالتحقق بانتظام من المستودعات الرسمية والوثائق للحصول على التحديثات وأفضل الممارسات للاستفادة الكاملة من قدرات Qwen2.5-Omni-7B.

مواضيع ذات صلة كيفية تشغيل نموذج Qwen2.5-Omni-7B

الخاتمة

يُجسّد Qwen2.5-Omni-7B التقاء أبحاث الذكاء الاصطناعي المتقدمة وتطبيقاتها العملية، مُقدّمًا حلاً متعدد الاستخدامات وفعالًا للعديد من المهام في مختلف القطاعات. يضمن كونه مفتوح المصدر سهولة الوصول إليه وقابليته للتكيف، مما يُمهد الطريق لابتكارات مستقبلية في مجال الذكاء الاصطناعي متعدد الوسائط.

كيفية استدعاء واجهة برمجة التطبيقات Qwen2.5-Omni-7B من CometAPI

1.تسجيل الدخول إلى كوميتابي.كوم. إذا لم تكن مستخدمًا لدينا بعد، فيرجى التسجيل أولاً

2.احصل على مفتاح API لبيانات اعتماد الوصول للواجهة. انقر على "إضافة رمز" في رمز واجهة برمجة التطبيقات في المركز الشخصي، واحصل على مفتاح الرمز: sk-xxxxx، ثم أرسله.

- احصل على عنوان URL لهذا الموقع: https://api.cometapi.com/

٤. حدد نقطة نهاية Qwen4-Omni-2.5B لإرسال طلب واجهة برمجة التطبيقات (API) وحدد نص الطلب. يتم الحصول على طريقة الطلب ونصه من وثيقة API لموقعنا على الويبيوفر موقعنا أيضًا اختبار Apifox لراحتك.

- عالج استجابة واجهة برمجة التطبيقات (API) للحصول على الإجابة المُولَّدة. بعد إرسال طلب واجهة برمجة التطبيقات، ستتلقى كائن JSON يحتوي على الإكمال المُولَّد.