Kunstig intelligens (AI) har revolutioneret adskillige industrier, og en af dens mest fængslende applikationer er billedgenerering. Fra at skabe realistiske menneskelige ansigter til at producere surrealistiske kunstværker har evnen til AI Image Generation åbnet nye veje inden for kunst, design og teknologi. Denne artikel dykker ned i mekanismerne bag AI-genererede billeder, de modeller, der driver dem, og de bredere implikationer af denne teknologi.

Forstå det grundlæggende: Hvordan fungerer AI-billedgenerering?

Hvad er generative modeller?

Generative modeller er en klasse af AI-algoritmer, der kan skabe nye dataforekomster, der ligner træningsdataene. I forbindelse med billedgenerering lærer disse modeller mønstre fra eksisterende billeder og bruger denne viden til at producere nye, lignende billeder.

Neurale netværks rolle

Kernen i AI-billedgenerering er neurale netværk, især deep learning-modeller som Convolutional Neural Networks (CNN'er). CNN'er er designet til at behandle data med en gitterlignende topologi, hvilket gør dem ideelle til billedanalyse og generering. De virker ved at detektere mønstre som kanter, teksturer og former, som er afgørende for at forstå og genskabe billeder.

Nøgle AI-modeller i AI-billedgenerering

Generative Adversarial Networks (GAN'er)

Introduceret af Ian Goodfellow i 2014, GAN'er består af to neurale netværk: en generator og en diskriminator. Generatoren skaber billeder, mens diskriminatoren vurderer dem i forhold til rigtige billeder. Gennem denne modstridende proces forbedrer generatoren sit output for at producere stadig mere realistiske billeder.

StyleGAN

StyleGAN er udviklet af NVIDIA og er en GAN-variant kendt for at generere menneskeansigter af høj kvalitet. Den introducerer en stilbaseret generatorarkitektur, der tillader kontrol over forskellige detaljeringsniveauer i billedet. StyleGAN2 og StyleGAN3 forbedrede billedkvaliteten yderligere og løste problemer som teksturvedhæftning.

Diffusionsmodeller

Diffusionsmodeller genererer billeder ved at starte med tilfældig støj og gradvist forfine det, så det matcher det ønskede output. De har vundet popularitet på grund af deres evne til at producere billeder i høj kvalitet og deres fleksibilitet i forskellige applikationer.

Stabil diffusion

Stable Diffusion er en open source-diffusionsmodel, der muliggør generering af tekst-til-billede. Det kan også udføre inpainting og outpainting, hvilket giver mulighed for billedredigering og udvidelse. Dens open source-karakter har gjort det bredt tilgængeligt for udviklere og kunstnere.

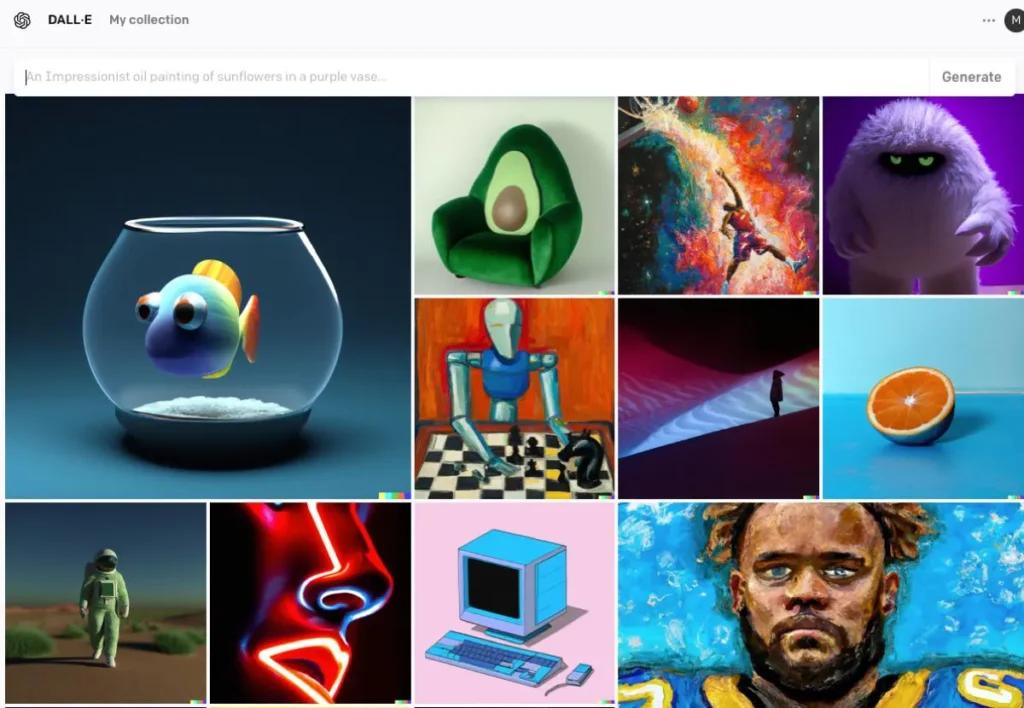

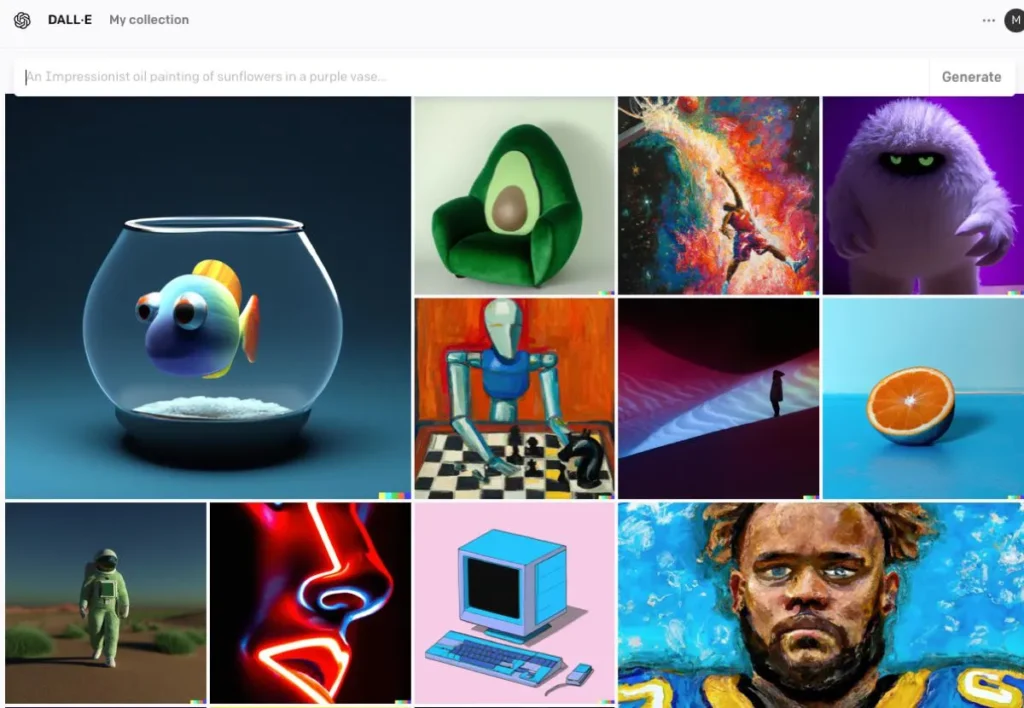

DALL E

DALL·E, der er udviklet af OpenAI, er en transformer-baseret model, der er i stand til at generere billeder ud fra tekstbeskrivelser. DALL·E 2 og DALL·E 3 er forbedret i forhold til originalen og tilbyder højere opløsning og mere nøjagtig billed-tekstjustering. DALL·E 3 er integreret i ChatGPT for forbedret brugerinteraktion.

Processen med AI-billedgenerering

Træning af modellen

AI-modeller kræver omfattende træning i store datasæt af billeder. Under træning lærer modellen at genkende mønstre og funktioner i billederne, hvilket gør den i stand til at generere nye billeder, der efterligner træningsdataene.

Generering af nye billeder

Når modellen er trænet, kan den generere nye billeder ved at:

- Modtagelse af input: Dette kan være tilfældig støj (i GAN'er), en tekstprompt (i DALL·E) eller et eksisterende billede (til redigering). Dette trin fanger tekstens semantiske betydning, hvilket gør AI i stand til at forstå indholdet og konteksten.

- Behandler input: Modellen behandler inputtet gennem sine neurale netværkslag og anvender indlærte mønstre og funktioner. Ved hjælp af den kodede tekst anvender AI modeller såsom Generative Adversarial Networks (GAN'er) eller diffusionsmodeller til at skabe billeder. Disse modeller genererer billeder ved at starte med tilfældig støj og forfine det, så det matcher tekstbeskrivelsen.

- Forfining og evaluering: Det genererede billede forfines derefter ved hjælp af opmærksomhedsmekanismer for at sikre sammenhæng med teksten. En diskriminatormodel evaluerer billedets realisme og overensstemmelse med inputtet og giver feedback til yderligere forfining.

- Udsender billede: Det endelige output er et nyt billede, der afspejler egenskaberne for træningsdataene og det specifikke input, der leveres.

Kodeeksempel på AI-billedgenerering

her er praktiske Python-kodeeksempler, der viser, hvordan man genererer billeder ved hjælp af tre fremtrædende AI-modeller: Generative Adversarial Networks (GAN'er), Stable Diffusion og DALL·E.

Generative Adversarial Networks (GAN'er) med PyTorch

Generative Adversarial Networks (GAN'er) består af to neurale netværk - Generatoren og Diskriminatoren - der konkurrerer med hinanden om at generere nye, realistiske dataforekomster. Her er et forenklet eksempel, hvor du bruger PyTorch til at generere billeder:

pythonimport torch

import torch.nn as nn

# Define the Generator network

class Generator(nn.Module):

def __init__(self):

super(Generator, self).__init__()

self.fc1 = nn.Linear(100, 128)

self.fc2 = nn.Linear(128, 784) # Assuming output image size is 28x28

def forward(self, x):

x = torch.relu(self.fc1(x))

x = torch.tanh(self.fc2(x))

return x

# Instantiate the generator

generator = Generator()

# Generate a random noise vector

noise = torch.randn(1, 100)

# Generate an image

generated_image = generator(noise)

Denne kode definerer et simpelt generatornetværk, der tager en 100-dimensional støjvektor som input og producerer et 784-dimensionelt output, som kan omformes til et 28×28-billede. De tanh aktiveringsfunktionen sikrer, at outputværdierne er i området , som er fælles for billeddata.

Stabil spredning med kramme ansigtsdiffusorer

Stable Diffusion er en kraftfuld tekst-til-billede-model, der genererer billeder baseret på tekstbeskrivelser. Det kramme ansigt diffusers biblioteket giver en nem grænseflade til at bruge denne model:

pythonfrom diffusers import StableDiffusionPipeline

import torch

# Load the pre-trained Stable Diffusion model

pipe = StableDiffusionPipeline.from_pretrained("CompVis/stable-diffusion-v1-4")

pipe = pipe.to("cuda") # Move the model to GPU for faster inference

# Generate an image from a text prompt

prompt = "A serene landscape with mountains and a river"

image = pipe(prompt).images

# Save the generated image

image.save("generated_image.png")

Dette script indlæser den stabile diffusionsmodel og genererer et billede baseret på den angivne prompt. Sørg for, at du har de nødvendige afhængigheder installeret og en kompatibel GPU for optimal ydeevne

DALL·E med OpenAI API

DALL·E er en anden tekst-til-billede-model udviklet af OpenAI. Du kan interagere med det ved hjælp af OpenAI's API:

pythonimport openai

import requests

from PIL import Image

from io import BytesIO

# Set your OpenAI API key

openai.api_key = "your-api-key"

# Generate an image using DALL·E

response = openai.Image.create(

prompt="A futuristic cityscape at sunset",

n=1,

size="512x512"

)

# Get the URL of the generated image

image_url = response

# Download and display the image

image_response = requests.get(image_url)

image = Image.open(BytesIO(image_response.content))

image.save("dalle_generated_image.png")

udskifte "your-api-key" med din faktiske OpenAI API-nøgle. Dette script sender en prompt til DALL·E-modellen og henter det genererede billede. Billedet gemmes derefter lokalt

CometAPI integrerer også DALL-E 3 API, kan du også bruge CometAPIs nøgle til at få adgang DALL-E 3 API, hvilket er mere bekvemt og hurtigere end OpenAI.

For mere modelinformation i Comet API, se venligst API-dok.

Disse eksempler giver et udgangspunkt for at generere billeder ved hjælp af forskellige AI-modeller. Hver model har sine unikke muligheder og krav, så vælg den, der passer bedst til dit projekts behov.

Konklusion

AI-billedgenerering står i skæringspunktet mellem teknologi og kreativitet og tilbyder hidtil usete muligheder inden for skabelse af visuelt indhold. At forstå, hvordan AI genererer billeder, de involverede modeller og implikationerne af denne teknologi er afgørende, når vi navigerer dens integration i forskellige aspekter af samfundet.

Få adgang til AI Image API i CometAPI

CometAPI giver adgang til over 500 AI-modeller, inklusive open source og specialiserede multimodale modeller til chat, billeder, kode og mere. Dens primære styrke ligger i at forenkle den traditionelt komplekse proces med AI-integration. Med den er adgang til førende AI-værktøjer som Claude, OpenAI, Deepseek og Gemini tilgængelig gennem et enkelt, samlet abonnement. Du kan bruge API'et i CometAPI til at skabe musik og kunst, generere videoer og bygge dine egne arbejdsgange

CometAPI tilbyde en pris langt lavere end den officielle pris for at hjælpe dig med at integrere GPT-4o API ,Midjourney API Stable Diffusion API (Stabil Diffusion XL 1.0 API) og Flux API(FLUX.1 API osv.), og du vil få $1 på din konto efter registrering og login!

CometAPI integrerer det nyeste GPT-4o-image API .