I slutningen af august 2025 udgav Google (DeepMind) Gemini 2.5 Flash-billede — bredt kaldet "nano-banan" — en model til billedgenerering og redigering med lav latenstid og høj kvalitet, der er integreret i Gemini-appen, Google AI Studio, Gemini API og CometAPI. Den er designet til at producere fotorealistiske billeder, bevare tegnkonsistens på tværs af redigeringer, fusionere flere inputbilleder og udføre fine, lokaliserede redigeringer via naturligt sproglige prompts. Modellen er tilgængelig i preview / tidlig GA og topper allerede billedranglisterne (LMArena), mens den leveres med sikkerhedsmekanismer (SynthID-vandmærkning og filtre på produktniveau).

Hvad er Gemini 2.5 Flash Image (også kendt som "Nano Banana")?

Gemini 2.5 Flash Image — legende kaldenavn Nano-banan — er Google DeepMinds seneste model til billedgenerering og -redigering i Gemini-familien. Modellen, der blev annonceret i slutningen af august 2025, er positioneret som en forhåndsvisning, der bringer redigeringer med højere kvalitet, fusion af flere billeder, bedre karakterkonsistens (hvor den samme person/kæledyr/objekt holdes genkendelig på tværs af flere redigeringer) og billedgenerering med lav latenstid ind i Gemini's multimodale værktøjssæt. Den er tilgængelig via Gemini API, Google AI Studio, Gemini mobil-/webapps og Vertex AI til virksomhedskunder.

Oprindelse og navngivning

Kælenavnet "nano banan" blev en viral forkortelse på sociale medier og ranglister i community'et, efter at tidlige testere og LMArena-deltagere brugte en frugt-tema-etiket. Google bekræftede forbindelsen og omfavnede det legende navn offentligt i deres udvikler- og produktindlæg. Det officielle produktnavn er Gemini 2.5 Flash-billede og du vil typisk se modelidentifikatoren, der bruges i kode og API-kald (til forhåndsvisning vises den som f.eks. gemini-2.5-flash-image-preview).

Hvad er de vigtigste funktioner i Gemini 2.5 Flash Image?

Hvad betyder "karakterkonsistens" egentlig?

En af de fremtrædende funktioner er karakterkonsistensDu kan bede modellen om at genbruge det samme motiv (en person, et kæledyr, en maskot eller et produkt) på tværs af mange redigeringer eller nye scener, samtidig med at identificerende visuelle træk (ansigt/form, farvepalet, kendetegn) bevares. Dette adresserer en almindelig svaghed i tidligere billedmodeller, hvor efterfølgende redigeringer ville producere visuelt plausible, men mærkbart forskellige personer/objekter. Udviklere kan derfor opbygge arbejdsgange til produktkataloger, episodisk historiefortælling eller generering af brandaktiver med mindre manuel korrektion.

Hvilke andre redigeringsfunktioner er inkluderet?

Gemini 2.5 Flash Image understøtter:

- Målrettede lokale redigeringer via letforståelige instruktioner (fjern en genstand, skift outfit, retoucher hud, fjern baggrundselement).

- Flerbilledfusionkombiner op til tre inputbilleder til en enkelt sammenhængende komposition (f.eks. indsæt et produkt fra billede A i scene B, mens belysningen bevares).

- Stil- og formatkontrollerfotorealistiske instruktioner, kamera- og objektivattributter, billedformat og stiliserede output (illustration, klistermærke osv.).

- Indfødt verdenskendskabModellen udnytter den bredere Gemini-families viden til at udføre semantisk bevidste redigeringer (f.eks. forstå, hvad "renæssancebelysning" eller "Tokyo-fodgængerovergang" indebærer).

Hvad med hastighed, pris og tilgængelighed?

Gemini 2.5 Flash Image er en del af Flash-niveauet af Gemini 2.5 – optimeret til lav latenstid og omkostninger, samtidig med at den høje kvalitet opretholdes. Google har forhåndsvist priserne for billedoutputtokens og angivet tilgængelighed via API og AI Studio; virksomhedskunder kan få adgang til det via Vertex AI. Ved annonceringen var den offentliggjorte pris for Gemini 2.5 Flash Image-niveauet ... 30 USD pr. 1 million output-tokens, med et eksempel på en pris pr. billede rapporteret som 1290 outputtokens ≈ $0.039 pr. billede.

Hvordan fungerer Gemini 2.5 Flash Image under motorhjelmen?

Arkitektur og træningstilgang

Gemini 2.5 Flash Image arver Gemini 2.5-familiens arkitektur: en sparsom blanding af eksperter (MoE) med multimodal træning, der kombinerer tekst, billede, lyd og andre data. Google trænede Flash Image på meget store, filtrerede multimodale korpora og finjusterede modellen til billedopgaver (generering, redigering, fusion) og sikkerhedsadfærd. Træningen blev kørt på Googles TPU-struktur og evalueret med både automatiske og menneskelige vurderingsmålinger.

Samtaledrevet redigering

På et overordnet niveau bruger modellen kontekstuel betingning: Når du leverer et billede (eller flere billeder) plus tekstprompter, koder modellen motivets visuelle identitet ind i dets interne repræsentation. Under efterfølgende redigeringer eller nye scener betinges genereringen af den repræsentation, så ønskede visuelle attributter (ansigtsgeometri, vigtige beklædnings- eller produktidentifikatorer, farvepaletter) bevares. I praksis implementeres dette som en del af den multimodale indholdspipeline, der eksponeres af Gemini API'en: du sender referencebillederne sammen med redigeringsinstruktioner, og modellen returnerer redigerede billedoutput (eller flere kandidatbilleder) i ét svar.

Vandmærkning og proveniens

Google integrerer sikkerheds- og indholdspolitikfiltre i Gemini 2.5 Flash Image. Udgivelsen lægger vægt på evaluering og red-teaming, automatiserede filtreringstrin, overvåget finjustering og forstærkningslæring til opfølgning på instruktioner, samtidig med at skadelige output minimeres. Outputtet inkluderer et usynligt SynthID-vandmærke, så billeder produceret eller redigeret af modellen senere kan identificeres som AI-genererede.

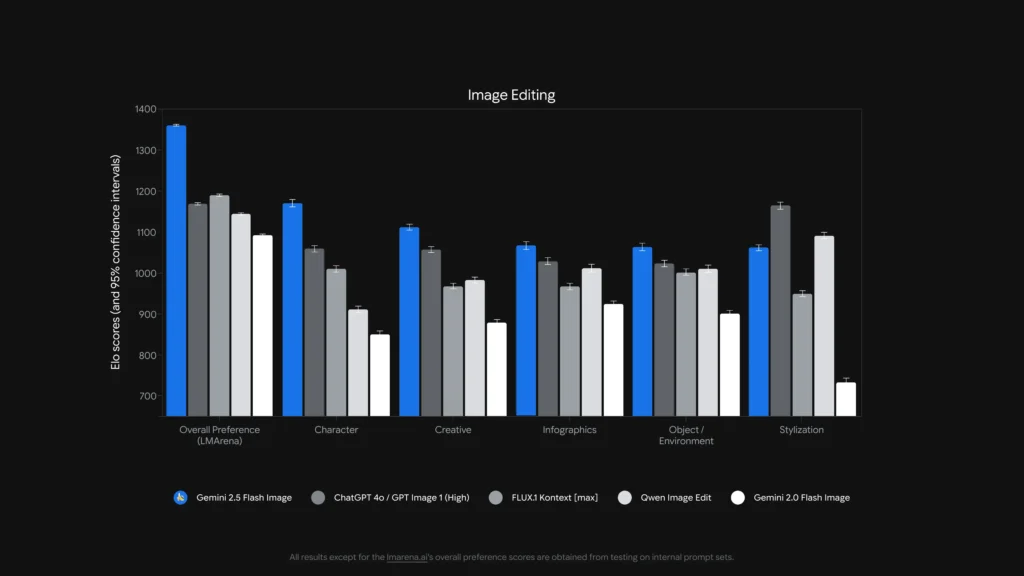

Hvor godt klarer den sig? (Benchmarkdata)

Gemini 2.5 Flash Image (markedsført som "nano-banan" i nogle benchmarking-sammenhænge) nåede #1 på LMArenas ranglister over billedredigering og tekst-til-billede pr. slutningen af august 2025, med store Elo/præference-føringer i forhold til konkurrenter i de rapporterede sammenligninger. Jeg refererer til resultaterne af den menneskelige evaluering af LMArena og GenAI-Bench, der viser de bedste præferencescorer for både tekst-til-billede og billedredigeringsopgaver.

Tekst-til-billede-sammenligning

| Evnebenchmark | Gemini Flash 2.5-billede | Imagen 4 Ultra 06-06 | ChatGPT 4o / GPT Billede 1 (Høj) | FLUX.1 Kontekst | Gemini Flash 2.0-billede |

|---|---|---|---|---|---|

| Samlet præference (LMArena) | 1147 | 1135 | 1129 | 1075 | 988 |

| Visuel kvalitet (GenAI-Bench) | 1103 | 1094 | 1013 | 864 | 926 |

| Tekst-til-billede-justering (GenAI-Bench) | 1042 | 1053 | 1046 | 937 | 922 |

Billedredigering

| Evnebenchmark | Gemini Flash 2.5-billede | ChatGPT 4o / GPT Billede 1 (Høj) | FLUX.1 Kontekst | Qwen-billedredigering | Gemini Flash 2.0-billede |

|---|---|---|---|---|---|

| Samlet præference (LMArena) | 1362 | 1170 | 1191 | 1145 | 1093 |

| Character | 1170 | 1059 | 1010 | 911 | 850 |

| Kreativ | 1112 | 1057 | 968 | 983 | 879 |

| infografik | 1067 | 1029 | 967 | 1012 | 925 |

| Objekt / Miljø | 1064 | 1023 | 1002 | 1010 | 901 |

| Produktrekontekstualisering | 1128 | 1032 | 943 | 1009 | 888 |

| Stilisering | 1062 | 1165 | 949 | 1091 | 733 |

Hvad betyder disse benchmarks i praksis?

Benchmarks fortæller os to ting: (1) modellen er konkurrencedygtig ved fotorealistisk generering og (2) den skiller sig ud i redigering Opgaver, hvor karakterkonsistens og hurtig overholdelse er vigtige. Menneskelige præferencer viser, at brugere, der ser output, vurderede Gemini's output højt for realisme og overensstemmelse med instruktioner i mange evaluerede prompts. Der er dog eksplicit om kendte begrænsninger (risiko for hallucinationer på fine faktuelle detaljer, lang tekstgengivelse i billeder, stiloverførselstilfælde) - så benchmarks er en vejledning, ikke en garanti.

Hvad kan man gøre med Gemini 2.5 Flash Image (brugseksempler)?

Gemini 2.5 Flash Image er eksplicit bygget til kreative, produktivitets- og anvendte billeddannelsesscenarier. Typiske og nye anvendelsesscenarier inkluderer:

Hurtige produktmodeller og e-handel

Træk produktfotos ind i scener, generer ensartede katalogbilleder på tværs af miljøer, eller byt farver/stoffer på tværs af en produktlinje – alt imens produktets identitet bevares. Funktionerne til fusion af flere billeder og karakter-/produktkonsistensen gør det attraktivt til katalogarbejdsgange.

Fotoretouchering og målrettede redigeringer

Fjern genstande, ret pletter, skift tøj/tilbehør, eller juster belysningen med vejledninger i naturligt sprog. Den lokaliserede redigeringsfunktion giver ikke-eksperter mulighed for at udføre professionel retouchering ved hjælp af samtalekommandoer.

Storyboarding og visuel historiefortælling

Placer den samme karakter på tværs af forskellige scener, og hold deres udseende ensartet (nyttigt til tegneserier, storyboards eller pitch decks). Iterative redigeringer giver skabere mulighed for at forfine stemning, indramning og narrativ kontinuitet uden at genopbygge elementer fra bunden.

Uddannelse, diagrammer og designprototyping

Fordi den kan kombinere tekstprompter og billeder og har "verdensviden", kan modellen hjælpe med at generere kommenterede diagrammer, undervisningsvisualiseringer eller hurtige mockups til præsentationer. Google fremhæver endda skabeloner i AI Studio til use cases som ejendomsmockups og produktdesign.

Hvordan bruger du Nano Banana API'en?

Nedenfor er praktiske uddrag tilpasset fra CometAPI API-dokumentation og Googles API-dokumentation. De demonstrerer de almindelige flows: tekst-til-billede og billede + tekst til billede (redigering) ved hjælp af det officielle GenAI SDK eller REST-slutpunkt.

Bemærk: I CometAPI's dokumentation vises navnet på forhåndsvisningsmodellen som

gemini-2.5-flash-image-previewEksemplerne nedenfor afspejler de officielle SDK-eksempler (Python og JavaScript) og et REST curl-eksempel; tilpas nøgler og filstier til dit miljø.

REST curl-eksempel fra CometAPI

Brug Gemini's officielle generateContent slutpunkt for tekst-til-billede-generering. Placer tekstprompten i contents.parts[].text.Eksempel (Windows-shell, ved hjælp af ^ for linjefortsættelse):

curl --location --request POST "https://api.cometapi.com/v1beta/models/gemini-2.5-flash-image-preview:generateContent" ^

--header "Authorization: sk-xxxx" ^

--header "User-Agent: Apifox/1.0.0 (https://apifox.com)" ^

--header "Content-Type: application/json" ^

--header "Accept: */*" ^

--header "Host: api.cometapi.com" ^

--header "Connection: keep-alive" ^

--data-raw "{ "contents": [{

"parts": [

{"text": "A photorealistic macro shot of a nano-banana on a silver fork, shallow depth of field"}

]

}]

}'}"

| grep -o '"data": "*"' \

| cut -d'"' -f4 \

| base64 --decode > gemini-generated.png

Svaret indeholder base64 billedbytes; pipelinen ovenfor udtrækker "data" streng og afkoder den til gemini-generated.png.

Dette endpoint understøtter generering af "billede-til-billede": upload et inputbillede (som Base64) og modtag et ændret nyt billede (også i Base64-format).Eksempel:

curl --location --request POST "https://api.cometapi.com/v1beta/models/gemini-2.5-flash-image-preview:generateContent" ^

--header "Authorization: sk-xxxx" ^

--header "User-Agent: Apifox/1.0.0 (https://apifox.com)" ^

--header "Content-Type: application/json" ^

--header "Accept: */*" ^

--header "Host: api.cometapi.com" ^

--header "Connection: keep-alive" ^

--data-raw "{ \"contents\": } ], \"generationConfig\": { \"responseModalities\": }}"

**Beskrivelse:**Først skal du konvertere din kildebilledfil til en Base64-streng og placere den i inline_data.dataMedtag ikke præfikser som data:image/jpeg;base64,Udgangen er også placeret i candidates.content.parts og inkluderer: En valgfri tekstdel (beskrivelse eller prompt). Billeddelen som inline_data (hvor data er Base64 for outputbilledet). For flere billeder kan du tilføje dem direkte, for eksempel:

{

"inline_data": {

"mime_type": "image/jpeg",

"data": "iVBORw0KGgo...",

"data": "iVBORw0KGgo..."

}

}

Nedenfor er eksempler fra udviklere, der er tilpasset fra Googles officielle dokumenter og blog. Erstat legitimationsoplysninger og filstier med dine egne.

Python (officiel SDK-stil)

from google import genai

from PIL import Image

from io import BytesIO

client = genai.Client()

prompt = "Create a picture of a nano banana dish in a fancy restaurant with a Gemini theme"

# Text-to-Image

response = client.models.generate_content(

model="gemini-2.5-flash-image-preview",

contents=,

)

for part in response.candidates.content.parts:

if part.text is not None:

print(part.text)

elif part.inline_data is not None:

image = Image.open(BytesIO(part.inline_data.data))

image.save("generated_image.png")

Dette er det kanoniske Python-kodestykke fra Googles dokumenter (forhåndsvisningsmodel-ID vist). Det samme SDK-kaldsmønster understøtter redigering af billeder + prompter (send et billede som en af contents).For flere detaljer henvises til Gemini-dokteren.

Konklusion

Hvis dit produkt har brug for robust billedgenerering med lav latenstid, og især pålidelig redigering med ensartet emneGemini 2.5 Flash Image er nu en produktionskvalitetsløsning, der er værd at evaluere: den kombinerer den nyeste billedkvalitet med API'er designet til udviklerintegration (AI Studio, Gemini API og Vertex AI). Overvej nøje modellens nuværende begrænsninger (fin tekst i billeder, nogle stiliseringskanttilfælde) og implementer sikkerhedsforanstaltninger for ansvarlig brug.

Kom godt i gang

CometAPI er en samlet API-platform, der samler over 500 AI-modeller fra førende udbydere – såsom OpenAIs GPT-serie, Googles Gemini, Anthropics Claude, Midjourney, Suno og flere – i en enkelt, udviklervenlig grænseflade. Ved at tilbyde ensartet godkendelse, formatering af anmodninger og svarhåndtering forenkler CometAPI dramatisk integrationen af AI-funktioner i dine applikationer. Uanset om du bygger chatbots, billedgeneratorer, musikkomponister eller datadrevne analysepipelines, giver CometAPI dig mulighed for at iterere hurtigere, kontrollere omkostninger og forblive leverandøruafhængig – alt imens du udnytter de seneste gennembrud på tværs af AI-økosystemet.

Udviklere kan få adgang Gemini 2.5 Flash-billede(Nano Banana Comet API-liste gemini-2.5-flash-image-preview/gemini-2.5-flash-image stilposter i deres katalog.) via CometAPI, er de seneste modelversioner, der er angivet, fra artiklens udgivelsesdato. For at begynde, skal du udforske modellens muligheder i Legeplads og konsulter API guide for detaljerede instruktioner. Før du får adgang, skal du sørge for at være logget ind på CometAPI og have fået API-nøglen. CometAPI tilbyde en pris, der er langt lavere end den officielle pris, for at hjælpe dig med at integrere.