Udgivelsen af GLM-5, lanceret i denne uge af Kinas Zhipu AI (offentligt brandet som Z.AI / zai-org i mange udviklerkanaler), markerer endnu et skridt i den accelererende kadence af udgivelser af store modeller. Den nye model positioneres som Zhipus flagskib: større i skala, tunet til agentiske opgaver med lang horisont, og bygget med ingeniørvalg, der skal reducere inferensomkostningerne samtidig med at den lange kontekst bevares. Tidlige branchemeldinger og praktiske udviklernoter peger på mærkbare forbedringer i kodning, multitrins ræsonnering og agentorkestrering sammenlignet med tidligere GLM-iterationer — og i nogle tests udfordrer den endda Claude 4.5.

Hvad er GLM-5, og hvem har bygget den?

GLM-5 er den seneste større udgivelse i GLM-familien: en stor, open-source grundmodel udviklet og udgivet af Z.ai (teamet bag GLM-serien). Annonceret i begyndelsen af februar 2026 præsenteres GLM-5 som en næste-generations model, der er specifikt tunet til "agentic" opgaver — dvs. multitrins, lang-horisont arbejdsforløb, hvor en model skal planlægge, kalde værktøjer, udføre og bevare kontekst i længere samtaler eller automatiserede agenter. Udgivelsen er bemærkelsesværdig ikke kun for modeldesign, men også for hvordan og hvor den blev trænet: Z.ai brugte en kombination af indenlandsk kinesisk hardware og værktøjskæder som led i en satsning på selvforsyning.

Rapporterede arkitektur- og træningsdata omfatter:

- Parameter-skalering: GLM-5 skalerer op til omtrent 744B parametre (med et mindre "aktivt" ekspertantal nævnt i nogle tekniske noter, f.eks. 40B aktiv), versus tidligere GLM-4-familie-størrelser omkring 355B/32B aktiv.

- Fortræningsdata: Træningskorpusets størrelse er angiveligt øget fra ~23 trillion tokens (GLM-4-generation) til ~28.5 trillion tokens for GLM-5.

- Sparsomme attention / DeepSeek Sparse Attention (DSA): Et sparsomt attention-skema for at bevare lang kontekst, samtidig med at beregningsomkostningen under inferens reduceres.

- Designfokus: ingeniørvalg med fokus på agentorkestrering, lang-kontekst-ræsonnering og omkostningseffektiv inferens.

Oprindelse og positionering

GLM-5 bygger videre på en række, der omfattede GLM-4.5 (udgivet midt i 2025) og nogle iterative opdateringer som 4.7. Z.ai positionerer GLM-5 som et spring fra "vibe coding" (hurtige enkeltrins kodeuddata) mod “agentisk engineering”: vedvarende ræsonnering, orkestrering af flere værktøjer og systemsyntese over lange kontekstvinduer. Offentlige materialer fremhæver, at GLM-5 er designet til at håndtere komplekse systemingeniøropgaver — at bygge, koordinere og vedligeholde multitrins agentadfærd frem for blot at besvare isolerede forespørgsler.

Hvad er de nye funktioner i GLM-5?

Væsentlige arkitektoniske ændringer

- Massiv sparsom skalering (MoE): GLM-5 går over til en langt større, sparsom Mixture-of-Experts-arkitektur. Offentlige tal fra udviklersider og uafhængige gennemgange angiver modellen som omtrent 744B samlede parametre med ~40B aktive pr. token — et markant skridt op fra GLM-4.5’s ~355B / 32B aktiv-konfiguration. Denne sparsomme skalering gør det muligt for modellen at have meget stor samlet kapacitet, samtidig med at beregningen pr. token holdes håndterbar.

- DeepSeek Sparse Attention (DSA): For at bevare evnen til lang kontekst uden lineær skalering af inferensomkostningen integrerer GLM-5 en sparsom attention-mekanisme (brandet DeepSeek), der bevarer vigtige langtrækkende afhængigheder i skala, samtidig med at omkostningen ved attention over meget lange kontekster reduceres.

Agentisk engineering som grundlæggende designmål

En af GLM-5’s overskriftsfunktioner er, at den eksplicit er designet til agentisk engineering — dvs. modellen er tænkt som “hjernen” i multitrins agenter, der kan planlægge, udstede værktøjskald, håndtere tilstand og ræsonnere på tværs af lange kontekster; ikke blot til enkelt-turn chat eller opsummering. Z.ai positionerer GLM-5 til at fungere i orkestreringssløjfer: at bryde komplekse problemer ned, kalde eksterne værktøjer/API’er og spore lange opgaver over mange ture.

Hvorfor agentisk design betyder noget

Agentiske arbejdsforløb er centrale for automatisering i den virkelige verden: automatiserede forskningsassistenter, autonome softwareingeniører, driftsorkestrering og simulationskontrol. En model bygget til dette kræver stærk planlægning, stabil værktøjskalds-adfærd og robusthed over tusindvis af tokens i konteksten.

Forbedret kodning, ræsonnering og “long-horizon”-adfærd

GLM-5 fremhæver forbedret kodegenerering og ræsonnering. Z.ai hævder målrettede forbedringer i modellens evne til at skrive, refaktorere og debugge kode, samt mere konsistent multitrins ræsonnering over lange interaktioner. Uafhængige tidlige adgangsrapporter og partnerevalueringer fandt modellen markant stærkere til udviklerorienterede opgaver end tidligere GLM-generationer.

Praktiske udviklerfunktioner

- Større kontekstvinduer til at rumme dokumentation, kodebaser og samtalestatus.

- Værktøjsprimitiver til sikker værktøjsinvokering og resultathåndtering.

- Bedre few-shot og chain-of-thought-ydeevne til at dekomponere og udføre komplekse opgaver.

- Agentiske funktioner og værktøjskald: GLM-5 fremhæver native support for agenter: funktions-/værktøjskald, stateful sessioner og bedre håndtering af lange dialoger og sekvenser af værktøjsbrug. Det gør det lettere at bygge agenter, der integrerer websøgnings-, database- eller opgaveautomatisering.

Hvordan klarer GLM-5 sig på benchmarks?

Specifikke benchmark-højdepunkter

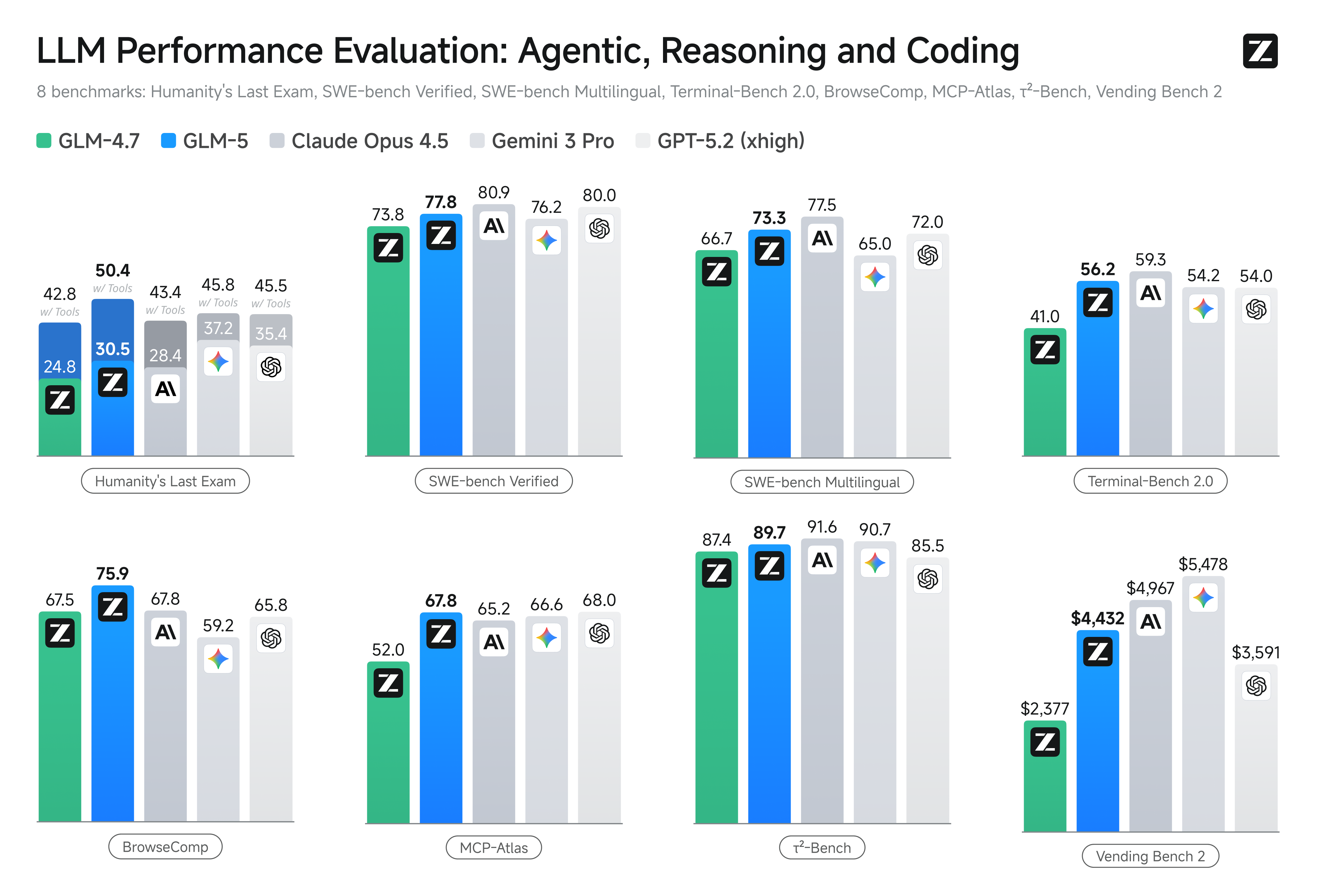

- Kodnings-benchmarks: GLM-5 nærmer sig (og i nogle tilfælde matcher) kodningsydelsen for højt optimerede proprietære modeller som Anthropic’s Claude Opus 4.5 på specifikke kodningsopgaver. Resultaterne afhænger af opgaven (enhedstests, algoritmisk kodning, API-brug), men de markerer en klar forbedring over GLM-4.5.

- Ræsonnerings- og agentiske tests: På multitrins ræsonnering og agentiske evalueringssæt (f.eks. multi-turn planlægning, opgavedekomponerings-benchmarks) opnåede GLM-5 bedste-inden-for-klassen resultater for open-source modeller og i nogle metrikker overgik konkurrerende lukkede modeller på målrettede opgaver.

Hvordan får jeg adgang til og prøver GLM-5?

GLM-5 er femte generation af stor sprogmodel fra Zhipu AI (Z.ai), bygget med en Mixture-of-Experts-arkitektur (~745 B total, ~44 B aktiv) og rettet mod stærk ræsonnering, kodning og agentiske arbejdsforløb. Den blev officielt lanceret omkring 12. feb. 2026.

Som det ser ud nu, er der to hovedmåder, folk får adgang til den:

A) Officiel API-adgang (Z.ai eller aggregatorer)

Zhipu AI tilbyder selv API’er til sine modeller, og du kan kalde GLM-5 via disse API’er.

Typiske trin:

- Opret en Z.ai/Open BigModel API-konto.

- Hent en API-nøgle fra dashboardet.

- Brug et OpenAPI-lignende eller REST API-endpoint med modelnavnet (f.eks.

glm-5). (På samme måde som du ville kalde GPT-modeller fra OpenAI). - Opsæt prompts og send HTTP-anmodninger.

👉 Z.ai’s prisside viser officielle GLM-5 token-priser som:

- ~$1.0 pr. million input tokens

- ~$3.2 pr. million output tokens

B) Tredjeparts API-wrappere —— CometAPI

API’er som CometAPI eller WaveSpeed samler flere AI-modeller (OpenAI, Claude, Z.ai osv.) bag en samlet grænseflade.

- Med tjenester som CometAPI kan du kalde GLM-modeller ved at skifte model-ID. (CometAPI understøtter i øjeblikket GLM-5/GLM-4.7.)

- CometAPI’s glm-5 er prissat til 20% af den officielle pris.

| Brugstype | Pris |

|---|---|

| Input tokens | ~$0.8 pr. 1M tokens |

| Output tokens | ~$2.56 pr. 1M tokens |

Hvorfor det er vigtigt: Du beholder din eksisterende OpenAI-kompatible klientkode og ændrer blot base-URL/model-ID.

C) Selv-hosting via Hugging Face / weights

Der findes uofficielle GLM-5 weight-repositorier (f.eks. versioner kaldet glm-5/glm-5-fp8) synlige i Hugging Face’s modellister.

Med dem kan du:

- Downloade modelweights.

- Bruge værktøjer som vLLM, SGLang, xLLM eller Transformers til at serve lokalt eller på din cloud-GPU-flåde.

Fordele: maksimal kontrol, ingen løbende API-omkostning.

Ulemper: meget store beregningskrav — sandsynligvis flere high-end GPU’er og hukommelse (flere hundrede GB), hvilket gør det upraktisk på små systemer.

Så — er GLM-5 det værd, og bør du beholde GLM-4.7?

Kort svar (lederresumé)

- Hvis dit arbejde kræver robust, multitrins agentisk adfærd, produktionsklar kodegenerering eller systemniveau-automatisering: GLM-5 er værd at evaluere med det samme. Dens arkitektur, skala og tuning prioriterer netop disse resultater.

- Hvis du har brug for omkostningseffektive, høj-gennemløbs mikrotjenester (kort chat, klassificering, lette prompts): GLM-4.7 er sandsynligvis stadig det mest økonomiske valg. GLM-4.7 bevarer en stærk kapabilitetsprofil til betydeligt lavere omkostning pr. token i mange udbyderlister og er allerede gennemprøvet.

Længere svar (praktisk anbefaling)

Adoptér en lagdelt modelstrategi: brug GLM-4.7 til daglige, højvolumen-interaktioner og reserver GLM-5 til højværdi-ingeniøropgaver og agentisk orkestrering. Pilotér GLM-5 på en lille produktdel, der belaster lang kontekst, værktøjsintegration og kodekorrekthed; mål både sparet ingeniørtid og den ekstra modelomkostning. Over tid vil du vide, om GLM-5’s kapacitetsløft retfærdiggør bredere migrering.

Med CometAPI, kan du skifte mellem GLM-4.7 og GLM-5 når som helst.

Virkelige anvendelser hvor GLM-5 skinner

1. Kompleks agentorkestrering

GLM-5’s designfokus på multitrins planlægning og værktøjskald gør den velegnet til systemer, der skal koordinere søgning, API-kald og programudførelse (for eksempel: automatiserede forskningsassistenter, iterative kodegeneratorer eller kundeservice-agenter i flere trin, der skal konsultere databaser og eksterne API’er).

2. Langformet engineering og ræsonnering over kodebaser

Når du har brug for, at modellen analyserer, refaktorerer eller syntetiserer på tværs af mange filer eller en stor kodebase, er GLM-5’s udvidede kontekst og sparsomme attention direkte fordele — færre fejlsituationer forårsaget af afkortet kontekst og bedre konsistens over lange spænd.

3. Videnstung syntese

Analytikere og produktteams, der genererer komplekse rapporter — flerafsnits forskningsbriefs, juridiske resuméer eller reguleringsindberetninger — kan drage fordel af modellens forbedringer i stabil multitrins ræsonnering og reducerede hallucinationer i leverandør-rapporterede tests.

4. Agentisk automatisering for arbejdsforløb

Teams, der bygger automatisering, som skal orkestrere flere systemer (f.eks. planlægning + ticketing + deployments-pipelines), kan bruge GLM-5 som den centrale planlægger og eksekverer, understøttet af værktøjskalds-rammer og sikkerheds-wrappere.

Konklusion

GLM-5 er en vigtig udgivelse i det hurtigt udviklende frontier-modellandskab. Dens fokus på agentisk engineering, forbedret kodning og ræsonnering samt åbne weights gør den attraktiv for teams, der bygger værktøjsaktiverede AI-systemer med lang horisont. Reelle gevinster i udvalgte opgaver og opmuntrende omkostnings-/ydelsesafvejninger — men købere bør evaluere GLM-5 mod deres specifikke opgaver og køre egne kontrollerede benchmarks, før de forpligter sig til produktion.

Udviklere kan få adgang til GLM-5 via CometAPI nu. For at komme i gang, udforsk modellens kapabiliteter i Playground og se API guide for detaljerede instruktioner. Inden adgang, sørg venligst for at du er logget ind på CometAPI og har fået API-nøglen. CometAPI tilbyder en pris langt under den officielle pris for at hjælpe dig med at integrere.

Klar til at gå i gang?→ Tilmeld dig til glm-5 i dag !

Hvis du vil kende flere tips, guides og nyheder om AI, så følg os på VK, X og Discord!