pr. 15. december 2025 viser offentlige fakta, at Google’s Gemini 3 Pro (preview) og OpenAI’s GPT-5.2 begge sætter nye grænser for ræsonnering, multimodalitet og arbejde med lang kontekst — men de vælger forskellige ingeniørveje (Gemini → sparsom MoE + enorm kontekst; GPT-5.2 → tætte/“routing”-design, kompaktering og x-high ræsonneringstilstande) og afvejer derfor topplaceringer i benchmarks vs. ingeniørmæssig forudsigelighed, værktøjer og økosystem. Hvad der er “bedre” afhænger af dit primære behov: ekstrem-kontekst, multimodale agentiske applikationer hælder mod Gemini 3 Pro; stabilt enterprise-udviklerværktøj, forudsigelige omkostninger og øjeblikkelig API-tilgængelighed favoriserer GPT-5.2.

Hvad er GPT-5.2, og hvad er dets vigtigste funktioner?

GPT-5.2 er OpenAI’s udgivelse den 11. december 2025 i GPT-5-familien (varianter: Instant, Thinking, Pro). Det er positioneret som virksomhedens mest kapable model til “professionelt vidensarbejde” — optimeret til regneark, præsentationer, lang-kontekst-ræsonnering, værktøjskald, kodegenerering og visionsopgaver. OpenAI gjorde GPT-5.2 tilgængelig for betalende ChatGPT-brugere og via OpenAI API (Responses API / Chat Completions) under modelnavne som gpt-5.2, gpt-5.2-chat-latest og gpt-5.2-pro.

Modelvarianter og tilsigtet brug

- gpt-5.2 / GPT-5.2 (Thinking) — bedst til kompleks, flertrins ræsonnering (standardvarianten “Thinking” brugt i Responses API).

- gpt-5.2-chat-latest / Instant — lav latens til daglig assistent- og chatbrug.

- gpt-5.2-pro / Pro — højeste troskab/pålidelighed til de sværeste problemer (ekstra compute, understøtter

reasoning_effort: "xhigh").

Centrale tekniske funktioner (brugerrettede)

- Forbedringer i vision og multimodalitet — bedre rumlig ræsonnering på billeder og forbedret videoforståelse, når den parres med kodetools (Python-værktøj), plus støtte til code-interpreter-lignende værktøjer til at køre snippets.

- Konfigurerbar ræsonneringsindsats (

reasoning_effort: none|minimal|low|medium|high|xhigh) til at afveje latens/omkostning vs. dybde.xhigher nyt for GPT-5.2 (og understøttes på Pro). - Forbedret lang-kontekst-håndtering og kompakteringsfunktioner til at ræsonnere over hundrede tusinder af tokens (OpenAI rapporterer stærke MRCRv2-/lang-kontekst-metrics).

- Avanceret værktøjskald og agentiske arbejdsforløb — stærkere multi-turn-koordinering, bedre orkestrering af værktøjer på tværs af en “single mega-agent”-arkitektur (OpenAI fremhæver Tau2-bench-værktøjsperformance).

Hvad er Gemini 3 Pro Preview?

Gemini 3 Pro Preview er Googles mest avancerede generative AI-model, udgivet som en del af den bredere Gemini 3-familie i november 2025. Modellen er bygget med fokus på multimodal forståelse — i stand til at forstå og syntetisere tekst, billeder, video og lyd — og har et stort kontekstvindue (~1 million tokens) til håndtering af omfattende dokumenter eller kodebaser.

Google positionerer Gemini 3 Pro som state-of-the-art i ræsonneringsdybde og nuance, og den fungerer som kerne-motoren for flere udvikler- og virksomhedsværktøjer, herunder Google AI Studio, Vertex AI og agentiske udviklingsplatforme som Google Antigravity.

Indtil videre er Gemini 3 Pro i preview — hvilket betyder, at funktionalitet og adgang stadig udvides, men modellen scorer allerede højt på logik, multimodal forståelse og agentiske arbejdsforløb.

Centrale tekniske & produktfunktioner

- Kontekstvindue: Gemini 3 Pro Preview understøtter et input-kontekstvindue på 1.000.000 tokens (og op til 64k tokens i output), hvilket er en markant praktisk fordel til at indlæse ekstremt store dokumenter, bøger eller videotransskripter i én forespørgsel.

- API-funktioner: parameteren

thinking_level(low/high) for at afveje latens og ræsonneringsdybde;media_resolution-indstillinger til at styre multimodal troskab og token-forbrug; søge-grounding, fil/URL-kontekst, kodeeksekvering og funktionskald er understøttet. Thought signatures og kontekst-caching hjælper med at fastholde tilstand på tværs af workflows med flere kald. - Deep Think-tilstand / højere ræsonnering: En “Deep Think”-mulighed giver et ekstra ræsonneringspas for at hæve scorerne på svære benchmarks. Google udgiver Deep Think som en separat højtydende vej til komplekse problemer.

- Multimodal native support: Tekst-, billed-, lyd- og video-input med tæt grounding til søgning og produktintegrationer (Video-MMMU-scorer og andre multimodale benchmarks fremhæves).

Hurtigt overblik — GPT-5.2 vs Gemini 3 Pro

Kompakt sammenligningstabel med de vigtigste fakta (kilder citeret).

| Aspect | GPT-5.2 (OpenAI) | Gemini 3 Pro (Google / DeepMind) |

|---|---|---|

| Vendor / positioning | OpenAI — flagskibsopgradering i GPT-5.x med fokus på professionelt vidensarbejde, kodning og agentiske workflows. | Google DeepMind / Google AI — flagskib i Gemini-generationen med fokus på ultralang-kontekst, multimodal ræsonnering og værktøjsintegration. |

| Main model flavors | Instant, Thinking, Pro (og Auto der skifter mellem dem). Pro tilføjer højere ræsonneringsindsats. | Gemini 3-familie inkl. Gemini 3 Pro og Deep-Think-tilstande; multimodal-/agentisk fokus. |

| Context window (input / output) | ~400.000 tokens total inputkapacitet; op til 128.000 output-/ræsonnerings-tokens (designet til meget lange dokumenter & kodebaser). | Op til ~1.000.000 tokens input/kontekstvindue (1M) med op til 64K tokens i output |

| Key strengths / focus | Lang-kontekst-ræsonnering, agentisk værktøjskald, kodning, strukturerede arbejdsopgaver (regneark, præsentationer); sikkerheds-/systemkortopdateringer fremhæver pålidelighed. | Multimodal forståelse i skala, ræsonnering + billedkomposition, meget stor kontekst + “Deep Think”-tilstand, stærke værktøjs-/agent-integrationer i Google-økosystemet. |

| Multimodal & image capabilities | Forbedret vision og multimodal grounding; tunet til værktøjsbrug og dokumentanalyse. | Højtrofast billedgenerering + ræsonneringsforstærket komposition, multi-reference billedredigering og læselig tekstrendering. |

| Latency / interactivity | Leverandøren fremhæver hurtigere inferens og prompt-respons (lavere latens end tidligere GPT-5.x-modeller); flere niveauer (Instant / Thinking / Pro). | Google fremhæver optimeret “Flash”/serving og sammenlignelige interaktive hastigheder for mange flows; Deep Think bytter latens for dybere ræsonnering. |

| Notable features / differentiators | Ræsonneringsindsats-niveauer (medium/high/xhigh), forbedret værktøjskald, kode af høj kvalitet, høj token-effektivitet til enterprise-workflows. | 1M token-kontekst, stærk native multimodal indlæsning (video/lyd), “Deep Think”-tilstand, tætte Google-produktintegrationer (Docs/Drive/NotebookLM). |

| Typical best uses (short) | Langdokumentanalyse, agentiske workflows, komplekse kodeprojekter, enterprise-automatisering (regneark/rapporter). | Ekstremt store multimodale projekter, lang-horisont agentiske workflows der kræver 1M-token-kontekst, avancerede billed- + ræsonneringspipelines. |

Hvordan sammenlignes GPT-5.2 og Gemini 3 Pro arkitektonisk?

Kernearkitektur

- Benchmarks / virkelighedsnære evalueringer: GPT-5.2 Thinking opnåede 70,9% sejre/uafgjorte på GDPval (44-erhverv eval for vidensarbejde) og store gevinster på ingeniør- og matematikbenchmarks vs. tidligere GPT-5-varianter. Markante forbedringer i kodning (SWE-Bench Pro) og domænevidenskabelig QA (GPQA Diamond).

- Værktøjer & agenter: Stærk indbygget støtte til værktøjskald, Python-eksekvering og agentiske workflows (dokumentsøgning, filanalyse, data science-agenter). 11x hastighed / <1% omkostning vs. menneskelige eksperter for nogle GDPval-opgaver (mål for potentiel økonomisk værdi, 70,9% vs. tidligere ~38,8%), og viser konkrete gevinster i regnearksmodellering (f.eks. +9,3% på en junior investment banking-opgave vs. GPT-5.1).

- Gemini 3 Pro: Sparse Mixture-of-Experts Transformer (MoE). Modellen aktiverer et lille sæt eksperter pr. token, hvilket muliggør ekstremt stor samlet parameterkapacitet med sublineær beregning pr. token. Google udgiver et modelkort, der præciserer, at den sparsomme MoE-udformning er en kernebidragyder til den forbedrede performanceprofil. Denne arkitektur gør det muligt at skubbe modelkapaciteten langt højere uden lineære inferensomkostninger.

- GPT-5.2 (OpenAI): OpenAI fortsætter med Transformer-baserede arkitekturer med routing/kompaktion-strategier i GPT-5-familien (en “router” udløser forskellige tilstande — Instant vs. Thinking — og virksomheden dokumenterer kompaktering og token-håndteringsteknikker til lange kontekster). GPT-5.2 lægger vægt på træning og evaluering til at “tænke før der svares” og kompaktering til lang-horisont-opgaver frem for at annoncere klassisk sparsom MoE i stor skala.

Konsekvenser af arkitekturerne

- Latens- & omkostningsafvejninger: MoE-modeller som Gemini 3 Pro kan tilbyde højere spidskapabilitet pr. token samtidig med at inferensomkostningen holdes lavere for mange opgaver, fordi kun et undersæt af eksperter kører. De kan dog tilføje kompleksitet i serving og planlægning (cold-start-ekspertbalancering, IO). GPT-5.2’s tilgang (tæt/rutet med kompaktering) favoriserer forudsigelig latens og udviklerergonomi — især når den integreres i etablerede OpenAI-værktøjer som Responses, Realtime, Assistants og batch-API’er.

- Skalering af lang kontekst: Geminis 1M input-token-kapabilitet lader dig give ekstremt lange dokumenter og multimodale strømme ind nativt. GPT-5.2’s ~400k kombinerede kontekst (input+output) er stadig massiv og dækker de fleste enterprise-behov, men er mindre end Geminis 1M-spec. Til meget store korpora eller multi-timers videotransskripter giver Geminis specifikation en klar teknisk fordel.

Værktøjer, agenter og multimodal plumbing

- OpenAI: dyb integration til værktøjskald, Python-eksekvering, “Pro”-ræsonneringstilstande og betalte agent-økosystemer (ChatGPT Agents / enterprise-værktøjsintegrationer. Stærkt fokus på kodecentriske workflows og generering af regneark/præsentationer som førsteklasses outputs.

- Google / Gemini: indbygget grounding til Google Search (valgfri betalt funktion), kodeeksekvering, URL- og filkontekst samt eksplicitte medieopløsningskontroller for at bytte tokens for visuel troskab. API’en tilbyder

thinking_levelog andre knapper til at tune omkostning/latens/kvalitet.

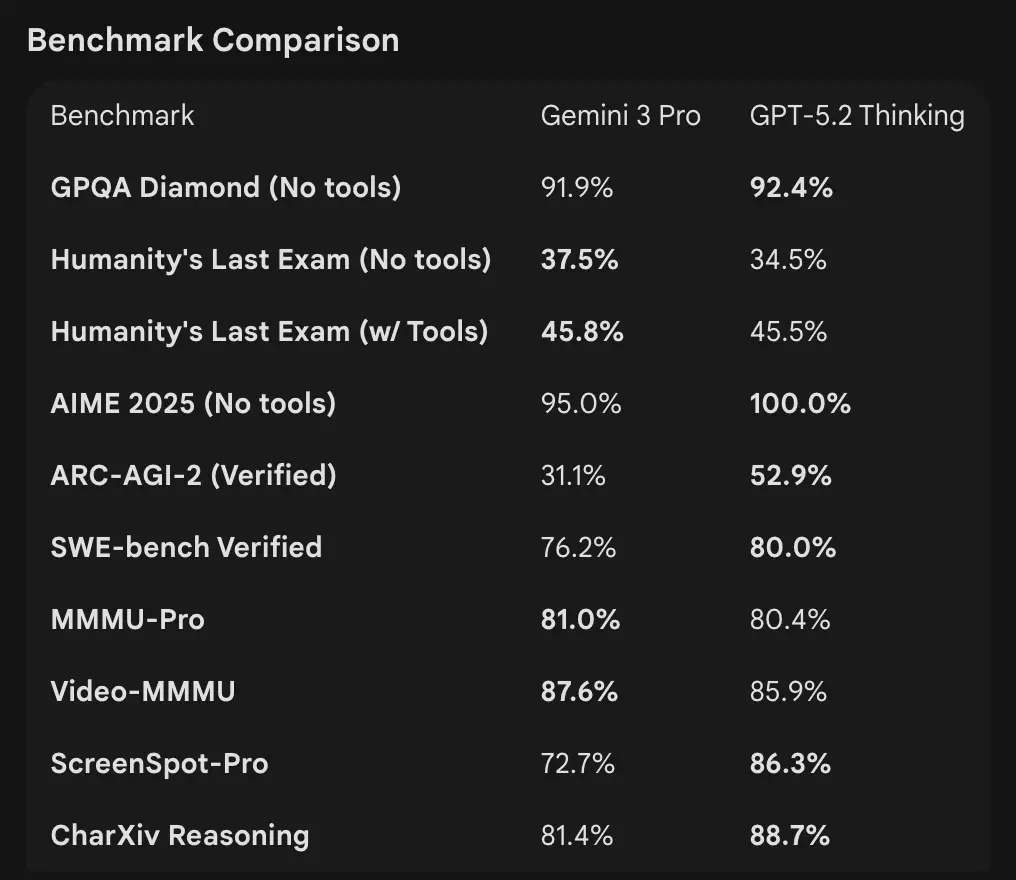

Hvordan ser benchmark-tallene ud i sammenligning

Kontekstvinduer og token-håndtering

- Gemini 3 Pro Preview: 1.000.000 input-tokens / 64k output-tokens (Pro preview modelkort). Vidensafskæring: januar 2025 (Google).

- GPT-5.2: OpenAI demonstrerer stærk lang-kontekst-performance (MRCRv2-scorer på tværs af 4k–256k “needle”-opgaver med >85–95% i mange indstillinger) og bruger kompakteringsfunktioner; OpenAI’s offentlige konteksteksempler indikerer robust performance selv ved meget store kontekster, men OpenAI lister variantspecifikke vinduer (og fremhæver kompaktering frem for et enkelt 1M-tal). Til API-brug er modelnavnene

gpt-5.2,gpt-5.2-chat-latest,gpt-5.2-pro.

Ræsonnering og agentiske benchmarks

- OpenAI (udvalg): Tau2-bench Telecom 98,7% (GPT-5.2 Thinking), stærke gevinster i flertrins værktøjsbrug og agentiske opgaver (OpenAI fremhæver kollaps af multi-agent-systemer til en “mega-agent”). GPQA Diamond og ARC-AGI viste trinstigninger over GPT-5.1.

- Google (udvalg): Gemini 3 Pro: LMArena 1501 Elo, MMMU-Pro 81%, Video-MMMU 87,6%, høje GPQA- og Humanity’s Last Exam-scorer; Google demonstrerer også stærk lang-horisont-planlægning via agentiske eksempler.

Værktøjer & agenter:

GPT-5.2: Stærk indbygget støtte til værktøjskald, Python-eksekvering og agentiske workflows (dokumentsøgning, filanalyse, data science-agenter). 11x hastighed / <1% omkostning vs. menneskelige eksperter for nogle GDPval-opgaver (mål for potentiel økonomisk værdi , 70,9% vs. tidligere ~38,8%), og viser konkrete gevinster i regnearksmodellering (f.eks. +9,3% på en junior investment banking-opgave vs. GPT-5.1).

Fortolkning: benchmarks er komplementære — OpenAI fremhæver virkelighedsnære vidensarbejds-benchmarks (GDPval), der viser, at GPT-5.2 udmærker sig i produktionstasks som regneark, slides og lange agentiske sekvenser. Google fremhæver rå ræsonnerings-leaderboards og ekstremt store kontekstvinduer i enkeltforespørgsler. Hvad der betyder mest, afhænger af din arbejdsbyrde: agentiske, langdokument-enterprise-pipelines favoriserer GPT-5.2’s dokumenterede GDPval-performance; indlæsning af massiv rå kontekst (f.eks. hele videokorpora / hele bøger i ét hug) favoriserer Geminis 1M inputvindue.

Hvordan sammenlignes multimodale kapabiliteter?

Inputs & outputs

- Gemini 3 Pro Preview: understøtter tekst, billede, video, lyd, PDF som input og tekst som output; Google tilbyder granulære

media_resolution-kontroller og enthinking_level-parameter til at tune pris vs. troskab i multimodalt arbejde. Output-tokenloft 64k; input op til 1M tokens. - GPT-5.2: understøtter rige vision- og multimodale workflows; OpenAI fremhæver forbedret rumlig ræsonnering (billedkomponenters estimerede afgrænsningsetiketter), videoforståelse (Video MMMU-scorer) og værktøjsaktiveret vision (Python-værktøj på visionsopgaver forbedrer scorer). GPT-5.2 fremhæver, at komplekse vision + kode-opgaver drager stor fordel af, at værktøjsstøtte (Python-kodeeksekvering) er aktiveret.

Praktiske forskelle

Granularitet vs. bredde: Gemini eksponerer et sæt multimodale knapper (media_resolution, thinking_level), designet til at lade udviklere tune afvejninger pr. medietype. GPT-5.2 lægger vægt på integreret værktøjsbrug (kør Python i løkken) for at kombinere vision, kode og datatransformationsopgaver. Hvis din brugssag er tung video + billedanalyse med ekstremt store kontekster, er Geminis 1M-kontekst overbevisende; hvis dine workflows kræver at eksekvere kode i løkken (datatransformationer, regnearksgenerering), kan GPT-5.2’s kodeværktøjer og agentvenlighed være mere bekvemme.

Hvad med API-adgang, SDK’er og priser?

OpenAI GPT-5.2 (API & prissætning)

- API:

gpt-5.2,gpt-5.2-chat-latest,gpt-5.2-provia Responses API / Chat Completions. Etablerede SDK’er (Python/JS), cookbook-guides og et modent økosystem. - Priser (offentlige): $1,75 / 1M input-tokens og $14 / 1M output-tokens; cache-rabatter (90% for cached inputs) reducerer den effektive pris for gentagne data. OpenAI fremhæver token-effektivitet (højere pris pr. token men færre samlede tokens for at nå en kvalitetsgrænse).

Gemini 3 Pro Preview (API & prissætning)

- API:

gemini-3-pro-previewvia Google GenAI SDK og Vertex AI/GenerativeLanguage-endpoints. Nye parametre (thinking_level,media_resolution) og integration med Googles groundings og værktøjer. - Priser (public preview): Omtrent $2 / 1M input-tokens og $12 / 1M output-tokens for preview-niveauer under 200k tokens; yderligere gebyrer kan gælde for Search-grounding, Maps eller andre Google-tjenester (Search-grounding-fakturering starter 5. januar 2026).

Brug GPT-5.2 og Gemini 3 via CometAPI

CometAPI er en gateway-/aggregator-API: et enkelt, OpenAI-stilet REST-API-endpoint, der giver dig samlet adgang til hundredvis af modeller fra mange leverandører (LLM’er, billede-/videomodeller, embeddings-modeller osv.). I stedet for at integrere mange leverandør-SDK’er, lader CometAPI dig kalde velkendte OpenAI-format-endpoints (chat/completions/embeddings/images), mens der skiftes model eller leverandør under motorhjelmen.

Udviklere kan bruge flagskibsmodeller fra to forskellige virksomheder samtidig via CometAPI uden at skifte leverandør, og API-priserne er mere overkommelige, typisk med 20% rabat.

Eksempel: hurtige API-snippets (kopiér-indsæt for at prøve)

Nedenfor er minimale eksempler, du kan køre. De afspejler leverandørernes offentliggjorte quickstarts (OpenAI Responses API + Google GenAI-klient). Erstat $OPENAI_API_KEY / $GEMINI_API_KEY med dine nøgler.

GPT-5.2 — Python (OpenAI Responses API, reasoning sat til xhigh til dybe problemer)

# Python (requires openai SDK that supports responses API)from openai import OpenAIclient = OpenAI(api_key="YOUR_OPENAI_API_KEY")resp = client.responses.create( model="gpt-5.2-pro", # gpt-5.2 or gpt-5.2-pro input="Summarize this 50k token company report and output a 10-slide presentation outline with speaker notes.", reasoning={"effort": "xhigh"}, # deeper reasoning max_output_tokens=4000)print(resp.output_text) # or inspect resp to get structured outputs / tokens

Noter: reasoning.effort lader dig bytte omkostning vs. dybde. Brug gpt-5.2-chat-latest til Instant chat-stil. OpenAI-dokumentationen viser eksempler for responses.create.

GPT-5.2 — curl (simpel)

curl https://api.openai.com/v1/responses \ -H "Authorization: Bearer $OPENAI_API_KEY" \ -H "Content-Type: application/json" \ -d '{ "model": "gpt-5.2", "input": "Write a Python function that converts a PDF with tables into a normalized CSV with typed columns.", "reasoning": {"effort":"high"} }'

(Undersøg JSON for output_text eller strukturerede outputs.)

Gemini 3 Pro Preview — Python (Google GenAI-klient)

# Python (google genai client) — example from Google docsfrom google import genaiclient = genai.Client(api_key="YOUR_GEMINI_API_KEY")response = client.models.generate_content( model="gemini-3-pro-preview", contents="Find the race condition in this multi-threaded C++ snippet: <paste code here>", config={ "thinkingConfig": {"thinking_level": "high"} })print(response.text)

Noter: thinking_level styrer modellens interne overvejelse; media_resolution kan sættes for billeder/videoer. REST- og JS-eksempler findes i Googles Gemini-udviklerguide.

Gemini 3 Pro — curl (REST)

curl "https://generativelanguage.googleapis.com/v1beta/models/gemini-3-pro-preview:generateContent" \ -H "x-goog-api-key: $GEMINI_API_KEY" \ -H "Content-Type: application/json" \ -X POST \ -d '{ "contents": [{ "parts": [{"text": "Explain the race condition in this C++ code: ..."}] }], "generationConfig": {"thinkingConfig": {"thinkingLevel": "high"}} }'

Googles dokumentation inkluderer multimodale eksempler (billede inline data, media_resolution).

Hvilken model er “bedst” — praktisk vejledning

Der findes ikke en one-size-fits-all “vinder”; vælg i stedet baseret på brugssag og begrænsninger. Nedenfor er en kort beslutningsmatrix.

Vælg GPT-5.2, hvis:

- Du har brug for tæt integration med kodeeksekveringsværktøjer (OpenAI’s interpreter-/værktøjsøkosystem) til programmatiske datapipelines, regnearksgenerering eller agentiske kodeworkflows. OpenAI fremhæver forbedringer i Python-værktøjet og agentisk mega-agent-brug.

- Du prioriterer token-effektivitet ifølge leverandørens påstande og ønsker eksplicit, forudsigelig OpenAI-prissætning pr. token med store rabatter på cached inputs (hjælper batch-/produktionsworkflows).

- Du ønsker OpenAI-økosystemet (ChatGPT-produktintegration, Azure / Microsoft-partnerskaber og værktøjer omkring Responses API og Codex).

Vælg Gemini 3 Pro, hvis:

- Du har brug for ekstrem multimodal input (video + billeder + lyd + pdf’er) og ønsker en enkelt model, der nativt accepterer alle disse input med et 1.000.000 token inputvindue. Google markedsfører dette eksplicit til lange videoer, store dokument + video-pipelines og interaktive Search/AI Mode-brugssager.

- Du bygger på Google Cloud / Vertex AI og ønsker tæt integration med Googles search-grounding, Vertex-provisionering og GenAI-klient-API’er. Du vil drage fordel af Google-produktintegrationer (Search AI Mode, AI Studio, Antigravity-agentværktøjer).

Konklusion: Hvilken er bedst i 2026?

I GPT-5.2 vs. Gemini 3 Pro Preview-opgøret er svaret kontekstuelt:

- GPT-5.2 fører i professionelt vidensarbejde, analytisk dybde og strukturerede workflows.

- Gemini 3 Pro Preview excellerer i multimodal forståelse, integrerede økosystemer og opgaver med stor kontekst.

Ingen model er universelt “bedre” — deres styrker komplementerer forskellige virkelighedsnære behov. Kloge adoptører bør matche modelvalget til specifikke brugssager, budgetbegrænsninger og økosystemtilpasning.

Hvad der står klart i 2026 er, at AI-fronten er rykket markant frem, og både GPT-5.2 og Gemini 3 Pro skubber grænserne for, hvad intelligente systemer kan opnå i enterprise og videre.

Hvis du vil prøve med det samme, kan du udforske GPT-5.2 og Gemini 3 Pro's kapabiliteter på CometAPI i Playground og konsultere API-guiden for detaljerede instruktioner. Før adgang, skal du sikre, at du er logget ind på CometAPI og har fået API-nøglen. CometAPI tilbyder en pris langt under den officielle pris for at hjælpe dig med integration.

Klar til at komme i gang?→ Free trial of GPT-5.2 and Gemini 3 Pro !

Hvis du vil