grok-kode-hurtig-1 er xAI's Hastighedsfokuseret, omkostningseffektiv agentkodningsmodel designet til at drive IDE-integrationer og automatiserede kodningsagenter. Det lægger vægt på lav latency, agentisk adfærd (værktøjskald, trinvise ræsonnementsspor) og en kompakt omkostningsprofil til daglige udviklerworkflows.

Nøglefunktioner (overblik)

- Høj kapacitet / lav latenstid: fokuseret på meget hurtig token-output og hurtige færdiggørelser til IDE-brug.

- Agentisk funktionskald og værktøjer: understøtter funktionskald og ekstern værktøjsorkestrering (kørselstests, linters, filhentning) for at aktivere flertrinskodningsagenter.

- Stort kontekstvindue: designet til at håndtere store kodebaser og kontekster med flere filer (udbydere angiver 256k kontekstvinduer i markedspladsadaptere).

- Synlig ræsonnement / spor: Svar kan omfatte trinvise ræsonnementsspor, der har til formål at gøre agentbeslutninger inspicerbare og fejlfindingsbare.

Tekniske detaljer

Arkitektur og træning: xAI siger, at grok-code-fast-1 blev bygget fra bunden med en ny arkitektur og et præ-træningskorpus rigt på programmeringsindhold; modellen modtog derefter post-træningskurering på pull-request/code-datasæt af høj kvalitet fra den virkelige verden. Denne engineering-pipeline er målrettet mod at lave modellen. Praktiske interne arbejdsgange for agenter (IDE + værktøjsbrug).

Servering og kontekst: grok-code-fast-1 og typiske brugsmønstre forudsætter streamingoutput, funktionskald og rig kontekstindsprøjtning (filuploads/samlinger). Adskillige cloud-markedspladser og platformadaptere angiver det allerede med stor kontekstunderstøttelse (256k kontekster i nogle adaptere).

Brugervenlighedsfunktioner: Synlig spor af ræsonnement (modellen viser dens planlægning/værktøjsbrug), vejledning til prompt engineering og eksempelintegrationer samt integrationer med tidlige lanceringspartnere (f.eks. GitHub Copilot, Cursor).

Benchmark-præstation (hvad den scorer på)

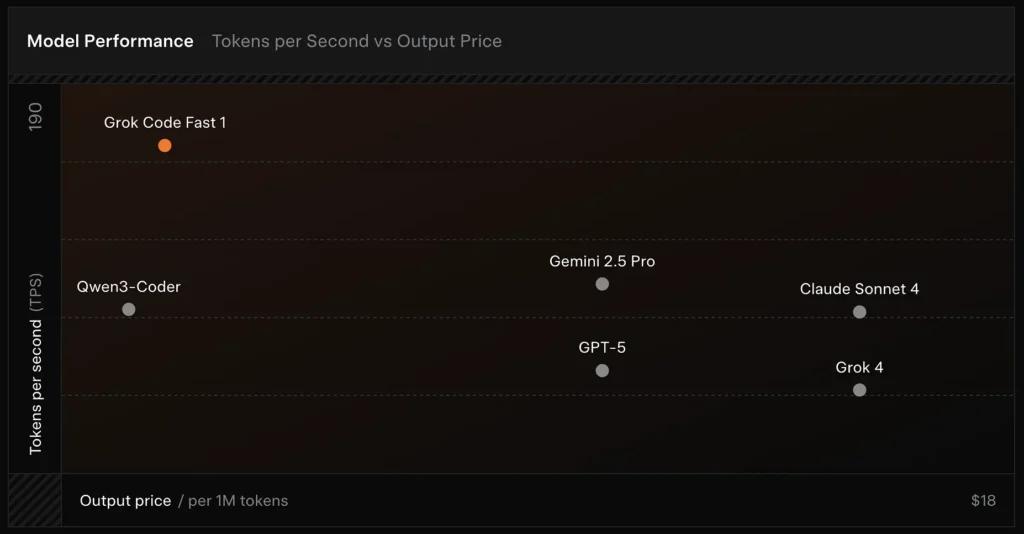

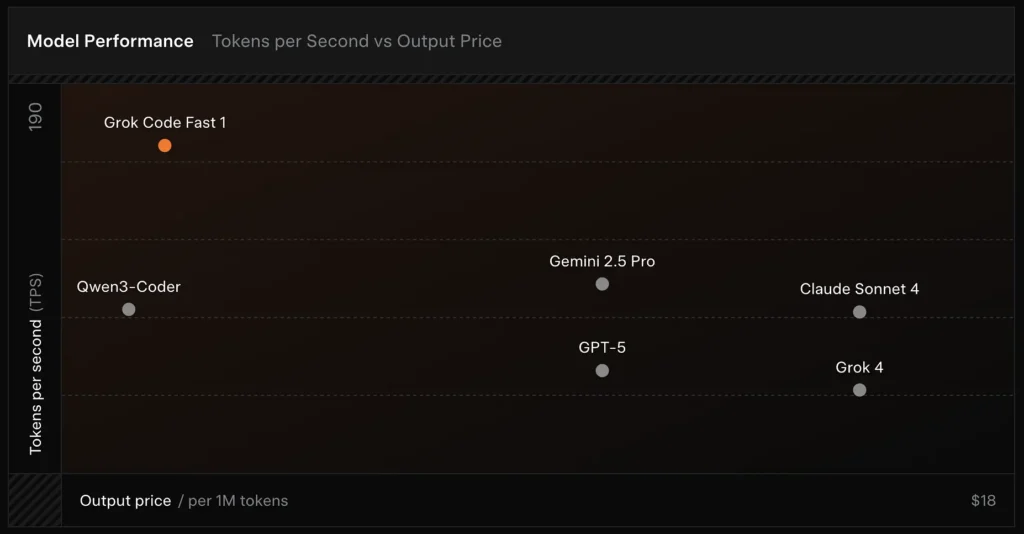

SWE-Bench-verificeret: xAI rapporterer en 70.8% score på deres interne harness i forhold til SWE-Bench-Verified-undergruppen – en benchmark, der almindeligvis bruges til sammenligning af softwareudviklingsmodeller. En nylig praktisk evaluering rapporterede en gennemsnitlig menneskelig vurdering ≈ 7.6 på en blandet kodningssuite — konkurrencedygtig med nogle modeller med høj værdi (f.eks. Gemini 2.5 Pro), men halter bag større multimodale/"bedste ræsonnement"-modeller som Claude Opus 4 og xAI's egen Grok 4 på ræsonnementsopgaver med høj sværhedsgrad. Benchmarks viser også varians efter opgave: fremragende til almindelige fejlrettelser og præcis kodegenerering, svagere på nogle niche- eller biblioteksspecifikke problemer (Tailwind CSS-eksempel).

Sammenligning:

- vs Grok 4: Grok-code-fast-1 bytter noget absolut korrekthed og dybere ræsonnement for meget lavere omkostninger og hurtigere gennemløbGrok 4 er fortsat den mere effektive løsning.

- vs Claude Opus / GPT-klassen: Disse modeller fører ofte an i komplekse, kreative eller vanskelige ræsonnementsopgaver; Grok-code-fast-1 konkurrerer godt på rutinemæssige udvikleropgaver med høj volumen, hvor latenstid og omkostninger betyder noget.

Begrænsninger og risici

Praktiske begrænsninger observeret indtil videre:

- Domænehuller: ydeevnedyk på nichebiblioteker eller usædvanligt formulerede problemer (eksempler inkluderer Tailwind CSS edge cases).

- Afvejning mellem ræsonnement og token-omkostninger: Fordi modellen kan udsende interne ræsonnementstokens, kan meget agentisk/verbose ræsonnement øge inferensoutputlængden (og omkostningerne).

- Nøjagtighed / kanttilfælde: Grok-code-fast-1 er stærk på rutineopgaver, men kan hallucinere eller producere forkert kode til nye algoritmer eller modstridende problemformuleringer; det kan underpræstere i forhold til topmodeller med fokus på ræsonnement på krævende algoritmiske benchmarks.

Typiske brugssager

- IDE-assistance og hurtig prototyping: hurtige færdiggørelser, trinvise kodeskrivninger og interaktiv fejlfinding.

- Automatiserede agenter / kodearbejdsgange: agenter, der orkestrerer tests, kører kommandoer og redigerer filer (f.eks. CI-hjælpere, bot-anmeldere).

- Daglige ingeniøropgaver: generering af kodeskeletter, refactorings, forslag til fejlvurdering og scaffolding af projekter med flere filer, hvor lav latenstid forbedrer udviklerflowet væsentligt.

Sådan kalder du grok-code-fast-1 API fra CometAPI

grok-code-fast-1 API-priser i CometAPI, 20 % rabat på den officielle pris:

- Input-tokens: $0.16/M tokens

- Output-tokens: $2.0/M-tokens

Påkrævede trin

- Log ind på cometapi.com. Hvis du ikke er vores bruger endnu, bedes du registrere dig først

- Få adgangslegitimations-API-nøglen til grænsefladen. Klik på "Tilføj token" ved API-tokenet i det personlige center, få token-nøglen: sk-xxxxx og send.

Brug metoden

- Vælg "

grok-code-fast-1” endepunkt for at sende API-anmodningen og indstille anmodningsteksten. Forespørgselsmetoden og anmodningsteksten er hentet fra vores websteds API-dokument. Vores websted tilbyder også Apifox-test for din bekvemmelighed. - Erstatte med din faktiske CometAPI-nøgle fra din konto.

- Indsæt dit spørgsmål eller din anmodning i indholdsfeltet – det er det, modellen vil reagere på.

- . Behandle API-svaret for at få det genererede svar.

CometAPI leverer en fuldt kompatibel REST API – til problemfri migrering. Vigtige detaljer til API-dok:

- Basis URL: https://api.cometapi.com/v1/chat/completions

- Modelnavne: "

grok-code-fast-1" - Godkendelse: Bærertoken via

Authorization: Bearer YOUR_CometAPI_API_KEYheader - Indholdstype:

application/json.

API-integration og eksempler

Python-kodestykke til et Chatafslutning kald gennem CometAPI:

pythonimport openai

openai.api_key = "YOUR_CometAPI_API_KEY"

openai.api_base = "https://api.cometapi.com/v1/chat/completions"

messages = [

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": "Summarize grok-code-fast-1's main features."}

]

response = openai.ChatCompletion.create(

model="grok-code-fast-1",

messages=messages,

temperature=0.7,

max_tokens=500

)

print(response.choices.message)

Se også Grok 4