DeepSeek har udgivet en eksperimenterende model kaldet DeepSeek-V3.2-Exp on September 29, 2025, introducerer en ny sparse-attention-mekanisme (DeepSeek Sparse Attention, eller DSA), der sigter mod meget lavere inferensomkostninger for lange kontekst-arbejdsbelastninger - og virksomheden skar samtidig API-priserne med omtrent halvdelen. Denne guide forklarer, hvad modellen er, arkitektur-/funktionshøjdepunkterne, hvordan man får adgang til og bruger API'en (med kodeeksempler), hvordan den sammenlignes med tidligere DeepSeek-modeller, og hvordan man analyserer og håndterer dens svar i produktion.

Hvad er DeepSeek-V3.2-Exp?

DeepSeek-V3.2-Exp er en eksperimentel iteration i DeepSeeks V3-spor. Udgivelsen – annonceret i slutningen af september 2025 – er positioneret som et "mellemliggende" trin, der validerer arkitektoniske optimeringer for udvidede kontekstlængder snarere end som et stort spring i rå nøjagtighed. Dens vigtigste innovation er DeepSeek Sparse Attention (DSA), et opmærksomhedsmønster, der selektivt fokuserer på dele af et langt input for at reducere beregnings- og hukommelsesomkostninger, samtidig med at outputkvaliteten holdes sammenlignelig med V3.1-Terminus.

Hvorfor det er vigtigt i praksis:

- Omkostninger for opgaver med lang kontekst: DSA er rettet mod de kvadratiske opmærksomhedsomkostninger og reducerer beregningsbehovet for meget lange input (tænk på hentning af flere dokumenter, lange transskriptioner, store spilverdener). API-brugsomkostningerne er væsentligt lavere for typiske anvendelsesscenarier med lang kontekst.

- Kompatibilitet og tilgængelighed: DeepSeek API'en bruger et OpenAI-kompatibelt anmodningsformat, så mange eksisterende OpenAI SDK-arbejdsgange kan hurtigt tilpasses.

Hvad er hovedfunktionerne og arkitekturen i DeepSeek V3.2-Exp?

Hvad er DeepSeek Sparse Attention (DSA), og hvordan fungerer det?

DSA er en finkornet sparsom opmærksomhed et skema designet til at være selektivt opmærksom på tokens i stedet for at beregne tæt opmærksomhed på tværs af hele konteksten. Kort sagt:

- Modellen vælger dynamisk delmængder af tokens, der skal tages hånd om på hvert lag eller blok, hvilket reducerer FLOP'er for lange inputlængder.

- Udvælgelsen er designet til at bevare den "vigtige" kontekst for ræsonnementsopgaver ved at udnytte en kombination af lærte udvælgelsespolitikker og routingheuristikker.

DSA som den centrale innovation i V3.2-Exp, der har til formål at holde outputkvaliteten tæt på modeller med tæt opmærksomhed, samtidig med at inferensomkostningerne reduceres, især når kontekstlængderne vokser. Udgivelsesnoterne og modelsiden understreger, at træningskonfigurationerne blev justeret med V3.1-Terminus, så forskelle i benchmark-målinger afspejler den sparse attention-mekanisme snarere end en generel ændring i træningen.

Hvilke andre arkitekturer/funktioner følger med V3.2-Exp?

- Hybride tilstande (tænkning vs. ikke-tænkning): DeepSeek eksponerer to model-ID'er:

deepseek-chat(ikke-tænkende / hurtigere svar) ogdeepseek-reasoner(tænketilstand, der kan eksponere indhold af tankekæder eller mellemliggende ræsonnement). Disse tilstande giver udviklere mulighed for at vælge hastighed kontra eksplicit ræsonnementsgennemsigtighed. - Meget store kontekstvinduer: V3.x-familien understøtter meget store kontekster (V3-linjen giver DeepSeek 128K kontekstmuligheder i aktuelle opdateringer), hvilket gør den velegnet til arbejdsgange med flere dokumenter, lange logfiler og agenter med stor viden.

- JSON-output og strict-funktionskald (Beta): API'en understøtter en

response_formatobjekt, der kan fremtvinge JSON-output (og en streng betaversion af funktionskald). Dette er nyttigt, når du har brug for forudsigelige maskinparsebare output til værktøjsintegration. - Streaming- og ræsonnementstokens: API'en understøtter streaming af svar og – for ræsonnementmodeller – distinkte tokens for ræsonnementsindhold (ofte eksponeret under

reasoning_content), som giver dig mulighed for at vise eller revidere modellens mellemliggende trin.

Hvordan får jeg adgang til og bruger DeepSeek-V3.2-Exp API'en via CometAPI?

DeepSeek beholder bevidst et OpenAI-lignende API-format – så eksisterende OpenAI SDK'er eller kompatible værktøjer kan målrettes med en anden basis-URL. Jeg anbefaler at bruge CometAPI til at få adgang til DeepSeek-V3.2-Exp, fordi det er billigt og en multimodal aggregeringsgateway. DeepSeek eksponerer modelnavne, der er knyttet til V3.2-Exp-adfærden. Eksempler:

DeepSeek-V3.2-Exp-thinking — ræsonnements-/tænketilstand kortlagt til V3.2-Exp.

DeepSeek-V3.2-Exp-thinking — ikke-ræsonnement/chat-tilstand kortlagt til V3.2-Exp.

Hvordan autentificerer jeg, og hvad er basis-URL'en?

- Få en API-nøgle fra CometAPI-udviklerkonsollen (ansøg på deres hjemmeside).

- Basis URL: (

https://api.cometapi.comorhttps://api.cometapi.com/v1(for OpenAI-kompatible stier). OpenAI-kompatibiliteten betyder, at mange OpenAI SDK'er kan omdirigeres til DeepSeek med små ændringer.

Hvilke model-ID'er skal jeg bruge?

DeepSeek-V3.2-Exp-thinking— tænketilstand, afdækker indhold i tankekæden/ræsonnementet. Begge blev opgraderet til V3.2-Exp i de seneste udgivelsesnoter.DeepSeek-V3.2-Exp-nothinking— ikke-tænkning, hurtigere svar, typisk chat/fuldførelsesbrug.

Eksempel: simpel curl-anmodning (chatafslutning)

curl -s https://api.cometapi.com/v1/chat/completions \

-H "Authorization: Bearer $cometapi_API_KEY" \

-H "Content-Type: application/json" \

-d '{

"model": "deepseek-v3.2-exp",

"messages": [

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": "Summarize the attached meeting transcript in 3 bullet points."}

],

"max_tokens": 512,

"stream": false

}'

Eksempel: Python (OpenAI-kompatibelt klientmønster)

Dette mønster fungerer efter at en OpenAI-klient er blevet peget på CometAPI's basis-URL (eller ved hjælp af CometAPI's SDK). Eksemplet nedenfor følger DeepSeeks dokumentationsstil:

import os

import requests

API_KEY = os.environ

url = "https://api.deepseek.com/v1/chat/completions"

headers = {

"Authorization": f"Bearer {API_KEY}",

"Content-Type": "application/json"

}

payload = {

"model": "deepseek-v3.2-exp",

"messages": [

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": "Extract action items from the following notes..."}

],

"max_tokens": 800

}

r = requests.post(url, headers=headers, json=payload)

r.raise_for_status()

print(r.json())

Ingen særlig SDK er påkrævet — men hvis du allerede bruger OpenAIs SDK, kan du ofte omkonfigurere base_url og api_key og behold de samme opkaldsmønstre.

Avanceret brug: muliggør ræsonnement eller reasoning_content

Hvis du har brug for modellens interne tankekæde (til revision, destillation eller udtrækning af mellemtrin), skal du skifte til DeepSeek-V3.2-Exp-thinking. Det reasoning_content feltet (og relaterede strømme eller tokens) er tilgængeligt i svaret for ræsonnementtilstand; API-dokumentationen leverer reasoning_content som et svarfelt for at inspicere den genererede CoT før det endelige svar. Bemærk: Eksponering af disse tokens kan påvirke faktureringen, da de er en del af modeloutputtet.

Streaming og delvise opdateringer

- Brug

"stream": truei anmodninger om at modtage token-deltaer via SSE (server-sendte hændelser). stream_optionsoginclude_usagelader dig justere, hvordan og hvornår brugsmetadata vises under en stream (nyttigt til trinvise brugergrænseflader).

Hvordan klarer DeepSeek-V3.2-Exp sig i forhold til tidligere DeepSeek-modeller?

V3.2-Exp vs. V3.1-Terminus

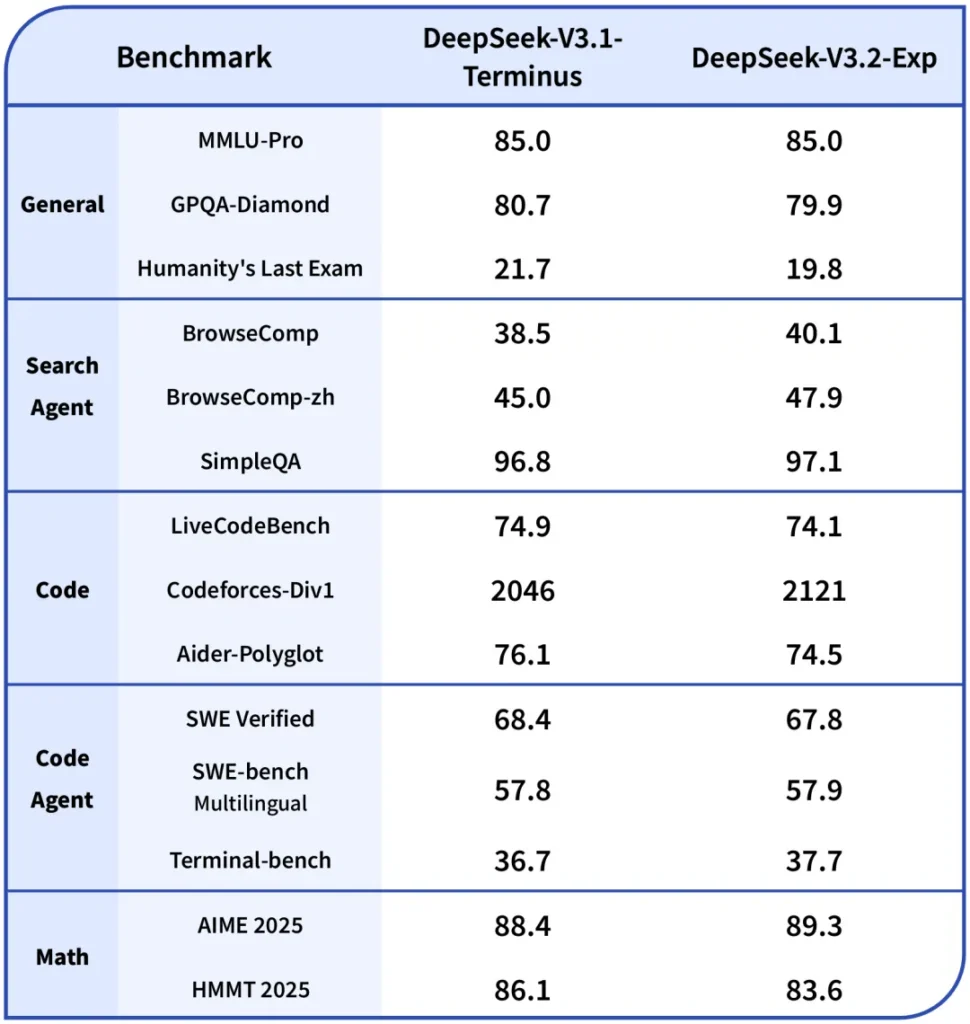

- Primær forskel: V3.2-Exp introducerer den sparse attention-mekanisme for at reducere beregningsbehovet i lange kontekster, samtidig med at resten af træningsopskriften holdes i overensstemmelse med V3.1. Dette gjorde det muligt for DeepSeek at lave en renere sammenligning af effektivitetsgevinster. ()

- benchmarks: Offentlige noter viser, at V3.2-Exp klarer sig nogenlunde på niveau med V3.1 på mange ræsonnements-/kodningsopgaver, samtidig med at den er betydeligt billigere på lange kontekster. Bemærk, at specifikke opgaver stadig kan have mindre regressioner afhængigt af, hvordan opmærksomhedssparsitet interagerer med de nødvendige token-interaktioner.

V3.2-Exp vs R1 / Ældre udgivelser

- R1- og V3-linjerne følger forskellige designmål (R1 fokuserede historisk set på forskellige arkitektoniske afvejninger og multimodale kapaciteter i nogle brancher). V3.2-Exp er en forbedring i V3-familien med fokus på lange kontekster og gennemløb. Hvis din arbejdsbyrde er tung på benchmarks for rå nøjagtighed i én tur, kan forskellene være beskedne; hvis du opererer på pipelines med flere dokumenter, er V3.2-Exps omkostningsprofil sandsynligvis mere attraktiv.

Hvor man kan få adgang til Claude Sonnet 4.5

CometAPI er en samlet API-platform, der samler over 500 AI-modeller fra førende udbydere – såsom OpenAIs GPT-serie, Googles Gemini, Anthropics Claude, Midjourney, Suno og flere – i en enkelt, udviklervenlig grænseflade. Ved at tilbyde ensartet godkendelse, formatering af anmodninger og svarhåndtering forenkler CometAPI dramatisk integrationen af AI-funktioner i dine applikationer. Uanset om du bygger chatbots, billedgeneratorer, musikkomponister eller datadrevne analysepipelines, giver CometAPI dig mulighed for at iterere hurtigere, kontrollere omkostninger og forblive leverandøruafhængig – alt imens du udnytter de seneste gennembrud på tværs af AI-økosystemet.

Udviklere kan få adgang DeepSeek V3.2 Exp gennem Comet API, den nyeste modelversion opdateres altid med den officielle hjemmeside. For at begynde, udforsk modellens muligheder i Legeplads og konsulter API guide for detaljerede instruktioner. Før du får adgang, skal du sørge for at være logget ind på CometAPI og have fået API-nøglen. CometAPI tilbyde en pris, der er langt lavere end den officielle pris, for at hjælpe dig med at integrere.

Klar til at gå? → Tilmeld dig CometAPI i dag !

Konklusion

DeepSeek-V3.2-Exp er en pragmatisk eksperimentel udgivelse, der har til formål at gøre langkontekstarbejde billigere og mere muligt, samtidig med at outputkvaliteten i V3-klassen bevares. For teams, der arbejder med lange dokumenter, transskriptioner eller argumentation med flere dokumenter, er den værd at afprøve: API'en følger en OpenAI-lignende grænseflade, der gør integrationen ligetil, og den fremhæver både DSA-mekanismen og meningsfulde prisreduktioner, der ændrer den økonomiske kalkulus ved at bygge i stor skala. Som med enhver eksperimentel model er omfattende evaluering, instrumentering og trinvis udrulning afgørende.