GLM-4.5-serien, udviklet af Zhipu AI (Z.ai), repræsenterer et betydeligt fremskridt inden for open source-store sprogmodeller (LLM'er). GLM-4.5 er designet til at forene ræsonnement, kodning og agentfunktioner og tilbyder robust ydeevne på tværs af forskellige applikationer. Uanset om du er udvikler, forsker eller entusiast, giver denne guide detaljerede oplysninger om, hvordan du får adgang til og bruger GLM-4.5-serien effektivt.

Hvad er GLM-4.5-serien, og hvorfor er den vigtig?

GLM-4.5 er en hybrid ræsonnementsmodel, der kombinerer to forskellige tilstande: en "tænketilstand" til kompleks ræsonnement og værktøjsbrug, og en "ikke-tænketilstand" til øjeblikkelige reaktioner. Denne dobbelttilstandstilgang gør det muligt for modellen at håndtere en bred vifte af opgaver effektivt. Serien indeholder to hovedvarianter:

- GLM-4.5Med 355 milliarder parametre i alt med 32 milliarder aktive parametre er denne model designet til storstilet implementering på tværs af ræsonnement, generering og opgaver med flere agenter.

- GLM-4.5-AirEn letvægtsversion med 106 milliarder parametre i alt og 12 milliarder aktive parametre, optimeret til cloud-inferens på enheder og i mindre skala uden at ofre kernefunktioner.

Begge modeller understøtter hybride ræsonnementtilstande, der tilbyder "tænkende" og "ikke-tænkende" tilstande for at balancere komplekse ræsonnementsopgaver og hurtige svar. De er open source og udgivet under MIT-licensen, hvilket gør dem tilgængelige til kommerciel brug og sekundær udvikling.

Arkitektur- og designprincipper

I sin kerne udnytter GLM-4.5 MoE til dynamisk at dirigere tokens gennem specialiserede ekspert-undernetværk, hvilket muliggør overlegen parametereffektivitet og skaleringsadfærd (). Denne tilgang betyder, at færre parametre skal aktiveres pr. fremadrettet gennemløb, hvilket reducerer driftsomkostningerne, samtidig med at den avancerede ydeevne på ræsonnement- og kodningsopgaver opretholdes ().

Nøglefunktioner

- Hybrid ræsonnement og kodningGLM-4.5 demonstrerer SOTA-ydeevne på både benchmarks for forståelse af naturligt sprog og kodegenereringstests og konkurrerer ofte med proprietære modeller i nøjagtighed og flydende tekst.

- AgentintegrationIndbyggede værktøjskaldsgrænseflader gør det muligt for GLM-4.5 at orkestrere flertrinsarbejdsgange – såsom databaseforespørgsler, API-orkestrering og interaktiv frontend-generering – i en enkelt session.

- Multimodale artefakterFra HTML/CSS-miniapps til Python-baserede simuleringer og interaktive SVG'er kan GLM-4.5 producere fuldt funktionelle artefakter, hvilket forbedrer brugerengagement og udviklerproduktivitet.

Hvorfor er GLM-4.5 banebrydende?

GLM-4.5 er blevet rost ikke kun for sin rå ydeevne, men også for at omdefinere værdiskabelsen af open source LLM'er i virksomheds- og forskningsmiljøer.

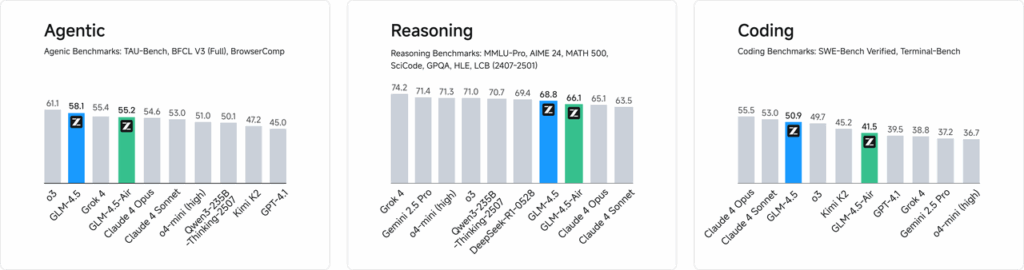

Performance benchmarks

I uafhængige evalueringer på tværs af 52 programmeringsopgaver – der spænder over webudvikling, dataanalyse og automatisering – overgik GLM-4.5 konsekvent andre førende open source-modeller i pålidelighed af værktøjskald og samlet opgaveudførelse. I sammenlignende tests mod Claude Code, Kimi-K2 og Qwen3-Coder opnåede GLM-4.5 de bedste scorer i sin klasse på benchmarks som f.eks. "SWE-bench Verified"-leaderboardet.

Omkostningseffektivitet

Ud over nøjagtighed reducerer GLM-4.5's MoE-design inferensomkostningerne dramatisk. Offentlig prissætning for API-kald starter så lavt som RMB 0.8 pr. million input-tokens og RMB 2 pr. million output-tokens - cirka en tredjedel af omkostningerne ved sammenlignelige proprietære tilbud. Kombineret med peakgenereringshastigheder på 100 tokens/sek. understøtter modellen implementeringer med høj gennemløbshastighed og lav latenstid uden uoverkommelige omkostninger.

Hvordan kan du få adgang til GLM-4.5?

1. Direkte adgang via Z.ai-platformen

Den mest ligefremme metode til at interagere med GLM-4.5 er via Z.ai-platformen. Ved at besøge chat.z.ai, kan brugerne vælge GLM-4.5-modellen og begynde at interagere via en brugervenlig grænseflade. Denne platform muliggør øjeblikkelig testning og prototyping uden behov for komplekse integrationer. Brugere kan vælge enten GLM-4.5- eller GLM-4.5-Air-modellen i øverste venstre hjørne og begynde at chatte med det samme. Denne grænseflade er brugervenlig og kræver ingen opsætning, hvilket gør den ideel til hurtige interaktioner og demonstrationer.

2. API-adgang for udviklere

For udviklere, der ønsker at integrere GLM-4.5 i applikationer, tilbyder Z.ai API-platformen omfattende support. API'en tilbyder OpenAI-kompatible grænseflader til både GLM-4.5- og GLM-4.5-Air-modeller, hvilket muliggør problemfri integration i eksisterende arbejdsgange. Detaljeret dokumentation og integrationsretningslinjer er tilgængelige på Z.ai API-dokumentation .

3. Open source-implementering

For dem, der er interesserede i lokal implementering, er GLM-4.5-modeller tilgængelige på platforme som Hugging Face og ModelScope. Disse modeller er udgivet under MIT open source-licensen, hvilket giver mulighed for kommerciel brug og sekundær udvikling. De kan integreres med mainstream inferensframeworks som vLLM og SGLang.

4. Integration med CometAPI

CometAPI tilbyder strømlinet adgang til GLM-4.5-modeller via deres samlede API-platform på DasboradDenne integration forenkler godkendelse, hastighedsbegrænsning og fejlhåndtering, hvilket gør den til et fremragende valg for udviklere, der søger en problemfri opsætning. Derudover muliggør CometAPIs standardiserede API-format nem modelskift og A/B-testning mellem GLM-4.5 og andre tilgængelige modeller.

Hvordan kan udviklere få adgang til GLM-4.5-serien?

Der er flere kanaler til at hente og implementere GLM-4.5, fra direkte modeldownloads til administrerede API'er.

Via Hugging Face og ModelScope

Både Hugging Face og ModelScope hoster hele GLM-4.5-serien under navneområdet zai-org. Efter at have accepteret MIT-licensen kan udviklere:

- Klon depotet:

git clone https://huggingface.co/zai-org/GLM-4.5

- Installer afhængigheder:

pip install transformers accelerate

- Indlæs modellen:

from transformers import AutoModelForCausalLM, AutoTokenizer

tokenizer = AutoTokenizer.from_pretrained("zai-org/GLM-4.5")

model = AutoModelForCausalLM.from_pretrained("zai-org/GLM-4.5")

``` :contentReference{index=15}.

Gennem Comet API

CometAPI leverer en serverløs API til GLM-4.5 og GLM-4.5 Air API Til betaling pr. token, tilgængelig via, ved at konfigurere OpenAI-kompatible slutpunkter, kan du kalde GLM-4.5 gennem OpenAIs Python-klient med minimale justeringer af eksisterende kodebaser. CometAPI leverer ikke kun GLM4.5 og GLM-4.5-air, men også alle officielle modeller:

| Modelnavn | indføre | Pris |

glm-4.5 | Vores mest kraftfulde ræsonnementsmodel med 355 milliarder parametre | Input-tokens $0.48 Output-tokens $1.92 |

glm-4.5-air | Omkostningseffektiv Letvægts Stærk Ydeevne | Input-tokens $0.16 Output-tokens $1.07 |

glm-4.5-x | Højtydende, stærk ræsonnement, ultrahurtig respons | Input-tokens $1.60 Output-tokens $6.40 |

glm-4.5-airx | Letvægts, stærk ydeevne, ultrahurtig respons | Input-tokens $0.02 Output-tokens $0.06 |

glm-4.5-flash | Stærk ydeevne Fremragende til ræsonnement, kodning og agenter | Input-tokens $3.20 Output-tokens $12.80 |

Python og REST API-integration

Til skræddersyede implementeringer kan organisationer hoste GLM-4.5 på dedikerede GPU-klynger ved hjælp af Docker eller Kubernetes. En typisk RESTful-opsætning involverer:

Start af inferensserver:

bashdocker run -p 8000:8000 zai-org/glm-4.5:latest

Afsendelse af anmodninger:

bashcurl -X POST http://localhost:8000/generate \ -H "Content-Type: application/json" \ -d '{"prompt": "Translate to French: Hello.", "max_tokens": 50}' Responses conform to the JSON formats used by popular LLM APIs .

Hvad er bedste praksis for integration af GLM-4.5 i applikationer?

For at maksimere ROI og sikre robust præstation bør teams overveje følgende:

API-optimering og hastighedsgrænser

- Batching-anmodningerGruppér lignende prompts for at reducere overhead og udnytte GPU-gennemstrømning.

- Cachelagring af almindelige forespørgslerGem hyppige fuldførelser lokalt for at undgå redundante inferenskald.

- Adaptiv prøveudtagningDynamisk justering

temperatureogtop_pbaseret på forespørgselskompleksitet for at balancere kreativitet og determinisme.

Sikkerhed og Compliance

- DatasaneringForbehandling af input for at fjerne følsomme oplysninger, før de sendes til modellen.

- AdgangskontrolImplementer API-nøgler, IP-tilladelseslister og hastighedsbegrænsning for at forhindre misbrug og overgreb.

- RevisionslogningRegistrer prompter, fuldførelser og metadata for at overholde virksomheds- og lovgivningsmæssige krav, især i finans- eller sundhedssammenhænge.

Kom godt i gang

CometAPI er en samlet API-platform, der samler over 500 AI-modeller fra førende udbydere – såsom OpenAIs GPT-serie, Googles Gemini, Anthropics Claude, Midjourney, Suno og flere – i en enkelt, udviklervenlig grænseflade. Ved at tilbyde ensartet godkendelse, formatering af anmodninger og svarhåndtering forenkler CometAPI dramatisk integrationen af AI-funktioner i dine applikationer. Uanset om du bygger chatbots, billedgeneratorer, musikkomponister eller datadrevne analysepipelines, giver CometAPI dig mulighed for at iterere hurtigere, kontrollere omkostninger og forblive leverandøruafhængig – alt imens du udnytter de seneste gennembrud på tværs af AI-økosystemet.

For udviklere, der ønsker at integrere GLM-4.5 i deres applikationer, tilbyder CometAPI-platformen en robust løsning. API'en leverer OpenAI-kompatible grænseflader, der muliggør problemfri integration i eksisterende arbejdsgange. Detaljeret dokumentation og brugsvejledning er tilgængelig på Comet API-side.

Udviklere kan få adgang GLM-4.5 og GLM-4.5 Air API ved CometAPI, de seneste modelversioner, der er anført, er fra artiklens udgivelsesdato. For at begynde med, skal du udforske modellens muligheder i Legeplads og konsulter API guide for detaljerede instruktioner. Før du får adgang, skal du sørge for at være logget ind på CometAPI og have fået API-nøglen. CometAPI tilbyde en pris, der er langt lavere end den officielle pris, for at hjælpe dig med at integrere.

Konklusion

GLM-4.5 repræsenterer et betydeligt fremskridt inden for store sprogmodeller og tilbyder en alsidig løsning til en bred vifte af applikationer. Dens hybride ræsonnementarkitektur, agentfunktioner og open source-natur gør den til en attraktiv mulighed for udviklere og organisationer, der søger at udnytte avancerede AI-teknologier. Ved at udforske de forskellige adgangsmetoder, der er beskrevet i denne vejledning, kan brugerne effektivt integrere GLM-4.5 i deres projekter og bidrage til dens løbende udvikling.