OpenAI har for nylig annonceret adskillige opdateringer, herunder udgivelsen af GPT-5-Codex-Mini-modellen, forbedringer af hastighedsgrænsen for flerbrugerhierarkier og optimeringer til effektivitet af modelbehandling.

OpenAI'er GPT-5-Codex-Mini er en nyligt annonceret, udviklerfokuseret variant af GPT-5-Codex: en mindre, omkostnings- og gennemløbsoptimeret model, der er beregnet til at levere det meste af kodningshjælpen fra GPT-5-Codex, men til en meget lavere pris og med højere brugbar volumen. "Mini"-varianten er positioneret som et pragmatisk valg til lange kodningssessioner, baggrundsautomatisering og højfrekvente udviklerworkflows, hvor rå peak-kapacitet er mindre vigtig end at få flere tokens/anmodninger til den samme plan.

Hvad er GPT-5-Codex-Mini, og hvad er dets funktioner?

GPT-5-Codex-Mini er en kompakt, omkostningseffektiv variant af OpenAIs GPT-5-Codex-familie, der er specifikt pakket til Codex-produktfladerne (CLI- og IDE-integration). Den er positioneret som en "mindre, mere omkostningseffektiv" model, der bytter en lille mængde maksimal kapacitet til fordel for et væsentligt lavere ressourceforbrug og en højere brugbar kvote til interaktive udvikler-workflows. Minimodellen er beregnet til at give udviklere mulighed for at køre mange flere kodningsrundes (OpenAI beskriver groft 4 gange mere brug for det samme ChatGPT-abonnementsniveau) samtidig med at latenstid og omkostninger holdes nede for almindelige, veldefinerede tekniske opgaver.

Med hensyn til funktioner arver GPT-5-Codex-Mini kernefunktionerne fra Codex-produktlinjen: en dyb forståelse af kodebasen og udførelsen af flertrinsopgaver på en "agent"-måde. Baseret på Codex CLI-funktionerne kan udviklere indsende kommandoer i naturligt sprog, kodestykker, skærmbilleder eller interfacedesigndiagrammer til Codex i en interaktiv terminal. Modellen vil først levere en plan og derefter automatisk gennemse filer, redigere kode, køre kommandoer og teste efter at have opnået brugergodkendelse.

Fra et modalt perspektiv tillader Codex-produkter at vedhæfte billeder (såsom UI-skærmbilleder, designkladder eller skærmbilleder af fejlmeddelelser) til sessionen i terminalen eller IDE'en. Modellen kan forstå både tekst- og billedindhold, men outputtet er stadig primært tekstkode og forklaringer. Derfor kan GPT-5-Codex-Mini betragtes som en kodeproxymodel, der primært er "tekst + billedinput, tekstoutput" og ikke udfører opgaver som billedgenerering, lydgenerering eller videogenerering.

Hvordan er GPT-5-Codex-Mini sammenlignet med GPT-5-Codex?

Hvad er nyt i Codex?

Ud over den realiserede GPT-5-Codex-Mini har OpenAI øget Codex-hastighedsgrænsen ensartet med 50 % for ChatGPT Plus-, Business- og Edu-brugerniveauer, hvilket øger grænsen for tilgængelige anmodninger betydeligt. I mellemtiden vil ChatGPT Pro-brugere få prioriterede behandlingstilladelser for at forbedre svartid og opgaveudførelsesoplevelse.

Derudover har OpenAI foretaget en mindre opgradering af GPT-5-Codex-modellen, der optimerer dens ydeevne i samarbejdsscenarier. Den opdaterede model viser forbedringer på adskillige procentpoint på vigtige evalueringsmålinger, en stigning på cirka 3% i token-brugseffektiviteten og større robusthed i håndteringen af edge-sager, hvilket reducerer behovet for brugervejledning.

| brugerniveau | GPT-5-Kodeks | GPT-5-Codex-Mini |

|---|---|---|

| Plus/Biz/Edu | øger beskedvolumen med henholdsvis 1.5 gange. | øger beskedvolumen med henholdsvis 6 gange. |

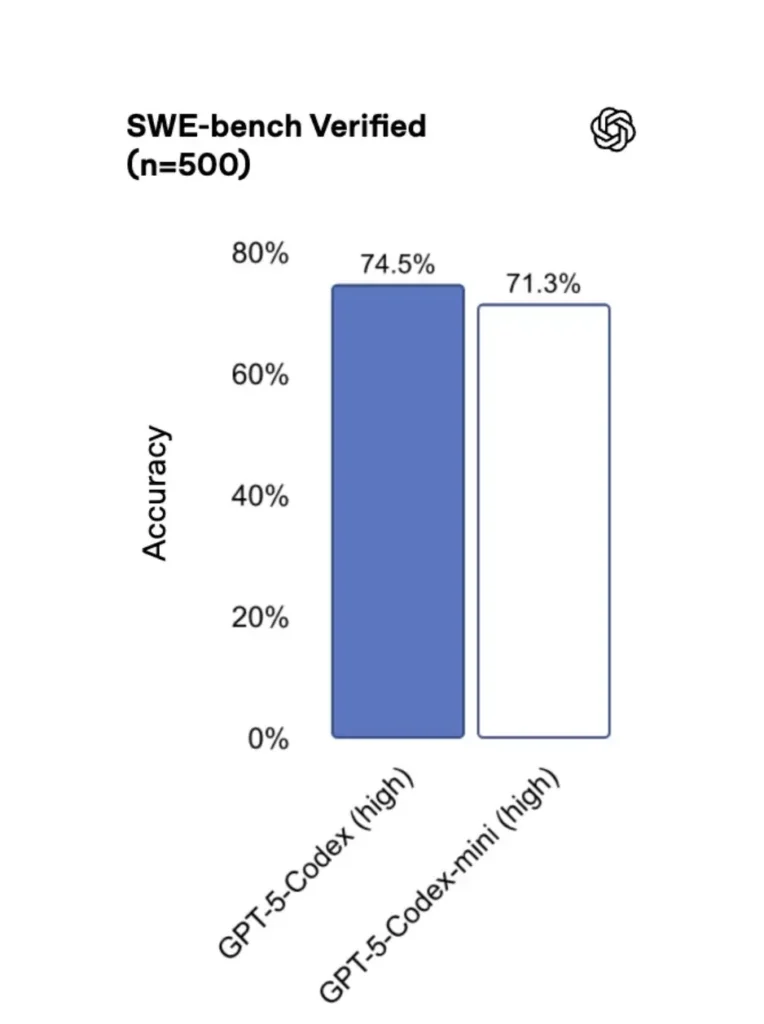

GPT-5-Codex-Mini vs. GPT-5-Codex: forskelle i benchmarks

Sammenlignet med den originale version er GPT-5-Codex-Mini's ydeevne en smule reduceret, men udviklere modtager cirka fire gange så meget brugskredit. I SWE-bench Verified-testen scorede GPT-5 High 72.8%, GPT-5-Codex 74.5%, og GPT-5-Codex-Mini scorede 71.3%.

Codex (og dens mini-variant) bruger dramatisk færre tokens til lette interaktioner – OpenAIs materialer hævder reduktioner i størrelsesordenen ti procentpoint for simple prompts (f.eks. et citeret tal på ≈93.7% færre tokens om letvægtsinteraktioner for Codex-familien vs. GPT-5 i nogle scenarier).

GPT-5-Codex-Mini vs. GPT-5-Codex: Funktionsforskelle

- Størrelse og pris: Mini er eksplicit mindre og mere omkostningseffektiv; OpenAI beskriver det som muligt at bruge omkring 4 gange mere under de samme abonnementsbegrænsninger. Dette er en kvote-/effektivitetsoptimering til rutinemæssige udvikleropgaver.

- Kapacitetsramme: GPT-5-Codex er fortsat den mest effektive løsning til lange, komplekse agentopgaver (store refaktoreringer, dybdegående kodegennemgange, udvidede testcyklusser). Mini er indstillet til at være hurtigere og mindre ressourcekrævende til hyppige, korte interaktioner.

- Latens- og hastighedsgrænser: Mini leverer typisk lavere latenstid og tillader højere hastighedsgrænser pr. plan – hvilket gør den velegnet til tætte, interaktive arbejdsgange.

- Standardoverflader: Mini er tilgængelig som en valgbar model i Codex CLI og IDE-udvidelsen; GPT-5-Codex er standarden for cloud-opgaver og dybdegående kodegennemgangsflows i Codex.

Hvornår skal man bruge Mini vs. Full Codex

- Brug Mini til: stilladsering, gentagen kodegenerering, små refaktoreringer, interaktive fuldførelser under redigering og når man arbejder under en kvote eller omkostningsbegrænsning.

- Brug GPT-5-Kodeks til: omfattende kodegennemgange, autonome opgaver af flere timers varighed, komplekse refaktoreringer og opgaver, der kræver modellens stærkeste ræsonnement og testdrevne udførelse.

Hvordan kan jeg få adgang til GPT-5-Codex-Mini (CLI, IDE, API)?

Codex CLI (terminal først)

OpenAI introduceret gpt-5-codex-mini som en modelindstilling i Codex CLI. Typiske brugsmønstre følger Codex CLI-arbejdsgangen: start en interaktiv session, angiv modellen, vedhæft filer eller skærmbilleder, kør "Codex Cloud-opgaver" og mere. CLI understøtter også hurtig /model skifte mellem fuld gpt-5-codex og gpt-5-codex-miniVed første kørsel skal du godkende ved hjælp af din ChatGPT/Pro/Enterprise-konto (eller angive en API-nøgle). CLI'en leverer forskellige kommandoer, der gør det muligt for Codex at scanne kodebaser, køre tests, åbne REPL'er eller anvende patch-anbefalinger.

Eksempel (interaktiv Codex CLI-session):

# Install Codex CLI (npm)

npm i -g @openai/codex

# or Homebrew on macOS

brew install --cask codex

# Launch in a repo

cd myproject

# Open a codex interactive session

codex

# In the session you can switch the model:

# (this is typed in the Codex TUI)

> /model gpt-5-codex-mini

# Ask Codex to generate a unit test

> Write pytest tests for function `calculate_discount` in discounts.py

Det flow afspejler de nye Codex CLI-standardindstillinger, hvor værktøjet vil foreslå Mini, der nærmer sig brugsgrænsen.

VS-kode / IDE-udvidelse

Ja — Codex IDE-udvidelsen (VS Code) inkluderer allerede gpt-5-codex-mini som en mulighed. Installer Codex-udvidelsen i Visual Studio Code for at få indlejret kodefuldførelse, forslag til refaktorering og AI-drevne hurtige løsninger. Udvidelsen eksponerer også hurtige handlinger (generering af kode, forklaring af valgt kode, refaktorering) og kan køre Codex Cloud-opgaver fra editoren, VS Code-trin:

- Installer OpenAI Codex / ChatGPT-udvidelsen til VS Code.

- Log ind med din ChatGPT-konto (Plus/Pro/Business).

- Åbn kommandopaletten:

Cmd/Ctrl+Shift+P → Codex: Set Model→ vælggpt-5-codex-mini. - Brug indlejrede kommandoer (vælg kode → højreklik → “Forklar med Codex” eller tryk på den konfigurerede genvejstast).

Eksempel: VS Code inline-kommando (pseudo-trin)

- Vælg en funktion i

user_service.py. - Presse

Cmd/Ctrl+Shift+P → Codex: Explain Selectioneller brug højreklik → “Forklar med Codex”. - Udvidelsen åbner et sidepanel med Minis forklaring, foreslåede tests og en "Opret PR"-knap med et enkelt klik, der bruger Codex Cloud-opgaver til at sende en gren til gennemgang.

Hvad med API'en — kan jeg kalde den fra min app?

OpenAIs annonceringer indikerer API-understøttelse kommer snart for GPT-5-Codex-Mini; på tidspunktet for skrivningen er modellen først tilgængelig i Codex-værktøjskæden (CLI/IDE). Det betyder, at produktions-API-klienter skal forberede sig på modelnavnet gpt-5-codex-mini i Requests/Responses API'en, når den er udgivet. I mellemtiden kan du prototype med Codex CLI og IDE-flows.

Når API-adgang er aktiveret, kan et typisk kald (i svarstil) se sådan ud:

# illustrative — check OpenAI docs for final param names

from openai import OpenAI

client = OpenAI(api_key="sk-...")

resp = client.responses.create(

model="gpt-5-codex-mini",

input="Write a Python function that validates an email address and includes unit tests.",

max_tokens=512,

temperature=0.2

)

print(resp.output_text)

Hvad er bedste praksis for hurtig udvikling med Codex Mini?

Nedenfor er konkrete, felttestede bedste praksisser og mønstre for at få maksimal værdi ud af Codex Mini i produktionstekniske arbejdsgange.

1) Strategi for modeludvælgelse — bland og match

Brug Mini til opgaver med høj frekvens og lavere kompleksitet (formatering, små refaktoreringer, automatiske tests), og brug fuld Codex til komplekst design, dybdegående fejlfinding eller store repo-omfattende transformationer. Automatiser skiftet: Codex CLI foreslår allerede Mini ved 90% forbrug, og du kan scripte. /model Skift mellem dine værktøjer for at vælge en model baseret på opgavens kompleksitet.

2) Fremskynde tekniske skabeloner

Lav små, deterministiske promptskabeloner til gentagne opgaver: testgenerering, udkast til ændringslogs, generering af commit-meddelelser og PR-beskrivelser. Gem disse som genbrugelige kodestykker i dit repo eller som Codex-promptforudindstillinger.

Eksempel på promptskabelon til enhedstests:

# Template: generate_pytests

System: You are a precise Python developer. Produce pytest tests.

User: Given the function below, produce parametrized pytest functions that cover typical edge cases.

--- file: discounts.py

<insert function>

---

Return only valid Python test code with imports and fixtures.

3) Automatiser sikkerhedsnet — godkendelser og CI-gating

Tillad aldrig en model at pushe kode direkte uden menneskelig godkendelse. Brug Codex' godkendelsestilstande og Codex Cloud-opgaver til at oprette diffs og kræve menneskelig godkendelse i CI. Codex CLI understøtter "godkendelsestilstande", så redigeringer skal godkendes, før de anvendes.

4) Cache- og deduplikeringsmodelkald

Ved gentagne prompter (f.eks. forklaring af en funktion) skal du cache det svar, der indtastes af prompt + filhash. Dette reducerer redundante kald og holder omkostningsprofilen forudsigelig.

5) Brug streaming + inkrementelle diffs

Anmod om streaming-output og trinvise diffs, når det er muligt, i stedet for omskrivning af hele filer. Dette reducerer tokenforbruget og hjælper korrekturlæsere med at se målrettede ændringer.

6) Enhedstest - først generatorflow

Generer tests og kør dem lokalt i et kortvarigt miljø. Hvis testene fejler, iterer med modellen, der leverer fejlrettelser til testene. Indram hver iteration som en separat prompt med testoutputtene inkluderet.

Eksempel på Codex CLI-automatiseringskodestykke (bash):

# Generate tests

codex --model gpt-5-codex-mini request "Generate pytest tests for discounts.py" > generated_tests.py

# Run tests locally

pytest generated_tests.py -q || {

echo "Tests failed. Opening Codex for debugging..."

codex --model gpt-5-codex-mini request "Tests failed. Here's pytest output: $(tail -n 50 pytest_output.txt). Propose a fix for discounts.py."

}

Konklusion

GPT-5-Codex-Mini er et pragmatisk produkttræk: det anerkender, at udviklernes arbejdsgange ofte domineres af mange korte interaktioner, hvor latenstid, omkostninger og uafbrudt flow er vigtige. Ved at tilbyde et mini-lag rettet mod IDE- og CLI-brug giver OpenAI teams mulighed for at skalere den daglige kodningsassistance uden straks at skulle aktivere den dyreste model for hver interaktion.

Udviklere kan få adgang GPT-5-Codex API ,GPT-5 Pro API Gennem CometAPI er cometAPI's seneste modeller anført pr. artiklens udgivelsesdato. Før du tilgår, skal du sørge for at være logget ind på CometAPI og have fået API-nøglen.CometAPI tilbyde en pris, der er langt lavere end den officielle pris, for at hjælpe dig med at integrere.

Klar til at gå? → Tilmeld dig CometAPI i dag !

Hvis du vil vide flere tips, guider og nyheder om AI, følg os på VK, X og Discord!