I 2025-2026 fortsatte AI-værktøjslandskabet med at konsolideres: Gateway-API'er (som CometAPI) blev udvidet til at give OpenAI-lignende adgang til hundredvis af modeller, mens slutbruger-LLM-apps (som AnythingLLM) fortsatte med at forbedre deres "Generic OpenAI"-udbyder for at lade desktop- og lokalt fokuserede apps kalde ethvert OpenAI-kompatibelt slutpunkt. Det gør det i dag nemt at dirigere AnythingLLM-trafik gennem CometAPI og få fordelene ved modelvalg, omkostningsrouting og samlet fakturering - mens man stadig bruger AnythingLLMs lokale brugergrænseflade og RAG/agentfunktioner.

Hvad er AnythingLLM, og hvorfor vil du forbinde det til CometAPI?

Hvad er AnythingLLM?

AnythingLLM er en open source, alt-i-en AI-applikation og lokal/cloud-klient til at bygge chatassistenter, retrieval-augmented generation (RAG)-workflows og LLM-drevne agenter. Den tilbyder en smart brugergrænseflade, en udvikler-API, arbejdsområde-/agentfunktioner og understøttelse af lokale og cloud-LLM'er - designet til at være private som standard og udvidelige via plugins. AnythingLLM eksponerer en Generisk OpenAI udbyder, der lader den kommunikere med OpenAI-kompatible LLM API'er.

Hvad er CometAPI?

CometAPI er en kommerciel API-aggregeringsplatform, der eksponerer 500+ AI-modeller gennem én OpenAI-lignende REST-grænseflade og samlet fakturering. I praksis giver det dig mulighed for at kalde modeller fra flere leverandører (OpenAI, Anthropic, Google/Gemini-varianter, billed-/lydmodeller osv.) via den samme https://api.cometapi.com/v1 endpoints og en enkelt API-nøgle (format sk-xxxxxCometAPI understøtter standard OpenAI-lignende slutpunkter såsom /v1/chat/completions, /v1/embeddingsosv., hvilket gør det nemt at tilpasse værktøjer, der allerede understøtter OpenAI-kompatible API'er.

Hvorfor integrere AnythingLLM med CometAPI?

Tre praktiske grunde:

- Modelvalg og leverandørfleksibilitet: AnythingLLM kan bruge "enhver OpenAI-kompatibel" LLM via sin generiske OpenAI-wrapper. Ved at pege denne wrapper på CometAPI får du øjeblikkelig adgang til hundredvis af modeller uden at ændre AnythingLLMs brugergrænseflade eller flows.

- Omkostnings-/driftsoptimering: Med CometAPI kan du centralt skifte model (eller skifte ned til billigere) for at kontrollere omkostningerne og bevare en samlet fakturering i stedet for at jonglere med flere udbydernøgler.

- Hurtigere eksperimenter: Du kan A/B forskellige modeller (f.eks.

gpt-4o,gpt-4.5, Claude-varianter eller open source multimodale modeller) via den samme AnythingLLM-brugergrænseflade — nyttig til agenter, RAG-svar, opsummering og multimodale opgaver.

Miljø og forhold skal du forberede inden integration

System- og softwarekrav (overordnet niveau)

- Desktop eller server, der kører AnythingLLM (Windows, macOS, Linux) — desktopinstallation eller selvhostet instans. Bekræft, at du bruger en nyere build, der eksponerer LLM-præferencer / AI-udbydere indstillinger.

- CometAPI-konto og en API-nøgle (den

sk-xxxxxstilhemmelighed). Du skal bruge denne hemmelighed i AnythingLLMs Generic OpenAI-udbyder. - Netværksforbindelse fra din maskine til

https://api.cometapi.com(ingen firewall blokerer udgående HTTPS). - Valgfrit, men anbefalet: et moderne Python- eller Node-miljø til testning (Python 3.10+ eller Node 18+), curl og en HTTP-klient (Postman / HTTPie) til at kontrollere CometAPI's fornuft, før den kobles til AnythingLLM.

AnythingLLM-specifikke betingelser

Generisk OpenAI LLM-udbyderen er den anbefalede rute for endpoints, der efterligner OpenAIs API-overflade. AnythingLLMs dokumentation advarer om, at denne udbyder er udviklerfokuseret, og at du bør forstå de input, du leverer. Hvis du bruger streaming, eller dit endpoint ikke understøtter streaming, inkluderer AnythingLLM en indstilling til at deaktivere streaming for Generic OpenAI.

Sikkerheds- og driftstjekliste

- Behandl CometAPI-nøglen som enhver anden hemmelighed – gem den ikke i repos; gem den i OS-nøgleringer eller miljøvariabler, hvor det er muligt.

- Hvis du planlægger at bruge følsomme dokumenter i RAG, skal du sørge for, at endpoint-privatlivsgarantier opfylder dine compliance-behov (se CometAPI's dokumenter/vilkår).

- Beslut dig for maksimale tokens og grænser for kontekstvinduer for at forhindre uoverskuelige regninger.

Hvordan konfigurerer man AnythingLLM til at bruge CometAPI (trin for trin)?

Nedenfor er en konkret trinsekvens — efterfulgt af eksempler på miljøvariabler og kodestykker til test af forbindelsen, før du gemmer indstillingerne i AnythingLLM-brugergrænsefladen.

Trin 1 — Få din CometAPI-nøgle

- Registrer dig eller log ind på CometAPI.

- Naviger til “API-nøgler” og generer en nøgle – du får en streng, der ligner

sk-xxxxxHold det hemmeligt.

Trin 2 — Bekræft at CometAPI fungerer med en hurtig anmodning

Brug curl eller Python til at kalde et simpelt chatafslutningsslutpunkt for at bekræfte forbindelsen.

Eksempel på krøller

curl -X POST "https://api.cometapi.com/v1/chat/completions" \

-H "Authorization: Bearer sk-xxxxx" \

-H "Content-Type: application/json" \

-d '{

"model": "gpt-4o",

"messages": ,

"max_tokens": 50

}'

Hvis dette returnerer en 200 og et JSON-svar med en choices array, din nøgle og dit netværk fungerer. (CometAPIs dokumentation viser OpenAI-lignende overflader og slutpunkter).

Python-eksempel (anmodninger)

import requests

url = "https://api.cometapi.com/v1/chat/completions"

headers = {"Authorization": "Bearer sk-xxxxx", "Content-Type": "application/json"}

payload = {

"model": "gpt-4o",

"messages": ,

"max_tokens": 64

}

r = requests.post(url, json=payload, headers=headers, timeout=15)

print(r.status_code, r.json())

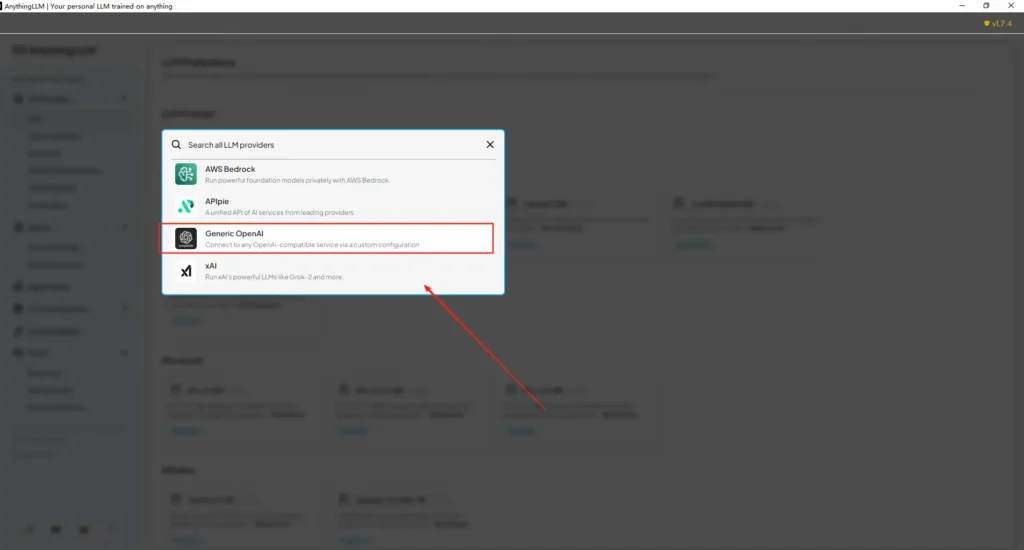

Trin 3 — Konfigurer AnythingLLM (brugergrænseflade)

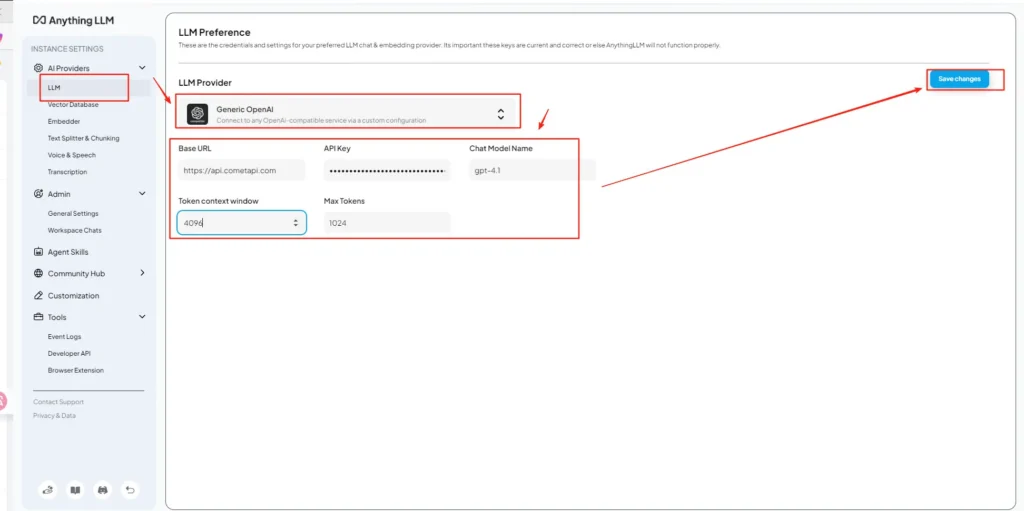

Åbn AnythingLLM → Indstillinger → AI-udbydere → LLM-præferencer (eller lignende sti i din version). Brug Generisk OpenAI udbyder og udfyld felterne som følger:

API-konfiguration (eksempel)

• Gå ind i indstillingsmenuen for AnythingLLM, og find LLM-præferencer under AI-udbydere.

• Vælg Generic OpenAI som modeludbyder, indtasthttps://api.cometapi.com/v1i URL-feltet.

• Indsætsk-xxxxxfra CometAPI i API-nøgleinputfeltet. Udfyld Token-kontekstvinduet og Max Tokens i henhold til den faktiske model. Du kan også tilpasse modelnavne på denne side, f.eks. tilføjegpt-4omodel.

Dette stemmer overens med AnythingLLMs "Generic OpenAI"-vejledning (udvikler-wrapper) og CometAPIs OpenAI-kompatible basis-URL-tilgang.

Trin 4 — Angiv modelnavne og tokengrænser

På den samme indstillingsskærm kan du tilføje eller tilpasse modelnavne præcis som CometAPI udgiver dem (f.eks. gpt-4o, minimax-m2, kimi-k2-thinking) så AnythingLLM-brugergrænsefladen kan præsentere disse modeller for brugerne. CometAPI udgiver modelstrenge for hver leverandør.

Trin 5 — Test i AnythingLLM

Start en ny chat eller brug et eksisterende arbejdsområde, vælg den generiske OpenAI-udbyder (hvis du har flere udbydere), vælg et af de CometAPI-modelnavne, du har tilføjet, og kør en simpel prompt. Hvis du får sammenhængende fuldførelser, er du integreret.

Hvordan AnythingLLM bruger disse indstillinger internt

AnythingLLMs generiske OpenAI-wrapper konstruerer OpenAI-lignende anmodninger (/v1/chat/completions, /v1/embeddings), så når du peger på basis-URL'en og angiver CometAPI-nøglen, vil AnythingLLM sende chats, agentopkald og indlejringsanmodninger transparent gennem CometAPI. Hvis du bruger AnythingLLM-agenter (den @agent flows), vil de arve den samme udbyder.

Hvad er bedste praksis og mulige faldgruber?

Bedste praksis

- Brug model-tilpassede kontekstindstillinger: Match AnythingLLMs Token Context Window og Max Tokens med den model, du vælger på CometAPI. Uoverensstemmelse fører til uventet afkortning eller mislykkede kald.

- Sikr dine API-nøgler: Gem CometAPI-nøgler i miljøvariabler og/eller Kubernetes/secret manager; tjek dem aldrig ind i git. AnythingLLM gemmer nøgler i sine lokale indstillinger, hvis du indtaster dem i brugergrænsefladen — behandl værtslageret som følsomt.

- Start med billigere/mindre modeller til eksperimentflows: Brug CometAPI til at afprøve billigere modeller til udvikling, og reserver premiummodeller til produktion. CometAPI reklamerer eksplicit for omkostningsskift og samlet fakturering.

- Overvåg brug og indstil alarmer: CometAPI leverer brugsdashboards — indstil budgetter/advarsler for at undgå uventede regninger.

- Testmidler og -værktøjer isoleret: AnythingLLM-agenter kan udløse handlinger; test dem først med sikre prompts og på staging-instanser.

Almindelige faldgruber

- Brugergrænseflade vs.

.envkonflikter: Ved selvhosting kan brugergrænsefladeindstillinger overskrives.envændringer (og omvendt). Kontroller de genererede/app/server/.envhvis tingene vender tilbage efter genstart. Rapport om problemer i lokalsamfundet.LLM_PROVIDERnulstiller. - Uoverensstemmelser i modelnavne: Brug af et modelnavn, der ikke er tilgængeligt på CometAPI, vil forårsage en 400/404 fra gatewayen. Bekræft altid tilgængelige modeller på CometAPI-modellisten.

- Tokengrænser og streaming: Hvis du har brug for streamingsvar, skal du kontrollere, at CometAPI-modellen understøtter streaming (og at AnythingLLMs brugergrænsefladeversion understøtter det). Nogle udbydere adskiller sig i streamingsemantik.

Hvilke anvendelsesscenarier i den virkelige verden åbner denne integration op for?

Retrieval-Augmented Generation (RAG)

Brug AnythingLLMs dokumentindlæsere + vektordatabase med CometAPI LLM'er til at generere kontekstbevidste svar. Du kan eksperimentere med billig indlejring + dyre chatmodeller eller beholde alt på CometAPI for samlet fakturering. AnythingLLMs RAG-flows er en primær indbygget funktion.

Agentautomatisering

AnythingLLM understøtter @agent arbejdsgange (gennemse sider, kaldværktøjer, kørsel af automatiseringer). Routing af agenters LLM-kald via CometAPI giver dig valget af modeller til kontrol-/fortolkningstrin uden at ændre agentkode.

Multimodel A/B-testning og omkostningsoptimering

Skift modeller pr. arbejdsområde eller funktion (f.eks. gpt-4o for produktionssvar, gpt-4o-mini til udviklere). CometAPI gør modelbytter trivielle og centraliserer omkostninger.

Multimodale rørledninger

CometAPI leverer billed-, lyd- og specialiserede modeller. AnythingLLMs multimodale understøttelse (via udbydere) plus CometAPIs modeller muliggør billedtekstning, multimodal opsummering eller lydtranskription, der flyder gennem den samme grænseflade.

Konklusion

CometAPI fortsætter med at positionere sig som en multimodel-gateway (500+ modeller, OpenAI-lignende API) – hvilket gør den til en naturlig partner for apps som AnythingLLM, der allerede understøtter en generisk OpenAI-udbyder. Ligeledes gør AnythingLLMs generiske udbyder og de seneste konfigurationsmuligheder det nemt at oprette forbindelse til sådanne gateways. Denne konvergens forenkler eksperimentering og produktionsmigrering i slutningen af 2025.

Sådan kommer du i gang med Comet API

CometAPI er en samlet API-platform, der samler over 500 AI-modeller fra førende udbydere – såsom OpenAIs GPT-serie, Googles Gemini, Anthropics Claude, Midjourney, Suno og flere – i en enkelt, udviklervenlig grænseflade. Ved at tilbyde ensartet godkendelse, formatering af anmodninger og svarhåndtering forenkler CometAPI dramatisk integrationen af AI-funktioner i dine applikationer. Uanset om du bygger chatbots, billedgeneratorer, musikkomponister eller datadrevne analysepipelines, giver CometAPI dig mulighed for at iterere hurtigere, kontrollere omkostninger og forblive leverandøruafhængig – alt imens du udnytter de seneste gennembrud på tværs af AI-økosystemet.

For at begynde, udforsk modellens mulighederCometAPI i Legeplads og se API-vejledningen for detaljerede instruktioner. Før du får adgang, skal du sørge for at være logget ind på CometAPI og have fået API-nøglen. CometAPI tilbyde en pris, der er langt lavere end den officielle pris, for at hjælpe dig med at integrere.

Klar til at gå? → Tilmeld dig CometAPI i dag !

Hvis du vil vide flere tips, guider og nyheder om AI, følg os på VK, X og Discord!