DeepSeek udgivet DeepSeek V3.2 og en variant med høj beregningsevne DeepSeek-V3.2-Speciale, med en ny sparse-attention engine (DSA), forbedret agent/værktøjsadfærd og en "tænknings"-tilstand (tankekæde), der afdækker intern ræsonnement. Begge modeller er tilgængelige via DeepSeeks API (OpenAI-kompatible slutpunkter), og modelartefakter/tekniske rapporter offentliggøres offentligt.

Hvad er DeepSeek V3.2?

DeepSeek V3.2 er produktionsefterfølgeren i DeepSeek V3-familien — en stor, generativ modelfamilie med lang kontekst, der er eksplicit konstrueret til ræsonnement først arbejdsgange og agentbrug. V3.2 konsoliderer tidligere eksperimentelle forbedringer (V3.2-Exp) i en mainstream-modellinje, der eksponeres via DeepSeeks app, web-UI og API. Den understøtter både hurtige, konversationsbaserede output og en dedikeret tænker (tankekæde)-tilstand egnet til flertrinsræsonnementsopgaver såsom matematik, fejlfinding og planlægning.

Hvorfor V3.2 er vigtig (hurtig kontekst)

DeepSeek V3.2 er bemærkelsesværdig af tre praktiske grunde:

- Lang kontekst: Op til 128k token-kontekstvinduer, hvilket gør den velegnet til lange dokumenter, juridiske kontrakter eller forskning i flere dokumenter.

- Design med fokus på ræsonnement: Modellen integrerer tankekæden ("tænkning") i arbejdsgange og i værktøjsbrug – et skift i retning af agentiske apps, der kræver mellemliggende ræsonnementstrin.

- Omkostninger og effektivitet: Introduktionen af DSA (sparse attention) reducerer beregningsbehovet for lange sekvenser, hvilket muliggør meget billigere inferens for store kontekster.

Hvad er DeepSeek-V3.2-Speciale, og hvordan adskiller den sig fra basisversionen v3.2?

Hvad gør "Speciale"-varianten speciel?

DeepSeek V3.2-Speciale er en høj beregningsevne, høj ræsonnement variant af v3.2-familien. Sammenlignet med den afbalancerede v3.2-variant er Speciale specifikt finjusteret (og eftertrænet) til flertrinsræsonnement, matematik og agentopgaver; den bruger ekstra forstærkningslæring fra menneskelig feedback (RLHF) og udvidet intern tankekæde under træning. Det midlertidige slutpunkt og Speciale API-adgangen blev annonceret som tidsbegrænsede (reference til et slutpunktsudløb den 15. december 2025 for Speciale-stien).

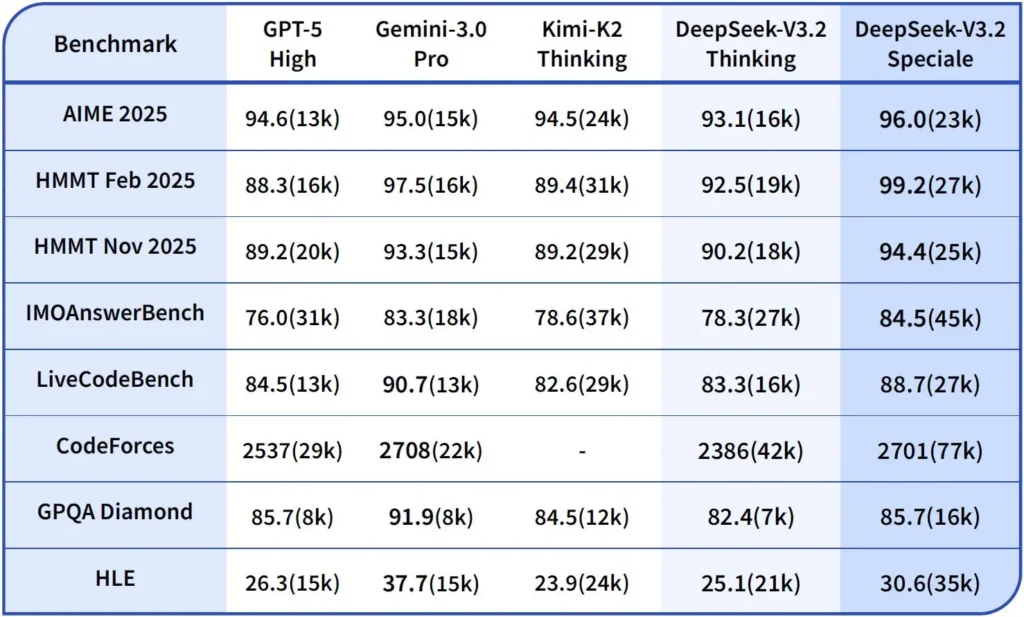

Ydeevne og benchmarks

DeepSeek-V3.2-Speciale er den højtydende, ræsonnementoptimerede variant af V3.2. Speciale-versionen integrerer den tidligere matematiske model DeepSeek-Math-V2. Den er positioneret som den model, der skal bruges, når arbejdsbyrden kræver det. dybeste mulige tankekæde, problemløsning i flere trin, konkurrencepræget ræsonnement (f.eks. matematisk olympiadestil) og kompleks agentisk orkestrering.

Den kan bevise matematiske sætninger og verificere logisk ræsonnement på egen hånd; den har opnået bemærkelsesværdige resultater i flere konkurrencer i verdensklasse:

- IMO (International Matematisk Olympiade) Guldmedalje

- CMO (Kinesisk Matematisk Olympiade) Guldmedalje

- ICPC (International Computer Programming Contest) 2. plads (Menneskelig konkurrence)

- IOI (International Olympiade i Informatik) 10. plads (Menneskelig konkurrence)

Hvad er ræsonnementstilstand i DeepSeek v3.2?

DeepSeek afslører en eksplicit tænke-/ræsonnementstilstand hvilket får modellen til at producere en Chain-of-Thought (CoT) som en diskret del af outputtet før det endelige svar. API'en viser denne CoT, så klientapplikationer kan inspicere, vise eller destillere den.

Mekanik — hvad API'en leverer

reasoning_contentfelt: når tænketilstand er aktiveret, inkluderer svarstrukturen enreasoning_contentfelt (CoT) på samme niveau som den endeligecontentDette giver klienter programmatisk adgang til de interne trin.- Værktøjsopkald under tænkningV3.2 hævder at understøtte værktøjskald inden for Tænkningsbanen: Modellen kan sammenflette ræsonnementstrin og værktøjsaktiveringer, hvilket forbedrer udførelse af komplekse opgaver.

Hvordan DeepSeek v3.2 API implementerer ræsonnement

Version 3.2 introducerer en standardiseret API-mekanisme til ræsonnementskæder for at opretholde ensartet ræsonnementslogik på tværs af samtaler med flere vendinger:

- Hver begrundelsesanmodning indeholder en

reasoning_contentfelt i modellen; - Hvis brugeren ønsker, at modellen skal fortsætte med at ræsonnere, skal dette felt sendes tilbage til næste tur;

- Når et nyt spørgsmål begynder, det gamle

reasoning_contentskal ryddes for at forhindre logisk kontaminering; - Modellen kan udføre løkken "ræsonnement → værktøjskald → genræsonnement" flere gange i ræsonnementstilstand.

Hvordan får jeg adgang til og bruger DeepSeek v3.2 API

Short: CometAPI er en OpenAI-lignende gateway, der eksponerer mange modeller (inklusive DeepSeek-familier) via https://api.cometapi.com/v1 så du kan bytte modeller ved at ændre model streng i anmodninger. Tilmeld dig på CometAPI og få din API-nøgle først.

Hvorfor bruge CometAPI frem for direkte DeepSeek?

- CometAPI centraliserer fakturering, takstgrænser og modelvalg (praktisk, hvis du planlægger at skifte udbyder uden at ændre kode).

- Direkte DeepSeek-slutpunkter (f.eks.

https://api.deepseek.com/v1) findes stadig og eksponerer sommetider udbyderspecifikke funktioner; vælg CometAPI for nemheds skyld eller det direkte leverandørslutpunkt for udbyder-native kontroller. Bekræft hvilke funktioner (f.eks. Speciale, eksperimentelle slutpunkter) der er tilgængelige via CometAPI, før du stoler på dem.

Trin A — Opret en CometAPI-konto og få en API-nøgle

- Gå til CometAPI (tilmelding / konsol) og generer en API-nøgle (dashboardet viser typisk

sk-...). Hold det hemmeligt. CometAPI

Trin B — Bekræft det nøjagtige modelnavn, der er tilgængeligt

- Forespørg på modellisten for at bekræfte den nøjagtige modelstreng, som CometAPI eksponerer (modelnavne kan indeholde variantsuffikser). Brug modelslutpunktet før hardcode-navne:

curl -s -H "Authorization: Bearer $COMET_KEY" \

https://api.cometapi.com/v1/models | jq .

Se efter DeepSeek-posten (f.eks. deepseek-v3.2 or deepseek-v3.2-exp) og noter det nøjagtige id. CometAPI eksponerer en /v1/models notering.

Trin C — Foretag et grundlæggende chatopkald (curl)

udskifte <COMET_KEY> og deepseek-v3.2 med det model-id, du bekræftede:

curl https://api.cometapi.com/v1/chat/completions \

-H "Content-Type: application/json" \

-H "Authorization: Bearer <COMET_KEY>" \

-d '{

"model": "deepseek-v3.2",

"messages": [

{"role":"system","content":"You are a helpful assistant."},

{"role":"user","content":"Summarize DeepSeek v3.2 in two sentences."}

],

"max_tokens":300

}'

Dette er det samme OpenAI-lignende kaldsmønster — CometAPI videresender til den valgte udbyder.

Kompatibilitet og forholdsregler

- Understøtter aktivering af Think Mode i Claude Code-miljøet;

- I kommandolinjen (CLI) skal du blot indtaste modelnavnet deepseek-reasoner;

- Det er dog muligvis ikke kompatibelt med ikke-standardværktøjer som Cline og RooCode i øjeblikket;

- Det anbefales at bruge ikke-tænketilstand til almindelige opgaver og tænketilstand til kompleks logisk ræsonnement.

Praktiske adoptionsmønstre: et par eksempler på arkitekturer

1 — Hjælpemiddel til udvikler-arbejdsgange

- Mode: Speciale (tænketilstand) aktiveret til generering af kompleks kode og oprettelse af tester; hurtig chattilstand til indlejret assistent.

- Sikkerhed: Brug CI-pipelinetjek og sandbox-testudførelse til genereret kode.

- Hosting: API eller selvhostet på vLLM + multi-GPU-klynge til stor kontekst.

2 — Dokumentanalyse for juridiske/finansielle teams

- Mode: V3.2 med DSA-optimeringer for lang kontekst til at behandle lange kontrakter og producere strukturerede resuméer og handlingslister.

- Sikkerhed: Godkendelse af menneskelig advokat for downstream-beslutninger; redigering af personoplysninger før afsendelse til hostede slutpunkter.

3 — Autonom orkestrator af data pipelines

- Mode: Tænketilstand til at planlægge ETL-opgaver i flere trin, kalde værktøjer til at forespørge på databaser og kalde valideringstests.

- Sikkerhed: Implementer handlingsbekræftelse og verificerbare kontroller før enhver irreversibel operation (f.eks. destruktiv DB-skrivning).

Hvert af ovenstående mønstre er muligt med V3.2-familiemodeller i dag, men du skal parre modellen med verifikationsværktøjer og konservativ styring.

Hvordan optimerer jeg omkostninger og ydeevne med v3.2?

Brug de dobbelte tilstande bevidst

- Hurtig tilstand til mikrointeraktioner: Brug ikke-tænkende værktøjstilstand til korte hentninger, formatkonverteringer eller direkte API-kald, hvor latenstid er vigtig.

- Tænketilstand til planlægning og verifikation: Send komplekse opgaver, agenter med flere handlinger eller sikkerhedsfølsomme beslutninger til tænketilstand. Registrer de mellemliggende trin, og kør en verifikation (automatiseret eller menneskelig), før kritiske handlinger udføres.

Hvilken modelvariant skal jeg vælge?

- deepseek-v3.2 — balanceret produktionsmodel til generelle agentopgaver.

- deepseek-v3.2-Speciale — specialiseret variant til tung ræsonnement; muligvis kun API-baseret i starten og bruges, når du har brug for den bedst mulige ræsonnement-/benchmark-ydeevne (og accepterer potentielt højere omkostninger).

Praktiske omkostningskontroller og tips

- Promptudvikling: Hold systeminstruktionerne koncise, undgå at sende overflødig kontekst. Eksplicitte systeminstruktioner: Brug systemprompter, der erklærer tilstandsintention: f.eks. "Du er i TÆNKER-tilstand — angiv din plan, før du kalder værktøjer." For værktøjstilstand skal du tilføje begrænsninger som "Når du interagerer med lommeregner-API'en, skal du kun udskrive JSON med følgende felter."

- Chunking + retrieval augmentation: brug en ekstern retriever til kun at sende de mest relevante segmenter for hvert brugerspørgsmål.

- Temperatur og prøveudtagning: Sænk temperaturen for værktøjsinteraktioner for at øge determinismen; øg den i udforskende eller idégenererende opgaver.

Benchmark og måling

- Behandl output som upålidelige indtil verificeret: Selv ræsonnerende output kan være forkerte. Tilføj deterministiske kontroller (enhedstest, typekontroller), før du foretager irreversible handlinger.

- Kør A/B-tests på en prøvearbejdsbelastning (latens, tokenbrug, korrekthed), før du forpligter dig til en variant. V3.2 rapporterede store gevinster på ræsonnementbenchmarks, men den reelle app-adfærd afhænger af hurtigt design og inputdistribution.

Ofte Stillede Spørgsmål

Q: Hvad er den anbefalede måde at hente CoT fra modellen?

A: Brug deepseek-reasoner model eller sæt thinking/thinking.type = enabled i din anmodning. Svaret inkluderer reasoning_content (CoT) og den endelige content.

Q: Kan modellen kalde eksterne værktøjer, mens den er i tænketilstand?

A: Ja — V3.2 introducerede muligheden for at bruge værktøjer i både tænkende og ikke-tænkende tilstande; modellen kan udsende strukturerede værktøjskald under intern ræsonnement. strict tilstand og ryd JSON-skemaer for at undgå forkert udformede kald.

Q: Øger brugen af tænketilstand omkostningerne?

A: Ja — tænketilstanden udsender mellemliggende CoT-tokens, hvilket øger tokenforbruget og dermed omkostningerne. Design dit system til kun at muliggøre tænkning, når det er nødvendigt.

Q: Hvilket slutpunkt og hvilken basis-URL skal jeg bruge?

A: CometAPI leverer OpenAI-kompatible slutpunkter. Standardbasis-URL'en er https://api.cometapi.com og det primære chat-slutpunkt er /v1/chat/completions (eller /chat/completions afhængigt af den basis-URL, du vælger).

Q: Kræves der specialværktøj for at bruge værktøjskald?

A: Nej — API'en understøtter strukturerede funktionsdeklarationer i JSON. Du skal angive tools parameter, værktøjsskemaerne og håndter JSON-funktionens livscyklus i din applikation: modtag funktionskald-JSON, udfør funktionen, og returner derefter resultaterne til modellen til fortsættelse eller lukning. Tænketilstand tilføjer et krav om at sende tilbage reasoning_content sammen med værktøjsresultater.

Konklusion

DeepSeek V3.2 og DeepSeek-V3.2-Speciale repræsenterer et klart skub i retning af åben, ræsonnementscentreret LLM'er, der ekspliciterer tankekæder og understøtter arbejdsgange for agentværktøjer. De tilbyder kraftfulde nye primitiver (DSA, tænketilstand, træning i værktøjsbrug), der kan forenkle opbygningen af troværdige agenter – forudsat at man tager højde for tokenomkostninger, omhyggelig tilstandsstyring og operationelle kontroller.

Udviklere kan få adgang Deepseek v3.2 API osv. via CometAPI, den nyeste modelversion opdateres altid med den officielle hjemmeside. For at begynde, udforsk modellens muligheder i Legeplads og konsulter API guide for detaljerede instruktioner. Før du får adgang, skal du sørge for at være logget ind på CometAPI og have fået API-nøglen. CometAPI tilbyde en pris, der er langt lavere end den officielle pris, for at hjælpe dig med at integrere.

Klar til at gå? → Gratis prøveversion af deepseek v3.2 !

Hvis du vil vide flere tips, guider og nyheder om AI, følg os på VK, X og Discord!