I en spændende livestream-begivenhed torsdag den 27. OpenAI afslørede en forskningspreview af GPT-4.5, den seneste iteration af dets flagskibsmodel med store sprog. Virksomhedens repræsentanter roste denne nye version som deres mest dygtige og alsidige chatmodel til dato. Det vil i første omgang være åbent for softwareudviklere og folk med ChatGPT Pro-abonnementer.

Udgivelsen af GPT-4.5 vil markere afslutningen på en slags æra for OpenAI. I et indlæg på X tidligere på måneden sagde OpenAI CEO Sam Altman, at modellen ville være den sidste, som virksomheden introducerer, som ikke brugte yderligere computerkraft til at overveje forespørgsler, før de svarede.

Hvad er GPT 4.5?

GPT 4.5 er OpenAI's hidtil største model — Eksperter har estimeret, at GPT-4 kan have så mange som 1.8 billioner parametre, de værdier, der bliver justeret, når en model trænes. Ved at skalere uovervåget læring forbedrer GPT 4.5 dens evne til at genkende mønstre, tegne forbindelser og generere forbindelser uden kreative ræsonnementer.

GPT 4.5 er et eksempel på skalering af uovervåget læring ved at opskalere computer og data sammen med arkitektur- og optimeringsinnovationer. Og GPT-4.5 er mere naturlig i brugerinteraktion, dækker et bredere spektrum af viden og kan bedre forstå og reagere på brugerhensigter, hvilket fører til reducerede hallucinationer og mere pålidelighed på tværs af en lang række emner.

Hvad er opgraderingerne af GPT 4.5 og dets funktioner

EQ opgradering:

Den største egenskab ved GPT-4.5 er dens forbedrede "emotionelle intelligens" (EQ), som kan give en mere naturlig, varm og jævn samtaleoplevelse. OpenAI CEO Sam Altman delte på sociale medier: "Dette er første gang, jeg føler, at AI taler med en betænksom person. Det giver virkelig værdifulde råd og fik mig endda til at læne mig tilbage i stolen et par gange, overrasket over, at AI kan give så fremragende svar."

I testen af menneskelige præferencer mener brugerne generelt, at GPT 4.5's svar er mere i overensstemmelse med menneskelige kommunikationsvaner end GPT-4o. Specifikt fik den nye model højere vurderinger inden for kreativ intelligens (56.8 %), faglige problemer (63.2 %) og daglige problemer (57.0 %).

Reducerede hallucinationer:

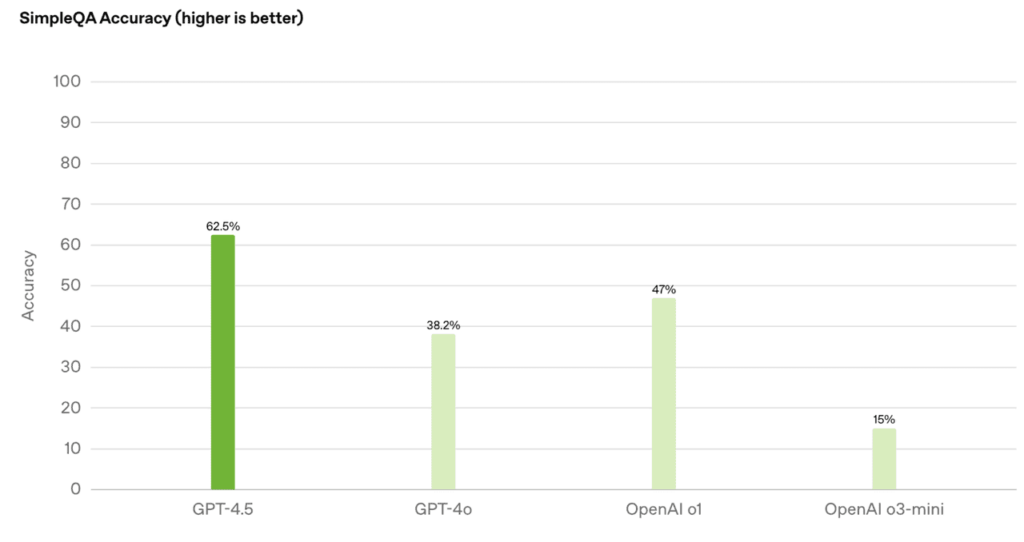

Gennem storstilet "uovervåget læring" har GPT 4.5 gjort betydelige fremskridt med hensyn til vidensnøjagtighed og reduktion af "hallucinationer" (falsk information):

- Ved at opnå 62.5 % nøjagtighed i SimpleQA-evaluering faldt hallucinationsfrekvensen til 37.1 %

- At opnå en nøjagtighed på 0.78 på PersonQA-datasættet, langt bedre end GPT-4o (0.28) og o1 (0.55)

Udvidelse af videnbasen og Expression Upgrade

Effektiviteten steg dramatisk: Computerstrømforbruget faldt med 10 gange, videnbasen fordoblet, men omkostningerne var højere (Pro-brugere har prioriteret erfaring til $200/måned). Derudover er GPT 4.5 blevet optimeret inden for arkitektur og innovation, hvilket forbedrer kontrollerbarheden, forståelsen af nuancer og naturlige samtaleevner og er særligt velegnet til skrivning, programmering, løsning af praktiske problemer og interaktive scenarier, der kræver en høj grad af empati.

Teknisk arkitektur højdepunkter

Opgradering af computerkraft: Baseret på Microsoft Azure supercomputing-træning er computerkraften 10 gange større end GPT-40, computereffektiviteten er forbedret med mere end 10 gange, og distribueret træning på tværs af datacentre understøttes.

Sikkerhedsoptimering: Integrer traditionel overvåget finjustering (SFT) og RLHF, indfør ny overvågningsteknologi og reducer risikoen for skadeligt output.

Multimodale begrænsninger: Stemme/video er ikke understøttet endnu, men billedforståelse er tilføjet for at hjælpe SVG-animationsdesign og ophavsretsfri musikgenerering.

Relaterede emner:De bedste 8 mest populære AI-modeller sammenligning af 2025

GPT 4.5 API-priser forklaret: Er det virkelig det værd?

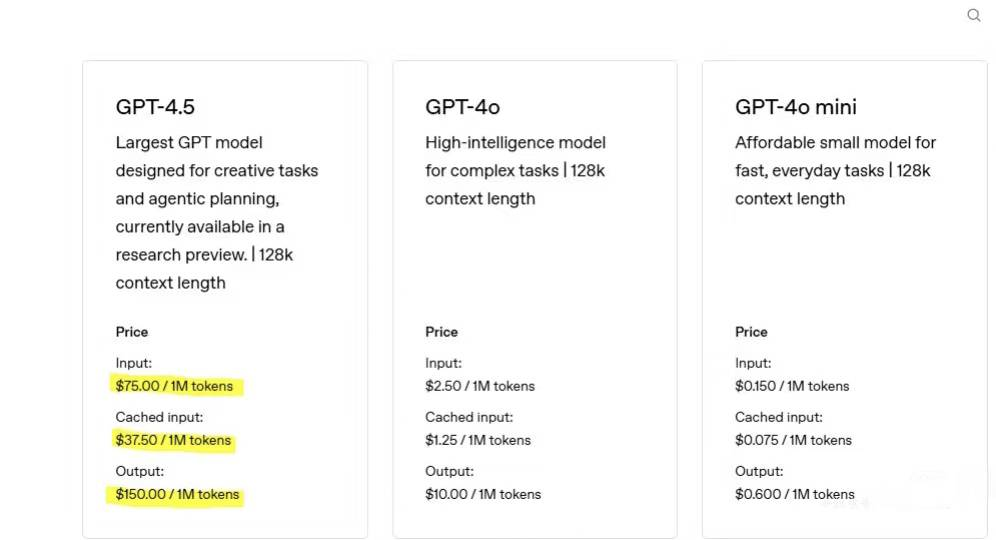

GPT-4.5 er bygget på en kolossal arkitektur med 12.8 billioner parametre og et 128k token kontekstvindue. Dette enorme skala og computerintensive design kommer med premium priser. For eksempel kan en arbejdsbyrde med 750 input-tokens og 250 output-tokens koste omkring $147—omtrent 30-34× dyrere end tidligere modeller som GPT-4o.

GPT-seriens prissammenligning

Den nye model er nu tilgængelig til research preview for ChatGPT Pro-brugere og vil blive rullet ud til Plus-, Team-, Enterprise- og Education-brugere i løbet af de næste to uger.

GPT 4.5 vs. andre sprogmodeller

Den æstetiske intuition ved designskrivning er blevet opgraderet, hvilket gør den mere velegnet til kreativt arbejde og følelsesmæssig interaktion end andre modeller. Begrundelsen er blevet nedprioriteret, og den har tydeligvis forladt positioneringen af "den stærkeste model". Dens ræsonnement halter bagefter sine konkurrenter. GPT-4.5 har hævet standarden for konversations-AI, men dens høje pris gør det til et professionelt værktøj frem for en massemarkedsløsning.

Omfattende API-prissammenligning på tværs af førende AI-modeller

| Model | Inputpris (pr. 1 mio. tokens) | Outputomkostninger (pr. 1 mio. tokens) | Kontekstvindue | Kommentarer |

| GPT-4.5 | 75 | 150 | 128 tokens | Premium-priser for avancerede følelsesmæssige og samtaleevner |

| GPT-4o | 2.5 | 10 | 128 tokens | Omkostningseffektiv baseline med hurtig, multimodal support |

| Claude 3.7 sonet | 3 | 15 | 200 tokens | Usædvanligt økonomisk; understøtter både tekst og billeder |

| DeepSeek R1 | ~ $ 0.55 | ~ $ 2.19 | 64 tokens | Aggressiv prisfastsættelse; caching kan yderligere reducere omkostningerne til store mængder brugssager |

| Google Gemini 2.0 Flash | ~ $ 0.15 | ~ $ 0.60 | Op til 1M tokens | Ultralav pris med massiv kontekstkapacitet; ideel til store opgaver |

Tekniske muligheder og omkostningsafvejninger

Kontekst og multimodalitet:

**GPT-4.5:**Understøtter en 128k token kontekst, men er kun tekst.

Claude 3.7 sonet: Tilbyder et større 200k token-vindue og billedbehandling for forbedret ydeevne i lang kontekst.

**Google Gemini 2.0 Flash:**Kan prale af et imponerende 1M token-vindue, ideelt til omfattende indholdsbehandling (selvom tekstkvaliteten kan variere).

Specialiserede opgaver:

**Kodningsbenchmarks:**GPT-4.5 opnår omkring 38 % nøjagtighed på kodningsopgaver (f.eks. SWE-Bench), hvorimod Claude 3.7 Sonnet leverer væsentligt bedre omkostningseffektivitet og ydeevne i tekniske opgaver.

**Følelsesmæssig intelligens:**GPT-4.5 udmærker sig ved at levere nuanceret, følelsesmæssigt rig dialog, hvilket gør den ideel til kundesupport og coachingapplikationer.

Konklusion

GPT-4.5 er den "sidste ikke-inferensmodel". Dens uovervågede læringsevne vil blive integreret med o-seriens ræsonnementteknologi, hvilket baner vejen for GPT-5, der blev frigivet i slutningen af maj. Udgivelsen af GPT-4.5 er ikke kun en teknologisk opgradering, men også en rekonstruktion af menneske-maskine-samarbejdsmodellen. Selvom flaskehalsen med høj pris og computerkraft er kontroversiel, giver dens gennembrud inden for følelsesmæssig resonans og praktisk funktion et nyt paradigme for integrationen af kunstig intelligens i uddannelse, medicinsk behandling og andre områder. AI har ubegrænset udviklingspotentiale!

Almindelige ofte stillede spørgsmål om GPT 4.5

Hvad er dens begrænsninger?

Den mangler tankekæder og kan være langsommere på grund af dens størrelse. Det producerer heller ikke multimodalt output som lyd eller video.

Kan det give fuldt nøjagtige svar 100 % af tiden?

Nej. Selvom GPT-4.5 generelt hallucinerer mindre end tidligere modeller, bør brugere stadig verificere vigtige eller følsomme output.

Understøtter GPT-4.5 billeder?

Ja, GPT-4.5 accepterer billedinput, kan generere SVG-billeder in-line og generere billeder via DALL·E.

Understøtter GPT-4.5 søgning på nettet?

Ja, GPT-4.5 har adgang til de seneste opdaterede oplysninger med søgning.

Hvilke filer og filtyper fungerer det med?

GPT-4.5 understøtter alle filer og filtyper.