Qwen2.5-Omni-7B API'en giver udviklere OpenAI-kompatible metoder til at interagere med modellen, hvilket muliggør behandling af tekst, billede, lyd og video-input og genererer både tekst- og naturlig talesvar i realtid.

Hvad er Qwen2.5-Omni-7B?

Qwen2.5-Omni-7B er Alibabas flagskib multimodale AI-model, der kan prale af 7 milliarder parametre. Designet til at behandle og forstå flere datamodaliteter, det understøtter tekst, billede, lyd og video input. Modellen letter tale- og videointeraktioner i realtid, hvilket gør den til et alsidigt værktøj til forskellige applikationer.

Nøglefunktioner i Qwen2.5-Omni-7B

- Multimodal behandling: I stand til at håndtere forskellige input, herunder tekst, billeder, lyd og video, hvilket muliggør omfattende dataforståelse.

- Interaktion i realtid: Understøtter behandling med lav latens, hvilket giver mulighed for tale- og videosamtaler i realtid.

- Tænker-taler-arkitektur: Anvender et system med dobbelt arkitektur, hvor 'Tænkeren' styrer databehandling og forståelse, mens 'Talker' genererer flydende taleoutput.

- Time-Alignet Multimodal RoPE (TMRoPE): Anvender TMRoPE til præcis synkronisering af tidsmæssige data på tværs af forskellige modaliteter, hvilket sikrer sammenhængende forståelse og generering af respons.

Ydelsesmålinger

Benchmark-præstationer

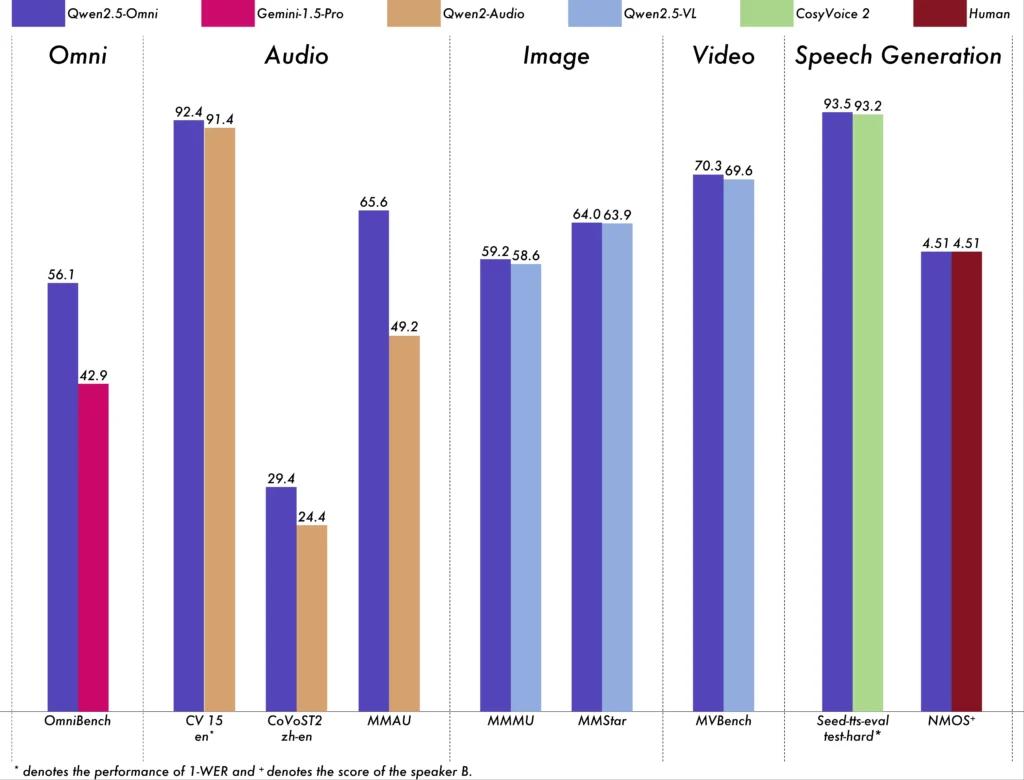

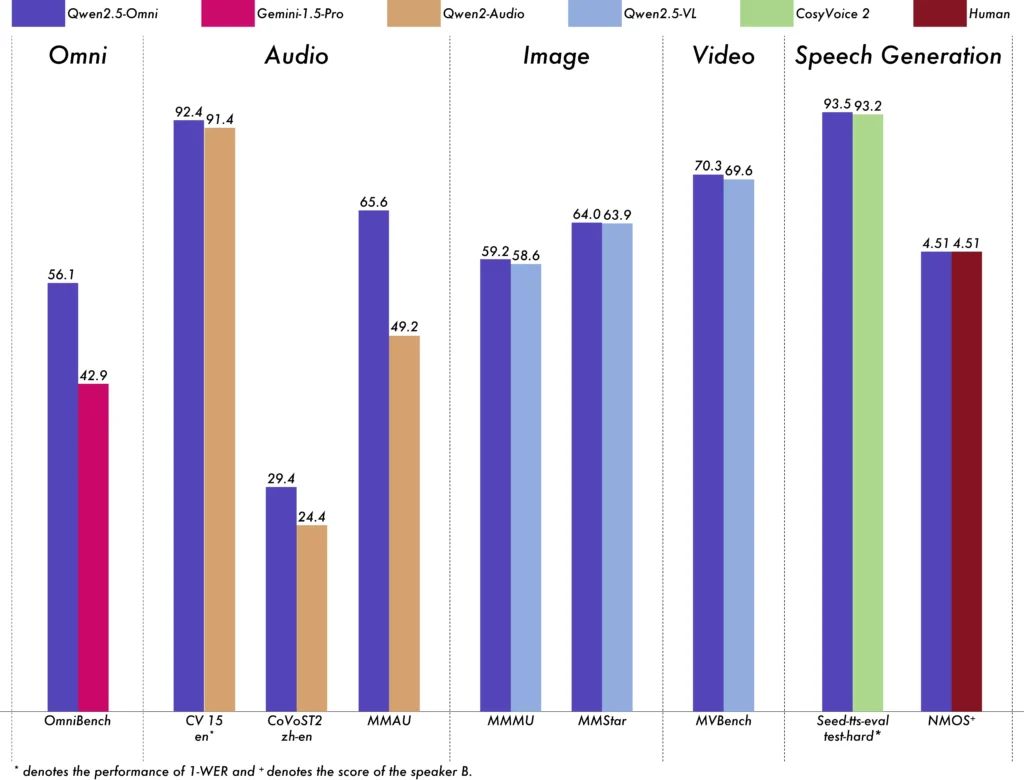

Qwen2.5-Omni-7B har vist enestående ydeevne på tværs af forskellige benchmarks:

- OmniBench: Opnåede en gennemsnitlig score på 56.13 %, hvilket overgik modeller som Gemini-1.5-Pro (42.91 %) og MIO-Instruct (33.80 %).

- Tale genkendelse: På Librispeech-datasættet opnåede det Word-fejlrater, der spænder fra 1.6 % til 3.5 %, sammenlignet med specialiserede modeller såsom Whisper-large-v3.

- Lydhændelsesgenkendelse: Sikret en score på 0.570 på Meld-datasættet, hvilket sætter et nyt benchmark i feltet.

- Musikforståelse: Opnåede en score på 0.88 på GiantSteps Tempo benchmark, hvilket fremhæver dens færdigheder i musikforståelse.

Realtidsbehandlingsfunktioner

Qwen2.5-Omni-7B er designet til realtidsapplikationer og understøtter blok-for-blok-streaming, hvilket muliggør øjeblikkelig lydgenerering med minimal latenstid. Denne funktion er især fordelagtig for applikationer, der kræver hurtige svar, såsom virtuelle assistenter og interaktive AI-systemer.

Tekniske specifikationer

Arkitektonisk design

- Thinker-Talker Framework: 'Thinker'-komponenten behandler og forstår multimodale input og genererer semantiske repræsentationer på højt niveau og tekstoutput. 'Talker'en konverterer disse repræsentationer til naturlig, flydende tale, hvilket sikrer problemfri kommunikation mellem AI-systemet og brugerne.

- TMRoPE-mekanisme: Løser udfordringen med at synkronisere tidsmæssige data fra forskellige kilder ved at justere tidsstempler for video- og lydinput, hvilket letter sammenhængende multimodal forståelse.

Træningsmetode

Modellen gennemgik en trefaset træningsproces:

- Fase 1: Faste sprogmodelparametre, mens du træner visuelle og lydkodere ved hjælp af omfattende lyd-tekst- og billed-tekst-par for at forbedre multimodal forståelse.

- Fase to: Frigør alle parametre og trænet på et mangfoldigt datasæt bestående af billede, video, lyd og tekst, hvilket yderligere forbedrer den omfattende multimodale forståelse.

- Fase tre: Fokuseret på datatræning i lang sekvens for at styrke modellens kapacitet til at håndtere komplekse, udvidede input.

Udvikling af Qwen-modeller

Progression fra Qwen til Qwen2.5

Udviklingen fra Qwen til Qwen2.5 betyder et væsentligt spring i AI-modeludvikling:

- Forbedrede parametre: Qwen2.5 udvidet til modeller med op til 72 milliarder parametre og tilbyder skalerbare løsninger til forskellige applikationer.

- Udvidet kontekstbehandling: Indførte muligheden for at behandle op til 128,000 tokens, hvilket letter håndteringen af omfattende dokumenter og komplekse samtaler.

- Kodningsmuligheder: Qwen2.5-Coder-varianten understøtter over 92 programmeringssprog og hjælper med kodegenerering, fejlfinding og optimeringsopgaver.

Fordele ved Qwen2.5-Omni-7B

Omfattende multimodal integration

Ved effektivt at behandle tekst, billeder, lyd og video giver Qwen2.5-Omni-7B en holistisk AI-løsning, der er velegnet til en bred vifte af applikationer.

Realtidsinteraktion

Dens lav-latency-behandling sikrer øjeblikkelige svar, hvilket forbedrer brugeroplevelsen i interaktive applikationer.

Open Source tilgængelighed

Som en open source-model fremmer Qwen2.5-Omni-7B gennemsigtighed og giver udviklere mulighed for at tilpasse og integrere modellen i forskellige platforme uden proprietære begrænsninger.

Tekniske indikatorer

- Modelparametre: 7 mia

- Input-modaliteter: Tekst, billede, lyd, video

- Output-modaliteter: Tekst, tale

- Behandlingsevne: Tale- og videointeraktion i realtid

- Ydeevne benchmarks:

- OmniBench: 56.13% gennemsnitlig score

- Librispeech (ordfejlfrekvens): Test-ren: 1.8 %, Test-andet: 3.4 %

Applikationsscenarier

Interaktive virtuelle assistenter

Qwen2.5-Omni-7B's realtidsbehandling og multimodale forståelse gør den ideel til virtuelle assistenter, der kan se, høre og reagere naturligt.

Oprettelse af multimedieindhold

Indholdsskabere kan udnytte modellen til at generere engagerende multimedieindhold, der problemfrit kombinerer tekst, billeder og lyd.

Hjælpemidler

Modellens muligheder kan hjælpe personer med handicap, såsom at levere beskrivende lyd til visuelt indhold.

Tips til brug

Optimering af ydeevne

For at opnå optimal ydeevne, især i realtidsapplikationer, anbefales det at bruge hardwareacceleratorer og sikre tilstrækkelig GPU-hukommelse.

Integration med eksisterende systemer

Udviklere bør overveje modellens input- og outputformater, når de integreres med eksisterende applikationer for at sikre kompatibilitet og maksimere effektiviteten.

Holder sig opdateret

Tjek jævnligt de officielle arkiver og dokumentation for opdateringer og bedste praksis for fuldt ud at udnytte Qwen2.5-Omni-7B's muligheder.

Relaterede emner Sådan kører du Qwen2.5-Omni-7B Model

Konklusion

Qwen2.5-Omni-7B eksemplificerer konvergensen af avanceret AI-forskning og praktisk anvendelse, og tilbyder en alsidig og effektiv løsning til en lang række opgaver på tværs af forskellige industrier. Dens open source-karakter sikrer, at den forbliver tilgængelig og tilpasningsdygtig, hvilket baner vejen for fremtidige innovationer inden for multimodal AI.

Sådan kalder du Qwen2.5-Omni-7B API fra CometAPI

1.Log på til cometapi.com. Hvis du ikke er vores bruger endnu, bedes du registrere dig først

2.Få adgangslegitimations-API-nøglen af grænsefladen. Klik på "Tilføj token" ved API-tokenet i det personlige center, få token-nøglen: sk-xxxxx og send.

-

Hent webadressen til dette websted: https://api.cometapi.com/

-

Vælg Qwen2.5-Omni-7B-slutpunktet for at sende API-anmodningen og indstil anmodningens brødtekst. Anmodningsmetoden og anmodningsorganet er hentet fra vores hjemmeside API dok. Vores hjemmeside giver også Apifox-test for din bekvemmelighed.

-

Bearbejd API-svaret for at få det genererede svar. Efter at have sendt API-anmodningen, vil du modtage et JSON-objekt, der indeholder den genererede fuldførelse.