DeepSeek har udgivet DeepSeek V3.2 som efterfølgeren til dens V3.x-linje og en ledsagende DeepSeek-V3.2-Speciale variant, som virksomheden positionerer som en højtydende, ræsonnement-først-udgave til agent/værktøjsbrug. V3.2 bygger på eksperimentelt arbejde (V3.2-Exp) og introducerer højere ræsonnementskapacitet, en Speciale-udgave optimeret til "guldniveau" matematik/konkurrencepræstation i programmering, og hvad DeepSeek beskriver som et førsteklasses dual-mode "tænkning + værktøj"-system, der tæt integrerer intern trinvis ræsonnement med ekstern værktøjsaktivering og agent-arbejdsgange.

Hvad er DeepSeek V3.2 – og hvordan adskiller V3.2-Speciale sig?

DeepSeek-V3.2 er den officielle efterfølger til DeepSeeks eksperimentelle V3.2-Exp-gren. Den beskrives af DeepSeek som en "Fornuftfokuseret" modelfamilie bygget til agenter, dvs. modeller, der ikke kun er justeret til naturlig samtalekvalitet, men specifikt til flertrins-inferens, værktøjsaktivering og pålidelig tankekæde-stil-ræsonnement, når der opereres i miljøer, der inkluderer eksterne værktøjer (API'er, kodeudførelse, dataconnectors).

Hvad er DeepSeek-V3.2 (basis)

- Positioneret som den almindelige produktionsefterfølger til V3.2-Exp-eksperimentlinjen; beregnet til bred tilgængelighed via DeepSeeks app/web/API.

- Holder en balance mellem beregningseffektivitet og robust ræsonnement for agentopgaver.

Hvad er DeepSeek-V3.2-Speciale

DeepSeek-V3.2-Speciale er en variant, som DeepSeek markedsfører som en mere kapabel "Special Edition", der er tunet til ræsonnement på konkurrenceniveau, avanceret matematik og agentpræstation. Markedsføres som en mere kapabel variant, der "skubber grænserne for ræsonnementsmuligheder". DeepSeek eksponerer i øjeblikket Speciale som en API-only-model med midlertidig adgangsrouting; tidlige benchmarks tyder på, at den er positioneret til at konkurrere med avancerede lukkede modeller inden for ræsonnement- og kodningsbenchmarks.

Hvilke afstamnings- og tekniske valg førte til V3.2?

V3.2 arver en række iterative engineering-metoder, som DeepSeek publicerede i 2025: V3 → V3.1 (Terminus) → V3.2-Exp (et eksperimentelt trin) → V3.2 → V3.2-Speciale. Den eksperimentelle V3.2-Exp blev introduceret. DeepSeek Sparse Attention (DSA) — en finmasket sparse attention-mekanisme, der har til formål at sænke hukommelses- og beregningsomkostninger for meget lange kontekstlængder, samtidig med at outputkvaliteten bevares. Denne DSA-forskning og omkostningsreduktionsarbejdet fungerede som et teknisk springbræt til den officielle V3.2-familie.

Hvad er nyt i den officielle DeepSeek 3.2?

1) Forbedret ræsonnementsevne — hvordan forbedres ræsonnement?

DeepSeek markedsfører V3.2 som "Fornuft først." Det betyder, at arkitekturen og finjusteringen fokuserer på pålidelig udførelse af flertrins-inferens, vedligeholdelse af interne tankekæder og understøttelse af de typer strukturerede overvejelser, som agenter har brug for for at bruge eksterne værktøjer korrekt.

Konkret omfatter forbedringerne:

- Træning og RLHF (eller lignende justeringsprocedurer) justeret til at fremme eksplicit trinvis problemløsning og stabile mellemtilstande (nyttigt til matematisk ræsonnement, generering af flertrinskode og logiske opgaver).

- Arkitektoniske og tabsfunktionsvalg, der bevarer længere kontekstvinduer og tillader modellen at referere til tidligere ræsonnementstrin med nøjagtighed.

- Praktiske tilstande (se "dobbelttilstand" nedenfor), der lader den samme model operere enten i en hurtigere "chat"-tilstand eller i en overvejende "tænkningstilstand", hvor den bevidst arbejder sig gennem mellemliggende trin, før den handler.

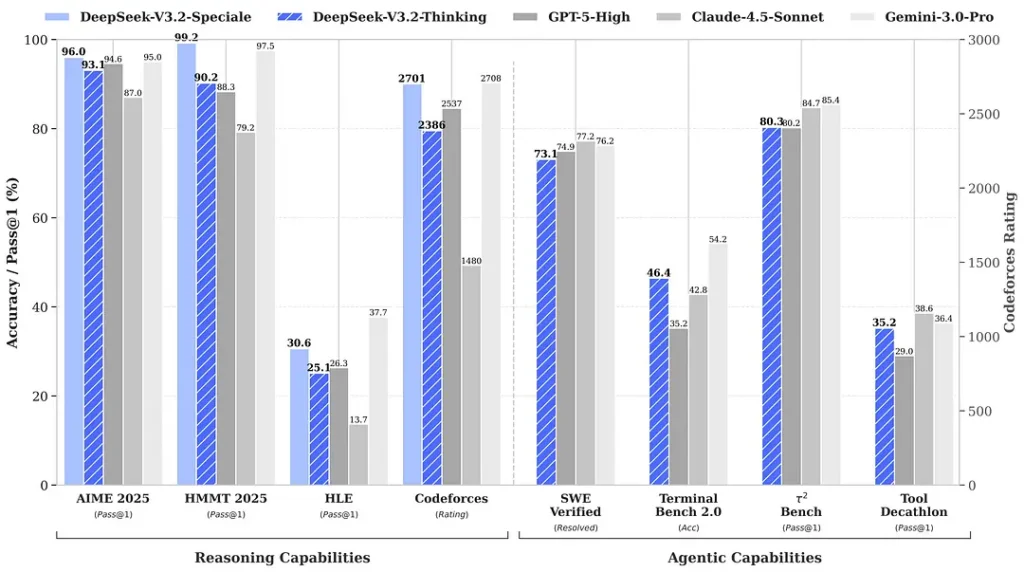

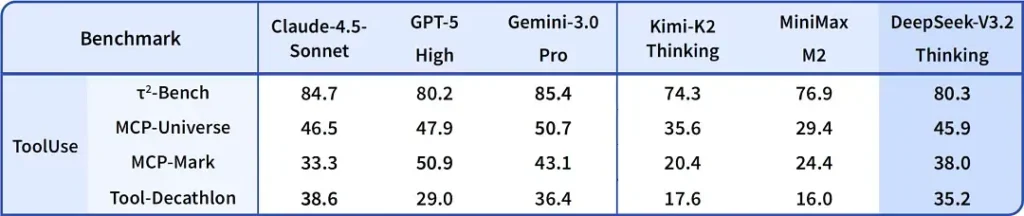

Benchmarks citeret omkring udgivelsen hævder bemærkelsesværdige forbedringer i matematik- og ræsonnementspakker; uafhængige tidlige community-benchmarks rapporterer også imponerende scorer på konkurrencedygtige evalueringssæt:

2) Gennembrud i ydeevnen i specialudgaven – hvor meget bedre?

DeepSeek-V3.2-Speciale hævdes at levere et skridt i retning af ræsonnementsnøjagtighed og agentorkestrering sammenlignet med standard V3.2. Udbyderen fremstiller Speciale som et performance-niveau målrettet mod tunge ræsonnementsbelastninger og udfordrende agentopgaver; det er i øjeblikket kun API-baseret og tilbydes som et midlertidigt endpoint med højere kapacitet (DeepSeek indikerede, at Speciales tilgængelighed vil være begrænset i starten). Speciale-versionen integrerer den tidligere matematiske model DeepSeek-Math-V2; Den kan bevise matematiske sætninger og verificere logisk ræsonnement på egen hånd; Den har opnået bemærkelsesværdige resultater i flere konkurrencer i verdensklasse:

- 🥇 IMO (International Matematisk Olympiade) Guldmedalje

- 🥇 CMO (Kinesisk Matematisk Olympiade) Guldmedalje

- 🥈 ICPC (International Computer Programming Contest) Andenplads (Menneskelig Konkurrence)

- 🥉 IOI (International Olympiade i Informatik) Tiendeplads (Menneskelig Konkurrence)

| benchmark | GPT-5 Høj | Gemini-3.0 Pro | Kimi-K2 Tænkning | DeepSeek-V3.2 Tænkning | DeepSeek-V3.2 Speciale |

|---|---|---|---|---|---|

| FORMÅL 2025 | 94.6 (13) | 95.0 (15) | 94.5 (24) | 93.1 (16) | 96.0 (23) |

| HMMT februar 2025 | 88.3 (16) | 97.5 (16) | 89.4 (31) | 92.5 (19) | 99.2 (27) |

| HMMT november 2025 | 89.2 (20) | 93.3 (15) | 89.2 (29) | 90.2 (18) | 94.4 (25) |

| IMOAnswerBench | 76.0 (31) | 83.3 (18) | 78.6 (37) | 78.3 (27) | 84.5 (45) |

| LiveCodeBench | 84.5 (13) | 90.7 (13) | 82.6 (29) | 83.3 (16) | 88.7 (27) |

| CodeForces | 2537 (29) | 2708 (22) | — | 2386 (42) | 2701 (77) |

| GPQA diamant | 85.7 (8) | 91.9 (8) | 84.5 (12) | 82.4 (7) | 85.7 (16) |

| HLE | 26.3 (15) | 37.7 (15) | 23.9 (24) | 25.1 (21) | 30.6 (35) |

3) Første implementering nogensinde af et dobbeltfunktionelt "tænkning + værktøj"-system

En af de mest praktisk interessante påstande i V3.2 er en dobbelttilstands-workflow der adskiller (og lader dig vælge mellem) hurtig samtalefunktion og en langsommere, overvejende "tænkningstilstand", der integreres tæt med værktøjsbrug.

- "Chat / hurtig"-tilstand: Designet til brugervenlig chat med lav latenstid, præcise svar og færre interne ræsonnementsspor – god til afslappet hjælp, korte spørgsmål og svar og hastighedsafhængige applikationer.

- "Tænkning / ræsonnement"-tilstand: Optimeret til stringent tankekæde, trinvis planlægning og orkestrering af eksterne værktøjer (API'er, databaseforespørgsler, kodeudførelse). Når modellen opererer i tænketilstand, producerer den mere eksplicitte mellemtrin, som kan inspiceres eller bruges til at køre sikre, korrekte værktøjskald i agentsystemer.

Dette mønster (et to-tilstandsdesign) var til stede i tidligere eksperimentelle grene, og DeepSeek har integreret det mere dybtgående i V3.2 og Speciale — Speciale understøtter i øjeblikket udelukkende tænketilstanden (deraf API-gating). Muligheden for at skifte mellem hastighed og overvejelse er værdifuld for engineering, fordi den giver udviklere mulighed for at vælge den rigtige afvejning for latenstid vs. pålidelighed, når de bygger agenter, der skal interagere med virkelige systemer.

Hvorfor det er bemærkelsesværdigt: Mange moderne systemer tilbyder enten en stærk tankekædemodel (for at forklare ræsonnement) eller et separat agent/værktøj-orkestreringslag. DeepSeeks framing antyder en tættere kobling – modellen kan "tænke" og derefter deterministisk kalde værktøjer ved hjælp af værktøjsresponser til at informere efterfølgende tænkning – hvilket er mere problemfrit for udviklere, der bygger autonome agenter.

Hvor skal man komme hen? DeepSeek v3.2

Kort svar — du kan få DeepSeek v3.2 på flere måder afhængigt af hvad du har brug for:

- Officiel web/app (brug online) — prøv DeepSeek-webgrænsefladen eller mobilappen for at bruge V3.2 interaktivt.

- API-adgang — DeepSeek eksponerer V3.2 via deres API (dokumentationen inkluderer modelnavne / base_url og priser). Tilmeld dig en API-nøgle og kald v3.2-slutpunktet.

- Downloadbare/åbne vægte (Hugging Face) — modellen (V3.2 / V3.2-Exp varianter) er udgivet på Hugging Face og kan downloades (open-weight). Brug

huggingface-hubortransformersat trække filerne. - CometAPI — En AI API-aggregeringsplatform leverer hostede endpoints V3.2-Exp. Prisen er billigere end den officielle pris.

Et par praktiske noter:

- Hvis du vil vægte til at køre lokalt, gå til siden med krammeansigtsmodellen (accepter eventuelle licens-/adgangsbetingelser der) og brug

huggingface-cliortransformersat downloade; GitHub-repoet viser normalt de nøjagtige kommandoer. - Hvis du vil produktionsbrug via API, følg den ønskede platform, såsom cometapi API-dokumentation for endpoint-navne og den korrekte

base_urlfor V3.2-varianten.

DeepSeek-V3.2-Specialer:

- Kun åben til forskningsbrug, understøtter dialogen "Tænketilstand", men understøtter ikke værktøjskald.

- Maksimal output kan nå 128K tokens (ultralang Thinking Chain).

- I øjeblikket gratis at teste indtil 15. december 2025.

Afsluttende tanker

DeepSeek-V3.2 repræsenterer et meningsfuldt skridt i modningen af ræsonnementscentrerede modeller. Kombinationen af forbedret flertrinsræsonnement, specialiserede højtydende udgaver (Speciale) og en produktionsbaseret "tænkning + værktøj"-integration er bemærkelsesværdig for alle, der bygger avancerede agenter, kodningsassistenter eller forskningsarbejdsgange, der skal integrere overvejelser med eksterne handlinger.

Udviklere kan få adgang til DeepSeek V3.2 via CometAPI. For at begynde, udforsk CometAPI's modelfunktioner i Legeplads og konsulter API guide for detaljerede instruktioner. Før du får adgang, skal du sørge for at være logget ind på CometAPI og have fået API-nøglen. CometAPI tilbyde en pris, der er langt lavere end den officielle pris, for at hjælpe dig med at integrere.

Klar til at gå? → Tilmeld dig CometAPI i dag !

Hvis du vil vide flere tips, guider og nyheder om AI, følg os på VK, X og Discord!