Kimi K2 repræsenterer et betydeligt spring inden for store open source-sprogmodeller, der kombinerer en avanceret ekspertarkitektur med specialiseret træning til agentopgaver. Nedenfor udforsker vi dens oprindelse, design, ydeevne og praktiske overvejelser i forbindelse med adgang og brug.

Hvad er Kimi K2?

Kimi K2 er en sprogmodel med en blanding af eksperter (MoE) baseret på billioner af parametre, udviklet af Moonshot AI. Den har 32 milliarder "aktiverede" parametre - dem, der er aktiveret pr. token - og et samlet antal ekspertparametre på 1 billion, hvilket muliggør massiv kapacitet uden lineære inferensomkostninger. Kimi K2, der er bygget på Muon-optimereren, blev trænet på over 15.5 billioner tokens, hvilket opnåede stabilitet i skalaer, der tidligere blev anset for upraktiske. Modellen tilbydes i to hovedvarianter:

Kimi‑K2‑Instruktion: Forudindstillet til konversations- og agentapplikationer, klar til øjeblikkelig implementering i dialogsystemer og værktøjsaktiverede arbejdsgange.

Kimi-K2-Base: En grundlæggende model egnet til forskning, brugerdefineret finjustering og eksperimentering på lavt niveau.

Hvordan fungerer dens arkitektur?

- Ekspertblanding (MoE): På hvert lag udvælger en gating-mekanisme en lille delmængde af eksperter (8 ud af 384) til at behandle hvert token, hvilket dramatisk reducerer beregningsbehovet for inferens, samtidig med at en massiv vidensbase opretholdes.

- Specialiserede lag: Indeholder et enkelt tæt lag sammen med i alt 61 lag, med 64 opmærksomhedshoveder og skjulte dimensioner skræddersyet til MoE-effektivitet.

- Kontekst og ordforråd: Understøtter op til 128 tokens i kontekstlængde og et ordforråd på 160 tokens, hvilket muliggør forståelse og generering af lange formater.

Hvorfor er Kimi K2 vigtig?

Kimi K2 flytter grænserne for open source AI ved at levere ydeevne på niveau med førende proprietære modeller, især inden for kodning og ræsonnement benchmarks.

Hvilke benchmarks viser dens muligheder?

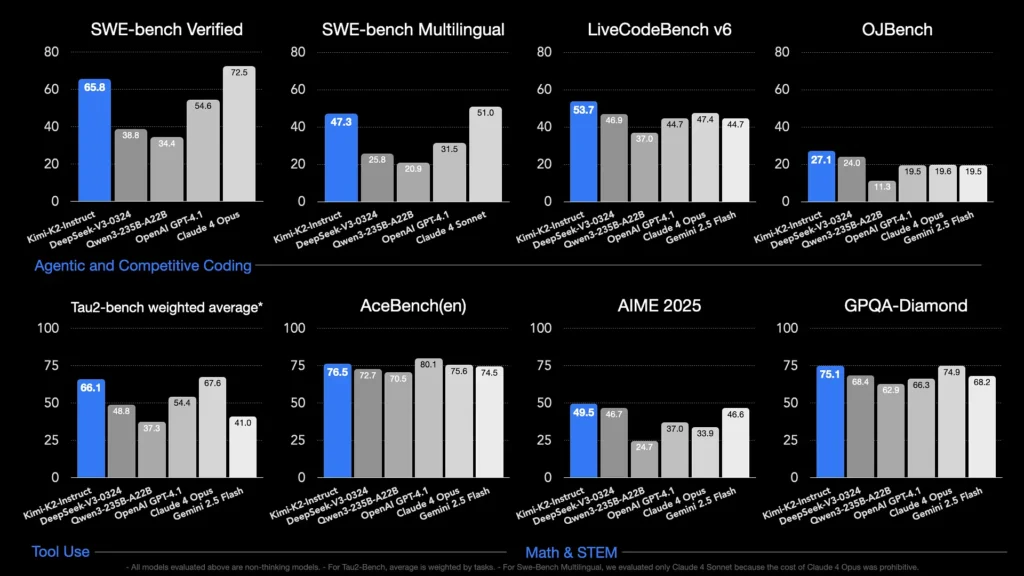

- LiveCodeBench v6: Opnår en pass@1-rate på 53.7%, hvilket er førende i open source-modeller og konkurrerer med lukkede systemer som GPT-4.1 (44.7%).

- SWE-bænk verificeret: Scorer 65.8%, hvilket overgår GPT-4.1's 54.6% og kun overgået af Claude Sonnet 4 i offentligt tilgængelige sammenligningstests.

- MultiPL-E & OJBench: Demonstrerer robust flersproget kodningsevne (85.7% på MultiPL-E) og pålidelig ydeevne på tværs af virkelige programmeringsudfordringer.

- Matematik-500Opnår 97.4%, hvilket overgår GPT-4.1's 92.4%, og viser dermed dens dygtighed inden for formel matematisk ræsonnement.

Hvordan er det optimeret til agentopgaver?

Ud over rågenerering blev Kimi K2 trænet med syntetiske værktøjsbrugsscenarier - Model Context Protocol (MCP)-data - til at kalde eksterne værktøjer, ræsonnere gennem flertrinsprocesser og autonomt løse problemer. Dette gør den særligt dygtig i miljøer som Cline, hvor den problemfrit kan orkestrere kodeudførelse, API-interaktion og workflowautomatisering.

Hvordan kan jeg få adgang til Kimi K2?

Adgangsmulighederne spænder over officielle platforme, open source-distributioner og tredjepartsintegrationer, der imødekommer forsknings-, udviklings- og virksomhedsbehov.

Officiel Moonshot AI-platform

Moonshot AI tilbyder hosted inferens via sin platform, hvilket giver API-adgang med lav latenstid til både Kimi-K2-Base og Kimi-K2-Instruct-varianter. Prisen er niveauopdelt baseret på computerforbrug, med virksomhedsplaner, der inkluderer prioriteret support og on-prem implementeringer. Brugere kan tilmelde sig på Moonshot AI's hjemmeside og hente API-nøgler til øjeblikkelig integration.

CometAPI

CometAPI har allerede integreret K2 i sine tilbud. De kombinerer K2-inferens med administreret GPU-infrastruktur, SLA-garantier og skalerbare prisniveauer, hvilket gør det muligt for organisationer at vælge mellem API-brug med betaling efter forbrug eller reserveret kapacitet med mængderabatter.

CometAPI er en samlet API-platform, der samler over 500 AI-modeller fra førende udbydere – såsom OpenAIs GPT-serie, Googles Gemini, Anthropics Claude, Midjourney, Suno og flere – i en enkelt, udviklervenlig brugerflade. Ved at tilbyde ensartet godkendelse, formatering af anmodninger og svarhåndtering forenkler CometAPI dramatisk integrationen af AI-funktioner i dine applikationer.

Udviklere kan få adgang Kimi K2 API(kimi-k2-0711-preview)ved CometAPIFor at begynde, udforsk modellens muligheder i Legeplads og konsulter API guidefor detaljerede instruktioner. Før du får adgang, skal du sørge for at være logget ind på CometAPI og have fået API-nøglen.

Integrationer af tredjepartsværktøjer

- Kline: Et populært kodecentreret IDE, der native understøtter Kimi K2 via

cline:moonshotai/kimi-k2udbyder, der giver udviklere adgang til chat, kodegenerering og agentworkflows i deres editor med et enkelt klik. - Krammede ansigtsrum: Demoer fra fællesskabet og minimalistiske brugergrænseflader giver brugerne mulighed for at interagere med K2-Instruct-modeller direkte i browseren. En Hugging Face-konto er påkrævet, og ydeevnen kan variere afhængigt af delte backend-ressourcer.

Hvordan bruger jeg Kimi K2?

Når du har valgt en adgangsmetode, kan du bruge K2 til en række forskellige opgaver – fra chat til kodeudførelse og autonome agenter.

Via API eller platform-SDK

- Godkend: Hent din API-nøgle fra Moonshot AI eller CometAPI.

- Initialiser klient: Brug det officielle SDK (Python/JavaScript) eller standard HTTP-anmodninger.

- Vælg modelvariant:

- Kimi-K2-Base til finjustering og forskning.

- Kimi‑K2‑Instruktion til plug-and-play-chat og agenter.

- CometAPI's model:

kimi-k2-0711-preview

- Send prompts: Formatér input i henhold til chatskabelonen (system, bruger, assistentroller) for at udnytte optimeret adfærd i forhold til at følge instruktioner.

Kører lokalt med llama.cpp

For offline eller selvhostede opsætninger skal du bruge de Unsloth-kvantiserede GGUF-vægte (245 GB for 1.8-bit dynamisk kvantitet).

- Download vægte: Fra Moonshot AI GitHub eller Hugging Face-arkivet.

- Installer llama.cpp: Sørg for, at du har tilstrækkelig diskplads (≥ 250 GB) og kombineret RAM+VRAM (≥ 250 GB) til en gennemløbshastighed på ~5 tokens/s.

- Lanceringsmodel:

./main --model kimi-k2-gguf.q8_0 --prompt "Your prompt here" - Juster indstillinger: Brug anbefalede parametre (

rope_freq_base,context_len) dokumenteret i Unsloth-guiden for stabil ydeevne.

Integrationer med udviklingsværktøjer

- IDE-plugins: Adskillige community-plugins aktiverer K2 i VS Code, Neovim og JetBrains IDE'er. Konfiguration involverer typisk angivelse af API-slutpunktet og model-ID'et i indstillinger.

- Automatiseringsrammer: Udnyt K2's agentkerne med frameworks som LangChain eller Haystack til at kæde prompts, API-kald og kodeudførelsestrin sammen i komplekse automatiseringer.

Hvad er de typiske anvendelsesscenarier for Kimi K2?

K2's kombination af skala, agentisk træning og åben adgang gør det alsidigt på tværs af domæner.

Kodningshjælp

Fra generering af standardtekster og refactoring til fejlretning og performanceprofilering omsættes K2's SOTA-kodningsbenchmarks til produktivitetsgevinster i den virkelige verden – ofte med en bedre læsbarhed og enkelhed end alternativer.

Viden og ræsonnement

Med en kontekstlængde på 128 K håndterer K2 lange dokumenter, spørgsmål og svar i flere dokumenter og tankekæder. Dens MoE-arkitektur sikrer opbevaring af forskelligartet viden uden katastrofal glemsel.

Agentiske arbejdsgange

K2 udmærker sig ved at orkestrere flertrinsopgaver – hentning af data, kald af API'er, opdatering af kodebaser og opsummering af resultater – hvilket gør den ideel til autonome assistenter inden for kundesupport, dataanalyse og DevOps.

Hvordan klarer Kimi K2 sig i forhold til andre open source-modeller?

Mens DeepSeeks V3 og Metas nylige åbne udgivelser har domineret overskrifterne tidligere i 2025, adskiller Kimi K2 sig ved:

Agentintelligens

Kimi K2 blev eksplicit designet til "agentiske" arbejdsgange – automatisering af opgaver via værktøjskald, shell-kommandoer, webautomatisering og API-integrationer. Dets selvudviklede træningsdatasæt indeholder forskellige eksempler på værktøjskald, hvilket muliggør problemfri integration med virkelige systemer.

Omkostningseffektivitet

Med cirka 80-90 % lavere inferensomkostninger pr. token sammenlignet med modeller som Claude Sonnet 4, tilbyder Kimi K2 ydeevne i virksomhedsklassen uden blockbuster-priser, hvilket katalyserer hurtig adoption blandt prisfølsomme udviklere.

Licenser og tilgængelighed

I modsætning til visse open source-udgivelser, der er behæftet med restriktive licenser, er Kimi K2 tilgængelig under en permissiv licens, der tillader kommerciel brug, afledte værker og lokale implementeringer, hvilket stemmer overens med Moonshot AIs open source-etos.

—

Ved at forene banebrydende MoE-design, grundig agenttræning og tilgængelighed af open source giver Kimi K2 udviklere og forskere mulighed for at bygge intelligente, autonome applikationer uden uoverkommelige omkostninger eller lukkede økosystemer. Uanset om du skriver kode, udvikler komplekse flertrins-workflows eller eksperimenterer med storstilet ræsonnement, tilbyder K2 et alsidigt og højtydende fundament.