Billedredigering med kunstig intelligens er gået fra sjovt legetøj til et egentligt workflow-værktøj på måneder – ikke år. Hvis du har brug for at fjerne baggrunde, bytte ansigter, bevare en karakter på tværs af optagelser eller lave flertrinskompositioner med naturligt sprog, lover flere nye modeller at gøre det hurtigere og med færre manuelle rettelser. I dette indlæg sammenligner jeg tre af de værktøjer, folk taler om lige nu: OpenAI's GPT-billede-1, Qwen-Billedredigering, den virale Nano-banan modeller (Gemini-2.5-Flash-Image), og Flux-kontekstJeg vil gennemgå, hvad hver enkelt er god til, hvor de ikke lykkes, og give en praktisk anbefaling afhængigt af, hvad du vil opnå.

Hvad er de kernekompetencer, der definerer ekspertise inden for billed-AI?

"Bedst" afhænger af, hvad du har brug for. Min evaluering bruger syv praktiske kriterier. Før vi dissekerer individuelle modeller, er det afgørende at forstå de grundlæggende funktioner, der definerer ekspertise inden for billedgenerering og redigering af kunstig intelligens. Disse kan bredt kategoriseres i:

- Generationskvalitet og -trofasthed: Dette refererer til AI'ens evne til at producere meget realistiske, æstetisk tiltalende og sammenhængende billeder ud fra tekstprompter. Faktorer omfatter detaljer, belysning, komposition og fravær af artefakter eller forvrængninger.

- Redigeringsalsidighed og præcision: Ud over den indledende generation bør en overlegen AI tilbyde robuste redigeringsfunktioner. Dette inkluderer inpainting (udfyldning af manglende dele), outpainting (udvidelse af billeder), fjernelse/tilføjelse af objekter, stiloverførsel og præcis kontrol over specifikke elementer.

- Hastighed og effektivitet: For professionelle arbejdsgange er den tid, det tager at generere eller redigere billeder, altafgørende. Hurtigere behandling uden at gå på kompromis med kvaliteten er en betydelig fordel.

- Brugeroplevelse og tilgængelighed: En intuitiv brugerflade, klare kontroller og nem integration i eksisterende arbejdsgange er afgørende for udbredt anvendelse og brugertilfredshed.

- Etiske overvejelser og sikkerhedsfunktioner: Efterhånden som AI bliver mere kraftfuld, er ansvarlig udvikling og implementering afgørende. Dette inkluderer beskyttelse mod generering af skadeligt eller partisk indhold.

- Omkostningseffektivitets- og prismodeller: Selvom nogle værktøjer tilbyder gratis niveauer, er det vigtigt for budgetbevidste brugere at forstå prisstrukturen for avancerede funktioner og kommerciel brug.

- Konsekvente flertrinsredigeringer — bevarelse af identitet/objekter på tværs af flere redigeringer eller billeder.

Jeg hælder til det praktiske: en model, der producerer lidt mindre "wow-faktor"-billeder, men som giver dig mulighed for at få reproducerbare, hurtige og pålidelige redigeringer, vil slå en prangende model, der kræver en masse oprydning.

Hvilke modeller er der under overvejelse, og hvad adskiller dem?

Hurtigt modeløjebliksbillede

- gpt-billede-1 (OpenAI) — en native multimodal model udgivet til API i april 2025, der direkte understøtter iterativ billedgenerering og -redigering i den samme multimodale Responses/Images API.

- Gemini 2.5 Flash-billede (Google) — annonceret 26. august 2025 (“nano-banana”); designet til hurtig generering med lav latenstid og omfattende redigering (fusion af flere billeder, tegnkonsistens); inkluderer SynthID-vandmærkning for proveniens.

- Qwen-Billedredigering (QwenLM / Alibaba-gruppen) — en billedredigeringsversion af Qwen-Image (20B fundament) med vægt på tosproget, præcis tekstredigering og kombineret semantisk + udseenderedigering.

- FLUX.1 Kontext (Flux / Black Forest Labs / Flux platformvarianter) — en familie af modeller (Dev / Pro / Max) med fokus på hurtig, lokal, kontekstbevidst redigering med tegnkonsistens og iterative arbejdsgange.

Hvorfor disse fire?

De dækker de mest relevante designpunkter, som designudviklere spørger om i 2025: multimodal integration (OpenAI), skalering + produktion plus verdenskendskab (Google), præcisionsredigering og åben forskning (Qwen) og UX-first iterativ redigering (Flux). Hver især har forskellige afvejninger i forhold til omkostninger, latenstid og hvor de skinner (tekstgengivelse, fusion af flere billeder, iterativ redigering, bevarelse af uændrede områder).

GPT-Image-1 (OpenAI) — udviklerens tunge medarbejder

Hvad er det: OpenAIs GPT-Image-1 er en native multimodal model, der accepterer både tekst- og billedinput og understøtter generering og billedredigering (inpainting, image-to-image) via deres Images API. Den er positioneret som en produktionsmodel til integration på tværs af apps og tjenester. Den er designet som en native tekst+billedmodel, der kan acceptere billedinput og tekstprompter og udføre redigeringer med fin kontrol.

Hvad er styrkerne ved GPT-image-1?

- Enestående semantisk forståelse: En af GPT-image-1's primære styrker ligger i dens evne til at fortolke nuancerede og detaljerede tekstmeddelelser. Brugere kan beskrive indviklede scener, specifikke stemninger og abstrakte koncepter med bemærkelsesværdig nøjagtighed, og AI'en producerer ofte billeder, der trofast afspejler disse beskrivelser.

- Fotorealisme i høj kvalitet: Når GPT-image-1 bliver bedt om at lave realistiske billeder, leverer det ofte output, der er slående naturtro, med imponerende fokus på teksturer, belysning og naturlige kompositioner. Dette gør det til et formidabelt værktøj til fotorealistisk rendering og konceptkunst.

- Kreativ fortolkning: Ud over blot bogstavelig oversættelse udviser GPT-image-1 en grad af kreativ fortolkning, ofte med tilføjelse af subtile detaljer eller stilistiske udsmykninger, der forbedrer den genererede billedes samlede kunstneriske appel. Dette kan være særligt gavnligt for idégenerering og udforskning af forskellige visuelle koncepter.

- Stærkt fundament for iteration: Dens evne til at generere indledende koncepter af høj kvalitet giver et fremragende udgangspunkt for yderligere forfinelse, enten inden for AI'ens redigeringsmuligheder (hvis tilgængelige) eller gennem traditionel grafisk designsoftware.

Hvad er begrænsningerne ved GPT-image-1?

- Kontrol over fine detaljer: Selvom de er fremragende til brede koncepter, kan det nogle gange være udfordrende at opnå absolut kontrol på pixelniveau eller præcis manipulation af meget små elementer. Dette er en almindelig hindring for mange generative AI'er, hvor outputtet er noget deterministisk baseret på prompten.

- Tilgængelighed og integration: Afhængigt af den specifikke implementering kan GPT-image-1's direkte redigeringsfunktioner være mindre robuste eller integrerede sammenlignet med dedikerede billedredigeringsplatforme. Brugere kan være nødt til at eksportere og bruge andre værktøjer til intensiv redigering efter generering.

- Beregningskrav: Generering af meget detaljerede billeder med komplekse prompts kan være beregningskrævende, hvilket potentielt kan føre til længere behandlingstider sammenlignet med mere specialiserede, lettere modeller til hurtige redigeringer.

Nano Banana (Google / Gemini 2.5 Flash-billede)

Hvad er det: "Nano Banana" er det legende navn, der er givet til Googles nylige Gemini-billedopgradering (Gemini 2.5 Flash Image). Den er blevet positioneret som en næste generations billedgenerator/-editor inden for Googles Gemini-økosystem, markedsført for stærkere, mere nuancerede flertrinsredigeringer og overlegen ensartethed i fotoredigeringer.

Hvor skinner Gemini-2.5-Flash-Image i det visuelle AI-landskab?

Gemini-2.5-Flash-Image, en nyere version designet til hastighed og effektivitet, er Googles konkurrent, der sigter mod en balance mellem output af høj kvalitet og hurtig behandling. Dens "Flash"-betegnelse peger specifikt på dens optimerede arkitektur for hurtigere responstider, hvilket gør den yderst velegnet til applikationer, hvor generering og redigering i realtid eller næsten realtid er afgørende.

Hvad gør Gemini-2.5-Flash-Image til en stærk kandidat?

- Lynhurtig generation: Som navnet antyder, er hastighed en central fordel. Gemini-2.5-Flash-Image udmærker sig ved at generere billeder hurtigt, hvilket er uvurderligt for kreative fagfolk med stramme deadlines eller til interaktive applikationer.

- Solid billedkvalitet: Trods sin hastighed går modellen ikke væsentligt på kompromis med billedkvaliteten. Den producerer sammenhængende, visuelt tiltalende billeder, der generelt er fri for større artefakter, hvilket gør den konkurrencedygtig med langsommere og mere ressourcekrævende modeller til mange anvendelsesscenarier.

- Multimodal forståelse: Ved at udnytte det bredere Gemini-framework drager det ofte fordel af avanceret multimodal forståelse, hvilket betyder, at det potentielt kan fortolke ikke blot tekst, men også andre former for input for at guide billedgenerering og -redigering, selvom dette varierer afhængigt af den specifikke API.

- Integrerede redigeringsfunktioner: Gemini-2.5-Flash-Image leveres typisk med integrerede redigeringsfunktioner såsom inpainting (udfyldning af manglende dele af et billede), outpainting (udvidelse af et billede ud over dets oprindelige rammer) og objektmanipulation, hvilket gør det til en mere komplet løsning til end-to-end billedworkflows.

Hvad er forbedringsområderne for Gemini-2.5-Flash-Image?

- Højeste fotorealisme: Selvom det er godt, når det måske ikke altid den absolutte top af fotorealisme, der ses i nogle af de langsommere, større modeller til meget indviklede og nuancerede scener. Der kan være en lille afvejning mellem hastighed og ultimativ naturtrohed.

- Kunstnerisk nuance til komplekse stilarter: For meget specifikke kunstneriske stilarter eller ekstremt abstrakte anmodninger kan nogle brugere finde den lidt mindre i stand til at indfange de mest subtile kunstneriske nuancer sammenlignet med modeller, der er trænet på enorme kunsthistoriske datasæt.

- Kontrol over genereret tekst (i billeder): Ligesom mange generative modeller kan det stadig være en udfordring at generere perfekt sammenhængende og korrekt stavet tekst i et billede.

Hvad er Qwen-Image-Edit?

Hvad er det: Qwen-Billedredigering (Alibaba / Qwen-teamet) — billedredigeringsmodel bygget på Qwen-Image-familien; hævder stærk tosproget tekstredigering (kinesisk og engelsk), semantisk og udseendekontrol samt direkte billedredigeringsnøjagtighed.

Hvad er de unikke styrker ved Qwen-Image Edit?

- Overlegen redigeringspræcision: Qwen-Image Edit kan ofte prale af avancerede algoritmer til indmaling, udmaling og objektmanipulation, der muliggør meget præcise og problemfri redigeringer. Det udmærker sig ved at opretholde visuel sammenhæng, selv når der foretages betydelige ændringer.

- Kontekstbevidst redigering: En central styrke er dens kontekstbevidsthed. Når man for eksempel fjerner et objekt, udfylder den intelligent tomrummet med indhold, der logisk passer ind i det omgivende miljø, hvilket gør redigeringen praktisk talt uopdagelig.

- Stiloverføring og harmonisering: Qwen-Image Edit kan være yderst effektivt til at overføre stilarter fra et billede til et andet eller harmonisere forskellige elementer i et billede for at skabe et sammenhængende udseende. Dette er uvurderligt for designere, der arbejder med forskellige visuelle aktiver.

- Robust fjernelse/tilføjelse af objekter: Dens evne til at tilføje eller fjerne objekter, samtidig med at belysning, skygger og perspektiv bevares, er yderst imponerende, hvilket muliggør komplekse scenekonstruktioner eller oprydning.

- Billedopskalering og -forbedring: Indeholder ofte avancerede funktioner til opskalering af billeder uden at miste kvalitet og forbedring af detaljer, farver og den samlede visuelle appel.

Hvad er de potentielle svagheder ved Qwen-Image Edit?

- Fokus i den første generation: Selvom den kan generere billeder, ligger dens primære styrke og optimering ofte i redigering. Dens indledende tekst-til-billede-generering kan være god, men potentielt ikke så kreativt alsidig eller fotorealistisk som modeller, der udelukkende fokuserer på generering, afhængigt af den specifikke version.

- Læringskurve for avancerede funktioner: Præcisionen og dybden af redigeringsværktøjerne kan kræve en lidt stejlere indlæringskurve for brugere, der ikke er bekendt med avancerede billedmanipulationskoncepter.

- Ressourceintensitet for komplekse redigeringer: Meget komplekse redigeringer med flere lag kan stadig være beregningskrævende, hvilket potentielt kan føre til længere behandlingstider for meget store eller komplicerede opgaver.

Hvilke innovationer bringer Flux Kontext til billed-AI?

Hvad er det: Flux' Kontext (undertiden markedsført som FLUX.1 Kontext) er et billedredigerings-/genereringsværktøj designet til designere og brandteams. Det lægger vægt på kontekstbevidst redigering, præcis typografi, stiloverførsler og stram UI/UX til iterativt designarbejde.

Hvad er styrkerne ved Flux Kontext?

- Kontekstuel kohæsion: Flux Kontexts primære styrke er dens evne til at forstå og fastholde kontekst på tværs af flere billedgenerationer eller redigeringer. Dette er uvurderligt til at skabe ensartede visuelle fortællinger, karakterdesign eller produktlinjer, hvor visuel harmoni er afgørende.

- Forbedret konsistens i serier: Hvis du har brug for at generere en serie af billeder, der deler en fælles stil, karakter eller miljø, sigter Flux Kontext mod at reducere uoverensstemmelser, der kan plage andre modeller.

- Adaptiv styling: Den kan tilpasse sit output baseret på tidligere genererede billeder eller en defineret stilguide, hvilket fører til en mere strømlinet og mindre iterativ kreativ proces.

- Specialiseret til brand og narrativ: Særligt gavnligt for marketing, branding og storytelling, hvor en samlet visuel identitet er afgørende.

- Hurtig forståelse i kontekst: Dens hurtige forståelse handler ikke kun om det aktuelle billede, men hvordan det passer ind i en større kontekst eller et instruktionssæt.

Hvad er begrænsningerne ved Flux Kontext?

- Potentiale for nichefokus: Dens vægt på kontekst og konsistens kan betyde, at den ikke altid er den absolutte leder inden for rå, selvstændig fotorealisme eller ekstrem kunstnerisk mangfoldighed, hvis det er det eneste krav.

- Mindre offentligt dokumenterede benchmarks: Som en nyere eller mere specialiseret aktør kan omfattende offentlige benchmarkdata være mindre tilgængelige sammenlignet med mere etablerede modeller.

- Afhængig af tydelig kontekstuel input: For at udnytte dens styrker skal brugerne give klar kontekstuel information eller definere den narrative ramme effektivt, hvilket kan kræve en anden tilgang til prompterne.

Hvilken model er bedst til billedredigering?

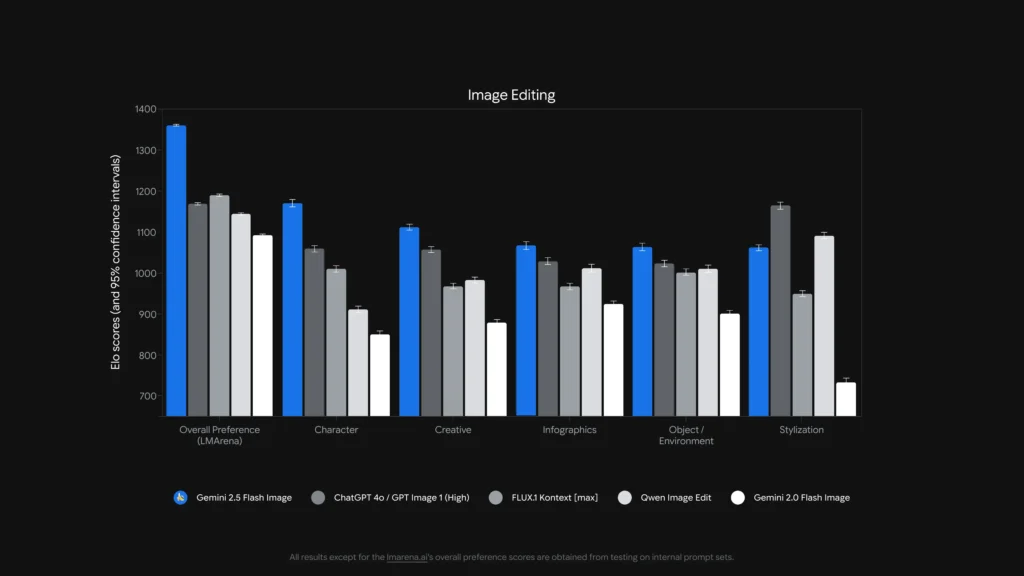

For enlige, præcise maskeløse redigeringer og tekstredigering inde i billeder, Qwen-Billedredigering og Gemini 2.5 Flash-billede (og specialiserede modeller som FLUX.1 Kontext) er blandt de stærkeste. komplekse flertrinskædede redigeringer, at kombinere en instruktionsstærk LLM-frontend (Gemini- eller GPT-varianter) med en billedmodel giver ofte det bedste resultat — noget benchmarkarbejde har vist, at Chain-of-Thought style prompting (Gemini-CoT) forbedrer succes med redigering i flere trin.

lokale redigeringer, tegnkonsistens, teksthåndtering

- Qwen-Billedredigering retter sig eksplicit mod begge semantiske og udseende redigeringer — f.eks. erstatte objekt, rotere, præcis tekstudskiftning — eksplicit bygget som en billedredigering model med dobbelte signalveje (semantisk kontrol via Qwen2.5-VL + udseendekontrol via VAE-encoder). Den reklamerer for robust tosproget (kinesisk/engelsk) tekstredigeringer i billeder (f.eks. ændre skiltetekst, produktetiketter) samtidig med at stilen bevares, hvilket er sjældent og værdifuldt til lokalisering og emballagearbejde.

- Gemini 2.5 Flash-billede understøtter maskerede redigeringer, promptdrevne lokale ændringer (slør baggrund, fjern person, skift positur) og fusion af flere billeder. Google annoncerer promptbaserede regionsbevidste redigeringer plus fordele ved verdenskendskab (f.eks. bedre objektsemantik i den virkelige verden). Modellen tilføjer også en usynligt SynthID vandmærke til genererede/redigerede billeder for at hjælpe med proveniens og detektion.

- FLUX.1 Kontekst: positionerer sig som en billed-til-billed kontekstløser — den er optimeret til præcise, kontekstbevidste lokale redigeringer og iterative eksperimenter. Anmeldere roser dens evne til at bevare kontekst og scenesemantik, samtidig med at der foretages lokale ændringer. FLUX.1 Kontext og Flux Kontext UI er rost i direkte praktiske tests for iterative redigeringsarbejdsgange og tekstlæsbarhed, hvilket gør den til et praktisk valg til arbejdsgange, der kræver mange hurtige iterationer (marketingaktiver, miniaturebilleder).

- GPT-billede-1: understøtter redigeringshandlinger (tekst+billedprompter til redigeringer), og OpenAIs værktøjer integrerer kæde- og prompt engineering-mønstre; ydeevnen er stærk, men afhænger af prompt engineering og kan halte bagefter specialiserede redigerings-først-modeller i finkornet redigering (f.eks. præcis tosproget teksterstatning) i nogle tests.

Benchmarks som f.eks. ComplexBench-Edit og CompBench viser, at mange modeller stadig fejler, når redigeringer er kædet sammen eller indbyrdes afhængige, men at kombinationen af en LLM til instruktionsparsing med en robust billedmodel (LLM→billedmodelorkestrering) eller brug af CoT-prompter kan reducere fejl. Derfor sammensætter nogle produktionsarbejdsgange modeller (f.eks. en ræsonnement-LLM plus en billedgenerator) til hårde redigeringer.

Hvem er bedst til at redigere tekst i billeder?

- Qwen-Billedredigering blev eksplicit designet til tosproget (kinesisk + engelsk) præcis tekstredigering og rapporterer overlegne resultater i tekstredigeringsbenchmarks (Qwens offentlige tekniske noter og rapporterede scorer). Open source Qwen-artefakter og -demoer viser nøjagtig bevarelse af skrifttype/størrelse/stil under redigeringer.

- gpt-billede-1 og Gemini 2.5 Flash-billede begge gør fremskridt i tekstgengivelse, men akademiske benchmarks og leverandørnotater indikerer resterende udfordringer for lille/detaljeret tekst og lange tekstpassager – forbedringer er trinvise og varierer afhængigt af prompt og løsning.

Komparativ analyse: Feature, Redigering

For at give et klarere billede, lad os konsolidere de vigtigste aspekter af disse førende AI-modeller i en sammenligningstabel.

| Funktion / Mulighed | GPT-billede-1 (OpenAI) | Gemini-2.5-Flash-billede (Google) | Qwen-Billedredigering (Alibaba) | FLUX.1 Kontekst |

|---|---|---|---|---|

| Native generation + redigering | Ja. Multimodal tekst + billede i én API. | Ja — native generering og målrettet redigering; fusion af flere billeder og karakterkonsistens understreges. | Fokuseret på redigering (Qwen-Image-Edit) med semantisk + udseendekontrol. | Fokuseret på billede-til-billede redigeringer i høj kvalitet. |

| Redigeringsdybde (lokale justeringer) | Høj (men generalist) | Meget høj (målrettede prompts + maskeløse redigeringer) | Meget høj for semantiske/tekstlige redigeringer (understøttelse af tosproget tekst). | Meget høj — kontekstbevidste redigeringspipelines. |

| Håndtering af tekst i billede | Godt, afhænger af hastighed | Forbedret (leverandør viser demoer af skabelon- og skilteredigering) | Bedst blandt disse for ændringer i tosprogede læsbare tekster. | Stærk til at bevare stilen; læsbarheden afhænger af prompten. |

| Karakter-/objektkonsistens | Godt med omhyggelig opfordring | Stærk (eksplicit funktion) | Medium (fokus er redigering snarere end identitet med flere billeder) | Stærk via iterative redigeringsworkflows. |

| Latens/gennemstrømning | Moderat | Lav latenstid / høj gennemløbshastighed (Flash-model) | Varierer afhængigt af hosting (lokal/HF vs. cloud) | Designet til hurtige iterative redigeringer i hostet SaaS. |

| Proveniens / vandmærkning | Intet obligatorisk vandmærke (politiske mekanismer) | SynthID usynligt vandmærke til billeder. | Afhænger af værten | Afhænger af værten |

Bemærkninger: "Redigeringsdybde" måler, hvor finkornede og pålidelige lokale redigeringer er i praksis; "Teksthåndtering" vurderer evnen til at placere/ændre læsbar tekst i billeder.

Hvad med latenstid, ergonomi for udviklere og virksomhedsintegration?

Latens- og implementeringsmuligheder

- Gemini 2.5 Flash-billede understreger lav latency og er tilgængelig via Gemini API, Google AI Studio og Vertex AI — et stærkt valg til virksomhedsapps, der har brug for forudsigelig hastighed og cloudintegration. Google rapporterer også omtrentlig prisfastsættelse pr. billede (og udviklerbloggen indeholder et eksempel på prisfastsættelse pr. billede).

- gpt-billede-1 er tilgængelig via OpenAI Images API og har bred økosystemintegration (Playground, partnere som Adobe/Canva). Prisen er tokenbaseret og varierer afhængigt af billedkvalitetsniveauet (OpenAI offentliggør token-til-dollar-konverteringer).

- Flux-kontekst fokuserer på en hurtig interaktiv brugeroplevelse og tilbyder kreditter + lave redigeringstider i produktdemoer — praktisk for designere og hurtig iteration. Qwen giver åbne artefakter og adgang til forskning (ideelt, hvis du vil hoste eller inspicere interne elementer).

Hvor meget koster disse tjenester – hvilken er bedst egnet?

Priserne ændrer sig ofte – nedenfor er udgivernes oplyste tal (august 2025) og repræsentative beregninger af omkostningerne pr. billede, hvor leverandørerne har offentliggjort dem.

Offentliggjorte priser (leverandørudtalelser)

| Model / Leverandør | Offentlig prisoversigt (offentliggjort) | Groft estimat pr. billede |

|---|---|---|

| gpt-billede-1 (OpenAI) | Tokeniseret prissætning (tekstinput $5 / 1M, billedinput $10 / 1M, billedudput $40 / 1M). OpenAI bemærker, at dette omtrent svarer til $ 0.02- $ 0.19 pr. genereret billede afhængigt af kvalitet/størrelse. | ~$0.02 (lav kvalitet/miniaturebillede) → ~$0.19 (kvadratisk billede af høj kvalitet) |

| Gemini 2.5 Flash-billede (Google) | $30 pr. 1 million output-tokens og eksempel: hvert billede ≈ 1290 outputtokens (~$0.039 pr. billede) ifølge udviklerens blog. Priser anvendes via Gemini API / Vertex. | ~$0.039 pr. billede (Google-eksempel) |

| Flux-kontekst (Flux) | Gratis niveau med kreditter; Flux produktsider viser 10 gratis kreditter og typiske redigeringer prissat til 5 kreditter; abonnementsniveauer tilgængelige for storbrugere. (Leverandørens produktside). | Meget lave omkostninger til lejlighedsvise redigeringer; abonnement ved intensiv brug. |

| Qwen-Billedredigering (QwenLM) | Åben udgivelse og GitHub-artefakter – åben adgang til forskning med gratis eksempler; kommercielle implementeringer varierer afhængigt af integrator (selvhostet vs. cloud). Ingen enkelt kanonisk pris pr. billede; har tendens til at være lavest, hvis selvhostet. |

Værdifortolkning: Hvis du har brug for billeder i høj volumen generation i produktion og ønsker forudsigelig prisfastsættelse pr. billede, er Googles eksempel pr. billede ekstremt konkurrencedygtigt. Hvis dine omkostninger domineres af human-in-the-loop-redigering eller iterativ designertid, kan Flux eller lokal kørsel af Qwen være mere økonomisk. OpenAI tilbyder et bredt SDK-økosystem og mange partnere, hvilket er værd at vælge det højere niveau for bekvemmeligheden ved integration.

Pris i CometAPI

| Model | GPT-billede-1 | Gemini-2.5-Flash-billede | FLUX.1 Kontekst |

| Pris | Input-tokens 8.00 USD; Output-tokens 32.00 USD | $0.03120 | flux kontekst pro: $0.09600 flux-kontext-max: $0.19200 |

Praktiske hurtige tips til at opnå de bedste resultater

Tips til prompter og arbejdsgange (gælder for alle modeller)

- Vær tydelig omkring kompositionenkameravinkel, belysning, stemning, brændvidde, objektiv og de rumlige relationer mellem objekter. Eksempel: "35 mm nærbillede, lille dybdeskarphed, motivet centreret, blødt lyskant fra øverste venstre hjørne."

- Brug iterativ forbedring til redigeringerForetag først grove strukturelle redigeringer, og følg derefter op med tekstur-/belysningsforbedringer. Modeller som FLUX og Gemini er bygget til at understøtte flertrinsforbedring.

- Til tekst i billeder: Angiv præcis den ønskede tekst, og tilføj "gengiv som et læseligt skilt med høj kontrast og realistisk prægning" — til tosprogede redigeringer skal du bruge Qwen-Image-Edit, når du har brug for nøjagtig kinesisk/engelsk tekst.

- Brug referencebillederFor karakterkonsistens eller produktvarianter, angiv referencebilleder af høj kvalitet og ankerprompts som "match karakteren i reference_01: ansigtstræk, kostumefarve og belysning." Gemini og Flux understreger fusion/konsistens af flere billeder.

- Maskering vs. maskeløs redigeringBrug en maske, hvor det er muligt, for at begrænse redigeringerne. Når maskeløs redigering bruges, skal man forvente lejlighedsvis spillover. Modeller varierer: Flux/Gemini håndterer maskeløse redigeringer godt, men en maske hjælper stadig.

- Brug GPT-billede / GPT-4o til komplekse kompositionsopgaver med flere objekter, antal og rumlige begrænsninger. Brug en enkelt, præcis instruktion pr. generation, når det er muligt.

Tips til omkostninger og latenstid

batchingBrug batch-API'er eller cloud-funktioner til at generere mange varianter effektivt. Gemini-2.5-Flash er optimeret til gennemløb, hvis du har brug for høj volumen.

Tunekvalitet vs. prisOpenAI eksponerer lave/mellem/høje billedniveauer; genererer grove udkast i lav kvalitet, færdiggør i høj kvalitet.

endelige dom

- Bedst til produktion og integration: GPT-billede-1 — stærkest til API-behov, komposition og integration i professionelle værktøjer.

- Bedst til forbrugerens fotoreale konsistens: Nano-banan — Googles Gemini-billedopgradering udmærker sig ved naturlige, sekventielle portrætredigeringer og en imødekommende brugeroplevelse.

- Bedste mobil-/redigeringsoplevelse: Flux-kontekst — fantastiske samtaleredigeringer på telefonen med lav friktion.

- Hvis du måler med kirurgiske tekstredigeringer og tosproget/flersproget redigering, er Qwen-Image-Edit** den bedste specialist og et fremragende valg, hvor tekstnøjagtighed i billeder er vigtig.

Kom godt i gang

CometAPI er en samlet API-platform, der samler over 500 AI-modeller fra førende udbydere – såsom OpenAIs GPT-serie, Googles Gemini, Anthropics Claude, Midjourney, Suno og flere – i en enkelt, udviklervenlig grænseflade. Ved at tilbyde ensartet godkendelse, formatering af anmodninger og svarhåndtering forenkler CometAPI dramatisk integrationen af AI-funktioner i dine applikationer. Uanset om du bygger chatbots, billedgeneratorer, musikkomponister eller datadrevne analysepipelines, giver CometAPI dig mulighed for at iterere hurtigere, kontrollere omkostninger og forblive leverandøruafhængig – alt imens du udnytter de seneste gennembrud på tværs af AI-økosystemet.

Udviklere kan få adgang GPT-billede-1, FLUX.1 Kontekst og Gemini 2.5 Flash-billede via CometAPI er de seneste modelversioner, der er angivet, fra artiklens udgivelsesdato. For at begynde med, skal du udforske modellens muligheder i Legeplads og konsulter API guide for detaljerede instruktioner. Før du får adgang, skal du sørge for at være logget ind på CometAPI og have fået API-nøglen. CometAPI tilbyde en pris, der er langt lavere end den officielle pris, for at hjælpe dig med at integrere.

Den seneste integration Qwen-Billedredigering vil snart blive vist på CometAPI, så følg med! Klar til at komme i gang med at redigere billeder? → Tilmeld dig CometAPI i dag !

Pris i CometAPI

| Model | GPT-billede-1 | Gemini-2.5-Flash-billede | FLUX.1 Kontekst |

| Pris | Input-tokens 8.00 USD; Output-tokens 32.00 USD | $0.03120 | flux kontekst pro: $0.09600 flux-kontext-max: $0.19200 |