Künstliche Intelligenz (KI) hat zahlreiche Branchen revolutioniert, und eine ihrer faszinierendsten Anwendungen ist die Bilderzeugung. Von der Erstellung realistischer menschlicher Gesichter bis hin zur Produktion surrealer Kunstwerke – die Fähigkeit zur KI-Bilderzeugung hat neue Wege in Kunst, Design und Technologie eröffnet. Dieser Artikel befasst sich mit den Mechanismen hinter KI-generierten Bildern, den zugrunde liegenden Modellen und den weiteren Auswirkungen dieser Technologie.

Die Grundlagen verstehen: Wie funktioniert die KI-Bildgenerierung?

Was sind generative Modelle?

Generative Modelle sind eine Klasse von KI-Algorithmen, die neue Dateninstanzen erstellen können, die den Trainingsdaten ähneln. Im Kontext der Bildgenerierung lernen diese Modelle Muster aus vorhandenen Bildern und nutzen dieses Wissen, um neue, ähnliche Bilder zu erzeugen.

Die Rolle neuronaler Netze

Das Herzstück der KI-Bildgenerierung bilden neuronale Netze, insbesondere Deep-Learning-Modelle wie Convolutional Neural Networks (CNNs). CNNs sind für die Verarbeitung von Daten mit einer gitterartigen Topologie konzipiert und eignen sich daher ideal für die Bildanalyse und -generierung. Sie erkennen Muster wie Kanten, Texturen und Formen, die für das Verständnis und die Darstellung von Bildern unerlässlich sind.

Wichtige KI-Modelle in der KI-Bildgenerierung

Generative Adversarial Networks (GANs)

GANs wurden 2014 von Ian Goodfellow eingeführt und bestehen aus zwei neuronalen Netzwerken: einem Generator und einem Diskriminator. Der Generator erzeugt Bilder, während der Diskriminator sie mit realen Bildern vergleicht. Durch diesen konfrontativen Prozess verbessert der Generator seine Ausgabe und erzeugt immer realistischere Bilder.

StilGAN

StyleGAN wurde von NVIDIA entwickelt und ist eine GAN-Variante, die für die Generierung hochwertiger menschlicher Gesichter bekannt ist. Es führt eine stilbasierte Generatorarchitektur ein, die die Steuerung verschiedener Detailebenen im Bild ermöglicht. StyleGAN2 und StyleGAN3 verbesserten die Bildqualität weiter und behoben Probleme wie Texture Sticking.

Diffusionsmodelle

Diffusionsmodelle erzeugen Bilder, indem sie mit zufälligem Rauschen beginnen und dieses schrittweise verfeinern, um das gewünschte Ergebnis zu erzielen. Sie erfreuen sich aufgrund ihrer Fähigkeit, qualitativ hochwertige Bilder zu erzeugen, und ihrer Flexibilität in verschiedenen Anwendungen großer Beliebtheit.

Stable Diffusion

Stable Diffusion ist ein Open-Source-Diffusionsmodell, das die Generierung von Text in Bilder ermöglicht. Es ermöglicht außerdem Inpainting und Outpainting und ermöglicht so die Bildbearbeitung und -erweiterung. Dank seines Open-Source-Charakters ist es für Entwickler und Künstler allgemein zugänglich.

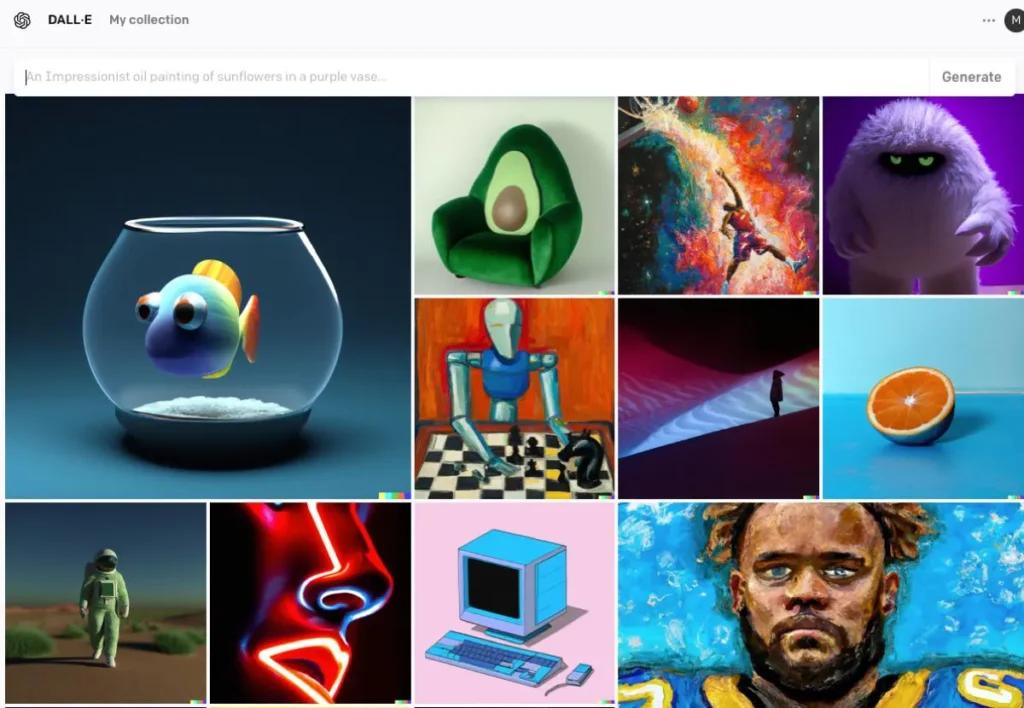

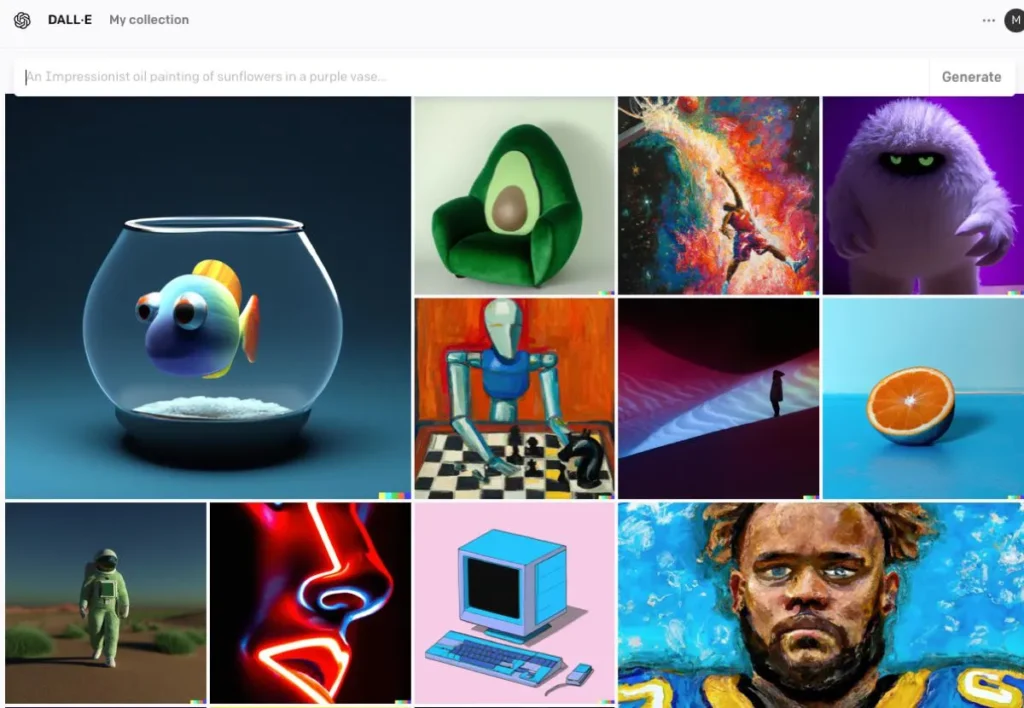

DALL · E.

DALL·E wurde von OpenAI entwickelt und ist ein transformerbasiertes Modell, das Bilder aus Textbeschreibungen generieren kann. DALL·E 2 und DALL·E 3 sind eine Weiterentwicklung des Originals und bieten eine höhere Auflösung und eine präzisere Bild-Text-Ausrichtung. DALL·E 3 ist in ChatGPT integriert und ermöglicht so eine verbesserte Benutzerinteraktion.

Der Prozess der KI-Bildgenerierung

Das Modell trainieren

KI-Modelle erfordern ein umfangreiches Training anhand großer Bilddatensätze. Während des Trainings lernt das Modell, Muster und Merkmale in den Bildern zu erkennen und so neue Bilder zu generieren, die die Trainingsdaten nachahmen.

Neue Bilder generieren

Nach dem Training kann das Modell neue Bilder generieren, indem es:

- Eingabe empfangen: Dies kann zufälliges Rauschen (in GANs), eine Textaufforderung (in DALL·E) oder ein vorhandenes Bild (zum Bearbeiten) sein. Dieser Schritt erfasst die semantische Bedeutung des Textes und ermöglicht es der KI, den Inhalt und Kontext zu verstehen.

- Eingabeverarbeitung: Das Modell verarbeitet die Eingaben über seine neuronalen Netzwerkschichten und wendet dabei erlernte Muster und Merkmale an. Aus dem kodierten Text erstellt die KI mithilfe von Modellen wie Generative Adversarial Networks (GANs) oder Diffusionsmodellen Bilder. Diese Modelle generieren Bilder, indem sie mit zufälligem Rauschen beginnen und es so verfeinern, dass es der Textbeschreibung entspricht.

- Verfeinerung und Bewertung: Das generierte Bild wird anschließend mithilfe von Aufmerksamkeitsmechanismen verfeinert, um die Übereinstimmung mit dem Text sicherzustellen. Ein Diskriminatormodell bewertet den Realismus des Bildes und die Übereinstimmung mit der Eingabe und liefert Feedback für die weitere Verfeinerung.

- Bildausgabe: Die endgültige Ausgabe ist ein neues Bild, das die Eigenschaften der Trainingsdaten und der bereitgestellten spezifischen Eingabe widerspiegelt.

Codebeispiel für die KI-Bildgenerierung

Hier sind praktische Python-Codebeispiele, die zeigen, wie Bilder mithilfe von drei bekannten KI-Modellen generiert werden: Generative Adversarial Networks (GANs), Stable Diffusion und DALL·E.

Generative Adversarial Networks (GANs) mit PyTorch

Generative Adversarial Networks (GANs) bestehen aus zwei neuronalen Netzwerken – dem Generator und dem Diskriminator –, die miteinander konkurrieren, um neue, realistische Dateninstanzen zu generieren. Hier ist ein vereinfachtes Beispiel für die Bildgenerierung mit PyTorch:

pythonimport torch

import torch.nn as nn

# Define the Generator network

class Generator(nn.Module):

def __init__(self):

super(Generator, self).__init__()

self.fc1 = nn.Linear(100, 128)

self.fc2 = nn.Linear(128, 784) # Assuming output image size is 28x28

def forward(self, x):

x = torch.relu(self.fc1(x))

x = torch.tanh(self.fc2(x))

return x

# Instantiate the generator

generator = Generator()

# Generate a random noise vector

noise = torch.randn(1, 100)

# Generate an image

generated_image = generator(noise)

Dieser Code definiert ein einfaches Generatornetzwerk, das einen 100-dimensionalen Rauschvektor als Eingabe verwendet und eine 784-dimensionale Ausgabe erzeugt, die in ein 28×28-Bild umgewandelt werden kann. Die tanh Die Aktivierungsfunktion stellt sicher, dass die Ausgabewerte im für Bilddaten üblichen Bereich liegen.

Stabile Diffusion mit dichten Gesichtsdiffusoren

Stabile Diffusion ist ein leistungsstarkes Text-zu-Bild-Modell, das Bilder basierend auf Textbeschreibungen generiert. Das umarmende Gesicht diffusers Die Bibliothek bietet eine einfache Schnittstelle zur Verwendung dieses Modells:

pythonfrom diffusers import StableDiffusionPipeline

import torch

# Load the pre-trained Stable Diffusion model

pipe = StableDiffusionPipeline.from_pretrained("CompVis/stable-diffusion-v1-4")

pipe = pipe.to("cuda") # Move the model to GPU for faster inference

# Generate an image from a text prompt

prompt = "A serene landscape with mountains and a river"

image = pipe(prompt).images

# Save the generated image

image.save("generated_image.png")

Dieses Skript lädt das Stable-Diffusion-Modell und generiert ein Bild basierend auf der Eingabeaufforderung. Stellen Sie sicher, dass Sie die erforderlichen Abhängigkeiten installiert haben und eine kompatible GPU für optimale Leistung verwenden.

DALL·E mit OpenAI API

DALL·E ist ein weiteres von OpenAI entwickeltes Text-zu-Bild-Modell. Sie können über die OpenAI-API damit interagieren:

pythonimport openai

import requests

from PIL import Image

from io import BytesIO

# Set your OpenAI API key

openai.api_key = "your-api-key"

# Generate an image using DALL·E

response = openai.Image.create(

prompt="A futuristic cityscape at sunset",

n=1,

size="512x512"

)

# Get the URL of the generated image

image_url = response

# Download and display the image

image_response = requests.get(image_url)

image = Image.open(BytesIO(image_response.content))

image.save("dalle_generated_image.png")

Ersetzen "your-api-key" mit Ihrem aktuellen OpenAI-API-Schlüssel. Dieses Skript sendet eine Eingabeaufforderung an das DALL·E-Modell und ruft das generierte Bild ab. Das Bild wird anschließend lokal gespeichert.

CometAPI integriert auch DALL-E 3-API, können Sie auch den Schlüssel von CometAPI verwenden, um auf DALL-E 3-API, was bequemer und schneller ist als OpenAI.

Weitere Modellinformationen zur Comet-API finden Sie unter API-Dokument.

Diese Beispiele bieten einen Ausgangspunkt für die Bildgenerierung mit verschiedenen KI-Modellen. Jedes Modell hat seine eigenen Fähigkeiten und Anforderungen. Wählen Sie daher das Modell aus, das am besten zu den Anforderungen Ihres Projekts passt.

Fazit

Die KI-basierte Bildgenerierung steht an der Schnittstelle zwischen Technologie und Kreativität und bietet beispiellose Möglichkeiten für die Erstellung visueller Inhalte. Das Verständnis der KI-Bildgenerierung, der verwendeten Modelle und der Auswirkungen dieser Technologie ist für ihre Integration in verschiedene gesellschaftliche Bereiche unerlässlich.

Greifen Sie in CometAPI auf die AI Image API zu

CometAPI bietet Zugriff auf über 500 KI-Modelle, darunter Open-Source- und spezialisierte multimodale Modelle für Chat, Bilder, Code und mehr. Die größte Stärke liegt in der Vereinfachung des traditionell komplexen Prozesses der KI-Integration. Mit CometAPI erhalten Sie Zugriff auf führende KI-Tools wie Claude, OpenAI, Deepseek und Gemini über ein einziges, einheitliches Abonnement. Mit der API in CometAPI können Sie Musik und Grafiken erstellen, Videos generieren und eigene Workflows entwickeln.

CometAPI bieten einen Preis weit unter dem offiziellen Preis an, um Ihnen bei der Integration zu helfen GPT-4o-API ,Midjourney-API Stabile Diffusions-API (Stabile Diffusion XL 1.0 API) und Flux API(FLUX.1 API usw.), und Sie erhalten 1 $ auf Ihr Konto, nachdem Sie sich registriert und angemeldet haben!

CometAPI integriert die neuesten GPT-4o-Image-API .