In den letzten Monaten hat das agentenbasierte Programmieren rasant zugenommen: Spezialisierte Modelle, die nicht nur einzelne Anfragen beantworten, sondern ganze Repositories planen, bearbeiten, testen und iterativ verbessern. Zwei der bekanntesten Vertreter sind: Komponieren, ein speziell entwickeltes Codierungsmodell mit geringer Latenz, das von Cursor mit der Version Cursor 2.0 eingeführt wurde, und GPT-5-CodexOpenAIs agentenoptimierte Variante von GPT-5, die für nachhaltige Programmier-Workflows optimiert ist, verdeutlicht die neuen Konfliktlinien in der Entwicklerwerkzeugwelt: Geschwindigkeit versus Tiefe, lokales Arbeitsbereichsbewusstsein versus generalistisches Denken und intuitives Programmieren versus technische Strenge.

Auf einen Blick: Direktvergleich

- Designabsicht: GPT-5-Codex – tiefgreifendes, agentenbasiertes Denken und Robustheit für lange, komplexe Sitzungen; Composer – schnelle, arbeitsbereichsorientierte Iteration, optimiert für Geschwindigkeit.

- Primäre Integrationsfläche: GPT-5-Codex – Codex-Produkt/Responses-API, IDEs, Unternehmensintegrationen; Composer – Cursor-Editor und Cursor-Multiagenten-UI.

- Latenz/Iteration: Composer legt Wert auf Wendezeiten unter 30 Sekunden und beansprucht große Geschwindigkeitsvorteile; GPT-5-Codex priorisiert Gründlichkeit und mehrstündige autonome Läufe, wo dies erforderlich ist.

Ich habe das getestet GPT-5-Codex-API Modell bereitgestellt von CometAPI (ein Drittanbieter von API-Aggregationsdiensten, dessen API-Preise im Allgemeinen günstiger sind als die des offiziellen Anbieters), fasste meine Erfahrungen mit dem Composer-Modell von Cursor 2.0 zusammen und verglich die beiden hinsichtlich verschiedener Dimensionen der Codegenerierung.

Was sind Composer und GPT-5-Codex?

Was ist GPT-5-Codex und welche Probleme will er lösen?

OpenAIs GPT-5-Codex ist eine spezialisierte Version von GPT-5, die laut OpenAI für agentenbasierte Codierungsszenarien optimiert ist: Sie führt Tests aus, bearbeitet Code im Repository-Maßstab und iteriert autonom, bis alle Prüfungen erfolgreich sind. Der Fokus liegt auf umfassenden Fähigkeiten für vielfältige Entwicklungsaufgaben – tiefgreifendes Denken bei komplexen Refaktorierungen, langfristiges „agentenbasiertes“ Agieren (bei dem das Modell Minuten bis Stunden mit Denken und Testen verbringen kann) und eine höhere Leistung bei standardisierten Benchmarks, die reale Entwicklungsprobleme abbilden.

Was ist Composer und welche Probleme will es lösen?

Composer ist Cursors erstes natives Codierungsmodell, das mit Cursor 2.0 eingeführt wurde. Cursor beschreibt Composer als ein zukunftsweisendes, agentenzentriertes Modell, das für geringe Latenz und schnelle Iterationen innerhalb von Entwickler-Workflows entwickelt wurde: Es plant Diffs über mehrere Dateien, wendet die Repository-weite semantische Suche an und erledigt die meisten Schritte in unter 30 Sekunden. Es wurde mit integriertem Werkzeugzugriff (Suchen, Bearbeiten, Testen) trainiert, um bei praktischen Entwicklungsaufgaben effizient zu sein und die Reibungsverluste durch wiederholte Eingabeaufforderungs-Antwort-Zyklen im täglichen Codierungsprozess zu minimieren. Cursor positioniert Composer als ein für Entwicklergeschwindigkeit und Echtzeit-Feedbackschleifen optimiertes Modell.

Modellumfang und Laufzeitverhalten

- Komponist: Optimiert für schnelle, editorzentrierte Interaktionen und Konsistenz über mehrere Dateien hinweg. Die plattformweite Integration von Cursor ermöglicht es Composer, mehr vom Repository einzusehen und an der Orchestrierung mehrerer Agenten teilzunehmen (z. B. zwei Composer-Agenten im Vergleich zu anderen), wodurch laut Cursor übersehene Abhängigkeiten zwischen Dateien reduziert werden.

- GPT-5-Codex: Optimiert für tiefgreifendere, variable Schlussfolgerungen. OpenAI wirbt damit, dass das Modell bei Bedarf Rechenzeit gegen tiefergehende Schlussfolgerungen eintauschen kann – von Sekunden für einfache Aufgaben bis hin zu Stunden für umfangreiche autonome Läufe – was gründlichere Refaktorierungen und testgestütztes Debugging ermöglicht.

Kurz gesagt: Composer = Cursors IDE-basiertes, arbeitsbereichsorientiertes Codierungsmodell; GPT-5-Codex = OpenAIs spezialisierte GPT-5-Variante für die Softwareentwicklung, verfügbar über Responses/Codex.

Wie schneiden Composer und GPT-5-Codex im Geschwindigkeitsvergleich ab?

Was behaupteten die Verkäufer?

Cursor positioniert Composer als einen der schnellsten Programmierer: Veröffentlichte Zahlen belegen den Generierungsdurchsatz in Token pro Sekunde und die 2- bis 4-fach schnellere interaktive Codeausführung im Vergleich zu anderen Modellen dieser Klasse in Cursors interner Umgebung. Unabhängige Berichte (Presse und frühe Tester) bestätigen, dass Composer in Cursors Umgebung Code mit ca. 200–250 Token/Sekunde generiert und typische interaktive Codierungsaufgaben in vielen Fällen in unter 30 Sekunden abschließt.

Der GPT-5-Codex von OpenAI ist nicht als Latenzexperiment konzipiert; er priorisiert Robustheit und tiefergehendes Denken und kann – bei vergleichbaren rechenintensiven Arbeitslasten – bei größeren Kontextgrößen langsamer sein, wie aus Community-Berichten und Problemdiskussionen hervorgeht.

Wie wir die Geschwindigkeit gemessen haben (Methodik)

Um einen fairen Geschwindigkeitsvergleich zu ermöglichen, müssen Sie den Aufgabentyp (kurze Aufgabenabwicklungen vs. lange Schlussfolgerungen), die Umgebung (Netzwerklatenz, lokale vs. Cloud-Integration) kontrollieren und beides messen. Zeit bis zum ersten brauchbaren Ergebnis kombiniert mit einem nachhaltigen Materialprofil. Wanduhr von Ende zu Ende (einschließlich aller Testausführungs- oder Kompilierungsschritte). Wichtigste Punkte:

- ausgewählte Aufgaben — kleine Snippet-Generierung (Implementierung eines API-Endpunkts), mittlere Aufgabe (Refactoring einer Datei und Aktualisierung der Importe), große Aufgabe (Implementierung einer Funktion über drei Dateien hinweg, Aktualisierung der Tests).

- Metrik — Zeit bis zum ersten Token, Zeit bis zur ersten nützlichen Änderung (Zeit bis zur Ausgabe des Kandidaten-Patches) und Gesamtzeit einschließlich Testausführung und -verifizierung.

- Wiederholungen — Jede Aufgabe wurde 10 Mal ausgeführt, der Median wurde verwendet, um das Netzwerkrauschen zu reduzieren.

- Arbeitsumfeld — Die Messungen wurden von einem Entwicklerrechner in Tokio aus durchgeführt (um die Latenz in der Praxis widerzuspiegeln) und verfügen über eine stabile 100/10-Mbps-Verbindung; die Ergebnisse können regional variieren.

Im Folgenden finden Sie eine reproduzierbare Anleitung. Geschwindigkeitsgurt für GPT-5-Codex (Responses API) und eine Beschreibung, wie man Composer (innerhalb von Cursor) misst.

Speed Harness (Node.js) — GPT-5-Codex (Responses API):

// node speed_harness_gpt5_codex.js

// Requires: node16+, npm install node-fetch

import fetch from "node-fetch";

import { performance } from "perf_hooks";

const API_KEY = process.env.OPENAI_API_KEY; // set your key

const ENDPOINT = "https://api.openai.com/v1/responses"; // OpenAI Responses API

const MODEL = "gpt-5-codex";

async function runPrompt(prompt) {

const start = performance.now();

const body = {

model: MODEL,

input: prompt,

// small length to simulate short interactive tasks

max_output_tokens: 256,

};

const resp = await fetch(ENDPOINT, {

method: "POST",

headers: {

"Authorization": `Bearer ${API_KEY}`,

"Content-Type": "application/json"

},

body: JSON.stringify(body)

});

const json = await resp.json();

const elapsed = performance.now() - start;

return { elapsed, output: json };

}

(async () => {

const prompt = "Implement a Node.js Express route POST /signup that validates email and stores user in-memory with hashed password (bcrypt). Return code only.";

const trials = 10;

for (let i=0;i<trials;i++){

const r = await runPrompt(prompt);

console.log(`trial ${i+1}: ${Math.round(r.elapsed)} ms`);

}

})();

Dies misst die End-to-End-Anfragelatenz für GPT-5-Codex unter Verwendung der öffentlichen Responses API (die OpenAI-Dokumentation beschreibt die Responses API und die Verwendung des gpt-5-codex-Modells).

So messen Sie die Geschwindigkeit des Komponisten (Cursor):

Composer läuft innerhalb von Cursor 2.0 (Desktop-/VS Code-Fork). Cursor bietet (zum jetzigen Zeitpunkt) keine allgemeine externe HTTP-API für Composer, die der Responses API von OpenAI entspricht; die Stärke von Composer liegt darin, dass… Integration von zustandsbehafteten Arbeitsbereichen in die IDEMessen Sie Composer daher so, wie es ein menschlicher Entwickler tun würde:

- Öffnen Sie dasselbe Projekt in Cursor 2.0.

- Verwenden Sie Composer, um die gleiche Eingabeaufforderung als Agentenaufgabe auszuführen (Route erstellen, Refactoring, Änderung mehrerer Dateien).

- Starten Sie eine Stoppuhr, wenn Sie den Composer-Plan einreichen; stoppen Sie sie, wenn Composer den atomaren Diff ausgibt und die Testsuite ausführt (die Cursor-Oberfläche kann Tests ausführen und einen konsolidierten Diff anzeigen).

- Wiederholen Sie den Vorgang 10 Mal und verwenden Sie den Median.

Die von Cursor veröffentlichten Materialien und praktischen Rezensionen zeigen, dass Composer in der Praxis viele gängige Aufgaben in unter 30 Sekunden erledigt; dies ist ein Zielwert für die interaktive Latenz und nicht die reine Modellinferenzzeit.

Mitnehmen: Das Designziel von Composer sind schnelle, interaktive Bearbeitungen innerhalb eines Editors. Wenn geringe Latenz und dialogorientierte Codierungsschleifen Priorität haben, ist Composer optimal für diesen Anwendungsfall geeignet. GPT-5-Codex ist für Korrektheit und agentenbasiertes Denken über längere Sitzungen hinweg optimiert; für eine tiefergehende Planung kann eine etwas höhere Latenz in Kauf genommen werden. Herstellerangaben bestätigen diese Positionierung.

Wie schneiden Composer und GPT-5-Codex im Hinblick auf ihre Genauigkeit ab?

Was Genauigkeit bei der KI-Programmierung bedeutet

Genauigkeit ist hier vielschichtig: funktionale Korrektheit (Lässt sich der Code kompilieren und besteht er die Tests?) semantische Korrektheit (Entspricht das Verhalten der Spezifikation?) und Robustheit (Behandelt Sonderfälle und Sicherheitsbedenken).

Verkäufer- und Pressezahlen

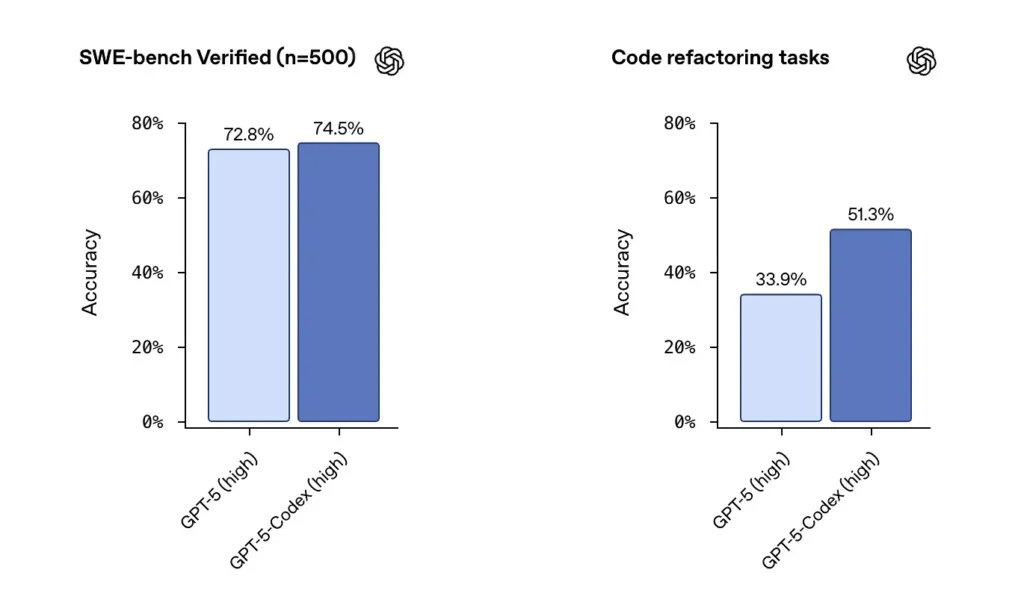

OpenAI berichtet über die starke Leistung des GPT-5-Codex auf SWE-bench-verifizierten Datensätzen und hob Folgendes hervor: 74.5% Erfolgsquote auf einem realen Codierungs-Benchmark (über den in der Presse berichtet wurde) und einer bemerkenswerten Steigerung des Refactoring-Erfolgs (51.3 % gegenüber 33.9 % für die Basisversion von GPT-5 bei ihrem internen Refactoring-Test).

Die Veröffentlichung von Cursor zeigt, dass Composer seine Stärken oft bei kontextsensitiven Bearbeitungen mehrerer Dateien ausspielt, bei denen die Editorintegration und die Sichtbarkeit des Repositorys wichtig sind. Meine Tests ergaben, dass Composer bei Refactorings mehrerer Dateien weniger Abhängigkeitsfehler verursachte und bei Blind-Review-Tests für bestimmte Workloads mit mehreren Dateien besser abschnitt. Die Latenz- und Parallel-Agent-Funktionen von Composer tragen außerdem zur Verbesserung der Iterationsgeschwindigkeit bei.

Unabhängige Genauigkeitsprüfung (empfohlene Methode)

Ein fairer Test verwendet eine Mischung aus:

- Unit-Tests: Beiden Modellen das gleiche Repository und die gleiche Testsuite zuweisen; Code generieren, Tests ausführen.

- Refactor-Tests: eine absichtlich unübersichtliche Funktion bereitstellen und das Modell auffordern, den Faktor zu überarbeiten und Tests hinzuzufügen.

- Sicherheitskontrollen: Statische Codeanalyse und SAST-Tools auf den generierten Code anwenden (z. B. Bandit, ESLint, semgrep).

- Menschliche Überprüfung: Code-Review-Bewertungen von erfahrenen Ingenieuren hinsichtlich Wartbarkeit und Best Practices.

Beispiel: Automatisierte Testumgebung (Python) – Generierten Code und Unit-Tests ausführen

# python3 run_generated_code.py

# This is a simplified harness: it writes model output to file, runs pytest, captures results.

import subprocess, tempfile, os, textwrap

def write_file(path, content):

with open(path, "w") as f:

f.write(content)

# Suppose `generated_code` is the string returned from model

generated_code = """

# sample module

def add(a,b):

return a + b

"""

tests = """

# test_sample.py

from sample import add

def test_add():

assert add(2,3) == 5

"""

with tempfile.TemporaryDirectory() as d:

write_file(os.path.join(d, "sample.py"), generated_code)

write_file(os.path.join(d, "test_sample.py"), tests)

r = subprocess.run(, cwd=d, capture_output=True, text=True, timeout=30)

print("pytest returncode:", r.returncode)

print(r.stdout)

print(r.stderr)

Verwenden Sie dieses Muster, um automatisch zu überprüfen, ob die Modellausgabe funktional korrekt ist (Tests besteht). Führen Sie bei Refactoring-Aufgaben das Testframework mit dem ursprünglichen Repository und den Modelländerungen aus und vergleichen Sie die Testerfolgsraten und die Änderungen der Testabdeckung.

Mitnehmen: Bei reinen Benchmark-Tests erzielt GPT-5-Codex hervorragende Ergebnisse und überzeugt durch seine starke Refactoring-Fähigkeit. In realen Arbeitsabläufen mit mehreren Dateien, wie der Reparatur und Bearbeitung von Editoren, kann Composers Workspace-Sensitivität zu einer höheren Akzeptanz und weniger „mechanischen“ Fehlern (fehlende Importe, falsche Dateinamen) führen. Für maximale funktionale Korrektheit bei algorithmischen Aufgaben mit einer einzelnen Datei ist GPT-5-Codex eine gute Wahl; bei Änderungen mit mehreren Dateien, die Konventionen innerhalb einer IDE berücksichtigen, spielt Composer oft seine Stärken aus.

Composer vs. GPT-5: Wie schneiden sie im Vergleich hinsichtlich der Codequalität ab?

Was gilt als Qualität?

Qualität umfasst Lesbarkeit, Benennung, Dokumentation, Testabdeckung, Verwendung idiomatischer Muster und Sicherheitshygiene. Sie wird sowohl automatisch (Linter, Komplexitätsmetriken) als auch qualitativ (menschliche Überprüfung) gemessen.

Beobachtete Unterschiede

- GPT-5-CodexOpenAIs Codex-Tooling ist stark darin, auf explizite Anfrage idiomatische Muster zu generieren; es zeichnet sich durch algorithmische Klarheit aus und kann auf Anfrage umfassende Testsuiten erstellen. Es beinhaltet integrierte Test-/Berichts- und Ausführungsprotokolle.

- KomponierenComposer ist so optimiert, dass es den Stil und die Konventionen eines Repositories automatisch berücksichtigt. Es kann bestehenden Projektmustern folgen und Aktualisierungen mehrerer Dateien koordinieren (Umbenennung/Refactoring-Weitergabe, Import von Aktualisierungen). Dadurch bietet es eine hervorragende, bedarfsgerechte Wartbarkeit für große Projekte.

Beispielhafte Codequalitätsprüfungen, die Sie durchführen können

- Linters — ESLint / pylint

- Komplexität — Radon / Flocken8-Komplexität

- Sicherheit — semgrep / Bandit

- Testabdeckung — Führen Sie coverage.py oder vitest/nyc für JS aus.

Automatisieren Sie diese Prüfungen nach dem Anwenden des Modell-Patches, um Verbesserungen oder Verschlechterungen zu quantifizieren. Beispielhafte Befehlsfolge (JS-Repository):

# after applying model patch

npm ci

npm test

npx eslint src/

npx semgrep --config=auto .

Menschliche Überprüfung und bewährte Verfahren

In der Praxis benötigen Modelle Anweisungen, um Best Practices zu befolgen: Docstrings, Typannotationen, Abhängigkeitsfixierung oder spezifische Muster (z. B. async/await) müssen angefordert werden. GPT-5-Codex ist hervorragend geeignet, wenn explizite Anweisungen gegeben werden; Composer profitiert vom impliziten Repository-Kontext. Verwenden Sie einen kombinierten Ansatz: Weisen Sie das Modell explizit an und lassen Sie Composer den Projektstil durchsetzen, wenn Sie sich innerhalb von Cursor befinden.

Empfehlung: Für die Bearbeitung mehrerer Dateien innerhalb einer IDE ist Composer vorzuziehen; für externe Pipelines, Forschungsaufgaben oder die Automatisierung von Toolchains, bei denen eine API aufgerufen und ein großer Kontext bereitgestellt werden kann, ist GPT-5-Codex eine gute Wahl.

Integrations- und Bereitstellungsoptionen

Composer ist Bestandteil von Cursor 2.0 und in den Cursor-Editor und die Benutzeroberfläche integriert. Cursor setzt auf eine zentrale Steuerungsebene eines einzigen Anbieters, die Composer parallel zu anderen Modellen ausführt. So können Benutzer mehrere Modellinstanzen auf derselben Eingabeaufforderung ausführen und die Ergebnisse direkt im Editor vergleichen. ()

GPT-5-Codex wird in OpenAIs Codex-Angebot und die ChatGPT-Produktfamilie integriert und ist über die kostenpflichtigen ChatGPT-Tarife und die API verfügbar. Drittanbieterplattformen wie CometAPI bieten hier ein besseres Preis-Leistungs-Verhältnis. OpenAI integriert Codex außerdem in Entwicklerwerkzeuge und Workflows von Cloud-Partnern (z. B. in Visual Studio Code/GitHub Copilot).

Wohin könnten Composer und GPT-5-Codex die Branche als Nächstes führen?

Kurzfristige Auswirkungen

- Schnellere Iterationszyklen: Editor-integrierte Modelle wie Composer reduzieren den Aufwand bei kleineren Korrekturen und der Erstellung von Pull Requests.

- Steigende Erwartungen an die Verifizierung: Der Fokus von Codex auf Tests, Protokolle und autonome Fähigkeiten wird die Anbieter dazu drängen, eine stärkere sofort einsatzbereite Verifizierung für modellgenerierten Code bereitzustellen.

Mittel- bis langfristig

- Multi-Modell-Orchestrierung wird zum Standard: Die Multi-Agenten-GUI von Cursor ist ein erster Hinweis darauf, dass Entwickler schon bald erwarten werden, mehrere spezialisierte Agenten parallel auszuführen (Linting, Sicherheit, Refactoring, Leistungsoptimierung) und die besten Ergebnisse zu akzeptieren.

- Engere Feedbackschleifen zwischen CI und KI: Mit der Verbesserung der Modelle werden CI-Pipelines zunehmend modellgesteuerte Testgenerierung und automatisierte Reparaturvorschläge integrieren – die menschliche Überprüfung und die stufenweise Einführung bleiben jedoch von entscheidender Bedeutung.

Fazit

Composer und GPT-5-Codex sind keine identischen Waffen im selben Wettrüsten; sie sind komplementäre Werkzeuge, die für unterschiedliche Phasen des Softwarelebenszyklus optimiert sind. Composers Stärke liegt in der Geschwindigkeit: schnelle, arbeitsplatzbasierte Iterationen, die den Entwicklerfluss aufrechterhalten. GPT-5-Codex hingegen punktet mit Tiefe: agentenbasierte Persistenz, testgetriebene Korrektheit und Nachvollziehbarkeit für komplexe Transformationen. Die pragmatische Vorgehensweise in der Softwareentwicklung lautet: beides orchestrierenKurzschleifige, Composer-ähnliche Agenten für alltägliche Abläufe und GPT-5-Codex-ähnliche Agenten für kontrollierte, hochzuverlässige Operationen. Erste Benchmarks deuten darauf hin, dass beide in naher Zukunft zum Standardrepertoire von Entwicklern gehören werden, anstatt dass einer den anderen ersetzt.

Es gibt keinen eindeutigen Gewinner, der alle Dimensionen überblickt. Die Modelle tauschen Stärken aus:

- GPT-5-Codex: Stärker ist es bei anspruchsvollen Korrektheitsprüfungen, umfangreichen logischen Schlussfolgerungen und autonomen, mehrstündigen Arbeitsabläufen. Es glänzt besonders dann, wenn die Aufgabenkomplexität lange logische Schlussfolgerungen oder umfangreiche Verifizierungen erfordert.

- Komponist: Stärker ist es bei enger Integration in den Editor, bei der Konsistenz des Kontextes mehrerer Dateien und bei der schnellen Iterationsgeschwindigkeit innerhalb der Cursor-Umgebung. Es kann die tägliche Produktivität von Entwicklern steigern, wenn sofortige, präzise und kontextbezogene Änderungen erforderlich sind.

Web Link Cursor 2.0 und Composer: Wie ein Multiagenten-Ansatz die KI-Programmierung revolutionierte

Erste Schritte

CometAPI ist eine einheitliche API-Plattform, die über 500 KI-Modelle führender Anbieter – wie die GPT-Reihe von OpenAI, Gemini von Google, Claude von Anthropic, Midjourney, Suno und weitere – in einer einzigen, entwicklerfreundlichen Oberfläche vereint. Durch konsistente Authentifizierung, Anforderungsformatierung und Antwortverarbeitung vereinfacht CometAPI die Integration von KI-Funktionen in Ihre Anwendungen erheblich. Ob Sie Chatbots, Bildgeneratoren, Musikkomponisten oder datengesteuerte Analyse-Pipelines entwickeln – CometAPI ermöglicht Ihnen schnellere Iterationen, Kostenkontrolle und Herstellerunabhängigkeit – und gleichzeitig die neuesten Erkenntnisse des KI-Ökosystems zu nutzen.

Entwickler können zugreifen GPT-5-Codex-APIüber CometAPI, die neuste Modellversion wird immer mit der offiziellen Website aktualisiert. Erkunden Sie zunächst die Fähigkeiten des Modells in der Spielplatz und konsultieren Sie die API-Leitfaden Für detaillierte Anweisungen. Stellen Sie vor dem Zugriff sicher, dass Sie sich bei CometAPI angemeldet und den API-Schlüssel erhalten haben. CometAPI bieten einen Preis weit unter dem offiziellen Preis an, um Ihnen bei der Integration zu helfen.

Bereit loszulegen? → Melden Sie sich noch heute für CometAPI an !

Wenn Sie weitere Tipps, Anleitungen und Neuigkeiten zu KI erfahren möchten, folgen Sie uns auf VK, X kombiniert mit einem nachhaltigen Materialprofil. Discord!