Ende August 2025 veröffentlichte Google (DeepMind) Gemini 2.5 Flash-Image — weithin Spitzname „Nano-Banane“ – ein latenzarmes, hochwertiges Bildgenerierungs- und Bearbeitungsmodell, das in die Gemini-App, Google AI Studio, die Gemini-API und CometAPI integriert ist. Es wurde entwickelt, um fotorealistische Bilder zu erzeugen, die Zeichenkonsistenz über Bearbeitungen hinweg zu wahren, mehrere Eingabebilder zu verschmelzen und präzise, lokalisierte Bearbeitungen durch natürlichsprachliche Eingabeaufforderungen durchzuführen. Das Modell ist in der Vorschau bzw. frühen allgemeinen Verfügbarkeit verfügbar und führt bereits die Bild-Bestenlisten (LMArena) an. Es wird mit Sicherheitsmechanismen (SynthID-Wasserzeichen und Filtern auf Produktebene) ausgeliefert.

Was ist Gemini 2.5 Flash Image (auch bekannt als „Nano Banana“)?

Gemini 2.5 Flash Image – spielerisch mit dem Spitznamen Nano-Banane – ist Google DeepMinds neuestes Modell zur Bildgenerierung und -bearbeitung in der Gemini-Familie. Das Ende August 2025 angekündigte Modell ist als Vorabversion positioniert und bietet präzisere Bearbeitungen, Multi-Image-Fusion, bessere Charakterkonsistenz (wodurch dieselbe Person/dasselbe Haustier/dasselbe Objekt über mehrere Bearbeitungen hinweg erkennbar bleibt) und Bildgenerierung mit geringer Latenz in Geminis multimodalem Toolset. Es ist über die Gemini-API, Google AI Studio, die mobilen/Web-Apps von Gemini und Vertex AI für Unternehmenskunden verfügbar.

Herkunft und Namensgebung

Der Spitzname „Nano-Banane“ wurde zu einer viralen Abkürzung in sozialen Feeds und Community-Bestenlisten, nachdem frühe Tester und LMArena-Teilnehmer ein fruchtbezogenes Label verwendeten; Google bestätigte die Verbindung und übernahm den spielerischen Namen öffentlich in seinen Entwickler- und Produktbeiträgen. Der offizielle Produktname lautet Gemini 2.5 Flash-Image und Sie sehen normalerweise die Modellkennung, die in Code und API-Aufrufen verwendet wird (für die Vorschauverwendung wird sie beispielsweise als gemini-2.5-flash-image-preview).

Was sind die Hauptfunktionen von Gemini 2.5 Flash Image?

Was bedeutet eigentlich „Charakterkonsistenz“?

Eine der Marquee-Funktionen ist Zeichenkonsistenz: Sie können das Modell bitten, dasselbe Motiv (Person, Haustier, Maskottchen oder Produkt) in vielen Bearbeitungen oder neuen Szenen wiederzuverwenden und dabei visuelle Merkmale (Gesicht/Form, Farbpalette, Erkennungsmerkmale) beizubehalten. Dies behebt eine häufige Schwäche früherer Bildmodelle, bei denen nachfolgende Bearbeitungen zwar optisch plausible, aber deutlich unterschiedliche Personen/Objekte hervorbrachten. Entwickler können so Workflows für Produktkataloge, episodisches Storytelling oder die Generierung von Marken-Assets mit weniger manuellen Korrekturen erstellen.

Welche anderen Bearbeitungssteuerelemente sind enthalten?

Gemini 2.5 Flash Image unterstützt:

- Gezielte lokale Bearbeitungen über Anweisungen in einfacher Sprache (Objekt entfernen, Outfit ändern, Haut retuschieren, Hintergrundelement entfernen).

- Mehrbildfusion: Kombinieren Sie bis zu drei Eingabebilder zu einer einzigen zusammenhängenden Komposition (z. B. platzieren Sie ein Produkt aus Bild A in Szene B und behalten Sie dabei die Beleuchtung bei).

- Stil- und Formatsteuerelemente: fotorealistische Anweisungen, Kamera- und Objektivattribute, Seitenverhältnis und stilisierte Ausgaben (Illustration, Aufkleber usw.).

- Wissen der einheimischen Welt: Das Modell nutzt das Wissen der breiteren Gemini-Familie, um semantisch bewusste Bearbeitungen vorzunehmen (z. B. zu verstehen, was „Renaissance-Beleuchtung“ oder „Tokio-Zebrastreifen“ bedeuten).

Wie steht es um Geschwindigkeit, Kosten und Verfügbarkeit?

Gemini 2.5 Flash Image ist Teil der Flash-Version von Gemini 2.5 – optimiert für niedrige Latenzzeiten und Kosten bei gleichbleibend hoher Qualität. Google hat die Preise für Bildausgabe-Token vorgestellt und die Verfügbarkeit über API und AI Studio bereitgestellt; Unternehmenskunden können über Vertex AI darauf zugreifen. Bei der Ankündigung lauteten die veröffentlichten Preise für die Gemini 2.5 Flash Image-Version: \30 $ pro 1 Mio. Ausgabetoken, mit einem Beispiel für die Kosten pro Bild, die wie folgt angegeben werden: 1290 Ausgabetoken ≈ $0.039 pro Bild.

Wie funktioniert Gemini 2.5 Flash Image unter der Haube?

Architektur und Trainingsansatz

Gemini 2.5 Flash Image übernimmt die Architektur der Gemini 2.5-Familie: ein spärliches Backbone im Mixture-of-Experts-Stil (MoE) mit multimodalem Training, das Text, Bild, Audio und andere Daten kombiniert. Google trainierte Flash Image anhand sehr großer, gefilterter multimodaler Korpora und optimierte das Modell für die Bildaufgaben (Generierung, Bearbeitung, Fusion) und das Sicherheitsverhalten. Das Training erfolgte auf Googles TPU-Fabric und wurde sowohl mit automatischen als auch mit menschlichen Beurteilungsmetriken ausgewertet.

Konversationsgesteuerte Bearbeitung

Auf einer höheren Ebene verwendet das Modell kontextuelle Konditionierung: Wenn Sie ein Bild (oder mehrere Bilder) plus Texteingaben bereitstellen, kodiert das Modell die visuelle Identität des Motivs in seiner internen Darstellung. Bei nachfolgenden Bearbeitungen oder neuen Szenen konditioniert es die Generierung auf Grundlage dieser Darstellung, sodass gewünschte visuelle Attribute (Gesichtsgeometrie, wichtige Kleidungs- oder Produktkennungen, Farbpaletten) erhalten bleiben. In der Praxis wird dies als Teil der multimodalen Content-Pipeline der Gemini-API implementiert: Sie senden die Referenzbilder zusammen mit Bearbeitungsanweisungen, und das Modell gibt die bearbeiteten Bildausgaben (oder mehrere Kandidatenbilder) in einer Antwort zurück.

Wasserzeichen und Herkunft

Google integriert Sicherheits- und Inhaltsrichtlinienfilter in Gemini 2.5 Flash Image. Die Version legt den Schwerpunkt auf Evaluierung und Red-Teaming, automatisierte Filterschritte, überwachtes Feintuning und Reinforcement Learning zur Befolgung von Anweisungen bei gleichzeitiger Minimierung schädlicher Ergebnisse. Die Ergebnisse enthalten ein unsichtbares SynthID-Wasserzeichen, sodass vom Modell erstellte oder bearbeitete Bilder später als KI-generiert identifiziert werden können.

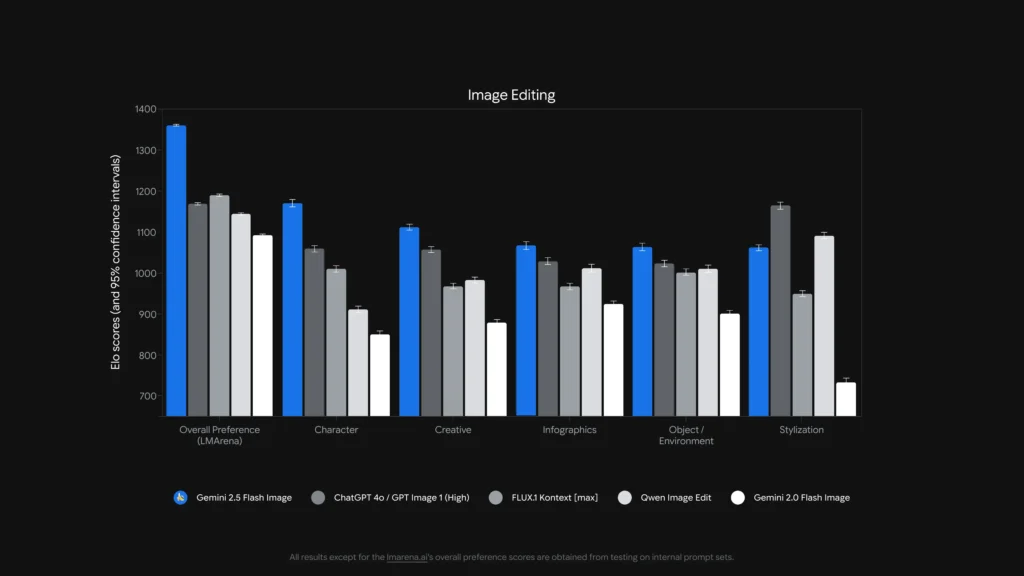

Wie gut ist die Leistung? (Benchmark-Daten)

Gemini 2.5 Flash Image (in einigen Benchmarking-Kontexten als „Nano-Banane“ vermarktet) erreichte Platz 1 in den Bestenlisten von LMArena für Bildbearbeitung und Text-zu-Bild Stand Ende August 2025, mit großen Elo-/Präferenzvorsprüngen gegenüber der Konkurrenz in den berichteten Vergleichen. Ich beziehe mich auf die menschlichen Bewertungsergebnisse von LMArena und GenAI-Bench, die sowohl bei Text-zu-Bild- als auch bei Bildbearbeitungsaufgaben höchste Präferenzwerte zeigen.

Text-Bild-Vergleich

| Leistungsbenchmark | Gemini Flash 2.5 Bild | Imagen 4 Ultra 06-06 | ChatGPT 4o / GPT-Bild 1 (Hoch) | FLUX.1 Kontext | Gemini Flash 2.0 Bild |

|---|---|---|---|---|---|

| Gesamtpräferenz (LMArena) | 1147 | 1135 | 1129 | 1075 | 988 |

| Visuelle Qualität (GenAI-Bench) | 1103 | 1094 | 1013 | 864 | 926 |

| Text-Bild-Ausrichtung (GenAI-Bench) | 1042 | 1053 | 1046 | 937 | 922 |

Bildbearbeitung

| Leistungsbenchmark | Gemini Flash 2.5 Bild | ChatGPT 4o / GPT-Bild 1 (Hoch) | FLUX.1 Kontext | Qwen Bildbearbeitung | Gemini Flash 2.0 Bild |

|---|---|---|---|---|---|

| Gesamtpräferenz (LMArena) | 1362 | 1170 | 1191 | 1145 | 1093 |

| Charakter | 1170 | 1059 | 1010 | 911 | 850 |

| Kreativ | 1112 | 1057 | 968 | 983 | 879 |

| Infografiken | 1067 | 1029 | 967 | 1012 | 925 |

| Objekt / Umgebung | 1064 | 1023 | 1002 | 1010 | 901 |

| Produkt-Rekontextualisierung | 1128 | 1032 | 943 | 1009 | 888 |

| Stilisierung | 1062 | 1165 | 949 | 1091 | 733 |

Was bedeuten diese Benchmarks in der Praxis?

Benchmarks zeigen uns zwei Dinge: (1) Das Modell ist bei der fotorealistischen Generierung konkurrenzfähig und (2) es zeichnet sich durch Bearbeitung Aufgaben, bei denen es auf Charakterkonsistenz und die Einhaltung von Eingabeaufforderungen ankommt. Die Rangfolge menschlicher Präferenzen zeigt, dass Benutzer die Ergebnisse von Gemini aufgrund ihres Realismus und ihrer Übereinstimmung mit den Anweisungen in vielen bewerteten Eingabeaufforderungen hoch bewerteten. Bekannte Einschränkungen (Halluzinationsrisiko bei feinen Faktendetails, Darstellung langer Texte in Bildern, Randfälle der Stilübertragung) werden jedoch explizit genannt – Benchmarks dienen daher nur als Richtlinie, nicht als Garantie.

Was können Sie mit Gemini 2.5 Flash Image tun (Anwendungsfälle)?

Gemini 2.5 Flash Image wurde speziell für kreative, produktive und angewandte Bildgebungsszenarien entwickelt. Typische und neu auftretende Anwendungsfälle sind:

Schnelle Produktmodelle und E-Commerce

Ziehen Sie Produktfotos in Szenen, erstellen Sie konsistente Katalogbilder für verschiedene Umgebungen oder tauschen Sie Farben und Stoffe innerhalb einer Produktlinie aus – und bewahren Sie dabei die Identität des Produkts. Die Funktionen zur Multi-Image-Fusion und die Charakter-/Produktkonsistenz machen es attraktiv für Katalog-Workflows.

Fotoretusche und gezielte Bearbeitungen

Entfernen Sie Objekte, beheben Sie Schönheitsfehler, ändern Sie Kleidung/Accessoires oder optimieren Sie die Beleuchtung mit natürlichen Sprachanweisungen. Dank der lokalisierten Bearbeitungsfunktion können auch Laien mithilfe von Konversationsbefehlen professionelle Retuschen durchführen.

Storyboarding und visuelles Storytelling

Platzieren Sie dieselbe Figur in verschiedenen Szenen und behalten Sie ihr Aussehen bei (nützlich für Comics, Storyboards oder Pitch Decks). Durch iterative Bearbeitungen können Entwickler Stimmung, Rahmung und narrative Kontinuität verfeinern, ohne die Assets von Grund auf neu erstellen zu müssen.

Bildung, Diagramme und Design-Prototyping

Da das Modell Textaufforderungen und Bilder kombinieren kann und über „Weltwissen“ verfügt, kann es bei der Erstellung kommentierter Diagramme, lehrreicher Visualisierungen oder schneller Mockups für Präsentationen helfen. Google bietet in AI Studio sogar Vorlagen für Anwendungsfälle wie Immobilienmodelle und Produktdesign.

Wie verwenden Sie die Nano Banana API?

Nachfolgend finden Sie praktische Ausschnitte aus CometAPI API-Dokumente und die API-Dokumente von Google. Sie veranschaulichen die gängigen Abläufe: Text-zu-Bild kombiniert mit einem nachhaltigen Materialprofil. Bild + Text zu Bild (Bearbeitung) mithilfe des offiziellen GenAI SDK oder REST-Endpunkts.

Hinweis: In den CometAPI-Dokumenten wird der Name des Vorschaumodells wie folgt angezeigt:

gemini-2.5-flash-image-preview. Die folgenden Beispiele spiegeln die offiziellen SDK-Beispiele (Python und JavaScript) und ein REST-Curl-Beispiel wider. Passen Sie Schlüssel und Dateipfade an Ihre Umgebung an.

REST-Curl-Beispiel von CometAPI

Nutzen Sie Geminis offizielle generateContent Endpunkt für die Text-zu-Bild-Generierung. Platzieren Sie die Texteingabeaufforderung in contents.parts[].text.Beispiel (Windows-Shell, mit ^ zur Zeilenfortsetzung):

curl --location --request POST "https://api.cometapi.com/v1beta/models/gemini-2.5-flash-image-preview:generateContent" ^

--header "Authorization: sk-xxxx" ^

--header "User-Agent: Apifox/1.0.0 (https://apifox.com)" ^

--header "Content-Type: application/json" ^

--header "Accept: */*" ^

--header "Host: api.cometapi.com" ^

--header "Connection: keep-alive" ^

--data-raw "{ "contents": [{

"parts": [

{"text": "A photorealistic macro shot of a nano-banana on a silver fork, shallow depth of field"}

]

}]

}'}"

| grep -o '"data": "*"' \

| cut -d'"' -f4 \

| base64 --decode > gemini-generated.png

Die Antwort enthält Base64-Bildbytes; die obige Pipeline extrahiert die "data" Zeichenfolge und dekodiert sie in gemini-generated.png.

Dieser Endpunkt unterstützt die „Bild-zu-Bild“-Generierung: Laden Sie ein Eingabebild hoch (als Base64) und erhalten Sie ein geändertes neues Bild (ebenfalls im Base64-Format).Ejemplo:

curl --location --request POST "https://api.cometapi.com/v1beta/models/gemini-2.5-flash-image-preview:generateContent" ^

--header "Authorization: sk-xxxx" ^

--header "User-Agent: Apifox/1.0.0 (https://apifox.com)" ^

--header "Content-Type: application/json" ^

--header "Accept: */*" ^

--header "Host: api.cometapi.com" ^

--header "Connection: keep-alive" ^

--data-raw "{ \"contents\": } ], \"generationConfig\": { \"responseModalities\": }}"

**Beschreibung:**Konvertieren Sie zunächst Ihre Quellbilddatei in eine Base64-Zeichenfolge und platzieren Sie sie in inline_data.data. Fügen Sie keine Präfixe wie data:image/jpeg;base64,.Der Ausgang befindet sich ebenfalls in candidates.content.parts und beinhaltet:Einen optionalen Textteil (Beschreibung oder Eingabeaufforderung).Der Bildteil als inline_data (woher data ist das Base64 des Ausgabebildes). Bei mehreren Bildern können Sie diese direkt anhängen, zum Beispiel:

{

"inline_data": {

"mime_type": "image/jpeg",

"data": "iVBORw0KGgo...",

"data": "iVBORw0KGgo..."

}

}

Nachfolgend finden Sie Entwicklerbeispiele, die aus den offiziellen Dokumenten und dem Blog von Google übernommen wurden. Ersetzen Sie Anmeldeinformationen und Dateipfade durch Ihre eigenen.

Python (offizieller SDK-Stil)

from google import genai

from PIL import Image

from io import BytesIO

client = genai.Client()

prompt = "Create a picture of a nano banana dish in a fancy restaurant with a Gemini theme"

# Text-to-Image

response = client.models.generate_content(

model="gemini-2.5-flash-image-preview",

contents=,

)

for part in response.candidates.content.parts:

if part.text is not None:

print(part.text)

elif part.inline_data is not None:

image = Image.open(BytesIO(part.inline_data.data))

image.save("generated_image.png")

Dies ist der kanonische Python-Ausschnitt aus den Google-Dokumenten (Vorschaumodell-ID wird angezeigt). Dasselbe SDK-Aufrufmuster unterstützt die Bild- und Eingabeaufforderungsbearbeitung (übergeben Sie ein Bild als eines der contents).Weitere Einzelheiten finden Sie unter Zwillings-Doc.

Fazit

Wenn Ihr Produkt eine robuste Bilderzeugung mit geringer Latenz benötigt und insbesondere zuverlässige Bearbeitung mit ThemenkonsistenzGemini 2.5 Flash Image ist jetzt eine produktionsreife Option, die es wert ist, geprüft zu werden: Es kombiniert modernste Bildqualität mit APIs, die für die Entwicklerintegration entwickelt wurden (AI Studio, Gemini API und Vertex AI). Wägen Sie die aktuellen Einschränkungen des Modells (kleiner Text in Bildern, einige Randfälle bei der Stilisierung) sorgfältig ab und implementieren Sie Sicherheitsvorkehrungen für eine verantwortungsvolle Nutzung.

Erste Schritte

CometAPI ist eine einheitliche API-Plattform, die über 500 KI-Modelle führender Anbieter – wie die GPT-Reihe von OpenAI, Gemini von Google, Claude von Anthropic, Midjourney, Suno und weitere – in einer einzigen, entwicklerfreundlichen Oberfläche vereint. Durch konsistente Authentifizierung, Anforderungsformatierung und Antwortverarbeitung vereinfacht CometAPI die Integration von KI-Funktionen in Ihre Anwendungen erheblich. Ob Sie Chatbots, Bildgeneratoren, Musikkomponisten oder datengesteuerte Analyse-Pipelines entwickeln – CometAPI ermöglicht Ihnen schnellere Iterationen, Kostenkontrolle und Herstellerunabhängigkeit – und gleichzeitig die neuesten Erkenntnisse des KI-Ökosystems zu nutzen.

Entwickler können zugreifen Gemini 2.5 Flash-Image(Nano Banana CometAPI-Liste gemini-2.5-flash-image-preview/gemini-2.5-flash-image Stileinträge in ihrem Katalog.) über CometAPI, die neuesten Modellversionen sind zum Veröffentlichungsdatum des Artikels aufgeführt. Erkunden Sie zunächst die Funktionen des Modells in der Spielplatz und konsultieren Sie die API-Leitfaden Für detaillierte Anweisungen. Stellen Sie vor dem Zugriff sicher, dass Sie sich bei CometAPI angemeldet und den API-Schlüssel erhalten haben. CometAPI bieten einen Preis weit unter dem offiziellen Preis an, um Ihnen bei der Integration zu helfen.