Die GLM-4.5-API von Zhipu ist ein einheitlicher RESTful-Dienst auf den Plattformen Z.ai (global) und Zhipu AI Open (Festlandchina), der das 355 Milliarden Parameter umfassende, hybride Expertenmodell GLM-4.5 – das komplexe Schlussfolgerungen, Codierungen und Agentenaufgaben ausführen kann – mit konfigurierbaren Optionen (z. B. Temperatur, maximale Token, Streaming) bereitstellt.

Grundlegende Merkmale

GLM‑4.5 ist konzipiert als einheitliches Agentenmodellund Argumentation, Verschlüsselung und autonome Entscheidungsfindung Funktionen innerhalb einer einzigen Architektur. Es unterstützt nativ zwei Betriebsmodi:Denken für komplexes Denken und Werkzeuggebrauch und Nichtdenken für schnelle, bedarfsgerechte Reaktionen – ideal für vielseitige Agent zum Arbeitsablauf

Technische Daten

- Parameterskala: Das Flaggschiff GLM‑4.5 umfasst 355 Milliarden Gesamtparameter mit 32 Milliarden aktive Parameter.

- Hybrides Denken: GLM‑4.5 verwendet eine hybride FP8-Quantisierung Strategie zur Optimierung Inferenzeffizienz ohne wesentliche Einbußen bei der Genauigkeit.

- Parameter Effizienz: Verwendet 32 B aktive Parameter von 355 B, um die Hardwarelast während der Inferenz zu minimieren.

- Ebenenoptimierung: Komponenten werden beschnitten und in tiefere Schichten umverteilt, was die logisches Denken ohne die Modellgröße aufzublähen.

Trainingsworkflow

Mehrstufiges Training:

- Grundlagenvorbereitung auf ~15 Billionen Token.

- Argumentation Feinabstimmung auf >7 Billionen kuratierten Token, um die Entscheidungsfindung und Codesynthese zu verbessern.

Benchmark-Leistung

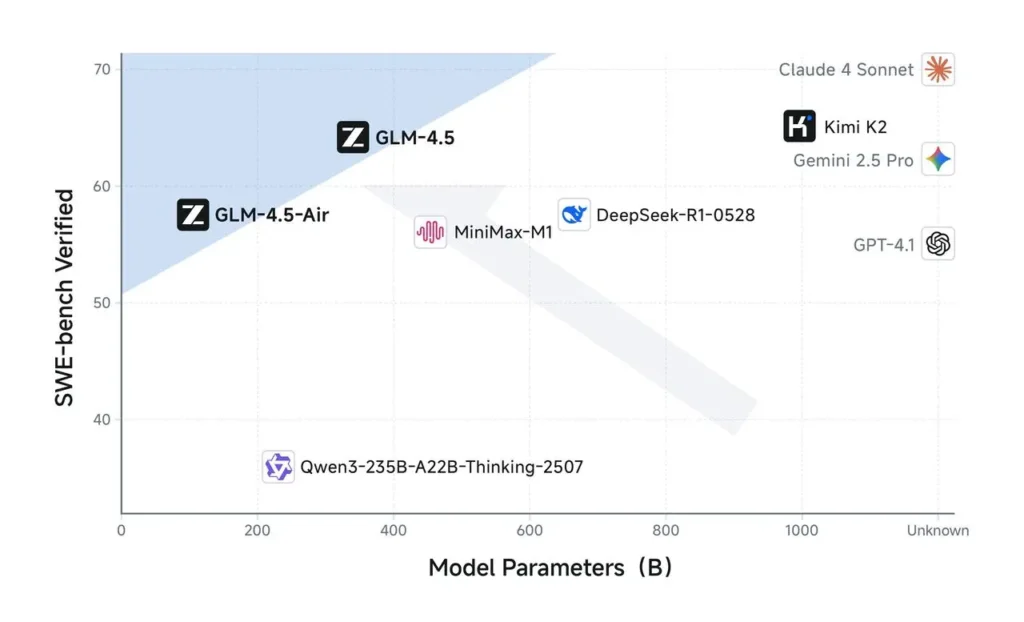

Auf einer Suite von 12 branchenübliche Benchmarks in Agenten, Argumentation und Verschlüsselung Aufgaben erreichte GLM‑4.5 eine Gesamtpunktzahl von 63.2, Rangfolge dritte weltweit hinter proprietären Titanen wie GPT‑4 kombiniert mit einem nachhaltigen Materialprofil. Grok 4. Zu den Highlights gehören:

| Benchmark | GLM‑4.5-Ergebnis | Vergleich der besten proprietären Produkte |

|---|---|---|

| BrowseComp (Web) | 26.4% | Claude 4 Opus: 18.8 % |

| MATH 500 | 98.2% | GPT‑4 Turbo |

| AIME24 | 91.0% | Claude 4 Sonett |

| GPQA | 79.1% | Gemini 2.5 Pro |

In einer Reihe von 12 Wettbewerbstests – von Verschlüsselung, Argumentation und Agenten Benchmarks – GLM‑4.5-Ränge Dritter in der Gesamtwertung, gleichauf oder sogar besser als führende proprietäre Modelle wie Claude 4 Sonnet und Gemini 2.5 Pro bei Aufgaben wie SWE‑Bank kombiniert mit einem nachhaltigen Materialprofil. AIME24 .

Modellversionen

Die GLM‑4.5 Familie umfasst mehrere spezialisierte Varianten, die über die API zugänglich sind:

- GLM‑4.5 (355 B Gesamtparameter; 32 B aktiv)

- GLM‑4.5‑Air (insgesamt 106 B; leichtgewichtig, schnellere Inferenz)

- GLM‑4.5‑X, GLM‑4.5‑AirX (ultraschnelle Inferenz)

- GLM‑4.5‑Flash (kostenlos, optimiert für Codierung und logisches Denken)

Wie man anruft GLM‑4.5 API von CometAPI

GLM‑4.5 Serien-API-Preise in CometAPI, 20 % Rabatt auf den offiziellen Preis:

| Modell | stellen die Kernaussage vor | Preis |

glm-4.5 | Unser leistungsstärkstes Schlussfolgerungsmodell mit 355 Milliarden Parametern | Eingabe-Token 0.48 $ Ausgabe-Token 1.92 $ |

glm-4.5-air | Kostengünstig Leichtgewicht Starke Leistung | Eingabe-Token 0.16 $ Ausgabe-Token 1.07 $ |

glm-4.5-x | Hohe Leistung, starke Argumentation, ultraschnelle Reaktion | Eingabe-Token 1.60 $ Ausgabe-Token 6.40 $ |

glm-4.5-airx | Leichtgewichtig Starke Leistung Ultraschnelle Reaktion | Eingabe-Token 0.02 $ Ausgabe-Token 0.06 $ |

glm-4.5-flash | Starke Leistung, hervorragend für Reasoning Coding und Agenten | Eingabe-Token 3.20 $ Ausgabe-Token 12.80 $ |

Erforderliche Schritte

- Einloggen in cometapi.comWenn Sie noch nicht unser Benutzer sind, registrieren Sie sich bitte zuerst

- Holen Sie sich den API-Schlüssel für die Zugangsdaten der Schnittstelle. Klicken Sie im persönlichen Bereich beim API-Token auf „Token hinzufügen“, holen Sie sich den Token-Schlüssel: sk-xxxxx und senden Sie ihn ab.

- Holen Sie sich die URL dieser Site: https://api.cometapi.com/

Methode verwenden

- Wählen Sie das "

glm-4.5”-Endpunkt, um die API-Anfrage zu senden und den Anfragetext festzulegen. Die Anfragemethode und der Anfragetext stammen aus der API-Dokumentation unserer Website. Unsere Website bietet außerdem einen Apifox-Test für Ihre Bequemlichkeit. - Ersetzen mit Ihrem aktuellen CometAPI-Schlüssel aus Ihrem Konto.

- Geben Sie Ihre Frage oder Anfrage in das Inhaltsfeld ein – das Modell antwortet darauf.

- . Verarbeiten Sie die API-Antwort, um die generierte Antwort zu erhalten.

CometAPI bietet eine vollständig kompatible REST-API für eine nahtlose Migration. Wichtige Details zu API-Dokument:

- Basis-URL: https://api.cometapi.com/v1/chat/completions

- Modellnamen: "

glm-4.5" - Authentifizierung:

Bearer YOUR_CometAPI_API_KEYKopfzeile - Content-Type:

application/json.

API-Integration und Beispiele

Unten ist eine Python Snippet, das zeigt, wie GLM‑4.5 über die API von CometAPI aufgerufen wird. Ersetzen Sie <API_KEY> kombiniert mit einem nachhaltigen Materialprofil. <PROMPT> entsprechend:

import requests

API_URL = "https://api.cometapi.com/v1/chat/completions"

headers = {

"Authorization": "Bearer <API_KEY>",

"Content-Type": "application/json"

}

payload = {

"model": "glm-4.5",

"messages": [

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": "<PROMPT>"}

],

"max_tokens": 512,

"temperature": 0.7

}

response = requests.post(API_URL, json=payload, headers=headers)

print(response.json())

Parameter:

- Modell: Gibt die GLM‑4.5-Variante an

- max_tokens: Steuert die Ausgabelänge

- Temperatur: Gleicht Kreativität vs. Determinismus aus

Siehe auch GLM-4.5 Air API