Die Veröffentlichung von GLM-5, die diese Woche von China’s Zhipu AI (öffentlich als Z.AI / zai-org in vielen Entwicklerkanälen) vorgestellt wurde, markiert einen weiteren Schritt in der sich beschleunigenden Taktung von Großmodell-Releases. Das neue Modell wird als Zhipus Flaggschiff positioniert: größer im Umfang, für langfristige agentische Aufgaben optimiert und mit Engineering-Entscheidungen entwickelt, die die Inferenzkosten senken sollen, während der lange Kontext erhalten bleibt. Frühe Branchenberichte und praxisnahe Entwicklernotizen deuten auf spürbare Fortschritte beim Codieren, mehrstufigem Reasoning und der Agenten-Orchestrierung gegenüber früheren GLM-Versionen hin — und in einigen Tests fordert es sogar Claude 4.5 heraus.

Was ist GLM-5 und wer hat es entwickelt?

GLM-5 ist die jüngste große Veröffentlichung in der GLM-Familie: ein großes, Open-Source-Grundmodell, entwickelt und publiziert von Z.ai (dem Team hinter der GLM-Serie). Angekündigt Anfang Februar 2026 wird GLM-5 als Next-Generation-Modell präsentiert, das speziell für „agentische“ Aufgaben abgestimmt ist — also mehrschrittige, langfristige Workflows, in denen ein Modell planen, Tools aufrufen, ausführen und Kontext über längere Gespräche oder automatisierte Agenten hinweg aufrechterhalten muss. Die Veröffentlichung ist nicht nur aufgrund des Modelldesigns bemerkenswert, sondern auch wegen des Trainings und des Einsatzortes: Z.ai nutzte eine Mischung aus inländischer chinesischer Hardware und Toolchains als Teil einer Initiative zur Selbstversorgung.

Berichtete Architektur- und Trainingskennzahlen umfassen:

- Parameterskalierung: GLM-5 skaliert auf ungefähr 744B Parameter (mit einer kleineren „aktiven“ Expert:innen-Anzahl in einigen technischen Notizen, z. B. 40B aktiv), gegenüber früheren GLM-4-Familiengrößen um 355B/32B aktiv.

- Pretraining-Daten: Die Trainingskorpusgröße stieg Berichten zufolge von ~23 trillion tokens (GLM-4-Generation) auf ~28.5 trillion tokens für GLM-5.

- Sparse Attention / DeepSeek Sparse Attention (DSA): Ein Sparse-Attention-Schema, um langen Kontext zu erhalten und gleichzeitig die Rechenkosten während der Inferenz zu reduzieren.

- Designschwerpunkt: Engineering-Entscheidungen mit Fokus auf Agenten-Orchestrierung, Langkontext-Reasoning und kosteneffiziente Inferenz.

Herkunft und Positionierung

GLM-5 baut auf einer Linie auf, die GLM-4.5 (veröffentlicht Mitte 2025) und einige iterative Updates wie 4.7 einschloss. Z.ai positioniert GLM-5 als Sprung von „Vibe-Coding“ (schnelle, einstufige Code-Ausgaben) hin zu „agentischer Ingenieurarbeit“: nachhaltiges Reasoning, Multi-Tool-Orchestrierung und System-Synthese über lange Kontextfenster. Die öffentlichen Materialien betonen, dass GLM-5 für komplexe Systemingenieuraufgaben konzipiert wurde — also für das Aufbauen, Koordinieren und Aufrechterhalten mehrstufiger Agentenverhalten statt bloß isolierte Fragen zu beantworten.

Was sind die neuen Funktionen in GLM-5?

Wichtige architektonische Änderungen

- Massives Sparse-Scaling (MoE): GLM-5 wechselt zu einer deutlich größeren sparsamen Mixture-of-Experts-Architektur. Öffentliche Zahlen aus Entwicklerseiten und unabhängigen Berichten führen das Modell mit ungefähr 744B Gesamtparametern und ~40B aktiv pro Token — ein signifikanter Schritt gegenüber GLM-4.5’s ~355B / 32B aktiv. Dieses Sparse-Scaling ermöglicht sehr große Gesamtkapazität, während die pro-Token-Berechnung beherrschbar bleibt.

- DeepSeek Sparse Attention (DSA): Um die Langkontext-Fähigkeit zu erhalten, ohne die Inferenzkosten linear zu skalieren, integriert GLM-5 einen Sparse-Attention-Mechanismus (gebrandet als DeepSeek), der wichtige Langstrecken-Abhängigkeiten skaliert beibehält und gleichzeitig die Kosten der Aufmerksamkeit über sehr lange Kontexte reduziert.

Agentische Ingenieurarbeit als grundlegendes Designziel

Eine der herausragenden Eigenschaften von GLM-5 ist, dass es explizit für agentische Ingenieurarbeit entwickelt wurde — das Modell soll nicht nur für Einzelschritt-Chat oder Zusammenfassung genutzt werden, sondern als „Gehirn“ mehrschrittiger Agenten, die planen, Funktions-/Tool-Aufrufe auslösen, Zustand verwalten und über lange Kontexte hinweg schlüssig argumentieren. Z.ai positioniert GLM-5 für Orchestrierungsschleifen: komplexe Probleme zerlegen, externe Tools/APIs aufrufen und lange Aufgaben über viele Turns verfolgen.

Warum agentisches Design wichtig ist

Agentische Workflows sind zentral für reale Automatisierung: automatisierte Forschungsassistenten, autonome Softwareentwickler:innen, Operations-Orchestrierung und Simulationssteuerung. Ein Modell für diese Welt braucht starke Planung, stabiles Tool-Calling-Verhalten und Robustheit über Tausende Tokens Kontext.

Verbesserte Codierung, Reasoning und „Langhorizont“-Verhalten

GLM-5 betont verbesserte Codegenerierung und Reasoning. Z.ai meldet gezielte Verbesserungen bei der Fähigkeit des Modells, Code zu schreiben, zu refaktorisieren und zu debuggen, plus konsistenteres mehrstufiges Reasoning über lange Interaktionen. Unabhängige Early-Access-Berichte und Partnerbewertungen fanden das Modell deutlich stärker bei entwicklerorientierten Aufgaben als frühere GLM-Generationen.

Praktische Entwicklerfunktionen

- Größere Kontextfenster für Dokumentation, Codebasen und Gesprächszustand.

- Tooling-Primitiven für sichere Tool-Aufrufe und Ergebnisverarbeitung.

- Bessere Few-Shot- und Chain-of-Thought-Leistung, um komplexe Aufgaben zu zerlegen und auszuführen.

- Agentische Funktionen und Tool-Calling: GLM-5 betont native Unterstützung für Agenten: Funktions-/Tool-Calling, zustandsbehaftete Sessions und bessere Verwaltung langer Dialoge und Tool-Nutzungssequenzen. Das erleichtert den Aufbau von Agenten, die Websuche, Datenbanken oder Aufgabenautomatisierung integrieren.

Wie schneidet GLM-5 in Benchmarks ab?

Konkrete Benchmark-Highlights

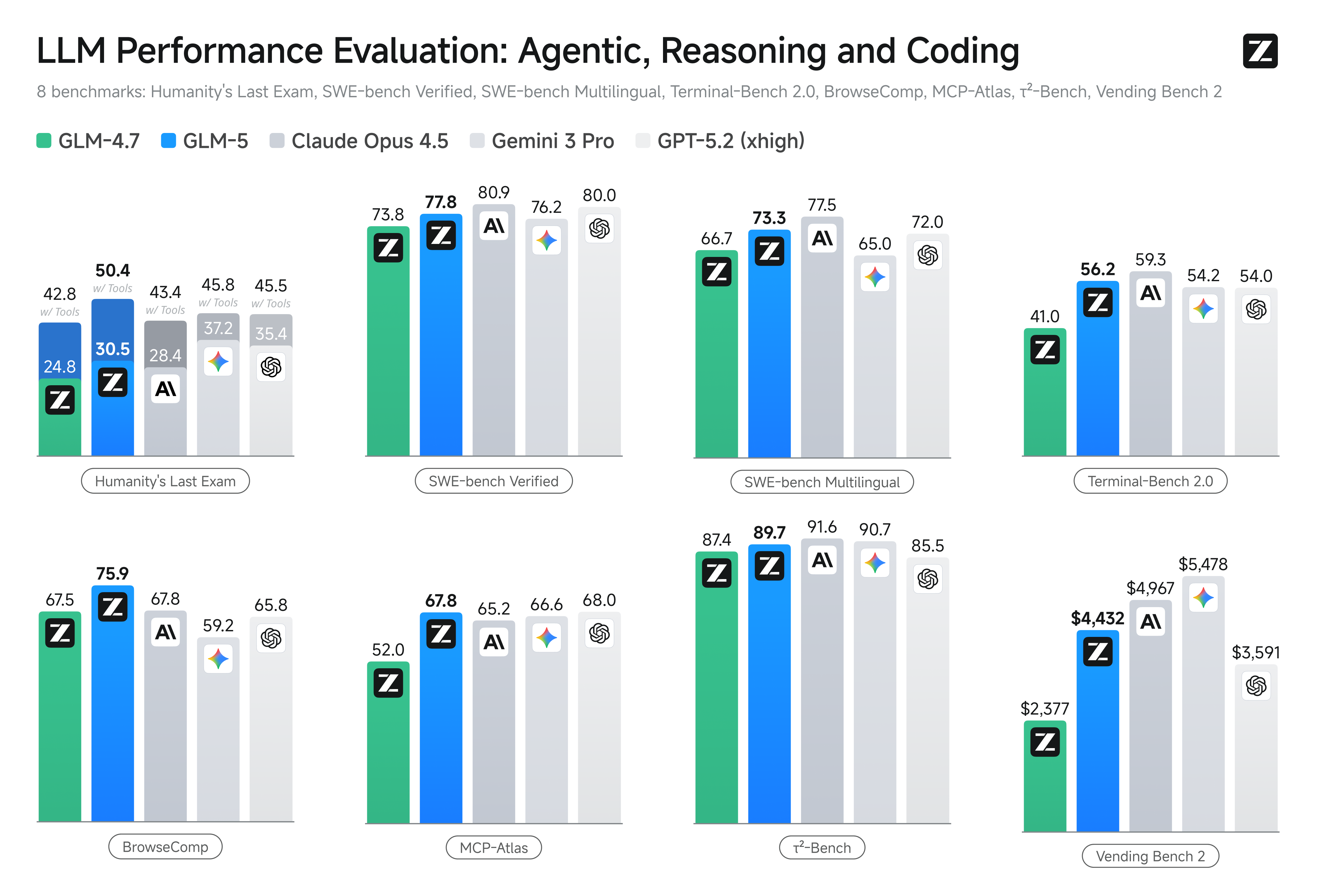

- Coding-Benchmarks: GLM-5 nähert sich (und entspricht in manchen Fällen) der Coding-Leistung hochoptimierter proprietärer Modelle wie Anthropic’s Claude Opus 4.5 bei bestimmten Coding-Aufgaben. Diese Ergebnisse sind aufgabenabhängig (Unit-Tests, algorithmisches Codieren, API-Nutzung), markieren aber eine klare Verbesserung gegenüber GLM-4.5.

- Reasoning- und agentische Tests: Bei mehrstufigem Reasoning und agentischen Evaluationssuites (z. B. mehrturnige Planung, Aufgabenzerlegung) erzielte GLM-5 Best-in-Class-Ergebnisse für Open-Source-Modelle und übertraf in einigen Metriken konkurrierende geschlossene Modelle bei gezielten Aufgaben.

Wie kann ich GLM-5 nutzen und ausprobieren?

GLM-5 ist das großsprachige Modell der fünften Generation von Zhipu AI (Z.ai), gebaut mit einer Mixture-of-Experts-Architektur (~745 B gesamt, ~44 B aktiv) und ausgerichtet auf starkes Reasoning, Coding und agentische Workflows. Es wurde offiziell um den 12. Februar 2026 gestartet.

Derzeit gibt es zwei Hauptwege, über die man darauf zugreift:

A) Offizieller API-Zugang (Z.ai oder Aggregatoren)

Zhipu AI bietet selbst APIs für seine Modelle, und Sie können GLM-5 über diese APIs aufrufen.

Typische Schritte:

- Melden Sie sich für ein Z.ai/Open BigModel API-Konto an.

- Holen Sie sich einen API-Schlüssel aus dem Dashboard.

- Nutzen Sie einen OpenAPI- oder REST-API-Endpunkt mit dem Modellnamen (z. B.

glm-5).

(Ähnlich wie beim Aufruf von GPT-Modellen von OpenAI). - Setzen Sie Prompts und senden Sie HTTP-Anfragen.

👉 Die Preisseite von Z.ai zeigt offizielle GLM-5-Tokenpreise wie:

- ~$1.0 pro Million Eingabe-Tokens

- ~$3.2 pro Million Ausgabe-Tokens

B) Drittanbieter-API-Wrapper ——CometAPI

APIs wie CometAPI oder WaveSpeed bündeln mehrere KI-Modelle (OpenAI, Claude, Z.ai etc.) hinter einer einheitlichen Schnittstelle.

- Mit Diensten wie CometAPI können Sie GLM-Modelle aufrufen, indem Sie die Modell-ID umschalten.

(CometAPI unterstützt derzeit GLM-5/GLM-4.7.) - CometAPI’s glm-5 ist zu 20% des offiziellen Preises bepreist.

| Nutzungsart | Preis |

|---|---|

| Eingabe-Tokens | ~$0.8 pro 1M Tokens |

| Ausgabe-Tokens | ~$2.56 pro 1M Tokens |

Warum das wichtig ist: Sie behalten Ihren bestehenden OpenAI-kompatiblen Client-Code und ändern nur die Basis-URL/Modell-ID.

C) Selbsthosting über Hugging Face / Gewichte

Es gibt inoffizielle GLM-5-Gewichts-Repositories (z. B. Versionen namens glm-5/glm-5-fp8), die in den Hugging Face-Modelllisten sichtbar sind.

Damit können Sie:

- Die Modellgewichte herunterladen.

- Tools wie vLLM, SGLang, xLLM oder Transformers nutzen, um lokal oder auf Ihrer Cloud-GPU-Flotte zu serven.

Vorteile: maximale Kontrolle, keine laufenden API-Kosten.

Nachteile: enorme Rechenanforderungen — vermutlich mehrere High-End-GPUs und Speicher (mehrere hundert GB), was es auf kleinen Systemen unpraktisch macht.

Also — lohnt sich GLM-5, und sollten Sie GLM-4.7 behalten?

Kurzfassung (Executive Summary)

- Wenn Ihre Arbeit robustes, mehrstufiges agentisches Verhalten, produktionsreife Codegenerierung oder Systemautomatisierung erfordert: GLM-5 lohnt sich zur sofortigen Evaluierung. Architektur, Umfang und Tuning sind genau auf diese Ergebnisse ausgerichtet.

- Wenn Sie kosteneffiziente, hochdurchsatzfähige Microservices benötigen (kurzer Chat, Klassifikation, leichte Prompts): GLM-4.7 bleibt vermutlich die wirtschaftlichste Wahl. GLM-4.7 bewahrt einen starken Fähigkeitsumfang zu deutlich niedrigeren pro-Token-Kosten bei vielen Anbietern und ist bereits praxiserprobt.

Ausführlichere Antwort (praktische Empfehlung)

Verfolgen Sie eine gestufte Modellstrategie: Nutzen Sie GLM-4.7 für alltägliche, hochvolumige Interaktionen und reservieren Sie GLM-5 für hochwertige Ingenieurprobleme und agentische Orchestrierung. Pilotieren Sie GLM-5 auf einem kleinen Produktausschnitt, der langen Kontext, Tooling-Integration und Codekorrektheit erprobt; messen Sie sowohl eingesparte Ingenieurszeit als auch die zusätzlichen Modellkosten. Mit der Zeit wissen Sie, ob der Fähigkeitszuwachs von GLM-5 eine breitere Migration rechtfertigt.

Mit CometAPI können Sie jederzeit zwischen GLM-4.7 und GLM-5 wechseln.

Praxisnahe Anwendungsfälle, in denen GLM-5 glänzt

1. Komplexe Agenten-Orchestrierung

Der Designfokus von GLM-5 auf mehrstufige Planung und Tool-Calling macht es gut geeignet für Systeme, die Suche, API-Aufrufe und Programmausführung koordinieren müssen (zum Beispiel: automatisierte Forschungsassistenten, iterative Codegeneratoren oder mehrstufige Kundendienst-Agenten, die Datenbanken und externe APIs konsultieren müssen).

2. Langform-Engineering & Codebasen-Reasoning

Wenn das Modell viele Dateien oder eine große Codebasis analysieren, refaktorisieren oder synthesieren soll, sind GLM-5’s erweiterter Kontext und Sparse Attention direkte Vorteile — weniger Fehlermodi durch abgeschnittenen Kontext und bessere Konsistenz über lange Spannen.

3. Wissensintensive Synthese

Analyst:innen und Produktteams, die komplexe Berichte erstellen — mehrteilige Forschungsbriefings, juristische Zusammenfassungen oder regulatorische Einreichungen — profitieren von den Verbesserungen des Modells beim stabilen mehrstufigen Reasoning und reduzierten Halluzinationen in von Anbietern gemeldeten Tests.

4. Agentische Automatisierung für Workflows

Teams, die Automatisierungen aufbauen, die mehrere Systeme orchestrieren müssen (z. B. Planung + Ticketing + Deployment-Pipelines), können GLM-5 als zentralen Planer und Ausführer nutzen, unterstützt von Tool-Calling-Frameworks und Sicherheits-Wrappern.

Fazit

GLM-5 ist eine wichtige Veröffentlichung im sich schnell entwickelnden Frontier-Model-Landschaft. Der Schwerpunkt auf agentischer Ingenieurarbeit, verbessertem Codieren und Reasoning sowie die Verfügbarkeit offener Gewichte machen es attraktiv für Teams, die langhorizontige, Tool-gestützte KI-Systeme bauen. Reale Fortschritte bei ausgewählten Aufgaben und ermutigende Kosten-/Leistungsabstriche — Käufer sollten GLM-5 jedoch an ihren spezifischen Aufgaben evaluieren und eigene kontrollierte Benchmarks durchführen, bevor sie sich für den Produktionseinsatz entscheiden.

Entwickler:innen können auf GLM-5 über CometAPI jetzt zugreifen. Zum Einstieg erkunden Sie die Fähigkeiten des Modells im Playground und konsultieren Sie den API-Guide für detaillierte Anweisungen. Bevor Sie zugreifen, stellen Sie bitte sicher, dass Sie sich bei CometAPI angemeldet und den API-Schlüssel erhalten haben. CometAPI bietet einen Preis, der weit unter dem offiziellen liegt, um Ihnen die Integration zu erleichtern.

Bereit, loszulegen?→ Registrieren Sie sich noch heute für glm-5 !

Wenn Sie mehr Tipps, Anleitungen und Neuigkeiten zu KI erfahren möchten, folgen Sie uns auf VK, X und Discord!