GPT-4o Echtzeit-API: Ein multimodaler Streaming-Endpunkt mit geringer Latenz, der es Entwicklern ermöglicht, synchronisierte Text-, Audio- und Bilddaten über WebRTC oder WebSocket zu senden und zu empfangen (Modell=gpt-4o-realtime-preview-<date>, stream=true) für interaktive Echtzeitanwendungen.

Grundlegende Informationen und Funktionen

OpenAIs GPT-4o Echtzeit (Modell-ID: gpt-4o-Echtzeit-Vorschau-2025-06-03) ist das erste öffentlich zugängliche Stiftungsmodell, das für End-to-End-Sprache-zu-Sprache (S2S) interagieren mit Latenz von unter einer SekundeAbgeleitet aus der „omni“ GPT-4o-Familie, vereint die Realtime-Variante Spracherkennung, natürliche Spracherkennung und neuronale Text-to-Speech- in einem einzigen Netzwerk, sodass Entwickler Sprachagenten erstellen können, die so flüssig kommunizieren wie Menschen. Das Modell wird durch die speziell entwickelte Echtzeit-API und ist eng integriert mit dem neuen RealtimeAgent Abstraktion innerhalb der Agenten-SDK (TypeScript und Python).

Kernfunktionsumfang — End-to-End S2S • Unterbrechungsbehandlung • Tool-Aufruf

• Native Spracherkennung: Audioeingaben werden als kontinuierliche Streams aufgenommen, intern tokenisiert, analysiert und als synthetisierte Sprache zurückgegeben. Es werden keine externen STT/TTS-Puffer benötigt, wodurch Pipeline-Verzögerungen von mehreren Sekunden vermieden werden.

• Latenz im Millisekundenbereich: Architektonisches Beschneiden, Modelldestillation und ein GPU-optimierter Server-Stack ermöglichen ~300–500 ms Latenz beim ersten Token in typischen Cloud-Bereitstellungen, die sich den menschlichen Gesprächswechselnormen annähern.

• Robustes Befolgen von Anweisungen: GPT-4o Realtime ist auf Konversationsskripte und Funktionsaufrufspuren abgestimmt und demonstriert eine >25 % weniger Fehler bei der Aufgabenausführung verglichen mit dem GPT-2024o-Basiswert vom Mai 4.

• Deterministischer Tool-Aufruf: Das Modell erzeugt strukturiertes JSON, das OpenAIs Funktionsaufrufschema, wodurch der deterministische Aufruf von Back-End-APIs (Buchungssysteme, Datenbanken, IoT) ermöglicht wird. Fehlerbewusste Wiederholungsversuche und Argumentvalidierung sind integriert.

• Angenehme Unterbrechungen: Ein Echtzeit-Stimmaktivitätsdetektor gepaart mit inkrementeller Dekodierung ermöglicht dem Agenten, Rede mitten im Satz unterbrechen, nehmen Sie eine Benutzerunterbrechung auf und setzen Sie die Antwort nahtlos fort oder planen Sie sie neu.

• Konfigurierbare Sprechgeschwindigkeit: Neue Geschwindigkeit Mit dem Parameter (0.25–4 × Echtzeit) können Entwickler die Ausgabegeschwindigkeit für Zugänglichkeits- oder Schnellfeueranwendungen anpassen.

Technische Architektur — Einheitlicher multimodaler Transformator

Einheitlicher Encoder-Decoder: GPT-4o Realtime teilt die Omni-Architektur Single-Stack-Transformator in dem Audio-, Text- und (zukünftige) Vision-Token in einem latenten Raum koexistieren. Durch schichtweise adaptive Berechnung werden Audioframes direkt an spätere Aufmerksamkeitsblöcke weitergeleitet, wodurch pro Durchgang 20–40 ms eingespart werden.

Hierarchische Audio-Tokenisierung: Rohes 16 kHz PCM wird in Log-Mel-Patches zerlegt → in grobkörnige akustische Token quantisiert → in semantische Token komprimiert, wodurch die Token pro Sekunde Budget, ohne die Prosodie zu opfern.

Low-Bit-Inferenzkerne: Die eingesetzten Gewichte betragen 4-Bit-NF4-Quantisierung über Triton-/TensorRT-LLM-Kernel, wodurch der Durchsatz im Vergleich zu fp16 verdoppelt wird und gleichzeitig der MOS-Qualitätsverlust <1 dB erhalten bleibt.

Streaming Achtung: Durch rotierende Einbettungen mit gleitendem Fenster und Schlüssel-Wert-Caching kann das Modell die letzten 15 Sekunden des Audios mit O(L)-Speicher verarbeiten, was für Dialoge in der Länge eines Telefongesprächs entscheidend ist.

Technische Daten

- API Version:

2025-06-03-preview - Transportprotokolle:

- WebRTC: Extrem niedrige Latenz (< 80 ms) für clientseitige Audio-/Video-Streams

- WebSocket: Server-zu-Server-Streaming mit einer Latenz von unter 100 ms

- Datencodierung:

- opus Codec innerhalb RTP Pakete für Audio

- H.264 / H.265 Frame Wrapper für Video

- Streaming: Unterstützt

stream: true. inkremental Teilantworten als Token werden generiert - Neue Stimmenpalette: Stellt acht neue Stimmen vor—Legierung, Asche, Ballade, Koralle, Echo, Salbei, Schimmer und Vers– für mehr expressiv, menschenähnlich Interaktionen ..

Entwicklung von GPT-4o Realtime

- Mai 2024: GPT-4o Omni Debütiert mit multimodaler Unterstützung für Text, Audio und Bild.

- Oktober 2024: Echtzeit-API geht in die private Beta (

2024-10-01-preview), optimiert für Audio mit geringer Latenz. - Dezember 2024: Erweiterte globale Verfügbarkeit von

gpt-4o-realtime-preview-2024-12-17Und fügte hinzu, sofortige Zwischenspeicherung und mehr Stimmen. - 3. Juni 2025: Letztes Update (

2025-06-03-preview) rollt verfeinert aus Stimmpalette und Leistungsoptimierungen.

Benchmark-Leistung

- MMLU: 88.7und übertraf damit GPT-4s 86.5 auf Massives Multitask-Sprachverständnis .

- Spracherkennung: Erreicht branchenführend Wortfehlerraten in lauten Umgebungen, übertreffen Flüstern Basislinien.

- Latenztests:

- Ende zu Ende (Sprache rein → Text raus): 50–80 ms über WebRTC

- Round-Trip-Audio (Rede ein → Rede aus): <100 ms .

Technische Indikatoren

- Durchsatz: Hält 15 Token/Sekunde für Textströme; 24 kbps Opus für Audio.

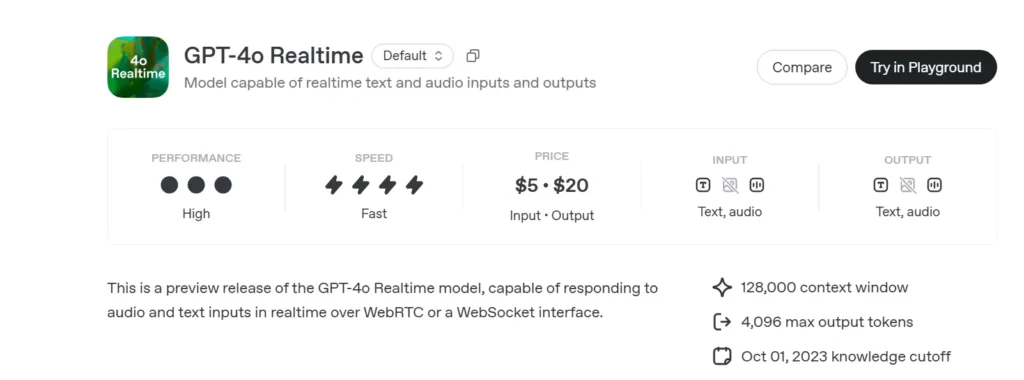

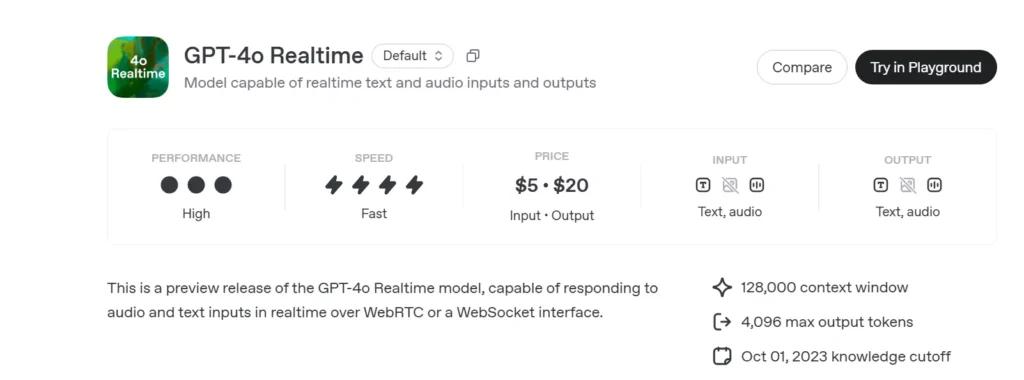

- AnzeigenPreise:

- Text: 5 USD pro 1 Mio. Eingabetoken; 20 USD pro 1 Mio. Ausgabetoken

- Audio: 100 USD pro 1 Mio. Eingabetoken; 200 USD pro 1 Mio. Ausgabetoken.

- Verfügbarkeit: Weltweit in allen Regionen bereitgestellt, die die Echtzeit-API unterstützen.

So rufen Sie die GPT-4o-Echtzeit-API von CometAPI auf

GPT-4o Realtime API-Preise in CometAPI:

- Eingabe-Token: 2 $ / M Token

- Ausgabe-Token: 8 $ / M Token

Erforderliche Schritte

- Einloggen in cometapi.comWenn Sie noch nicht unser Benutzer sind, registrieren Sie sich bitte zuerst

- Holen Sie sich den API-Schlüssel für die Zugangsdaten der Schnittstelle. Klicken Sie im persönlichen Bereich beim API-Token auf „Token hinzufügen“, holen Sie sich den Token-Schlüssel: sk-xxxxx und senden Sie ihn ab.

- Holen Sie sich die URL dieser Site: https://api.cometapi.com/

Verwendungsmethoden

- Wählen Sie das "

gpt-4o-realtime-preview-2025-06-03”-Endpunkt, um die Anfrage zu senden und den Anfragetext festzulegen. Die Anfragemethode und der Anfragetext stammen aus der API-Dokumentation unserer Website. Unsere Website bietet außerdem einen Apifox-Test für Ihre Bequemlichkeit. - Ersetzen mit Ihrem aktuellen CometAPI-Schlüssel aus Ihrem Konto.

- Geben Sie Ihre Frage oder Anfrage in das Inhaltsfeld ein – das Modell antwortet darauf.

- . Verarbeiten Sie die API-Antwort, um die generierte Antwort zu erhalten.

Informationen zum Modellzugriff in der Comet-API finden Sie unter API-Dokument.

Informationen zu Modellpreisen in der Comet-API finden Sie unter https://api.cometapi.com/pricing.

Beispielcode und API-Integration

import openai

openai.api_key = "YOUR_API_KEY"

# Establish a Realtime WebRTC connection

connection = openai.Realtime.connect(

model="gpt-4o-realtime-preview-2025-06-03",

version="2025-06-03-preview",

transport="webrtc"

)

# Stream audio frames and receive incremental text

with open("user_audio.raw", "rb") as audio_stream:

for chunk in iter(lambda: audio_stream.read(2048), b""):

result = connection.send_audio(chunk)

print("Assistant:", result)

- Parameter:

model: „gpt-4o-realtime-preview-2025-06-03“version: „2025-06-03-Vorschau“transport: „webrtc“ für minimale Latenzstream:truefür inkremental Aktuelles

Durch Kombinieren State-of-the-art multimodales Denken, ein robust neue Stimmpalette und Sehr niedrig Latenz-Streaming, GPT-4o Echtzeit (2025-06-03) ermöglicht Entwicklern, wirklich interaktive, Konversations KI-Anwendungen.

Siehe auch o3-Pro API

Sicherheit & Compliance

OpenAI liefert GPT-4o Realtime mit:

• Leitplanken auf Systemebene: Richtlinienmäßig darauf abgestimmt, unzulässige Anfragen abzulehnen (Extremismus, rechtswidriges Verhalten).

• Echtzeit-Inhaltsfilterung: Klassifikatoren mit einer Laufzeit von weniger als 100 ms prüfen vor der Ausgabe sowohl die Benutzereingaben als auch die Modellausgaben.

• Pfade zur menschlichen Genehmigung: Ausgelöst durch den Aufruf von Tools mit hohem Risiko (Zahlungen, Rechtsberatung) unter Nutzung der neuen Genehmigungsprimitiven des Agents SDK.