Stand December 15, 2025 zeigen öffentlich verfügbare Fakten, dass Google’s Gemini 3 Pro (preview) und OpenAI’s GPT-5.2 beide neue Maßstäbe bei Reasoning, Multimodalität und Langkontext-Aufgaben setzen — jedoch unterschiedliche Engineering-Wege einschlagen (Gemini → Sparse MoE + riesiger Kontext; GPT-5.2 → dichte/„Routing“-Designs, Komprimierung und x-high Reasoning-Modi) und dadurch Spitzen-Benchmark-Siege vs. Engineering-Vorhersagbarkeit, Tooling und Ökosystem gegeneinander abwägen. Welches „besser“ ist, hängt von den primären Anforderungen ab: Agentische Anwendungen mit extremem Kontext und Multimodalität tendieren zu Gemini 3 Pro; stabiles Enterprise-Developer-Tooling, vorhersehbare Kosten und sofortige API-Verfügbarkeit sprechen für GPT-5.2.

Was ist GPT-5.2 und was sind die wichtigsten Funktionen?

GPT-5.2 ist OpenAIs Release vom 11. Dezember 2025 in der GPT-5-Familie (Varianten: Instant, Thinking, Pro). Es ist als das leistungsfähigste Modell des Unternehmens für „professionelle Wissensarbeit“ positioniert — optimiert für Tabellenkalkulationen, Präsentationen, Langkontext-Reasoning, Tool-Aufrufe, Codegenerierung und Vision-Aufgaben. OpenAI stellte GPT-5.2 zahlenden ChatGPT-Nutzern und über die OpenAI API (Responses API / Chat Completions) unter Modellnamen wie gpt-5.2, gpt-5.2-chat-latest und gpt-5.2-pro zur Verfügung.

Modellvarianten und vorgesehener Einsatz

- gpt-5.2 / GPT-5.2 (Thinking) — am besten für komplexes, mehrstufiges Reasoning (die Standardvariante der „Thinking“-Familie in der Responses API).

- gpt-5.2-chat-latest / Instant — geringere Latenz für alltägliche Assistenten- und Chat‑Anwendungen.

- gpt-5.2-pro / Pro — höchste Präzision/Zuverlässigkeit für die schwierigsten Probleme (zusätzliche Rechenleistung, unterstützt

reasoning_effort: "xhigh").

Wichtige technische Funktionen (nutzerseitig)

- Vision- & Multimodal-Verbesserungen — besseres räumliches Reasoning bei Bildern und verbesserte Videokompetenz in Kombination mit Code-Tools (Python-Tool) sowie Unterstützung für Code-Interpreter‑ähnliche Tools zur Ausführung von Snippets.

- Konfigurierbarer Reasoning-Aufwand (

reasoning_effort: none|minimal|low|medium|high|xhigh), um Latenz/Kosten gegen Tiefe zu tauschen.xhighist neu bei GPT-5.2 (und auf Pro verfügbar). - Verbesserter Langkontext und Komprimierungsfunktionen, um über Hunderttausende Tokens hinweg zu argumentieren (OpenAI berichtet starke MRCRv2-/Langkontext-Metriken).

- Fortgeschrittene Tool-Aufrufe & agentische Workflows — stärkere Multi-Turn-Koordination, bessere Orchestrierung von Tools in einer „Single Mega-Agent“-Architektur (OpenAI hebt Tau2-bench‑Tool-Performance hervor).

Was ist Gemini 3 Pro Preview?

Gemini 3 Pro Preview ist Googles fortschrittlichstes generatives KI-Modell, veröffentlicht als Teil der breiteren Gemini‑3‑Familie im November 2025. Das Modell legt den Schwerpunkt auf multimodales Verständnis — in der Lage, Text, Bilder, Video und Audio zu verstehen und zu synthetisieren — und verfügt über ein großes Kontextfenster (~1 Million Tokens) für sehr umfangreiche Dokumente oder Codebasen.

Google positioniert Gemini 3 Pro als State of the Art in Reasoning-Tiefe und Nuance und setzt es als Kernmotor für mehrere Developer- und Enterprise-Tools ein, darunter Google AI Studio, Vertex AI und agentische Entwicklungsplattformen wie Google Antigravity.

Derzeit befindet sich Gemini 3 Pro in der Preview-Phase — Funktionalität und Zugriff werden noch ausgebaut, doch das Modell erzielt bereits hohe Werte bei Logik, multimodalem Verständnis und agentischen Workflows.

Wichtige technische & Produkt-Features

- Kontextfenster: Gemini 3 Pro Preview unterstützt ein 1.000.000‑Token‑Eingabekontextfenster (und bis zu 64k Token Ausgaben), was praktisch ein großer Vorteil ist, um extrem große Dokumente, Bücher oder Videotranskripte in einer einzigen Anfrage zu verarbeiten.

- API-Features: Parameter

thinking_level(low/high) zum Abwägen von Latenz und Reasoning-Tiefe;media_resolution‑Einstellungen zur Steuerung von multimodaler Qualität und Tokenverbrauch; Search-Grounding, Datei/URL‑Kontext, Codeausführung und Function Calling werden unterstützt. Thought Signatures und Kontext‑Caching helfen, den Zustand über mehrere Aufrufe hinweg zu halten. - Deep‑Think‑Modus / höheres Reasoning: Eine „Deep Think“-Option ermöglicht einen zusätzlichen Reasoning‑Durchlauf, um bei schwierigen Benchmarks höhere Werte zu erzielen. Google veröffentlicht Deep Think als separaten Hochleistungs‑Pfad für komplexe Probleme.

- Native Multimodal‑Unterstützung: Text‑, Bild‑, Audio‑ und Videoeingaben mit enger Anbindung an Search und Produktintegrationen (Video‑MMMU‑Werte und andere multimodale Benchmarks werden hervorgehoben).

Schnellüberblick — GPT-5.2 vs Gemini 3 Pro

Kompakte Vergleichstabelle mit den wichtigsten Fakten (Quellen angegeben).

| Aspekt | GPT-5.2 (OpenAI) | Gemini 3 Pro (Google / DeepMind) |

|---|---|---|

| Anbieter / Positionierung | OpenAI — Flaggschiff‑Upgrade GPT‑5.x mit Fokus auf professionelle Wissensarbeit, Coding und agentische Workflows. | Google DeepMind / Google AI — Flaggschiff der Gemini‑Generation mit Fokus auf ultralanges Kontext‑Reasoning und Tool‑Integration. |

| Hauptvarianten | Instant, Thinking, Pro (und automatisches Umschalten zwischen ihnen). Pro bietet höheren Reasoning‑Aufwand. | Gemini‑3‑Familie einschließlich Gemini 3 Pro und Deep‑Think‑Modi; Fokus auf Multimodalität/Agentik. |

| Kontextfenster (Input / Output) | ~400.000 Token Gesamteingabekapazität; bis zu 128.000 Output‑/Reasoning‑Tokens (ausgelegt für sehr lange Dokumente & Codebasen). | Bis zu ~1.000.000 Tokens Eingabe/Kontextfenster (1M) mit bis zu 64K‑Token Ausgaben |

| Zentrale Stärken / Fokus | Langkontext‑Reasoning, agentische Tool‑Aufrufe, Coding, strukturierte Office‑Aufgaben (Tabellen, Präsentationen); Sicherheits-/System‑Cards betonen Zuverlässigkeit. | Multimodales Verständnis in großem Maßstab, Reasoning + Bildkomposition, sehr großer Kontext + „Deep Think“-Reasoning‑Modus, starke Tool-/Agent‑Integrationen im Google‑Ökosystem. |

| Multimodal- & Bildfähigkeiten | Verbesserte Vision und multimodales Grounding; abgestimmt auf Tool‑Nutzung und Dokumentanalyse. | Hochwertige Bildgenerierung + Reasoning‑gestützte Komposition, Multi‑Reference‑Bildbearbeitung und gut lesbare Textrenderings. |

| Latenz / Interaktivität | Anbieter betont schnellere Inferenz und Prompt‑Reaktionsfähigkeit (geringere Latenz als frühere GPT‑5.x‑Modelle); mehrere Stufen (Instant / Thinking / Pro). | Google betont optimiertes „Flash“/Serving und vergleichbare Interaktivität in vielen Abläufen; Deep‑Think‑Modus tauscht Latenz gegen tieferes Reasoning. |

| Bemerkenswerte Merkmale / Differenz. | Reasoning‑Aufwandsstufen (medium/high/xhigh), verbesserte Tool‑Aufrufe, hochwertige Codegenerierung, hohe Token‑Effizienz für Enterprise‑Workflows. | 1M‑Token‑Kontext, starke native multimodale Ingestion (Video/Audio), „Deep Think“-Reasoning‑Modus, enge Google‑Produktintegrationen (Docs/Drive/NotebookLM). |

| Typische Best‑Uses (kurz) | Langdokument‑Analyse, agentische Workflows, komplexe Coding‑Projekte, Enterprise‑Automatisierung (Tabellen/Reports). | Extrem große multimodale Projekte, langhorizontale agentische Workflows mit 1M‑Token‑Kontext, fortgeschrittene Bild‑ + Reasoning‑Pipelines. |

Wie vergleichen sich GPT-5.2 und Gemini 3 Pro architektonisch?

Kernarchitektur

- Benchmarks / Real‑Work‑Evals: GPT-5.2 Thinking erreichte 70.9% Siege/Unentschieden auf GDPval (44‑Berufe‑Wissensarbeits‑Eval) und große Zugewinne auf Engineering‑ und Mathe‑Benchmarks gegenüber früheren GPT‑5‑Varianten. Deutliche Verbesserungen beim Coding (SWE‑Bench Pro) und wissenschaftlichen QA‑Domänen (GPQA Diamond).

- Tooling & Agenten: Starke Built‑in‑Unterstützung für Tool‑Aufrufe, Python‑Ausführung und agentische Workflows (Dokumentensuche, Dateianalyse, Data‑Science‑Agenten). 11x Geschwindigkeit / <1% Kosten gegenüber menschlichen Experten bei einigen GDPval‑Aufgaben (Maß für potenziellen wirtschaftlichen Wert, 70.9% vs. zuvor ~38.8%) und konkrete Zugewinne in Spreadsheet‑Modellierung (z. B. +9.3% bei einer Junior‑Investment‑Banking‑Aufgabe vs. GPT‑5.1).

- Gemini 3 Pro: Sparse Mixture‑of‑Experts Transformer (MoE). Das Modell aktiviert pro Token nur eine kleine Menge an Experten, was eine extrem große Gesamt‑Parameterkapazität bei sublinearen Pro‑Token‑Rechenkosten ermöglicht. Google veröffentlicht eine Model Card, die klarstellt, dass das Sparse‑MoE‑Design wesentlich zur verbesserten Performance beiträgt. Diese Architektur ermöglicht es, die Modellkapazität deutlich zu erhöhen, ohne die Inferenzkosten linear mitwachsen zu lassen.

- GPT-5.2 (OpenAI): OpenAI setzt weiterhin Transformer‑basierte Architekturen mit Routing/Komprimierung in der GPT‑5‑Familie ein (ein „Router“ triggert verschiedene Modi — Instant vs. Thinking — und das Unternehmen dokumentiert Komprimierungs‑ und Token‑Management‑Techniken für lange Kontexte). GPT‑5.2 betont Training und Auswertung, um „vor der Antwort nachzudenken“, sowie Komprimierung für Langhorizont‑Aufgaben statt eines klassisch großskalig angekündigten Sparse‑MoE.

Implikationen der Architekturen

- Latenz‑ & Kosten‑Trade‑offs: MoE‑Modelle wie Gemini 3 Pro können höhere Spitzenfähigkeit pro Token bieten und gleichzeitig die Inferenzkosten für viele Aufgaben niedrig halten, da nur ein Teil der Experten ausgeführt wird. Sie können jedoch Serving‑ und Scheduling‑Komplexität erhöhen (Cold‑Start‑Expert‑Balancing, IO). GPT‑5.2s Ansatz (dicht/geroutet mit Komprimierung) begünstigt vorhersehbare Latenz und Developer‑Ergonomie — insbesondere in den etablierten OpenAI‑Tools wie Responses, Realtime, Assistants und Batch‑APIs.

- Skalierung langer Kontexte: Geminis 1M‑Eingabe‑Token‑Fähigkeit erlaubt es, extrem lange Dokumente und multimodale Streams nativ zu verarbeiten. GPT‑5.2s ~400k kombinierter Kontext (Input+Output) ist weiterhin massiv und deckt die meisten Enterprise‑Bedarfe ab, ist aber kleiner als Geminis 1M‑Spez. Für sehr große Korpora oder mehrstündige Videotranskripte bietet Geminis Spez einen klaren technischen Vorteil.

Tooling, Agenten und multimodale Infrastruktur

- OpenAI: tiefe Integration für Tool‑Aufrufe, Python‑Ausführung, „Pro“‑Reasoning‑Modi und bezahlte Agenten‑Ökosysteme (ChatGPT Agents / Enterprise‑Tool‑Integrationen. Starker Fokus auf code‑zentrische Workflows sowie die Generierung von Tabellen/Slides als First‑Class‑Outputs.

- Google / Gemini: integriertes Grounding zu Google Search (optionales, kostenpflichtiges Feature), Codeausführung, URL‑ und Datei‑Kontext sowie explizite Medienauflösungs‑Kontrollen, um Tokens gegen visuelle Qualität zu tauschen. Die API bietet

thinking_levelund weitere Stellschrauben, um Kosten/Latenz/Qualität zu tunen.

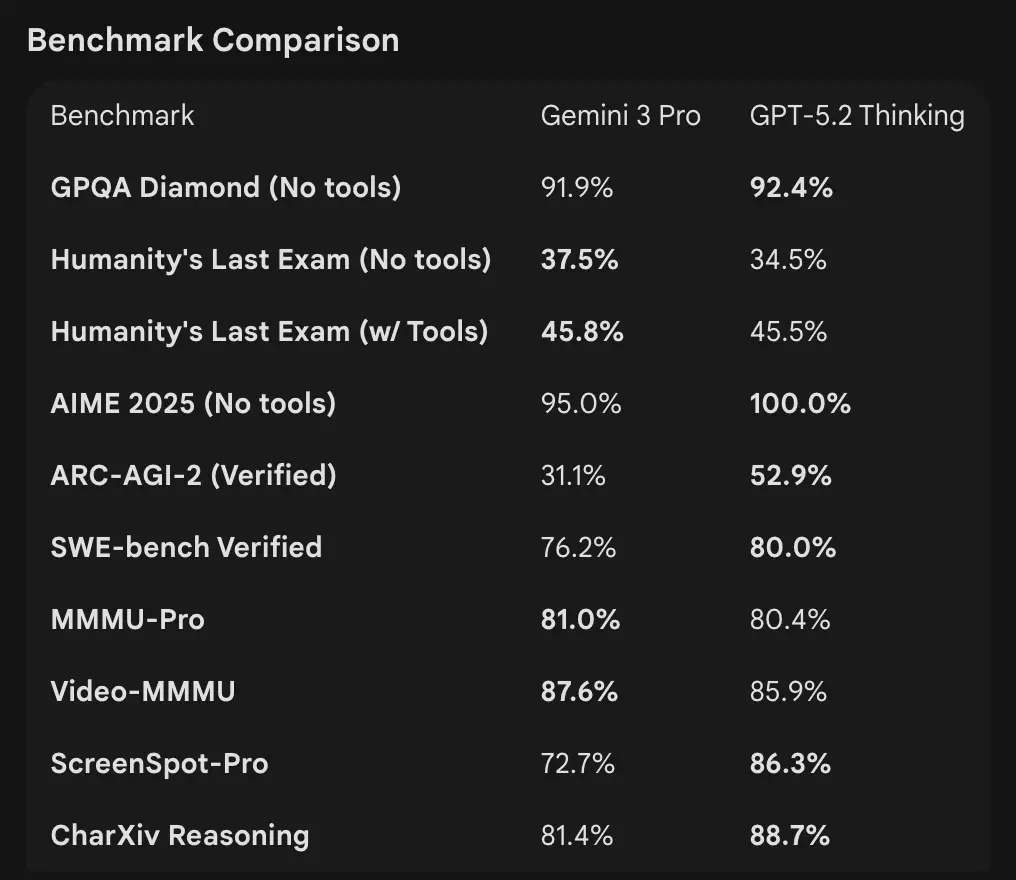

Wie vergleichen sich die Benchmark-Zahlen?

Kontextfenster und Token-Handhabung

- Gemini 3 Pro Preview: 1,000,000 Input‑Tokens / 64k Output‑Tokens (Pro‑Preview‑Model Card). Knowledge cutoff: January 2025 (Google).

- GPT-5.2: OpenAI demonstriert starke Langkontext‑Performance (MRCRv2‑Scores über 4k–256k „Needle“‑Tasks mit >85–95% in vielen Einstellungen) und nutzt Komprimierungsfunktionen; OpenAIs öffentliche Kontextbeispiele zeigen robuste Performance auch bei sehr großen Kontexten, doch OpenAI listet variantspezifische Fenster (und betont Komprimierung statt einer einzigen 1M‑Zahl). Für die API‑Nutzung lauten die Modellnamen

gpt-5.2,gpt-5.2-chat-latest,gpt-5.2-pro.

Reasoning- und agentische Benchmarks

- OpenAI (Auswahl): Tau2‑bench Telecom 98.7% (GPT‑5.2 Thinking), starke Zugewinne in Multi‑Step‑Tool‑Nutzung und agentischen Aufgaben (OpenAI betont das Kollabieren von Multi‑Agent‑Systemen zu einem „Mega‑Agent“). GPQA Diamond und ARC‑AGI zeigten Sprünge gegenüber GPT‑5.1.

- Google (Auswahl): Gemini 3 Pro: LMArena 1501 Elo, MMMU‑Pro 81%, Video‑MMMU 87.6%, hohe GPQA‑ und Humanity’s Last Exam‑Werte; Google demonstriert zudem starke Langhorizont‑Planung anhand agentischer Beispiele.

Tooling & Agenten:

GPT-5.2: Starke Built‑in‑Unterstützung für Tool‑Aufrufe, Python‑Ausführung und agentische Workflows (Dokumentensuche, Dateianalyse, Data‑Science‑Agenten). 11x Geschwindigkeit / <1% Kosten gegenüber menschlichen Experten bei einigen GDPval‑Aufgaben (Maß für potenziellen wirtschaftlichen Wert , 70.9% vs. zuvor ~38.8%), und konkrete Zugewinne in Spreadsheet‑Modellierung (z. B. +9.3% bei einer Junior‑Investment‑Banking‑Aufgabe vs. GPT‑5.1).

Interpretation: Benchmarks sind komplementär — OpenAI betont Real‑World‑Wissensarbeits-Benchmarks (GDPval), die zeigen, dass GPT‑5.2 bei produktiven Aufgaben wie Tabellen, Slides und langen agentischen Sequenzen glänzt. Google betont Raw‑Reasoning‑Leaderboards und extrem große Kontextfenster für Einzelanfragen. Was wichtiger ist, hängt vom Workload ab: agentische Enterprise‑Pipelines mit Langdokumenten begünstigen die bewährte GDPval‑Performance von GPT‑5.2; die Aufnahme massiven Rohkontexts (z. B. ganze Videokorpora/volle Bücher in einem Durchlauf) begünstigt Geminis 1M‑Eingabefenster.

Wie vergleichen sich die multimodalen Fähigkeiten?

Eingaben & Ausgaben

- Gemini 3 Pro Preview: unterstützt Text, Bild, Video, Audio, PDF als Eingaben und Textausgaben; Google bietet granulare

media_resolution‑Kontrollen sowie den Parameterthinking_level, um Kosten vs. Multimodal‑Fidelity zu steuern. Maximale Output‑Tokens 64k; Eingabe bis zu 1M Tokens. - GPT-5.2: unterstützt reichhaltige Vision‑ und Multimodal‑Workflows; OpenAI hebt verbessertes räumliches Reasoning (geschätzte Labels für Bild‑Komponenten/Bereiche), Videokompetenz (Video‑MMMU‑Scores) und Tool‑gestützte Vision hervor (Python‑Tool bei Vision‑Aufgaben verbessert Scores). GPT‑5.2 betont, dass komplexe Vision+Code‑Aufgaben deutlich profitieren, wenn Tool‑Support (Python‑Codeausführung) aktiviert ist.

Praktische Unterschiede

Granularität vs. Breite: Gemini bietet eine Reihe multimodaler Stellschrauben (media_resolution, thinking_level), mit denen Entwickler Trade‑offs pro Medientyp feintunen können. GPT‑5.2 betont die integrierte Tool‑Nutzung (Python im Loop), um Vision, Code und Datentransformationen zu kombinieren. Wenn Ihr Use Case stark auf Video‑/Bildanalyse mit extrem großen Kontexten setzt, ist Geminis 1M‑Kontext sehr überzeugend; wenn Ihre Workflows Codeausführung „in the loop“ benötigen (Datentransformationen, Spreadsheet‑Generierung), sind GPT‑5.2s Code‑Tooling und Agenten‑Freundlichkeit oft bequemer.

Wie sieht es mit API-Zugang, SDKs und Preisen aus?

OpenAI GPT-5.2 (API & Preise)

- API:

gpt-5.2,gpt-5.2-chat-latest,gpt-5.2-proüber Responses API / Chat Completions. Etablierte SDKs (Python/JS), Cookbook‑Guides und ein reifes Ökosystem. - Preise (öffentlich): $1.75 / 1M Input‑Tokens und $14 / 1M Output‑Tokens; Caching‑Rabatte (90% für gecachte Inputs) senken die effektiven Kosten bei wiederholten Daten. OpenAI betont Token‑Effizienz (höherer Preis pro Token, aber geringere Gesamtkosten bis zur Qualitäts‑Schwelle).

Gemini 3 Pro Preview (API & Preise)

- API:

gemini-3-pro-previewüber Google GenAI SDK sowie Vertex AI/GenerativeLanguage‑Endpoints. Neue Parameter (thinking_level,media_resolution) und Integration mit Google‑Groundings und Tools. - Preise (Public Preview): ungefähr $2 / 1M Input‑Tokens und $12 / 1M Output‑Tokens für Preview‑Tiers unter 200k Tokens; zusätzliche Gebühren können für Search‑Grounding, Maps oder andere Google‑Dienste anfallen (Search‑Grounding‑Abrechnung beginnt am 5. Jan. 2026).

GPT-5.2 und Gemini 3 über CometAPI verwenden

CometAPI ist ein Gateway-/Aggregator‑API: ein einzelner, OpenAI‑ähnlicher REST‑API‑Endpoint, der Ihnen einheitlichen Zugriff auf Hunderte Modelle vieler Anbieter ermöglicht (LLMs, Bild/Video‑Modelle, Embedding‑Modelle usw.). Statt viele Vendor‑SDKs zu integrieren, können Entwickler vertraute OpenAI‑Format‑Endpoints (chat/completions/embeddings/images) aufrufen und unter der Haube zwischen Modellen oder Anbietern wechseln.

Entwickler können Flaggschiff‑Modelle zweier unterschiedlicher Unternehmen gleichzeitig via CometAPI nutzen, ohne den Anbieter zu wechseln, und die API‑Preise sind günstiger, meist mit 20% Nachlass.

Beispiel: schnelle API-Snippets (Copy & Paste zum Ausprobieren)

Nachfolgend minimalistische Beispiele, die Sie ausführen können. Sie orientieren sich an den Quickstarts der Anbieter (OpenAI Responses API + Google GenAI Client). Ersetzen Sie $OPENAI_API_KEY / $GEMINI_API_KEY durch Ihre Schlüssel.

GPT-5.2 — Python (OpenAI Responses API, reasoning auf xhigh für schwierige Probleme)

# Python (requires openai SDK that supports responses API)from openai import OpenAIclient = OpenAI(api_key="YOUR_OPENAI_API_KEY")resp = client.responses.create( model="gpt-5.2-pro", # gpt-5.2 or gpt-5.2-pro input="Summarize this 50k token company report and output a 10-slide presentation outline with speaker notes.", reasoning={"effort": "xhigh"}, # deeper reasoning max_output_tokens=4000)print(resp.output_text) # or inspect resp to get structured outputs / tokens

Hinweise: reasoning.effort ermöglicht den Trade‑off zwischen Kosten und Tiefe. Verwenden Sie gpt-5.2-chat-latest für Instant‑Chat‑Stil. OpenAI‑Dokumente zeigen Beispiele für responses.create.

GPT-5.2 — curl (einfach)

curl https://api.openai.com/v1/responses \ -H "Authorization: Bearer $OPENAI_API_KEY" \ -H "Content-Type: application/json" \ -d '{ "model": "gpt-5.2", "input": "Write a Python function that converts a PDF with tables into a normalized CSV with typed columns.", "reasoning": {"effort":"high"} }'

(Prüfen Sie das JSON auf output_text oder strukturierte Ausgaben.)

Gemini 3 Pro Preview — Python (Google GenAI Client)

# Python (google genai client) — example from Google docsfrom google import genaiclient = genai.Client(api_key="YOUR_GEMINI_API_KEY")response = client.models.generate_content( model="gemini-3-pro-preview", contents="Find the race condition in this multi-threaded C++ snippet: <paste code here>", config={ "thinkingConfig": {"thinking_level": "high"} })print(response.text)

Hinweise: thinking_level steuert die interne Überlegung des Modells; media_resolution kann für Bilder/Videos gesetzt werden. REST‑ und JS‑Beispiele finden Sie im Gemini‑Dev‑Guide von Google.

Gemini 3 Pro — curl (REST)

curl "https://generativelanguage.googleapis.com/v1beta/models/gemini-3-pro-preview:generateContent" \ -H "x-goog-api-key: $GEMINI_API_KEY" \ -H "Content-Type: application/json" \ -X POST \ -d '{ "contents": [{ "parts": [{"text": "Explain the race condition in this C++ code: ..."}] }], "generationConfig": {"thinkingConfig": {"thinkingLevel": "high"}} }'

Googles Dokumente enthalten multimodale Beispiele (Bild‑Inline‑Daten, media_resolution).

Welches Modell ist „besser“ — praktische Orientierung

Es gibt keinen „One‑Size‑Fits‑All“-Gewinner; die Wahl richtet sich nach Use Case und Rahmenbedingungen. Nachfolgend eine kurze Entscheidungsmatrix.

Wählen Sie GPT-5.2, wenn:

- Sie enge Integration mit Code‑Ausführungstools (OpenAIs Interpreter/Tool‑Ökosystem) für programmatische Datenpipelines, Spreadsheet‑Generierung oder agentische Code‑Workflows benötigen. OpenAI hebt Python‑Tool‑Verbesserungen und die Nutzung eines Mega‑Agenten hervor.

- Sie Token‑Effizienz priorisieren und explizite, vorhersehbare OpenAI‑Per‑Token‑Preise mit großen Rabatten auf gecachte Eingaben wünschen (hilfreich für Batch/Produktion).

- Sie das OpenAI‑Ökosystem bevorzugen (ChatGPT‑Produktintegration, Azure/Microsoft‑Partnerschaften und Tooling rund um Responses API und Codex).

Wählen Sie Gemini 3 Pro, wenn:

- Sie extreme multimodale Eingaben (Video + Bilder + Audio + PDFs) benötigen und ein einzelnes Modell wollen, das all dies nativ akzeptiert — mit einem 1,000,000‑Token‑Eingabefenster. Google vermarktet dies ausdrücklich für lange Videos, große Dokument‑+‑Video‑Pipelines und interaktive Search/AI‑Mode‑Use‑Cases.

- Sie auf Google Cloud / Vertex AI aufbauen und enge Integration mit Google Search‑Grounding, Vertex‑Provisionierung und den GenAI‑Client‑APIs wünschen. Sie profitieren von Google‑Produktintegrationen (Search AI Mode, AI Studio, Antigravity‑Agent‑Tooling).

Fazit: Welches ist 2026 besser?

Im Showdown GPT‑5.2 vs. Gemini 3 Pro Preview ist die Antwort kontextabhängig:

- GPT-5.2 führt bei professioneller Wissensarbeit, analytischer Tiefe und strukturierten Workflows.

- Gemini 3 Pro Preview glänzt bei multimodalem Verständnis, integrierten Ökosystemen und Aufgaben mit großem Kontext.

Keines der Modelle ist universell „besser“ — ihre Stärken adressieren unterschiedliche Realwelt‑Anforderungen. Kluge Anwender gleichen Modellwahl mit spezifischen Use Cases, Budgetgrenzen und Ökosystem‑Ausrichtung ab.

Klar ist 2026, dass die KI‑Frontier deutlich vorangeschritten ist, und sowohl GPT‑5.2 als auch Gemini 3 Pro die Grenzen dessen verschieben, was intelligente Systeme im Enterprise‑Umfeld und darüber hinaus leisten können.

Wenn Sie sofort loslegen wollen, erkunden Sie die Fähigkeiten von GPT-5.2 und Gemini 3 Pro auf CometAPI im Playground und konsultieren Sie den API‑Leitfaden für detaillierte Anweisungen. Stellen Sie vor dem Zugriff sicher, dass Sie sich bei CometAPI angemeldet und den API‑Schlüssel erhalten haben. CometAPI bietet einen deutlich niedrigeren Preis als der offizielle, um Ihnen die Integration zu erleichtern.

Bereit?→ Kostenloses Testen von GPT-5.2 und Gemini 3 Pro !

Wenn Sie möchten