OpenAI hat GPT Image 1.5 vorgestellt, das neue Flaggschiff-Modell des Unternehmens für Bildgenerierung und -bearbeitung, und eine überarbeitete „ChatGPT Images“-Experience in ChatGPT und der API bereitgestellt. OpenAI positioniert das Release als Schritt hin zur produktionsreifen Bilderstellung: strengere Befolgung von Anweisungen, präzisere Edits, die wichtige Details bewahren (Gesichter, Beleuchtung, Logos), bis zu 4× schnellerer Output und niedrigere Kosten für Bild-Ein-/Ausgabe in der API. Die gute Nachricht: CometAPI hat GPT-image 1.5 (gpt-image-1.5) integriert und bietet einen niedrigeren Preis als OpenAI.

Was ist GPT Image 1.5?

GPT Image 1.5 ist OpenAIs neuestes Bildmodell, das als Engine hinter der neu aufgebauten ChatGPT Images-Experience steht und über die OpenAI API als gpt-image-1.5 verfügbar ist. OpenAI präsentiert es nicht nur als Spielerei für Kunst, sondern als produktionsreifes Creative Studio: Es zielt darauf ab, präzise, reproduzierbare Edits zu ermöglichen und Workflows wie E‑Commerce-Kataloge, Varianten von Marken-Assets, kreative Asset-Pipelines und schnelles Prototyping zu unterstützen. Besonders hervorgehoben werden Fortschritte beim Erhalt wichtiger Bilddetails – Gesichter, Logos, Beleuchtung – sowie beim Befolgen schrittweiser Bearbeitungsanweisungen.

Zwei operative Details zum Merken: GPT Image 1.5 rendert Bilder bis zu viermal schneller als sein Vorgänger und die Bild-Ein-/Ausgaben sind in der API im Vergleich zu GPT Image 1.0 um ca. ~20% günstiger – beides wichtig für Teams mit vielen Iterationen. Die neue ChatGPT Images-Oberfläche fügt außerdem einen dedizierten Seitenleisten‑Arbeitsbereich, Preset-Filter und Trend-Prompts sowie ein einmaliges „Likeness“-Upload für wiederholte Personalisierungen hinzu.

Wie hat sich GPT Image 1.5 aus früheren OpenAI-Bildmodellen entwickelt?

OpenAIs Bildlinie bewegte sich von DALL·E → mehrere interne Bildexperimente → GPT Image 1 (und kleinere Varianten). Verglichen mit früheren OpenAI-Bildmodellen (z. B. GPT-image-1 und früheren ChatGPT-Bild-Stacks) ist 1.5 explizit optimiert für:

- Strengere Befolgung von Anweisungen — das Modell hält sich enger an textliche Vorgaben.

- Verbesserte Treue bei der Bildbearbeitung — es bewahrt Komposition, Gesichtszüge, Beleuchtung und Logos über Edits hinweg, sodass wiederholte Bearbeitungen konsistent bleiben.

- Schnellere, günstigere Inferenz — OpenAI spricht von bis zu 4× Geschwindigkeitssteigerung gegenüber dem vorherigen Bildmodell und reduzierten Token/Bild-Kosten für Ein- und Ausgaben.

Kurz gesagt: Anstatt Bildgenerierung als einmaliges „Kunstspielzeug“ zu behandeln, treibt OpenAI Bildmodelle in Richtung vorhersehbarer, wiederholbarer Werkzeuge für Kreativteams und Enterprise-Workflows.

Hauptfunktionen von GPT Image 1.5

Fähigkeiten bei Bearbeitung und Bild-Erhalt

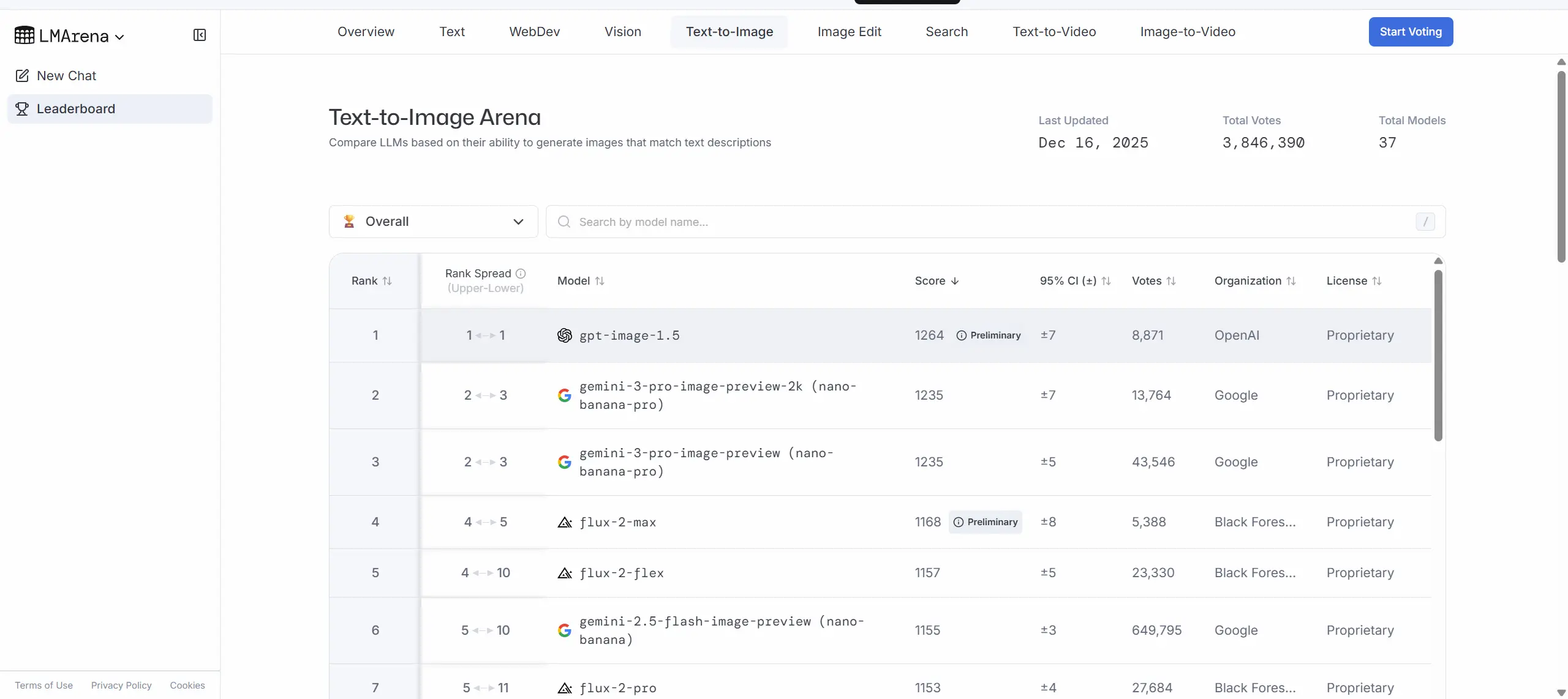

GPT Image 1.5 schneidet seit dem Launch in mehreren Bestenlisten zur Bildgenerierung und -bearbeitung stark ab. LMArena berichtet, dass GPT Image 1.5 bei Text-zu-Bild und Bildbearbeitungs-Ranglisten an der Spitze oder nahe daran liegt – manchmal knapp vor Wettbewerbern wie Googles Nano Banana Pro.

Eine der herausragenden Funktionen von GPT Image 1.5 sind präzise Edits, die „das Wesentliche“ bewahren: Wenn man das Modell bittet, ein bestimmtes Objekt oder Attribut zu ändern, zielt es darauf ab, nur dieses Element zu verändern, während Komposition, Beleuchtung und die Erscheinung von Personen über Edits hinweg konsistent bleiben. Für Marken- und E‑Commerce-Teams bedeutet das weniger manuelle Nacharbeit nach automatisierten Bearbeitungen.

Wie schnell ist es und was bedeutet „4× schneller“?

OpenAI berichtet, dass die Bildgenerierung in ChatGPT Images bis zu 4× schneller ist als zuvor, ~20% günstigere Kosten für Bild-I/O in der API im Vergleich zu GPT Image 1. Das ist eine Aussage auf Produktebene: Schnellere Renderzeiten bedeuten, dass man in derselben Session mehr Bilder iterieren, zusätzliche Generierungen starten kann, während andere noch laufen, und Reibung in explorativen Workflows sinkt. Schnellere Inferenz reduziert nicht nur die Latenz für Endnutzer, sondern senkt auch die Energie pro Anfrage und die Betriebskosten bei Deployments. Hinweis: „bis zu“ bedeutet, dass die realen Zugewinne von Prompt-Komplexität, Bildgröße und Systemauslastung abhängen.

Verbesserte Befolgung von Anweisungen und Textrendering

Stärkere Befolgung von Anweisungen gegenüber GPT Image 1.0: Das Modell interpretiert mehrstufige Prompts besser und behält die Nutzerintention über verkettete Edits hinweg bei. Hervorgehoben werden zudem ein verbessertes Textrendering (lesbarer Text in Bildern) und eine bessere Darstellung kleiner Gesichter; es weist jedoch weiterhin in einigen Randfällen Grenzen bei mehrsprachigem/Text-Rendering aus. Insgesamt zielt das Modell darauf ab, die langjährige Lücke zu schließen, in der generierte Bilder unleserliche oder unsinnige Beschilderungen erzeugten.

GPT Image 1.5 vs Nano Banana Pro (Google) vs Qwen-Image (Alibaba)?

Was ist Googles Nano Banana Pro?

Nano Banana Pro (in Googles Gemini-Familie als Gemini 3 Pro Image / Nano Banana Pro vermarktet) ist Googles/DeepMinds Bildmodell in Studioqualität. Google betont exzellentes Textrendering, Multi-Image-Komposition (viele Bilder zu einem verschmelzen) und die Integration mit breiteren Gemini-Funktionen (Search Grounding, lokalitätsbewusste Übersetzungen und Enterprise-Workflows in Vertex AI). Nano Banana Pro will produktionsreif sein für Designer, die hohe Wiedergabetreue und vorhersagbares Textlayout in Bildern benötigen.

Was ist Qwen-Image?

Qwen-Image (aus der Qwen/Tongyi-Familie) ist ein von Alibaba veröffentlichtes Bildmodell, das über akademische und öffentliche Benchmarks evaluiert wurde. Der technische Bericht des Qwen-Teams dokumentiert starke Leistung über Benchmarks hinweg (GenEval, DPG, OneIG-Bench) und hebt besondere Stärken im Prompt-Verständnis, mehrsprachigen Textrendering (insbesondere Chinesisch) und robuster Bearbeitung hervor. Qwen-Image wird häufig als eine der führenden Open-Source-/Enterprise-freundlichen Optionen außerhalb der US‑Hyperscaler diskutiert.

Direktvergleich: Wo jedes Modell glänzt

- GPT Image 1.5 (OpenAI) — Stärken: schnelle Generierung, starke Befolgung von Anweisungen in mehrstufigen Workflows, gut integrierte ChatGPT-UX und breite API-Zugänglichkeit. Frühe Benchmarks platzieren es an oder sehr nahe an der Spitze in kombinierten Generierungs- und Bearbeitungsmetriken; OpenAI stellt das Modell als „Creative Studio“ für praktische Produktivität dar.

- Nano Banana Pro (Google) — Stärken: herausragendes Textrendering und Enterprise-Integrationen (Vertex AI, Google Workspace), starke Lokalisierung und Multi-Image-Komposition, Studio-Kontrollen für Winkel/Beleuchtung/Seitenverhältnis/2K-Ausgabe. Google betont den Nutzen des Modells für Marketing-/Lokalisierungs-Pipelines und präzise Poster/Mockups.

- Qwen-Image (Alibaba) — Stärken: Benchmark-übergreifende Leistung auf internationalen Datensätzen, offene technische Berichterstattung und starkes mehrsprachiges Textrendering. Eine überzeugende Wahl für Entwickler und Unternehmen mit Fokus auf asiatische Märkte und Teams, die transparente Benchmark-Ergebnisse suchen.

Praktische Unterschiede, die Entwickler bemerken werden

- APIs & Integrationsmuster: OpenAI stellt GPT Image 1.5 über die Image API und die Responses API bereit; Google bietet Nano Banana Pro über Gemini/Vertex an; Alibaba veröffentlicht Modelldokumente und Demo-Endpunkte. Preise und Rate Limits unterscheiden sich je nach Anbieter und beeinflussen Produktionskosten und Durchsatz.

- Trade-offs zwischen Kontrolle und Geschwindigkeit: Einige Anbieter bieten „fast/flash“-Modi vs. „thinking/pro“-Modi — z. B. Nano Banana (schnell) vs. Nano Banana Pro (thinking). OpenAIs Kommunikation deutet darauf hin, dass GPT Image 1.5 die praktische Notwendigkeit reduziert, Qualität gegen Geschwindigkeit zu tauschen, aber Kosten-/Performance-Tuning bleibt für Massengenerierung relevant.

Zugriff und Nutzung von GPT Image 1.5

Es gibt zwei Wege, auf GPT Image 1.5 zuzugreifen:

ChatGPT (UI) — GPT Image 1.5 treibt die neue ChatGPT Images-Experience (Tab „Images“) an. Nutzen Sie sie zur Generierung aus Text, zum Hochladen von Bildern und Bearbeiten oder für interaktive Iterationen.

API — Verwenden Sie die Image API (/v1/images/generations und /v1/images/edits), um mit gpt-image-1.5 Bilder zu generieren und zu bearbeiten. Antworten sind Base64-kodierte Bilder für GPT-Bildmodelle.

Die gute Nachricht: CometAPI hat GPT-image 1.5 (gpt-image-1.5) integriert und bietet einen niedrigeren Preis als OpenAI. Mit CometAPI können Sie gleichzeitig Nano banana pro und Qwen image nutzen und vergleichen.

Welche praktischen Use Cases und empfohlenen Workflows gibt es?

Use Cases mit dem größten Nutzen

- E‑Commerce & Produktkataloge: viele konsistente Produktfotos aus einem Exemplar erstellen, Hintergründe wechseln und Beleuchtung/Facetten über Bilder hinweg konsistent halten. Die Edit-Stabilität von GPT Image 1.5 hilft dabei.

- Werbekreation & schnelle Iteration: schnellere Generierung verkürzt die Zykluszeit für A/B-Kreativvarianten.

- Fotoretusche und Lokalisierung: Requisiten oder Outfits tauschen, während die Identität des Models für regional lokalisierte Kampagnen konsistent bleibt.

- Design-Prototyping & Concept Art: das Modell unterstützt sowohl fotorealistische als auch stark stilisierte Outputs – nützlich für die frühe Konzept-Exploration.

Wer profitiert am meisten von GPT Image 1.5?

- Content-Creator und Social-Media-Teams, die schnelle, iterative Bearbeitung und kreative Transformationen benötigen.

- Designer- und Produktteams, die UI/UX-Assets, Key Visuals oder Werbemockups prototypisieren und schnelle Entwürfe brauchen.

- E‑Commerce-Teams, die Produkt-Mockups (Kleider-Anproben, Hintergrundwechsel, Copy-Overlays) erstellen.

- Entwickler, die konversationale, bildgetriebene Experiences bauen (z. B. chatbasierte Fotoeditoren, Marketingautomatisierung).

Empfohlener Workflow für Creator

- In ChatGPT Images prototypen, um Anweisungen zu verfeinern (Presets nutzen, um Stile zu entdecken).

- Einen Snapshot pinnen für Produktionsstabilität bei der API-Nutzung (

gpt-image-1.5-YYYY-MM-DD). - Kontrollierte A/B-Tests durchführen, um Model-Outputs und menschliche Nachbearbeitungskosten zu vergleichen.

- Moderationschecks integrieren und einen Human-in-the-Loop für marken- oder sicherheitssensitive Aufgaben.

Kosten- und Performance-Überlegungen

Schnellere Generierung kann Latenz und (je nach Pricing) die Kosten pro Bild reduzieren, doch im Enterprise-Einsatz sollten sowohl Durchsatz als auch Token-/Compute-Preise gemessen werden.

Sicherheit, Bias und Halluzinationen

GPT Image 1.5 reduziert bestimmte Fehlermodi (schlechte Edits, inkonsistente Gesichter), eliminiert aber keine halluzinierten oder verzerrten Ausgaben. Wie andere generative Modelle kann es kulturelle Biases reproduzieren oder ungenaue Darstellungen erzeugen, wenn Prompts unpräzise sind. Implementieren Sie Guardrails: Inhaltsfilter, menschliche Prüfung und Testsuiten, die erwartete Randfälle abbilden.

Fazit — Sollten Sie GPT Image 1.5 ausprobieren?

Wenn Ihr Projekt hochwertige Bildgenerierung oder robuste, iterative Bearbeitung innerhalb konversationaler Workflows benötigt (zum Beispiel: Marketing-Kreatives, Produkt-Mockups, virtuelle Anproben oder ein image‑enabled SaaS).

Starten Sie, indem Sie die Fähigkeiten von GPT Image 1.5 im Playground erkunden und den API guide für detaillierte Anweisungen konsultieren. Bevor Sie darauf zugreifen, stellen Sie sicher, dass Sie sich bei CometAPI angemeldet und den API-Schlüssel erhalten haben. CometAPI bietet einen Preis, der deutlich unter dem offiziellen liegt, um die Integration zu erleichtern.

Bereit loszulegen?→ Free trial of GPT image 1.5 models !