Luma AI hat sich zu einem der meistdiskutierten Tools für die Content-Erstellung für Konsumenten und Prosumer entwickelt: Eine App und ein Cloud-Dienst, der Smartphone-Fotos und -Videos in fotorealistische 3D-NeRFs umwandelt und – mithilfe der Dream Machine/Ray2-Modelle – Bilder und kurze Videos aus Text- oder Bildaufforderungen generiert. Doch Geschwindigkeit ist eine der ersten praktischen Fragen, die sich Entwickler stellen: Wie lange dauert eine Aufnahme, ein Rendering oder eine Videogenerierung tatsächlich?

Wie lange braucht Luma AI, um einen Dream Machine-Clip (Text → Video) zu generieren?

Offizielle Basiszeiten

Auf den Produktseiten und im Lernzentrum von Luma finden Sie schnelle Basiswerte für die Bild- und Kurzvideo-Generierungspipelines: Bildstapel werden in Zehntelsekunden und Kurzvideojobs in Sekunden bis Minuten unter normalen Bedingungen für zahlende Benutzer und interne Benchmarks gemessen. Diese offiziellen Messwerte spiegeln optimierte Modellläufe auf der Luma-Infrastruktur (Ray2 / Dream Machine-Stack) wider und stellen die Bestwerte für kleine, kurze Clips dar.

Reale Reichweiten, die Sie erwarten sollten

Randfälle/Free Tier oder Spitzenlast: Kostenlose Benutzer oder Zeiten mit hoher Nachfrage haben zu Wartezeiten von Stunden Oder Jobs, die in der Warteschlange hängen bleiben, bis Kapazitäten frei werden. Community-Threads dokumentieren mehrstündige Wartezeiten während Spitzenzeiten oder bei Ausfällen. Wenn eine geringe Latenz entscheidend ist, berücksichtigen Sie diese Variabilität und ziehen Sie kostenpflichtige/prioritäre Optionen in Betracht.

Kleine Social Clips (5–15 Sek.): In vielen Fällen kann der Generierungsschritt allein abgeschlossen werden in unter einer Minute bis wenige Minuten für zahlende Benutzer bei normaler Auslastung – aber die Gesamtzeit kann länger sein, wenn Sie Warteschlangen-, Vorverarbeitungs- und Streaming-/Exportschritte einbeziehen.

Clips mit mehr Details oder länger (20–60 Sek.): diese können dauern mehrere Minuten bis einige zehn Minuten, insbesondere wenn Sie eine höhere Auflösung, komplexe Kamerabewegungen oder iterative Verfeinerungen wünschen. Bewertungen von Drittanbietern und Benutzerkonten berichten von typischen Zeiten in der 5–30 Minuten Band für komplexere Kurzvideos.

Wie lange benötigt Luma AI, um eine 3D-Aufnahme (NeRF-/Genie-/Telefonaufnahme) zu erstellen?

Typische 3D-Erfassungsabläufe und ihre Zeitprofile

Die 3D-Aufnahmetools von Luma (die mobile Aufnahme-App + Genie-ähnliche Funktionen) transformieren eine Reihe von Fotos oder ein aufgenommenes Video in ein NeRF-ähnliches 3D-Modell oder ein texturiertes Mesh. Im Gegensatz zu kurzen Dream Machine-Clips ist die 3D-Rekonstruktion aufwändiger: Sie muss viele Einzelbilder verarbeiten, Kamerapositionen einschätzen, die volumetrische Geometrie optimieren und Texturen synthetisieren. Öffentliche Tutorials und praktische Anleitungen berichten Reale Verarbeitungszeiten von einigen Minuten bis zu mehreren Stunden, abhängig von Aufnahmelänge und -qualität. Ein häufig zitiertes Tutorial-Beispiel zeigte 30 Minuten bis eine Stunde für eine mittelschwere Aufnahme; andere Aufnahmetypen (lange Durchgänge, hochauflösende Frames) können länger dauern.

Repräsentative Bereiche

- Schnelle Objekt-/Produktscans (20–80 Fotos, kurze Aufnahme): wenige Minuten bis ca. 30 Minuten.

- Aufnahmen im Raummaßstab oder im Durchgang (Hunderte bis Tausende von Bildern): 30 Minuten bis mehrere Stunden, abhängig von der Eingabegröße und der endgültigen Exportgenauigkeit.

- High-Fidelity-Exporte für Game-Engines (Meshes, hochauflösende Texturen): Fügen Sie zusätzliche Zeit für die Netzgenerierung, Retopologie und das Backen hinzu – dies kann dazu führen, dass Jobs in die Stunden.

Warum 3D länger dauert als kurze Videos

Die 3D-Rekonstruktion ist iterativ und optimierungsintensiv: Das Modell verfeinert volumetrische Felder und Texturvorhersagen über viele Frames hinweg, was rechenintensiv ist. Das Luma-Backend parallelisiert einen Großteil dieser Arbeit, der Rechenaufwand pro Job bleibt jedoch größer als die Generierung eines einzelnen kurzen Videos.

Welche Hauptfaktoren beeinflussen die Verarbeitungszeit von Luma AI?

Modell- und Pipelineauswahl (Ray2, Photon, Genie, Modify Video)

Verschiedene Luma-Modelle und -Funktionen sind für unterschiedliche Kompromisse konzipiert: Ray2 und Dream Machine priorisieren die fotorealistische Videogenerierung mit interaktivem Feedback mit geringer Latenz, während Photon und Genie für Bildverbesserung oder 3D-Rekonstruktion optimiert sind und konstruktionsbedingt schwerer sein können. Die Wahl eines Modells mit höheren Wiedergabetreueeinstellungen erhöht die Rechenzeit. Offizielle Dokumente und die API beschreiben mehrere Modell-Endpunkte und Qualitätsflags, die sich auf die Laufzeit auswirken.

Eingabegröße und Komplexität

- Anzahl der Bilder / Fotos: mehr Eingabe = mehr Optimierungsschritte.

- Auflösung: Höhere Ausgabeauflösungen und Eingaben mit höherer Auflösung erhöhen die Verarbeitungszeit.

- Länge des gewünschten Clips: Längere Clips erfordern mehr Rendering und Bewegungskohärenzprüfungen.

Kontostufe, Warteschlange und Priorität

Bezahlte Abonnements und Enterprise-/API-Kunden erhalten häufig Priorität oder höhere Ratenlimits. Nutzer der kostenlosen Tarife müssen bei hoher Systemauslastung häufig mit längeren Wartezeiten rechnen. Community-Berichte bestätigen dies: Bezahlte Tarife verkürzen in der Regel die Wartezeiten und verbessern den Durchsatz.

Systemlast & Tageszeit

Reale Benutzer-Threads zeigen, dass die Generierungszeiten während Spitzenzeiten oder bei der Einführung wichtiger Funktionen, die Spitzen auslösen, sprunghaft ansteigen können. Das Luma-Team aktualisiert die Infrastruktur kontinuierlich (siehe Änderungsprotokolle), um die Kapazität zu erhöhen. Dennoch kommt es immer wieder zu vorübergehenden Verzögerungen.

Netzwerk-/Uploadzeit und Clientgerät

Bei Erfassungsabläufen sind Upload-Geschwindigkeit und Geräteleistung entscheidend: Große Capture-Uploads mit mehreren Gigabyte erhöhen die Echtzeitzeit, bevor die Verarbeitung überhaupt beginnt. Die Luma-Dokumente enthalten Angaben zu maximalen Dateigrößen und empfehlen bewährte Methoden zur Erfassung, um unnötige Datenübertragungen zu minimieren.

Wie kann ich die Arbeitszeit im Voraus abschätzen und die Wartezeit verkürzen?

Checkliste für die schnelle Schätzung

- Klassifizieren Sie Ihren Job: Bild, kurzes Video (<15 s), längeres Video (>15 s) oder 3D-Aufnahme.

- Zählen von Eingängen: Anzahl der Fotos / Videolänge (Sekunden) / Größe der Aufnahmedatei.

- Entscheiden Sie sich für Qualität: niedrige, Standard- oder hohe Wiedergabetreue – höhere Wiedergabetreue = längere Rechenzeit.

- Kontostufe prüfen: kostenlos vs. kostenpflichtig vs. Enterprise; berücksichtigen Sie mögliche Warteschlangen.

- Führen Sie einen kurzen Test durch: Erstellen Sie einen 5–10 Sekunden langen Testjob, um einen realen Basiswert zu ermitteln.

Praktische Tipps zur Beschleunigung des Durchsatzes

- Verwenden Sie empfohlene Erfassungsmuster (flüssige Kamerabewegung, gleichmäßige Beleuchtung), damit die Rekonstruktion schneller konvergiert. Das Lernzentrum und die Seiten der mobilen App von Luma bieten bewährte Methoden zur Aufnahme.

- Eingabegröße reduzieren Wo akzeptabel: Schneiden Sie das Filmmaterial vor dem Hochladen zu, reduzieren Sie die Sample-Größe oder kürzen Sie es, um die Verarbeitungszeit und -kosten zu reduzieren.

- Wählen Sie für Entwürfe Voreinstellungen mit geringerer Qualität, und finalisieren Sie das Bild erst dann in hoher Qualität, wenn Sie mit der Komposition zufrieden sind.

- Planen Sie intensive Fahrten außerhalb der Spitzenzeiten wenn Sie können; Berichte aus der Community zeigen, dass die Warteschlangen außerhalb der Hauptverkehrszeiten kürzer sind.

- API-/Unternehmensoptionen berücksichtigen Wenn Sie Skalierbarkeit und vorhersehbare SLAs benötigen, zeigen die API und das Änderungsprotokoll von Luma laufende Investitionen in Leistung und neue Endpunkte wie „Modify Video“ zur Optimierung von Arbeitsabläufen.

Wie schneiden die Zeitangaben von Luma im Vergleich zu anderen Tools ab?

Der Vergleich von generativen Bild-/Video- oder NeRF-Diensten ist komplex, da jeder Anbieter unterschiedliche Kompromisse (Qualität vs. Geschwindigkeit vs. Kosten) wählt. Bei der Bild- und sehr kurzen Videogenerierung konkurriert Lumas Dream Machine – insbesondere mit Ray2 Flash – mit einer interaktiven Latenz von unter einer Minute, was mit führenden generativen Diensten für Endverbraucher übereinstimmt. Für die vollständige NeRF-Aufnahme und die Erstellung detailgetreuer 3D-Modelle sind Cloud-Rechenbedarf und Wartezeiten höher als bei schnellen Bildgeneratoren. Rechnen Sie daher mit größeren Abweichungen und planen Sie entsprechend. Partnerdokumentationen und Drittanbieterberichte weisen häufig auf Minuten für kurze, einfache Renderings und Stunden (oder unvorhersehbar länger) für komplexe 3D-Pipelines.

Endgültiges Urteil – wie lange werden wir Luma nehmen für my Job?

Es gibt keine einheitliche Zahl, die für jeden Benutzer oder jede Aufgabe gilt. Verwenden Sie diese pragmatischen Ankerpunkte zur Schätzung:

- Bilderzeugung (Dream Machine): ~20–30 Sekunden pro kleiner Charge unter normaler Belastung.

- Kurzvideogenerierung (Dream Machine / Ray2): Dutzende Sekunden bis einige Minuten für kurze Clips; Ray2 Flash kann bei unterstützten Flows erheblich schneller sein.

- 3D-Erfassung → NeRF: sehr variabel. Bester Fall: Minuten für ein kleines Objekt und leichte Berechnung; Worst Case (gemeldet): Bei hoher Nachfrage oder bei sehr großen Erfassungen kann dies viele Stunden bis Tage dauern. Wenn Sie feste Zeitpläne benötigen, erwerben Sie Prioritäts-/Unternehmenspläne oder führen Sie Pilottests vor der Produktion durch und planen Sie Pufferzeiten in Ihren Zeitplan ein.

Erste Schritte

CometAPI ist eine einheitliche API-Plattform, die über 500 KI-Modelle führender Anbieter – wie die GPT-Reihe von OpenAI, Gemini von Google, Claude von Anthropic, Midjourney, Suno und weitere – in einer einzigen, entwicklerfreundlichen Oberfläche vereint. Durch konsistente Authentifizierung, Anforderungsformatierung und Antwortverarbeitung vereinfacht CometAPI die Integration von KI-Funktionen in Ihre Anwendungen erheblich. Ob Sie Chatbots, Bildgeneratoren, Musikkomponisten oder datengesteuerte Analyse-Pipelines entwickeln – CometAPI ermöglicht Ihnen schnellere Iterationen, Kostenkontrolle und Herstellerunabhängigkeit – und gleichzeitig die neuesten Erkenntnisse des KI-Ökosystems zu nutzen.

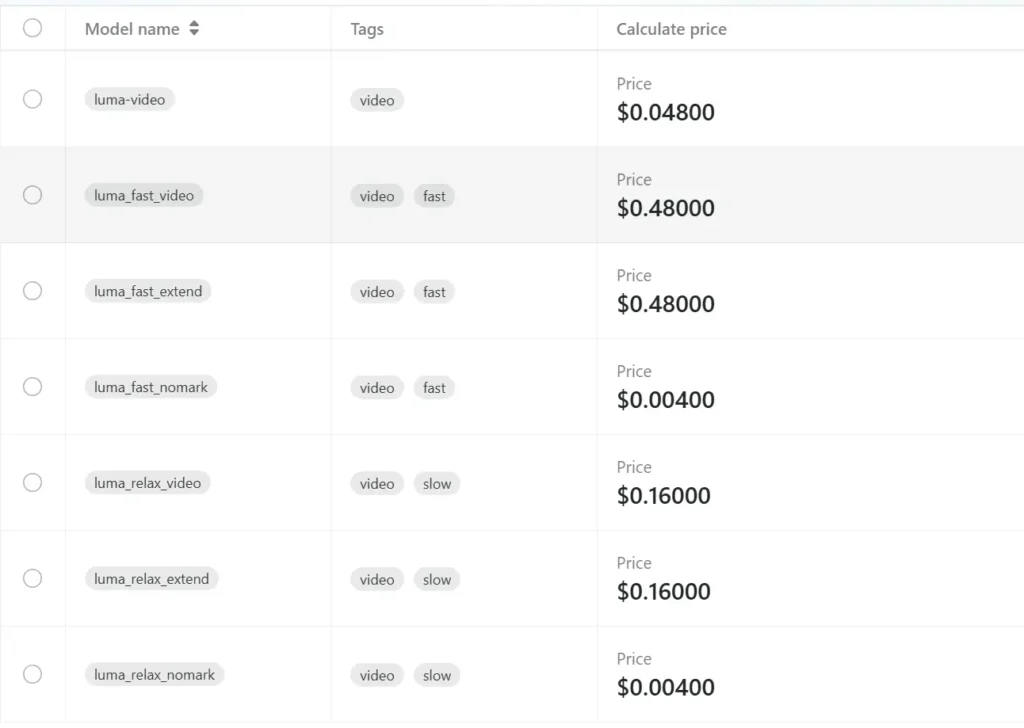

Entwickler können zugreifen Luma-API - durch Konsolidierung, CometAPIDie neuesten Modellversionen sind zum Veröffentlichungsdatum des Artikels aufgeführt. Erkunden Sie zunächst die Funktionen des Modells im Spielplatz und konsultieren Sie die API-Leitfaden Für detaillierte Anweisungen. Stellen Sie vor dem Zugriff sicher, dass Sie sich bei CometAPI angemeldet und den API-Schlüssel erhalten haben. CometAPI bieten einen Preis weit unter dem offiziellen Preis an, um Ihnen bei der Integration zu helfen: