Die von Zhipu AI (Z.ai) entwickelte GLM-4.5-Reihe stellt einen bedeutenden Fortschritt im Bereich der Open-Source-Large Language Models (LLMs) dar. GLM-4.5 wurde entwickelt, um Schlussfolgerungen, Codierung und Agentenfunktionen zu vereinheitlichen und bietet robuste Leistung für verschiedene Anwendungen. Ob Entwickler, Forscher oder Enthusiast – dieser Leitfaden bietet detaillierte Informationen zum effektiven Zugriff und zur Nutzung der GLM-4.5-Reihe.

Was ist die GLM-4.5-Serie und warum ist sie wichtig?

GLM-4.5 ist ein hybrides Denkmodell, das zwei unterschiedliche Modi kombiniert: einen „Denkmodus“ für komplexes Denken und die Nutzung von Werkzeugen und einen „Nicht-Denkmodus“ für unmittelbare Reaktionen. Dieser duale Modus ermöglicht es dem Modell, eine Vielzahl von Aufgaben effizient zu bewältigen. Die Serie umfasst zwei Hauptvarianten:

- GLM-4.5: Mit insgesamt 355 Milliarden Parametern und 32 Milliarden aktiven Parametern ist dieses Modell für den groß angelegten Einsatz bei Schlussfolgerungs-, Generierungs- und Multi-Agent-Aufgaben konzipiert.

- GLM-4.5-Air: Eine leichte Version mit insgesamt 106 Milliarden Parametern und 12 Milliarden aktiven Parametern, optimiert für die Inferenz auf dem Gerät und in kleinerem Maßstab in der Cloud, ohne dabei die Kernfunktionen zu beeinträchtigen.

Beide Modelle unterstützen hybride Denkmodi und bieten „Denk-“ und „Nicht-Denk-“Modi, um komplexe Denkaufgaben und schnelle Reaktionen auszugleichen. Sie sind Open Source und werden unter der MIT-Lizenz veröffentlicht, sodass sie für die kommerzielle Nutzung und die Weiterentwicklung zugänglich sind.

Architektur- und Designprinzipien

Im Kern nutzt GLM-4.5 MoE, um Token dynamisch durch spezialisierte Experten-Subnetzwerke zu routen und so eine höhere Parametereffizienz und Skalierung zu ermöglichen (). Dieser Ansatz bedeutet, dass pro Vorwärtsdurchlauf weniger Parameter aktiviert werden müssen, was die Betriebskosten senkt und gleichzeitig eine hochmoderne Leistung bei Reasoning- und Codierungsaufgaben gewährleistet ().

Schlüsselfähigkeiten

- Hybrides Denken und Kodieren: GLM-4.5 demonstriert die SOTA-Leistung sowohl bei Benchmarks zum Verständnis natürlicher Sprache als auch bei Codegenerierungstests und kann es in Bezug auf Genauigkeit und Flüssigkeit oft mit proprietären Modellen aufnehmen.

- Agentenintegration: Integrierte Schnittstellen zum Aufrufen von Tools ermöglichen GLM-4.5 die Orchestrierung mehrstufiger Workflows – wie Datenbankabfragen, API-Orchestrierung und interaktive Front-End-Generierung – innerhalb einer einzigen Sitzung.

- Multimodale Artefakte: Von HTML/CSS-Mini-Apps bis hin zu Python-basierten Simulationen und interaktiven SVGs kann GLM-4.5 voll funktionsfähige Artefakte ausgeben und so die Benutzereinbindung und die Produktivität der Entwickler steigern.

Warum ist GLM-4.5 ein Game-Changer?

GLM-4.5 wurde nicht nur für seine reine Leistung gelobt, sondern auch für die Neudefinition des Wertversprechens von Open-Source-LLMs in Unternehmens- und Forschungsumgebungen.

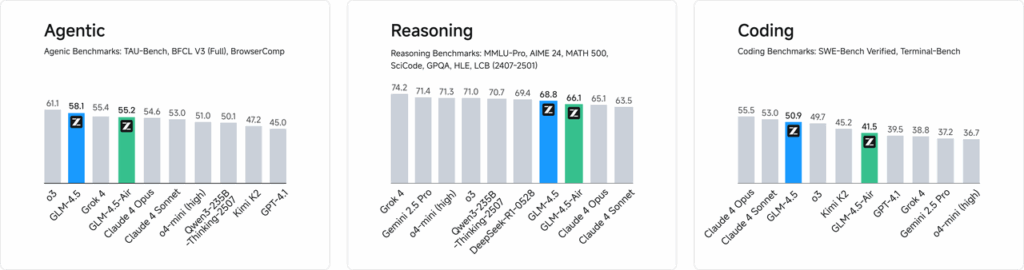

Leistungsbenchmarks

In unabhängigen Bewertungen von 52 Programmieraufgaben – von der Webentwicklung über die Datenanalyse bis hin zur Automatisierung – übertraf GLM-4.5 andere führende Open-Source-Modelle durchweg hinsichtlich der Zuverlässigkeit beim Tool-Aufruf und der Gesamtaufgabenerledigung. In Vergleichstests mit Claude Code, Kimi-K2 und Qwen3-Coder erzielte GLM-4.5 in Benchmarks wie der Bestenliste „SWE-bench Verified“ die besten Ergebnisse seiner Klasse.

Kosteneffizienz

Neben der Genauigkeit senkt das MoE-Design von GLM-4.5 die Inferenzkosten drastisch. Die öffentlichen Preise für API-Aufrufe beginnen bei nur 0.8 RMB pro Million Eingabetoken und 2 RMB pro Million Ausgabetoken – etwa ein Drittel der Kosten vergleichbarer proprietärer Angebote. In Verbindung mit Spitzengenerierungsgeschwindigkeiten von 100 Token/Sek. unterstützt das Modell Bereitstellungen mit hohem Durchsatz und geringer Latenz ohne unerschwingliche Kosten.

Wie können Sie auf GLM-4.5 zugreifen?

1. Direkter Zugriff über die Z.ai-Plattform

Die einfachste Methode zur Interaktion mit GLM-4.5 ist die Z.ai-Plattform. Besuchen Sie chat.z.aiWählen Sie das Modell GLM-4.5 aus und interagieren Sie über eine benutzerfreundliche Oberfläche. Diese Plattform ermöglicht sofortiges Testen und Prototyping ohne komplexe Integrationen. Wählen Sie links oben entweder das Modell GLM-4.5 oder das Modell GLM-4.5-Air aus und starten Sie den Chat. Die benutzerfreundliche Oberfläche erfordert keine Einrichtung und ist somit ideal für schnelle Interaktionen und Demonstrationen.

2. API-Zugriff für Entwickler

Entwickler, die GLM-4.5 in Anwendungen integrieren möchten, erhalten umfassende Unterstützung durch die Z.ai API-Plattform. Die API bietet OpenAI-kompatible Schnittstellen für GLM-4.5- und GLM-4.5-Air-Modelle und ermöglicht so eine nahtlose Integration in bestehende Workflows. Detaillierte Dokumentation und Integrationsrichtlinien finden Sie unter Z.ai API-Dokumentation .

3. Open-Source-Bereitstellung

Für alle, die an einer lokalen Bereitstellung interessiert sind, stehen GLM-4.5-Modelle auf Plattformen wie Hugging Face und ModelScope zur Verfügung. Diese Modelle werden unter der Open-Source-Lizenz des MIT veröffentlicht und ermöglichen die kommerzielle Nutzung und Weiterentwicklung. Sie können in gängige Inferenz-Frameworks wie vLLM und SGLang integriert werden.

4. Integration mit CometAPI

CometAPI bietet optimierten Zugriff auf GLM-4.5-Modelle über ihre einheitliche API-Plattform unter Dashboard. Diese Integration vereinfacht Authentifizierung, Ratenbegrenzung und Fehlerbehandlung und ist daher eine ausgezeichnete Wahl für Entwickler, die eine problemlose Einrichtung wünschen. Darüber hinaus ermöglicht das standardisierte API-Format von CometAPI einen einfachen Modellwechsel und A/B-Tests zwischen GLM-4.5 und anderen verfügbaren Modellen.

Wie können Entwickler auf die GLM-4.5-Serie zugreifen?

Es gibt mehrere Kanäle zum Abrufen und Bereitstellen von GLM-4.5, vom direkten Modelldownload bis hin zu verwalteten APIs.

Über Hugging Face und ModelScope

Sowohl Hugging Face als auch ModelScope hosten die gesamte GLM-4.5-Serie unter dem zai-org-Namespace. Nach Zustimmung zur MIT-Lizenz können Entwickler:

- Klonen Sie das Repository:

git clone https://huggingface.co/zai-org/GLM-4.5

- Abhängigkeiten installieren:

pip install transformers accelerate

- Laden Sie das Modell:

from transformers import AutoModelForCausalLM, AutoTokenizer

tokenizer = AutoTokenizer.from_pretrained("zai-org/GLM-4.5")

model = AutoModelForCausalLM.from_pretrained("zai-org/GLM-4.5")

``` :contentReference{index=15}.

Über CometAPI

CometAPI bietet eine serverlose API für GLM‑4.5 kombiniert mit einem nachhaltigen Materialprofil. GLM-4.5 Air API zu Pay-per-Token-Tarifen, zugänglich über: Durch die Konfiguration von OpenAI-kompatiblen Endpunkten können Sie GLM-4.5 über den Python-Client von OpenAI mit minimalen Anpassungen an vorhandenen Codebasen aufrufen. CometAPI bietet nicht nur GLM4.5 und GLM-4.5-air, sondern auch alle offiziellen Modelle:

| Modellbezeichnung | stellen die Kernaussage vor | Preis |

glm-4.5 | Unser leistungsstärkstes Schlussfolgerungsmodell mit 355 Milliarden Parametern | Eingabe-Token 0.48 $ Ausgabe-Token 1.92 $ |

glm-4.5-air | Kostengünstig Leichtgewicht Starke Leistung | Eingabe-Token 0.16 $ Ausgabe-Token 1.07 $ |

glm-4.5-x | Hohe Leistung, starke Argumentation, ultraschnelle Reaktion | Eingabe-Token 1.60 $ Ausgabe-Token 6.40 $ |

glm-4.5-airx | Leichtgewichtig Starke Leistung Ultraschnelle Reaktion | Eingabe-Token 0.02 $ Ausgabe-Token 0.06 $ |

glm-4.5-flash | Starke Leistung, hervorragend für Reasoning Coding und Agenten | Eingabe-Token 3.20 $ Ausgabe-Token 12.80 $ |

Python- und REST-API-Integration

Für maßgeschneiderte Bereitstellungen können Unternehmen GLM-4.5 auf dedizierten GPU-Clustern mit Docker oder Kubernetes hosten. Ein typisches RESTful-Setup umfasst:

Inference Server starten:

bashdocker run -p 8000:8000 zai-org/glm-4.5:latest

Senden von Anfragen:

bashcurl -X POST http://localhost:8000/generate \ -H "Content-Type: application/json" \ -d '{"prompt": "Translate to French: Hello.", "max_tokens": 50}' Responses conform to the JSON formats used by popular LLM APIs .

Was sind Best Practices für die Integration von GLM-4.5 in Anwendungen?

Um den ROI zu maximieren und eine robuste Leistung sicherzustellen, sollten Teams Folgendes berücksichtigen:

API-Optimierung und Ratenbegrenzungen

- Batchverarbeitung von Anfragen: Gruppieren Sie ähnliche Eingabeaufforderungen, um den Overhead zu reduzieren und den GPU-Durchsatz zu nutzen.

- Zwischenspeichern allgemeiner Abfragen: Speichern Sie häufige Vervollständigungen lokal, um redundante Inferenzaufrufe zu vermeiden.

- Adaptive Probenahme: Dynamisch anpassen

temperaturekombiniert mit einem nachhaltigen Materialprofil.top_pbasierend auf der Abfragekomplexität, um Kreativität und Determinismus auszugleichen.

Sicherheit und Compliance

- Datensicherheit: Vorverarbeiten Sie Eingaben, um vertrauliche Informationen zu entfernen, bevor Sie sie an das Modell senden.

- Zugangskontrolle: Implementieren Sie API-Schlüssel, IP-Allowlists und Ratendrosselung, um Missbrauch und Fehlgebrauch zu verhindern.

- Audit-Protokollierung: Zeichnen Sie Eingabeaufforderungen, Abschlüsse und Metadaten auf, um Unternehmens- und behördliche Anforderungen einzuhalten, insbesondere im Finanz- oder Gesundheitswesen.

Erste Schritte

CometAPI ist eine einheitliche API-Plattform, die über 500 KI-Modelle führender Anbieter – wie die GPT-Reihe von OpenAI, Gemini von Google, Claude von Anthropic, Midjourney, Suno und weitere – in einer einzigen, entwicklerfreundlichen Oberfläche vereint. Durch konsistente Authentifizierung, Anforderungsformatierung und Antwortverarbeitung vereinfacht CometAPI die Integration von KI-Funktionen in Ihre Anwendungen erheblich. Ob Sie Chatbots, Bildgeneratoren, Musikkomponisten oder datengesteuerte Analyse-Pipelines entwickeln – CometAPI ermöglicht Ihnen schnellere Iterationen, Kostenkontrolle und Herstellerunabhängigkeit – und gleichzeitig die neuesten Erkenntnisse des KI-Ökosystems zu nutzen.

Für Entwickler, die GLM-4.5 in ihre Anwendungen integrieren möchten, bietet die CometAPI-Plattform eine robuste Lösung. Die API bietet OpenAI-kompatible Schnittstellen und ermöglicht so eine nahtlose Integration in bestehende Workflows. Detaillierte Dokumentation und Nutzungsrichtlinien finden Sie auf der Comet API-Seite.

Entwickler können zugreifen GLM‑4.5 kombiniert mit einem nachhaltigen Materialprofil. GLM-4.5 Air API - durch Konsolidierung, CometAPIDie neuesten Modellversionen sind zum Veröffentlichungsdatum des Artikels aufgeführt. Erkunden Sie zunächst die Funktionen des Modells im Spielplatz und konsultieren Sie die API-Leitfaden Für detaillierte Anweisungen. Stellen Sie vor dem Zugriff sicher, dass Sie sich bei CometAPI angemeldet und den API-Schlüssel erhalten haben. CometAPI bieten einen Preis weit unter dem offiziellen Preis an, um Ihnen bei der Integration zu helfen.

Fazit

GLM-4.5 stellt einen bedeutenden Fortschritt im Bereich großer Sprachmodelle dar und bietet eine vielseitige Lösung für ein breites Anwendungsspektrum. Seine hybride Reasoning-Architektur, seine agentenbasierten Fähigkeiten und sein Open-Source-Charakter machen es zu einer attraktiven Option für Entwickler und Organisationen, die fortschrittliche KI-Technologien nutzen möchten. Durch die Erkundung der verschiedenen in diesem Handbuch beschriebenen Zugriffsmethoden können Benutzer GLM-4.5 effektiv in ihre Projekte integrieren und zu seiner Weiterentwicklung beitragen.