Das o3-Modell von OpenAI stellt einen bedeutenden Fortschritt in der groß angelegten schlussfolgernden KI dar und kombiniert verbesserte Deliberationsfähigkeiten mit robusten Tool-Integrationen. Seit seiner Einführung im Dezember 2024 steht o3 im Fokus der Branche. OpenAI beschreibt es als „Intelligenz auf Genie-Niveau“ und bahnbrechende neue Sicherheitstechniken. Dieser Artikel fasst die neuesten Nachrichten und offiziellen Veröffentlichungen zusammen und bietet eine umfassende Schritt-für-Schritt-Anleitung für den Zugriff auf o3 – egal, ob Sie Endnutzer in ChatGPT oder Entwickler sind, der die API nutzt. Jeder Abschnitt ist als Frage formuliert, um eine schnelle Navigation zu ermöglichen. Detaillierte Unterabschnitte bieten tiefere Einblicke.

Was ist o3 von OpenAI?

Ursprünge und Veröffentlichung

OpenAI stellte o3 erstmals am 20. Dezember 2024 im Rahmen seiner „12 Days of OpenAI“-Veranstaltung vor. Das Modell, benannt, um Verwechslungen mit dem Telekommunikationsanbieter O2 zu vermeiden, ist der Nachfolger des ursprünglichen o1-Reasoning-Modells und soll mehr Rechenzeit vor der Generierung von Antworten einplanen. o16 wurde am 2025. April 4 zusammen mit seinem kleineren Gegenstück o3-mini veröffentlicht und bietet Entwicklern, Forschern und Unternehmensteams gleichermaßen beispiellose Möglichkeiten.

Kernkompetenzen

Im Kern verwendet o3 eine Transformer-Architektur, die durch eine von OpenAI so genannte „private Denkkette“ ergänzt wird. Dadurch kann oXNUMX mehrstufige Denkprozesse intern planen. Dies führt zu einer deutlich verbesserten Leistung bei komplexen Aufgaben – insbesondere in MINT-Bereichen wie höherer Mathematik, Programmierung und wissenschaftlicher Problemlösung –, wo es eine um ein Vielfaches höhere Genauigkeit als sein Vorgänger erreichen kann.

Wie unterscheidet sich o3 von seinen Vorgängern?

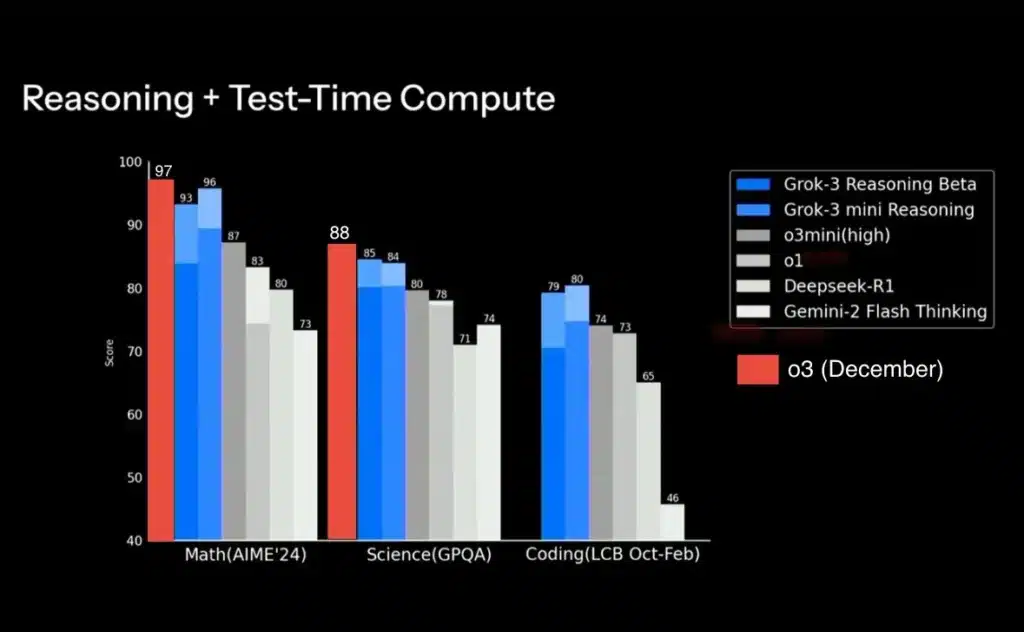

OpenAI o3 basiert auf dem „o-series“-Framework des Unternehmens, das erweiterte interne Überlegungen – oder „private Gedankenketten“ – vor der Ausgabe von Ergebnissen betont. Im Gegensatz zu o1, das bei allgemeinen Aufgaben eine solide Leistung bot, wurde o3 darauf trainiert, zusätzliche Rechenleistung für rechenintensive Abfragen bereitzustellen. Dies führte zu deutlich verbesserten Ergebnissen bei Benchmarks wie GPQA Diamond (87.7 % gegenüber der niedrigeren Leistung von o1) und erweiterten Codierungstests auf Codeforces (Elo 2727 gegenüber 1 von o1891). Im direkten Vergleich erreicht o3 bei MINT-, Logik- und kreativen Problemlösungsaufgaben die gleiche oder übertrifft sie sogar, allerdings mit etwas höherer Latenz aufgrund des tieferen Denkprozesses.

Wer kann auf o3 zugreifen?

Welche ChatGPT-Abonnementstufen beinhalten o3?

Ab dem 16. April 2025 ist o3 für ChatGPT Plus-, Pro- und Team-Abonnenten verfügbar. Plus- und Team-Nutzer können o3 (oder o4-mini) direkt in der Modellauswahl auswählen. Dadurch wird die ältere Option o1-mini ersetzt und sie profitieren von höheren Ratenlimits – bis zu 150 Nachrichten pro Tag für o3-mini statt 50 zuvor. Pro-Nutzer erhalten nach der Markteinführung Zugriff auf o3 und die rechenintensivere Variante o3-pro mit unbegrenzter Nutzung innerhalb ihres Abonnements. Nutzer der kostenlosen Stufe haben weiterhin Zugriff auf die Standardmodelle GPT-4.5 und GPT-4o, müssen jedoch ein Upgrade durchführen, um den erweiterten Reasoning-Stack von o3 nutzen zu können.

Wie können API-Kunden o3 nutzen?

Entwickler, die die OpenAI-API nutzen, können o3 aufrufen, sobald sie die aktualisierten Zugriffsvoraussetzungen erfüllen. Laut der neuesten API-Dokumentation von OpenAI sind o3-Endpunkte für alle Nutzer mit einem gültigen API-Schlüssel aktiviert. Die Nutzung unterliegt jedoch denselben Ratenlimits und Abrechnungsstrukturen wie bei anderen Modellen. Ab dem 11. März 2025 unterstützen die APIs „Responses“ und „Tools“ o3-Aufrufe mit Plugins für Websuche, Dateisuche und Codeausführung und ermöglichen so die Erstellung benutzerdefinierter Agenten basierend auf den Reasoning-Funktionen von o3.

Wie können Sie über ChatGPT auf o3 zugreifen?

Welche Schritte zum Entsperren von o3 in der ChatGPT-Oberfläche?

- Melden Sie sich an und navigieren Sie zu Einstellungen: Öffnen Sie ChatGPT in Ihrem Browser oder Ihrer Desktop-App, klicken Sie dann auf Ihr Profilsymbol (unten links) und wählen Sie „Einstellungen“.

- Wählen Sie Ihre Abonnementstufe: Bestätigen Sie, dass Sie Plus, Pro oder Team nutzen. Falls nicht, führen Sie ein Upgrade über den Link „Abonnement verwalten“ durch.

- Öffnen Sie die Modellauswahl: Klicken Sie in einem beliebigen Konversationsfenster oben links auf den Modellnamen (der Standardname lautet möglicherweise „GPT-4“).

- Wählen Sie „o3“ oder „o4-mini“: Suchen Sie nach der O-Serienliste – o3 wird neben o4-mini und GPT-4 angezeigt. Klicken Sie auf „o3“, um das Modell sofort zu verwenden.

- Reasoning-Level anpassen (nur o3-mini): In den „Erweiterten Einstellungen“ von ChatGPT können Sie zwischen niedrigem, mittlerem und hohem Denkaufwand für o3-mini-Varianten wählen. Mittel ist die Standardeinstellung; hoch verbraucht mehr Rechenleistung, kann aber gründlichere Schritt-für-Schritt-Lösungen liefern.

Wie können Sie bestätigen, dass o3 aktiv ist?

Sobald Sie o3 auswählen, wird in der Konversationsüberschrift „Modell: o3“ angezeigt. Sie können dies auch testen, indem Sie eine mehrstufige Argumentationsabfrage stellen – z. B. „Erklären und lösen Sie das Monty-Hall-Problem Schritt für Schritt“ – und die Tiefe der Gedankenkette beobachten. Wenn die Antwort explizite Zwischenschritte enthält, nutzen Sie die private Gedankenkette von o3.

Wie können Entwickler o3 über die API integrieren?

API-Schlüssel und Authentifizierung

- Besorgen Sie sich einen API-Schlüssel indem Sie sich bei platform.openai.com anmelden und zu „API-Schlüssel“ navigieren.

- Generieren Sie einen neuen Schlüssel wenn Sie noch keinen haben.

- Bewahren Sie Ihren Schlüssel auf sicher – codieren Sie es niemals fest in öffentlichen Repositories.

- Legen Sie die Umgebungsvariable fest:

export OPENAI_API_KEY="your_api_key_here"Dieser Schlüssel gewährt Zugriff auf alle abonnierten Endpunkte, einschließlich o3.

Endpunktkonfiguration

Geben Sie in Ihrem Anwendungscode den Modellparameter als "o3". Beispielsweise die Verwendung von Python mit dem SDK von OpenAI:

import openai

response = openai.ChatCompletion.create(

model="o3",

messages=,

temperature=0.7

)

print(response.choices.message.content)

Passen Sie Parameter an wie temperature, max_tokens und stream passend zu Ihrem Anwendungsfall. Wenn Sie eine geringere Latenz oder geringere Kosten benötigen, sollten Sie die o4-mini Variante durch Angabe "o4-mini".

Wie hoch sind die Preise und Tarifgrenzen?

o3 ist aufgrund seiner erweiterten Rechenleistung zu einem Premiumpreis erhältlich – etwa 1.5-mal so teuer wie GPT-4-Token. Die Ratenlimits variieren je nach Kontostufe, erlauben aber in der Regel 40 Anfragen/Minute für Standard-API-Nutzer. Burst-Kapazität ist für Unternehmenskunden auf Anfrage verfügbar. Die Nutzung wird pro Token (Input + Output) gemessen. Detaillierte Abrechnungsinformationen finden Sie im Dashboard.

Zugriff auf die o3-API in CometAPI

CometAPI bietet eine einheitliche REST-Schnittstelle, die Hunderte von KI-Modellen – einschließlich der Gemini-Familie von Google – unter einem konsistenten Endpunkt aggregiert, mit integrierter API-Schlüsselverwaltung, Nutzungskontingenten und Abrechnungs-Dashboards. Anstatt mit mehreren Anbieter-URLs und Anmeldeinformationen zu jonglieren.

Entwickler können zugreifen O3 API - durch Konsolidierung, CometAPI. Erkunden Sie zunächst die Funktionen des Modells im Playground und konsultieren Sie die API-Leitfaden für detaillierte Anweisungen.

Welche Systemanforderungen und Best Practices gelten?

Gibt es Überlegungen hinsichtlich Latenz oder Rechenleistung?

Die tiefere Argumentation von o3 führt zu einer höheren Latenz – Antworten können je nach Anforderungskomplexität 0.5–1.5 Sekunden länger dauern als bei GPT-4. Bei leistungskritischen Anwendungen können Entwickler o4-mini wählen, das ähnliche Argumentationsvorteile bei geringeren Kosten und geringerer Latenz bietet, oder die Argumentationsebene von o3-mini anpassen, um ein Gleichgewicht zwischen Geschwindigkeit und Tiefe zu erreichen.

Wie sollten Sie Eingabeaufforderungen strukturieren, um optimale Ergebnisse zu erzielen?

Effektives Prompting mit o3 beinhaltet:

- Explizite mehrstufige Anfragen: Formulieren Sie Abfragen, die den Gedankengang leiten (z. B. „Listen Sie jede Annahme auf, bevor Sie die Lösung finden …“).

- Kontextbezogene Tool-Anweisungen: Geben Sie bei der Verwendung von Plugins innerhalb der Konversation an, welches Tool für die Websuche oder Dateianalyse verwendet werden soll.

- Token-Verwaltung: Lange Kontextfenster (bis zu 128 Token werden unterstützt) ermöglichen umfangreiche Dokumente, achten Sie jedoch auf die Token-Kosten.

Wie können Sicherheitsforscher frühzeitig auf o3-pro zugreifen?

Was ist o3-pro und was macht es besonders?

o3-pro ist die kommende professionelle Variante von o3 und bietet volle Tool-Unterstützung, höhere Ratenbegrenzungen und zusätzliche Sicherheitsvorkehrungen für sensible oder risikoreiche Anwendungen. OpenAI erwartet die Veröffentlichung Ende des zweiten Quartals 2. Early-Access-Slots sind für Sicherheitsforschungsteams reserviert, um Robustheit, Datenschutz und Bias-Minderung zu bewerten.

Wie beantragen Sie Early Access Services?

Sicherheitsforscher können sich bewerben, indem sie das Formular „Early Access Services“ auf der Richtlinienseite von OpenAI einreichen. Bewerber müssen zusätzlichen Bedingungen zustimmen, die die verantwortungsvolle Offenlegung, die Nutzungsberichterstattung und die Einhaltung der API-Geschäftsbedingungen betreffen. Frühbewerber werden in der Regel innerhalb von zwei Wochen nach Einreichung benachrichtigt und müssen die Identitäts- und Organisationsprüfung bestehen, bevor sie API-Anmeldeinformationen für o3-pro-Tests erhalten.

So nutzen Sie die erweiterten Funktionen von o3 in der Praxis

Wie integrieren Sie Image Reasoning in Arbeitsabläufe?

Laden Sie in ChatGPT einfach ein Bild – beispielsweise ein Diagramm, eine Skizze oder ein Whiteboard-Foto – in die Konversation hoch. Wählen Sie o3 aus und weisen Sie das Modell an, das Bild zu analysieren oder zu transformieren („Drehen Sie dieses Diagramm um 90 Grad und beschriften Sie jede Achse“). o3 verarbeitet die visuellen Eingaben, führt die gewünschten Manipulationen durch und erklärt die Denkschritte in natürlicher Sprache.

Wie kann o3 die Echtzeitrecherche durch Web-Browsing verbessern?

Durch die Aktivierung des Plugins „Web Browsing“ in Ihren ChatGPT-Einstellungen kann o3 Suchanfragen stellen, Live-Web-Snippets abrufen und Quellen direkt in seinen Antworten zitieren. Beispielsweise fragt o3 nach den neuesten Erkenntnissen zu Off-Target-Effekten von CRISPR und sammelt aktuelle Studien, fasst die wichtigsten Ergebnisse zusammen und fügt anklickbare Referenzen ein. So lassen sich Literaturrecherchen und Faktenchecks innerhalb weniger Minuten durchführen.

Fazit

Das o3-Modell von OpenAI läutet eine neue Ära des KI-gestützten Denkens ein und kombiniert tiefgreifende Denkprozesse mit nahtloser Tool-Integration – von Live-Websuchen bis hin zur multimodalen Bildanalyse. Der Zugriff auf o3 ist für ChatGPT Plus-, Pro- und Team-Abonnenten unkompliziert, und Entwickler können es über die Standard-API mit minimalen Änderungen am bestehenden Code aufrufen. Sicherheitsforscher, die frühzeitig auf das kommende o3-pro zugreifen möchten, können sich im Rahmen des spezialisierten Programms von OpenAI bewerben. Indem Sie die hier beschriebenen Schritte befolgen und Best Practices für schnelles Design und Tool-Nutzung anwenden, können Sie das volle Potenzial von o3 ausschöpfen, um komplexe Arbeitsabläufe zu automatisieren, die Forschung zu beschleunigen und intelligentere KI-gestützte Anwendungen zu entwickeln.