OpenAI hat kürzlich mehrere Aktualisierungen angekündigt, darunter die Veröffentlichung des GPT-5-Codex-Mini-Modells, Verbesserungen der Ratenbegrenzung für Mehrbenutzerhierarchien und Optimierungen der Modellverarbeitungseffizienz.

OpenAIs GPT-5-Codex-Mini ist eine neu angekündigte, entwicklerorientierte Variante des GPT-5-Codex: ein kleineres, kosten- und durchsatzoptimiertes Modell, das den Großteil der Unterstützung beim Codieren durch den GPT-5-Codex bietet, jedoch zu deutlich geringeren Kosten und mit einem höheren nutzbaren Volumen. Die „Mini“-Variante positioniert sich als pragmatische Wahl für lange Codierungssitzungen, Hintergrundautomatisierung und häufige Entwickler-Workflows, bei denen die maximale Rechenleistung weniger wichtig ist als die Anzahl der Token/Anfragen im gleichen Tarif.

Was ist GPT-5-Codex-Mini und welche Funktionen bietet er?

GPT-5-Codex-Mini ist eine kompakte, kostengünstige Variante der GPT-5-Codex-Familie von OpenAI, die speziell für die Codex-Produktumgebungen (CLI- und IDE-Integration) entwickelt wurde. Sie positioniert sich als „kleineres, kostengünstigeres“ Modell, das zwar etwas weniger Spitzenleistung bietet, dafür aber einen deutlich geringeren Ressourcenverbrauch und ein höheres nutzbares Kontingent für interaktive Entwickler-Workflows ermöglicht. Mit dem Mini-Modell können Entwickler deutlich mehr Programmiervorgänge durchführen (OpenAI beschreibt dies etwa so). 4-fache Nutzung (für die gleiche ChatGPT-Abonnementstufe) bei gleichzeitiger Reduzierung von Latenz und Kosten für gängige, klar definierte Engineering-Aufgaben.

GPT-5-Codex-Mini übernimmt die Kernfunktionen der Codex-Produktlinie: ein tiefes Verständnis der Codebasis und die Ausführung mehrstufiger Aufgaben wie ein Agent. Basierend auf den Codex-CLI-Funktionen können Entwickler über ein interaktives Terminal natürlichsprachliche Befehle, Code-Snippets, Screenshots oder Interface-Design-Diagramme an Codex übermitteln. Das Modell erstellt zunächst einen Plan und durchsucht anschließend automatisch Dateien, bearbeitet Code, führt Befehle aus und testet die Ausführung nach Benutzerfreigabe.

Aus modaler Sicht ermöglichen Codex-Produkte das Anhängen von Bildern (z. B. UI-Screenshots, Designentwürfen oder Screenshots von Fehlermeldungen) an die Sitzung im Terminal oder der IDE. Das Modell versteht sowohl Text- als auch Bildinhalte, die Ausgabe besteht jedoch weiterhin hauptsächlich aus Textcode und Erläuterungen. Daher kann GPT-5-Codex-Mini als Code-Proxy-Modell betrachtet werden, das hauptsächlich Text- und Bildeingaben verarbeitet und Text ausgibt. Es übernimmt keine Aufgaben wie Bild-, Audio- oder Videogenerierung.

Wie schneidet GPT-5-Codex-Mini im Vergleich zu GPT-5-Codex ab?

Was ist neu im Codex?

Zusätzlich zur Veröffentlichung von GPT-5-Codex-Mini hat OpenAI das Codex-Ratenlimit für ChatGPT Plus-, Business- und Edu-Nutzer einheitlich um 50 % erhöht und damit das verfügbare Anfragelimit deutlich angehoben. ChatGPT Pro-Nutzer erhalten zudem priorisierte Verarbeitungsrechte, um die Reaktionsgeschwindigkeit und die Ausführung von Aufgaben zu verbessern.

Darüber hinaus hat OpenAI das GPT-5-Codex-Modell leicht verbessert und dessen Leistung in kollaborativen Szenarien optimiert. Das aktualisierte Modell zeigt Verbesserungen um mehrere Prozentpunkte bei wichtigen Bewertungsmetriken, eine um etwa 3 % höhere Token-Nutzungseffizienz und eine größere Robustheit im Umgang mit Sonderfällen, wodurch der Bedarf an Benutzeranleitungen reduziert wird.

| Benutzerebene | GPT-5-Codex | GPT-5-Codex-Mini |

|---|---|---|

| Plus/Biz/Edu | erhöht das Nachrichtenvolumen jeweils um das 1.5-fache. | erhöht das Nachrichtenvolumen jeweils um das 6-fache. |

GPT-5-Codex-Mini vs. GPT-5-Codex: Benchmark-Unterschiede

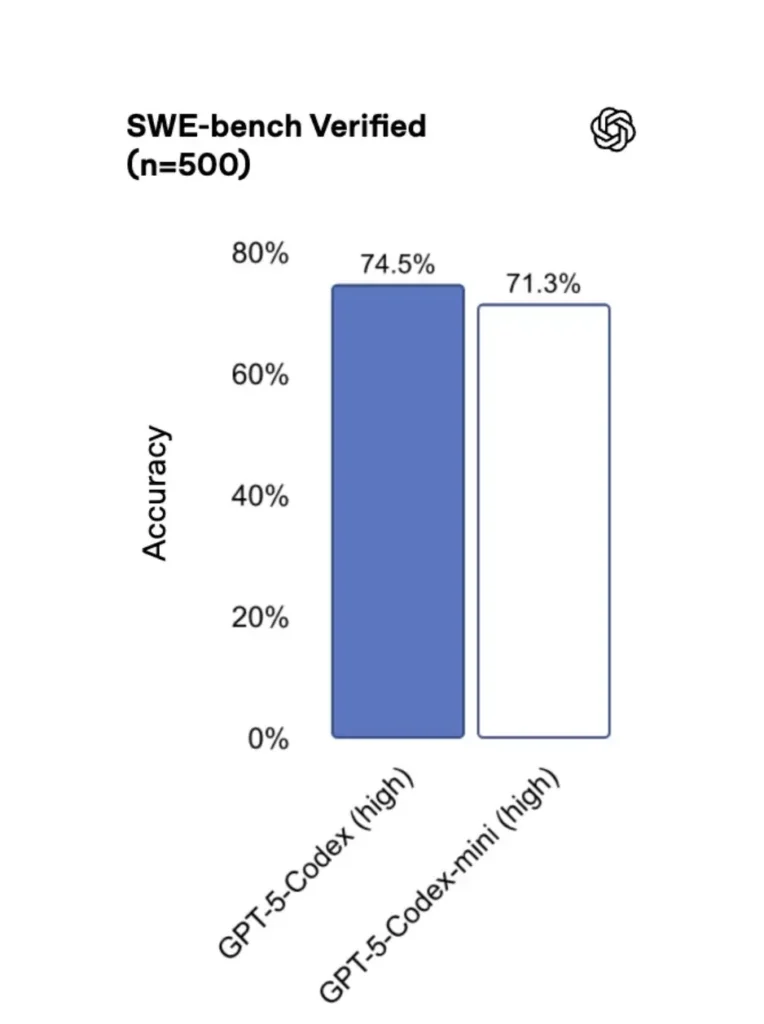

GPT-5-Codex-Mini bietet im Vergleich zur Originalversion eine etwas geringere Leistung, dafür erhalten Entwickler aber etwa die vierfache Nutzungsgutschrift. Im SWE-bench-Verified-Test erreichte GPT-5 High 72.8 %, GPT-5-Codex 74.5 % und GPT-5-Codex-Mini 71.3 %.

Codex (und seine Mini-Variante) verwenden deutlich weniger Token für einfache Interaktionen – OpenAI spricht in seinen Materialien von Reduzierungen im zweistelligen Prozentbereich bei einfachen Eingabeaufforderungen (z. B. eine zitierte Zahl von …). ≈93.7 % weniger Token (über leichte Interaktionen für die Codex-Familie im Vergleich zu GPT-5 in bestimmten Szenarien).

GPT-5-Codex-Mini vs. GPT-5-Codex: Funktionsunterschiede

- Größe und Kosten: Mini ist deutlich kleiner und kostengünstiger; OpenAI gibt an, dass es unter denselben Abonnementbedingungen etwa die vierfache Nutzung ermöglicht. Dies ist eine Quoten-/Effizienzoptimierung für routinemäßige Entwickleraufgaben.

- Leistungsumfang: GPT-5-Codex bleibt die leistungsfähigere Option für lange, komplexe Aufgaben mit Agenten (umfangreiche Refaktorierungen, tiefgreifende Code-Reviews, verlängerte Testzyklen). Mini ist für häufige, kurze Interaktionen optimiert und benötigt weniger Ressourcen.

- Latenz- und Ratenbegrenzungen: Mini bietet typischerweise eine geringere Latenz und ermöglicht höhere Ratenlimits pro Tarif – wodurch es sich für dichte, interaktive Arbeitsabläufe eignet.

- Standardoberflächen: Mini ist als auswählbares Modell in der Codex CLI und der IDE-Erweiterung verfügbar; GPT-5-Codex ist der Standard für Cloud-Aufgaben und Deep-Code-Review-Workflows in Codex.

Wann man den Mini-Codex und wann den vollständigen Codex verwendet

- Nutzen Sie Mini für: Scaffolding, wiederkehrende Codegenerierung, kleine Refaktorierungen, interaktive Vervollständigungen während der Bearbeitung und bei Arbeiten unter Quoten- oder Kostenbeschränkungen.

- Nutzen Sie GPT-5-Codex für: umfassende Code-Reviews, mehrstündige autonome Aufgaben, komplexe Refaktorierungen und Aufgaben, die die stärkste Argumentationsfähigkeit des Modells und testgetriebene Ausführung erfordern.

Wie kann ich auf GPT-5-Codex-Mini zugreifen (CLI, IDE, API)?

Codex CLI (Terminal zuerst)

OpenAI eingeführt gpt-5-codex-mini als Modelloption in der Codex CLI. Typische Nutzungsmuster folgen dem Codex CLI-Workflow: eine interaktive Sitzung starten, das Modell angeben, Dateien oder Screenshots anhängen, „Codex Cloud-Aufgaben“ ausführen usw. Die CLI unterstützt außerdem schnelle /model Umschalten zwischen vollständigem gpt-5-codex kombiniert mit einem nachhaltigen Materialprofil. gpt-5-codex-miniBeim ersten Start müssen Sie sich mit Ihrem ChatGPT-/Pro-/Enterprise-Konto authentifizieren (oder einen API-Schlüssel angeben). Die Befehlszeilenschnittstelle (CLI) bietet verschiedene Befehle, mit denen Codex Codebasen scannen, Tests ausführen, REPLs öffnen oder Patch-Empfehlungen anwenden kann.

Beispiel (interaktive Codex CLI-Sitzung):

# Install Codex CLI (npm)

npm i -g @openai/codex

# or Homebrew on macOS

brew install --cask codex

# Launch in a repo

cd myproject

# Open a codex interactive session

codex

# In the session you can switch the model:

# (this is typed in the Codex TUI)

> /model gpt-5-codex-mini

# Ask Codex to generate a unit test

> Write pytest tests for function `calculate_discount` in discounts.py

Dieser Ablauf spiegelt die neuen Standardeinstellungen der Codex CLI wider, bei denen das Tool Mini in der Nähe von Nutzungsgrenzen vorschlägt.

VS Code / IDE-Erweiterung

Ja – die Codex IDE-Erweiterung (VS Code) enthält bereits Folgendes: gpt-5-codex-mini Alternativ können Sie die Codex-Erweiterung in Visual Studio Code installieren, um Inline-Codevervollständigung, Refactoring-Vorschläge und KI-gestützte Schnellkorrekturen zu erhalten. Die Erweiterung bietet außerdem Schnellaktionen (Code generieren, ausgewählten Code erklären, Refactoring) und ermöglicht die Ausführung von Codex Cloud-Aufgaben direkt aus dem Editor (VS Code-Schritte).

- Installieren Sie die OpenAI Codex / ChatGPT-Erweiterung für VS Code.

- Melden Sie sich mit Ihrem ChatGPT-Konto (Plus/Pro/Business) an.

- Öffnen Sie die Befehlspalette:

Cmd/Ctrl+Shift+P → Codex: Set Model→ wählengpt-5-codex-mini. - Verwenden Sie Inline-Befehle (Code auswählen → Rechtsklick → „Mit Codex erklären“ oder konfigurierte Tastenkombination drücken).

Beispiel: VS Code Inline-Befehl (Pseudo-Schritte)

- Wählen Sie eine Funktion aus in

user_service.py. - Presse

Cmd/Ctrl+Shift+P → Codex: Explain Selectionoder verwenden Sie den Rechtsklick → „Mit Codex erklären“. - Die Erweiterung öffnet ein Seitenfenster mit Minis Erklärung, Testvorschlägen und einer Schaltfläche „PR erstellen“, die mit einem Klick Codex Cloud-Aufgaben nutzt, um einen Branch zur Überprüfung zu pushen.

Wie sieht es mit der API aus – kann ich sie von meiner App aus aufrufen?

Die Ankündigungen von OpenAI deuten darauf hin API-Unterstützung folgt in Kürze. für GPT-5-Codex-Mini; zum Zeitpunkt der Erstellung dieses Dokuments ist das Modell zuerst in der Codex-Toolchain (CLI/IDE) verfügbar. Dies bedeutet, dass sich Produktions-API-Clients auf den Modellnamen vorbereiten sollten. gpt-5-codex-mini Sobald die Requests/Responses-API veröffentlicht ist, wird sie verfügbar sein. In der Zwischenzeit können Sie mit den Codex CLI- und IDE-Workflows Prototypen erstellen.

Wenn der API-Zugriff aktiviert ist, könnte ein typischer Aufruf (im Antwortstil) wie folgt aussehen:

# illustrative — check OpenAI docs for final param names

from openai import OpenAI

client = OpenAI(api_key="sk-...")

resp = client.responses.create(

model="gpt-5-codex-mini",

input="Write a Python function that validates an email address and includes unit tests.",

max_tokens=512,

temperature=0.2

)

print(resp.output_text)

Was sind die besten Vorgehensweisen für schnelles Engineering mit Codex Mini?

Nachfolgend finden Sie konkrete, in der Praxis erprobte Best Practices und Muster, um den maximalen Nutzen aus Codex Mini in Produktions-Engineering-Workflows zu ziehen.

1) Strategie zur Modellauswahl – Mix und Match

Verwenden Sie Mini für häufige, weniger komplexe Aufgaben (Formatierung, kleinere Refaktorierungen, automatische Tests) und greifen Sie bei komplexen Designs, tiefgehendem Debugging oder umfangreichen, Repository-weiten Transformationen auf die vollständige Codex-Version zurück. Automatisieren Sie den Wechsel: Die Codex-CLI schlägt Mini bereits bei einer Nutzung von 90 % vor, und Sie können dies per Skript steuern. /model Wechseln Sie in Ihren Werkzeugen, um ein Modell basierend auf der Aufgabenkomplexität auszuwählen.

2) Schnelle technische Vorlagen

Erstellen Sie kleine, deterministische Vorlagen für wiederkehrende Aufgaben: Testgenerierung, Changelog-Entwürfe, Commit-Nachrichten und PR-Beschreibungen. Speichern Sie diese als wiederverwendbare Code-Snippets in Ihrem Repository oder als Codex-Voreinstellungen.

Beispielvorlage für eine Eingabeaufforderung für Unit-Tests:

# Template: generate_pytests

System: You are a precise Python developer. Produce pytest tests.

User: Given the function below, produce parametrized pytest functions that cover typical edge cases.

--- file: discounts.py

<insert function>

---

Return only valid Python test code with imports and fixtures.

3) Sicherheitsnetze automatisieren – Genehmigungen & CI-Gating

Lassen Sie niemals zu, dass ein Modell ohne menschliche Genehmigung direkt Code überträgt. Verwenden Sie die Genehmigungsmodi von Codex und Codex Cloud-Aufgaben, um Änderungen zu erstellen und die Freigabe durch einen Mitarbeiter in der CI-Pipeline zu erzwingen. Die Codex CLI unterstützt Genehmigungsmodi, sodass Änderungen vor ihrer Anwendung genehmigt werden müssen.

4) Modellaufrufe zwischenspeichern und deduplizieren

Bei wiederholten Eingabeaufforderungen (z. B. zur Erklärung einer Funktion) wird die Antwort anhand der Eingabeaufforderung und des Dateihashs zwischengespeichert. Dies reduziert redundante Aufrufe und sorgt für ein vorhersehbares Kostenprofil.

5) Streaming + inkrementelle Differenzen verwenden

Fordern Sie nach Möglichkeit Streaming-Ausgaben und inkrementelle Unterschiede anstelle von kompletten Dateiüberschreibungen an. Dies reduziert den Tokenverbrauch und hilft Prüfern, gezielte Änderungen zu erkennen.

6) Unit-Test-First-Generator-Ablauf

Generieren Sie Tests und führen Sie diese lokal in einer temporären Umgebung aus. Falls Tests fehlschlagen, wiederholen Sie den Vorgang mit dem Modell, das die Korrekturen für die fehlgeschlagenen Tests bereitstellt. Formulieren Sie jede Iteration als separate Eingabeaufforderung mit den Testergebnissen.

Beispiel für einen Codex CLI-Automatisierungs-Snippet (Bash):

# Generate tests

codex --model gpt-5-codex-mini request "Generate pytest tests for discounts.py" > generated_tests.py

# Run tests locally

pytest generated_tests.py -q || {

echo "Tests failed. Opening Codex for debugging..."

codex --model gpt-5-codex-mini request "Tests failed. Here's pytest output: $(tail -n 50 pytest_output.txt). Propose a fix for discounts.py."

}

Fazit

GPT-5-Codex-Mini ist ein pragmatischer Produktschritt: Er trägt der Tatsache Rechnung, dass Entwickler-Workflows oft von vielen kurzen Interaktionen geprägt sind, bei denen Latenz, Kosten und ein unterbrechungsfreier Arbeitsablauf entscheidend sind. Durch die Bereitstellung einer Mini-Version für die Nutzung in IDEs und CLI ermöglicht OpenAI Teams, die tägliche Unterstützung beim Codieren flexibel zu skalieren, ohne für jede Interaktion sofort das teuerste Modell aufrufen zu müssen.

Entwickler können zugreifen GPT-5-Codex-API ,GPT-5 Pro API Die neuesten Modelle der CometAPI sind zum Veröffentlichungsdatum des Artikels aufgeführt. Melden Sie sich vor dem Zugriff bei CometAPI an und erhalten Sie den API-Schlüssel.CometAPI bieten einen Preis weit unter dem offiziellen Preis an, um Ihnen bei der Integration zu helfen.

Bereit loszulegen? → Melden Sie sich noch heute für CometAPI an !

Wenn Sie weitere Tipps, Anleitungen und Neuigkeiten zu KI erfahren möchten, folgen Sie uns auf VK, X kombiniert mit einem nachhaltigen Materialprofil. Discord!