Neuigkeiten zu Gemini 3.0 waren seit August das meistdiskutierte Thema unter Entwicklern. Ständig verkündeten Meldungen voller Zuversicht den Veröffentlichungstermin, nur um dann festzustellen, dass dieser nicht eingehalten wurde. Die Hoffnungen wurden immer wieder enttäuscht, doch die Vorfreude bleibt groß – denn die Leistung des Gemini 2.5 Pro ist bereits hinter die Konkurrenz von Chatgpt und Claude zurückgefallen. Nun kann ich euch die neuesten Informationen aus erster Hand präsentieren und freue mich, verkünden zu können, dass es ab sofort verfügbar ist auf CometAPI.

Die nächste Generation von Googles Gemini 3-Prozessoren hat mehr durch Leaks ausgelöste Diskussionen als die meisten anderen Produkteinführungen – Community-Checkpoints tauchen auf öffentlichen Benchmarking-Seiten auf, Modellnamen erscheinen in Googles eigenen Tools, und es gibt einen aktiven Entwicklerpfad zum Testen von Modellen über die Gemini CLI und die CometAPI.

Was ist Gemini 3.0 – und warum wird es so sehnsüchtig erwartet?

Auf einer höheren Ebene ist Gemini 3.0 die nächste große Iteration Die Gemini-Familie umfasst große, multimodale KI-Modelle, die von Google DeepMind (und dessen Muttergesellschaft Google LLC) entwickelt wurden. Die Gemini-Serie positioniert sich als Googles Flaggschiff unter den KI-Modellen – entwickelt nicht nur für das Verstehen und Generieren von Texten, sondern auch für … multimodale Aufgaben (Text + Bild + Code + Audio/Video), logisches Denken, Werkzeuggebrauch und letztendlich ein selbstbestimmteres Verhalten.

Der Grund, warum die Leute so begeistert von Gemini 3.0 sind, ist, dass es anscheinend etwas repräsentiert großer Sprung nach vorne – nicht nur ein kleines Update – in Bezug auf die Leistungsfähigkeit des Modells, die Kontextlänge, die Schlussfolgerungsfähigkeit und die praktische Anwendbarkeit. Leaks aus der Community, Code-Referenzen, Benchmark-Ergebnisse und Artikel deuten darauf hin, dass Gemini 3.0 neue Wege beschreiten wird, etwa im Bereich „Denkmodelle“, längerer Kontextfenster, tieferer multimodaler Integration und der Orchestrierung agentenbasierter Werkzeuge.

Im Folgenden werde ich genau durchgehen. warum es ist wichtig, was wir bisher wissen und was noch spekulativ ist.

Was sind „lithiumflow“ und „orionmist“ und warum sind sie auf LMArena erschienen?

Was haben LM Arena und die Community herausgefunden?

Vom 19. bis 23. Oktober entdeckten Community-Ermittler zwei neue LM Arena-Checkpoints mit den Namen lithiumflow und orionmist. Diese Namen scheinen mit Googles internen Namenskonventionen übereinzustimmen (der Familienname „Orion“ wurde bereits in früheren Gemini-Codenamen verwendet), und Community-Analysten interpretieren sie als frühe Kennungen oder Checkpoints für Varianten von Gemini 3.x – umgangssprachlich auch als Gemini 3 Pro / Flash-Checkpoints bekannt.

Warum spielt es eine Rolle?

Sollten Lithiumflow und Orionmist tatsächlich Gemini-3-Checkpoints sein, deutet die Aufteilung darauf hin, dass Google mehrere Unterfamilien (Flash und Pro) vorbereitet: beispielsweise eine für Durchsatz und Effizienz optimierte „Lithiumflow“-Variante und eine „Orionmist“-Variante, die auf aktuelle Retrieval- oder multimodale Funktionen ausgelegt ist. Lithiumflow scheint (laut Spekulationen der Community) das Basismodell für die Generierung von Daten zu sein, optimiert für logisches Denken und die Datengenerierung (ohne Suchgrundlagen). Orionmist hingegen scheint eine Variante mit Integration externer Daten und Echtzeitsuche zu sein, die möglicherweise stärker bei der Retrieval-gestützten Generierung oder bei „Live“-Aufgaben ist.

Mein Test

LM Arena Check-in-Anzeige sehr stark Ergebnisse für lithiumflow bei klassischen Sprachaufgaben (logisches Denken, Codierung und einige SVG-/Layout-Aufgaben). Mehrere Community-Analysten veröffentlichten zudem Vergleichstests, die belegen, dass lithiumflow die aktuelle öffentliche Gemini 2.x-Version und andere vergleichbare Programme bei spezifischen Mikrobenchmarks übertrifft.

Die Verwendung von Lithiumflow zum Schreiben führt zu höherer Kreativität und besserer literarischer Qualität als mit Gemini 2.5, die begrenzte Wortanzahl von nur zwei- bis dreitausend Wörtern bleibt jedoch ein Schwachpunkt. In Kombination mit OrionMist kann es hinsichtlich Leistung und Codierungsgenauigkeit mit Claude 4.5 mithalten, der Unterschied ist aber nicht signifikant.

Hier ist der bisherige Vergleich dieser Modelle in den Benchmarks:

| Benchmark | Gemini 3.0 (lithiumflow) | Zwillinge 3.0 (Orionnebel) | Gemini 2.5 Pro | Claude Opus 4.1 | Claude 3.7 Sonett |

|---|---|---|---|---|---|

| SimpleBench | 80-100 % | 80-100 % | 62.4% | 60.0% | 46.4% |

Beide Modelle zeigten in bestimmten Wissensaufgaben noch Illusionen und Instabilitäten – was für eine frühe Vorschau verständlich ist. Dieses Muster (hervorragende Leistungen bei kreativen Aufgaben und Generierung exzellenter Struktur/Code, aber gelegentliche sachliche Fehler) ist typisch, wenn Modelle mit neuartigen multimodalen oder Codegenerierungsfunktionen kombiniert werden.

Die Tests dieser beiden Modelle wurden in der LM Arena abgeschlossen, was weiter bestätigt, dass es sich tatsächlich um Gemini 3.0 handelt.

Apples Beteiligung und durchgesickerte Spezifikationen

Modellunterschiede

In der Mitte von 2025, Apple Berichten zufolge sind in einer Beta-Version von iOS Code-Schnipsel durchgesickert, die Kennungen wie beispielsweise … enthalten. com.google.gemini_3_pro kombiniert mit einem nachhaltigen Materialprofil. gemini_3_ultra.

Analysten schlussfolgerten, dass Google und Apple sich vorbereiteten. Gemini-basierte „Apple Intelligence“-Integrationenwahrscheinlich für Siri und die Zusammenfassung auf dem Gerät:

- Gemini 3 Pro (cloudbasierte Reasoning-Schicht)

- Gemini 3 Nano (On-Device-Variante)

- Echtzeit-Multimodal-Inferenz

Dies steht im Einklang mit Googles Bestrebungen nach einem KI-Gewebe Die Verbindung von Mobilgeräten, Cloud-APIs und dem Web-Ökosystem.

Spezifikationsleck

Apple und Google verhandeln über eine tiefere Integration von Gemini in Apple Intelligence/Siri – laut einem Bericht plant Apple, eine angepasste Gemini-Variante in seiner KI-Architektur einzusetzen. Apple und Google erwähnten den Parameter 1.2T in ihrem gemeinsamen Plan für KI-Modelle, bei dem es sich möglicherweise um die Spezifikation von Gemini 3.0 handelt.

So starten Sie mit der Gemini 3 Pro Vorschau

Basierend auf den verfügbaren Informationen und Tests stelle ich drei Methoden vor: Vertex, Gemini CLI und API. Entwickler können die Methode wählen, die ihren Bedürfnissen und ihrer Umgebung am besten entspricht. Die Modellbezeichnungen für Gemini 3.0 Pro lauten gemini-3-pro-preview-11-2025 und gemini-3-pro-preview-11-2025-thinking.

Accoss Vertex

Gemini 3.0 pro (gemini-3-pro-preview-11-2025) wurde der Modellliste von Vertex hinzugefügt, und einige Benutzer in der Community behaupten, dass sie es direkt testen können, vorausgesetzt, sie verfügen über ein kostenpflichtiges Vertex-Konto und können mit ihren Kontodaten darauf zugreifen. Tatsächlich lassen sich Spuren in den Netzwerkprotokollen von Vertex finden:

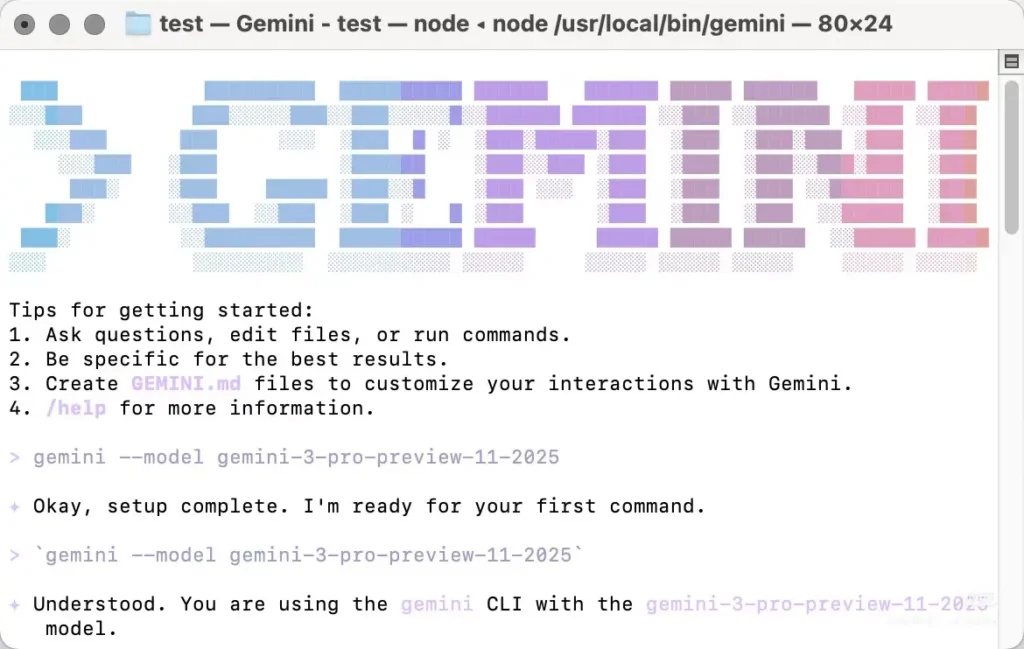

Zugang Gemini cli

Gemini 3.0 Pro kann auch über die Gemini-Befehlszeilenschnittstelle (CLI) aufgerufen werden, allerdings muss das Modell dabei manuell angegeben werden. Die meisten aktuellen Rezensionen zu Gemini 3.0 Pro basieren auf der Verwendung der Gemini-CLI. Diese hat jedoch einige Nachteile: Sie funktioniert nur mit bestimmten nordamerikanischen Knoten, weshalb die lokale IP-Adresse manuell geändert werden muss, und es können mehrere Versuche nötig sein. Die Stabilität lässt zu wünschen übrig, und im Fehlerfall wird ein 404-Fehler zurückgegeben.

Du brauchst Installieren Sie die Gemini CLI lokalAuthentifizieren Sie sich anschließend mit einem Konto, das über Zugriffsberechtigungen verfügt (Google-Konto / CometAPI-Konto), und geben Sie den Modellnamen manuell an.gemini-3-pro-preview-11-2025„Beispiel für die Verwendung von Gemini 3.0 Pro-Vorschau: Installation und Ausführung (Shell)“

```bash

# instant run (no install)

npx https://github.com/google-gemini/gemini-cli

or install globally:

npm install -g @google/gemini-cli

# or on macOS/Linux using Homebrew

brew install gemini-cli

Die CLI akzeptiert Modellbezeichner auf die gleiche Weise wie die API. Praktisch: Legen Sie Ihren Modellbezeichner fest (zum Beispiel `model: "gemini-3-pro-preview-11-2025"`) in einer CLI-Anfrage oder Konfiguration und rufen Sie diese auf – wenn Ihr Konto Zugriff hat, wird die Anfrage erfolgreich sein.

### Zugriff auf die CometAPI-API

[CometAPI](https://www.cometapi.com/de/) ist eine einheitliche API-Plattform, die über 500 KI-Modelle führender Anbieter – wie die GPT-Serie von OpenAI, Gemini von Google, Claude von Anthropics, Midjourney, Suno und weitere – in einer einzigen, benutzerfreundlichen Oberfläche zusammenführt. Sie bietet konsistente Authentifizierung, Anfrageformatierung und Antwortverarbeitung.

CometAPI hat die [Gemini 3 Pro Vorschau-API](https://www.cometapi.com/de/gemini-3-pro-api/) und der Name des internen API-Aufrufs lautet `gemini-3-pro-preview`Beim Aufruf müssen Sie lediglich die Anforderungsadresse ändern in `https://api.cometapi.com/v1/chat/completions`.

Die Gemini 3.0 Pro-Vorschau kann auf dieselbe Weise aufgerufen werden wie die OpenAI-API. In meinen Tests erwies sich der Aufruf über die CometAPI als stabiler als die Verwendung der Gemini-Befehlszeilenschnittstelle.

## Welche Eigenschaften werden für Gemini 3.0 vorhergesagt?

Nachfolgend sind die am häufigsten diskutierten Funktionen aufgeführt (wobei explizit gekennzeichnet wird, welche Punkte bestätigt sind und welche Erwartungen der Community/Analysten nicht erfüllt wurden).

### Kerndesign & Architektur (bestätigt vs. erwartet)

- **Multimodale Grundlage:** Gemini ist als multimodale Familie (Text, Bilder, Code, Audio/Video) konzipiert, und Google hat bereits multimodale Modelle und Tools in der Gemini API veröffentlicht. Dies ist bestätigt und wird auch weiterhin von zentraler Bedeutung sein.

- **Fortgeschrittenes Denken / Planen:** Erwarten Sie eine stärkere Integration von Planungs- und RL-Techniken, die auf DeepMind-Forschungsergebnissen basieren – ein wahrscheinlicher Unterschied im Designschwerpunkt im Vergleich zu einigen Wettbewerbern. Diese Erwartung gründet sich eher auf die Geschichte von DeepMind als auf eine öffentliche Spezifikation.

### Kontextfenster und Speicher

Längere Kontextfenster: Gemini 3.0 soll die effektive Kontextkapazität erhöhen (Diskussionen sprechen von Millionen von Tokens) und baut dabei auf früheren Arbeiten mit großen Kontexten auf. Dies ist eine Prognose – Google hat noch keine offiziellen Token-Limits für Gemini 3.0 veröffentlicht.

### Leistung, Latenz und Modellvarianten

- **Hohe Genauigkeit bei logischem Denken und Codierung:** Beiträge in der LM Arena-Community zu „lithiumflow“ (und „orionmist“) deuten auf eine starke Leistung bei Reasoning- und Code-Aufgaben hin. Es handelt sich dabei um unbestätigte Community-Benchmarks, die jedoch den Hauptgrund für die Begeisterung darstellen. Betrachten Sie sie als erste Anzeichen, nicht als endgültigen Beweis.

- **Mehrere Varianten:** Gerüchte und Leaks deuten auf verschiedene Varianten hin – eine Rohversion/„Pro“-Variante (oft in Beiträgen mit dem Tag „lithiumflow“ erwähnt) und eine geerdete/suchfähige Variante (Orionmist). Auch hier handelt es sich um Schlussfolgerungen der Community, die auf Modell-IDs und Testergebnissen basieren.

### Multimodalität und neue Fähigkeiten

- **Video- und Bildintegration:** Google hat kürzlich Videomodelle (z. B. Veo 3) und Bildverarbeitungsfunktionen in der Gemini API bereitgestellt; Gemini 3.0 soll diese nutzen und vereinheitlichen, um komplexere multimodale Arbeitsabläufe zu ermöglichen. Dies wird durch frühere Google-Releases im Gemini-Ökosystem unterstützt.

- **Geräteinterne Funktionen und Datenschutzfunktionen (Ziel):**Man erwartet effizientere Optionen für die Speicherung sensibler Daten direkt auf dem Gerät oder in einer privaten Cloud, da Google und seine Partner Wert auf Datenschutz und geringe Latenz legen. Diese Prognose basiert auf den Trends im Ökosystem; Details zu Gemini 3.0 sind noch nicht veröffentlicht.

## Endeffekt

Die Gemini 3.0 Pro-Vorschau wird allgemein als Meilenstein für Googles multimodale, auf Schlussfolgerungen ausgerichtete Modelle erwartet – mit potenziell längerem Kontext, verbesserter Planung und umfassenderen multimodalen Fähigkeiten. Die aktuelle Begeisterung ist eine Mischung aus **bestätigte Entwicklertools und Google-Produktsignale** (gemini API, CLI, Veo/Video-Modelle) und **inoffizielle, aber laute Gemeinschaftssignale** (LM Arena-Einträge für lithiumflow/orionmist, Leaks und Analystengerüchte). Betrachten Sie die Community-Benchmarks als Frühindikatoren und bereiten Sie sich vor, indem Sie die Gemini-Entwicklertools erlernen, um das Modell objektiv bewerten zu können, sobald Google den offiziellen Zugriff freigibt.

Ich vermute, dass der 18. November der wahrscheinlichste offizielle Veröffentlichungstermin ist, was mit Googles Modellumstellungsplan für den 18. übereinstimmt. Wir sind gespannt auf weitere Informationen zur Gemini 3 Pro Preview!

### Erste Schritte

CometAPI ist eine einheitliche API-Plattform, die über 500 KI-Modelle führender Anbieter – wie die GPT-Reihe von OpenAI, Gemini von Google, Claude von Anthropic, Midjourney, Suno und weitere – in einer einzigen, entwicklerfreundlichen Oberfläche vereint. Durch konsistente Authentifizierung, Anforderungsformatierung und Antwortverarbeitung vereinfacht CometAPI die Integration von KI-Funktionen in Ihre Anwendungen erheblich. Ob Sie Chatbots, Bildgeneratoren, Musikkomponisten oder datengesteuerte Analyse-Pipelines entwickeln – CometAPI ermöglicht Ihnen schnellere Iterationen, Kostenkontrolle und Herstellerunabhängigkeit – und gleichzeitig die neuesten Erkenntnisse des KI-Ökosystems zu nutzen.

Entwickler können über CometAPI auf die Gemini 3.0 Pro-Vorschau zugreifen. [die neuste Modellversion](https://api.cometapi.com/pricing) wird immer mit der offiziellen Website aktualisiert. Erkunden Sie zunächst die Fähigkeiten des Modells in der [Spielplatz](https://www.cometapi.com/console/playground) und konsultieren Sie die [API-Leitfaden](https://api.cometapi.com/doc) Für detaillierte Anweisungen. Stellen Sie vor dem Zugriff sicher, dass Sie sich bei CometAPI angemeldet und den API-Schlüssel erhalten haben. [CometAPI](https://www.cometapi.com/de/) bieten einen Preis weit unter dem offiziellen Preis an, um Ihnen bei der Integration zu helfen.

Bereit loszulegen? → [Melden Sie sich noch heute für CometAPI an](https://api.cometapi.com/login) !

Wenn Sie weitere Tipps, Anleitungen und Neuigkeiten zu KI erfahren möchten, folgen Sie uns auf [VK](https://vk.com/id1078176061), [X](https://x.com/cometapi2025) kombiniert mit einem nachhaltigen Materialprofil. [Discord](https://discord.com/invite/HMpuV6FCrG)!