In den Jahren 2025–2026 konsolidierte sich die Landschaft der KI-Tools weiter: Gateway-APIs (wie CometAPI) wurden erweitert, um OpenAI-ähnlichen Zugriff auf Hunderte von Modellen zu ermöglichen, während Endbenutzer-LLM-Anwendungen (wie AnythingLLM) ihren „Generic OpenAI“-Provider kontinuierlich verbesserten, sodass Desktop- und lokale Anwendungen jeden OpenAI-kompatiblen Endpunkt aufrufen können. Dadurch ist es heute unkompliziert, den AnythingLLM-Datenverkehr über CometAPI zu leiten und von der Modellauswahl, dem kostengünstigen Routing und der einheitlichen Abrechnung zu profitieren – und gleichzeitig die lokale Benutzeroberfläche und die RAG-/Agentenfunktionen von AnythingLLM zu nutzen.

Was ist AnythingLLM und warum sollte man es mit CometAPI verbinden wollen?

Was ist AnythingLLM?

AnythingLLM ist eine Open-Source-KI-Anwendung und ein lokaler/Cloud-Client für die Entwicklung von Chat-Assistenten, RAG-Workflows (Retrieval-Augmented Generation) und LLM-gesteuerten Agenten. Sie bietet eine intuitive Benutzeroberfläche, eine Entwickler-API, Workspace-/Agent-Funktionen und Unterstützung für lokale und Cloud-basierte LLMs – standardmäßig auf Datenschutz ausgelegt und durch Plugins erweiterbar. AnythingLLM stellt eine Generisches OpenAI Anbieter, der die Kommunikation mit OpenAI-kompatiblen LLM-APIs ermöglicht.

Was ist CometAPI?

CometAPI ist eine kommerzielle API-Aggregationsplattform, die … Mehr als 500 KI-Modelle über eine einzige REST-Schnittstelle im OpenAI-Stil und einheitliche Abrechnung. In der Praxis ermöglicht es, Modelle verschiedener Anbieter (OpenAI, Anthropic, Google/Gemini-Varianten, Bild-/Audiomodelle usw.) über dieselbe Schnittstelle aufzurufen. https://api.cometapi.com/v1 Endpunkte und ein einzelner API-Schlüssel (Format sk-xxxxxCometAPI unterstützt standardmäßige OpenAI-Endpunkte wie z. B. /v1/chat/completions, /v1/embeddingsusw., was die Anpassung von Tools erleichtert, die bereits OpenAI-kompatible APIs unterstützen.

Warum sollte AnythingLLM mit CometAPI integriert werden?

Drei praktische Gründe:

- Modellwahl und Flexibilität der Anbieter: AnythingLLM kann über seinen generischen OpenAI-Wrapper „jedes OpenAI-kompatible“ LLM verwenden. Durch die Verwendung dieses Wrappers für CometAPI erhält man sofortigen Zugriff auf Hunderte von Modellen, ohne die Benutzeroberfläche oder die Abläufe von AnythingLLM ändern zu müssen.

- Kosten-/Betriebsoptimierung: Mit CometAPI können Sie Modelle zentral wechseln (oder auf günstigere Modelle zurückgreifen), um die Kosten zu kontrollieren, und eine einheitliche Abrechnung beibehalten, anstatt mit mehreren Anbieterschlüsseln jonglieren zu müssen.

- Schnelleres Experimentieren: Sie können verschiedene Modelle im A/B-Vergleich testen (z. B.

gpt-4o,gpt-4.5, Claude-Varianten oder Open-Source-Multimodalmodelle) über dieselbe AnythingLLM-Benutzeroberfläche – nützlich für Agenten, RAG-Antworten, Zusammenfassungen und multimodale Aufgaben.

Umgebung und Bedingungen, die Sie vor der Integration vorbereiten müssen

System- und Softwareanforderungen (allgemein)

- Desktop-PC oder Server mit AnythingLLM (Windows, macOS, Linux) – Desktop-Installation oder selbstgehostete Instanz. Stellen Sie sicher, dass Sie eine aktuelle Version verwenden, die die folgenden Funktionen bereitstellt: LLM-Präferenzen / KI-Anbieter zu üben.

- CometAPI-Konto und ein API-Schlüssel (der

sk-xxxxxStilgeheimnis). Dieses Geheimnis benötigen Sie für den generischen OpenAI-Provider von AnythingLLM. - Netzwerkverbindung von Ihrem Computer zu

https://api.cometapi.com(keine Firewall blockiert ausgehende HTTPS-Verbindungen). - Optional, aber empfohlen: eine moderne Python- oder Node-Umgebung zum Testen (Python 3.10+ oder Node 18+), curl und ein HTTP-Client (Postman / HTTPie), um CometAPI vor der Einbindung in AnythingLLM auf seine Funktionalität zu überprüfen.

AnythingLLM-spezifische Bedingungen

Die Generisches OpenAI Der LLM-Provider ist die empfohlene Methode für Endpunkte, die die API-Oberfläche von OpenAI nachbilden. Die Dokumentation von AnythingLLM weist darauf hin, dass dieser Provider entwicklerorientiert ist und Sie die von Ihnen verwendeten Eingaben genau verstehen sollten. Falls Sie Streaming verwenden oder Ihr Endpunkt Streaming nicht unterstützt, bietet AnythingLLM eine Einstellung zum Deaktivieren von Streaming für generisches OpenAI.

Sicherheits- und Betriebscheckliste

- Behandeln Sie den CometAPI-Schlüssel wie jedes andere Geheimnis – speichern Sie ihn nicht in Repositories, sondern nach Möglichkeit in OS-Schlüsselbunden oder Umgebungsvariablen.

- Wenn Sie planen, sensible Dokumente in RAG zu verwenden, stellen Sie sicher, dass die Datenschutzgarantien für Endpunkte Ihren Compliance-Anforderungen entsprechen (siehe CometAPI-Dokumentation/Bedingungen).

- Legen Sie maximale Token- und Kontextfensterlimits fest, um eine unkontrollierte Kostenexplosion zu verhindern.

Wie konfiguriert man AnythingLLM für die Verwendung der CometAPI (Schritt für Schritt)?

Nachfolgend finden Sie eine konkrete Schrittfolge – gefolgt von Beispielen für Umgebungsvariablen und Code-Snippets zum Testen der Verbindung, bevor Sie die Einstellungen in der AnythingLLM-Benutzeroberfläche speichern.

Schritt 1 – CometAPI-Schlüssel abrufen

- Registrieren Sie sich oder melden Sie sich bei CometAPI an.

- Navigieren Sie zu „API-Schlüssel“ und generieren Sie einen Schlüssel – Sie erhalten eine Zeichenkette, die etwa so aussieht:

sk-xxxxx. Bewahre es geheim.

Schritt 2 – Überprüfen Sie mit einer kurzen Anfrage, ob CometAPI funktioniert.

Verwenden Sie curl oder Python, um einen einfachen Chat-Abschluss-Endpunkt aufzurufen und die Verbindung zu bestätigen.

Curl-Beispiel

curl -X POST "https://api.cometapi.com/v1/chat/completions" \

-H "Authorization: Bearer sk-xxxxx" \

-H "Content-Type: application/json" \

-d '{

"model": "gpt-4o",

"messages": ,

"max_tokens": 50

}'

Wenn dies einen 200-Statuscode und eine JSON-Antwort mit einem zurückgibt choices Array, Schlüssel und Netzwerk funktionieren. (Die CometAPI-Dokumentation zeigt die OpenAI-ähnliche Oberfläche und die Endpunkte).

Python-Beispiel (Anfragen)

import requests

url = "https://api.cometapi.com/v1/chat/completions"

headers = {"Authorization": "Bearer sk-xxxxx", "Content-Type": "application/json"}

payload = {

"model": "gpt-4o",

"messages": ,

"max_tokens": 64

}

r = requests.post(url, json=payload, headers=headers, timeout=15)

print(r.status_code, r.json())

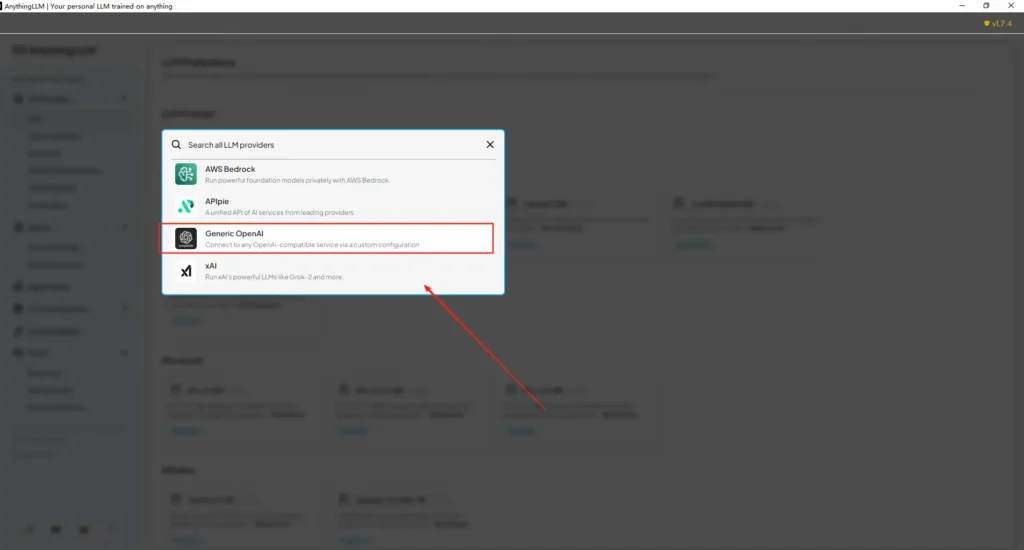

Schritt 3 – AnythingLLM konfigurieren (Benutzeroberfläche)

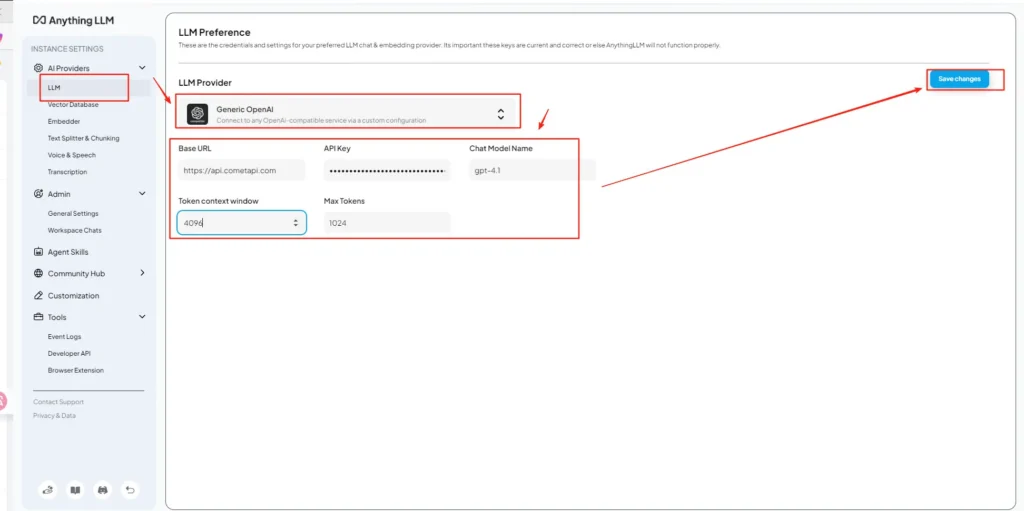

AnythingLLM öffnen → Einstellungen → KI-Anbieter → LLM-Präferenzen (oder ein ähnlicher Pfad in Ihrer Version). Verwenden Sie die Generisches OpenAI Anbieter und füllen Sie die Felder wie folgt aus:

API-Konfiguration (Beispiel)

• Rufen Sie das AnythingLLM-Einstellungsmenü auf und suchen Sie unter KI-Anbieter nach LLM-Einstellungen.

• Wählen Sie Generic OpenAI als Modellanbieter aus und geben Sie Folgendes ein:https://api.cometapi.com/v1in das URL-Feld.

• Fügen Sie diesk-xxxxxGeben Sie den API-Schlüssel von CometAPI in das Eingabefeld ein. Füllen Sie das Fenster „Token-Kontext“ und „Maximale Tokenanzahl“ entsprechend dem jeweiligen Modell aus. Sie können auf dieser Seite auch Modellnamen anpassen, z. B. durch Hinzufügen des Namens.gpt-4oModell.

Dies steht im Einklang mit den Richtlinien von AnythingLLM für „Generic OpenAI“ (Entwickler-Wrapper) und dem OpenAI-kompatiblen Basis-URL-Ansatz von CometAPI.

Schritt 4 – Modellnamen und Token-Limits festlegen

Fügen Sie auf demselben Einstellungsbildschirm Modellnamen hinzu oder passen Sie diese genau so an, wie sie von CometAPI veröffentlicht werden (z. B. gpt-4o, minimax-m2, kimi-k2-thinkingDamit die AnythingLLM-Benutzeroberfläche diese Modelle den Benutzern präsentieren kann. CometAPI veröffentlicht Modellzeichenfolgen für jeden Anbieter.

Schritt 5 – Testen in AnythingLLM

Starten Sie einen neuen Chat oder verwenden Sie einen bestehenden Arbeitsbereich, wählen Sie den generischen OpenAI-Anbieter (falls Sie mehrere Anbieter haben), wählen Sie einen der hinzugefügten CometAPI-Modellnamen und führen Sie eine einfache Eingabeaufforderung aus. Wenn Sie sinnvolle Vervollständigungen erhalten, ist die Integration abgeschlossen.

Wie AnythingLLM diese Einstellungen intern verwendet

AnythingLLMs generischer OpenAI-Wrapper erstellt Anfragen im OpenAI-Stil (/v1/chat/completions, /v1/embeddingsSobald Sie die Basis-URL angegeben und den CometAPI-Schlüssel bereitgestellt haben, leitet AnythingLLM Chats, Agentenanrufe und Einbettungsanfragen transparent über CometAPI weiter. Wenn Sie AnythingLLM-Agenten verwenden (die @agent Wenn sie Datenflüsse haben, werden sie denselben Provider erben.

Was sind die besten Vorgehensweisen und welche möglichen Fallstricke?

Best Practices

- Verwenden Sie modellgerechte Kontexteinstellungen: Passen Sie die Einstellungen für das Token-Kontextfenster und die maximale Tokenanzahl von AnythingLLM an das in CometAPI ausgewählte Modell an. Eine Nichtübereinstimmung führt zu unerwarteten Datenkürzungen oder fehlgeschlagenen Aufrufen.

- Sichern Sie Ihre API-Schlüssel: Speichern Sie CometAPI-Schlüssel in Umgebungsvariablen und/oder im Kubernetes-/Secret-Manager; checken Sie sie niemals in Git ein. AnythingLLM speichert Schlüssel in seinen lokalen Einstellungen, wenn Sie diese in der Benutzeroberfläche eingeben – behandeln Sie den Host-Speicher daher als sensibel.

- Beginnen Sie mit günstigeren/kleineren Modellen für die Experimentierabläufe: Nutzen Sie CometAPI, um kostengünstigere Modelle für die Entwicklung zu testen und Premium-Modelle für den Produktiveinsatz zu reservieren. CometAPI wirbt explizit mit Kostenoptimierung durch flexibles Umschalten und einheitliche Abrechnung.

- Nutzung überwachen und Benachrichtigungen einrichten: CometAPI bietet Nutzungsübersichten – legen Sie Budgets/Warnungen fest, um unerwartete Rechnungen zu vermeiden.

- Testen Sie Agenten und Tools isoliert: AnythingLLM-Agenten können Aktionen auslösen; testen Sie sie zunächst mit sicheren Eingabeaufforderungen und auf Testinstanzen.

Häufige Fehler

- UI vs

.envKonflikte: Beim Selbsthosting können UI-Einstellungen überschrieben werden.envÄnderungen (und umgekehrt). Überprüfen Sie die generierten/app/server/.envFalls die Einstellungen nach einem Neustart wiederhergestellt werden, melden Sie bitte Probleme in der Community.LLM_PROVIDERwird zurückgesetzt. - Namenskonflikte bei Modellen: Die Verwendung eines nicht in CometAPI verfügbaren Modellnamens führt zu einem 400/404-Fehler vom Gateway. Prüfen Sie daher immer die verfügbaren Modelle in der CometAPI-Modellliste.

- Token-Limits & Streaming: Wenn Sie Streaming-Antworten benötigen, überprüfen Sie, ob das CometAPI-Modell Streaming unterstützt (und ob die Benutzeroberfläche von AnythingLLM dies ebenfalls unterstützt). Die Streaming-Semantik kann je nach Anbieter variieren.

Welche realen Anwendungsfälle ergeben sich durch diese Integration?

Retrieval-Augmented Generation (RAG)

Nutzen Sie die Dokumentenlader von AnythingLLM und die Vektordatenbank in Verbindung mit CometAPI-LLMs, um kontextbezogene Antworten zu generieren. Sie können mit kostengünstigen Einbettungs- und aufwändigen Chatmodellen experimentieren oder alles über CometAPI abwickeln, um eine einheitliche Abrechnung zu gewährleisten. Die RAG-Flows von AnythingLLM sind eine der wichtigsten integrierten Funktionen.

Agentenautomatisierung

AnythingLLM unterstützt @agent Workflows (Seiten durchsuchen, Tools aufrufen, Automatisierungen ausführen). Durch das Routing von LLM-Anrufen der Agenten über CometAPI haben Sie die Wahl zwischen verschiedenen Modellen für Steuerungs-/Interpretationsschritte, ohne den Agentencode ändern zu müssen.

Multimodell-A/B-Testing und Kostenoptimierung

Schaltmodelle pro Arbeitsbereich oder Funktion (z. B. gpt-4o für Produktionsantworten, gpt-4o-mini (für Entwickler). CometAPI vereinfacht Modellwechsel und zentralisiert die Kosten.

Multimodale Pipelines

CometAPI bietet Bild-, Audio- und Spezialmodelle. Die multimodale Unterstützung von AnythingLLM (über Anbieter) in Kombination mit den Modellen von CometAPI ermöglicht Bildbeschreibung, multimodale Zusammenfassung oder Audiotranskription über dieselbe Schnittstelle.

Fazit

CometAPI positioniert sich weiterhin als Multi-Modell-Gateway (über 500 Modelle, OpenAI-ähnliche API) und ist damit ein idealer Partner für Anwendungen wie AnythingLLM, die bereits einen generischen OpenAI-Provider unterstützen. Ebenso ermöglichen der generische Provider von AnythingLLM und die kürzlich eingeführten Konfigurationsoptionen eine unkomplizierte Anbindung an solche Gateways. Diese Konvergenz vereinfacht Experimente und die Produktionsmigration Ende 2025.

Erste Schritte mit der Comet-API

CometAPI ist eine einheitliche API-Plattform, die über 500 KI-Modelle führender Anbieter – wie die GPT-Reihe von OpenAI, Gemini von Google, Claude von Anthropic, Midjourney, Suno und weitere – in einer einzigen, entwicklerfreundlichen Oberfläche vereint. Durch konsistente Authentifizierung, Anforderungsformatierung und Antwortverarbeitung vereinfacht CometAPI die Integration von KI-Funktionen in Ihre Anwendungen erheblich. Ob Sie Chatbots, Bildgeneratoren, Musikkomponisten oder datengesteuerte Analyse-Pipelines entwickeln – CometAPI ermöglicht Ihnen schnellere Iterationen, Kostenkontrolle und Herstellerunabhängigkeit – und gleichzeitig die neuesten Erkenntnisse des KI-Ökosystems zu nutzen.

Zunächst sollten Sie die Modellfunktionen vonCometAPI in England, Spielplatz Detaillierte Anweisungen finden Sie im API-Handbuch. Stellen Sie vor dem Zugriff sicher, dass Sie sich bei CometAPI angemeldet und den API-Schlüssel erhalten haben. MitetAPI bieten einen Preis weit unter dem offiziellen Preis an, um Ihnen bei der Integration zu helfen.

Bereit loszulegen? → Melden Sie sich noch heute für CometAPI an !

Wenn Sie weitere Tipps, Anleitungen und Neuigkeiten zu KI erfahren möchten, folgen Sie uns auf VK, X kombiniert mit einem nachhaltigen Materialprofil. Discord!