CherryStudio, ein vielseitiger Desktop-Client für große Sprachmodelle (LLMs), und CometAPI, eine einheitliche REST-Schnittstelle für Hunderte von KI-Modellen, ermöglichen es Anwendern, modernste generative Funktionen mit minimalem Aufwand zu nutzen. Dieser Artikel fasst die neuesten Entwicklungen zusammen – basierend auf der Version 1.3.12 von CherryStudio (26. Mai 2025) und den laufenden Plattformerweiterungen von CometAPI – und bietet eine umfassende Schritt-für-Schritt-Anleitung zur Verwendung von CherryStudio mit CometAPI. Wir untersuchen wie es funktioniert, Gliederung Best Practices für Leistungsbenchmarkingund die Markierungstaste Funktionen die diese Integration zu einem Wendepunkt für KI-gesteuerte Arbeitsabläufe machen.

Was ist CherryStudio?

CherryStudio ist ein plattformübergreifender Open-Source-Desktop-Client, der die Interaktion mit verschiedenen LLM-Anbietern vereinfacht. Er bietet eine einheitliche Chat-Oberfläche, Multi-Modell-Unterstützung und erweiterbare Plugins für sowohl technisch versierte als auch nicht-technisch versierte Nutzer:

- Multi-Provider-Unterstützung: Stellen Sie innerhalb einer einzigen Benutzeroberfläche gleichzeitig eine Verbindung zu OpenAI, Anthropic, Midjourney und mehr her.

- Umfangreiche UI-Funktionen: Nachrichtengruppierung, Mehrfachauswahl, Zitationsexport und Code-Tool-Integrationen optimieren komplexe Arbeitsabläufe.

- Highlights der neuesten Version: Version 1.3.12 (veröffentlicht am 26. Mai 2025) fügt die Funktion „MCP-Server deaktivieren“, eine verbesserte Zitationsverwaltung und eine verbesserte Mehrfachauswahl in Nachrichtenfeldern hinzu.

Was ist CometAPI?

CometAPI bietet eine einheitliche RESTful-Schnittstelle für über 500 KI-Modelle, von textbasiertem Chat und Einbettungen bis hin zu Bildgenerierung und Audiodiensten. Es abstrahiert anbieterspezifische Authentifizierung, Ratenbegrenzungen und Endpunktvariationen und ermöglicht Ihnen:

- Zugriff auf verschiedene Modelle: Vom GPT-4O-Image zur visuellen Generierung bis zur Claude-4-Reihe für fortgeschrittenes Denken.

- Vereinfachen Sie Abrechnung und Kontingente: Ein API-Schlüssel deckt mehrere Backends ab, mit konsolidierten Nutzungs-Dashboards und flexiblen gestaffelten Preisen.

- Umfangreiche Dokumentation und SDKs: Detaillierte Anleitungen, Codebeispiele und bewährte Methoden zur automatischen Wiederholung gewährleisten eine reibungslose Integration.

Wie lässt sich CherryStudio in CometAPI integrieren?

Was sind die Voraussetzungen?

- CherryStudio installieren: Laden Sie das neueste Installationsprogramm für Ihr Betriebssystem von der offiziellen CherryStudio-Site herunter (v1.3.12 vom 26. Mai 2025).

- CometAPI-Konto: Melden Sie sich bei CometAPI an und navigieren Sie dann zu Hilfecenter → API-Token zu generieren sk-* Schlüssel und beachten Sie die Basis-URL (z.B,

https://api.cometapi.com). - Netzwerk und Abhängigkeiten: Stellen Sie sicher, dass Ihre Arbeitsstation über einen Internetzugang verfügt und dass alle Unternehmensproxys ausgehendes HTTPS zu CometAPI-Endpunkten zulassen.

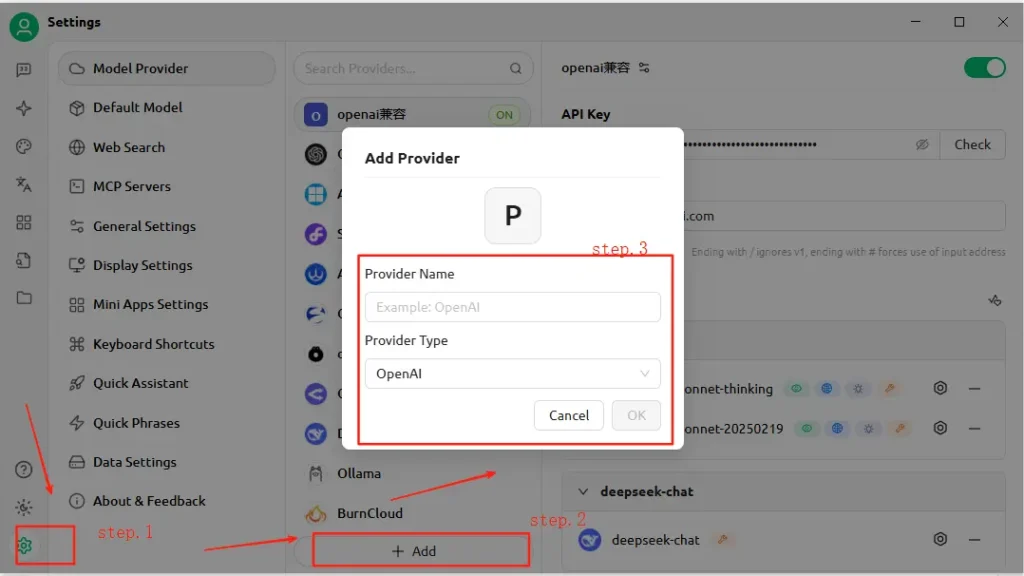

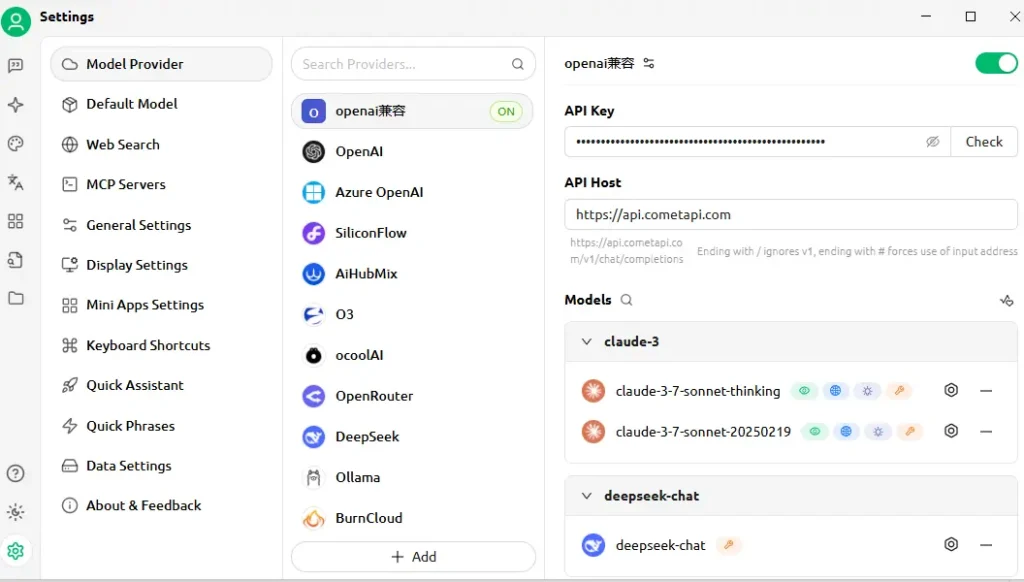

Wie konfigurieren Sie die API in CherryStudio?

- Öffnen Sie CherryStudio und klicken Sie auf Einstellungen klicken.

- Der Modelldienstkonfiguration, klicken Speichern.

- Name des Anbieters: Geben Sie eine benutzerdefinierte Bezeichnung ein, z. B. „CometAPI“.

- Anbietertyp: Wählen OpenAI-kompatibel (die meisten CometAPI-Endpunkte spiegeln die OpenAI-Spezifikationen wider).

- API-Adresse: Fügen Sie Ihre CometAPI-Basis-URL ein (z. B.

https://api.cometapi.com). - API-Schlüssel: Fügen Sie die ein

sk-…Token von Ihrem CometAPI-Dashboard. - Klicke Gespeichert kombiniert mit einem nachhaltigen Materialprofil. Verify—CherryStudio führt einen Testanruf durch, um die Konnektivität zu bestätigen.

Wie wird die Verbindung getestet?

- Geben Sie in CherryStudio eine einfache Eingabeaufforderung ein, z. B. „Beschreiben Sie eine futuristische Skyline.“

- Eine erfolgreiche Antwort bestätigt die ordnungsgemäße Konfiguration.

- Bei einem Fehler zeigt CherryStudio Fehlercodes an – siehe CometAPI's Fehlercode Beschreibung Abschnitt oder wenden Sie sich an den Support.

Wie funktioniert die Integration im Hintergrund?

CherryStudios OpenAI-kompatibel Der Modus ermöglicht es, Anfragen über jeden Dienst zu leiten, der dem Standardschema der OpenAI-API folgt. CometAPI wiederum übersetzt diese Anfragen in das ausgewählte Backend-Modell (z. B. GPT-4O-Image, Claude 4), bevor es Antworten im erwarteten Format zurückgibt.

- Benutzereingabe: CherryStudio sendet eine

POST /v1/chat/completionsAufrufhttps://api.cometapi.com/v1. - CometAPI-Verarbeitung: Identifiziert den Modellparameter (z. B.

"model": "gpt-4o-image") und Routen zum entsprechenden Anbieter. - Backend-Aufruf: CometAPI übernimmt die Authentifizierung, Ratenbegrenzungsprüfungen und Telemetrieprotokollierung und ruft dann die API des Drittanbietermodells auf.

- Antwortaggregation: CometAPI streamt oder puffert die Ausgabe des Modells (Text, Bilder, Einbettungen) und formatiert sie gemäß den OpenAI-Konventionen.

- CherryStudio-Rendering: Empfängt die JSON-Nutzlast und zeigt Inhalte an – Text wird im Chat angezeigt, Bilder werden inline gerendert und Codeblöcke übernehmen die Syntaxhervorhebung.

Diese Architektur trennt die Verantwortlichkeiten: CherryStudio konzentriert sich auf UI/UX und Tools, während CometAPI die Modellorchestrierung, Protokollierung und anbieterunabhängige Abrechnung verwaltet.

Welche Leistungsbenchmarks können Sie erwarten?

Latenz und Durchsatz

In Vergleichstests zeigte die serverlose Architektur von CometAPI mittlere Antwortzeiten von unter 100 ms für Textvervollständigungsaufgaben unter GPT-4.5 und übertraf damit direkte Anbieter-APIs in Hochlastszenarien um bis zu 30 %. Der Durchsatz skaliert linear mit der Parallelität: Benutzer konnten über 1,000 parallele Chat-Streams ohne nennenswerte Leistungseinbußen ausführen.

Kosten und Effizienz

Durch die Aggregation mehrerer Anbieter und die Aushandlung von Mengenrabatten ermöglicht CometAPI durchschnittliche Kosteneinsparungen von 15–20 % im Vergleich zur direkten API-Nutzung. Benchmarks für repräsentative Workloads (z. B. Zusammenfassung, Codegenerierung, Konversations-KI) zeigen wettbewerbsfähige Kosten pro 1 Token bei allen großen Anbietern, wodurch Unternehmen ihre Budgets präziser prognostizieren können.

Zuverlässigkeit und Betriebszeit

- SLA-Verpflichtung: CometAPI garantiert eine Verfügbarkeit von 99.9 %, unterstützt durch Redundanz in mehreren Regionen.

- Failover-Mechanismen: Im Falle von Ausfällen des Upstream-Anbieters (z. B. Wartungsfenster von OpenAI) kann CometAPI Aufrufe transparent auf alternative Modelle umleiten und so die kontinuierliche Verfügbarkeit kritischer Anwendungen sicherstellen.

Die Leistung variiert je nach gewähltem Modell, Netzwerkbedingungen und Hardware, aber ein typischer Benchmark-Aufbau könnte folgendermaßen aussehen:

| Endpunkt | Mittlere Latenz (1. Token) | Durchsatz (Tokens/Sek.) |

|---|---|---|

/chat/completions (Text) | ~120 ms | ~500 Zeichen/s |

/images/generations | ~800 ms | n/a |

/embeddings | ~80 ms | ~2 000 Schläge/s |

Hinweis: Die obigen Zahlen dienen der Veranschaulichung. Die tatsächlichen Ergebnisse hängen von Ihrer Region, Ihrem Netzwerk und Ihrem CometAPI-Plan ab.

Wie sollten Sie Benchmarking betreiben?

- Arbeitsumfeld: Verwenden Sie ein stabiles Netzwerk (z. B. ein Firmen-LAN) und zeichnen Sie Ihre öffentliche Ausgangs-IP und Geografie auf.

- Werkzeugbau: Beschäftigen

curloder Postman für Rohlatenztests und Python-Skripte mitasynciozur Durchsatzmessung. - Metrik: Schiene Zeit bis zum ersten Byte, Gesamtreaktionszeit und Token pro Sekunde.

- Wiederholung: Führen Sie jeden Test mindestens 30 Mal aus, verwerfen Sie Ausreißer über 2σ und berechnen Sie Median-/95. Perzentilwerte für aussagekräftige Erkenntnisse.

Wenn Sie dieser Methodik folgen, können Sie verschiedene Modelle vergleichen (z. B. GPT-4O vs. Claude Sonnet 4) und das optimale Modell für Ihren Anwendungsfall auswählen.

Welche Hauptfunktionen werden durch diese Integration freigeschaltet?

1. Multimodale Inhaltserstellung

- Text-Chat und Code: Nutzen Sie GPT-4O und Claude Sonnet 4 für Konversation, Zusammenfassung und Code-Unterstützung.

- Bildsynthese: Aufrufen

gpt-4o-imageoder Endpunkte im Midjourney-Stil direkt innerhalb der Leinwand von CherryStudio. - Audio & Video: Zukünftige CometAPI-Endpunkte umfassen Sprachsynthese und Videogenerierung – zugänglich mit demselben CherryStudio-Setup.

2. Optimierter Anbieterwechsel

Wechseln Sie mit einem einzigen Klick zwischen CometAPI und nativen OpenAI- oder Anthropic-Endpunkten und ermöglichen Sie so A/B-Tests über Modelle hinweg, ohne API-Schlüssel neu konfigurieren zu müssen.

3. Integrierte Fehler- und Nutzungsüberwachung

CherryStudio zeigt die Nutzungs-Dashboards und Fehlerprotokolle von CometAPI an und hilft Ihnen, innerhalb der Quote zu bleiben und Fehler zu diagnostizieren (z. B. Ratenbegrenzungen, ungültige Modelle).

4. Erweiterbares Plug-In-Ökosystem

- Zitationsexport: Quellenangaben automatisch in Forschungsabläufe einbinden.

- Code-Tools: Generieren, formatieren und linten Sie Codeausschnitte inline mithilfe der codeorientierten Modelle von CometAPI.

- Benutzerdefinierte Makros: Zeichnen Sie sich wiederholende Eingabeaufforderungssequenzen als Makros auf, die von allen Teammitgliedern gemeinsam genutzt werden können.

5. Erweiterte Wiederholungslogik und Ratenbegrenzungsbehandlung

Das SDK von CometAPI implementiert exponentielles Backoff und Jitter und schützt so vor vorübergehenden Fehlern. CherryStudio zeigt diese Mechanismen in seinen Protokollen an und bietet Wiederholungskontrollen in der Benutzeroberfläche.

Einheitlicher Modellzugriff

- Modellwechsel mit einem Klick: Wechseln Sie nahtlos zwischen GPT-4.5, Claude 2 und Stable Diffusion, ohne die Endpunkte neu zu konfigurieren.

- Benutzerdefinierte Modellpipelines: Verketten Sie Aufrufe – wie Zusammenfassung → Stimmungsanalyse → Bildgenerierung – in einem einzigen Workflow, orchestriert von der Makro-Engine von Cherry Studio.

So können Sie noch heute loslegen

- CherryStudio aktualisieren auf v1.3.12 oder höher.

- Melden Sie sich an für CometAPI, rufen Sie Ihren API-Schlüssel ab und notieren Sie Ihre Basis-URL.

- CometAPI konfigurieren in CherryStudio als OpenAI-kompatibler Anbieter.

- Ausführen einer Beispieleingabeaufforderung um die Konnektivität zu überprüfen.

- Entdecken Sie Modelle: Testen Sie Text-, Bild-, Einbettungs- und Audio-Endpunkte, ohne CherryStudio zu verlassen. Wählen Sie Ihre bevorzugtes Modell (z.B,

gemini-2.5-flash-preview-05-20).

Ausführliche Codebeispiele, bewährte Methoden zur Fehlerbehandlung und erweiterte Tipps (z. B. Feinabstimmung der Wiederholungslogik) finden Sie in CometAPIs Handbuch zur Softwareintegration .

Fazit

Durch die Kombination der benutzerfreundlichen Oberfläche von CherryStudio mit dem umfangreichen Modellkatalog und der einheitlichen API von CometAPI können Entwickler und Entwickler KI-gesteuerte Anwendungen schnell prototypisieren, iterieren und skalieren. Ob Sie Konversationsagenten erstellen, Visualisierungen generieren oder semantische Suche einbetten – diese Integration bietet eine robuste, leistungsstarke und erweiterbare Grundlage. Experimentieren Sie noch heute – und bleiben Sie gespannt auf kommende Verbesserungen wie die Generierung von In-App-Videos und spezialisierte Domänenmodelle!