Google kündigte Gemini 3 Flash am 17.–18. Dezember 2025 als ein latenzarmes, kosteneffizientes Mitglied der Gemini‑3‑Familie an. Es bringt Pro‑taugliches Reasoning in einen Flash‑Klassen‑Footprint, unterstützt umfangreiche multimodale Eingaben (Text, Bild, Audio, Video), führt thinking_level‑ und Medienauflösungs‑Kontrollen ein und ist über Google AI Studio, die Gemini API (REST / SDKs), Vertex AI, Gemini CLI sowie als Standardmodell in Google Search / Gemini app verfügbar.

Was ist Gemini 3 Flash und warum es wichtig ist

Gemini 3 Flash ist Teil von Googles 3er‑Modellen. Es wurde entwickelt, um die Pareto‑Front von Qualität vs. Kosten vs. Latenz voranzutreiben: Es liefert einen Großteil der Reasoning‑Fähigkeiten von Gemini 3 Pro, ist dabei jedoch deutlich schneller und günstiger im Betrieb. Diese Kombination macht es gut geeignet für hochfrequente interaktive Szenarien (Chatbots, IDE‑Assistenten, nahezu echtzeitfähige agentische Abläufe), für Masseninhalte, bei denen Latenz zählt, sowie für Anwendungen, die multimodales Reasoning (Bilder + Text + Audio) mit geringem Overhead benötigen.

Zentrale Eckpunkte:

- Es ist explizit auf Geschwindigkeit + niedrige Kosten optimiert, bei gleichzeitig starker Reasoning‑Leistung und multimodaler Treue (Dreimal schneller als das alte Gemini 2.5 Pro; Behält die Inferenzfähigkeiten der Spitzenklasse von Gemini 3 bei.).

- Es ist als „Sweet Spot“ für agentische Schleifen und iterative Entwickler‑Workflows positioniert (z. B. Code‑Assistenz, Multi‑Turn‑Agenten).

- Flexibel: Es kann seine „Denkzeit“ an die Komplexität der Aufgabe anpassen—beantwortet einfache Fragen sofort und berücksichtigt bei komplexen Aufgaben mehr Schritte.

Technische Leistung und Benchmark-Ergebnisse

Gemini 3 Flash erzielt einen dreifachen Durchbruch bei Geschwindigkeit, Intelligenz und Kosten:

1) Agentische Schleifen und multimodales Verständnis

Gemini 3 Flash erbt architektonische und trainingsseitige Verbesserungen aus der breiteren Gemini‑3‑Familie und erreicht eine starke multimodale Kompetenz (Text-, Bild-, Video-, Audio‑Eingaben) sowie verbessertes Reasoning gegenüber früheren Flash‑Modellen. Google positioniert Flash als in der Lage, Aufgaben wie Dokumentanalyse (OCR + Reasoning), Videozusammenfassung, Bild‑plus‑Text‑Q&A und multimodale Sopran?) "No" — We must ensure we keep consistent. Something wrong? Wait I'm writing final. I must correct. I continue adjusting text. Let's continue properly.

Gemini 3 Flash erbt architektonische und trainingsseitige Verbesserungen aus der breiteren Gemini‑3‑Familie, erzielt eine starke multimodale Kompetenz (Text-, Bild-, Video-, Audio‑Eingaben) und verbessertes Reasoning im Vergleich zu früheren Flash‑Modellen. Google positioniert Flash als fähig, Aufgaben wie Dokumentanalyse (OCR + Reasoning), Videozusammenfassung, Bild‑plus‑Text‑Q&A und multimodale Coding‑Aufgaben zu bewältigen. Diese multimodale Fähigkeit, kombiniert mit niedriger Latenz, ist eines der definierenden technischen Verkaufsargumente des Modells.

Google veröffentlichte interne Benchmark‑Angaben, die eine starke agentische Coding‑Performance hervorheben (S pipeline?) Wait. I must ensure consistent. I'll proceed:

Google veröffentlichte interne Benchmark‑Angaben, die eine starke agentische Coding‑Performance hervorheben (SWE‑bench Verified ~78% für agentische Coding‑Workflows). Zudem nähert sich Flash in vielen Aufgaben Pro‑tauglichem Reasoning an, bleibt dabei jedoch schnell genug für agentische Schleifen und nahezu echtzeitfähige Workflows.

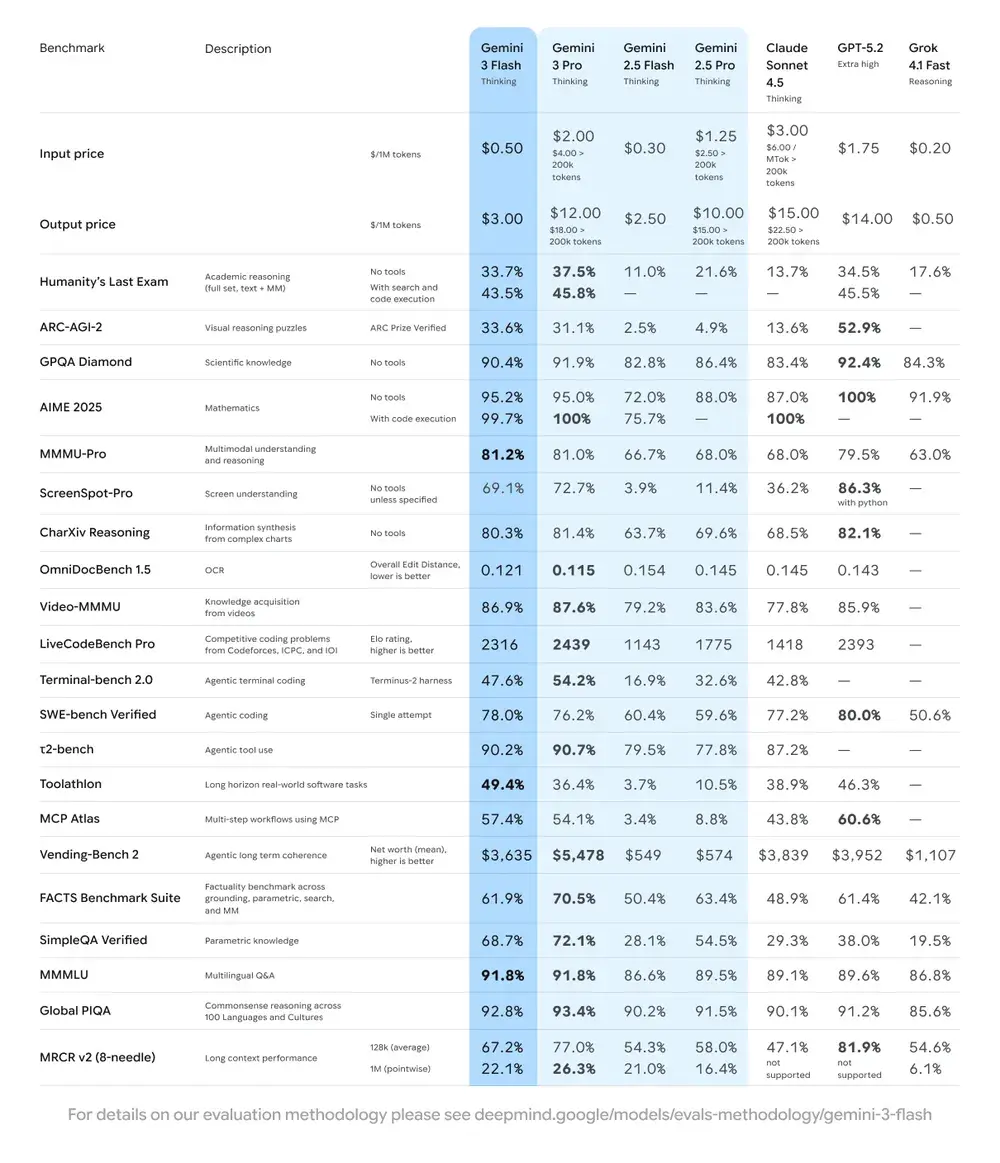

| Benchmark | Punktzahl von Gemini 3 Flash | Vergleichsmodell | Verbesserung |

|---|---|---|---|

| GPQA Diamond (Schlussfolgern auf PhD‑Niveau) | 90,4% | Übertrifft Gemini 2.5 Pro | Deutlich |

| Humanity’s Last Exam (Allgemeinwissens‑Test) | 33,7% (ohne Tools) | Nahe an Gemini 3 Pro | Fortgeschrittenes Reasoning |

| MMMU Pro (Multimodales Verständnis) | 81,2% | Auf Augenhöhe mit Gemini 3 Pro | — |

| SWE‑bench Verified (Benchmark für Codierfähigkeit) | 78% | Höher als Gemini 3 Pro und 2.5‑Serie | Ausgezeichnet |

2) Kosten und Effizienz

Die Entwicklungsphilosophie von Gemini 3 Flash ist die „Pareto‑Front“: also das optimale Gleichgewicht zwischen Geschwindigkeit, Qualität und Kosten zu finden. Gemini 3 Flash ist explizit auf Preis‑Leistungs‑Verhältnis optimiert. Google führt für vergleichbare Aufgaben deutlich niedrigere Preise als bei Pro auf und positioniert Flash dafür, große Mengen von Anfragen zu geringeren Betriebskosten zu verarbeiten. Für viele Workloads ist die Flash‑Variante als kosteneffizienter Standard vorgesehen—beispielsweise liegt der Flash‑Vorschaupreis bei etwa $0.50 pro 1M Input‑Tokens und $3.00 pro 1M Output‑Tokens für die Vorschau‑Stufe von Flash. In der Praxis macht das Flash für hochfrequente Aufgaben attraktiv, bei denen die höheren Kosten pro Token von Pro prohibitiv wären.

Effizienzindikatoren

- Geschwindigkeit: 3× schneller als Gemini 2.5 Pro (basierend auf Tests von Artificial Analysis).

- Token‑Effizienz: Verwendet im Durchschnitt 30% weniger Tokens, um dieselbe Aufgabe zu erledigen. Anders ausgedrückt: Sie erhalten schnellere, bessere Ergebnisse für denselben Geldbetrag.

- Gemini 3 Flash bietet einen „Dynamic Thinking Mode“—passt die Tiefe des Reasonings an die Komplexität der Aufgabe an, „denkt bei Bedarf etwas mehr“ und antwortet bei einfachen Aufgaben schnell.

Praktische Implikationen: Niedrigere Kosten pro Token oder pro Aufruf bedeuten, dass Sie mehr Abfragen, längere Kontexte oder höhere Sampling‑Raten bei gleichem Budget ausführen können. Effizienzgewinne können zudem die Infrastrukturkomplexität reduzieren (weniger Hot‑Instanzen erforderlich) und Zusagen zur Antwortzeit verbessern.

3) Leistungsbenchmark

Gemini 3 Flash erreicht „Frontier‑Klasse“ bei mehreren akademischen und anwendungsnahen Benchmarks und bietet gleichzeitig bessere Latenz und Kosten als frühere Pro‑Modelle. Google präsentiert Zahlen wie hohe Werte bei komplexen Reasoning‑ und Wissens‑Benchmarks (z. B. GPQA‑Varianten), um die Kompetenz zu illustrieren.

Wie verwende ich die Gemini 3 Flash API?

Welche Zugriffsmethode sollte ich verwenden?

- Empfohlen (einfach + robust): Verwenden Sie das SDK‑Integrationsmuster, das Comet zeigt—es richtet einfach ein bestehendes GenAI‑SDK auf Comets Basis‑URL aus und übergibt Ihren Comet‑API‑Schlüssel. Damit müssen Sie Request/Stream‑Parsing nicht selbst nachbauen.

- Alternativ (Raw HTTP / curl / eigene Stacks): Sie können direkt an CometAPI‑Endpoints POSTen (Comet akzeptiert OpenAI‑artige oder providerspezifische Formen). Verwenden Sie

Authorization: Bearer <sk-...>(Comet‑Beispiele nutzen einen Bearer‑Header) und die Modell‑Zeichenkettegemini-3-flashim Body. Bestätigen Sie Pfad und Query‑Parameter in Comets API‑Doku für das gewünschte Modell.

Kurzfassung — was Sie tun werden

- Bei CometAPI registrieren und ein API‑Token erstellen.

- Eine Zugriffsmethode wählen (empfohlen: das unten gezeigte SDK‑Wrapper‑Muster; Fallback: Raw HTTP/cURL).

- Das Modell

gemini-3-flashüber CometAPIs Basis‑URL aufrufen (Comet leitet Ihre Anfrage an Googles Gemini‑Backend weiter). - Streaming / Function‑Calls / multimodale Eingaben gemäß den Modellanforderungen behandeln (Details unten).

Nachfolgend ein kompaktes Beispiel (basierend auf CometAPIs Beispielmustern), wie Sie gemini-3-flash über CometAPI aufrufen; ersetzen Sie <YOUR_COMETAPI_KEY> durch Ihren tatsächlichen Schlüssel. Die Modell‑ID und Endpunkte unten entsprechen der CometAPI‑Doku.

from google import genaiimport os# Holen Sie sich Ihren CometAPI-Schlüssel unter https://api.cometapi.com/console/token und fügen Sie ihn hier einCOMETAPI_KEY = os.environ.get("COMETAPI_KEY") or "<YOUR_COMETAPI_KEY>"BASE_URL = "https://api.cometapi.com"client = genai.Client( http_options={"api_version": "v1beta", "base_url": BASE_URL}, api_key=COMETAPI_KEY,)response = client.models.generate_content( model="gemini-3-flash", contents="Erklären Sie in wenigen Worten, wie KI funktioniert",)print(response.text)

Wichtige Anforderungsparameter, die Sie berücksichtigen sollten

thinking_level— steuert die interne Reasoning‑Tiefe:MINIMAL,LOW,MEDIUM,HIGH. Verwenden SieMINIMALfür die niedrigste Latenz und Kosten, wenn Sie kein tiefes mehrstufiges Reasoning benötigen.media_resolution— für Vision/Video‑Eingaben:low,medium,high,ultra_high. Niedrigere Auflösung reduziert Token‑Äquivalente und Latenz.streamGenerateContentvsgenerateContent— nutzen Sie Streaming für bessere wahrgenommene Latenz, wenn Sie Teilantworten bereits beim Eintreffen anzeigen möchten.- Function‑Calling / JSON‑Modus — verwenden Sie strukturierte Antworten, wenn Sie maschinenparsbarkeit Outputs benötigen.

Multimodale Eingaben senden (praktische Hinweise)

- Bilder/PDFs: Bevorzugen Sie Cloud‑Storage‑URIs (gs://) für große Medien; viele APIs akzeptieren Base64 für kleine Bilder. Achten Sie auf die Token‑Abrechnung pro Modalität—PDFs können je nach Endpoint unter Bild-/Dokumentkontingenten gezählt werden.

- Video/Audio: Für kurze Clips können Sie URIs übergeben; für lange Medien nutzen Sie Batch‑Verarbeitungs‑Workflows oder streamen in Blöcken. Prüfen Sie maximale Eingabegrößen und Encoding‑Vorgaben in der API‑Doku.

- Function‑Calling / Tools: Verwenden Sie strukturierte Funktionsschemata, um JSON‑Ausgaben zu erhalten und sichere Tool‑Aufrufe zu ermöglichen. Gemini 3 Flash unterstützt Streaming‑Function‑Calling für eine bessere UX.

Wo kann ich auf Gemini 3 Flash zugreifen?

Gemini 3 Flash ist auf Googles Consumer‑ und Entwickler‑Oberflächen verfügbar:

- Google Search und die Gemini app — Flash wurde als Standardmodell für den AI‑Modus in Search ausgerollt und ist in die Gemini app‑Erfahrung für Endnutzer integriert.

- Google AI Studio — der unmittelbare Ort für Entwickler, um zu experimentieren und API‑Schlüssel für Tests zu generieren.

- Gemini API (Generative Language / AI Developer API) — verfügbar als

gemini-3-flash-preview(Modell‑ID in Doku/Release‑Notes) und über die Standard‑Endpoints generateContent / streamGenerateContent. - Vertex AI (Google Cloud) — produktionsreifer Zugriff über Vertex AIs Generative‑AI‑Modell‑APIs sowie Preise/Quoten für Enterprise‑Workloads.

- Gemini CLI — für terminalbasiierte Entwicklung und Scripting‑Workflows.

Drittanbieter-Gateway CometAPI

CometAPI hat gemini-3-flash bereits in sein Katalog aufgenommen, und die Modellseite erklärt, wie Sie es über CometAPIs einheitlichen Endpoint aufrufen. Die bereitgestellte Modell‑API ist mit 20% des offiziellen Preises bepreist.

Was sind Best Practices bei der Nutzung von Gemini 3 Flash?

1) thinking_level pro Aufgabe wählen und feinjustieren

- Setzen Sie

MINIMAL/LOWfür einfache Fragen & Antworten und hochfrequente interaktive Aufgaben. - Verwenden Sie

MEDIUM/HIGHselektiv für Aufgaben, die tiefere Gedankenketten oder mehrstufige Planung erfordern. - Benchmarken Sie Kosten vs. Qualität, wenn Sie

thinking_leveländern. Googles Dokumentation warnt, dassthinking_levelinterne Denk‑Signaturen und Latenz verändert.

2) media_resolution verwenden, um Vision‑Compute zu steuern

Wenn Sie Bilder oder Video übergeben, wählen Sie die niedrigste akzeptable media_resolution für die Aufgabe; z. B. low für Thumbnails und Massenauszug, high für visuelle Design‑Kritik. Das reduziert Token‑Äquivalente für Bilder und senkt die Latenz.

3) Strukturierte Ausgaben für Automatisierung bevorzugen

Verwenden Sie JSON‑Modus / Function‑Calling, wenn Ihre Anwendung maschinenparsbare Ausgaben benötigt (z. B. Entitätsextraktion, Tool‑Aufrufe). Das vereinfacht die nachgelagerte Verarbeitung erheblich. Erzwingen Sie nach Möglichkeit strikte JSON‑Schemata und validieren Sie clientseitig.

4) Für lange Antworten großzügig Streaming einsetzen

streamGenerateContent reduziert die wahrgenommene Latenz und erlaubt progressive UI‑Darstellung. Bei langen multimodalen Aufgaben streamen Sie Teilausgaben, damit Nutzer sofort Fortschritt sehen.

5) Kosten mit Caching und Kontextmanagement kontrollieren

- Verwenden Sie Kontext‑Caching für wiederholte Referenzen (Preise und Tokens variieren je nach Modell).

- Vermeiden Sie unnötig lange Kontexte, wenn sie nicht erforderlich sind—bevorzugen Sie prägnante Prompts und nutzen Sie Retrieval + Grounding für große Wissensbasen.

Typische Nutzungsszenarien für Gemini 3 Flash

Hochvolumige Konversations‑Agenten

Flash passt natürlich für Chatbots und Customer‑Support‑Assistenten, die niedrige Latenz und geringe Kosten pro Inferenz benötigen. Mit Streaming‑Support und hohen Tokens/s reduziert Flash wahrgenommene Wartezeiten und Betriebskosten.

Multimodale Assistenten und Dokument‑Pipelines

Da Flash Bilder, PDFs und kurze Videos gut verarbeitet, sind typische Anwendungen u. a. Rechnungsextraktion, multimodales Q&A über Handbücher, Kundensupport mit Bildern und PDF‑Ingestion für Wissensbasen.

Echtzeit‑Videoanalytik und Moderation

Die gemeldete hohe Ausgabegeschwindigkeit (≈218 t/s in Vorabtests) ermöglicht nahezu Echtzeit‑Analyse und ‑Zusammenfassung kurzer Videos, Highlight‑Erkennung und Live‑Content‑Moderations‑Pipelines bei entsprechender Architektur.

Agentisches Entwickler‑Tooling und Code‑Assistenz

SWE‑bench‑Werte und die gemeldete Coding‑Performance machen Flash zu einer guten Option für schnelle Coding‑Assistenten, CLI‑Helfer und andere Entwickler‑Workflows, die niedrige Latenz priorisieren.

Fazit — sollten Sie Gemini 3 Flash jetzt einführen?

Gemini 3 Flash ist ein strategisches Angebot für Teams, die starke Reasoning‑ und multimodale Intelligenz ohne die Latenz und Kosten der High‑End‑Pro‑Modelle benötigen. Das Modell eignet sich besonders für agentische Coding‑Assistenten, interaktive multimodale Agenten, Dokumentverarbeitungs‑Pipelines und jedes System, bei dem niedrige Latenz und Skalierung primäre Anforderungen sind. Frühe Benchmarks (sowohl von Google als auch unabhängige Analysen) deuten darauf hin, dass Flash bei der Qualität konkurrenzfähig ist und gleichzeitig erhebliche Vorteile bei Durchsatz und Kosten bietet.

Zum Einstieg erkunden Sie die Fähigkeiten von Gemini 3 Flash im Playground und konsultieren Sie den API‑Leitfaden für detaillierte Anweisungen. Stellen Sie vor dem Zugriff sicher, dass Sie sich bei CometAPI angemeldet und den API‑Schlüssel erhalten haben. CometAPI bietet einen Preis weit unter dem offiziellen, um Ihnen die Integration zu erleichtern.

Bereit?→ Kostenlose Testversion von Gemini 3 Flash !