Der Markt für Low-Code-Visual-AI-Tools entwickelt sich rasant. Flowise – ein Open-Source-Visual-Builder für LLM-Workflows – erweitert die Community kontinuierlich um Integrationen und veröffentlicht regelmäßig Updates. CometAPI ist einer von mehreren einheitliche KI-API Plattformen, die mittlerweile Hunderte von Modellen über einen einzigen Endpunkt bereitstellen; und No-Code-Backend-Builder wie BuildShip bieten ebenfalls Knoten zum Aufrufen von CometAPI, sodass Sie dieselben Modelle in Server-Workflows integrieren können. Diese Anleitung zeigt, warum und wann diese Teile kombiniert werden sollten, und führt Sie anschließend durch eine konkrete Flowise → CometAPI-Integration, die Integration von Prompt → LLM Chain → CometAPI, empfohlene Best Practices und Anwendungsbeispiele.

Was ist FlowiseAI und warum ist es wichtig?

FlowiseAI ist eine visuelle Open-Source-Plattform zum Erstellen von LLM-Workflows, Chat-Assistenten und Agenten-Pipelines. Sie bietet eine Drag-and-Drop-Leinwand aus Knoten (Integrationen), die Eingabeaufforderungen, Ketten, LLM-Konnektoren, Retriever, Speicher, Tools und Ausgaben darstellen. So können Teams Prototypen von LLM-basierten Systemen erstellen und ausliefern, ohne alles manuell verdrahten zu müssen. Flowise bietet außerdem APIs, Tracing, Evaluierungstools und von der Community gepflegte Knoten und eignet sich daher sowohl für Rapid Prototyping als auch für Produktionsexperimente.

Warum das wichtig ist: Durch die Verwendung von Flowise erhalten Sie visuelle Beobachtbarkeit und schnelle Iteration bei Eingabeaufforderungsketten und Modellauswahlen – und durch das Hinzufügen von Konnektoren von Drittanbietern (wie CometAPI) können Sie mit minimalen Änderungen zwischen vielen zugrunde liegenden Modellen wechseln oder mit ihnen experimentieren.

Was ist CometAPI und was bietet es?

CometAPI ist eine einheitliche API-Schicht, die den Zugriff auf Hunderte von KI-Modellen (OpenAI, Anthropic/Claude, Google/Gemini, Replikationsmodelle, Bild- und Audioanbieter usw.) hinter einem einzigen, konsistenten Anforderungsformat und Authentifizierungsschema. Das bedeutet, dass Sie Modelle auswählen oder austauschen, Kosten/Latenz vergleichen oder programmgesteuert auf verschiedene Anbieter zurückgreifen können, ohne Ihren Anwendungscode neu schreiben zu müssen. Die Plattform ist als kostenmanagement- und herstellerunabhängige Zugriffsebene für LLMs und multimodale Modelle positioniert.

Was Ihnen das in der Praxis bringt: einfachere Anmeldeinformationsverwaltung für die Bewertung mehrerer Modelle, die Möglichkeit, schnell verschiedene Modelle A/B-zu-testen und (häufig) Kostenoptimierung durch Auswahl günstigerer Modellvarianten, wenn dies angebracht ist.

Warum sollten Sie FlowiseAI mit CometAPI integrieren?

Die Integration von Flowise mit CometAPI bietet Ihnen den Komfort des visuellen Builders von Flowise und gleichzeitig zentralen Zugriff auf viele Modell-Backends über CometAPI. Zu den Vorteilen gehören:

- Einheitliche Anmeldeinformationsverwaltung für mehrere Modell-Endpunkte (über CometAPI).

- Einfaches Modell A/Bing und Routing auf Anbieterebene innerhalb einer visuellen Kette (Modelle wechseln, ohne die Knotenverdrahtung zu ändern).

- Schnelleres Experimentieren: Tauschen Sie Modelle aus, passen Sie Eingabeaufforderungen an und vergleichen Sie Ausgaben innerhalb von Flowise-Flows.

- Geringere technische Reibungsverluste für Teams, die eine visuelle Orchestrierungsebene wünschen, aber im Hintergrund mehrere Modellanbieter benötigen.

- Warum sollten Sie FlowiseAI mit CometAPI integrieren?

- Die Integration von Flowise mit CometAPI bietet Ihnen den Komfort des visuellen Builders von Flowise und gleichzeitig zentralen Zugriff auf viele Modell-Backends über CometAPI. Zu den Vorteilen gehören:

- Einheitliche Anmeldeinformationsverwaltung für mehrere Modell-Endpunkte (über CometAPI).

- Einfaches Modell A/Bing und Routing auf Anbieterebene innerhalb einer visuellen Kette (Modelle wechseln, ohne die Knotenverdrahtung zu ändern).

- Schnelleres Experimentieren: Tauschen Sie Modelle aus, passen Sie Eingabeaufforderungen an und vergleichen Sie Ausgaben innerhalb von Flowise-Flows.

- Geringere technische Reibungsverluste für Teams, die eine visuelle Orchestrierungsebene wünschen, aber im Hintergrund mehrere Modellanbieter benötigen.

- Diese Funktionen beschleunigen die RAG-Setups, die Agenten-Orchestrierung und die Arbeitsabläufe bei der Modellzusammenstellung, während die visuelle Herkunft und Rückverfolgbarkeit, die Flowise bietet, erhalten bleibt.

Diese Funktionen beschleunigen RAG-Setups, Agenten-Orchestrierung und Modellkompositions-Workflows, während die visuelle Herkunft und Rückverfolgbarkeit Flowise bietet.

Welches Umfeld und welche Voraussetzungen benötigen Sie vor der Integration?

Checkliste (mindestens):

- Einloggen in FlowiseAI

- A CometAPI Konto + API-Schlüssel (diesen erhalten Sie von der CometAPI-Konsole). Hinweis: CometAPI verwendet einen Basispfad (z. B.

https://api.cometapi.com/v1/) für Anfragen – das geben Sie in den Flowise-Knoteneinstellungen an.

Sicherheits- und Betriebsvorbereitungen:

- Speichern Sie API-Schlüssel in Flowise-Anmeldeinformationen – fügen Sie keine Schlüssel in Eingabeaufforderungsvorlagen oder Knotencode ein.

- Planen Sie Kontingent- und Ratenbegrenzungen: Sowohl CometAPI als auch die zugrunde liegenden Modellanbieter können Begrenzungen festlegen. Überprüfen Sie Ihren Plan und wenden Sie bei Bedarf eine clientseitige Drosselung oder Wiederholungsversuche an.

- Kosten beachten: Beim Modellwechsel können sich Token-Nutzung und -Kosten erheblich ändern – instrumentieren Sie Metriken und legen Sie Leitplanken fest.

Wie integriere ich CometAPI mit FlowiseAI? (Finden und fügen Sie den CometAPI-Knoten hinzu – wie sind die Schritte?)

Befolgen Sie diese praktischen Schritte, um die ChatCometAPI Knoten und konfigurieren Sie die Anmeldeinformationen.

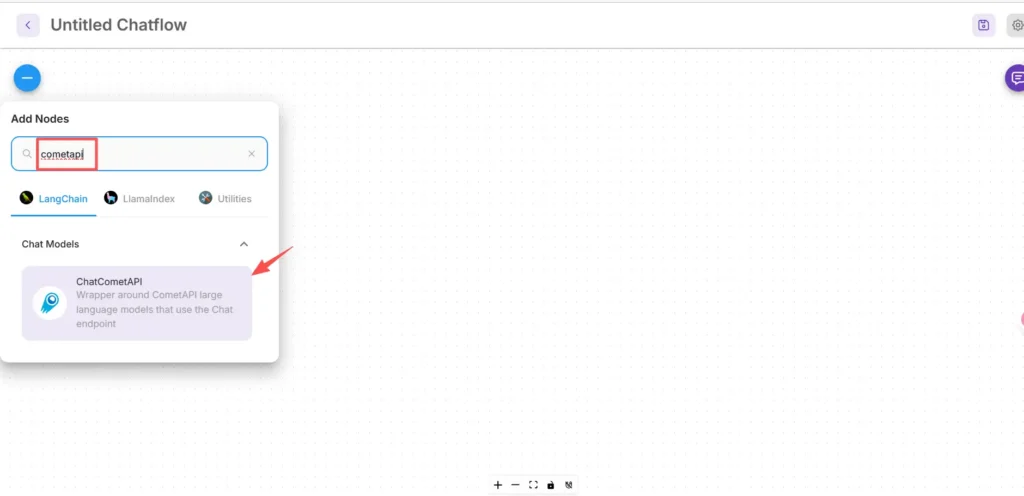

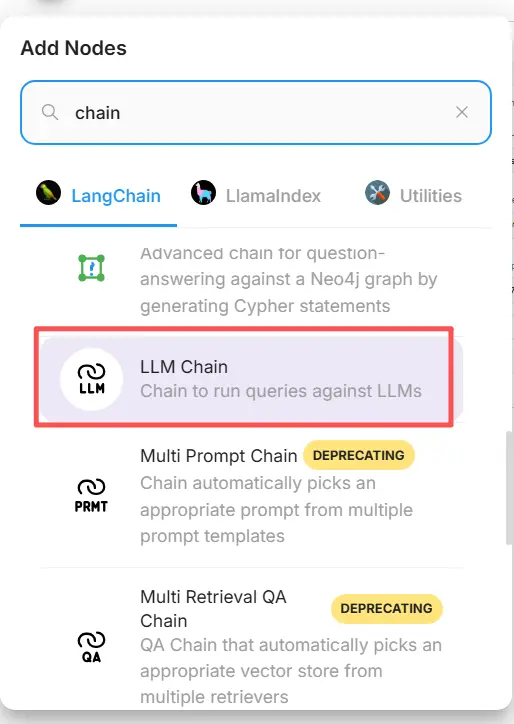

Schritt 1 – Bestätigen Sie, dass der Knoten verfügbar ist

- Klicken Sie in der FlowiseAI-Leinwand auf „Neu hinzufügen“.

- Geben Sie im Suchfeld „cometapi“ ein und suchen Sie nach „cometapi“, um das CometAPI-Feld zu finden. Einige Community-Knoten werden unter LangChain → Chat-Modelle angezeigt.

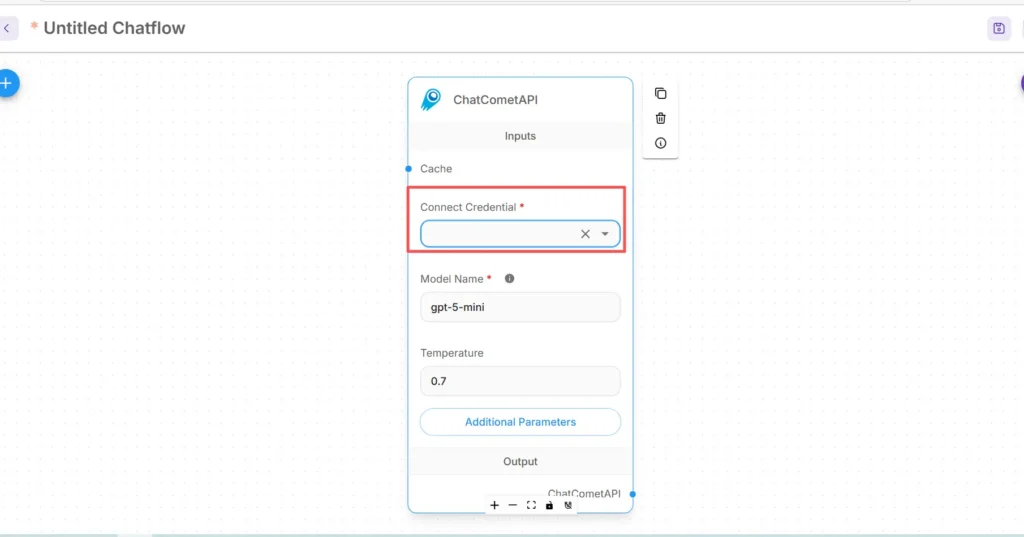

Schritt 2 – Fügen Sie den CometAPI-Knoten zu Ihrem Flow hinzu

- Ziehen Sie die ChatCometAPI Knoten in Ihren Arbeitsbereich. Der Knoten stellt Modellauswahl, Temperatur, maximale Token und andere Inferenzparameter bereit.

- Stellen Sie ein Start/Eingabe Knoten (oder Ihr Chatbot-Frontknoten) vor dem CometAPI-Knoten.

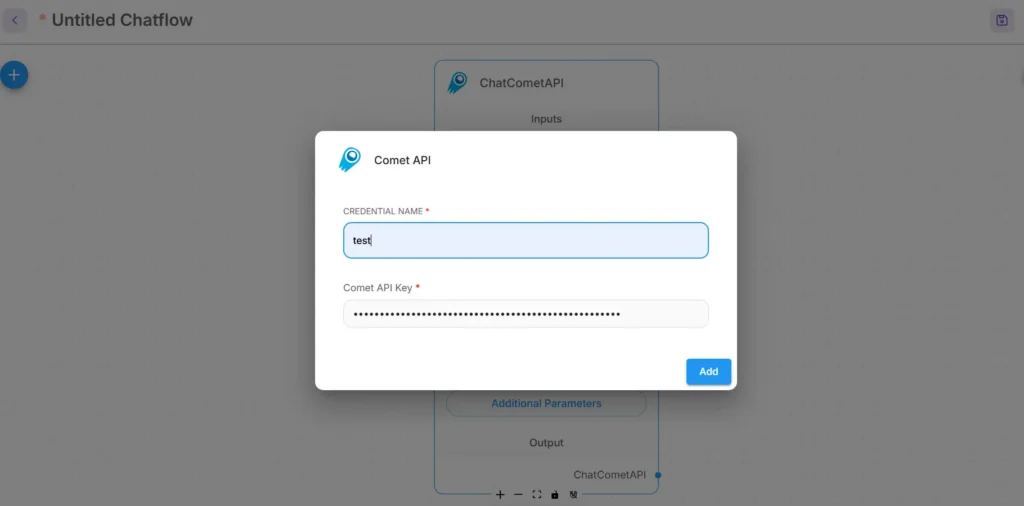

Schritt 3 – Anmeldeinformationen für CometAPI konfigurieren

- Wählen Sie im Dropdown-Menü Connect Credential des CometAPI-Knotens die Option Create New aus und suchen Sie nach API-Schlüssel / Aus- und Fortbildungen Feld. (In Flowise oder offen Aus- und Fortbildungen)

- Geben Sie Ihre CometAPI API-Schlüssel (vorzugsweise über den Anmeldeinformationsmanager von Flowise oder als Umgebungsvariable). Verwenden Sie in der Produktion die Geheimnisverwaltung

- Wählen Sie das zugrunde liegende Standardmodell (oder lassen Sie es über die Knoteneingaben einstellbar, wenn Sie das Laufzeitmodell wechseln möchten). CometAPI akzeptiert normalerweise ein

modelParameter, der angibt, welcher Anbieter/welches Modell verwendet werden soll.

Schritt 4 – Legen Sie den Basispfad und zusätzliche Parameter fest.

Erweitern Sie in den ChatCometAPI-Knoteneinstellungen Zusätzliche Parameter und setze die Basispfad zu https://api.cometapi.com/v1/ (Dies ist erforderlich, damit der Knoten auf das v1-Gateway von CometAPI verweist.) Passen Sie optional den Standardmodellnamen oder die von CometAPI unterstützten Anbieterparameter an.

Tipps zur Fehlerbehebung:

- Wenn Anrufe fehlschlagen, überprüfen Sie den Netzwerkausgang und alle Firewall-/NAT-Regeln zwischen Flowise- und CometAPI-Endpunkten.

- Überprüfen Sie die von CometAPI zurückgegebenen Ratenbegrenzungen und Fehlerantworten. Implementieren Sie einen exponentiellen Backoff auf 429/5xx.

Wie füge ich einen Prompt-Knoten hinzu und richte die LLM-Kette in Flowise ein?

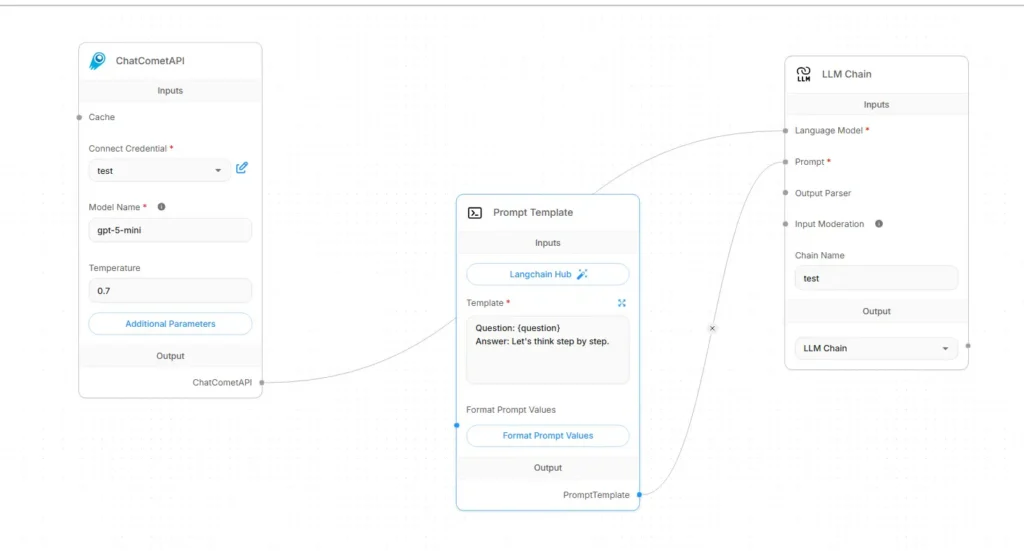

Flowise LLM-Flüsse werden typischerweise wie folgt zusammengestellt: Eingabe → Eingabeaufforderungsvorlage → LLM-Kette → Ausgabe. Hier ist ein konkretes Verdrahtungsrezept mit CometAPI als Sprachmodell:

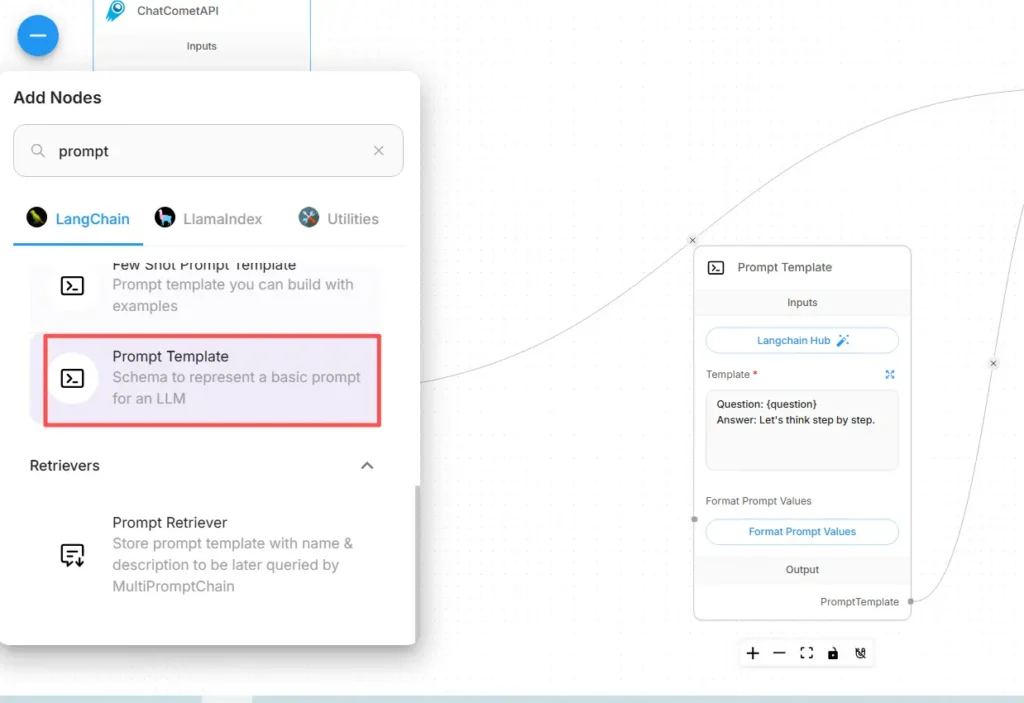

Schritt A – Erstellen eines Eingabeaufforderungsvorlagenknotens

- Hinzufügen Eingabeaufforderungsvorlage Knoten (oder „Prompt“-Knoten) zur Leinwand.

- Erstellen Sie im Eingabeaufforderungsknoten Ihre Vorlage mit Variablen für dynamische Inhalte, z. B.:

You are an expert SRE. Given the following user question: {{user_input}}

Produce a step-by-step diagnostic plan and concise summary.

- Entlarven

user_inputals auszufüllende Variable aus dem Start-/Eingabeknoten.

Schritt B – Hinzufügen eines LLM-Kettenknotens (LLM-Wrapper)

Fügen Sie ein ein LLM-Kette or LLM Knoten, der einen Prompt → Modellaufruf darstellt. In Flowise hat der LLM-Kettenknoten normalerweise zwei Haupteingaben: Sprachmodell (der Modell-/Inferenzknoten) und Prompt (die Eingabeaufforderungsvorlage).

Schritt C – Verbinden der Knoten (explizite Verdrahtung)

- Verbinden Sie den CometAPI-Knoten mit der LLM-Kette Sprachmodell Eingang.

Dadurch wird der Kette mitgeteilt, welches Modell zur Generierung aufgerufen werden soll. (CometAPI wird zum Modellanbieter.) - Verbinden Sie den Prompt Template-Knoten mit der LLM-Kette Prompt Eingang.

Die Kette kombiniert die Eingabeaufforderungsvorlage mit den Variablenwerten und sendet die resultierende Eingabeaufforderung an CometAPI. - Verbinden Sie den Start/Input-Knoten mit der Eingabeaufforderungsvorlage

user_inputvariabel. - Verbinden Sie den LLM-Kettenausgang mit dem Ausgangsknoten (UI-Antwort oder nachgelagertes Tool).

Visuell sollte der Ablauf folgendermaßen aussehen:

Start/Input → Prompt Template → LLM Chain (Language Model = CometAPI node) → Output

Schritt D – Testen Sie mit einem Probelauf

- Führen Sie den Flow in der Testkonsole von Flowise aus. Überprüfen Sie die an CometAPI gesendete Eingabeaufforderung, Antwort-Token und Latenz. Passen Sie Temperatur, maximale Token oder Top-P in den CometAPI-Knoteneinstellungen an, um Kreativität vs. Determinismus zu optimieren.

Welche praktischen Anwendungsfälle ermöglicht diese Integration?

Nachfolgend finden Sie überzeugende Anwendungsfälle, bei denen Flowise + CometAPI konkrete Vorteile bietet:

1) Multi-Modell-Routing / Auswahl des besten Tools

Erstellen Sie Flows, die Modelle pro Unteraufgabe auswählen: schnelle Zusammenfassung mit einem kostengünstigen Modell, faktische Grundlage mit einem hochpräzisen Modell und Bildgenerierung über ein Bildmodell – alles über CometAPI-Parameter, ohne die Flowise-Verdrahtung zu ändern.

2) Modell-A/B-Tests und -Bewertung

Starten Sie zwei parallele LLM-Ketten in Flowise (A vs. B), leiten Sie dieselbe Eingabeaufforderung an verschiedene CometAPI-Modelloptionen weiter und geben Sie die Ergebnisse an einen kleinen Vergleichsknoten weiter, der die Ergebnisse bewertet. Verwenden Sie Metriken, um zu entscheiden, welches Modell übernommen werden soll.

3) Hybrid-RAG (Retriever + LLM)

Nutzen Sie den Dokumentenspeicher und den Vektorabruf von Flowise, um Kontext zu erfassen, und senden Sie anschließend eine kombinierte Eingabeaufforderungsvorlage an das CometAPI-Modell. Die einheitliche API vereinfacht den Austausch des für die endgültige Synthese verwendeten LLM.

4) Agenten-Tools (APIs, DBs, Code)

Erstellen Sie Tools (HTTP GET/POST, DB-Aufrufe) in Flowise-Agenten, verwenden Sie CometAPI für Sprachbegründung und Aktionsauswahl und leiten Sie Ausgaben an Konnektoren/Tools weiter. Flowise unterstützt hierfür Anforderungstools und Agentenmuster.

Erste Schritte

CometAPI ist eine einheitliche API-Plattform, die über 500 KI-Modelle führender Anbieter – wie die GPT-Reihe von OpenAI, Gemini von Google, Claude von Anthropic, Midjourney, Suno und weitere – in einer einzigen, entwicklerfreundlichen Oberfläche vereint. Durch konsistente Authentifizierung, Anforderungsformatierung und Antwortverarbeitung vereinfacht CometAPI die Integration von KI-Funktionen in Ihre Anwendungen erheblich. Ob Sie Chatbots, Bildgeneratoren, Musikkomponisten oder datengesteuerte Analyse-Pipelines entwickeln – CometAPI ermöglicht Ihnen schnellere Iterationen, Kostenkontrolle und Herstellerunabhängigkeit – und gleichzeitig die neuesten Erkenntnisse des KI-Ökosystems zu nutzen.

Erkunden Sie zunächst die Möglichkeiten des Modells in der Spielplatz und konsultieren Sie die Flowise API-Leitfaden Für detaillierte Anweisungen. Stellen Sie vor dem Zugriff sicher, dass Sie sich bei CometAPI angemeldet und den API-Schlüssel erhalten haben. CometAPI bieten einen Preis weit unter dem offiziellen Preis an, um Ihnen bei der Integration zu helfen.

Bereit loszulegen? → Melden Sie sich noch heute für CometAPI an !

Abschließende Empfehlungen und Zusammenfassung

Die Integration von Flowise mit CometAPI ist eine pragmatische Möglichkeit, schnelle visuelle Orchestrierung (Flowise) mit flexiblem Zugriff auf viele Modellanbieter (CometAPI) zu kombinieren. Das Muster – Eingabeaufforderungen als Vorlagen speichern, Modellknoten entkoppeln und Abläufe sorgfältig instrumentieren – ermöglicht Teams schnelle Iterationen und den Anbieterwechsel, ohne Flows neu schreiben zu müssen. Denken Sie daran, Anmeldeinformationen sicher zu verwalten, Latenz und Kosten zu berücksichtigen und Ihre Flows für Beobachtbarkeit und Governance zu instrumentieren.