Kimi K2 API ist ein Open-Source-Sprachmodell mit Billionen Parametern und einem Mixture-of-Experts-Sprachmodell mit einem Kontextfenster von 256 Token, das für Hochleistungscodierung, agentenbasiertes Schlussfolgern und effiziente Inferenz optimiert ist.

Kimi K2-0905 ist das neueste KI-Modell von Darkside of the Moon Technology Co., Ltd. Es bietet leistungsstarke Programmierunterstützung und zeichnet sich durch hervorragende Codegenerierung und Front-End-Entwicklung aus. Die Kontextlänge beträgt 256 KB und unterstützt so komplexe Aufgaben. Die Hochgeschwindigkeits-API-Ausgabegeschwindigkeit des Modells erreicht 60–100 Token/Sekunde und sorgt so für schnelle Reaktionszeiten.

Das Modell ist mit der Anthropic API kompatibel, unterstützt das WebSearch Tool und bietet ein verbessertes Claude Code-Erlebnis. Es bietet außerdem automatisches Kontext-Caching zur Reduzierung der Benutzerkosten. Benutzer können es jetzt über CometAPI (kimi-k2-250905).

Grundlegende Informationen und Funktionen

- Modellname: Kimi K2

- Die Architektur: Expertenmischung (MoE)

- Gesamtparameter: 1 Billion

- Aktivierte Parameter: 32 Milliarden pro Vorwärtspass

- Kontextlänge: 256 Token

- Wortschatzgröße: 160 Token

- Primäre Anwendungsfälle: Codierung, Tool-Integration, Zerlegung komplexer Aufgaben, allgemeines Denken.

Technische Architektur

Kimi K2 verwendet eine 384-Experten-MoE Design, Auswahl 8 Experten pro Token um Leistung und Inferenzeffizienz in Einklang zu bringen. Es umfasst 61-Schichteneinschließlich 1 dichte Schicht, und verwendet Mehrschichtige Aufmerksamkeit (MLA) neben dem SwiGLU Aktivierungsfunktion. Das Training nutzte die Myon-Optimierer übrig 15.5 Billionen Token, wodurch Stabilität und hoher Durchsatz bei verschiedenen Benchmarks gewährleistet werden.

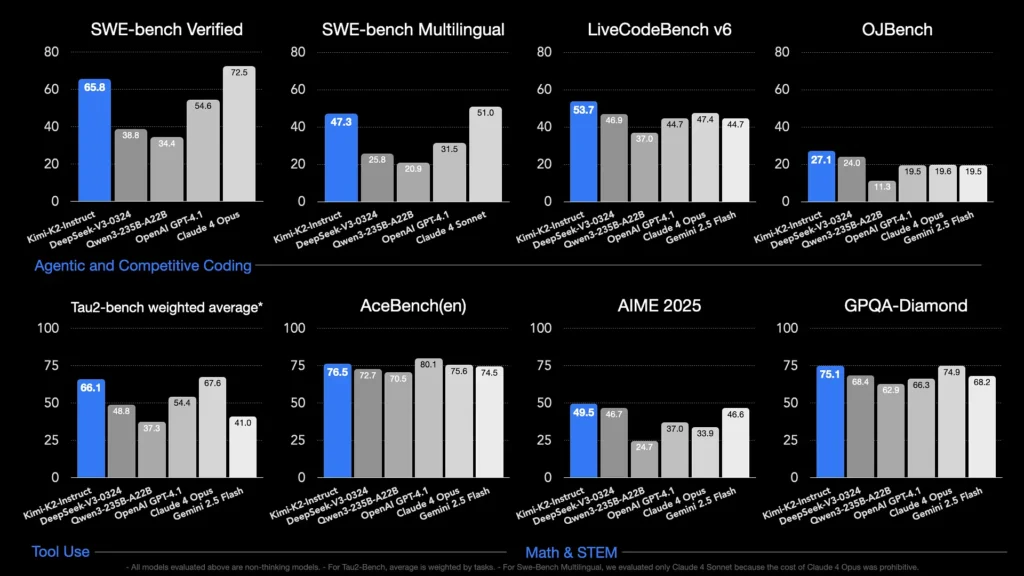

Benchmark-Leistung

- SWE‑bench Verifiziert: 65.8 % Genauigkeit bei einem einzelnen Versuch – übertrifft die 4.1 % von GPT-54.6 und liegt unter den Topmodellen nur hinter Claude Sonnet 4.

- Mehrsprachige SWE‑Bench: 47.3 % Genauigkeit, führender Open-Source-Anbieter.

- LiveCodeBench: 53.7 %, der höchste Wert unter den nicht proprietären Modellen.

- EvalPlus: 80.3 und übertrifft damit die Serien DeepSeek‑V3 und Qwen 2.5.

Diese Ergebnisse unterstreichen Kimi K2s modernste Programmierkenntnisse und robuste Denkfähigkeiten.

So rufen Sie die Kimi K2-API von CometAPI aus auf

Kimi K2 API-Preise in CometAPI, 20 % Rabatt auf den offiziellen Preis:

- Eingabetoken: 0.11 $/M Token

- Ausgabe-Token: 1.99 $/M Token

Erforderliche Schritte

- Einloggen in cometapi.comWenn Sie noch nicht unser Benutzer sind, registrieren Sie sich bitte zuerst

- Holen Sie sich den API-Schlüssel für die Zugangsdaten der Schnittstelle. Klicken Sie im persönlichen Bereich beim API-Token auf „Token hinzufügen“, holen Sie sich den Token-Schlüssel: sk-xxxxx und senden Sie ihn ab.

- Holen Sie sich die URL dieser Site: https://api.cometapi.com/

Methode verwenden

- Wählen Sie das "

kimi-k2-0711-preview”-Endpunkt, um die API-Anfrage zu senden und den Anfragetext festzulegen. Die Anfragemethode und der Anfragetext stammen aus der API-Dokumentation unserer Website. Unsere Website bietet außerdem einen Apifox-Test für Ihre Bequemlichkeit. - Ersetzen mit Ihrem aktuellen CometAPI-Schlüssel aus Ihrem Konto.

- Geben Sie Ihre Frage oder Anfrage in das Inhaltsfeld ein – das Modell antwortet darauf.

- . Verarbeiten Sie die API-Antwort, um die generierte Antwort zu erhalten.

CometAPI bietet eine vollständig kompatible REST-API für eine nahtlose Migration. Wichtige Details zu API-Dokument:

- Basis-URL: https://api.cometapi.com/v1/chat/completions

- Modellnamen: "

kimi-k2-250905" - Authentifizierung: Inhabertoken über

Authorization: Bearer YOUR_CometAPI_API_KEYKopfzeile - Content-Type:

application/json.

API-Integration und Beispiele

Kimi K2 ist erreichbar über CometAPI (OpenAI‑kompatibel) und die Moonshot AI APIUnten sehen Sie einen Python-Ausschnitt für eine Chat-Abschluss Aufruf über CometAPI:

Python-Snippet für eine Chat-Abschluss Aufruf über CometAPI:

pythonimport openai

openai.api_key = "YOUR_CometAPI_API_KEY"

openai.api_base = "https://api.cometapi.com/v1/chat/completions"

messages = [

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": "Summarize Kimi K2's main features."}

]

response = openai.ChatCompletion.create(

model="kimi-k2-250905",

messages=messages,

temperature=0.7,

max_tokens=500

)

print(response.choices.message)