Die Llama 4 API ist eine leistungsstarke Schnittstelle, die es Entwicklern ermöglicht, MetaDie neuesten multimodalen großen Sprachmodelle von ermöglichen erweiterte Text-, Bild- und Videoverarbeitungsfunktionen für verschiedene Anwendungen.

Übersicht der Llama 4-Serie

Die Llama 4-Serie von Meta führt hochmoderne KI-Modelle ein, die für die Verarbeitung und Übersetzung verschiedener Datenformate wie Text, Video, Bilder und Audio entwickelt wurden und so die Anwendungsvielfalt erhöhen. Die Serie umfasst:

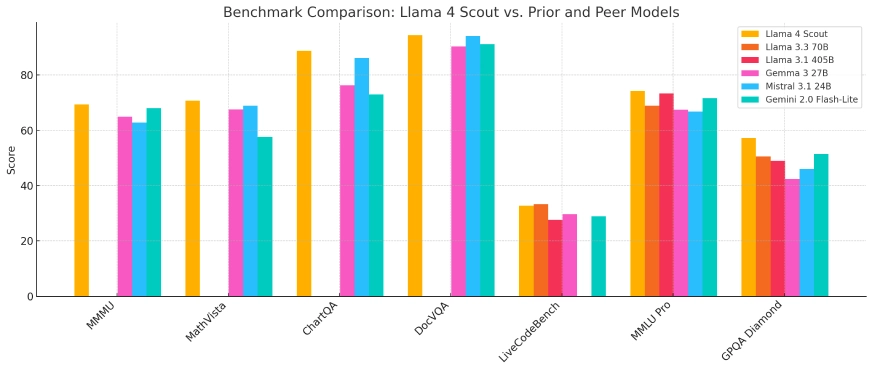

- Lama 4 Scout: Ein kompaktes Modell, das für die Bereitstellung auf einer einzelnen Nvidia H100-GPU optimiert ist und über ein Kontextfenster mit 10 Millionen Token verfügt. Es übertrifft Konkurrenten wie Gemma 3 und Mistral 3.1 von Google in verschiedenen Benchmarks.

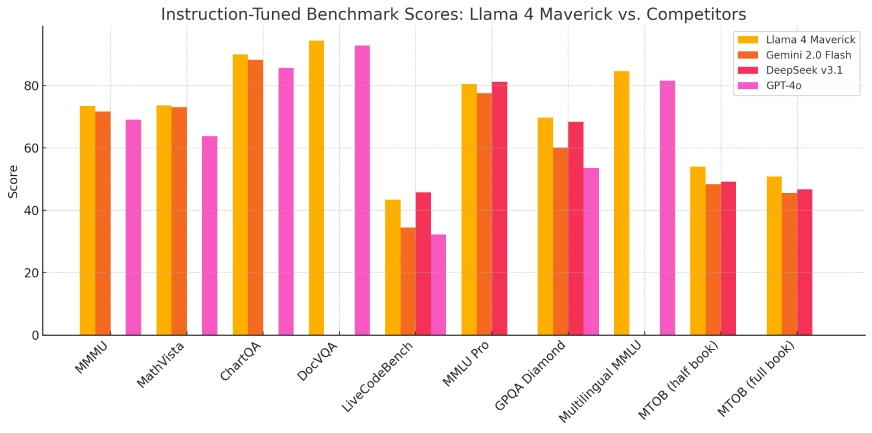

- Lama 4 Maverick: Ein größeres Modell, dessen Leistung bei Codierungs- und Argumentationsaufgaben mit GPT-4o und DeepSeek-V3 von OpenAI vergleichbar ist, das jedoch weniger aktive Parameter nutzt.

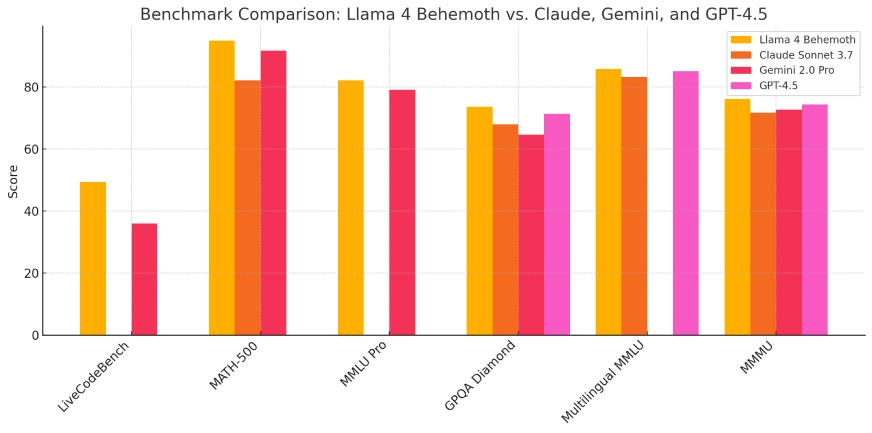

- Lama 4 Behemoth: Dieses Modell befindet sich derzeit in der Entwicklung und verfügt über 288 Milliarden aktive Parameter und insgesamt 2 Billionen. Ziel ist es, Modelle wie GPT-4.5 und Claude Sonnet 3.7 bei MINT-Benchmarks zu übertreffen.

Diese Modelle sind in den KI-Assistenten von Meta auf Plattformen wie WhatsApp, Messenger, Instagram und im Internet integriert und verbessern die Benutzerinteraktion mit erweiterten KI-Funktionen.

| Modell | Gesamtparameter | Aktive Parameter | Experten | Kontextlänge | Läuft auf | Öffentlicher Zugang | Ideal für |

|---|---|---|---|---|---|---|---|

| Kundschafter | 109 Mrd | 17 Mrd | 16 | 10 Millionen Token | Einzelne Nvidia H100 | ✅ ja | Leichtgewichtige KI-Aufgaben, Apps mit langem Kontext |

| Maverick | 400 Mrd | 17 Mrd | 128 | Keine Angabe | Einzel- oder Multi-GPU | ✅ ja | Forschung, Unternehmensanwendungen, Codierung |

| Behemoth | ~2T | 288 Mrd | 16 | Keine Angabe | Meta interne Infra | ❌ Nein | Internes Modelltraining und Benchmarking |

Technische Architektur und Innovationen

Die Llama 4-Serie verwendet eine „Mixture of Experts“-Architektur (MoE), einen innovativen Ansatz, der die Ressourcennutzung optimiert, indem bei bestimmten Aufgaben nur relevante Teilmengen der Modellparameter aktiviert werden. Dieses Design verbessert die Rechenleistung und -effizienz und ermöglicht es den Modellen, komplexe Aufgaben effektiver zu bewältigen.

Das Training dieser Modelle erforderte erhebliche Rechenressourcen. Meta nutzte einen GPU-Cluster mit über 100,000 Nvidia H100-Chips, der eine der bislang größten KI-Trainingsinfrastrukturen darstellt. Diese umfangreiche Rechenleistung ermöglichte die Entwicklung von Modellen mit verbesserten Fähigkeiten und Leistungskennzahlen.

Weiterentwicklung früherer Modelle

Aufbauend auf den Grundlagen früherer Iterationen stellt die Llama 4-Serie eine bedeutende Weiterentwicklung der KI-Modellentwicklung von Meta dar. Die Integration multimodaler Verarbeitungsfunktionen und die Übernahme der MoE-Architektur beseitigen die bei früheren Modellen beobachteten Einschränkungen, wie z. B. Herausforderungen beim Schlussfolgerungs- und Mathematikverständnis. Diese Fortschritte machen Llama 4 zu einem starken Konkurrenten in der KI-Landschaft.

Benchmark-Leistung und technische Indikatoren

In Benchmark-Bewertungen zeigte Llama 4 Scout eine überlegene Leistung gegenüber Modellen wie Gemma 3 und Mistral 3.1 von Google, insbesondere bei Aufgaben mit umfangreicher Kontextverarbeitung. Llama 4 Maverick zeigte Fähigkeiten, die mit führenden Modellen wie GPT-4o von OpenAI vergleichbar waren, insbesondere bei Codierungs- und Schlussfolgerungsaufgaben, und zeichnete sich gleichzeitig durch eine effizientere Parameternutzung aus. Diese Ergebnisse unterstreichen die Effektivität der MoE-Architektur und des umfangreichen Trainingsprogramms.

Lama 4 Scout

Lama 4 Maverick

Lama 4 Behemoth:

Anwendungsszenarien

Die Vielseitigkeit der Llama 4-Serie ermöglicht ihren Einsatz in verschiedenen Bereichen:

- Social Media-Integration: Verbesserung der Benutzerinteraktionen auf Plattformen wie WhatsApp, Messenger und Instagram durch erweiterte KI-gesteuerte Funktionen, einschließlich verbesserter Inhaltsempfehlungen und Konversationsagenten.

- Content Creation: Unterstützung von Kreativen bei der Erstellung hochwertiger, multimodaler Inhalte durch die Verarbeitung und Synthese von Text, Bildern und Videos, wodurch der kreative Prozess optimiert wird.

- Bildungswerkzeuge: Erleichterung der Entwicklung intelligenter Tutorensysteme, die verschiedene Datenformate interpretieren und darauf reagieren können und so ein intensiveres Lernerlebnis bieten.

- Geschäftsanalysen: Ermöglicht Unternehmen, komplexe Datensätze, einschließlich Text- und Bildinformationen, zu analysieren und zu interpretieren, um umsetzbare Erkenntnisse zu gewinnen und Entscheidungsprozesse zu unterstützen.

Die Integration der Llama 4-Modelle in die Plattformen von Meta verdeutlicht ihren praktischen Nutzen und ihr Potenzial, das Benutzererlebnis in verschiedenen Anwendungen zu verbessern.

Ethische Überlegungen und Open-Source-Strategie

Meta bewirbt die Llama 4-Reihe zwar als Open Source, die Lizenzbedingungen enthalten jedoch Einschränkungen für kommerzielle Unternehmen mit über 700 Millionen Nutzern. Dieser Ansatz hat Kritik der Open Source Initiative hervorgerufen und verdeutlicht die anhaltende Debatte über das Gleichgewicht zwischen Open Access und kommerziellen Interessen in der KI-Entwicklung.

Die beträchtlichen Investitionen von Meta, angeblich bis zu 65 Milliarden US-Dollar in die KI-Infrastruktur, unterstreichen das Engagement des Unternehmens, die KI-Fähigkeiten voranzutreiben und in der sich schnell entwickelnden KI-Landschaft einen Wettbewerbsvorteil zu behalten.

Fazit

Die Einführung der Llama 4-Serie von Meta markiert einen entscheidenden Fortschritt in der künstlichen Intelligenz und zeigt deutliche Verbesserungen bei multimodaler Verarbeitung, Effizienz und Leistung. Dank innovativer Architekturen und erheblicher Rechenleistung setzen diese Modelle neue Maßstäbe in der KI-Fähigkeit. Da Meta diese Modelle weiterhin plattformübergreifend integriert und weitere Entwicklungen erforscht, wird die Llama 4-Serie die zukünftige Entwicklung von KI-Anwendungen und -Diensten entscheidend mitgestalten.

So rufen Sie die Llama 4-API von CometAPI auf

1.Anmelden zu cometapi.comWenn Sie noch nicht unser Benutzer sind, registrieren Sie sich bitte zuerst

2.Holen Sie sich den API-Schlüssel für die Zugangsdaten der Schnittstelle. Klicken Sie im persönlichen Center beim API-Token auf „Token hinzufügen“, holen Sie sich den Token-Schlüssel: sk-xxxxx und senden Sie ihn ab.

-

Holen Sie sich die URL dieser Site: https://api.cometapi.com/

-

Wählen Sie das Llama 4 (Modellname: Lama-4-Maverick; Lama-4-Scout)-Endpunkt, um die API-Anforderung zu senden und den Anforderungstext festzulegen. Die Anforderungsmethode und der Anforderungstext werden abgerufen von unser Website-API-Dokument. Unsere Website bietet zu Ihrer Bequemlichkeit auch einen Apifox-Test.

- Informationen zum Modellstart in der Comet-API finden Sie unter https://api.cometapi.com/new-model.

- Informationen zu Modellpreisen in der Comet-API finden Sie unter https://api.cometapi.com/pricing

| Kategorie | Lama-4-Maverick | Lama-4-Scout |

| API-Preise | Eingabe-Token: 0.48 $ / M Token | Eingabe-Token: 0.216 $ / M Token |

| Ausgabe-Token: 1.44 $/M Token | Ausgabe-Token: 1.152 $/M Token |

- Verarbeiten Sie die API-Antwort, um die generierte Antwort zu erhalten. Nach dem Senden der API-Anfrage erhalten Sie ein JSON-Objekt mit der generierten Vervollständigung.