Was ist die GPT-5.2-API

Die GPT-5.2-API entspricht GPT-5.2 Thinking in ChatGPT. GPT-5.2 Thinking ist die mittlere Variante der GPT-5.2-Familie von OpenAI, konzipiert für tiefere Arbeit: mehrstufiges Reasoning, Zusammenfassung langer Dokumente, hochwertige Codegenerierung und professionelle Wissensarbeit, bei der Genauigkeit und nutzbare Struktur wichtiger sind als reiner Durchsatz. In der API ist es als Modell gpt-5.2 verfügbar (Responses API / Chat Completions) und liegt zwischen der latenzarmen Instant-Variante und der hochwertigeren, aber teureren Pro-Variante.

Hauptfunktionen

- Sehr langer Kontext & Verdichtung: 400K effektives Kontextfenster und Verdichtungswerkzeuge, um Relevanz über lange Unterhaltungen und Dokumente hinweg zu steuern.

- Konfigurierbarer Reasoning-Aufwand:

none | medium | high | xhigh(xhigh aktiviert maximale interne Rechenleistung für schwieriges Reasoning).xhighist in den Thinking/Pro-Varianten verfügbar. - Stärkere Tool- und Funktionsunterstützung: First-Class-Toolaufrufe, Grammatiken (CFG/Lark) zur Einschränkung strukturierter Ausgaben und verbesserte agentische Verhaltensweisen, die komplexe mehrstufige Automatisierung vereinfachen.

- Multimodales Verständnis: reichere Bild- und Textverarbeitung und Integration in mehrstufige Aufgaben.

- Verbesserte Sicherheit/Umgang mit sensiblen Inhalten: gezielte Maßnahmen zur Reduzierung unerwünschter Antworten in Bereichen wie Selbstschädigung und anderen sensiblen Kontexten.

Technische Fähigkeiten & Spezifikationen (Entwicklersicht)

- API-Endpunkte & Modell-IDs:

gpt-5.2für Thinking (Responses API),gpt-5.2-chat-latestfür Chat/Instant-Workflows undgpt-5.2-profür die Pro-Stufe; verfügbar über Responses API und Chat Completions, wo angegeben. - Reasoning-Tokens & Aufwandssteuerung: Die API unterstützt explizite Parameter zur Zuweisung von Rechenleistung (Reasoning-Aufwand) pro Anfrage; höherer Aufwand erhöht Latenz und Kosten, verbessert jedoch die Ausgabequalität für komplexe Aufgaben.

- Werkzeuge für strukturierte Ausgaben: Unterstützung für Grammatiken (Lark/CFG), um die Modellausgabe auf eine DSL oder exakte Syntax zu beschränken (nützlich für SQL, JSON, DSL-Generierung).

- Paralleler Toolaufruf & agentische Koordination: Verbesserter Parallelismus und sauberere Tool-Orchestrierung verringern den Bedarf an aufwendigen Systemprompts und Multi-Agent-Gerüsten.

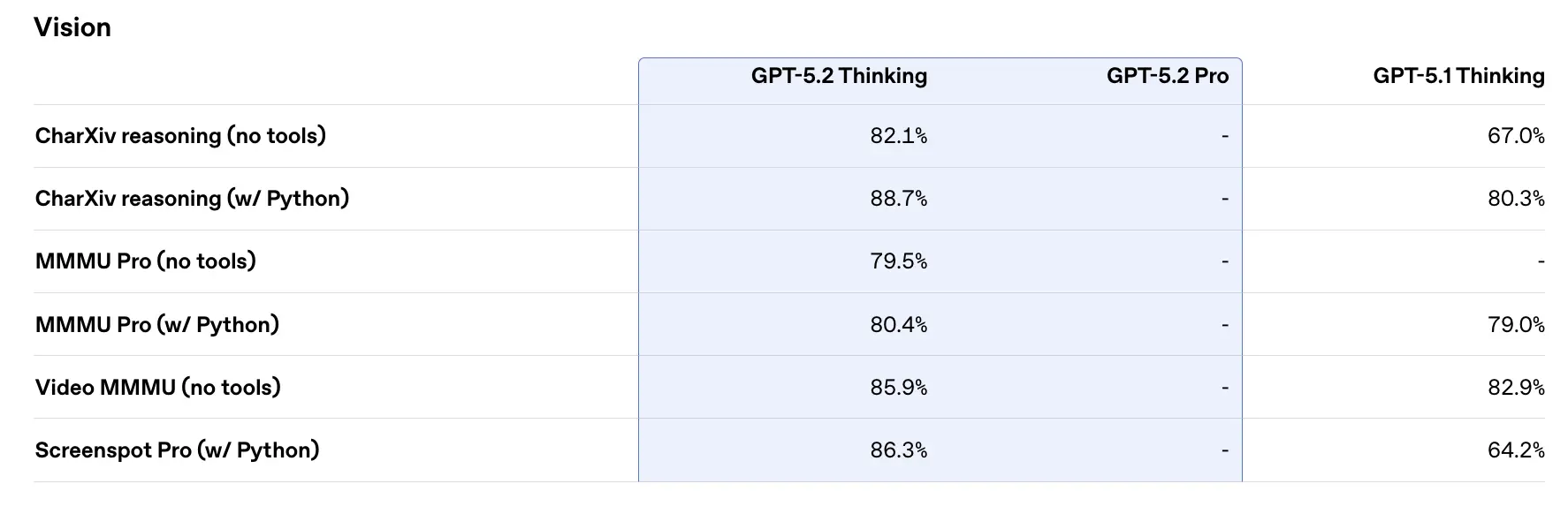

Benchmark-Leistung & unterstützende Daten

OpenAI veröffentlichte eine Vielzahl interner und externer Benchmark-Ergebnisse für GPT-5.2. Ausgewählte Highlights (von OpenAI gemeldete Zahlen):

- GDPval (44 Berufe, Wissensarbeit) — GPT-5.2 Thinking „übertrifft oder erreicht Spitzenfachleute in 70.9% der Vergleiche“; laut OpenAI wurden Ausgaben mit >11× der Geschwindigkeit und <1% der Kosten von Experten bei ihren GDPval-Aufgaben erzeugt (Geschwindigkeits- und Kostenschätzungen sind historisch basiert). Diese Aufgaben umfassen Tabellenkalkulationsmodelle, Präsentationen und Kurzvideos.

- SWE-Bench Pro (Coding) — GPT-5.2 Thinking erzielt ≈55.6% auf SWE-Bench Pro und ~80% auf SWE-Bench Verified (nur Python) laut OpenAI und setzt in deren Tests einen neuen Stand der Technik für Codegenerierung/Engineering-Bewertung. Dies führt in der Praxis zu zuverlässigeren Debugging-Prozessen und End-to-End-Fixes, gemäß den Beispielen von OpenAI.

- GPQA Diamond (wiss. Q&A auf Graduierten-Niveau) — GPT-5.2 Pro: 93.2%, GPT-5.2 Thinking: 92.4% auf GPQA Diamond (keine Tools, maximales Reasoning).

- ARC-AGI-Serie — Auf ARC-AGI-2 (ein schwierigerer Benchmark für flexibles Reasoning) erzielte GPT-5.2 Thinking 52.9% und GPT-5.2 Pro 54.2% (laut OpenAI neue State-of-the-Art-Werte für Chain-of-Thought-Modelle).

- Long-Context (OpenAI MRCRv2) — GPT-5.2 Thinking zeigt nahezu 100% Genauigkeit auf der 4-needle-MRCR-Variante bis zu 256k Tokens und deutlich verbesserte Werte gegenüber GPT-5.1 in Long-Context-Szenarien. (OpenAI veröffentlichte MRCRv2-Diagramme und -Tabellen.)

Vergleich mit Zeitgenossen

- vs Google Gemini 3 (Gemini 3 Pro / Deep Think): Gemini 3 Pro wurde mit einem ~1,048,576 (≈1M) Token-Kontextfenster und breiten multimodalen Eingaben (Text, Bild, Audio, Video, PDFs) sowie starken agentischen Integrationen über Vertex AI / AI Studio publiziert. Auf dem Papier ist das größere Kontextfenster von Gemini 3 ein Differenzierungsmerkmal für extrem große Single-Session-Workloads; Trade-offs betreffen Tooling-Oberfläche und Ökosystem-Passung.

- vs Anthropic Claude Opus 4.5: Anthropics Opus 4.5 betont Enterprise-Coding/Agent-Workflows und meldet starke SWE-Bench-Ergebnisse sowie Robustheit für lange agentische Sitzungen; Anthropic positioniert Opus für Automatisierung und Codegenerierung mit einem 200k-Kontextfenster und spezialisierten Agent/Excel-Integrationen. Opus 4.5 ist ein starker Wettbewerber bei Enterprise-Automatisierung und Codeaufgaben.

Praktisches Fazit: GPT-5.2 zielt auf einen ausgewogenen Satz von Verbesserungen (400k Kontext, hohe Token-Ausgaben, verbessertes Reasoning/Coding). Gemini 3 zielt auf die absolut größten Single-Session-Kontexte (≈1M), während Claude Opus den Fokus auf Enterprise-Engineering und agentische Robustheit legt. Wählen Sie anhand von Kontextgröße, Modalitätsbedarf, Feature-/Tooling-Passung sowie Kosten-/Latenz-Abwägungen.

Zugriff und Nutzung der GPT-5.2-API

Schritt 1: Für API-Schlüssel registrieren

Bei cometapi.com anmelden. Wenn Sie noch kein Nutzer sind, registrieren Sie sich zunächst. Melden Sie sich in Ihrer CometAPI-Konsole an. Holen Sie den Zugriffsberechtigungs-API-Schlüssel der Schnittstelle. Klicken Sie im persönlichen Zentrum beim API-Token auf „Add Token“, erhalten Sie den Token-Schlüssel: sk-xxxxx und senden Sie ihn ab.

Schritt 2: Anfragen an die GPT-5.2-API senden

Wählen Sie den „gpt-5.2“-Endpunkt, um die API-Anfrage zu senden, und setzen Sie den Request-Body. Methode und Request-Body der Anfrage werden aus der API-Dokumentation auf unserer Website entnommen. Unsere Website bietet zu Ihrer Bequemlichkeit auch einen Apifox-Test. Ersetzen Sie <YOUR_API_KEY> durch Ihren tatsächlichen CometAPI-Schlüssel aus Ihrem Konto. Entwickler rufen dies über die Responses API / Chat Endpunkte auf.

Fügen Sie Ihre Frage oder Anforderung in das Inhaltsfeld ein — darauf wird das Modell reagieren. Verarbeiten Sie die API-Antwort, um die generierte Antwort zu erhalten.

Schritt 3: Ergebnisse abrufen und verifizieren

Verarbeiten Sie die API-Antwort, um die generierte Antwort zu erhalten. Nach der Verarbeitung antwortet die API mit dem Aufgabenstatus und den Ausgabedaten.

Siehe auch Gemini 3 Pro Preview API