Hauptfunktionen

- Zwei Varianten:

grok-4-1-fast-reasoning(denk-/agentisch) undgrok-4-1-fast-non-reasoning(sofortige „Fast“-Antworten). - Massives Kontextfenster: 2.000.000 Token — ausgelegt für mehrstündige Transkripte, große Dokumentensammlungen und langfristige Planung über viele Dialogrunden.

- First-Party Agent Tools API: integriertes Web-/X-Browsing, serverseitige Codeausführung, Dateisuche und „MCP“-Konnektoren, damit das Modell als autonomer Agent ohne externe Zwischenlösungen agieren kann.

- Modalitäten: Multimodal (Text + Bilder sowie erweiterte visuelle Fähigkeiten einschließlich Diagrammanalyse und Extraktion auf OCR-Niveau).

Wie funktioniert Grok 4.1 Fast?

- Architektur & Modi: Grok 4.1 Fast wird als eine einzige Modellfamilie präsentiert, die für „Reasoning“ (interne Gedankenkette und höhere Abwägung) oder den nicht-reasoning „Fast“-Betrieb für geringere Latenz konfiguriert werden kann. Der Reasoning-Modus kann über API-Parameter (z. B.

reasoning.enabled) auf Anbieter-Ebenen wie CometAPI ein- bzw. ausgeschaltet werden. - Trainingssignal: xAI berichtet von Reinforcement Learning in simulierten agentischen Umgebungen (tool-lastiges Training), um die Leistung bei langfristigen, mehrrundigen Tool-Aufgaben zu verbessern (sie verweisen auf Training auf τ²-bench Telecom und Reinforcement Learning für lange Kontexte).

- Tool-Orchestrierung: Die Tools laufen auf der xAI-Infrastruktur; Grok kann mehrere Tools parallel aufrufen und agentische Pläne über mehrere Runden hinweg entscheiden (Websuche, X-Suche, Codeausführung, Dateiabruf, MCP-Server).

- Durchsatz & Rate Limits: Beispielhafte veröffentlichte Limits umfassen 480 Anfragen/Minute und 4.000.000 Token/Minute für den

grok-4-1-fast-reasoning-Cluster.

Grok 4.1 fast Modellversionen & Benennung

grok-4-1-fast-reasoning— „denkende“ agentische Betriebsart: interne Reasoning-Token, Tool-Orchestrierung, am besten für komplexe, mehrschrittige Workflows.grok-4-1-fast-non-reasoning— sofortiger „Fast“-Modus: minimale interne Denk-Token, niedrigere Latenz für Chat, Brainstorming und Kurztext-Erstellung.

Grok 4.1 fast Benchmark-Leistung

xAI hebt mehrere Benchmark-Erfolge und gemessene Verbesserungen gegenüber früheren Grok-Versionen und einigen konkurrierenden Modellen hervor. Wichtige veröffentlichte Zahlen:

- τ²-bench (Telekommunikations-Benchmark für agentische Tools): gemeldete 100 % Punktzahl bei Gesamtkosten von $105.

- Berkeley Function Calling v4: gemeldete 72 % Gesamtgenauigkeit (von xAI veröffentlicht) bei insgesamt gemeldeten Kosten von ~$400 in diesem Benchmark-Kontext.

- Research & agentic search (Research-Eval / Reka / X Browse): xAI berichtet von besseren Ergebnissen und geringeren Kosten gegenüber mehreren Wettbewerbern auf internen/industriellen agentischen Such-Benchmarks (Beispiele: Grok 4.1 Fast: Research-Eval- und X Browse-Werte deutlich höher als bei GPT-5 und Claude Sonnet 4.5 in den von xAI veröffentlichten Tabellen).

- Faktizität / Halluzination: Grok 4.1 Fast halbiert die Halluzinationsrate gegenüber Grok 4 Fast bei FActScore und verwandten internen Metriken.

Grok 4.1 fast Einschränkungen & Risiken

- Halluzinationen sind reduziert, nicht eliminiert. Die veröffentlichten Reduktionen sind bedeutsam (xAI berichtet von einer erheblich geringeren Halluzinationsrate gegenüber dem vorherigen Grok 4 Fast), dennoch treten in Grenzfällen und Schnellantwort-Workflows weiterhin sachliche Fehler auf — validieren Sie geschäftskritische Ausgaben unabhängig.

- Vertrauensoberfläche der Tools: Serverseitige Tools erhöhen die Bequemlichkeit, erweitern aber auch die Angriffsfläche (Tool-Missbrauch, falsche externe Ergebnisse oder veraltete Quellen). Nutzen Sie Herkunftsnachweise und Schutzmaßnahmen; behandeln Sie automatisierte Tool-Ausgaben als zu überprüfende Evidenz.

- Nicht universell State-of-the-Art: Rezensionen deuten darauf hin, dass die Grok-Serie in STEM, Reasoning und Aufgaben mit langem Kontext hervorragend ist, aber bei einigen multimodalen visuellen Verständnis- und kreativen Generierungsaufgaben im Vergleich zu den neuesten multimodalen Angeboten anderer Anbieter zurückliegen kann.

Wie Grok 4.1 fast im Vergleich zu anderen führenden Modellen abschneidet

- Verglichen mit Grok 4 / Grok 4.1 (Non-Fast): Fast tauscht einen Teil des internen Rechen-/„Denk“-Overheads gegen geringere Latenz und Token-Ökonomie, mit dem Ziel, die Reasoning-Qualität nahe Grok 4 zu halten; es ist für den produktiven agentischen Einsatz optimiert statt für reines Spitzen-Reasoning auf schweren Offline-Benchmarks. ([xAI][5])

- Verglichen mit der Google Gemini-Familie / OpenAI GPT-Familie / Anthropic Claude: Unabhängige Rezensionen und die Tech-Presse vermerken Groks Stärken in logischem Reasoning, Tool-Aufrufen und der Verarbeitung langer Kontexte, während andere Anbieter teils bei multimodaler Bildverarbeitung, kreativer Generierung oder unterschiedlichen Preis-/Leistungsabstimmungen führen.

- Wie Sie auf die Grok 4.1 fast API zugreifen

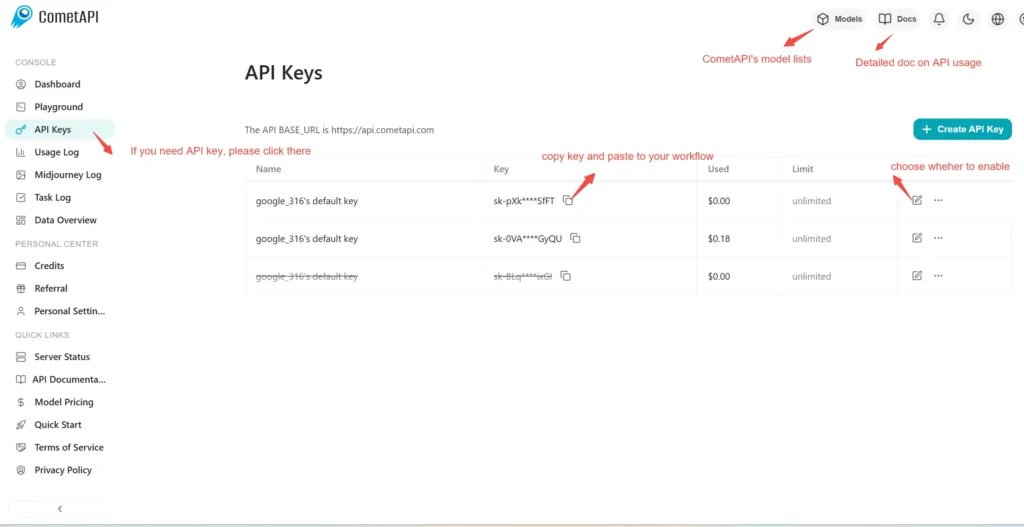

Schritt 1: Für den API-Schlüssel registrieren

Loggen Sie sich bei cometapi.com ein. Falls Sie noch kein Nutzer sind, registrieren Sie sich bitte zuerst. Melden Sie sich bei Ihrer CometAPI-Konsole an. Holen Sie sich den Zugriffsberechtigungs-API-Schlüssel der Schnittstelle. Klicken Sie im persönlichen Bereich beim API-Token auf „Add Token“, erhalten Sie den Token-Schlüssel: sk-xxxxx und senden Sie ihn ab.

Schritt 2: Anfragen an die Grok 4.1 fast API senden

Wählen Sie den „\grok-4-1-fast-reasoning/ grok-4-1-fast-non-reasoning\“-Endpoint, um die API-Anfrage zu senden, und legen Sie den Request-Body fest. Methode und Body der Anfrage erhalten Sie aus der API-Dokumentation unserer Website. Unsere Website bietet zudem Apifox-Tests für Ihre Bequemlichkeit. Ersetzen Sie <YOUR_API_KEY> durch Ihren tatsächlichen CometAPI-Schlüssel aus Ihrem Konto. Basis-URL ist das Chat-Format (https://api.cometapi.com/v1/chat/completions).

Fügen Sie Ihre Frage oder Anfrage in das Content-Feld ein — darauf wird das Modell antworten. Verarbeiten Sie die API-Antwort, um die generierte Antwort zu erhalten.

Schritt 3: Ergebnisse abrufen und verifizieren

Verarbeiten Sie die API-Antwort, um die generierte Antwort zu erhalten. Nach der Verarbeitung liefert die API den Aufgabenstatus und die Ausgabedaten.