OpenAI, Anthropic und Google erweitern mit ihren neuesten Flaggschiff-Produkten – OpenAIs o3 (und seiner erweiterten Variante o3-pro), Anthropics Claude Opus 4 und Googles Gemini 2.5 Pro – weiterhin die Grenzen großer Sprachmodelle. Jedes dieser Modelle bietet einzigartige Architekturinnovationen, Leistungsstärken und Ökosystemintegrationen für unterschiedliche Anwendungsfälle, von unternehmensweiter Programmierunterstützung bis hin zu Suchverbesserungen für Endverbraucher. Dieser ausführliche Vergleich untersucht ihre Veröffentlichungshistorie, technischen Möglichkeiten, Benchmark-Leistung und empfohlenen Anwendungen, um Unternehmen bei der Auswahl des richtigen Modells für ihre Anforderungen zu unterstützen.

Was ist OpenAIs o3 und wie hat es sich entwickelt?

OpenAI stellte o3 erstmals am 16. April 2025 vor und positionierte es als „unser intelligentestes Modell“, das für erweiterten Kontext und äußerst zuverlässige Antworten entwickelt wurde. Kurz darauf, am 10. Juni 2025, veröffentlichte OpenAI o3-pro – eine leistungsoptimierte Variante, die Pro-Benutzern in ChatGPT sowie über die API zur Verfügung steht und schnellere Inferenz und höheren Durchsatz bei hoher Belastung bietet.

Kontextfenster und Durchsatz

OpenAI o3 bietet eine 200-Token Kontextfenster für Eingabe und Ausgabe, wodurch die Verarbeitung umfangreicher Dokumente, Codebasen oder mehrstufiger Konversationen ohne häufiges Abschneiden möglich ist. Der Durchsatz beträgt etwa 37.6 Token/Sekunde, das zwar nicht zu den Spitzenreitern zählt, aber dennoch eine gleichbleibende Reaktionsfähigkeit bei anhaltender Arbeitslast bietet.

Fortgeschrittenes deliberatives Denken

- „Privater Gedankengang“: o3 wurde mit Verstärkungslernen trainiert, um Zwischenschritte zu planen und zu durchdenken, bevor es sein endgültiges Ergebnis produzierte, wodurch seine Fähigkeit zur logischen Schlussfolgerung und Problemzerlegung deutlich verbessert wurde.

- Bewusste Ausrichtung: Es enthält Sicherheitstechniken, die das Modell durch schrittweises Denken dazu anleiten, Richtlinien zuverlässiger einzuhalten, wodurch schwerwiegende Fehler bei komplexen Aufgaben in der realen Welt reduziert werden.

Preise und Unternehmensintegration

Der Preis von OpenAI für o3 beträgt ca. \2 $ pro Million Eingabetoken kombiniert mit einem nachhaltigen Materialprofil. \8 $ pro Million Ausgabe-Token. Damit liegt es im mittleren Bereich: Bei hohen Arbeitslasten ist es günstiger als Premiummodelle wie Claude Opus 4, aber teurer als budgetfreundliche Alternativen wie Gemini 2.5 Pro. Entscheidend ist, dass Unternehmen von der nahtlosen Integration in das breitere OpenAI-API-Ökosystem profitieren – das Einbettungen, Feinabstimmungen und spezialisierte Endpunkte umfasst – und so den Integrationsaufwand minimiert.

Wie unterscheidet sich Claude Opus 4 vom Markt?

Anthropic kündigte Claude Opus 4 am 22. Mai 2025 an und vermarktete es als „das weltweit beste Codierungsmodell“ mit nachhaltiger Leistung bei komplexen, lang andauernden Aufgaben und Agenten-Workflows. Es wurde gleichzeitig in Anthropics eigener API und über Amazon Bedrock eingeführt und ist für AWS-Kunden über die LLM-Funktionen und die REST-API von Bedrock zugänglich...

Erweiterte „Denkfähigkeiten“

Eine Besonderheit von Opus 4 ist seine „erweitertes Denken“ Betamodus, der die Rechenleistung dynamisch zwischen modellbasierter Argumentation und Tool-Aufrufen (z. B. Suche, Abruf, externe APIs) aufteilt. In Verbindung mit „Denkzusammenfassungen“ erhalten Benutzer Einblick in die interne Argumentationskette des Modells – entscheidend für Compliance-sensible Anwendungen im Finanz- und Gesundheitswesen.

Preis- und Kontextkompromisse

At \15 $ pro Million Eingabetoken kombiniert mit einem nachhaltigen Materialprofil. \75 $ pro Million Ausgabe-Token, Claude Opus 4 liegt am oberen Ende der Preisskala. Seine 200-Token Eingabefenster (mit einem 32-Token Die Ausgabeobergrenze (Output Cap) ist kleiner als das 2.5-Millionen-Token-Fenster von Gemini 1 Pro, reicht aber für die meisten Codeüberprüfungen und langwierigen Denkaufgaben aus. Anthropic rechtfertigt den Aufpreis mit der Betonung der internen Rechenintensität und der anhaltenden Genauigkeit der Gedankenkette. Bis zu 90 % Einsparungen durch sofortiges Caching und 50 % durch Stapelverarbeitung sind möglich. Erweiterte Denkbudgets sind in den kostenpflichtigen Tarifen enthalten; kostenlose Nutzer können nur auf die Sonnet-Variante zugreifen.

Welche einzigartigen Funktionen und Leistungen bietet Gemini 2.5 Pro?

Veröffentlicht als Googles nächste Generation „Pro“-Stufe, Gemini 2.5 Pro richtet sich an Organisationen, die massiven Kontext, multimodale Eingaben und kosteneffiziente Skalierung benötigen. Insbesondere unterstützt es bis zu 1,048,576-Token in einer einzigen Eingabeaufforderung – eingehend – und 65,535-Token ausgehend und ermöglicht durchgängige Dokumenten-Workflows, die Hunderttausende von Seiten umfassen.

Überlegener Kontext und Multimodalität

Gemini 2.5 Pro glänzt mit seinem 1M-Token Kontextfenster, das Anwendungsfälle wie Vertragsanalysen, Patent-Mining und umfassende Codebasis-Refactoring ermöglicht. Das Modell akzeptiert nativ Text, Code, Bilder, Audio, PDFs und Videoframes, Rationalisierung multimodaler Pipelines ohne separate Vorverarbeitungsschritte.

Wie verbessert Gemini die multimodale und konversationelle Suche?

Gemini 2.5 Pro zeichnet sich durch seine „Query Fan-Out“-Methodik aus: Es zerlegt komplexe Abfragen in Unterfragen, führt parallele Suchen durch und synthetisiert im Handumdrehen umfassende, dialogorientierte Antworten. Mit Unterstützung für Text-, Sprach- und Bildeingaben nutzt der KI-Modus die multimodalen Fähigkeiten von Gemini, um auf vielfältige Benutzerinteraktionen einzugehen – obwohl er sich noch in einem frühen Stadium befindet und Abfragen gelegentlich falsch interpretiert werden können.

Wettbewerbsfähige Preise

Mit einer Eingaberate von $1.25–$2.50 pro Million Token und $10–$15 pro Million ausgegebener Token liefert Gemini 2.5 Pro die beste Preis-zu-Token Verhältnis zwischen den dreien. Dies macht es besonders attraktiv für dokumentenintensive Anwendungen mit hohem Volumen, bei denen lange Kontexte den Token-Verbrauch stärker beeinflussen als reine Leistungskennzahlen. Premium-Pläne ermöglichen „Deep Think“-Budgets und höheren Durchsatz. Google AI Pro- und Ultra-Abonnements bündeln den Zugriff auf Gemini 2.5 Pro mit anderen Tools wie der Veo-Videogenerierung und NotebookLM.

Zugrunde liegende Architekturen und Fähigkeiten

OpenAI o3: Reflektierendes Denken im großen Maßstab

OpenAIs o3 ist ein reflektierender, generativer, vortrainierter Transformer, der entwickelt wurde, um schrittweisen logischen Denkaufgaben zusätzliche Zeit zu widmen. Architektonisch baut er auf dem Transformer-Backbone von GPT-4 auf, integriert aber einen „Denkbudget“-Mechanismus: Das Modell weist komplexen Problemen dynamisch mehr Rechenzyklen zu und erstellt interne Denkketten, bevor es Ergebnisse generiert. Dies führt zu einer deutlich verbesserten Leistung in Bereichen, die mehrstufiges Denken erfordern, wie z. B. höhere Mathematik, wissenschaftliche Forschung und Codesynthese.

Claude Opus 4: Hybrides Denken für erweiterte Arbeitsabläufe

Claude Opus 4 von Anthropic ist das bisher leistungsstärkste Modell und für die Programmierung und nachhaltige Agenten-Workflows optimiert. Wie o3 nutzt es einen Transformer-Kern, führt aber hybride Denkmodi ein – nahezu sofortige Reaktionen („Fast Think“) versus ausgedehnte Überlegungen („Deep Think“) – und ermöglicht so die Wahrung des Kontexts über Tausende von Schritten und Rechenstunden hinweg. Dieser hybride Ansatz macht Opus 4 besonders geeignet für langlaufende Softwareentwicklungs-Pipelines, mehrstufige Forschungsaufgaben und die autonome Agenten-Orchestrierung.

Gemini 2.5 Pro: Multimodales Denken mit adaptiven Budgets

Gemini 2.5 Pro von Google DeepMind erweitert die nativen Multimodalitäts- und Denkfähigkeiten von Gemini. Es führt „Deep Think“ ein, einen adaptiven Mechanismus für paralleles Denken, der Teilaufgaben auf interne Module verteilt und Ergebnisse zu schlüssigen Antworten zusammenfasst. Gemini 2.5 Pro verfügt außerdem über ein außergewöhnlich langes Kontextfenster, das die Verarbeitung ganzer Codebasen, großer Datensätze (Text, Audio, Video) und Designdokumente in einem Durchgang ermöglicht. Gleichzeitig bietet es eine detaillierte Kontrolle über die Denkbudgets, um Leistung und Kosten optimal abzuwägen.

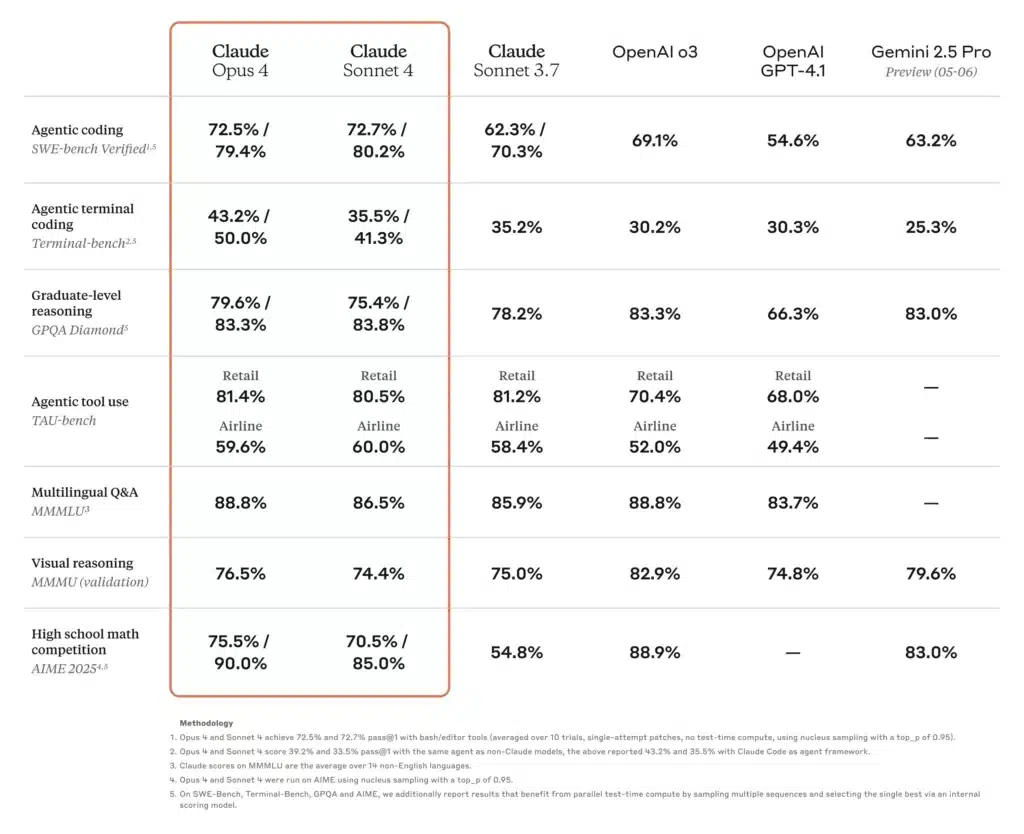

Wie schneiden die Leistungsbenchmarks dieser Modelle im Vergleich ab?

Akademisches und wissenschaftliches Denken

In einer aktuellen Rangliste von SciArena lag o3 bei von Forschern bewerteten Fragen zum technischen Denken an der Spitze seiner Konkurrenten, was das große Vertrauen der Community in seine wissenschaftliche Genauigkeit widerspiegelt. Claude Opus 4 zeigte unterdessen eine überlegene Leistung bei agentenbasierten Benchmarks, die ein mehrstündiges, anhaltendes Problemlösen erfordern, und übertraf Sonnet-Modelle bei TAU-Bench- und Predictive-Reasoning-Aufgaben um bis zu 30 %. Gemini 2.5 Pro führt auch viele akademische Benchmarks an, erreichte bei LMArena den ersten Platz bei der Messung menschlicher Präferenzen und zeigte bei Mathematik- und Naturwissenschaftstests erhebliche Vorsprung.

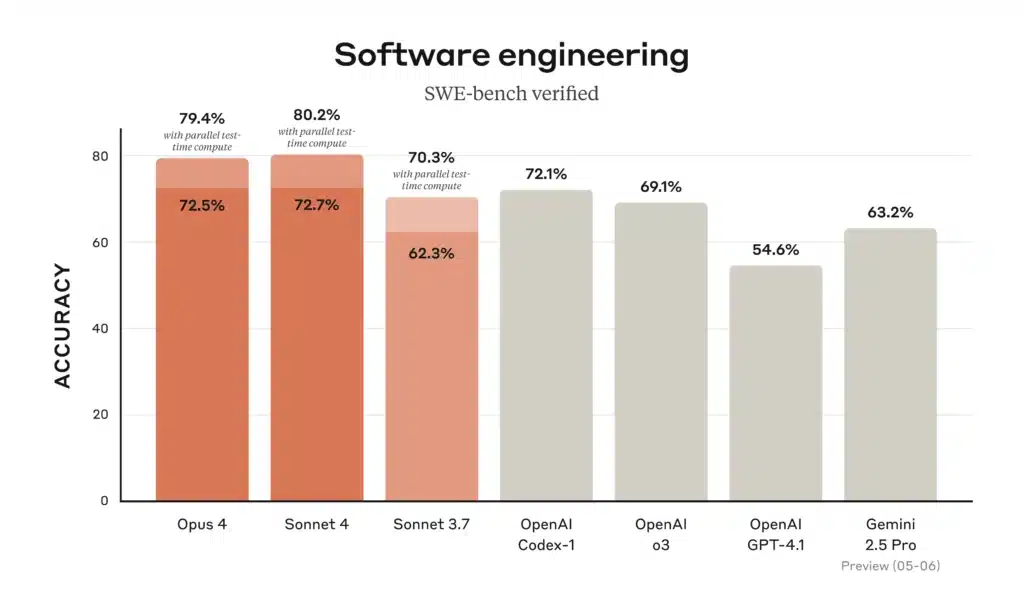

Codierung und Softwareentwicklung

Auf den Codierungs-Bestenlisten führt Gemini 2.5 Pro die beliebte WebDev Arena an und führt dank seiner Fähigkeit, ganze Repositories zu laden und zu analysieren, auch die gängigen Codierungs-Benchmarks an. Claude Opus 4 hält den Titel „weltbestes Codierungsmodell“ mit 72.5 % beim SWE-Benchmark und 43.2 % beim Terminal-Benchmark – Benchmarks, die sich auf komplexe, lang andauernde Softwareaufgaben konzentrieren. o3 ist auch bei der Codesynthese und beim Debuggen hervorragend, fällt aber bei mehrstufigen, groß angelegten Engineering-Szenarien etwas hinter Opus 4 und Gemini zurück; dennoch ist es aufgrund seiner intuitiven Denkkette für einzelne Codierungsaufgaben äußerst zuverlässig.

Werkzeugnutzung und multimodale Integration

Das multimodale Design von Gemini 2.5 Pro – Verarbeitung von Text, Bildern, Audio und Video – verschafft ihm einen Vorteil bei kreativen Arbeitsabläufen wie interaktiven Simulationen, visueller Datenanalyse und Video-Storyboarding. Die agentenbasierte Tool-Nutzung von Claude Opus 4, einschließlich der Claude Code CLI und integrierter Dateisystemoperationen, eignet sich hervorragend zum Erstellen autonomer Pipelines über APIs und Datenbanken hinweg. o3 unterstützt Web-Browsing, Dateianalyse, Python-Ausführung und Bildbetrachtung und ist damit ein vielseitiges „Schweizer Taschenmesser“ für Aufgaben mit gemischten Formaten, wenn auch mit kürzeren Kontextgrenzen als Gemini 2.5 Pro.

Wie schneiden diese Modelle in realen Codierungsszenarien ab?

Wenn es um Programmierunterstützung geht, erzählen Benchmarks nur einen Teil der Wahrheit. Entwickler legen Wert auf präzise Codegenerierung, Refactoring-Kompetenz und die Fähigkeit, den Projektkontext über mehrere Dateien hinweg zu verstehen.

Genauigkeit und Halluzinationsraten

- Claude Opus 4 ist führend bei der Vermeidung von Halluzinationen, mit weniger Fällen nicht vorhandener API-Referenzen oder falscher Bibliothekssignaturen – entscheidend für unternehmenskritische Codebasen. Die Halluzinationsrate wird berichtet bei ~ 12% auf umfangreichen Code-Audits gegenüber ~ 18% für Zwillinge und ~ 20% für o3.

- Gemini 2.5 Pro ist dank seines riesigen Kontextfensters hervorragend bei Massentransformationen (z. B. Migration von Codemustern über Zehntausende von Zeilen) geeignet, hat jedoch gelegentlich mit subtilen Logikfehlern in großen Codeblöcken zu kämpfen.

- OpenAI o3 bleibt aufgrund seiner stabilen Latenz und hohen Verfügbarkeit die erste Wahl für schnelle Snippets, Boilerplate-Generierung und interaktives Debugging – Entwickler führen jedoch häufig eine Kreuzvalidierung mit einem anderen Modell durch, um Randfallfehler zu erkennen.

Tool- und API-Ökosystem

- Beide o3 kombiniert mit einem nachhaltigen Materialprofil. Gemini Nutzen Sie umfangreiche Tools – die Funktionsaufruf-API von OpenAI bzw. das integrierte Actions-Framework von Google – und ermöglichen Sie so eine nahtlose Orchestrierung von Datenabrufen, Datenbankabfragen und externen API-Aufrufen.

- Claude Opus 4 wird in Agenten-Frameworks wie Claude Code (Anthropics CLI-Tool) und Amazon Bedrock integriert und bietet Abstraktionen auf hoher Ebene zum Erstellen autonomer Workflows ohne manuelle Orchestrierung.

Welches Modell bietet das beste Preis-Leistungs-Verhältnis?

Durch Abwägen der Rohkapazitäten, der Kontextlänge und der Kosten lassen sich je nach Workload-Eigenschaften unterschiedliche Schlussfolgerungen zum „besten Preis-Leistungs-Verhältnis“ ziehen.

Umfangreiche, dokumentenzentrierte Anwendungsfälle

Bei der Verarbeitung umfangreicher Korpora – wie etwa juristischer Repositorien, wissenschaftlicher Literatur oder Unternehmensarchiven –Gemini 2.5 Pro geht oft als Sieger hervor. Seine 1M-Token Fenster und Preispunkt von $ $ 1.25 2.50- (Eingabe) und $ $ 10 15- (Ausgabe-)Token bieten eine unschlagbare Kostenstruktur für Aufgaben mit langem Kontext.

Tiefgründiges Denken und mehrstufige Arbeitsabläufe

Wenn Genauigkeit, Genauigkeit der Gedankenkette und langfristige Agentenfähigkeiten wichtig sind – etwa bei der Finanzmodellierung, bei der Prüfung der Einhaltung gesetzlicher Vorschriften oder bei F&E-Pipelines –Claude Opus 4kann trotz des höheren Preises den Aufwand für die Fehlerbehandlung verringern und den End-to-End-Durchsatz verbessern, indem Wiederholungen und menschliche Überprüfungszyklen minimiert werden.

Ausgewogene Unternehmensakzeptanz

Für Teams, die zuverlässige Allzweckleistung ohne extreme Skalierung suchen, OpenAI o3 bietet einen Mittelweg. Mit umfassender API-Unterstützung, moderaten Preisen und soliden Benchmark-Ergebnissen bleibt es eine überzeugende Wahl für Data-Science-Plattformen, die Automatisierung des Kundensupports und Produktintegrationen im Frühstadium.

Welches KI-Modell sollten Sie für Ihre spezifischen Anforderungen wählen?

Letztendlich hängt Ihr ideales Modell von drei Hauptfaktoren ab:

- Kontextskala: Bei Arbeitslasten, die große Eingabefenster erfordern, dominiert Gemini 2.5 Pro.

- Tiefe der Argumentation: Wenn Ihre Aufgaben eine mehrstufige Logik und eine geringe Fehlertoleranz erfordern, bietet Claude Opus 4 überlegene Konsistenz.

- Kostensensibilität und Ökosystem-Passung: Für allgemeine Aufgaben innerhalb des OpenAI-Stacks – insbesondere wenn die Integration in vorhandene Datenpipelines wichtig ist – stellt o3 eine ausgewogene, kostengünstige Option dar.

Durch die Bewertung des Token-Profils (Eingabe vs. Ausgabe), der Toleranz gegenüber Halluzinationen und der Tool-Anforderungen Ihrer Anwendung können Sie das Modell auswählen, das sowohl den technischen Anforderungen als auch den Budgetbeschränkungen optimal entspricht.

Hier ist eine Vergleichstabelle, die die wichtigsten Spezifikationen, Leistungskennzahlen, Preise und idealen Anwendungsfälle für OpenAI o3, Anthropic Claude Opus 4 und Google Gemini 2.5 Pro zusammenfasst:

| Funktion/Metrik | OpenAI o3 | Claude Opus 4 | Gemini 2.5 Pro |

|---|---|---|---|

| Kontextfenster (eingehend / ausgehend) | 200 Token / 200 Token | 200 Token / 32 Token | 1 048 576 Token / 65 535 Token |

| Durchsatz (Tokens/Sek.) | ~ 37.6 | ~ 42.1 | ~ 83.7 |

| Durchschnittliche Latenz | ~2.8 Sek. | ~3.5 Sek. | ~2.52 Sek. |

| Codierungs-Benchmark (SWE-Benchmark) | 69.1% | 72.5% | 63.2% |

| Mathematik-Benchmark (AIME-2025) | 78.4 %¹ | 81.7 %¹ | 83.0% |

| Halluzinationsrate (Code-Audits) | ~ 20% | ~ 12% | ~ 18% |

| Multimodale Eingaben | Text und Code | Text und Code | Text, Code, Bilder, Audio, PDFs, Video |

| Unterstützung der „Gedankenkette“ | Standard | Erweitertes Denken mit Zusammenfassungen | Standard |

| Funktions-/Tool-Aufruf-API | Ja (OpenAI-Funktionen) | Ja (über Anthropische Agenten und Bedrock) | Ja (Google Actions) |

| Preise (Eingabe-Token) | 2.00 $ / M Token | 15.00 $ / M Token | 1.25–2.50 $/M Token |

| Preise (Ausgabe-Token) | 8.00 $ / M Token | 75.00 $ / M Token | 10–15 $/M Token |

| Ideale Anwendungsfälle | Allgemeine Chatbots, Kundensupport, schnelle Code-Snippets | Tiefgründiges Denken, komplexe Codebasen, autonome Agenten | Massive Dokumentenanalyse, multimodale Workflows |

Die AIME-2025-Mathematikergebnisse für o3 und Opus 4 sind ungefähre Mittelwerte basierend auf gemeldeten Benchmarks.

Erste Schritte

CometAPI ist eine einheitliche API-Plattform, die über 500 KI-Modelle führender Anbieter – wie die GPT-Reihe von OpenAI, Gemini von Google, Claude von Anthropic, Midjourney, Suno und weitere – in einer einzigen, entwicklerfreundlichen Oberfläche vereint. Durch konsistente Authentifizierung, Anforderungsformatierung und Antwortverarbeitung vereinfacht CometAPI die Integration von KI-Funktionen in Ihre Anwendungen erheblich. Ob Sie Chatbots, Bildgeneratoren, Musikkomponisten oder datengesteuerte Analyse-Pipelines entwickeln – CometAPI ermöglicht Ihnen schnellere Iterationen, Kostenkontrolle und Herstellerunabhängigkeit – und gleichzeitig die neuesten Erkenntnisse des KI-Ökosystems zu nutzen.

Entwickler können zugreifen Gemini 2.5 Pro,Claude Opus 4 kombiniert mit einem nachhaltigen Materialprofil. O3 API - durch Konsolidierung, CometAPIDie neuesten Modellversionen sind zum Veröffentlichungsdatum des Artikels aufgeführt. Erkunden Sie zunächst die Funktionen des Modells im Spielplatz und konsultieren Sie die API-Leitfaden Für detaillierte Anweisungen. Stellen Sie vor dem Zugriff sicher, dass Sie sich bei CometAPI angemeldet und den API-Schlüssel erhalten haben. CometAPI bieten einen Preis weit unter dem offiziellen Preis an, um Ihnen bei der Integration zu helfen.

Letztendlich hängt die Wahl zwischen der o3-Serie von OpenAI, Claude Opus 4 von Anthropics und Gemini 2.5 Pro von spezifischen organisatorischen Prioritäten ab – sei es erstklassige technische Leistung, sichere Unternehmensintegration oder nahtlose multimodale Kundenerlebnisse. Indem Sie Ihre Anwendungsfälle auf die Stärken und das Ökosystem jedes Modells abstimmen, können Sie die neuesten KI-Technologien nutzen, um Innovationen in Forschung, Entwicklung, Bildung und darüber hinaus voranzutreiben.

Anmerkung des Verfassers: Bis zum 31. Juli 2025 wird jedes dieser Modelle kontinuierlich weiterentwickelt, mit häufigen kleineren Updates und Verbesserungen des Ökosystems. Beachten Sie vor einer endgültigen Entscheidung immer die aktuelle CometAPI-API-Dokumentation und Leistungsbenchmarks.