In einem spannenden Livestream-Event am Donnerstag, den 27. OpenAI veröffentlichte eine Forschungsvorschau von GPT-4.5, der neuesten Version seines Flaggschiff-Modells für große Sprachen. Unternehmensvertreter lobten diese neue Version als ihr bisher leistungsfähigstes und vielseitigstes Chat-Modell. Sie wird zunächst Softwareentwicklern und Nutzern von ChatGPT Pro-Abonnements zur Verfügung stehen.

Die Veröffentlichung von GPT-4.5 markiert das Ende einer Ära für OpenAI. In einem Beitrag auf X Anfang des Monats erklärte OpenAI-CEO Sam Altman, das Modell sei das letzte, das das Unternehmen einführt, ohne zusätzliche Rechenleistung für die Prüfung von Anfragen vor der Beantwortung zu benötigen.

Was ist GPT 4.5?

GPT 4.5 ist das bisher größte Modell von OpenAI. Experten haben geschätzt, dass GPT-4 bis zu 1.8 Billionen Parameter haben könnte, also Werte, die beim Trainieren eines Modells angepasst werden. Durch die Skalierung des unüberwachten Lernens verbessert GPT 4.5 seine Fähigkeit, Muster zu erkennen, Verbindungen herzustellen und ohne logisches Denken kreative Erkenntnisse zu generieren.

GPT 4.5 ist ein Beispiel für die Skalierung unüberwachten Lernens durch die Skalierung von Rechenleistung und Daten sowie durch Architektur- und Optimierungsinnovationen. GPT-4.5 bietet zudem eine natürlichere Benutzerinteraktion, deckt ein breiteres Wissensspektrum ab und kann Benutzerabsichten besser verstehen und darauf reagieren. Dies führt zu weniger Halluzinationen und mehr Zuverlässigkeit in einem breiten Themenspektrum.

Was sind die Upgrades von GPT 4.5 und seine Funktionen

EQ-Upgrade:

Das größte Feature von GPT-4.5 ist die verbesserte „emotionale Intelligenz“ (EQ), die für ein natürlicheres, herzlicheres und flüssigeres Gesprächserlebnis sorgt. OpenAI-CEO Sam Altman teilte in den sozialen Medien mit: „Zum ersten Mal habe ich das Gefühl, dass KI mit einem nachdenklichen Menschen spricht. Sie liefert wirklich wertvolle Ratschläge und hat mich sogar ein paar Mal überrascht, dass KI so hervorragende Antworten geben kann.“

Im Test menschlicher Präferenzen sind die Nutzer im Allgemeinen der Meinung, dass die Antworten von GPT 4.5 eher den menschlichen Kommunikationsgewohnheiten entsprechen als die von GPT-4o. Insbesondere erhielt das neue Modell höhere Bewertungen in den Bereichen kreative Intelligenz (56.8 %), berufliche Probleme (63.2 %) und alltägliche Probleme (57.0 %).

Reduzierte Halluzinationen:

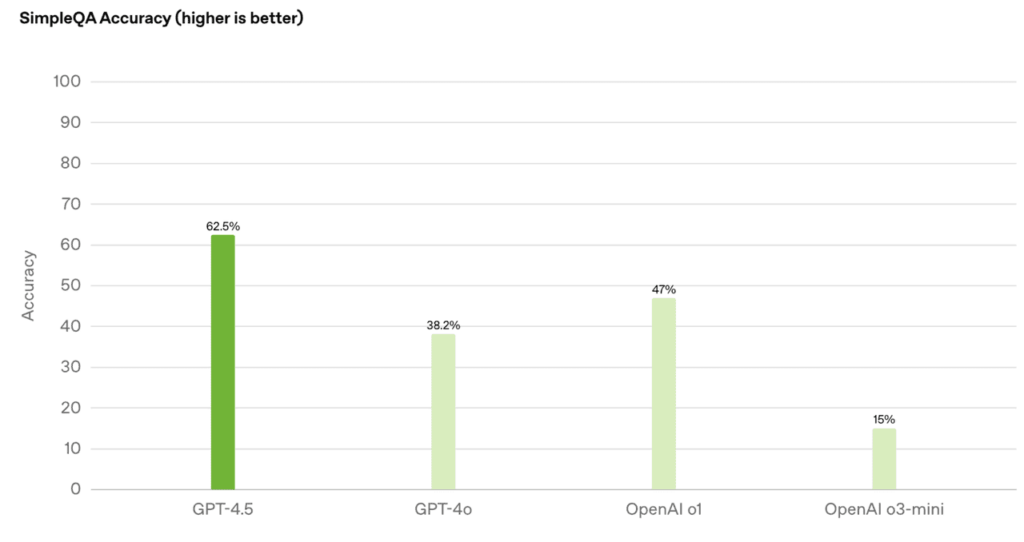

Durch groß angelegtes „unüberwachtes Lernen“ hat GPT 4.5 erhebliche Fortschritte bei der Wissensgenauigkeit und der Reduzierung von „Halluzinationen“ (falschen Informationen) erzielt:

- Bei einer Genauigkeit von 62.5 % in der SimpleQA-Auswertung sank die Halluzinationsrate auf 37.1 %

- Erreichen einer Genauigkeit von 0.78 im PersonQA-Datensatz, deutlich besser als GPT-4o (0.28) und o1 (0.55)

Wissensdatenbankerweiterung und Expression Upgrade

Die Effizienz wurde drastisch gesteigert: Der Rechenleistungsverbrauch sank um das Zehnfache, die Wissensbasis verdoppelte sich, aber die Kosten waren höher (Pro-Benutzer erhalten vorrangige Erfahrung für 10 $/Monat). Darüber hinaus wurde GPT 200 hinsichtlich Architektur und Innovation optimiert, wodurch die Steuerbarkeit, das Verständnis von Nuancen und die natürlichen Konversationsfähigkeiten verbessert wurden und es sich besonders zum Schreiben, Programmieren, Lösen praktischer Probleme und interaktiver Szenarien eignet, die ein hohes Maß an Empathie erfordern.

Highlights der technischen Architektur

Upgrade der Rechenleistung: Basierend auf dem Supercomputing-Training von Microsoft Azure ist die Rechenleistung zehnmal so hoch wie bei GPT-10, die Recheneffizienz ist um mehr als das Zehnfache verbessert und verteiltes Training über Rechenzentren hinweg wird unterstützt.

Sicherheitsoptimierung: Integrieren Sie traditionelle überwachte Feinabstimmung (SFT) und RLHF, führen Sie neue Überwachungstechnologien ein und reduzieren Sie das Risiko schädlicher Ausgaben.

Multimodale Einschränkungen: Sprache/Video werden noch nicht unterstützt, aber es wurde eine Bilderkennung hinzugefügt, um das SVG-Animationsdesign und die Generierung urheberrechtsfreier Musik zu unterstützen.

Verwandte Themen:Der Vergleich der 8 beliebtesten KI-Modelle des Jahres 2025

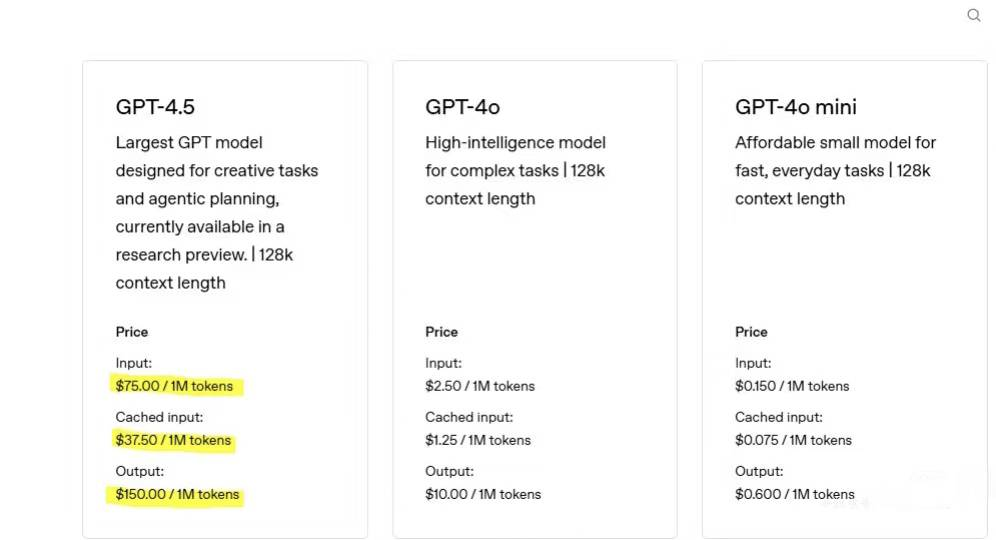

Erläuterung der GPT 4.5 API-Preise: Lohnt es sich wirklich?

GPT‑4.5 basiert auf einer kolossalen Architektur mit 12.8 Billionen Parametern und einem 128 Token-Kontextfenster. Dieser enorme Umfang und das rechenintensive Design sind mit Premiumpreisen verbunden. Beispielsweise kann eine Workload mit 750 Eingabe- und 250 Ausgabetoken rund 147 US-Dollar kosten – etwa 30–34-mal so viel wie bei früheren Modellen wie GPT‑4o.

Preisvergleich der GPT-Serie

Das neue Modell steht jetzt ChatGPT Pro-Benutzern zur Forschungsvorschau zur Verfügung und wird in den nächsten zwei Wochen für Plus-, Team-, Enterprise- und Education-Benutzer eingeführt.

GPT 4.5 im Vergleich zu anderen Sprachmodellen

Die ästhetische Intuition des Design Writing wurde verbessert und eignet sich nun besser für kreative Arbeit und emotionale Interaktion als andere Modelle. Die Argumentation wurde zurückgestuft, und die Position als „stärkstes Modell“ wurde deutlich aufgegeben. Die Argumentationsfähigkeit hinkt der Konkurrenz hinterher. GPT-4.5 hat den Standard für Konversations-KI erhöht, ist aufgrund seines hohen Preises jedoch eher ein professionelles Tool als eine Massenmarktlösung.

Umfassender API-Preisvergleich führender KI-Modelle

| Modell | Eingabekosten (pro 1 Mio. Token) | Ausgabekosten (pro 1 Mio. Token) | Kontextfenster | Kommentare |

| GPT‑4.5 | 75 | 150 | 128 Token | Premium-Preise für erweiterte emotionale und konversationelle Fähigkeiten |

| GPT‑4o | 2.5 | 10 | 128 Token | Kostengünstige Basis mit schneller, multimodaler Unterstützung |

| Claude 3.7 Sonett | 3 | 15 | 200 Token | Außergewöhnlich sparsam; unterstützt sowohl Text als auch Bilder |

| DeepSeek R1 | ~ $ 0.55 | ~ $ 2.19 | 64 Token | Aggressive Preisgestaltung; Caching kann die Kosten für Anwendungsfälle mit hohem Volumen weiter senken |

| Google Gemini 2.0 Flash | ~ $ 0.15 | ~ $ 0.60 | Bis zu 1 Million Token | Extrem niedrige Kosten mit enormer Kontextkapazität; ideal für Aufgaben mit hohem Volumen |

Technische Möglichkeiten und Kostenkompromisse

Kontext und Multimodalität:

**GPT‑4.5:**Unterstützt einen 128k-Token-Kontext, ist aber nur Text.

Claude 3.7 Sonett: Bietet ein größeres 200-Token-Fenster und Bildverarbeitung für eine verbesserte Leistung im Langkontext.

**Google Gemini 2.0 Flash:**Verfügt über ein beeindruckendes 1M-Token-Fenster, ideal für die umfangreiche Inhaltsverarbeitung (die Textqualität kann jedoch variieren).

Spezialisierte Aufgaben:

**Codierungs-Benchmarks:**GPT‑4.5 erreicht bei Codierungsaufgaben (z. B. SWE‑Bench) eine Genauigkeit von etwa 38 %, während Claude 3.7 Sonnet bei technischen Aufgaben eine deutlich bessere Kosteneffizienz und Leistung bietet.

**Emotionale Intelligenz:**GPT‑4.5 zeichnet sich durch die Wiedergabe nuancierter, emotional reicher Dialoge aus und eignet sich daher ideal für Kundensupport- und Coaching-Anwendungen.

Fazit

GPT-4.5 ist das „letzte Nicht-Inferenz-Modell“. Seine Fähigkeit zum unüberwachten Lernen wird in die O-Serie-Reasoning-Technologie integriert und ebnet den Weg für GPT-5, das Ende Mai veröffentlicht wird. Die Veröffentlichung von GPT-4.5 stellt nicht nur ein technologisches Upgrade dar, sondern auch eine Neugestaltung des Mensch-Maschine-Kollaborationsmodells. Obwohl der hohe Preis und der Rechenleistungsengpass umstritten sind, bieten seine Durchbrüche in Bezug auf emotionale Resonanz und praktische Anwendbarkeit ein neues Paradigma für die Integration von KI in Bildung, Medizin und anderen Bereichen. KI hat unbegrenztes Entwicklungspotenzial!

Häufige FAQs zu GPT 4.5

Was sind ihre Grenzen?

Es verfügt nicht über die Fähigkeit, logische Gedankenketten zu erstellen, und kann aufgrund seiner Größe langsamer sein. Außerdem erzeugt es keine multimodale Ausgabe wie Audio oder Video.

Kann es in 100 % der Fälle absolut genaue Antworten liefern?

Nein. Obwohl GPT-4.5 im Allgemeinen weniger halluziniert als frühere Modelle, sollten Benutzer dennoch wichtige oder vertrauliche Ausgaben überprüfen.

Unterstützt GPT-4.5 Bilder?

Ja, GPT-4.5 akzeptiert Bildeingaben, kann SVG-Bilder inline generieren und Bilder über DALL·E generieren.

Unterstützt GPT-4.5 die Suche im Internet?

Ja, GPT-4.5 hat mit der Suche Zugriff auf die aktuellsten Informationen.

Mit welchen Dateien und Dateitypen funktioniert es?

GPT-4.5 unterstützt alle Dateien und Dateitypen.