Am 28. April 2025 stellte Alibaba Cloud Qwen 3 vor, die neueste Version seiner Familie großer Sprachmodelle (LLMs). Diese Version markiert einen wichtigen Meilenstein in der Entwicklung von Open-Source-KI und bietet eine Reihe von Modellen für unterschiedliche Anwendungen und Nutzerbedürfnisse. Ob Entwickler, Forscher oder Unternehmen: Das Verständnis des Zugriffs und der Nutzung von Qwen 3 eröffnet neue Möglichkeiten in der natürlichen Sprachverarbeitung und darüber hinaus.

Was ist Qwen 3?

Qwen 3 ist die dritte Generation der Open-Source-LLMs von Alibaba Cloud und baut auf den Grundlagen seiner Vorgänger auf. Qwen 28 erschien am 2025. April 3 und führt eine Reihe von Modellen mit unterschiedlichen Parametergrößen ein, darunter sowohl dichte als auch spärliche Architekturen. Diese Modelle wurden anhand eines umfangreichen Datensatzes von 36 Billionen Token in 119 Sprachen und Dialekten trainiert, was Qwen 3 zu einem vielseitigen Werkzeug für globale Anwendungen macht.

Hauptfunktionen von Qwen 3

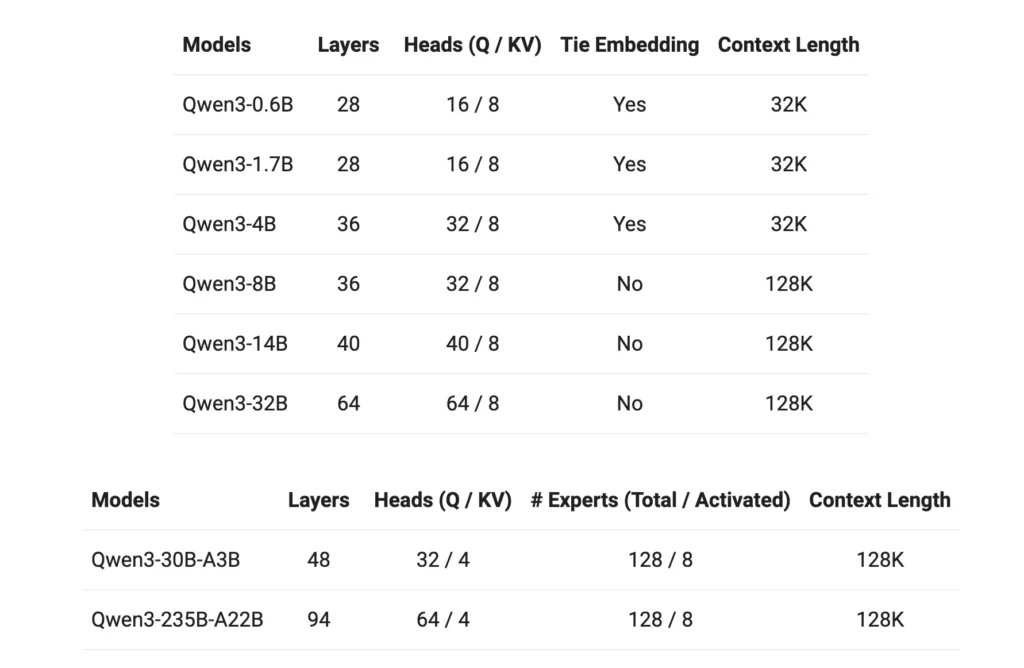

- Modellvarianten: Qwen 3 bietet dichte Modelle mit 0.6B, 1.7B, 4B, 8B, 14B und 32B Parametern sowie spärliche Modelle mit 30B (3B aktivierte Parameter) und 235B (22B aktivierte Parameter).

- Erweitertes Kontextfenster: Die meisten Modelle unterstützen ein 128K-Token-Kontextfenster, was die Verarbeitung von Langforminhalten erleichtert.

- Argumentationsfähigkeiten: Erweiterte Argumentationsfunktionen können über den Tokenizer umgeschaltet werden, was eine anpassbare Leistung basierend auf bestimmten Aufgaben ermöglicht.

- Mehrsprachigkeit: Mit Trainingsdaten, die 119 Sprachen und Dialekte umfassen, ist Qwen 3 für vielfältige linguistische Anwendungen gerüstet.

- Lizenzierung: Alle Modelle werden unter der Apache 2.0-Lizenz veröffentlicht, um die Open-Source-Zusammenarbeit und Innovation zu fördern.

Wie können Sie auf Qwen3 zugreifen?

Der Zugriff auf Qwen 3, Alibaba Clouds neueste Suite großer Sprachmodelle (LLMs), ist unkompliziert und vielseitig. Ob Entwickler, die erweiterte KI-Funktionen in ihre Anwendungen integrieren möchten, oder Forscher, die innovative Modelle erforschen – Qwen 3 bietet verschiedene Zugangspunkte für unterschiedliche Anforderungen.

1. Über die QwenChat-Weboberfläche

Für eine sofortige Interaktion ohne jegliche Einrichtung bietet QwenChat eine benutzerfreundliche Weboberfläche:

- Besuchen Sie QwenChat: Navigieren Sie zu QwenChat-Plattform.

- Wählen Sie ein Modell aus: Wählen Sie je nach Ihren Anforderungen aus verfügbaren Modellen wie Qwen3-8B, Qwen3-14B oder Qwen3-32B.

- Starten Sie den Chat: Interagieren Sie direkt über die Chat-Schnittstelle mit dem Modell, um Aufgaben wie Fragen und Antworten, Inhaltserstellung oder Unterstützung bei der Codierung zu erledigen.

2. API-Zugriff über Alibaba Cloud

Integrieren Sie Qwen 3 mithilfe der API-Dienste von Alibaba Cloud in Ihre Anwendungen:

API-Anmeldeinformationen abrufen: Melden Sie sich bei Alibaba Cloud an und erhalten Sie Ihren API-Schlüssel.

Zugriffsmethode auswählen:

- OpenAI-kompatible API: Nutzen Sie den OpenAI-kompatiblen Endpunkt für eine nahtlose Integration.

bashPOST https://dashscope-intl.aliyuncs.com/compatible-mode/v1/chat/completions

- DashScope SDK: Alternativ können Sie das DashScope SDK für individuellere Interaktionen verwenden.

- Umgebung einrichten: Konfigurieren Sie Ihre Entwicklungsumgebung, indem Sie den API-Schlüssel als Umgebungsvariable festlegen und die erforderlichen SDKs installieren.

3. Zugriff über Hugging Face und ModelScope

Für Entwickler, die Open-Source-Plattformen bevorzugen:

- Gesicht umarmen: Greifen Sie über die Qwen-Organisation auf Hugging Face auf Qwen 3-Modelle zu.

pythonfrom transformers import AutoTokenizer, AutoModelForCausalLM tokenizer = AutoTokenizer.from_pretrained("Qwen/Qwen3-14B") model = AutoModelForCausalLM.from_pretrained("Qwen/Qwen3-14B")

- ModelScope: Entdecken Sie Modelle auf ModelScope, das eine Reihe von Qwen 3-Varianten bietet.

4. Lokale Bereitstellungsoptionen

Stellen Sie Qwen 3-Modelle lokal bereit, um eine verbesserte Kontrolle und Anpassung zu erhalten:

Ollama: Eine Plattform, die die lokale Modellverwaltung vereinfacht.

- Installation: Laden Sie Ollama herunter und installieren Sie es von ollama.com.

- Modellbereitstellung: Verwenden Sie die CLI von Ollama, um Qwen 3-Modelle lokal auszuführen.

bashollama run qwen3-14b

vLLM: Optimiert für hohen Durchsatz und geringe Latenz.

- Installation: Installieren Sie vLLM mit pip.

bashpip install -U vllm

- Modelldienst: Qwen 3-Modelle mit Schlussfolgerungsfähigkeiten ausstatten.

bashvllm serve Qwen/Qwen3-30B-A3B \ --enable-reasoning \ --reasoning-parser deepseek_r1

Interaktion: Greifen Sie über den Standard-API-Server unter auf das Modell zu http://localhost:8000.

5. Plattformen von Drittanbietern: CometAPI

Nutzen Sie Qwen 3 durch CometAPI bietet kostenlosen Zugang:

- CometAPI: Registrieren Sie sich, um einen kostenlosen API-Schlüssel zu erhalten und wählen Sie aus Modellen wie Qwen3-8B, Qwen3-30B oder Qwen3-235B zur Integration in Ihre Projekte.

Erste Schritte mit Qwen 3

So beginnen Sie mit der Verwendung von Qwen 3:

- Bestimmen Sie Ihren Anwendungsfall: Ermitteln Sie, ob Sie eine Webschnittstelle, eine API-Integration oder eine lokale Bereitstellung benötigen.

- Wählen Sie das passende Modell: Wählen Sie eine Modellvariante, die Ihren Rechenressourcen und der Aufgabenkomplexität entspricht.

- Richten Sie die Umgebung ein: Befolgen Sie die Installations- und Konfigurationsschritte entsprechend Ihrer gewählten Zugriffsmethode.

- Integrieren und testen: Integrieren Sie Qwen 3 in Ihre Anwendungen und führen Sie Tests durch, um eine optimale Leistung sicherzustellen.

Wenn Sie diese Schritte befolgen, können Sie die Funktionen von Qwen 3 effektiv nutzen, um Ihre Projekte und Forschungsvorhaben zu verbessern.

Implementierung von Qwen 3: Praktische Überlegungen

Systemanforderungen

Die Bereitstellung von Qwen 3-Modellen, insbesondere der größeren Varianten, erfordert erhebliche Rechenressourcen. Benutzer sollten sicherstellen, dass sie über ausreichend GPU-Kapazitäten und Speicher verfügen, um die Modellgrößen und Verarbeitungsanforderungen zu erfüllen.

Integration und Anpassung

Der Open-Source-Charakter von Qwen 3 ermöglicht umfassende Anpassungen. Entwickler können die Modelle anhand domänenspezifischer Daten optimieren, Parameter für eine optimierte Leistung anpassen und die Modelle in bestehende Systeme integrieren, um die Funktionalität zu erweitern.

Community und Support

Die Teilnahme an der Qwen 3-Community in Foren, GitHub-Diskussionen und anderen kollaborativen Plattformen kann wertvolle Einblicke und Unterstützung bieten. Der Austausch von Erfahrungen und Lösungen trägt zur gemeinsamen Weiterentwicklung der Technologie bei.

Fazit

Qwen 3 stellt einen bedeutenden Fortschritt im Bereich der Open-Source-Sprachmodelle dar. Mit seinem vielfältigen Modellangebot, der umfassenden Sprachunterstützung und den zugänglichen Plattformen bietet es ein robustes Toolset für ein breites Anwendungsspektrum. Durch das Verständnis des Zugriffs und der Implementierung von Qwen 3 können Anwender dessen Funktionen nutzen, um Innovation und Effizienz in ihren jeweiligen Bereichen voranzutreiben.

Erste Schritte

Entwickler können zugreifen Qwen 3 API durch CometAPI. Erkunden Sie zunächst die Funktionen des Modells im Playground und konsultieren Sie die API-Leitfaden Detaillierte Anweisungen finden Sie unter „Verifizierung der Organisation“. Beachten Sie, dass Entwickler vor der Verwendung des Modells möglicherweise ihre Organisation überprüfen müssen.