Alibabas neuester Fortschritt in der künstlichen Intelligenz, Qwen3-Coder, markiert einen wichtigen Meilenstein in der sich rasant entwickelnden Landschaft der KI-gesteuerten Softwareentwicklung. Qwen23-Coder wurde am 2025. Juli 3 vorgestellt und ist ein Open-Source-Agenten-Codierungsmodell, das komplexe Programmieraufgaben autonom bewältigen soll, von der Generierung von Boilerplate-Code bis zum Debuggen ganzer Codebasen. Basierend auf einer hochmodernen Mixture-of-Experts-Architektur (MoE) und mit 480 Milliarden Parametern, von denen 35 Milliarden pro Token aktiviert werden, erreicht das Modell ein optimales Gleichgewicht zwischen Leistung und Recheneffizienz. In diesem Artikel untersuchen wir, was Qwen3-Coder auszeichnet, seine Benchmark-Leistung, enthüllen seine technischen Innovationen, führen Entwickler durch die optimale Nutzung und betrachten die Rezeption und Zukunftsaussichten des Modells.

Was ist Qwen3‑Coder?

Qwen3‑Coder ist das neueste agentenbasierte Codemodell der Qwen-Familie und wurde am 22. Juli 2025 offiziell angekündigt. Die Flaggschiff-Variante Qwen3‑Coder‑480B‑A35B‑Instruct wurde als „bisher agentenbasiertes Codemodell“ konzipiert und verfügt über insgesamt 480 Milliarden Parameter mit einem Mixture‑of‑Experts (MoE)-Design, das 35 Milliarden Parameter pro Token aktiviert. Es unterstützt nativ Kontextfenster mit bis zu 256 Token und skaliert durch Extrapolationstechniken auf eine Million Token, um den Anforderungen an das Verständnis und die Generierung von Code im Repo-Maßstab gerecht zu werden.

Open Source unter Apache 2.0

Im Einklang mit Alibabas Engagement für eine Community-getriebene Entwicklung wird Qwen3-Coder unter der Apache 2.0-Lizenz veröffentlicht. Diese Open-Source-Verfügbarkeit gewährleistet Transparenz, fördert die Beteiligung von Drittanbietern und beschleunigt die Akzeptanz in Wissenschaft und Industrie. Forscher und Ingenieure können auf vortrainierte Gewichte zugreifen und das Modell für spezielle Bereiche – von Fintech bis hin zum wissenschaftlichen Rechnen – optimieren.

Weiterentwicklung von Qwen2.5

Aufbauend auf dem Erfolg von Qwen2.5-Coder, der Modelle mit 0.5 bis 32 Milliarden Parametern anbot und SOTA-Ergebnisse in Codegenerierungs-Benchmarks erzielte, erweitert Qwen3-Coder die Fähigkeiten seines Vorgängers durch größere Skalierung, verbesserte Datenpipelines und neuartige Trainingsprogramme. Qwen2.5-Coder wurde mit über 5.5 Billionen Tokens trainiert, wobei sorgfältige Datenbereinigung und synthetische Datengenerierung zum Einsatz kamen. Qwen3-Coder geht noch einen Schritt weiter, indem er 7.5 Billionen Tokens mit einem Codeverhältnis von 70 % verarbeitet und vorherige Modelle nutzt, um verrauschte Eingaben zu filtern und neu zu schreiben und so eine überragende Datenqualität zu erzielen.

Welches sind die wichtigsten Innovationen, die Qwen3-Coder auszeichnen?

Mehrere wichtige Innovationen zeichnen Qwen3-Coder aus:

- Agentenbasierte Aufgabenorchestrierung: Anstatt nur Snippets zu generieren, kann Qwen3-Coder mehrere Vorgänge – Lesen der Dokumentation, Aufrufen von Dienstprogrammen und Validieren von Ausgaben – ohne menschliches Eingreifen autonom miteinander verketten.

- Budget für verbessertes Denken: Entwickler können konfigurieren, wie viel Rechenleistung jedem Schritt der Argumentation gewidmet wird, und so einen anpassbaren Kompromiss zwischen Geschwindigkeit und Gründlichkeit ermöglichen, der für die Codesynthese im großen Maßstab von entscheidender Bedeutung ist.

- Nahtlose Tool-Integration: Die Befehlszeilenschnittstelle von Qwen3-Coder, „Qwen Code“, passt Funktionsaufrufprotokolle und benutzerdefinierte Eingabeaufforderungen an, um sie in gängige Entwicklertools zu integrieren, sodass die Einbettung in vorhandene CI/CD-Pipelines und IDEs einfach ist.

Wie schneidet Qwen3‑Coder im Vergleich zur Konkurrenz ab?

Benchmark-Showdowns

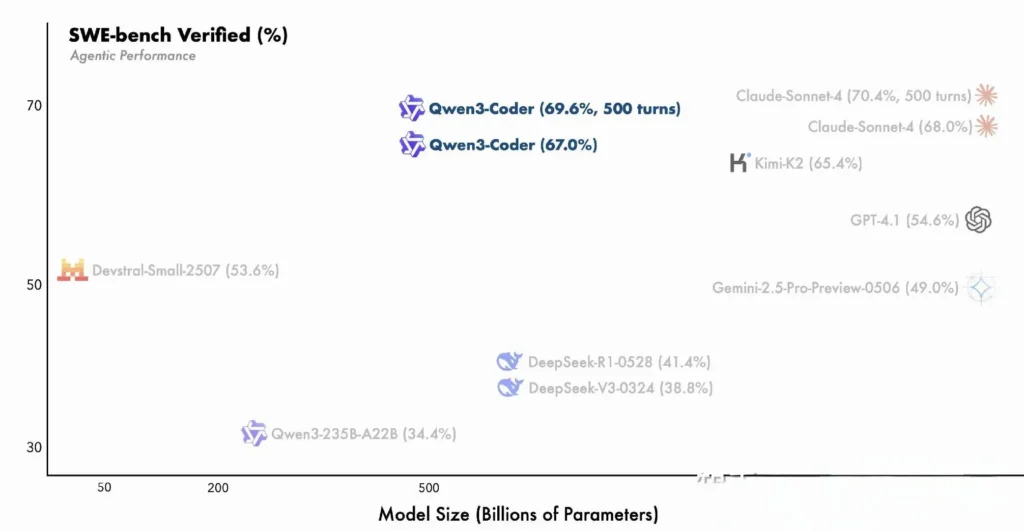

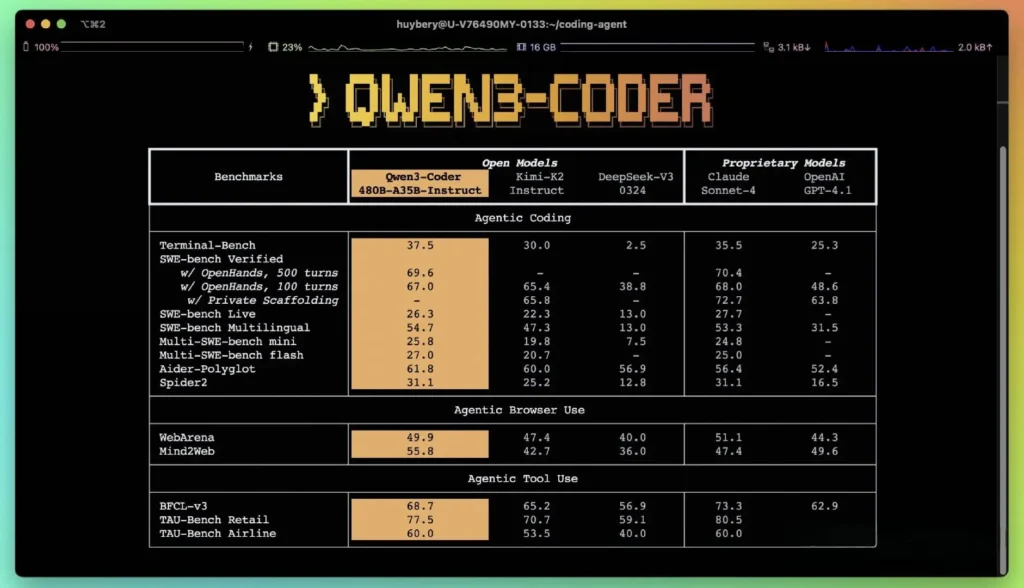

Laut den von Alibaba veröffentlichten Leistungskennzahlen übertrifft Qwen3-Coder führende inländische Alternativen – wie die Codex-Modelle von DeepSeek und K2 von Moonshot AI – und erreicht oder übertrifft die Codierungsfähigkeiten führender US-Angebote in mehreren Benchmarks. Bewertungen von Drittanbietern zeigen:

- Aider Polyglot: Qwen3-Coder-480B erreichte eine Punktzahl von 61.8%, was eine leistungsstarke mehrsprachige Codegenerierung und -begründung veranschaulicht.

- MBPP und HumanEval: Unabhängige Tests berichten, dass Qwen3-Coder-480B-A35B GPT-4.1 sowohl hinsichtlich der funktionalen Korrektheit als auch der komplexen Eingabeaufforderungsverarbeitung übertrifft, insbesondere bei mehrstufigen Codierungsherausforderungen.

- Die 480B-Parameter-Variante erreichte über 85% Ausführungserfolg auf der SWE‑Bank Verifizierte Suite – übertrifft sowohl das Topmodell von DeepSeek (78 %) als auch K2 von Moonshot (82 %) und liegt mit 4 % fast gleichauf mit Claude Sonnet 86.

Vergleich mit proprietären Modellen

Alibaba behauptet, dass die agentischen Fähigkeiten von Qwen3-Coder in End-to-End-Codierungs-Workflows mit denen von Anthropic Claude und OpenAI GPT-4 übereinstimmen – eine bemerkenswerte Leistung für ein Open-Source-Modell. Erste Tester berichten, dass die Multi-Turn-Planung, der dynamische Tool-Aufruf und die automatische Fehlerkorrektur komplexe Aufgaben – wie die Erstellung von Full-Stack-Webanwendungen oder die Integration von CI/CD-Pipelines – mit minimalem menschlichen Aufwand bewältigen können. Diese Fähigkeiten werden durch die Fähigkeit des Modells zur Selbstvalidierung durch Codeausführung unterstützt – eine Funktion, die bei rein generativen LLMs weniger ausgeprägt ist.

Welche technischen Neuerungen stecken hinter Qwen3‑Coder?

Mixture-of-Experts (MoE)-Architektur

Das Herzstück von Qwen3‑Coder ist ein hochmodernes MoE-Design. Im Gegensatz zu dichten Modellen, die alle Parameter für jedes Token aktivieren, greifen MoE-Architekturen gezielt auf spezialisierte Subnetzwerke (Experten) zurück, die auf bestimmte Tokentypen oder Aufgaben zugeschnitten sind. In Qwen3‑Coder sind insgesamt 480 Milliarden Parameter auf mehrere Experten verteilt, wobei pro Token nur 35 Milliarden Parameter aktiv sind. Dieser Ansatz reduziert die Inferenzkosten im Vergleich zu vergleichbaren dichten Modellen um über 60 % und gewährleistet gleichzeitig eine hohe Genauigkeit bei der Codesynthese und beim Debuggen.

Denkmodus und Nicht-Denkmodus

Qwen3‑Coder greift auf die Innovationen der Qwen3-Familie zurück und integriert eine Dual-Mode-Inferenz Rahmen:

- Denkmodus weist ein größeres „Denkbudget“ für komplexe, mehrstufige Denkaufgaben zu, wie etwa Algorithmendesign oder dateiübergreifendes Refactoring.

- Nicht-Denkmodus bietet schnelle, kontextgesteuerte Antworten, die für einfache Codevervollständigungen und API-Nutzungsausschnitte geeignet sind.

Durch diesen einheitlichen Moduswechsel entfällt die Notwendigkeit, mit separaten Modellen für chatoptimierte und für schlussfolgerungsoptimierte Aufgaben zu jonglieren, wodurch die Arbeitsabläufe der Entwickler optimiert werden.

Reinforcement Learning mit automatisierter Testfallsynthese

Eine herausragende Innovation ist das native 3K-Token-Kontextfenster von Qwen256‑Coder – doppelt so groß wie die typische Kapazität führender offener Modelle – und die Unterstützung von bis zu einer Million Token über Extrapolationsmethoden (z. B. YaRN). Dadurch kann das Modell ganze Repositories, Dokumentationssätze oder Multi-File-Projekte in einem Durchgang verarbeiten, wobei dateiübergreifende Abhängigkeiten erhalten bleiben und sich wiederholende Eingabeaufforderungen reduziert werden. Empirische Tests zeigen, dass die Erweiterung des Kontextfensters zwar zu abnehmenden, aber dennoch signifikanten Leistungssteigerungen bei langfristigen Aufgaben führt, insbesondere in umgebungsgesteuerten Reinforcement-Learning-Szenarien.

Wie können Entwickler auf Qwen3‑Coder zugreifen und ihn verwenden?

Die Release-Strategie für Qwen3-Coder legt Wert auf Offenheit und einfache Übernahme:

- Open-Source-Modellgewichte: Alle Modellprüfpunkte sind auf GitHub unter Apache 2.0 verfügbar, was vollständige Transparenz und Community-gesteuerte Verbesserungen ermöglicht.

- Befehlszeilenschnittstelle (Qwen-Code): Die CLI ist ein Fork von Google Gemini Code und unterstützt benutzerdefinierte Eingabeaufforderungen, Funktionsaufrufe und Plugin-Architekturen, um eine nahtlose Integration in vorhandene Build-Systeme und IDEs zu ermöglichen.

- Cloud- und On-Premise-Bereitstellungen: Vorkonfigurierte Docker-Images und Kubernetes Helm-Diagramme erleichtern skalierbare Bereitstellungen in Cloud-Umgebungen, während lokale Quantisierungsrezepte (2–8 Bit dynamische Quantisierung) eine effiziente Inferenz vor Ort ermöglichen, sogar auf handelsüblichen GPUs.

- API-Zugriff über CometAPI: Entwickler können auch mit Qwen3-Coder über gehostete Endpunkte auf Plattformen wie interagieren CometAPI, die Open Source anbieten (

qwen3-coder-480b-a35b-instruct) und kommerzielle Versionen (qwen3-coder-plus; qwen3-coder-plus-2025-07-22) zum gleichen Preis. Die kommerzielle Version ist 1 m lang. - Gesicht umarmen:Alibaba hat die Qwen3-Coder-Gewichte und die zugehörigen Bibliotheken sowohl auf Hugging Face als auch auf GitHub kostenlos zur Verfügung gestellt, verpackt unter einer Apache 2.0-Lizenz, die eine akademische und kommerzielle Nutzung ohne Lizenzgebühren erlaubt.

API- und SDK-Integration über CometAPI

CometAPI ist eine einheitliche API-Plattform, die über 500 KI-Modelle führender Anbieter – wie die GPT-Reihe von OpenAI, Gemini von Google, Claude von Anthropic, Midjourney, Suno und weitere – in einer einzigen, entwicklerfreundlichen Oberfläche vereint. Durch konsistente Authentifizierung, Anforderungsformatierung und Antwortverarbeitung vereinfacht CometAPI die Integration von KI-Funktionen in Ihre Anwendungen erheblich. Ob Sie Chatbots, Bildgeneratoren, Musikkomponisten oder datengesteuerte Analyse-Pipelines entwickeln – CometAPI ermöglicht Ihnen schnellere Iterationen, Kostenkontrolle und Herstellerunabhängigkeit – und gleichzeitig die neuesten Erkenntnisse des KI-Ökosystems zu nutzen.

Entwickler können interagieren mit Qwen3-Coder über eine kompatible API im OpenAI-Stil, verfügbar über CometAPI. CometAPI, die Open Source anbieten (qwen3-coder-480b-a35b-instruct) und kommerzielle Versionen (qwen3-coder-plus; qwen3-coder-plus-2025-07-22) zum gleichen Preis. Die kommerzielle Version ist 1 MB lang. Beispielcode für Python (unter Verwendung des OpenAI-kompatiblen Clients) mit Best Practices, die die folgenden Sampling-Einstellungen empfehlen: Temperatur = 0.7, Top_p = 0.8, Top_k = 20 und Wiederholungsstrafe = 1.05. Die Ausgabelänge kann bis zu 65,536 Token betragen, wodurch sich der Code für umfangreiche Codegenerierungsaufgaben eignet.

Erkunden Sie zunächst die Fähigkeiten der Modelle in der Spielplatz und konsultieren Sie die API-Leitfaden Für detaillierte Anweisungen. Stellen Sie vor dem Zugriff sicher, dass Sie sich bei CometAPI angemeldet und den API-Schlüssel erhalten haben.

Schnellstart zu Hugging Face und Alibaba Cloud

Entwickler, die gerne mit Qwen3‑Coder experimentieren möchten, finden das Modell auf Hugging Face im Repository Qwen/Qwen3‑Coder‑480B‑A35B‑InstructDie Integration wird optimiert durch die transformers Bibliothek (Version ≥ 4.51.0, um zu vermeiden KeyError: 'qwen3_moe') und OpenAI‑kompatible Python‑Clients. Ein Minimalbeispiel:

from transformers import AutoModelForCausalLM, AutoTokenizer

model = AutoModelForCausalLM.from_pretrained("Qwen/Qwen3-480B-A35B-Instruct")

tokenizer = AutoTokenizer.from_pretrained("Qwen/Qwen3-480B-A35B-Instruct")

input_ids = tokenizer("def fibonacci(n):", return_tensors="pt").input_ids

output = model.generate(input_ids, max_length=200, temperature=0.7, top_p=0.8, top_k=20, repetition_penalty=1.05)

print(tokenizer.decode(output))

Definieren von benutzerdefinierten Tools und Agenten-Workflows

Eine der herausragenden Funktionen von Qwen3‑Coder ist dynamischer ToolaufrufEntwickler können externe Dienstprogramme – Linters, Formatierer und Test-Runner – registrieren und dem Modell erlauben, diese während einer Programmiersitzung autonom aufzurufen. Diese Funktion verwandelt Qwen3-Coder von einem passiven Code-Assistenten in einen aktiven Code-Agenten, der Tests ausführen, den Code-Stil anpassen und sogar Microservices basierend auf Konversationsabsichten bereitstellen kann.

Welche potenziellen Anwendungen und zukünftigen Richtungen ermöglicht Qwen3‑Coder?

Durch die Kombination von Open-Source-Freiheit mit Enterprise-Performance ebnet Qwen3-Coder den Weg für eine neue Generation KI-gesteuerter Entwicklungstools. Von automatisierten Code-Audits und Sicherheitskonformitätsprüfungen über kontinuierliche Refactoring-Dienste bis hin zu KI-gestützten DevOps-Assistenten – die Vielseitigkeit des Modells begeistert bereits Startups und interne Innovationsteams gleichermaßen.

Softwareentwicklungs-Workflows

Frühanwender berichten von einer 30–50-prozentigen Zeitersparnis bei Boilerplate-Coding, Abhängigkeitsmanagement und anfänglichem Scaffolding. Dadurch können sich Ingenieure auf hochwertige Design- und Architekturaufgaben konzentrieren. Continuous-Integration-Suiten nutzen Qwen3-Coder, um automatisch Tests zu generieren, Regressionen zu erkennen und sogar Leistungsoptimierungen basierend auf Echtzeit-Codeanalysen vorzuschlagen.

Unternehmen spielen

Da Unternehmen aus den Bereichen Finanzen, Gesundheitswesen und E-Commerce Qwen3-Coder in unternehmenskritische Systeme integrieren, beschleunigen Feedbackschleifen zwischen Benutzerteams und Alibabas Forschungs- und Entwicklungsabteilung Verbesserungen – wie beispielsweise domänenspezifisches Tuning, verbesserte Sicherheitsprotokolle und zuverlässigere IDE-Plugins. Darüber hinaus fördert Alibabas Open-Source-Strategie Beiträge aus der globalen Community und fördert ein lebendiges Ökosystem aus Erweiterungen, Benchmarks und Best-Practice-Bibliotheken.

Fazit

Zusammenfassend stellt Qwen3‑Coder einen Meilenstein in der Open-Source-KI für die Softwareentwicklung dar: ein leistungsstarkes, agentenbasiertes Modell, das nicht nur Code schreibt, sondern auch ganze Entwicklungspipelines mit minimaler menschlicher Kontrolle orchestriert. Indem Alibaba die Technologie frei verfügbar und einfach integrierbar macht, demokratisiert das Unternehmen den Zugang zu fortschrittlichen KI-Tools und schafft die Voraussetzungen für eine Ära, in der die Softwareentwicklung zunehmend kollaborativ, effizient und intelligent wird.

FAQ

Was macht Qwen3‑Coder „agentisch“?

Agentische KI bezieht sich auf Modelle, die mehrstufige Aufgaben autonom planen und ausführen können. Die Fähigkeit von Qwen3-Coder, externe Tools aufzurufen, Tests auszuführen und Codebasen ohne menschliches Eingreifen zu verwalten, ist ein Beispiel für dieses Paradigma.

Ist Qwen3‑Coder für den Produktionseinsatz geeignet?

Obwohl Qwen3‑Coder bei Benchmarks und Praxistests eine starke Leistung zeigt, sollten Unternehmen domänenspezifische Evaluierungen durchführen und Sicherheitsvorkehrungen (z. B. Ausgabeüberprüfungspipelines) implementieren, bevor sie ihn in kritische Produktionsabläufe integrieren.

Welche Vorteile bietet die Mixture-of-Experts-Architektur Entwicklern?

MoE reduziert die Inferenzkosten, indem es nur relevante Subnetze pro Token aktiviert. Dies ermöglicht eine schnellere Generierung und geringere Rechenkosten. Diese Effizienz ist entscheidend für die Skalierung von KI-Codierungsassistenten in Cloud-Umgebungen.