Veo 3.1 kommt: Ich verstehe ist Googles Familie von KI-Video-Generationsmodellen (aktuell sind Veo 3 / Veo 3 Fast). Google hat kürzlich große Verbesserungen für Veo 3 ausgeliefert (vertikal 9:16, 1080p, Veo 3 Fast, niedrigere Preise) und es gibt Gerüchte / Social Posts zur Abwicklung, Integrierung, Speicherung und Veo 3.1 steht unmittelbar bevor – aber Google hat kein Frontalunterricht. hat noch kein offizielles Release Bulletin für Veo 3.1 veröffentlicht. Ich werde bestätigte Fakten, wahrscheinliche/erwartete Änderungen und einen direkten Vergleich mit OpenAIs Sora 2.

Was Ich verstehe is

Ich verstehe ist Googles Reihe generativer Videomodelle (DeepMind / Google Cloud / Gemini-Familie), die Text oder Bilder in kurze Videos umwandeln – und (in Veo 3) nativ Audio (Soundeffekte, Umgebungsgeräusche und Dialoge) generieren. Es wird in der Google Cloud (Vertex AI / Gemini API) für Entwickler und Unternehmen angeboten und enthält integrierte Herkunfts-/SynthID-Wasserzeichen in den Ausgaben.

Was Veo 3 bereits gebracht

- Text → Video kombiniert mit einem nachhaltigen Materialprofil. Bild → Video Funktionen (einschließlich Bild-zu-Video-Vorschau).

- Native Audiogenerierung (Musik, Umgebungsgeräusche, Dialoge) – Veo 3 führte erstklassiges Audio ein.

- Zwei Varianten: hochwertiges Veo 3 und Veo 3 Fast (optimiert für Geschwindigkeit/Iteration).

- Plattformverfügbarkeit: in Vertex AI / Gemini API verfügbar gemacht (kostenpflichtige Vorschau → allgemeine Verfügbarkeitsupdates Mitte 2025).

- Sicherheit/Herkunft: SynthID-Wasserzeichen und einige Generationen verwenden Kontrollen/Genehmigungen für die Personen-/Kindgeneration.

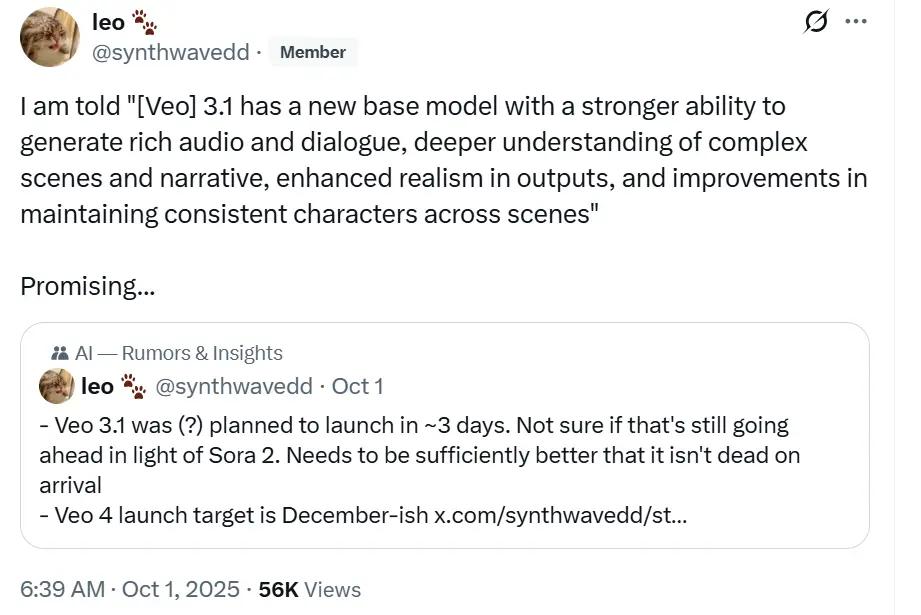

Also – was ist Veo 3.1 erwartet?

Status: Derzeit gibt es keine offizielle Veo 3.1-Produktseite von Google mit vollständigen Versionshinweisen. Mehrere Entwicklerbeiträge/Community-Beiträge und Tweets von Google deuten jedoch auf ein in Kürze erscheinendes inkrementelles Update (mit der Bezeichnung „Veo 3.1“) hin, bei dem der Schwerpunkt eher auf iterativen Verbesserungen der Audio-, Qualitäts- und Formatunterstützung als auf einer vollständigen Neufassung der neuen Generation liegen dürfte.

Hier sind einige Schlussfolgerungen, die ich auf Grundlage des Beitrags von x und der Eigenschaften von Veo3 gezogen habe:

- Verbesserter nativer Ton (Dialog, Lippensynchronisation mehrerer Stimmen) – klarere Dialoge, besseres SFX-Mixing und Räumlichkeit). Veo 3 generiert Audio bereits nativ; Veo 3.1 könnte den Dialogrealismus und die Sprachunterstützung verbessern, um mit den jüngsten Verbesserungen der Konkurrenz mitzuhalten.

- Schnellere/günstigere Wege für einige gängige Ausgaben (mehr Veo 3 Fast-Parität und Optimierungen).

- Verbesserte Bild-Video-Wiedergabetreue und bessere Charakter-/Pose-Konsistenz in Multi-Frame-Clips.

- Erweiterte Seitenverhältnisse/Auflösungssteuerungen (flexiblere 9:16/16:9 und 1080p über Konfigurationen hinweg). Google hat bereits vertikal + 1080p hinzugefügt; Veo 3.1 könnte diese Steuerelemente erweitern.

- Längere Clips / entspannte 8-Sekunden-Obergrenze – Die Nachfrage der Community und der bisherige Fahrplan von Google lassen darauf schließen, dass eine längere Dauer ein wahrscheinliches Ziel ist (Veo 3 ist heute für 8-Sekunden-Clips optimiert).

- Bessere Bild-Video-Wiedergabetreue und erweiterte Bild-zu-Video-Unterstützung (Verbesserungen des Realismus, der Bewegungskontinuität), aufbauend auf der Bild-Video-Vorschau in Veo 3.

Vergleiche Veo 3 / (erwartet) Veo 3.1 → OpenAI Sora 2

Hauptfokus

- Veo 3 (Google): kurze, hochauflösende 8-Sekunden-Videos mit Text-/Bildaufforderungen; natives Audio; integriert in Gemini/Gemini API und Vertex AI; optimiert für den Produktionseinsatz und die API-Integration für Entwickler.

- Sora 2 (OpenAI): OpenAIs Flaggschiff-Video- und Audiomodell, das physischen Realismus, kohärente Bewegung, synchronisierten Dialog und Ton betont, sowie eine begleitende soziale App (Sora) mit einem Cameo-/Zustimmungssystem zur Integration von Benutzerähnlichkeiten und einem starken Fokus auf Realismus und Sicherheitskontrollen.

Stärken

- Veo (jetzt): starke Entwickler-/Unternehmensintegration (Vertex AI, Gemini API), Produktionspreisoptionen, klarer Weg für Cloud-Kunden, vertikale/1080p + schnelle Variante. Gut für Unternehmen, die in Pipelines einbauen.

- Sora 2: Bemerkenswerte physische Genauigkeit und multimodale Synchronisierung (Dialog + Bildmaterial) sowie eine verbraucherorientierte App mit Integration in soziale Workflows (Cameo-Funktion, Moderation). Ideal für Entwickler, die realistische Erzählszenen und ein App-Ökosystem wünschen.

So greifen Sie jetzt auf Veo zu – und bereiten sich auf Veo 3.1 vor

- Versuchen Sie es in Gemini (Verbraucher/Web/Mobil): Die Veo-Generierung wird in den Gemini-Apps angezeigt (tippen Sie in der Eingabeaufforderung auf die Option „Video“). Die Zugriffsebene (Pro/Ultra) bestimmt, welche Veo-Varianten Sie verwenden können.

- Programmgesteuert / Unternehmen: benutzen API in CometAPI (Veo-Modell-IDs finden Sie in der Modelldokumentation). CometAPI bietet veo3-pro, veo3-fast und veo3. Weitere Informationen finden Sie unter Veo 3 's Dock.

Praxistipp (Entwickler): Um eine vertikale Ausgabe anzufordern, stellen Sie die aspectRatio Parameter (zB "9:16") und überprüfen Sie die Modellkonfiguration (Veo 3 vs. Veo 3 Fast) und Ihren Plan hinsichtlich der Auflösungsgrenzen (720p vs. 1080p).

So greifen Sie (heute) auf Sora 2 zu

Sora-App: Sora 2 wurde mit einer Sora-App veröffentlicht (begrenzte Einführung in den USA und Kanada zum Start). OpenAI kündigte später einen breiteren Zugriff und eine API-Erweiterung an. Wenn Sie Sora 2 jetzt ausprobieren möchten, besuchen Sie CpmetAPIs Sora 2 Seite. CometAPI hat bereits die Sora 2 API unterstützt und generiert ca. 10 Sekunden lange Social Clips und legt den Schwerpunkt auf Bewegungsrealismus für Menschen.

Erste Schritte

CometAPI ist eine einheitliche API-Plattform, die über 500 KI-Modelle führender Anbieter – wie die GPT-Reihe von OpenAI, Gemini von Google, Claude von Anthropic, Midjourney, Suno und weitere – in einer einzigen, entwicklerfreundlichen Oberfläche vereint. Durch konsistente Authentifizierung, Anforderungsformatierung und Antwortverarbeitung vereinfacht CometAPI die Integration von KI-Funktionen in Ihre Anwendungen erheblich. Ob Sie Chatbots, Bildgeneratoren, Musikkomponisten oder datengesteuerte Analyse-Pipelines entwickeln – CometAPI ermöglicht Ihnen schnellere Iterationen, Kostenkontrolle und Herstellerunabhängigkeit – und gleichzeitig die neuesten Erkenntnisse des KI-Ökosystems zu nutzen.

Entwickler können zugreifen Veo 3.1 API über CometAPI, die neuste Modellversion wird immer mit der offiziellen Website aktualisiert. Erkunden Sie zunächst die Fähigkeiten des Modells in der Spielplatz und konsultieren Sie die API-Leitfaden Für detaillierte Anweisungen. Stellen Sie vor dem Zugriff sicher, dass Sie sich bei CometAPI angemeldet und den API-Schlüssel erhalten haben. CometAPI bieten einen Preis weit unter dem offiziellen Preis an, um Ihnen bei der Integration zu helfen.

Bereit loszulegen? → Melden Sie sich noch heute für CometAPI an !