CometAPI CometAPI bietet Entwicklern und Unternehmen eine einheitliche Plattform für die zunehmende Komplexität bei der Integration und Verwaltung verschiedener KI-Modelle und bietet einen zentralen Zugang zu über 500 KI-Modellen weltweit. Durch die Bündelung führender Dienste – von umfangreichen Sprachmodellen bis hin zu hochmodernen multimodalen Systemen – optimiert CometAPI Entwicklungsabläufe, senkt Kosten und beschleunigt die Markteinführung. Dieser Artikel befasst sich mit den Grundlagen von CometAPI, erläutert die Funktionsweise, führt Sie durch die einzelnen Schritte und stellt die neuesten Modellaktualisierungen vor, die das Ökosystem unterstützen.

Was ist CometAPI?

Eine einheitliche Plattform zur Aggregation von KI-Modellen

CometAPI ist eine entwicklerzentrierte API-Aggregationsplattform, die den Zugriff auf über 500 KI-Modelle unter einer einzigen, konsistenten Oberfläche vereint. Anstatt separate Integrationen mit der GPT-Reihe von OpenAI, Claude von Anthropics, Midjourney, Suno, Gemini von Google und anderen durchzuführen, senden Entwickler Anfragen an den Endpunkt von CometAPI und geben das gewünschte Modell namentlich an. Diese Konsolidierung vereinfacht die Integration erheblich und reduziert den Verwaltungsaufwand für mehrere API-Schlüssel, Endpunkte und Abrechnungssysteme.

Wichtige Vorteile für Entwickler und Unternehmen

Durch die Zentralisierung von Modellen auf einer einzigen Plattform bietet CometAPI:

- Vereinfachte Abrechnung: Eine einheitliche Rechnung, die die gesamte Modellnutzung abdeckt, wodurch fragmentierte Lieferantenrechnungen vermieden werden.

- Herstellerunabhängigkeit: Müheloser Wechsel zwischen Modellen ohne Lock-in, wodurch langfristige Flexibilität gewährleistet wird.

- Hohe Parallelität und geringe Latenz: Ein serverloses Backbone bietet unbegrenzte Transaktionskapazität pro Minute und Antwortzeiten von unter 200 ms für die meisten textbasierten Anrufe.

- Kostenoptimierung: Mengenrabatte von bis zu 20 % auf beliebte Modelle helfen Teams, ihre KI-Ausgaben zu kontrollieren.

Wie funktioniert CometAPI?

Architektur und Schlüsselkomponenten

Der Kern von CometAPI ist eine leistungsstarke, serverlose Infrastruktur, die sich automatisch an die Nachfrage anpasst. Eingehende Anfragen durchlaufen einen globalen Load Balancer und werden basierend auf Faktoren wie Latenz und Kosten an den am besten geeigneten Modellanbieter-Endpunkt – OpenAI, Anthropic, Google Cloud und andere – weitergeleitet. Im Hintergrund verwaltet CometAPI:

- API-Schlüsselverwaltung: Sichere Speicherung von Benutzerschlüsseln und Unterstützung für automatische Rotation.

- Rate-Multiplikator-Engine: Transparente Preismultiplikatoren, die an den offiziellen Modellpreisblättern ausgerichtet sind und so für Kostenkonsistenz sorgen.

- Nutzungsverfolgung und Abrechnung: Dashboards zur Messung in Echtzeit, die den Tokenverbrauch, die Modellnutzung und Ausgabenwarnungen anzeigen.

Wie verwende ich CometAPI?

1. Holen Sie sich einen API-Schlüssel

Melden Sie sich für eine kostenlose CometAPI an Konto, um ein Token zu erhalten (formatiert als sk-XXXXX) in Ihrem Dashboard. Dieses Token gewährt Zugriff auf alle integrierten Modelle und wird in der Authorization Header von API-Anfragen.

2. Konfigurieren Sie die Basis-URL

Legen Sie in Ihrer Codebasis die Basis-URL wie folgt fest:

https://www.cometapi.com/console/

Alle nachfolgenden Aufrufe – ob Textvervollständigung, Bildgenerierung oder Dateisuche – werden über diesen einzelnen Endpunkt geleitet.

Verschiedene Clients müssen möglicherweise die folgenden Adressen ausprobieren:

- https://www.cometapi.com/console/

- https://api.cometapi.com/v1

- https://api.cometapi.com/v1/chat/completions

3. Führen Sie API-Aufrufe im OpenAI-Format durch

CometAPI akzeptiert Anfragen gemäß dem OpenAI-API-Schema. So generieren Sie beispielsweise Text mit GPT-4.1:

curl https://api.cometapi.com/v1/chat/completions \

-H "Authorization: Bearer sk-XXXXX" \

-H "Content-Type: application/json" \

-d '{

"model": "gpt-4.1",

"messages":

}'

Antworten und Fehlercodes spiegeln die der ursprünglichen Modellanbieter wider und ermöglichen so eine nahtlose Migration vorhandener OpenAI-basierter Integrationen.

Ersetzen

YOUR_API_KEYmit dem API-Schlüssel, den Sie bei der Registrierung erhalten haben.

Codebeispiel:

import os

from openai import OpenAI

client = OpenAI(

base_url="https://api.cometapi.com/v1/chat/completions",

api_key=os.getenv("COMETAPI_KEY"),

)

response = client.chat.completions.create(

model="claude-opus-4-20250514",

messages=[

{"role": "system", "content": "You are a coding assistant."},

{"role": "user", "content": "Refactor this function to improve performance."},

],

)

print(response.choices.message.content)

Dieses Snippet initialisiert den Anthropic-Client über CometAPI, sendet eine Chat-Abschlussanforderung an den Instant-Modus von Claude Opus 4 und druckt die Antwort des Assistenten aus.

4. Handbuch zur Softwareintegration

Die Integration von CometAPI mit Plattformen von Drittanbietern (wie n8n, Cherry Studio, Zapier, Cursor usw.) kann die Entwicklungseffizienz erheblich verbessern, Kosten senken und die Governance-Fähigkeiten stärken.Seine Vorteile:

- Tools von Drittanbietern unterstützen in der Regel den Aufruf OpenAI-kompatibler Schnittstellen über HTTP/REST oder dedizierte Knoten. Mit CometAPI als Anbieter im Hintergrund können Sie bestehende Workflows oder Assistenteneinstellungen unverändert wiederverwenden, indem Sie die Basis-URL einfach auf https://www.cometapi.com/console/ verweisen.

- Nach der Verbindung mit CometAPI ist kein Wechsel zwischen mehreren Anbietern mehr erforderlich. Sie können verschiedene Modelle (wie GPT-4o, Claude 3.7, Midjourney usw.) mit einem Klick in derselben Umgebung testen und so den Fortschritt vom Konzept zum verifizierbaren Prototyp erheblich beschleunigen.

- Im Vergleich zur Abrechnung mit jedem einzelnen Modellanbieter fasst CometAPI die Rechnungen aller Anbieter zusammen und bietet gestaffelte Rabatte auf der Grundlage der Nutzung, wodurch durchschnittlich 10–20 % der Kosten gespart werden.

Es können Tutorials zu beliebten Softwareanwendungen herangezogen werden:

- Eine Anleitung zum Einrichten des Cursors mit CometAPI

- Wie man Cherrystudio mit CometAPI verwendet

- So verwenden Sie n8n mit CometAPI

Typische Anwendungsszenarien:

- Automatisierte Prozesse in n8n: Verwenden Sie den HTTP-Anforderungsknoten, um zuerst Bilder (Midjourney) zu generieren, und rufen Sie dann GPT-4.1 auf, um Bildunterschriften dafür zu schreiben, um eine multimodale Ausgabe mit einem Klick zu erreichen.

- Desktop-Assistent in Cherry Studio: Registrieren Sie CometAPI als benutzerdefinierten OpenAI-Anbieter, und Administratoren können die erforderlichen Modelle in der GUI präzise aktivieren/deaktivieren, sodass Endbenutzer im selben Dialogfenster frei wechseln können. Cherry Studio ruft automatisch die neueste Modellliste aus /v1/models ab, und alle neu verbundenen CometAPI-Modelle werden in Echtzeit angezeigt, sodass manuelle Aktualisierungen entfallen.

Welche Modelle unterstützt CometAPI?

Durch die Verbindung verschiedener Anbieter bietet CometAPI eine umfangreiche, ständig wachsende Bibliothek an KI-Funktionen.

Modellkategorien

- Large Language Models : GPT (o4mini, o3, GPT-4o, GPT-4.1 usw.), Claude (Claude 4 Sonnet, Opus usw.). Google Gemini-Reihe (Gemini 2.5). Qwen (Qwen 3, qwq), Mistral- und LLaMA-basierte Modelle (Mistral-große .llama 4-Serie), Deepseeks Modelle usw.

- Vision & Multimodal: Midjourney (Fast Imagine, benutzerdefinierter Zoom), Luma, GPT-Bild-1, stabile Diffusionsmodelle (sdxl usw.)

- Audio & Musik: Suno (Musik, Texte), Udio.

- Spezial- und Reverse-Engineering: Grok, FLUX, Kling.text-embedding-ada-002 usw.

Aktuelle Modellveröffentlichungen

Gemini 2.5 Pro Vorschau (2025): Führt ein Kontextfenster mit einer Million Token und native multimodale Funktionen für fortgeschrittene Denkaufgaben ein. Gemini 1 – offizielle neueste Version Gemini 2.5 Pro Vorschau-API (Modell: gemini-2.5-pro-preview-06-05) in CometAPI zugreifen kann.

DeepSeek R1 (2025): Bietet umfassende Argumentationsleistung für komplexe Abfrageaufgaben, jetzt verfügbar über den Standard-Chat-Endpunkt. Offizielle neueste Version von DeepSeek R1 ——DeepSeek R1 API (Modell: deepseek-r1-0528) in CometAPI zugreifen kann.

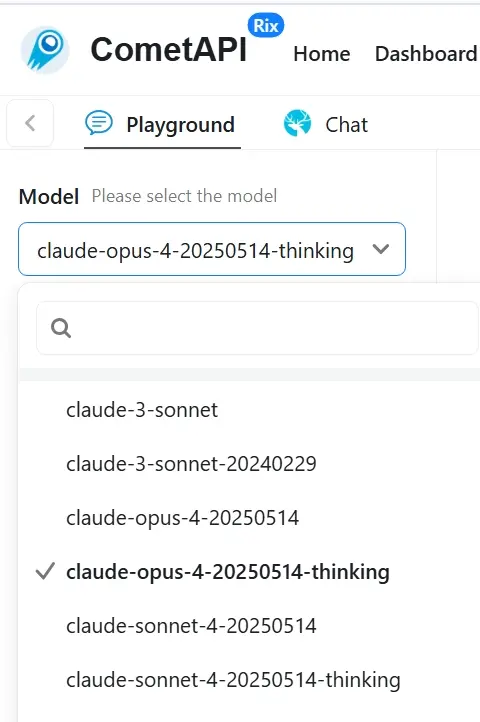

Claude 4 (2025): Verbessert die Kodierung und das logische Denken innerhalb der Claude-Reihe von Anthropics, optimiert für den kosteneffizienten Einsatz in Unternehmen. Offizielle neueste Version von Claude 4 ——Claude Opus 4 API (Modell: claud; claude-opus-4-20250514-thinking)und Claude Sonnet 4 API (Modell: claude-sonnet-4-20250514 ;claude-sonnet-4-20250514-thinking) in CometAPI zugreifen können. Wir haben auch c hinzugefügtometapi-sonnet-4-20250514-thinking speziell für die Verwendung im Cursor.

GPT-Bild-1 (2025): Bringt die Bildgenerierungsleistung von GPT-4o direkt zu Entwicklern und unterstützt hochauflösende Ausgaben und vielfältige stilistische Renderings. Und GPT-image-1 API ist das Top-Drei-Modell für Website-Besuche

GPT-4.1-Serie (2025): Enthält Mini- und Nano-Varianten, die Leistung mit reduzierter Latenz und Kosten in Einklang bringen und neue Maßstäbe für Aufgaben mit langem Kontext setzen. Offizielle neueste Version von GPT 4.1 ——GPT-4.1-API (Modell: gpt-4.1;gpt-4.1-nano;gpt-4.1-mini) in CometAPI kann darauf zugreifen.

Einheitlicher Zugriff auf neue Modelle

CometAPI kündigte Unterstützung für erweiterte Reverse-Engineering-Modelle und erweiterten Zugriff auf Midjourney und Suno für generative Kunst- und Musikanwendungen an. Nutzer können diese Modelle nun direkt über die einheitliche API von CometAPI aufrufen und profitieren von Rabatten von bis zu 20 Prozent auf beliebte Angebote.

Derzeit folgt cometAPI dem offiziellen Tempo. Suno Music API wurde auf Version v4.5 aktualisiert und Midjourney-API wurde auf Version v7 aktualisiert. Spezifische API-Details und -Aufrufe finden Sie in der API-Dokumentation, die speziell für Zwischendurch kombiniert mit einem nachhaltigen Materialprofil. sunoWenn Sie andere visuelle Modelle wie Sora, Runway usw. aufrufen möchten, um Bilder oder Videos zu generieren, lesen Sie bitte die entsprechenden Referenzdokumente auf der Website.

Hinweis: Diese Liste ist beispielhaft, nicht vollständig. CometAPI fügt kontinuierlich neue Anbieter und Modellversionen hinzu, sobald diese öffentlich verfügbar sind – oft innerhalb weniger Tage nach der offiziellen Veröffentlichung. So haben Sie immer sofortigen Zugriff auf die neuesten Entwicklungen, ohne Ihren Code ändern zu müssen.

Um die vollständige, aktuelle Liste aller über 500 Modelle zu sehen, greifen Sie zu Modellseite

FAQ

1. Welches Preismodell verwendet CometAPI?

CometAPI wendet transparente Multiplikatoren auf die offiziellen Modellpreise an – die Multiplikatoren sind bei allen Anbietern einheitlich. Die Abrechnung erfolgt nutzungsbasiert mit detaillierter tokenbasierter Messung und optionalen Mengenrabatten für Konten mit hoher Nutzung.

2. Kann ich die Nutzung in Echtzeit überwachen?

Ja. Das CometAPI-Dashboard zeigt Live-Metriken zu API-Aufrufen, Token-Nutzung und Ausgaben an. Sie können benutzerdefinierte Benachrichtigungen einrichten, um Ihr Team zu benachrichtigen, wenn Schwellenwerte erreicht werden.

3. Wie gehe ich mit großen Kontextfenstern um?

CometAPI unterstützt Modelle mit bis zu 1 Million Token-Kontextfenstern (z. B. Gemini 2.5 Pro, GPT-4.1-nano) und ermöglicht so komplexe, umfangreiche Aufgaben. Geben Sie einfach den Modellnamen im API-Aufruf an, und CometAPI leitet die Anfrage entsprechend weiter.

4. Welche Sicherheitsmaßnahmen gibt es?

Der gesamte API-Verkehr wird über TLS 1.3 verschlüsselt. API-Schlüssel werden sicher in hardwaregestützten Schlüsseltresoren gespeichert. Für Unternehmenskunden erfüllen verschlüsselte Argumentationselemente und Datenaufbewahrungskontrollen die Zero-Retention-Compliance-Standards.

5. Wie kann ich Support erhalten oder Probleme melden?

CometAPI bietet eine ausführliche Dokumentation, eine aktive Discord-Community und E-Mail-Support unter . Unternehmenskunden erhalten außerdem ein dediziertes Account-Management und SLAs für Verfügbarkeit und Leistung.

Fazit

Durch die Konsolidierung Hunderter KI-Modelle unter einer API ermöglicht CometAPI Entwicklern schnellere Iterationen, Kostenkontrolle und Herstellerunabhängigkeit – und das alles, während sie gleichzeitig von den neuesten Erkenntnissen profitieren. Ob Sie die nächste Generation von Chatbots, Multimedia-Content-Generatoren oder datengetriebenen Analyse-Pipelines entwickeln – CometAPI bietet Ihnen die einheitliche Grundlage, um Ihre KI-Ambitionen voranzutreiben.