GPT-5.2 ist OpenAIs Point-Release vom Dezember 2025 innerhalb der GPT-5-Familie: eine führende multimodale Modellfamilie (Text + Vision + Tools), abgestimmt auf professionelle Wissensarbeit, Langkontext-Reasoning, agentische Toolnutzung und Software Engineering. OpenAI positioniert GPT-5.2 als das bislang leistungsfähigste Modell der GPT-5-Reihe und gibt an, es mit Schwerpunkt auf zuverlässiges mehrstufiges Reasoning, die Verarbeitung sehr großer Dokumente sowie verbesserte Sicherheit/Policy-Compliance entwickelt zu haben; der Release umfasst drei nutzerorientierte Varianten — Instant, Thinking und Pro — und wird zuerst für zahlende ChatGPT-Abonnenten und API-Kunden ausgerollt.

Was ist GPT-5.2 und warum ist es wichtig?

GPT-5.2 ist das neueste Mitglied der GPT-5-Familie — eine neue „Frontier“-Modellreihe, die speziell darauf ausgelegt ist, die Lücke zwischen Ein-Turn-Konversationsassistenten und Systemen zu schließen, die über lange Dokumente hinweg schlussfolgern, Tools aufrufen, Bilder interpretieren und mehrstufige Workflows zuverlässig ausführen müssen. OpenAI positioniert 5.2 als den bislang leistungsfähigsten Release für professionelle Wissensarbeit: Es setzt neue State-of-the-Art-Ergebnisse auf internen Benchmarks (insbesondere einem neuen GDPval-Benchmark für Wissensarbeit), zeigt stärkere Coding-Leistung auf Software-Engineering-Benchmarks und bietet deutlich verbesserte Langkontext- und Vision-Fähigkeiten.

Praktisch betrachtet ist GPT-5.2 mehr als nur „ein größeres Chatmodell“. Es ist eine Familie aus drei abgestimmten Varianten (Instant, Thinking, Pro), die Latenz, Reasoning-Tiefe und Kosten gegeneinander abwägen — und die zusammen mit OpenAIs API und ChatGPT-Routing genutzt werden können, um lange Research-Jobs auszuführen, Agenten zu bauen, die externe Tools aufrufen, komplexe Bilder und Charts interpretieren und Code in Produktionsqualität mit höherer Treue als frühere Releases generieren. Das Modell unterstützt sehr große Kontextfenster (OpenAI-Dokumente nennen ein Kontextfenster von 400.000 Tokens und ein Max-Output-Limit von 128.000 für die Flaggschiffmodelle), neue API-Funktionen für explizite Reasoning-Aufwandsstufen und agentisches Toolaufruf-Verhalten.

5 Kernfähigkeiten, die in GPT-5.2 verbessert wurden

1) Ist GPT-5.2 besser bei mehrstufiger Logik und Mathematik?

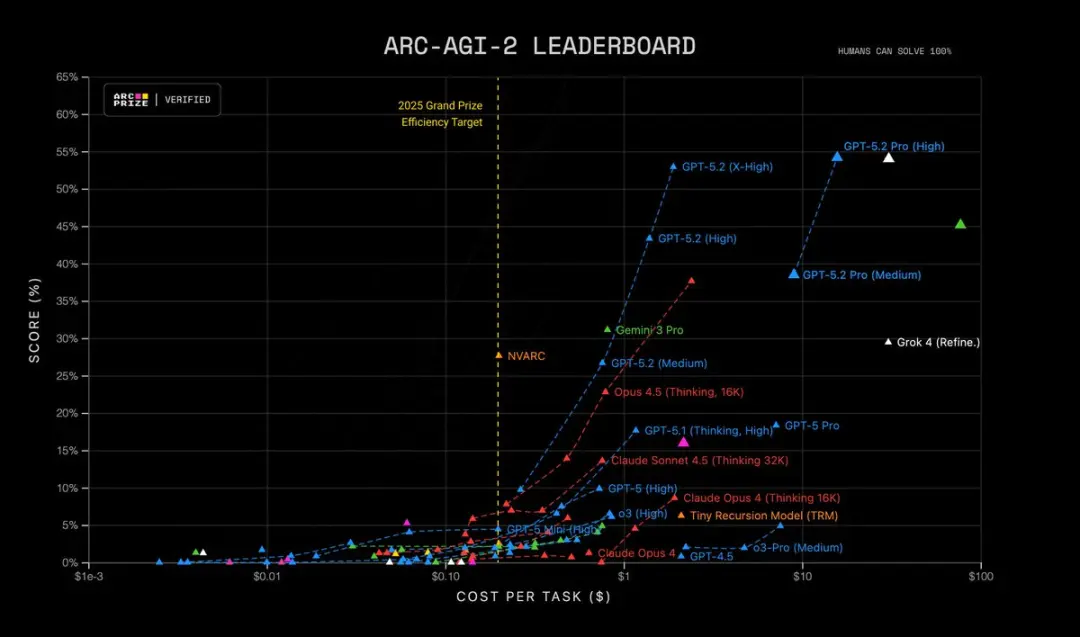

GPT-5.2 bringt schärferes mehrstufiges Reasoning und sichtbar stärkere Leistung in Mathematik und strukturierter Problemlösung. OpenAI sagt, sie hätten eine feinere Steuerung des Reasoning-Aufwands hinzugefügt (neue Stufen wie xhigh), „Reasoning-Token“-Support entwickelt und das Modell so abgestimmt, dass es Chain-of-Thought über längere interne Reasoning-Spuren beibehält. Benchmarks wie FrontierMath und ARC-AGI-ähnliche Tests zeigen substanzielle Zugewinne gegenüber GPT-5.1; es erzielt größere Abstände auf domänenspezifischen Benchmarks, die in wissenschaftlichen und finanziellen Workflows genutzt werden. Kurz: GPT-5.2 „denkt länger“ auf Nachfrage und kann komplexere symbolische/mathematische Arbeit mit besserer Konsistenz ausführen.

| RC-AGI-1 (Verifiziert) Abstraktes Schlussfolgern | 86.2% | 72.8% |

|---|---|---|

| ARC-AGI-2 (Verifiziert) Abstraktes Schlussfolgern | 52.9% | 17.6% |

GPT-5.2 Thinking setzt Rekorde in mehreren fortgeschrittenen Tests zu Wissenschaft und mathematischem Reasoning:

- GPQA Diamond Science Quiz: 92.4% (Pro-Version 93.2%)

- ARC-AGI-1 Abstraktes Schlussfolgern: 86.2% (erstes Modell, das die 90%-Schwelle überschreitet)

- ARC-AGI-2 Höherordentliches Schlussfolgern: 52.9%, neuer Rekord für das Thinking Chain-Modell

- FrontierMath Test für Fortgeschrittene Mathematik: 40.3%, weit übertrifft den Vorgänger;

- HMMT Mathewettbewerbsaufgaben: 99.4%

- AIME Mathetest: 100% vollständige Lösung

Darüber hinaus ist GPT-5.2 Pro (High) State-of-the-Art auf ARC-AGI-2 und erreicht 54.2% bei Kosten von $15.72 pro Aufgabe! Übertrifft alle anderen Modelle.

Warum das wichtig ist: viele reale Aufgaben — Finanzmodellierung, Versuchsdesign, Programmsynthese mit formaler Logik — sind durch die Fähigkeit eines Modells limitiert, viele korrekte Schritte zu verketten. GPT-5.2 reduziert „halluzinierte Schritte“ und erzeugt stabilere Zwischen-Reasoning-Spuren, wenn man es bittet, sein Vorgehen zu zeigen.

2) Wie haben sich Langtextverständnis und cross-dokumentales Reasoning verbessert?

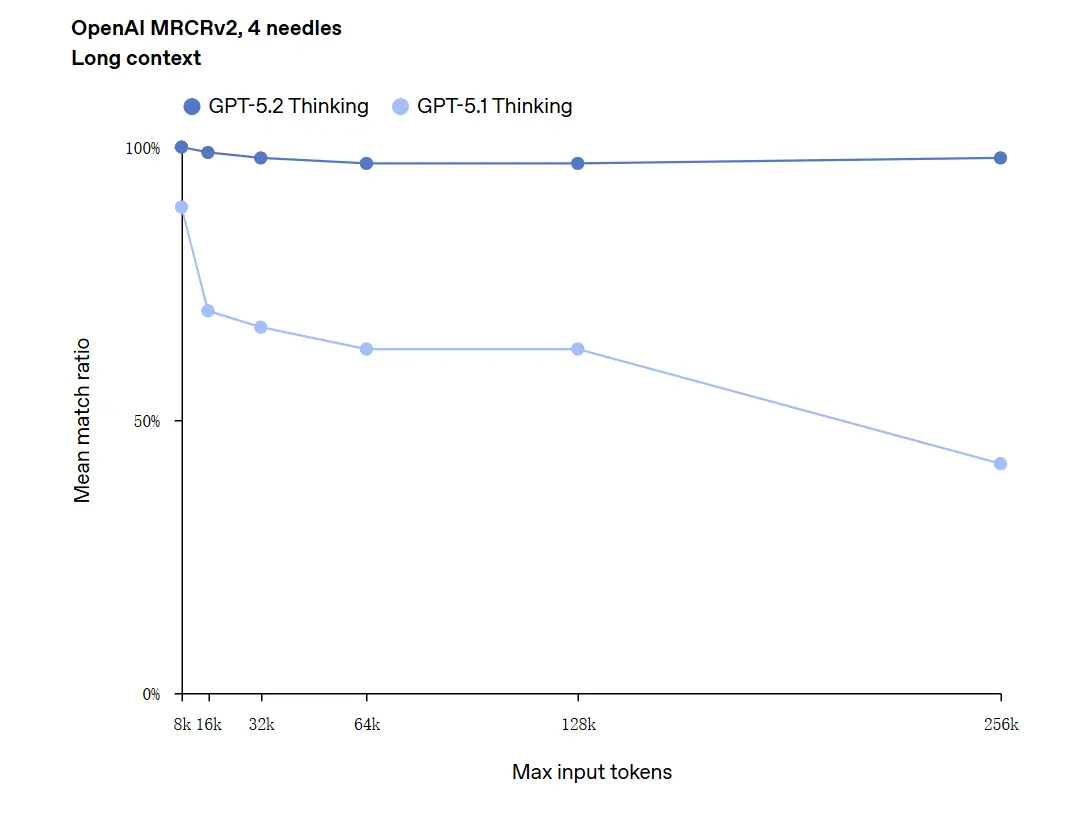

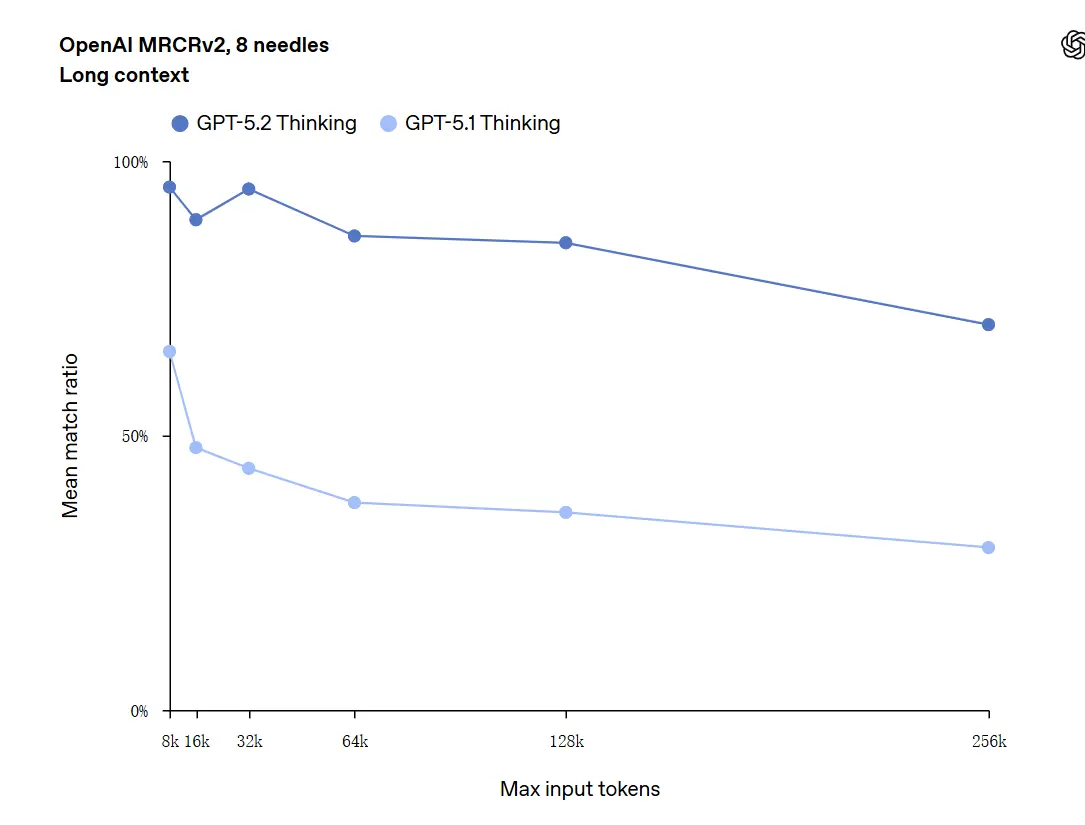

Langkontext-Verständnis ist eine der herausragenden Verbesserungen. Das zugrunde liegende Modell von GPT-5.2 unterstützt ein Kontextfenster von 400k Tokens und — wichtig — hält höhere Genauigkeit, wenn relevante Inhalte tief in diesen Kontext wandern. GDPval, eine Aufgabensuite für „klar spezifizierte Wissensarbeit“ über 44 Berufe, in der GPT-5.2 Thinking bei einem großen Anteil der Aufgaben Gleichstand oder bessere Ergebnisse als menschliche Expertenrichter erzielt. Unabhängige Berichte bestätigen, dass das Modell Informationen über viele Dokumente hinweg deutlich besser hält und synthetisiert als frühere Modelle. Dies ist ein wirklich praktischer Schritt nach vorn für Aufgaben wie Due Diligence, juristische Zusammenfassungen, Literaturreviews und Codebase-Verständnis.

GPT-5.2 kann Kontexte bis zu 256.000 Tokens verarbeiten (entspricht ungefähr 200+ Seiten Dokumente). Darüber hinaus erzielte GPT-5.2 Thinking im Langtextverständnistest „OpenAI MRCRv2“ eine Genauigkeit nahe 100%.

Einschränkung zur „100% Genauigkeit“: Die Verbesserungen wurden als „nahe an 100%“ für enge Mikroaufgaben beschrieben; OpenAIs Daten sind besser als „State-of-the-Art und in vielen Fällen auf oder über Expertenniveau bei den evaluierten Aufgaben“ zu charakterisieren, nicht im wörtlichen Sinne fehlerfrei für alle Anwendungen. Benchmarks zeigen große Zugewinne, aber keine universelle Perfektion.

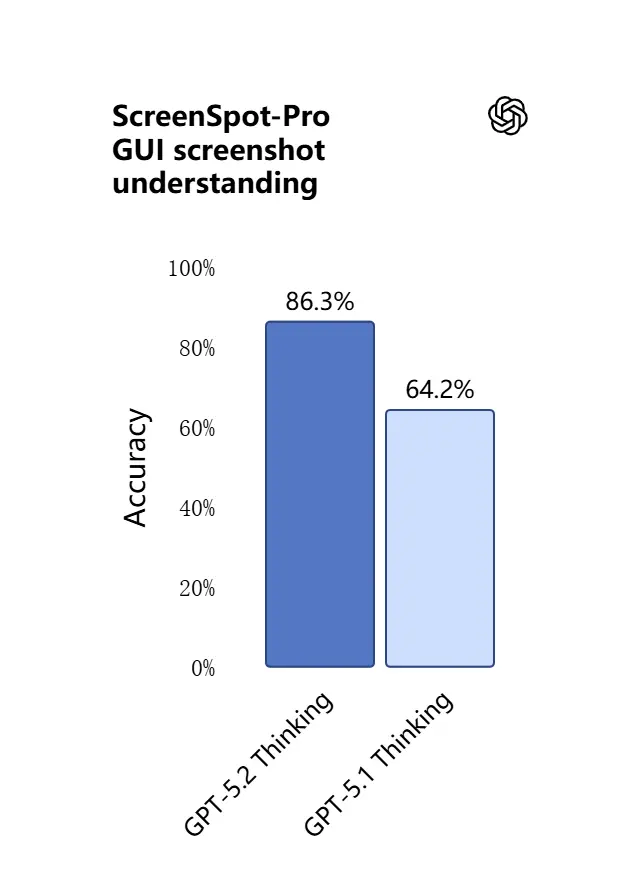

3) Was ist neu beim visuellen Verständnis und multimodalen Reasoning?

Die Vision-Fähigkeiten in GPT-5.2 sind präziser und praxisnäher. Das Modell interpretiert Screenshots besser, liest Charts und Tabellen, erkennt UI-Elemente und kombiniert visuelle Eingaben mit langem Textkontext. Das ist nicht nur Captioning: GPT-5.2 kann strukturierte Daten aus Bildern extrahieren (z. B. Tabellen in einem PDF), Graphen erläutern und über Diagramme so schlussfolgern, dass nachgelagerte Toolaktionen unterstützt werden (z. B. aus einem fotografierten Bericht eine Tabelle erzeugen).

.webp)

Praktischer Effekt: Teams können vollständige Foliensätze, gescannte Forschungsberichte oder bildlastige Dokumente direkt in das Modell einspeisen und um cross-dokumentale Synthesen bitten — was die manuelle Extraktionsarbeit deutlich reduziert.

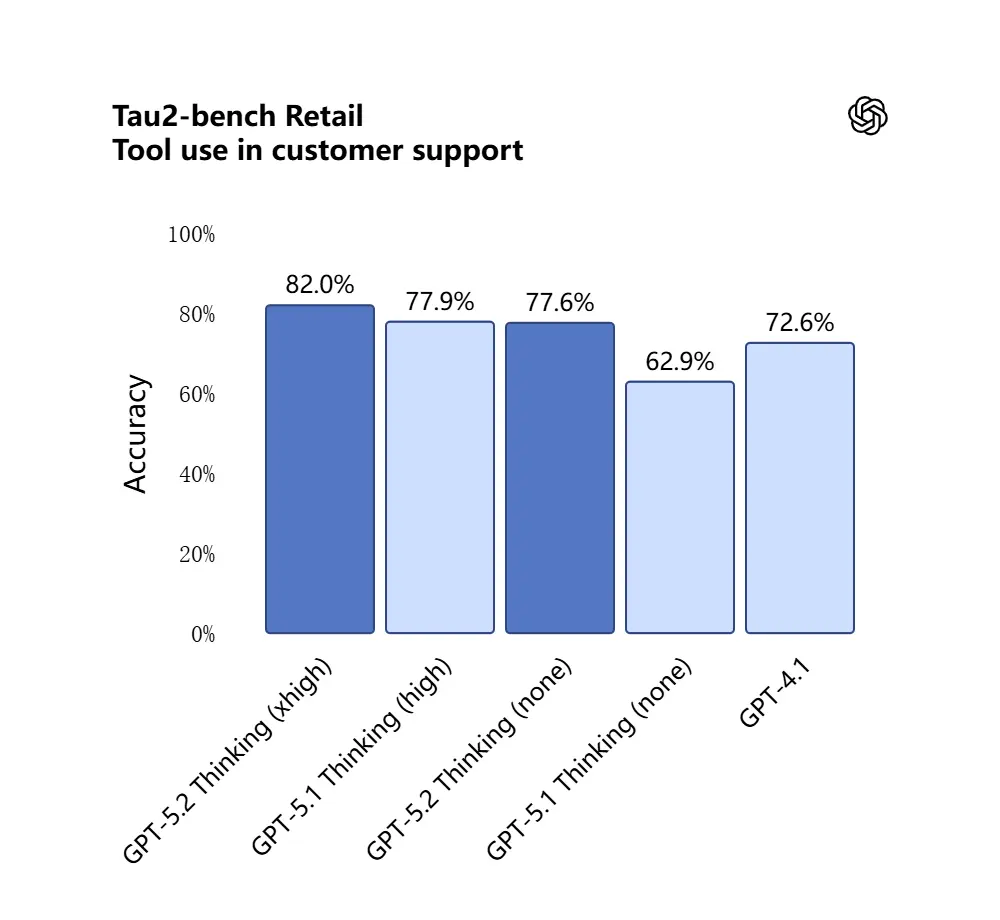

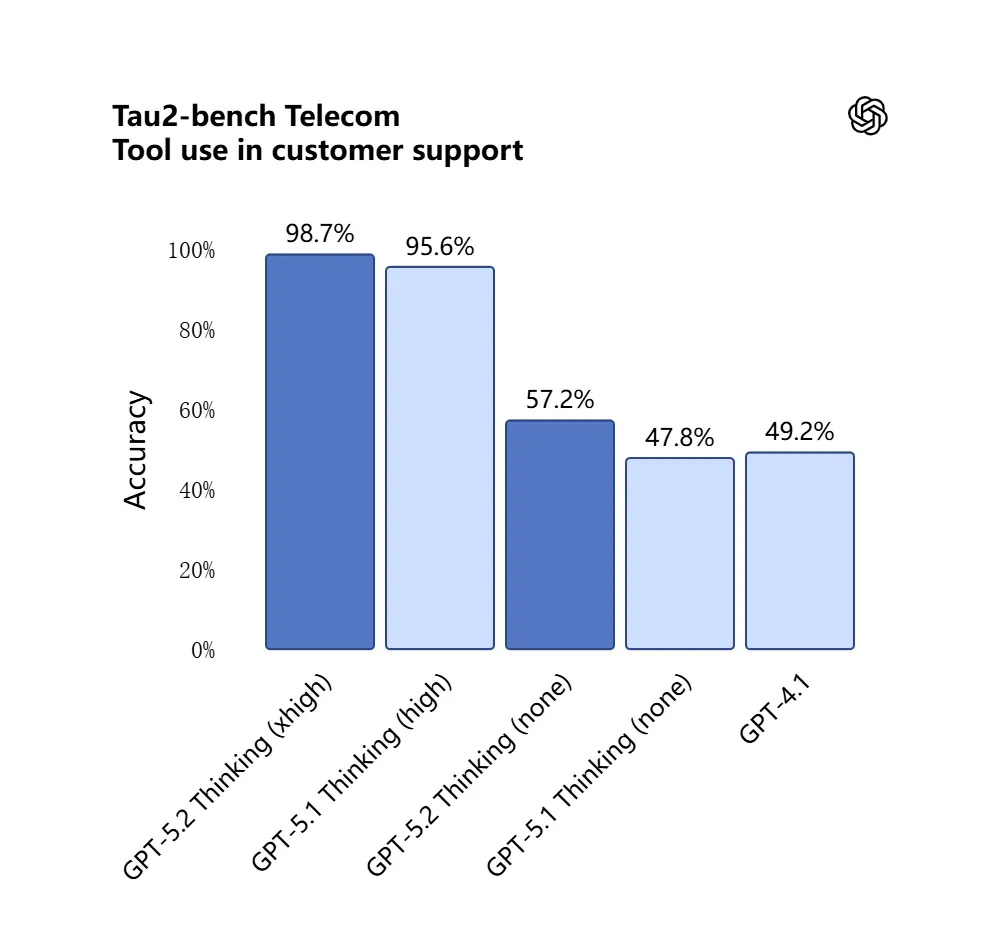

4) Wie haben sich Toolaufrufe und die Ausführung von Aufgaben verändert?

GPT-5.2 geht weiter in agentisches Verhalten: Es plant mehrstufige Aufgaben besser, entscheidet, wann externe Tools aufzurufen sind, und führt Sequenzen von API-/Toolaufrufen aus, um einen Job Ende-zu-Ende zu erledigen. Verbesserungen beim „agentischen Tool-Calling“ — das Modell schlägt einen Plan vor, ruft Tools (Datenbanken, Compute, Dateisysteme, Browser, Code-Runner) auf und synthetisiert Ergebnisse zuverlässiger als frühere Modelle zu einem finalen Deliverable. Die API führt Routing und Sicherheitskontrollen ein (Listen erlaubter Tools, Tool-Scaffolding) und die ChatGPT-UI kann Anfragen automatisch auf die passende 5.2-Variante (Instant vs Thinking) routen.

GPT-5.2 erzielte 98.7% im Tau2-Bench Telecom-Benchmark und demonstrierte seine ausgereiften Tool-Calling-Fähigkeiten in komplexen Multi-Turn-Aufgaben.

Warum das wichtig ist: Das macht GPT-5.2 als autonomer Assistent nützlicher für Workflows wie „diese Verträge einlesen, Klauseln extrahieren, eine Tabelle aktualisieren und eine Zusammenfassungs-E-Mail schreiben“ — Aufgaben, die zuvor sorgfältige Orchestrierung erforderten.

5) Programmierfähigkeit weiterentwickelt

GPT-5.2 ist deutlich besser bei Software-Engineering-Aufgaben: Es schreibt vollständigere Module, generiert und führt Tests zuverlässiger aus, versteht komplexe Abhängigkeitsgraphen in Projekten und ist weniger anfällig für „Lazy Coding“ (Auslassen von Boilerplate oder fehlendes Verbinden von Modulen). Auf industrienahen Coding-Benchmarks (SWE-bench Pro etc.) setzt GPT-5.2 neue Bestmarken. Für Teams, die LLMs als Pair-Programmer einsetzen, kann diese Verbesserung den manuellen Prüf- und Nacharbeitsaufwand nach der Generierung reduzieren.

Im SWE-Bench Pro-Test (realweltliche industrielle Software-Engineering-Aufgabe) stieg die Punktzahl von GPT-5.2 Thinking auf 55.6%, während es im SWE-Bench Verified-Test zudem einen neuen Höchstwert von 80% erreichte.

_Software%20engineering.webp)

In der praktischen Anwendung bedeutet das:

- Automatisches Debugging von Code in Produktionsumgebungen führt zu größerer Stabilität;

- Unterstützung für mehrsprachige Programmierung (nicht auf Python beschränkt);

- Fähigkeit, End-to-End-Reparaturaufgaben eigenständig zu erledigen.

Worin unterscheiden sich GPT-5.2 und GPT-5.1?

Kurzantwort: GPT-5.2 ist eine iterative, aber substanzielle Verbesserung. Es behält die Architektur und multimodalen Grundlagen der GPT-5-Familie bei, treibt jedoch vier praktische Dimensionen voran:

- Tiefe und Konsistenz des Reasonings. 5.2 führt höhere Reasoning-Aufwandsstufen ein und verbessert das Verketten bei mehrstufigen Problemen; 5.1 hatte das Reasoning bereits verbessert, aber 5.2 hebt die Decke für komplexe Mathematik und mehrstufige Logik.

- Zuverlässigkeit im Langkontext. Beide Versionen erweiterten den Kontext, aber 5.2 ist darauf getrimmt, die Genauigkeit tief in sehr langen Eingaben zu halten (OpenAI beansprucht verbesserte Retention über Hunderttausende Tokens hinweg).

- Vision + multimodale Treue. 5.2 verbessert die Querverweise zwischen Bildern und Text — z. B. ein Chart lesen und diese Daten in eine Tabelle integrieren — und zeigt höhere Genauigkeit auf Aufgabenebene.

- Agentisches Toolverhalten und API-Funktionen. 5.2 stellt neue Reasoning-Aufwandsparameter (

xhigh) und Kontextkompaktierung in der API bereit, und OpenAI hat die Routinglogik in ChatGPT verfeinert, sodass die UI automatisch die beste Variante wählen kann. - Weniger Fehler, größere Stabilität: GPT-5.2 reduziert seine „Illusionsrate“ (Fehlantwortquote) um 38%. Es beantwortet Forschungs-, Schreib- und Analysefragen zuverlässiger und verringert Fälle „fabrizierter Fakten“. Bei komplexen Aufgaben ist die strukturierte Ausgabe klarer und die Logik stabiler. Gleichzeitig ist die Antwortsicherheit des Modells in Aufgaben rund um psychische Gesundheit deutlich verbessert. Es arbeitet robuster in sensiblen Szenarien wie psychischer Gesundheit, Selbstverletzung, Suizid und emotionaler Abhängigkeit.

In Systemauswertungen erzielte GPT-5.2 Instant 0.995 (von 1.0) bei der Aufgabe „Mental Health Support“ und lag damit deutlich über GPT-5.1 (0.883).

Quantitativ zeigen die veröffentlichten Benchmarks von OpenAI messbare Zugewinne auf GDPval, Mathematik-Benchmarks (FrontierMath) und Software-Engineering-Evaluationen. GPT-5.2 übertrifft GPT-5.1 bei Tabellenaufgaben im Junior Investment Banking um mehrere Prozentpunkte.

Ist GPT-5.2 kostenlos — wie viel kostet es?

Kann ich GPT-5.2 kostenlos nutzen?

OpenAI hat GPT-5.2 zunächst in bezahlten ChatGPT-Plänen und über die API ausgerollt. Historisch hat OpenAI die schnellsten/tiefsten Modelle hinter Bezahlstufen vorgehalten, während leichtere Varianten später breiter zugänglich wurden; bei 5.2 teilte das Unternehmen mit, dass der Rollout bei bezahlten Plänen (Plus, Pro, Business, Enterprise) beginne und die API Entwicklern zur Verfügung stehe. Das bedeutet, dass sofortiger Gratiszugang begrenzt ist: Der Free-Tier kann später degradierte oder geroutete Zugänge (z. B. auf leichtere Subvarianten) erhalten, wenn OpenAI den Rollout skaliert.

Die gute Nachricht ist, dass CometAPI jetzt mit GPT-5.2 integriert ist — und derzeit Weihnachtsrabatt bietet. Sie können GPT-5.2 nun über CometAPI nutzen; das Playground erlaubt es, frei mit GPT-5.2 zu interagieren, und Entwickler können die GPT-5.2-API verwenden (CometAPI ist zu 20% des OpenAI-Preises bepreist), um Workflows zu bauen.

Was kostet es über die API (Entwickler-/Produktionsnutzung)?

API-Nutzung wird pro Token abgerechnet. Die veröffentlichten Plattformpreise von OpenAI zum Launch zeigen (CometAPI ist zu 20% des OpenAI-Preises bepreist):

- GPT-5.2 (Standard-Chat) — $1.75 pro 1M Eingabe-Tokens und $14 pro 1M Ausgabe-Tokens (Rabatte für zwischengespeicherte Eingaben gelten).

- GPT-5.2 Pro (Flaggschiff) — $21 pro 1M Eingabe-Tokens und $168 pro 1M Ausgabe-Tokens (deutlich teurer, da für hochgenaue, rechenintensive Workloads vorgesehen).

- Im Vergleich war GPT-5.1 günstiger (z. B. $1.25 in / $10 out pro 1M Tokens).

Interpretation: Die API-Kosten sind gegenüber früheren Generationen gestiegen; der Preis signalisiert, dass die Premium-Fähigkeiten von 5.2 beim Reasoning und im Langkontext als eigene Produktstufe bepreist sind. Für Produktionssysteme hängen die Plan-Kosten stark davon ab, wie viele Tokens Sie ein-/ausgeben und wie oft Sie zwischengespeicherte Eingaben wiederverwenden (zwischengespeicherte Eingaben erhalten hohe Rabatte).

Was das in der Praxis bedeutet

- Für gelegentliche Nutzung über die ChatGPT-UI sind monatliche Abos (Plus, Pro, Business, Enterprise) der Hauptpfad. Die Preise für ChatGPT-Abostufen haben sich mit dem 5.2-Release nicht geändert (OpenAI hält die Planpreise stabil, selbst wenn sich die Modellangebote ändern).

- Für Produktion & Entwickler sollten Sie Token-Kosten einplanen. Wenn Ihre App viele lange Antworten streamt oder lange Dokumente verarbeitet, dominieren die Ausgabekosten ($14 / 1M Tokens für Thinking), sofern Sie Eingaben nicht sorgfältig cachen und Ausgaben wiederverwenden.

GPT-5.2 Instant vs GPT-5.2 Thinking vs GPT-5.2 Pro

OpenAI hat GPT-5.2 mit drei zweckgerichteten Varianten gestartet, passend zu Anwendungsfällen: Instant, Thinking und Pro:

- GPT-5.2 Instant: Schnell, kosteneffizient, abgestimmt auf Alltagsarbeit — FAQs, How-tos, Übersetzungen, schnelles Drafting. Niedrige Latenz; gute Erstentwürfe und einfache Workflows.

- GPT-5.2 Thinking: Tiefere, hochwertigere Antworten für nachhaltige Arbeit — Langdokument-Zusammenfassung, mehrstufige Planung, detaillierte Code-Reviews. Ausgewogen zwischen Latenz und Qualität; das „Arbeitspferd“ für professionelle Aufgaben.

- GPT-5.2 Pro: Höchste Qualität und Vertrauenswürdigkeit. Langsamer und teurer; am besten für schwierige, hochrelevante Aufgaben (komplexes Engineering, juristische Synthese, wertige Entscheidungen) und dort, wo ein „xhigh“-Reasoning-Aufwand erforderlich ist.

Vergleichstabelle

| Feature / Metrik | GPT-5.2 Instant | GPT-5.2 Thinking | GPT-5.2 Pro |

|---|---|---|---|

| Verwendungszweck | Alltagsaufgaben, schnelle Entwürfe | Tiefe Analysen, lange Dokumente | Höchste Qualität, komplexe Probleme |

| Latenz | Am niedrigsten | Moderat | Am höchsten |

| Reasoning-Aufwand | Standard | Hoch | xHigh verfügbar |

| Am besten für | FAQ, Tutorials, Übersetzungen, kurze Prompts | Zusammenfassungen, Planung, Tabellen, Coding-Aufgaben | Komplexes Engineering, juristische Synthese, Forschung |

| API-Name Beispiele | gpt-5.2-chat-latest | gpt-5.2 | gpt-5.2-pro |

| Preis Eingabetoken (API) | $1.75 / 1M | $1.75 / 1M | $21 / 1M |

| Preis Ausgabetoken (API) | $14 / 1M | $14 / 1M | $168 / 1M |

| Verfügbarkeit (ChatGPT) | Rollout; erst bezahlt, dann breiter | Rollout auf bezahlte Pläne | Pro-User / Enterprise (bezahlt) |

| Typisches Beispiel | E-Mail-Entwurf, kleinere Code-Snippets | Mehrblatt-Finanzmodell, langes Report Q&A | Codebase-Audit, Systemdesign in Produktionsqualität |

Wer eignet sich für die Nutzung von GPT-5.2?

GPT-5.2 ist für eine breite Zielgruppe konzipiert. Nachfolgend rollenbasierte Empfehlungen:

Unternehmen & Produktteams

Wenn Sie Produkte für Wissensarbeit bauen (Research-Assistenten, Vertragsprüfung, Analyse-Pipelines oder Developer-Tooling), können die Langkontext- und agentischen Fähigkeiten von GPT-5.2 die Integrationskomplexität deutlich verringern. Unternehmen mit Bedarf an robuster Dokumentenverarbeitung, automatisierten Berichten oder intelligenten Copilots werden Thinking/Pro nützlich finden. Microsoft und andere Plattformpartner integrieren 5.2 bereits in Produktivitäts-Stacks (z. B. Microsoft 365 Copilot).

Entwickler- und Engineering-Teams

Teams, die LLMs als Pair-Programmer einsetzen oder Codegenerierung/Testing automatisieren wollen, profitieren von der verbesserten Programmier-Treue in 5.2. API-Zugriff (mit thinking- oder pro-Modi) ermöglicht tiefere Synthesen großer Codebasen dank des 400k-Token-Kontextfensters. Rechnen Sie bei Nutzung von Pro mit höheren API-Kosten, aber die Reduktion manuellen Debuggings und Reviews kann sich für komplexe Systeme rechtfertigen.

Forschende und datenintensive Analysten

Wenn Sie regelmäßig Literatur synthetisieren, lange technische Berichte parsen oder modellgestütztes Versuchsdesign wünschen, helfen die Langkontext- und Mathematikverbesserungen von GPT-5.2, Workflows zu beschleunigen. Für reproduzierbare Forschung sollten Sie das Modell mit sorgfältigem Prompt-Engineering und Verifikationsschritten koppeln.

Kleine Unternehmen und Power-User

ChatGPT Plus (und Pro für Power-User) erhält gerouteten Zugang zu 5.2-Varianten; damit werden fortgeschrittene Automatisierung und hochwertige Outputs für kleinere Teams erreichbar, ohne eine API-Integration zu bauen. Für nicht-technische Nutzer mit Bedarf an besserer Dokumentenzusammenfassung oder Folienerstellung liefert GPT-5.2 spürbaren praktischen Mehrwert.

Praktische Hinweise für Entwickler und Betreiber

Wichtige API-Funktionen

reasoning.effort-Stufen (z. B.medium,high,xhigh) ermöglichen es, dem Modell vorzugeben, wie viel Compute es für internes Reasoning einsetzen soll; nutzen Sie das, um Latenz gegen Genauigkeit pro Anfrage abzuwägen.- Kontextkompaktierung: Die API beinhaltet Tools, um Historie zu komprimieren und zu verdichten, sodass wirklich relevante Inhalte für lange Ketten erhalten bleiben. Das ist entscheidend, wenn die effektive Token-Nutzung beherrschbar bleiben muss.

- Tool-Scaffolding & Allowed-Tools-Kontrollen: Produktionssysteme sollten explizit whitelisten, was das Modell aufrufen darf, und Toolaufrufe für Audits loggen.

Tipps zur Kostenkontrolle

- Cachen Sie häufig verwendete Dokument-Embeddings und nutzen Sie zwischengespeicherte Eingaben (die starke Rabatte erhalten) für wiederholte Anfragen gegen denselben Korpus. Die Plattformpreise von OpenAI beinhalten signifikante Rabatte für zwischengespeicherte Eingaben.

- Routen Sie explorative/niedrigwertige Anfragen zu Instant und reservieren Sie Thinking/Pro für Batch-Jobs oder finale Durchläufe.

- Schätzen Sie Token-Nutzung (Input + Output) sorgfältig, wenn Sie API-Kosten prognostizieren, da lange Outputs die Kosten vervielfachen.

Fazit — sollten Sie auf GPT-5.2 upgraden?

Wenn Ihre Arbeit von Langdokument-Reasoning, cross-dokumentaler Synthese, multimodaler Interpretation (Bilder + Text) oder dem Bau von Agenten mit Toolaufrufen abhängt, ist GPT-5.2 ein klares Upgrade: Es hebt die praktische Genauigkeit an und reduziert manuellen Integrationsaufwand. Wenn Sie hauptsächlich hochvolumige, latenzarme Chatbots betreiben oder streng budgetbeschränkte Anwendungen, kann Instant (oder frühere Modelle) weiterhin eine sinnvolle Wahl sein.

GPT-5.2 markiert eine bewusste Verschiebung von „besserer Chat“ zu „besserer professioneller Assistent“: mehr Compute, mehr Fähigkeiten und höhere Preistiers — aber auch echte Produktivitätsgewinne für Teams, die zuverlässigen Langkontext, verbessertes Mathematik/Reasoning, Bildverständnis und agentische Toolausführung nutzen können.

Um zu beginnen, erkunden Sie die Fähigkeiten der GPT-5.2-Modelle(GPT-5.2;GPT-5.2 pro, GPT-5.2 chat ) im Playground und konsultieren Sie den API guide für ausführliche Anleitungen. Bevor Sie zugreifen, stellen Sie bitte sicher, dass Sie sich bei CometAPI angemeldet und einen API-Schlüssel erhalten haben. CometAPI bietet einen Preis, der weit unter dem offiziellen liegt, um Ihnen die Integration zu erleichtern.

Bereit loszulegen?→ Free trial of gpt-5.2 models !