Kimi K2 stellt einen bedeutenden Fortschritt in der Entwicklung großer Open-Source-Sprachmodelle dar und kombiniert modernste Expertenarchitektur mit spezialisiertem Training für agentenbasierte Aufgaben. Im Folgenden untersuchen wir die Ursprünge, das Design, die Leistung und praktische Aspekte für Zugriff und Nutzung.

Was ist Kimi K2?

Kimi K2 ist ein Billionen-Parameter-Mixtur-of-Experts-Sprachmodell (MoE), das von Moonshot AI entwickelt wurde. Es verfügt über 32 Milliarden „aktivierte“ Parameter – die pro Token genutzten – und insgesamt eine Billion Expertenparameter. Dies ermöglicht enorme Kapazitäten ohne lineare Inferenzkosten. Kimi K1 basiert auf dem Muon-Optimierer und wurde mit über 2 Billionen Token trainiert. Dadurch wurde Stabilität in Größenordnungen erreicht, die zuvor als unpraktisch galten. Das Modell wird in zwei Hauptvarianten angeboten:

Kimi‑K2‑Anweisung: Vorab abgestimmt für Konversations- und Agentenanwendungen, bereit für den sofortigen Einsatz in Dialogsystemen und toolgestützten Workflows.

Kimi‑K2‑Basis: Ein Basismodell, das für die Forschung, individuelle Feinabstimmung und Experimente auf niedriger Ebene geeignet ist.

Wie funktioniert seine Architektur?

- Expertenmischung (MoE): Auf jeder Ebene wählt ein Gating-Mechanismus eine kleine Teilmenge von Experten (8 von 384) zur Verarbeitung jedes Tokens aus. Dadurch wird der Rechenaufwand für die Inferenz drastisch reduziert, während gleichzeitig eine riesige Wissensbasis erhalten bleibt.

- Spezialisierte Schichten: Enthält eine einzelne dichte Schicht neben insgesamt 61 Schichten, mit 64 Aufmerksamkeitsköpfen und versteckten Dimensionen, die auf MoE-Effizienz zugeschnitten sind.

- Kontext und Wortschatz: Unterstützt bis zu 128 Token in Kontextlänge und ein Vokabular von 160 Token und ermöglicht so das Verständnis und die Generierung von Langformen.

Warum ist Kimi K2 wichtig?

Kimi K2 erweitert die Grenzen der Open-Source-KI, indem es eine Leistung liefert, die mit führenden proprietären Modellen vergleichbar ist, insbesondere bei Codierungs- und Argumentationsbenchmarks.

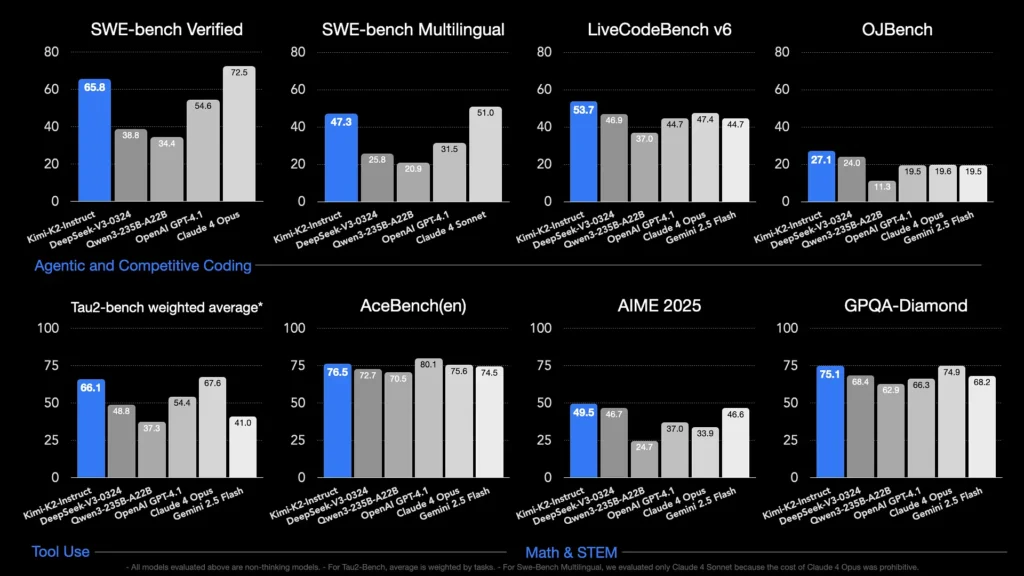

Welche Benchmarks zeigen seine Fähigkeiten?

- LiveCodeBench v6: Erreicht eine Pass@1-Rate von 53.7 %, führt damit Open-Source-Modelle an und konkurriert mit geschlossenen Systemen wie GPT-4.1 (44.7 %).

- SWE‑bench Verifiziert: Erreicht 65.8 %, übertrifft damit die 4.1 % von GPT-54.6 und liegt in öffentlich verfügbaren Vergleichstests nur hinter Claude Sonnet 4.

- MultiPL‑E und OJBench: Demonstriert robuste mehrsprachige Codierungsfähigkeiten (85.7 % bei MultiPL‑E) und zuverlässige Leistung bei realen Programmierherausforderungen.

- Mathe-500: Erreicht 97.4 % und übertrifft damit die 4.1 % von GPT-92.4, was seine Fähigkeiten im formalen mathematischen Denken unter Beweis stellt.

Wie ist es für Agentenaufgaben optimiert?

Über die Rohdatengenerierung hinaus wurde Kimi K2 mit synthetischen Tool-Nutzungsszenarien – Model Context Protocol (MCP)-Daten – trainiert, um externe Tools aufzurufen, mehrstufige Prozesse zu analysieren und Probleme selbstständig zu lösen. Dadurch eignet es sich besonders gut für Umgebungen wie Cline, wo es Codeausführung, API-Interaktion und Workflow-Automatisierung nahtlos orchestrieren kann.

Wie kann ich auf Kimi K2 zugreifen?

Die Zugriffsoptionen umfassen offizielle Plattformen, Open-Source-Distributionen und Integrationen von Drittanbietern und decken die Anforderungen von Forschung, Entwicklung und Unternehmen ab.

Offizielle Moonshot AI-Plattform

Moonshot AI bietet gehostete Inferenz über seine Plattform und ermöglicht latenzarmen API-Zugriff auf die Varianten Kimi-K2-Base und Kimi-K2-Instruct. Die Preise sind gestaffelt und richten sich nach dem Rechenleistungsverbrauch. Enterprise-Tarife beinhalten vorrangigen Support und On-Premise-Bereitstellungen. Nutzer können sich auf der Moonshot AI-Website registrieren und API-Schlüssel für die sofortige Integration abrufen.

CometAPI

CometAPI hat K2 bereits in sein Angebot integriert. Es bündelt K2-Inferenz mit verwalteter GPU-Infrastruktur, SLA-Garantien und skalierbaren Preisstufen. So können Unternehmen zwischen nutzungsbasierter API-Nutzung oder reservierter Kapazität mit Mengenrabatten wählen.

CometAPI ist eine einheitliche API-Plattform, die über 500 KI-Modelle führender Anbieter – wie die GPT-Reihe von OpenAI, Gemini von Google, Claude von Anthropics, Midjourney, Suno und weitere – in einer einzigen, entwicklerfreundlichen Oberfläche vereint. Durch konsistente Authentifizierung, Anforderungsformatierung und Antwortverarbeitung vereinfacht CometAPI die Integration von KI-Funktionen in Ihre Anwendungen erheblich.

Entwickler können zugreifen Kimi K2 API(kimi-k2-0711-preview)durch CometAPI. Erkunden Sie zunächst die Fähigkeiten des Modells in der Spielplatz und konsultieren Sie die API-LeitfadenFür detaillierte Anweisungen. Stellen Sie vor dem Zugriff sicher, dass Sie sich bei CometAPI angemeldet und den API-Schlüssel erhalten haben.

Integration von Drittanbieter-Tools

- Cline: Eine beliebte Code-zentrierte IDE, die Kimi K2 nativ unterstützt über die

cline:moonshotai/kimi-k2Anbieter, der Entwicklern per Mausklick Zugriff auf Chat, Codegenerierung und Agenten-Workflows in ihrem Editor bietet. - Umarmende Gesichtsbereiche: Von der Community gehostete Demos und minimalistische Benutzeroberflächen ermöglichen Benutzern die direkte Interaktion mit K2-Instruct-Modellen im Browser. Ein Hugging Face-Konto ist erforderlich. Die Leistung kann je nach gemeinsam genutzten Backend-Ressourcen variieren.

Wie verwende ich Kimi K2?

Sobald Sie eine Zugriffsmethode ausgewählt haben, können Sie K2 für eine Vielzahl von Aufgaben einsetzen – vom Chat über die Codeausführung bis hin zu autonomen Agenten.

Über API oder Plattform-SDK

- Authenticate: Rufen Sie Ihren API-Schlüssel von Moonshot AI oder CometAPI ab.

- Client initialisieren: Verwenden Sie das offizielle SDK (Python/JavaScript) oder Standard-HTTP-Anfragen.

- Modellvariante wählen:

- Kimi‑K2‑Basis zur Feinabstimmung und Recherche.

- Kimi‑K2‑Instruct für Plug-and-Play-Chat und Agenten.

- Das Modell von CometAPI:

kimi-k2-0711-preview

- Eingabeaufforderungen senden: Formatieren Sie Eingaben gemäß der Chat-Vorlage (System-, Benutzer-, Assistentenrollen), um ein optimiertes Verhalten beim Befolgen von Anweisungen zu erreichen. .

Lokale Ausführung mit llama.cpp

Verwenden Sie für Offline- oder selbstgehostete Setups die von Unsloth quantisierten GGUF-Gewichte (245 GB für 1.8-Bit dynamisches Quant).

- Gewichte herunterladen: Aus dem Moonshot AI GitHub- oder Hugging Face-Repository.

- Installieren Sie llama.cpp: Stellen Sie sicher, dass Sie über ausreichend Speicherplatz (≥ 250 GB) und RAM+VRAM (≥ 250 GB) für einen Durchsatz von ~5 Token/s verfügen.

- Modell starten:

./main --model kimi-k2-gguf.q8_0 --prompt "Your prompt here" - Einstellungen anpassen: Verwenden Sie empfohlene Parameter (

rope_freq_base,context_len) im Unsloth-Handbuch für stabile Leistung dokumentiert.

Integrationen mit Entwicklungstools

- IDE-Plugins: Mehrere Community-Plugins aktivieren K2 in VS Code, Neovim und JetBrains IDEs. Die Konfiguration umfasst in der Regel die Angabe des API-Endpunkts und der Modell-ID in den Einstellungen.

- Automatisierungs-Frameworks: Nutzen Sie den Agentenkern von K2 mit Frameworks wie LangChain oder Haystack, um Eingabeaufforderungen, API-Aufrufe und Codeausführungsschritte zu komplexen Automatisierungen zu verketten.

Was sind die typischen Anwendungsfälle für Kimi K2?

Die Kombination aus Skalierbarkeit, agentenbasiertem Training und offenem Zugang macht K2 domänenübergreifend vielseitig einsetzbar.

Codierungshilfe

Von der Boilerplate-Generierung und Refactoring bis hin zur Fehlerbehebung und Leistungsprofilierung führen die SOTA-Codierungsbenchmarks von K2 zu echten Produktivitätssteigerungen – und übertreffen Alternativen häufig in puncto Lesbarkeit und Einfachheit.

Wissen und Argumentation

Mit einer Kontextlänge von 128 K verarbeitet K2 lange Dokumente, Fragen und Antworten zu mehreren Dokumenten sowie logisches Denken. Die MoE-Architektur gewährleistet die Speicherung vielfältigen Wissens ohne katastrophales Vergessen.

Agenten-Workflows

K2 zeichnet sich durch die Orchestrierung mehrstufiger Aufgaben aus – Abrufen von Daten, Aufrufen von APIs, Aktualisieren von Codebasen und Zusammenfassen von Ergebnissen – und eignet sich daher ideal für autonome Assistenten im Kundensupport, in der Datenanalyse und bei DevOps.

Wie schneidet Kimi K2 im Vergleich zu anderen Open-Source-Modellen ab?

Während die jüngsten Open-Releases von DeepSeek V3 und Meta Anfang 2025 die Schlagzeilen beherrschten, unterscheidet sich Kimi K2 durch:

Agentenintelligenz

Kimi K2 wurde speziell für „agentenbasierte“ Workflows entwickelt und automatisiert Aufgaben über Tool-Aufrufe, Shell-Befehle, Web-Automatisierung und API-Integrationen. Der selbstspielende, erweiterte Trainingsdatensatz enthält verschiedene Tool-Aufrufbeispiele und ermöglicht so die nahtlose Integration in reale Systeme.

Kosteneffizienz

Mit etwa 80–90 % niedrigeren Inferenzkosten pro Token im Vergleich zu Modellen wie Claude Sonnet 4 bietet Kimi K2 Leistung auf Unternehmensniveau ohne Blockbuster-Preise und fördert so eine schnelle Akzeptanz bei preissensiblen Entwicklern.

Lizenzen und Zugänglichkeit

Im Gegensatz zu bestimmten Open-Source-Versionen, die mit restriktiven Lizenzen belastet sind, ist Kimi K2 unter einer freizügigen Lizenz erhältlich, die kommerzielle Nutzung, abgeleitete Werke und lokale Bereitstellungen erlaubt und damit dem Open-Source-Ethos von Moonshot AI entspricht.

- Durch die Kombination aus innovativem MoE-Design, rigorosem Agententraining und Open-Source-Verfügbarkeit ermöglicht Kimi K2 Entwicklern und Forschern die Entwicklung intelligenter, autonomer Anwendungen ohne unerschwingliche Kosten oder geschlossene Ökosysteme. Ob Sie Code schreiben, komplexe mehrstufige Workflows erstellen oder mit groß angelegtem Reasoning experimentieren – K2 bietet eine vielseitige und leistungsstarke Grundlage.