Kimi K2 Thinking ist Moonshot AIs neue „Denk“-Variante der Kimi K2-Familie: ein Billionen-Parameter-Modell mit spärlicher Mixture-of-Experts-Verteilung (MoE), das explizit für die Entwicklung von Modellen mit hoher kognitiver Leistungsfähigkeit konzipiert wurde. Denken Sie beim Handeln nach. Das heißt, tiefgreifende Gedankengänge werden mit zuverlässigen Werkzeugaufrufen, langfristiger Planung und automatisierten Selbstprüfungen verknüpft. Es kombiniert ein großes, dünnbesetztes Backbone (≈1T Gesamtparameter, ~32B aktivierte Parameter pro Token), eine native INT4-Quantisierungspipeline und ein skalierbares Design. Inferenzzeit Argumentation (mehr „Denk-Tokens“ und mehr Tool-Aufrufe) anstatt lediglich die Anzahl statischer Parameter zu erhöhen.

Einfach ausgedrückt: K2 Thinking behandelt das Modell als Problemlösungsansatz. Agent Anstelle eines einmaligen Sprachgenerators. Dieser Wandel – vom „Sprachmodell“ zum „Denkmodell“ – macht diese Version bemerkenswert und ist der Grund, warum viele Anwender sie als Meilenstein im Bereich der Open-Source-Agenten-KI betrachten.

Was genau ist „Kimi K2 Thinking“?

Architektur und wichtige Spezifikationen

K2 Thinking ist als spärliches MoE-Modell (384 Experten, 8 Experten pro Token) mit etwa 1 Billion Parameter insgesamt kombiniert mit einem nachhaltigen Materialprofil. ~32B aktivierte Parameter pro Inferenz. Es verwendet hybride Architekturmerkmale (MLA-Aufmerksamkeit, SwiGLU-Aktivierungen) und wurde mit Moonshots Muon/MuonClip-Optimierer auf großen Token-Budgets trainiert, wie im technischen Bericht beschrieben. Die Denkvariante erweitert das Basismodell um eine Quantisierung nach dem Training (native INT4-Unterstützung), ein Kontextfenster von 256k und Verbesserungen, um die interne Logik des Modells während der realen Anwendung offenzulegen und zu stabilisieren.

Was „Denken“ in der Praxis bedeutet

„Denken“ ist hier ein technisches Ziel: Das Modell soll (1) lange, strukturierte interne Schlussfolgerungsketten (Gedankenketten-Tokens) generieren, (2) externe Tools (Suche, Python-Sandboxes, Browser, Datenbanken) im Rahmen dieser Schlussfolgerungen aufrufen, (3) Zwischenergebnisse bewerten und selbstverifizieren und (4) viele solcher Zyklen durchlaufen können, ohne dass die Kohärenz verloren geht. Die Dokumentation und die Modellkarte von Moonshot zeigen, dass K2 Thinking explizit darauf trainiert und optimiert wurde, Schlussfolgerungen und Funktionsaufrufe zu verschachteln und ein stabiles, agentenbasiertes Verhalten über Hunderte von Schritten hinweg beizubehalten.

Was ist das Kernziel?

Die Grenzen traditioneller groß angelegter Modelle sind:

- Der Generierungsprozess ist kurzsichtig und entbehrt einer übergreifenden Logik;

- Die Nutzung der Tools ist begrenzt (in der Regel können nur externe Tools ein- oder zweimal aufgerufen werden);

- Bei komplexen Problemen können sie sich nicht selbst korrigieren.

Das zentrale Designziel von K2 Thinking ist die Lösung dieser drei Probleme. In der Praxis kann K2 Thinking ohne menschliches Eingreifen: 200–300 aufeinanderfolgende Werkzeugaufrufe ausführen; Hunderte von Schritten logisch kohärenten Denkens aufrechterhalten; komplexe Probleme durch kontextbezogene Selbstprüfung lösen.

Neupositionierung: Sprachmodell → Denkmodell

Das K2 Thinking-Projekt veranschaulicht einen umfassenderen strategischen Wandel in diesem Bereich: die Weiterentwicklung von der bedingten Textgenerierung hin zu agentische ProblemlöserDas Hauptziel besteht nicht primär darin, die Perplexität oder die Vorhersage des nächsten Tokens zu verbessern, sondern Modelle zu entwickeln, die Folgendes können:

- Planen ihre eigenen mehrstufigen Strategien;

- Koordinaten externe Werkzeuge und Effektoren (Suche, Codeausführung, Wissensdatenbanken);

- Verify Zwischenergebnisse und Fehlerkorrektur;

- Erhalten Kohärenz über lange Kontexte und lange Werkzeugketten hinweg.

Diese Neuausrichtung verändert sowohl die Evaluierung (Benchmarks betonen Prozesse und Ergebnisse, nicht nur die Textqualität) als auch die Entwicklung (Strukturen für Werkzeugrouting, Schrittzählung, Selbstkritik usw.).

Arbeitsmethoden: Wie Denkmodelle funktionieren

K2 Thinking demonstriert in der Praxis mehrere Arbeitsmethoden, die typisch für den Ansatz des „Denkmodells“ sind:

- Persistente interne Spuren: Das Modell erzeugt strukturierte Zwischenschritte (Schlussfolgerungsspuren), die im Kontext gehalten werden und später wiederverwendet oder überprüft werden können.

- Dynamische Werkzeugsteuerung: Basierend auf jedem internen Schritt entscheidet K2, welches Tool (Suche, Code-Interpreter, Webbrowser) wann aufgerufen wird.

- Skalierung zur Testzeit: Während der Schlussfolgerung kann das System seine „Denktiefe“ (mehr interne Schlussfolgerungsbausteine) erweitern und die Anzahl der Werkzeugaufrufe erhöhen, um Lösungen besser zu erkunden.

- Selbstverifizierung und Wiederherstellung: Das Modell prüft explizit die Ergebnisse, führt Plausibilitätstests durch und plant neu, wenn die Prüfungen fehlschlagen.

Diese Methoden kombinieren Modellarchitektur (MoE + langer Kontext) mit Systementwicklung (Werkzeugorchestrierung, Sicherheitsprüfungen).

Welche technologischen Innovationen ermöglichen Kimi K2 Thinking?

Der Denkmechanismus von Kimi K2 Thinking unterstützt verschachteltes Denken und die Nutzung von Werkzeugen. Die Denkschleife von K2 Thinking:

- Das Problem verstehen (analysieren & abstrahieren)

- Erstellung eines mehrstufigen Schlussfolgerungsplans (Plankette)

- Nutzung externer Tools (Code, Browser, Mathematik-Engine)

- Ergebnisse überprüfen und überarbeiten (verify & revise)

- Schlussfolgern (schlussfolgern)

Im Folgenden stelle ich drei Schlüsseltechniken vor, die die Schlussfolgerungsschleifen in xx ermöglichen.

1) Skalierung zur Testzeit

Was es ist: Herkömmliche Skalierungsgesetze konzentrieren sich auf die Erhöhung der Parameter- oder Datenanzahl während des Trainings. Die Innovation von K2 Thinking liegt in der dynamischen Erweiterung der Token-Anzahl (d. h. der Denktiefe) während der „Argumentationphase“ und der gleichzeitigen Erweiterung der Anzahl der Werkzeugaufrufe (d. h. des Handlungsspielraums). Diese Methode wird als Testzeit-Skalierung bezeichnet und basiert auf der Annahme: „Eine längere Argumentationskette + interaktivere Werkzeuge = ein qualitativer Sprung in der tatsächlichen Intelligenz.“

Warum es darauf ankommt: K2 Thinking optimiert dies explizit: Moonshot zeigt, dass die Erweiterung der „Denk-Token“ und der Anzahl/Tiefe der Werkzeugaufrufe messbare Verbesserungen in agentenbasierten Benchmarks ergibt, wodurch das Modell andere Modelle ähnlicher oder größerer Größe in FLOPs-angepassten Szenarien übertrifft.

2) Werkzeuggestütztes Schließen

Was es ist: K2 Thinking wurde entwickelt, um Werkzeugschemata nativ zu analysieren, selbstständig zu entscheiden, wann ein Werkzeug aufgerufen werden soll, und die Ergebnisse des Werkzeugs in den laufenden Denkprozess zu integrieren. Moonshot trainierte und optimierte das Modell, um Gedankengänge mit Funktionsaufrufen zu verschachteln und dieses Verhalten über Hunderte von sequenziellen Werkzeugschritten hinweg zu stabilisieren.

Warum es darauf ankommt: Diese Kombination aus zuverlässigem Parsing, stabilem internem Zustand und API-Tools ermöglicht es dem Modell, im Rahmen einer einzigen Sitzung Web-Browsing durchzuführen, Code auszuführen und mehrstufige Arbeitsabläufe zu orchestrieren.

Innerhalb seiner internen Architektur bildet das Modell einen Ablauf eines „visualisierten Denkprozesses“: Eingabeaufforderung → Schlussfolgerungselemente → Werkzeugaufruf → Beobachtung → nächster Schlussfolgerungsschritt → endgültige Antwort

3) Langfristige Kohärenz und Selbstverifizierung

Was es ist: Langfristige Kohärenz bezeichnet die Fähigkeit eines Modells, über viele Schritte und sehr lange Kontexte hinweg einen kohärenten Plan und internen Zustand beizubehalten. Selbstverifikation bedeutet, dass das Modell proaktiv seine Zwischenergebnisse prüft und Schritte wiederholt oder korrigiert, wenn eine Verifikation fehlschlägt. Lange Aufgaben führen häufig dazu, dass Modelle abdriften oder irreführende Aussagen treffen. K2 Thinking begegnet diesem Problem mit verschiedenen Techniken: sehr langen Kontextfenstern (256k), Trainingsstrategien, die den Zustand über lange CoT-Sequenzen hinweg erhalten, und expliziten Modellen zur Beurteilung der Satzgenauigkeit, um nicht begründete Behauptungen zu erkennen.

Warum es darauf ankommt: Der Mechanismus des „Recurrent Reasoning Memory“ erhält den Denkzustand aufrecht und verleiht ihm menschenähnliche Eigenschaften wie „Denkstabilität“ und „kontextuelle Selbstüberwachung“. Bei Aufgaben, die sich über viele Schritte erstrecken (z. B. Forschungsprojekte, Kodierungsaufgaben mit mehreren Dateien, lange redaktionelle Prozesse), ist die Aufrechterhaltung eines einheitlichen Gedankengangs unerlässlich. Die Selbstverifizierung reduziert unbemerkte Fehler; anstatt eine plausible, aber falsche Antwort zu liefern, kann das Modell Inkonsistenzen erkennen und erneut Hilfsmittel konsultieren oder die Planung anpassen.

Fähigkeiten:

- Kontextuelle Konsistenz: Gewährleistet semantische Kontinuität über mehr als 10 Token hinweg;

- Fehlererkennung und -korrektur: Erkennt und korrigiert logische Abweichungen in frühen Denkprozessen;

- Selbstverifizierungsschleife: Überprüft automatisch die Plausibilität der Antwort, nachdem die Schlussfolgerung abgeschlossen ist;

- Zusammenführung mehrerer logischer Pfade: Wählt den optimalen Pfad aus mehreren logischen Ketten aus.

Was sind die vier Kernkompetenzen des K2-Denkens?

Tiefgründiges und strukturiertes Denken

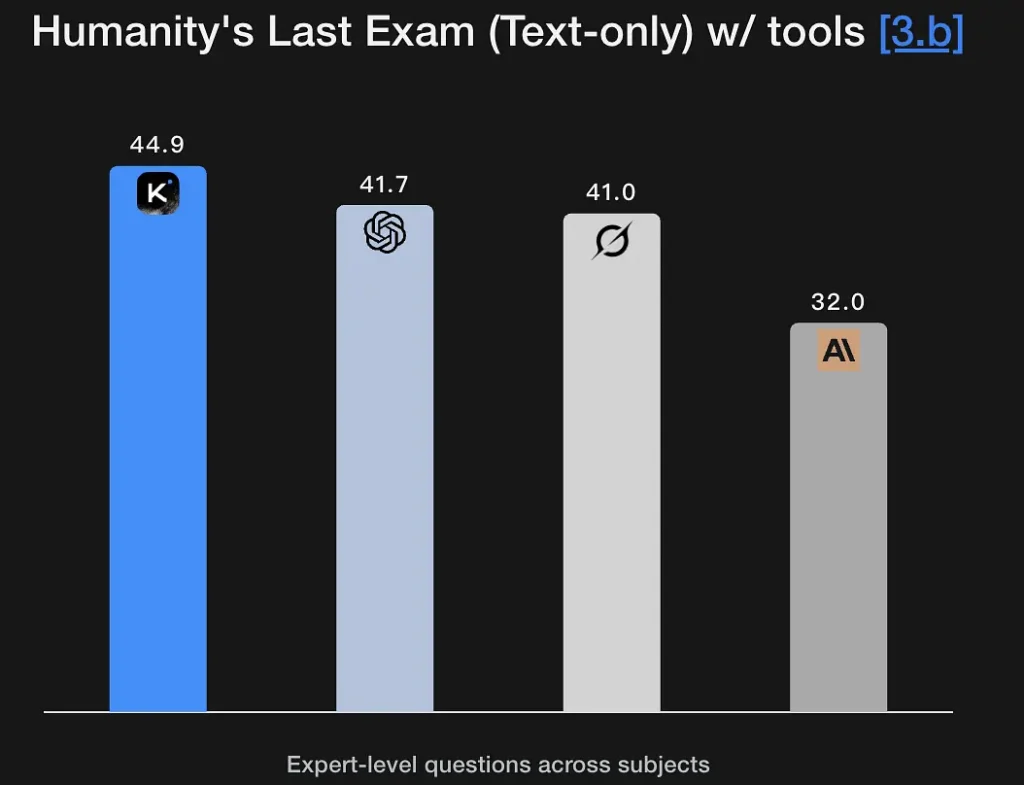

K2 Thinking ist darauf ausgelegt, explizite, mehrstufige Schlussfolgerungsprozesse zu generieren und daraus fundierte Schlüsse zu ziehen. Das Modell erzielt hervorragende Ergebnisse in Mathematik- und rigorosen Argumentationstests (GSM8K, AIME, IMO-ähnliche Benchmarks) und beweist die Fähigkeit, Argumentationsmuster über lange Sequenzen hinweg aufrechtzuerhalten – eine Grundvoraussetzung für die Problemlösung auf Forschungsniveau. Seine exzellente Leistung bei „Humanity’s Last Exam“ (44.9 %) demonstriert analytische Fähigkeiten auf Expertenniveau. Es kann logische Rahmen aus unscharfen semantischen Beschreibungen extrahieren und Argumentationsgraphen generieren.

Hauptmerkmale

- Unterstützt symbolisches Denken: Versteht und wendet mathematische, logische und programmiertechnische Strukturen an.

- Besitzt die Fähigkeit zum Hypothesentest: Kann spontan Hypothesen vorschlagen und überprüfen.

- Kann mehrstufige Problemzerlegung durchführen: Zerlegt komplexe Ziele in mehrere Teilaufgaben.

Agentensuche

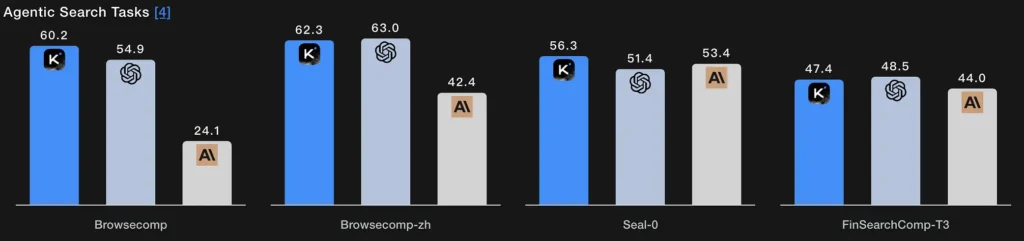

Anstelle eines einzelnen Suchvorgangs ermöglicht die agentenbasierte Suche dem Modell, eine Suchstrategie zu planen (wonach gesucht werden soll), diese durch wiederholte Web-/Tool-Aufrufe auszuführen, die eingehenden Ergebnisse zu synthetisieren und die Suchanfrage zu verfeinern. Die Ergebnisse der K2 Thinking BrowseComp- und Seal-0-Tools belegen die hohe Leistungsfähigkeit dieser Funktion; das Modell ist explizit darauf ausgelegt, mehrstufige Websuchen mit zustandsbehafteter Planung zu unterstützen.

Technisches Wesentliche:

- Das Suchmodul und das Sprachmodell bilden einen geschlossenen Kreislauf: Abfragegenerierung → Webseitenabruf → semantische Filterung → Schlussfolgerungsfusion.

- Das Modell kann seine Suchstrategie adaptiv anpassen, beispielsweise indem es zuerst nach Definitionen, dann nach Daten und schließlich nach Hypothesen sucht.

- Im Wesentlichen handelt es sich um eine zusammengesetzte Intelligenz aus „Informationsbeschaffung + Verständnis + Argumentation“.

Agentencodierung

Dies ist die Fähigkeit, schreiben, ausführen, testen und iterieren K2 Thinking analysiert Code im Rahmen eines logischen Prozesses. Es erzielt wettbewerbsfähige Ergebnisse bei Live-Coding- und Code-Verifizierungs-Benchmarks, unterstützt Python-Toolchains in seinen Tool-Aufrufen und kann mehrstufige Debugging-Schleifen ausführen, indem es eine Sandbox aufruft, Fehler ausliest und den Code in wiederholten Durchläufen repariert. Die Ergebnisse von EvalPlus/LiveCodeBench spiegeln diese Stärken wider. Mit 71.3 % im SWE-Bench Verified-Test kann es über 70 % der realen Software-Reparaturaufgaben korrekt ausführen.

Es zeigt auch eine stabile Leistung in der LiveCodeBench V6-Wettbewerbsumgebung und stellt damit seine Fähigkeiten zur Algorithmusimplementierung und -optimierung unter Beweis.

Technisches Wesentliche:

- Es verwendet einen Prozess aus „semantischem Parsen + AST-Refactoring + automatischer Verifizierung“.

- Die Codeausführung und das Testen erfolgen durch Toolaufrufe auf der Ausführungsschicht;

- Es realisiert einen geschlossenen, automatisierten Entwicklungsprozess vom Verständnis des Codes → Diagnose von Fehlern → Generierung von Patches → Überprüfung des Erfolgs.

Agentenschreiben

Über kreatives Schreiben hinaus umfasst handlungsorientiertes Schreiben die strukturierte, zielgerichtete Erstellung von Dokumenten, die externe Recherchen, Zitate, Tabellenerstellung und iterative Überarbeitung erfordern kann (z. B. Entwurf erstellen → Faktenprüfung → Überarbeitung). Dank des langfristigen Kontextes und der Werkzeugarchitektur eignet sich K2 Thinking hervorragend für mehrstufige Schreibprozesse (Rechercheberichte, Zusammenfassungen von Vorschriften, mehrteilige Texte). Die hohen Erfolgsquoten des Modells in Arena-ähnlichen Tests und die Kennzahlen für längere Texte bestätigen diese Aussage.

Technisches Wesentliche:

- Erzeugt automatisch Textsegmente mithilfe von agentischer Gedankenplanung;

- Steuert intern die Textlogik durch Reasoning Tokens;

- Kann gleichzeitig Werkzeuge wie Suche, Berechnung und Diagrammerstellung aufrufen, um „multimodales Schreiben“ zu erreichen.

Wie können Sie K2 Thinking heute anwenden?

Zugriffsarten

K2 Thinking ist als Open-Source-Version (Modellgewichte und Prüfpunkte) sowie über Plattform-Endpunkte und Community-Hubs (Hugging Face, Moonshot-Plattform) verfügbar. Sie können es selbst hosten, wenn Sie über ausreichend Rechenleistung verfügen, oder nutzen Sie CometAPIDie API/gehostete Benutzeroberfläche von 's ermöglicht ein schnelleres Onboarding. Außerdem dokumentiert sie eine reasoning_content Feld, das, wenn aktiviert, die internen Gedankentoken dem Aufrufer anzeigt.

Praktische Tipps zur Anwendung

- Beginnen Sie mit agentischen BausteinenZunächst sollten nur wenige deterministische Werkzeuge (Suche, Python-Sandbox und eine zuverlässige Faktendatenbank) bereitgestellt werden. Klare Werkzeugschemata sind erforderlich, damit das Modell Aufrufe analysieren und validieren kann.

- Testzeitberechnung optimierenBei komplexen Problemstellungen sollten längere Denkphasen und mehr Tool-Runden eingeplant werden; die Qualitätsverbesserung sollte im Verhältnis zu Latenz und Kosten gemessen werden. Moonshot setzt auf die Skalierung der Testzeit als zentralen Hebel.

- **Nutzen Sie INT4-Modi für mehr Kosteneffizienz.**K2 Thinking unterstützt INT4-Quantisierung, was zu spürbaren Geschwindigkeitssteigerungen führt; überprüfen Sie jedoch das Verhalten in Grenzfällen anhand Ihrer Aufgaben.

- Oberflächenargumentation sorgfältigDas Aufdecken interner Verarbeitungsketten kann zwar beim Debuggen helfen, erhöht aber auch die Wahrscheinlichkeit für Fehler im Rohmodell. Behandeln Sie interne Schlussfolgerungen als Diagnose nicht maßgebend; daher mit automatisierter Verifizierung kombinieren.

Fazit

Kimi K2 Thinking ist eine bewusst entwickelte Antwort auf die nächste Ära der KI: nicht nur größere Modelle, sondern Agenten, die denken, handeln und überprüfenEs vereint MoE-Skalierung, Testzeit-Berechnungsstrategien, native Inferenz mit geringer Präzision und explizite Werkzeugorchestrierung, um nachhaltige, mehrstufige Problemlösungen zu ermöglichen. Für Teams, die mehrstufige Problemlösungen benötigen und über die nötige technische Disziplin verfügen, um agentenbasierte Systeme zu integrieren, in einer Sandbox zu testen und zu überwachen, ist K2 Thinking ein bedeutender, praktischer Fortschritt – und ein wichtiger Stresstest dafür, wie Industrie und Gesellschaft zunehmend leistungsfähige, handlungsorientierte KI steuern werden.

Entwickler können zugreifen Kimi K2 Thinking API über CometAPI, die neuste Modellversion wird immer mit der offiziellen Website aktualisiert. Erkunden Sie zunächst die Fähigkeiten des Modells in der Spielplatz und konsultieren Sie die API-Leitfaden Für detaillierte Anweisungen. Stellen Sie vor dem Zugriff sicher, dass Sie sich bei CometAPI angemeldet und den API-Schlüssel erhalten haben. CometAPI bieten einen Preis weit unter dem offiziellen Preis an, um Ihnen bei der Integration zu helfen.

Bereit loszulegen? → Melden Sie sich noch heute für CometAPI an !

Wenn Sie weitere Tipps, Anleitungen und Neuigkeiten zu KI erfahren möchten, folgen Sie uns auf VK, X kombiniert mit einem nachhaltigen Materialprofil. Discord!