Was ist Lama 4?

Meta Platforms hat seine neueste Suite großer Sprachmodelle (LLMs) der Llama 4-Reihe vorgestellt und damit einen bedeutenden Fortschritt in der künstlichen Intelligenztechnologie markiert. Die Llama 4-Kollektion führt im April 2025 zwei Hauptmodelle ein: Llama 4 Scout und Llama 4 Maverick. Diese Modelle sind für die Verarbeitung und Übersetzung verschiedener Datenformate, darunter Text, Video, Bilder und Audio, konzipiert und demonstrieren ihre multimodalen Fähigkeiten. Darüber hinaus hat Meta eine Vorschau auf Llama 4 Behemoth gegeben, ein kommendes Modell, das als eines der leistungsstärksten LLMs aller Zeiten gilt und das Training zukünftiger Modelle unterstützen soll.

Wie unterscheidet sich Llama 4 von Vorgängermodellen?

Erweiterte multimodale Fähigkeiten

Im Gegensatz zu seinen Vorgängern ist Llama 4 für die nahtlose Verarbeitung mehrerer Datenmodalitäten konzipiert. Das bedeutet, dass es Text, Bilder, Videos und Audioeingaben analysieren und Antworten generieren kann, was es für vielfältige Anwendungen äußerst anpassungsfähig macht.

Einführung spezialisierter Modelle

Meta hat innerhalb der Llama 4-Reihe zwei spezialisierte Versionen eingeführt:

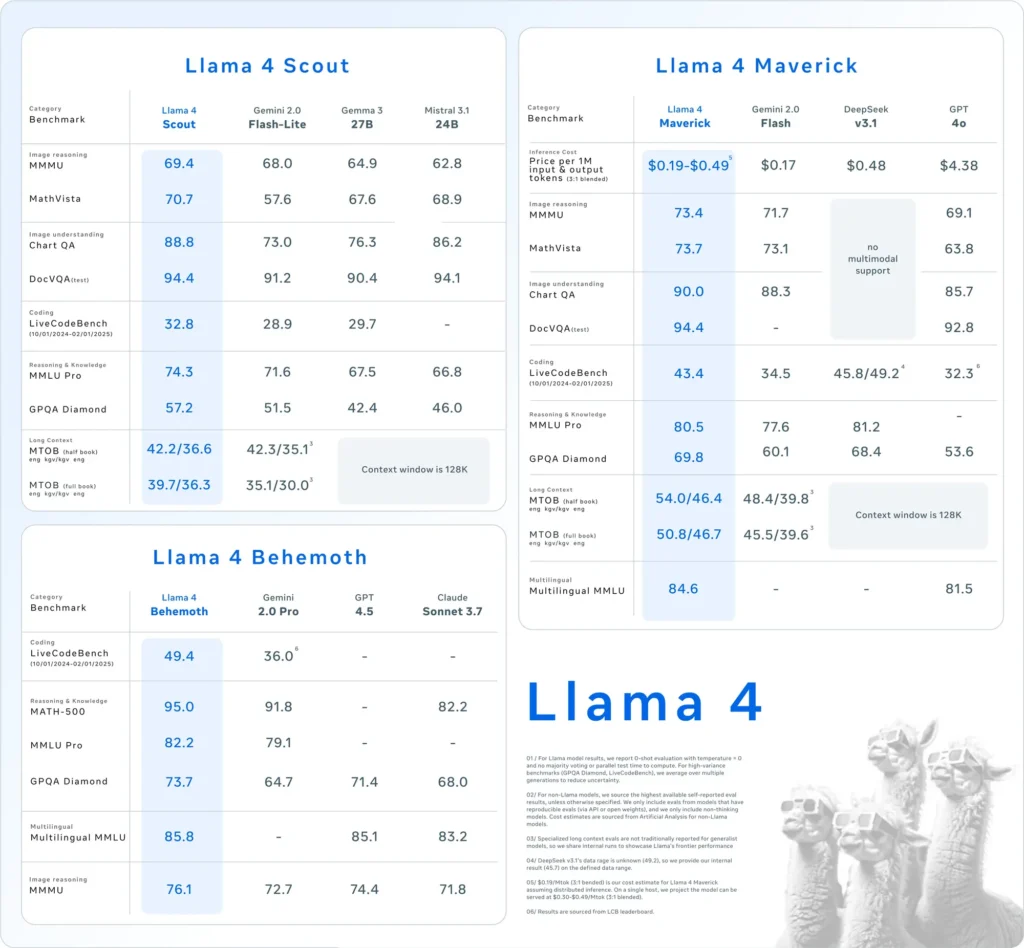

- Lama 4 Scout: Ein kompaktes Modell, das für den effizienten Betrieb auf einer einzelnen Nvidia H100-GPU optimiert ist. Es verfügt über ein Kontextfenster mit 10 Millionen Token und hat in verschiedenen Benchmarks eine überlegene Leistung gegenüber Konkurrenten wie Googles Gemma 3 und Mistral 3.1 gezeigt.

- Lama 4 Maverick: Ein größeres Modell, dessen Leistung mit GPT-4o und DeepSeek-V3 von OpenAI vergleichbar ist und das sich insbesondere bei Codierungs- und Argumentationsaufgaben auszeichnet, während es weniger aktive Parameter nutzt.

Darüber hinaus entwickelt Meta Lama 4 Behemoth, ein Modell mit 288 Milliarden aktiven Parametern und insgesamt 2 Billionen, mit dem Ziel, Modelle wie GPT-4.5 und Claude Sonnet 3.7 bei MINT-Benchmarks zu übertreffen.

Einführung der Mixture of Experts (MoE)-Architektur

Llama 4 verwendet eine „Mixture of Experts“-Architektur (MoE). Diese unterteilt das Modell in spezialisierte Einheiten, um die Ressourcennutzung zu optimieren und die Leistung zu verbessern. Dieser Ansatz ermöglicht eine effizientere Verarbeitung, indem nur relevante Teilmengen des Modells für bestimmte Aufgaben aktiviert werden.

Wie schneidet Llama 4 im Vergleich zu anderen KI-Modellen ab?

Llama 4 positioniert sich wettbewerbsfähig unter den führenden KI-Modellen:

- Leistungsbenchmarks: Die Leistung von Llama 4 Maverick ist bei Codierungs- und Schlussfolgerungsaufgaben mit der von GPT-4o und DeepSeek-V3 von OpenAI vergleichbar, während Llama 4 Scout in verschiedenen Benchmarks Modelle wie Gemma 3 und Mistral 3.1 von Google übertrifft.

- Open-Source-AnsatzMeta bietet Llama-Modelle weiterhin als Open Source an und fördert so eine breitere Zusammenarbeit und plattformübergreifende Integration. Die Llama-4-Lizenz schränkt jedoch kommerzielle Unternehmen mit über 700 Millionen Nutzern ein, was Diskussionen über die tatsächliche Offenheit des Modells auslöst.

| Kategorie | Benchmark | Lama 4 Maverick | GPT-4o | Gemini 2.0 Flash | DeepSeek v3.1 |

|---|---|---|---|---|---|

| Bildbegründung | MMMU | 73.4 | 69.1 | 71.7 | Keine multimodale Unterstützung |

| MathVista | 73.7 | 63.8 | 73.1 | Keine multimodale Unterstützung | |

| Bildverständnis | ChartQA | 90.0 | 85.7 | 88.3 | Keine multimodale Unterstützung |

| DocVQA (Test) | 94.4 | 92.8 | - | Keine multimodale Unterstützung | |

| Programmierung | LiveCodeBench | 43.4 | 32.3 | 34.5 | 45.8/49.2 |

| Argumentation und Wissen | MMLU Pro | 80.5 | - | 77.6 | 81.2 |

| GPQA Diamant | 69.8 | 53.6 | 60.1 | 68.4 | |

| Mehrsprachigkeit | Mehrsprachige MMLU | 84.6 | 81.5 | - | - |

| Langer Kontext | MTOB (Halbbuch) eng→kgv/kgv→eng | 54.0/46.4 | Kontext auf 128 KB begrenzt | 48.4/39.8 | Kontext auf 128 KB begrenzt |

| MTOB (vollständiges Buch) eng→kgv/kgv→eng | 50.8/46.7 | Kontext auf 128 KB begrenzt | 45.5/39.6 | Kontext auf 128 KB begrenzt |

Wie schneidet Llama 4 in Benchmarktests ab?

Benchmark-Auswertungen geben Aufschluss über die Leistungsfähigkeit der Llama 4-Modelle:

- Lama 4 Scout: Dieses Modell übertrifft in verschiedenen Benchmarks mehrere Konkurrenten, darunter Gemma 3 und Mistral 3.1 von Google. Die Fähigkeit, mit einem Kontextfenster von 10 Millionen Token auf einer einzigen GPU zu arbeiten, unterstreicht seine Effizienz und Effektivität bei der Bewältigung komplexer Aufgaben.

- Lama 4 Maverick: Vergleichbar mit OpenAIs GPT-4o und DeepSeek-V3 zeichnet sich Llama 4 Maverick durch hervorragende Leistung bei Codierungs- und Reasoning-Aufgaben aus und nutzt dabei weniger aktive Parameter. Diese Effizienz geht nicht auf Kosten der Leistungsfähigkeit und macht es zu einem starken Konkurrenten in der LLM-Landschaft.

- Lama 4 Behemoth: Mit 288 Milliarden aktiven Parametern und insgesamt 2 Billionen übertrifft Llama 4 Behemoth Modelle wie GPT-4.5 und Claude Sonnet 3.7 in MINT-Benchmarks. Seine umfangreiche Parameteranzahl und Leistung weisen auf sein Potenzial als Basismodell für zukünftige KI-Entwicklungen hin.

Diese Benchmark-Ergebnisse unterstreichen Metas Engagement für die Weiterentwicklung der KI-Fähigkeiten und die Positionierung der Llama 4-Serie als beeindruckender Akteur auf diesem Gebiet.

Wie können Benutzer auf Llama 4 zugreifen?

Meta hat die Llama 4-Modelle in seinen KI-Assistenten integriert und macht sie so über Plattformen wie WhatsApp, Messenger, Instagram und das Internet zugänglich. Diese Integration ermöglicht es Nutzern, die erweiterten Funktionen von Llama 4 in vertrauten Anwendungen zu erleben.

Entwicklern und Forschern, die Llama 4 für individuelle Anwendungen nutzen möchten, bietet Meta über Plattformen wie Hugging Face und eigene Vertriebskanäle Zugriff auf die Modellgewichte. Dieser Open-Source-Ansatz ermöglicht es der KI-Community, Innovationen zu entwickeln und die Fähigkeiten von Llama 4 weiterzuentwickeln.

Wichtig zu beachten: Obwohl Llama 4 als Open Source vermarktet wird, stellt die Lizenz Einschränkungen für kommerzielle Unternehmen mit über 700 Millionen Nutzern dar. Unternehmen sollten die Lizenzbedingungen überprüfen, um die Einhaltung der Meta-Richtlinien sicherzustellen.

Schnelles Erstellen mit Llama 4 auf CometAPI

CometAPI bietet Zugriff auf über 500 KI-Modelle, darunter Open-Source- und spezialisierte multimodale Modelle für Chat, Bilder, Code und mehr. Die größte Stärke liegt in der Vereinfachung des traditionell komplexen Prozesses der KI-Integration. Durch die Zentralisierung der API-Aggregation auf einer Plattform sparen Nutzer wertvolle Zeit und Ressourcen, die sonst für die Verwaltung separater Plattformen und Anbieter aufgewendet werden müssten. Damit ist der Zugriff auf führende KI-Tools wie Claude, OpenAI, Deepseek und Gemini über ein einziges, einheitliches Abonnement möglich. Mit der API in CometAPI können Sie Musik und Grafiken erstellen, Videos generieren und eigene Workflows entwickeln.

CometAPI bieten einen Preis weit unter dem offiziellen Preis an, um Ihnen bei der Integration zu helfen Lama 4 API, und Sie erhalten 1 $ auf Ihr Konto, nachdem Sie sich registriert und angemeldet haben! Willkommen bei der Registrierung und erleben Sie CometAPI. CometAPI zahlt nach Verbrauch,Lama 4 API Die Preisgestaltung bei CometAPI ist wie folgt strukturiert:

| Kategorie | Lama-4-Maverick | Lama-4-Scout |

| API-Preise | Eingabe-Token: 0.48 $ / M Token | Eingabe-Token: 0.216 $ / M Token |

| Ausgabe-Token: 1.44 $/M Token | Ausgabe-Token: 1.152 $/M Token |

- Bitte beachten Sie Lama 4 API für Integrationsdetails.

- Informationen zum Modellstart in der Comet-API finden Sie unter https://api.cometapi.com/new-model.

- Informationen zu Modellpreisen in der Comet-API finden Sie unter https://api.cometapi.com/pricing

Beginnen Sie mit dem Aufbau auf CometAPI noch heute – melden Sie sich an Hier erhalten Sie kostenlosen Zugriff oder können ohne Ratenbegrenzung skalieren, indem Sie auf ein Bezahlter Plan für CometAPI.

Welche Auswirkungen hat die Veröffentlichung von Llama 4?

Integration über Metaplattformen hinweg

Llama 4 ist in den KI-Assistenten von Meta auf Plattformen wie WhatsApp, Messenger, Instagram und im Internet integriert und verbessert das Benutzererlebnis mit erweiterten KI-Funktionen.

Auswirkungen auf die KI-Branche

Die Veröffentlichung von Llama 4 unterstreicht Metas aggressiven Vorstoß in den KI-Bereich. Das Unternehmen plant, bis zu 65 Milliarden US-Dollar in den Ausbau seiner KI-Infrastruktur zu investieren. Dieser Schritt spiegelt den wachsenden Wettbewerb zwischen den Technologiegiganten um die Führungsposition bei KI-Innovationen wider.

Überlegungen zum Energieverbrauch

Die für Llama 4 erforderlichen erheblichen Rechenressourcen geben Anlass zu Bedenken hinsichtlich Energieverbrauch und Nachhaltigkeit. Der Betrieb eines Clusters mit über 100,000 GPUs verbraucht viel Energie und führt zu Diskussionen über die Umweltauswirkungen groß angelegter KI-Modelle.

Was hält die Zukunft für Llama 4 bereit?

Meta plant, weitere Entwicklungen und Anwendungen von Llama 4 auf der kommenden LlamaCon-Konferenz am 29. April 2025 zu diskutieren. Die KI-Community erwartet Einblicke in Metas Strategien zur Bewältigung aktueller Herausforderungen und zur Nutzung der Fähigkeiten von Llama 4 in verschiedenen Sektoren.

Zusammenfassend stellt Llama 4 einen bedeutenden Fortschritt in der KI-Sprachmodellierung dar und bietet erweiterte multimodale Funktionen und spezialisierte Architekturen. Trotz entwicklungsbedingter Herausforderungen positionieren Metas umfangreiche Investitionen und strategische Initiativen Llama 4 als ernstzunehmenden Konkurrenten in der sich entwickelnden KI-Landschaft.