KI in der Bildbearbeitung hat sich innerhalb von Monaten – nicht Jahren – vom lustigen Spielzeug zum echten Workflow-Tool entwickelt. Ob Sie Hintergründe entfernen, Gesichter austauschen, eine Figur über mehrere Aufnahmen hinweg beibehalten oder mehrstufige Kompositionen mit natürlichen Sprachanweisungen erstellen müssen – mehrere neue Modelle versprechen schnellere und weniger manuelle Korrekturen. In diesem Beitrag vergleiche ich drei der aktuell in aller Munde befindlichen Tools: OpenAIs GPT-Bild-1, Qwen-Image Edit, das virale Nano-Banane Modelle (Gemini-2.5-Flash-Image) und Flux Kontext. Ich gehe durch, worin jeder einzelne gut ist, wo er Schwächen hat, und gebe eine praktische Empfehlung, je nachdem, was Sie erreichen möchten.

Welche Kernkompetenzen definieren Exzellenz in der Bild-KI?

„Das Beste“ hängt von Ihren Anforderungen ab. Meine Bewertung basiert auf sieben praktischen Kriterien. Bevor wir einzelne Modelle analysieren, ist es wichtig, die grundlegenden Fähigkeiten zu verstehen, die herausragende KI-Lösungen für die Bilderzeugung und -bearbeitung ausmachen. Diese lassen sich grob in folgende Kategorien einteilen:

- Qualität und Wiedergabetreue der Generierung: Damit ist die Fähigkeit der KI gemeint, aus Textaufforderungen hochrealistische, ästhetisch ansprechende und stimmige Bilder zu erzeugen. Zu den Faktoren gehören Detailgenauigkeit, Beleuchtung, Komposition und das Fehlen von Artefakten oder Verzerrungen.

- Vielseitigkeit und Präzision beim Bearbeiten: Über die anfängliche Generierung hinaus sollte eine überlegene KI robuste Bearbeitungsfunktionen bieten. Dazu gehören Inpainting (Füllen fehlender Teile), Outpainting (Erweitern von Bildern), Entfernen/Hinzufügen von Objekten, Stilübertragung und präzise Kontrolle über bestimmte Elemente.

- Geschwindigkeit und Effizienz: Für professionelle Arbeitsabläufe ist die Zeit, die zum Erstellen oder Bearbeiten von Bildern benötigt wird, von größter Bedeutung. Eine schnellere Verarbeitung ohne Qualitätseinbußen ist ein wesentlicher Vorteil.

- Benutzererfahrung und Zugänglichkeit: Eine intuitive Benutzeroberfläche, klare Bedienelemente und eine einfache Integration in vorhandene Arbeitsabläufe sind für eine breite Akzeptanz und Benutzerzufriedenheit von entscheidender Bedeutung.

- Ethische Überlegungen und Sicherheitsmerkmale: Angesichts der zunehmenden Leistungsfähigkeit von KI sind eine verantwortungsvolle Entwicklung und Bereitstellung von entscheidender Bedeutung. Dazu gehören auch Schutzmaßnahmen gegen die Erstellung schädlicher oder voreingenommener Inhalte.

- Kosteneffizienz und Preismodelle: Während einige Tools kostenlose Stufen anbieten, ist es für preisbewusste Benutzer wichtig, die Preisstruktur für erweiterte Funktionen und die kommerzielle Nutzung zu verstehen.

- Konsistente mehrstufige Bearbeitungen – Beibehaltung der Identität/Objekte über mehrere Bearbeitungen oder Bilder hinweg.

Ich neige eher zum praktischen Denken: Ein Modell, das etwas weniger beeindruckende Bilder erzeugt, aber reproduzierbare, schnelle und zuverlässige Bearbeitungen ermöglicht, ist besser als ein auffälliges Modell, das viel Aufräumarbeit erfordert.

Welche Modelle kommen in Frage und was unterscheidet sie?

Schneller Modell-Schnappschuss

- gpt-image-1 (OpenAI) – ein nativ multimodales Modell, das im April 2025 für die API veröffentlicht wurde und die iterative Bildgenerierung und -bearbeitung innerhalb derselben multimodalen Responses/Images-API direkt unterstützt.

- Gemini 2.5 Flash-Bild (Google) – angekündigt am 26. August 2025 („Nano-Banane“); konzipiert für schnelle Generierung mit geringer Latenz und umfangreiche Bearbeitung (Mehrbildfusion, Zeichenkonsistenz); enthält SynthID-Wasserzeichen zur Herkunftsbestimmung.

- Qwen-Image-Edit (QwenLM / Alibaba-Gruppe) – eine Bildbearbeitungsversion von Qwen-Image (20B-Grundlage) mit Schwerpunkt auf zweisprachiger, präziser Textbearbeitung und kombinierter semantischer und optischer Bearbeitung.

- FLUX.1 Kontext (Flux / Black Forest Labs / Flux-Plattformvarianten) – Modellfamilie (Dev/Pro/Max) mit Schwerpunkt auf schneller, lokaler, kontextbezogener Bearbeitung mit Zeichenkonsistenz und iterativen Arbeitsabläufen.

Warum diese vier?

Sie decken die wichtigsten Designpunkte ab, nach denen Praktiker im Jahr 2025 fragen: multimodale Integration (OpenAI), Skalierung + Produktion plus Weltwissen (Google), Präzisionsbearbeitung und offene Forschung (Qwen) sowie iterative UX-First-Bearbeitung (Flux). Jeder dieser Punkte hat unterschiedliche Kompromisse hinsichtlich Kosten, Latenz und Stärken (Textwiedergabe, Multi-Image-Fusion, iterative Bearbeitung, Beibehaltung unveränderter Bereiche).

GPT-Image-1 (OpenAI) – die Schwerlastlösung für Entwickler

Was es ist: GPT-Image-1 von OpenAI ist ein natives multimodales Modell, das sowohl Text- als auch Bildeingaben akzeptiert und die Generierung und Bildbearbeitung (Inpainting, Bild-zu-Bild) über die Images API unterstützt. Es ist als produktionsreifes Modell für die Integration in Apps und Dienste konzipiert. Es ist als natives Text-Bild-Modell konzipiert, das Bildeingaben und Textaufforderungen akzeptiert und Bearbeitungen mit feiner Kontrolle durchführt.

Was sind die Stärken von GPT-image-1?

- Außergewöhnliches semantisches Verständnis: Eine der Hauptstärken von GPT-image-1 liegt in seiner Fähigkeit, nuancierte und ausführliche Texteingaben zu interpretieren. Nutzer können komplexe Szenen, bestimmte Stimmungen und abstrakte Konzepte mit bemerkenswerter Genauigkeit beschreiben, und die KI erzeugt häufig Bilder, die diese Beschreibungen getreu wiedergeben.

- Hochwertiger Fotorealismus: Bei der Erstellung realistischer Bilder liefert GPT-image-1 häufig verblüffend naturgetreue Ergebnisse mit beeindruckender Berücksichtigung von Texturen, Beleuchtung und natürlichen Kompositionen. Dies macht es zu einem hervorragenden Werkzeug für fotorealistisches Rendering und Konzeptkunst.

- Kreative Interpretation: GPT-image-1 geht über die bloße wörtliche Übersetzung hinaus und weist ein gewisses Maß an kreativer Interpretation auf. Oft werden subtile Details oder stilistische Schnörkel hinzugefügt, die die künstlerische Gesamtwirkung des generierten Bildes steigern. Dies kann insbesondere für die Ideenfindung und die Erforschung verschiedener visueller Konzepte von Vorteil sein.

- Starke Grundlage für Iteration: Seine Fähigkeit, hochwertige Erstkonzepte zu generieren, bietet einen hervorragenden Ausgangspunkt für weitere Verfeinerungen, entweder mit den Bearbeitungsfunktionen der KI (sofern verfügbar) oder mithilfe herkömmlicher Grafikdesignsoftware.

Was sind die Einschränkungen von GPT-image-1?

- Kontrolle über feine Details: Während KIs bei allgemeinen Konzepten hervorragend sind, kann die absolute Kontrolle auf Pixelebene oder die präzise Manipulation sehr kleiner Elemente manchmal eine Herausforderung darstellen. Dies ist eine häufige Hürde für viele generative KIs, bei denen die Ausgabe je nach Eingabeaufforderung teilweise deterministisch ist.

- Verfügbarkeit und Integration: Abhängig von der spezifischen Implementierung sind die direkten Bearbeitungsfunktionen von GPT-image-1 im Vergleich zu dedizierten Bildbearbeitungsplattformen möglicherweise weniger robust oder weniger integriert. Benutzer müssen möglicherweise exportieren und andere Tools für die intensive Bearbeitung nach der Generierung verwenden.

- Rechenanforderungen: Das Erstellen hochdetaillierter Bilder mit komplexen Eingabeaufforderungen kann rechenintensiv sein und möglicherweise zu längeren Verarbeitungszeiten führen als bei spezialisierteren, einfacheren Modellen für schnelle Bearbeitungen.

Nano Banana (Google / Gemini 2.5 Flash-Bild)

Was es ist: „Nano Banana“ ist der spielerische Name für Googles neuestes Gemini-Bild-Upgrade (Gemini 2.5 Flash Image). Es wird als Bildgenerator/-editor der nächsten Generation innerhalb des Gemini-Ökosystems von Google positioniert und für leistungsstärkere, differenziertere Bearbeitungen in mehreren Schritten und eine höhere Konsistenz bei der Fotobearbeitung vermarktet.

Wo glänzt Gemini-2.5-Flash-Image in der visuellen KI-Landschaft?

Gemini-2.5-Flash-Image, eine neuere Version, die auf Geschwindigkeit und Effizienz ausgelegt ist, ist Googles Kandidat und zielt auf ein Gleichgewicht zwischen hochwertiger Ausgabe und schneller Verarbeitung ab. Die Bezeichnung „Flash“ weist insbesondere auf die optimierte Architektur für schnellere Reaktionen hin und eignet sich daher hervorragend für Anwendungen, bei denen die Generierung und Bearbeitung in Echtzeit oder nahezu in Echtzeit entscheidend ist.

Was macht Gemini-2.5-Flash-Image zu einem starken Konkurrenten?

- Blitzschnelle Generation: Wie der Name schon sagt, ist Geschwindigkeit ein zentraler Vorteil. Gemini-2.5-Flash-Image zeichnet sich durch die schnelle Bilderzeugung aus, was für Kreativprofis mit engen Terminvorgaben oder für interaktive Anwendungen von unschätzbarem Wert ist.

- Solide Bildqualität: Trotz seiner Geschwindigkeit geht das Modell keine nennenswerten Kompromisse bei der Bildqualität ein. Es erzeugt kohärente, optisch ansprechende Bilder, die im Allgemeinen frei von größeren Artefakten sind, wodurch es in vielen Anwendungsfällen mit langsameren, ressourcenintensiveren Modellen konkurrenzfähig ist.

- Multimodales Verständnis: Durch die Nutzung des umfassenderen Gemini-Frameworks profitiert es häufig von einem erweiterten multimodalen Verständnis, d. h. es kann möglicherweise nicht nur Text, sondern auch andere Eingabeformen interpretieren, um die Bildgenerierung und -bearbeitung zu steuern, obwohl dies je nach spezifischer API unterschiedlich ist.

- Integrierte Bearbeitungsfunktionen: Gemini-2.5-Flash-Image verfügt normalerweise über integrierte Bearbeitungsfunktionen wie Inpainting (Ausfüllen fehlender Teile eines Bildes), Outpainting (Erweitern eines Bildes über seine ursprünglichen Grenzen hinaus) und Objektmanipulation, wodurch es eine umfassendere Lösung für End-to-End-Bild-Workflows darstellt.

Welche Bereiche sind für Gemini-2.5-Flash-Image verbesserungswürdig?

- Höchster Fotorealismus: Obwohl es gut ist, erreicht es möglicherweise nicht immer den absoluten Höhepunkt des Fotorealismus, der bei einigen der langsameren, größeren Modelle für hochkomplexe und nuancierte Szenen zu sehen ist. Es kann einen leichten Kompromiss zwischen Geschwindigkeit und ultimativer Wiedergabetreue geben.

- Künstlerische Nuancen für komplexe Stile: Bei sehr spezifischen Kunststilen oder extrem abstrakten Anfragen sind manche Benutzer möglicherweise der Meinung, dass es im Vergleich zu Modellen, die auf umfangreichen kunsthistorischen Datensätzen trainiert wurden, etwas weniger in der Lage ist, die subtilsten künstlerischen Nuancen zu erfassen.

- Kontrolle über generierten Text (innerhalb von Bildern): Wie bei vielen generativen Modellen kann es immer noch eine Herausforderung sein, innerhalb eines Bildes vollkommen zusammenhängenden und korrekt geschriebenen Text zu generieren.

Was ist Qwen-Image-Edit?

Was es ist: Qwen-Bildbearbeitung (Alibaba / Qwen-Team) – Bildbearbeitungsmodell basierend auf der Qwen-Image-Familie; verspricht leistungsstarke zweisprachige Textbearbeitung (Chinesisch und Englisch), semantische und Erscheinungsbildkontrolle sowie direkte Bildbearbeitungstreue.

Was sind die einzigartigen Stärken von Qwen-Image Edit?

- Überlegene Bearbeitungspräzision: Qwen-Image Edit verfügt häufig über fortschrittliche Algorithmen zum Inpainting, Outpainting und zur Objektmanipulation, die hochpräzise und nahtlose Bearbeitungen ermöglichen. Es zeichnet sich durch die Beibehaltung der visuellen Kohärenz auch bei erheblichen Änderungen aus.

- Kontextbewusste Bearbeitung: Eine wesentliche Stärke ist die Kontextsensitivität. Beim Entfernen eines Objekts füllt es beispielsweise die Lücke intelligent mit Inhalt, der sich logisch in die Umgebung einfügt, sodass die Bearbeitung praktisch nicht erkennbar ist.

- Stiltransfer und Harmonisierung: Qwen-Image Edit kann sehr effektiv sein, um Stile von einem Bild auf ein anderes zu übertragen oder verschiedene Elemente innerhalb eines Bildes zu harmonisieren, um ein einheitliches Erscheinungsbild zu schaffen. Dies ist von unschätzbarem Wert für Designer, die mit unterschiedlichen visuellen Elementen arbeiten.

- Robustes Entfernen/Hinzufügen von Objekten: Seine Fähigkeit, Objekte hinzuzufügen oder zu entfernen und dabei Beleuchtung, Schatten und Perspektive beizubehalten, ist äußerst beeindruckend und ermöglicht komplexe Szenenrekonstruktionen oder das Aufräumen.

- Bildskalierung und -verbesserung: Enthält häufig erweiterte Funktionen zum Hochskalieren von Bildern ohne Qualitätsverlust und zur Verbesserung von Details, Farben und der allgemeinen visuellen Attraktivität.

Was sind die potenziellen Schwächen von Qwen-Image Edit?

- Fokus der ersten Generation: Obwohl es Bilder generieren kann, liegen seine Hauptstärke und Optimierung oft in der Bearbeitung. Die anfängliche Text-zu-Bild-Generierung mag gut sein, ist aber je nach Version möglicherweise nicht so kreativ vielfältig oder fotorealistisch wie Modelle, die sich ausschließlich auf die Generierung konzentrieren.

- Lernkurve für erweiterte Funktionen: Die Präzision und Tiefe der Bearbeitungswerkzeuge erfordern für Benutzer, die mit fortgeschrittenen Konzepten der Bildbearbeitung nicht vertraut sind, möglicherweise eine etwas steilere Lernkurve.

- Ressourcenintensität für komplexe Bearbeitungen: Hochkomplexe, mehrschichtige Bearbeitungen können dennoch rechenintensiv sein, was bei sehr großen oder komplizierten Aufgaben möglicherweise zu längeren Verarbeitungszeiten führt.

Welche Innovationen bringt Flux Kontext in die Bild-KI?

Was es ist: Flux's Kontext (manchmal auch als FLUX.1 Kontext vermarktet) ist ein Bildbearbeitungs- und -generierungstool für Designer und Markenteams. Es betont kontextsensitive Bearbeitung, präzise Typografie, Stilübertragungen und straffe UI/UX für iterative Designarbeit.

Was sind die Stärken von Flux Kontext?

- Kontextueller Zusammenhalt: Die größte Stärke von Flux Kontext liegt in der Fähigkeit, den Kontext über mehrere Bildgenerationen oder Bearbeitungen hinweg zu verstehen und beizubehalten. Dies ist von unschätzbarem Wert für die Erstellung konsistenter visueller Erzählungen, Charakterdesigns oder Produktlinien, bei denen visuelle Harmonie unerlässlich ist.

- Verbesserte Konsistenz in der Serie: Wenn Sie eine Reihe von Bildern erstellen müssen, die einen gemeinsamen Stil, Charakter oder eine gemeinsame Umgebung aufweisen, zielt Flux Kontext darauf ab, Inkonsistenzen zu reduzieren, die bei anderen Modellen auftreten können.

- Adaptives Styling: Es kann seine Ausgabe basierend auf zuvor generierten Bildern oder einem definierten Styleguide anpassen, was zu einem rationaleren und weniger iterativen kreativen Prozess führt.

- Spezialisiert auf Marke und Narrative: Besonders vorteilhaft für Marketing, Branding und Storytelling, wo eine einheitliche visuelle Identität entscheidend ist.

- Schnelles Verständnis im Kontext: Beim sofortigen Verständnis geht es nicht nur um das aktuelle Bild, sondern auch darum, wie es in einen größeren Kontext oder Befehlssatz passt.

Was sind die Einschränkungen von Flux Kontext?

- Potenzial für Nischenfokus: Die Betonung von Kontext und Konsistenz könnte bedeuten, dass es nicht immer der absolute Spitzenreiter in Sachen rohem, eigenständigem Fotorealismus oder extremer künstlerischer Vielfalt ist, wenn das die einzige Anforderung ist.

- Weniger öffentlich dokumentierte Benchmarks: Für Sie als neueren oder spezialisierteren Akteur stehen Ihnen möglicherweise weniger umfangreiche öffentliche Benchmark-Daten zur Verfügung als für etabliertere Modelle.

- Abhängig von klarer kontextbezogener Eingabe: Um seine Stärken zu nutzen, müssen Benutzer klare Kontextinformationen bereitstellen oder den narrativen Rahmen effektiv definieren, was möglicherweise einen anderen Eingabeaufforderungsansatz erfordert.

Welches Modell eignet sich am besten zur Bildbearbeitung?

Für Singles, präzise maskenlose Bearbeitungen kombiniert mit einem nachhaltigen Materialprofil. Textbearbeitung in Bildern, Qwen-Bild-Bearbeiten kombiniert mit einem nachhaltigen Materialprofil. Gemini 2.5 Flash-Image (und spezialisierte Modelle wie FLUX.1 Kontext) gehören zu den stärksten. Für komplexe mehrstufige verkettete BearbeitungenDie Kombination eines befehlsstarken LLM-Frontends (Gemini- oder GPT-Varianten) mit einem Bildmodell führt häufig zum besten Ergebnis. Einige Benchmark-Arbeiten haben gezeigt, dass die Eingabeaufforderung im Chain-of-Thought-Stil (Gemini-CoT) den Erfolg bei der Bearbeitung in mehreren Schritten verbessert.

lokale Bearbeitungen, Zeichenkonsistenz, Textverarbeitung

- Qwen-Bild-Bearbeiten zielt ausdrücklich auf beide semantisch kombiniert mit einem nachhaltigen Materialprofil. Aussehen Bearbeitungen – z. B. Objekt ersetzen, drehen, präziser Textersatz – explizit als Bildbearbeitung Modell mit dualen Pfaden (semantische Kontrolle über Qwen2.5-VL + Darstellungskontrolle über VAE-Encoder). Es wirbt für robuste Zweisprachigkeit (Chinesisch/Englisch) Textbearbeitungen in Bildern (z. B. Schildertext oder Produktetiketten ändern) und dabei den Stil beibehalten, was bei Lokalisierungs- und Verpackungsarbeiten selten und wertvoll ist.

- Gemini 2.5 Flash-Image unterstützt maskierte Bearbeitungen, prompt-gesteuerte lokale Modifikationen (Hintergrund verwischen, Person entfernen, Pose ändern) und Multi-Image-Fusion. Google wirbt mit prompt-basierten, regionsabhängigen Bearbeitungen und Weltwissensvorteilen (z. B. bessere Semantik realer Objekte). Das Modell fügt außerdem eine unsichtbares SynthID-Wasserzeichen zu generierten/bearbeiteten Bildern, um die Herkunft und Erkennung zu unterstützen.

- FLUX.1 Kontext: positioniert sich als Bild-zu-Bild-Kontextlöser – optimiert für präzise, kontextsensitive lokale Bearbeitungen und iteratives Experimentieren. Tester loben die Fähigkeit, Kontext und Szenensemantik bei lokalen Änderungen zu bewahren. FLUX.1 Kontext und Flux Kontext UI wurden in direkten Praxistests für iterative Bearbeitungsabläufe und Textlesbarkeit gelobt und sind daher eine praktische Wahl für Arbeitsabläufe, die viele schnelle Iterationen erfordern (Marketing-Assets, Miniaturansichten).

- GPT-Bild-1: unterstützt Bearbeitungsvorgänge (Text- und Bildaufforderungen für Bearbeitungen) und die Tools von OpenAI integrieren Verkettungs- und Prompt-Engineering-Muster. Die Leistung ist stark, hängt jedoch vom Prompt-Engineering ab und kann bei der feinkörnigen Bearbeitung (z. B. exakter zweisprachiger Textersetzung) in einigen Tests hinter spezialisierten Edit-First-Modellen zurückbleiben.

Benchmarks wie ComplexBench-Bearbeiten kombiniert mit einem nachhaltigen Materialprofil. CompBench zeigen, dass viele Modelle immer noch fehlschlagen, wenn Bearbeitungen verkettet oder voneinander abhängig sind, dass aber die Kombination eines LLM zur Befehlsanalyse mit einem robusten Bildmodell (LLM→Bildmodell-Orchestrierung) oder die Verwendung von CoT-Eingabeaufforderungen Fehler reduzieren kann. Aus diesem Grund fügen einige Produktions-Workflows Modelle für harte Bearbeitungen zusammen (z. B. ein Reasoning-LLM plus ein Bildgenerator).

Wer kann am besten Text in Bildern bearbeiten?

- Qwen-Bild-Bearbeiten wurde speziell für die präzise zweisprachige (Chinesisch + Englisch) Textbearbeitung entwickelt und liefert hervorragende Ergebnisse in Textbearbeitungs-Benchmarks (öffentliche technische Hinweise und gemeldete Ergebnisse von Qwen). Open-Source-Qwen-Artefakte und -Demos zeigen die genaue Beibehaltung von Schriftart, -größe und -stil während der Bearbeitung.

- gpt-Bild-1 kombiniert mit einem nachhaltigen Materialprofil. Gemini 2.5 Flash-Image beide machen Fortschritte bei der Textwiedergabe, aber akademische Benchmarks und Hinweise des Anbieters weisen darauf hin, dass bei kleinen/detaillierten Texten und langen Textpassagen noch Herausforderungen bestehen – Verbesserungen erfolgen schrittweise und variieren je nach Eingabeaufforderung und Auflösung.

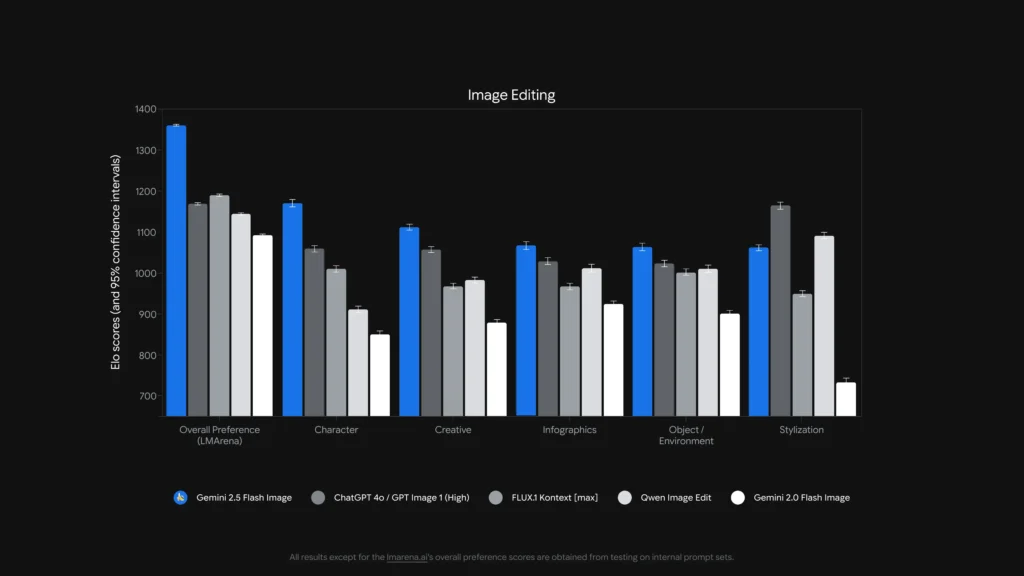

Vergleichende Analyse: Feature, Bearbeitung

Um ein klareres Bild zu vermitteln, fassen wir die wichtigsten Aspekte dieser führenden KI-Modelle in einer Vergleichstabelle zusammen.

| Funktion/Fähigkeit | GPT-Bild-1 (OpenAI) | Gemini-2.5-Flash-Image (Google) | Qwen-Bildbearbeitung (Alibaba) | FLUX.1 Kontext |

|---|---|---|---|---|

| Native Generierung + Bearbeiten | Ja. Multimodaler Text+Bild in einer API. | Ja – native Generierung und gezielte Bearbeitung; Schwerpunkt auf Multi-Image-Fusion und Zeichenkonsistenz. | Konzentriert auf Bearbeitung (Qwen-Image-Edit) mit semantischer + Erscheinungsbildkontrolle. | Konzentriert sich auf Bild-zu-Bild-Bearbeitungen mit hoher Wiedergabetreue. |

| Bearbeitungstiefe (lokale Anpassungen) | Hoch (aber generalistisch) | Sehr hoch (gezielte Eingabeaufforderungen + maskenlose Bearbeitungen) | Sehr hoch für semantische/Textbearbeitungen (zweisprachige Textunterstützung). | Sehr hoch – kontextsensitive Bearbeitungspipelines. |

| Text-in-Bild-Behandlung | Gut, hängt von der Eingabeaufforderung ab | Verbessert (Anbieter zeigt Demos zur Vorlagen- und Schilderbearbeitung) | Die besten kostenlosen darunter für zweisprachig lesbare Textänderungen. | Stark für die Erhaltung des Stils; die Lesbarkeit hängt von der Eingabeaufforderung ab. |

| Zeichen-/Objektkonsistenz | Gut mit vorsichtiger Anleitung | Strong Pilates (explizite Funktion) | Mittel (der Schwerpunkt liegt eher auf der Bearbeitung als auf der Identität mehrerer Bilder) | Stark durch iterative Bearbeitungsabläufe. |

| Latenz/Durchsatz | Moderat | Geringe Latenz / hoher Durchsatz (Flash-Modell) | Variiert je nach Hosting (lokal/HF vs. Cloud) | Entwickelt für schnelle iterative Bearbeitungen in gehostetem SaaS. |

| Provenienz / Wasserzeichen | Kein obligatorisches Wasserzeichen (Richtlinienmechanismen) | Unsichtbares SynthID-Wasserzeichen für Bilder. | Hängt vom Host ab | Hängt vom Host ab |

Anmerkungen: „Bearbeitungstiefe“ misst, wie feinkörnig und zuverlässig lokale Bearbeitungen in der Praxis sind; „Textverarbeitung“ bewertet die Fähigkeit, lesbaren Text in Bildern zu platzieren/ändern

Wie steht es um Latenz, Entwicklerergonomie und Unternehmensintegration?

Latenz- und Bereitstellungsoptionen

- Gemini 2.5 Flash-Image betont Low Latency und ist über die Gemini API, Google AI Studio und Vertex AI verfügbar – eine gute Wahl für Unternehmensanwendungen, die einen vorhersehbaren Durchsatz und Cloud-Integration benötigen. Google gibt auch ungefähre Token-Preise pro Bild an (und der Entwicklerblog enthält ein Beispiel für die Preise pro Bild).

- gpt-Bild-1 ist über die OpenAI Images API verfügbar und verfügt über eine breite Ökosystemintegration (Playground, Partner wie Adobe/Canva). Die Preise sind tokenisiert und variieren je nach Bildqualitätsstufe (OpenAI veröffentlicht Token-zu-Dollar-Umrechnungen).

- Flux Kontext konzentriert sich auf eine schnelle interaktive UX und bietet Credits + kurze Bearbeitungszeiten pro Produktdemo – praktisch für Designer und schnelle Iteration. Qwen bietet offene Artefakte und Forschungszugriff (ideal, wenn Sie selbst hosten oder interne Komponenten überprüfen möchten).

Wie viel kosten diese Dienste – was ist das bessere Preis-Leistungs-Verhältnis?

Die Preise ändern sich häufig. Nachfolgend finden Sie die vom Herausgeber angegebenen Zahlen (August 2025) und repräsentative Kostenberechnungen pro Bild, sofern die Anbieter sie veröffentlicht haben.

Veröffentlichte Preise (Lieferantenaussagen)

| Modell / Anbieter | Öffentliche Preisübersicht (veröffentlicht) | Grobe Schätzung pro Bild |

|---|---|---|

| gpt-image-1 (OpenAI) | Tokenisierte Preisgestaltung (Texteingabe 5 $ / 1M, Bildeingabe 10 $ / 1M, Bildausgabe 40 $ / 1M). OpenAI weist darauf hin, dass dies ungefähr $ $ 0.02 0.19- pro generiertem Bild, abhängig von Qualität/Größe. | ~0.02 $ (niedrige Qualität/Miniaturansicht) → ~0.19 $ (Quadrat mit hoher Qualität) |

| Gemini 2.5 Flash-Bild (Google) | 30 $ pro 1 Mio. Ausgabetoken und Beispiel: jedes Bild ≈ 1290 Ausgabetoken (~$0.039 pro Bild) laut Entwicklerblog. Preisgestaltung erfolgt über Gemini API / Vertex. | ~$0.039 pro Bild (Google-Beispiel) |

| Flux Kontext (Flux) | Kostenlose Stufe mit Credits; Flux-Produktseiten zeigen 10 kostenlose Kredite und typische Bearbeitungen zum Preis von 5 Kredite; Abonnementstufen für Vielnutzer verfügbar. (Produktseite des Anbieters). | Sehr niedrige Kosten für gelegentliche Bearbeitungen; Abonnement für intensive Nutzung. |

| Qwen-Bildbearbeitung (QwenLM) | Open Release und GitHub-Artefakte – offener Zugang für Forschungszwecke mit kostenlosen Beispielen; kommerzielle Bereitstellungen variieren je nach Integrator (selbst gehostet vs. Cloud). Kein einheitlicher kanonischer Preis pro Bild; bei selbst gehostetem System ist der Preis tendenziell am niedrigsten. |

Wertinterpretation: Wenn Sie ein Bild mit hohem Volumen benötigen Generation Wenn Sie in der Produktion sind und vorhersehbare Preise pro Bild wünschen, ist Googles Beispiel pro Bild äußerst wettbewerbsfähig. Wenn Ihre Kosten durch menschliche Bearbeitung oder iterative Designerzeit dominiert werden, sind Flux oder die lokale Ausführung von Qwen möglicherweise wirtschaftlicher. OpenAI bietet ein breites SDK-Ökosystem und viele Partner, sodass sich die höhere Stufe aufgrund der Integrationsfreundlichkeit lohnt.

Preis in CometAPI

| Modell | GPT-Bild-1 | Gemini-2.5-Flash-Image | FLUX.1 Kontext |

| Preis | Eingabe-Token 8.00 $; Ausgabe-Token 32.00 $ | $0.03120 | Flux Kontext Pro: 0.09600 $ flux-kontext-max: $0.19200 |

Praktische Kurztipps für optimale Ergebnisse

Eingabeaufforderungen und Tipps zum Arbeitsablauf (gilt für alle Modelle)

- Seien Sie explizit bezüglich der Komposition: Kamerawinkel, Beleuchtung, Stimmung, Brennweite, Objektiv und die räumlichen Beziehungen zwischen Objekten. Beispiel: „35-mm-Nahaufnahme, geringe Tiefenschärfe, Motiv zentriert, weiches Randlicht von oben links.“

- Verwenden Sie iterative Verfeinerung für Bearbeitungen: Nehmen Sie zunächst grobe Strukturänderungen vor und verfeinern Sie anschließend Textur und Beleuchtung. Modelle wie FLUX und Gemini unterstützen mehrstufige Verfeinerungen.

- Für Text in Bildern: Geben Sie den genauen gewünschten Text ein und fügen Sie „als kontrastreiches, lesbares Schild mit realistischer Prägung rendern“ hinzu – verwenden Sie für zweisprachige Bearbeitungen Qwen-Image-Edit, wenn Sie eine Wiedergabetreue zwischen Chinesisch und Englisch benötigen.

- Verwenden Sie Referenzbilder: Stellen Sie für Charakterkonsistenz oder Produktvarianten hochwertige Referenzbilder und Ankeraufforderungen wie „Passen Sie die Gesichtszüge, Kostümfarbe und Beleuchtung der Figur in Referenz_01 an.“ bereit. Gemini und Flux legen Wert auf die Fusion/Konsistenz mehrerer Bilder.

- Bearbeitungen mit Maskierung vs. ohne Maskierung: Wenn möglich, verwenden Sie eine Maske, um Bearbeitungen eng zu begrenzen. Bei maskenloser Bearbeitung ist mit gelegentlichem Überlauf zu rechnen. Modelle variieren: Flux/Gemini kommen mit maskenloser Bearbeitung gut zurecht, aber eine Maske ist trotzdem hilfreich.

- Nutzen Sie GPT-Bild / GPT-4o für komplexe Kompositionsanweisungen mit mehreren Objekten, Anzahlen und räumlichen Einschränkungen. Verwenden Sie nach Möglichkeit eine einzige, genaue Anweisung pro Generation.

Tipps zu Kosten und Latenz

Batching: Verwenden Sie Batch-APIs oder Cloud-Funktionen, um effizient viele Varianten zu generieren. Gemini-2.5-Flash ist für den Durchsatz optimiert, wenn Sie ein hohes Volumen benötigen.

Qualität und Preis im Vergleich: OpenAI stellt niedrige/mittlere/hohe Bildebenen bereit; erstellen Sie Rohentwürfe in niedriger Qualität und finalisieren Sie sie in hoher Qualität.

abschließendes Urteil

- Am besten für Produktion und Integration: GPT-Bild-1 – am besten geeignet für API-Anforderungen, Compositing und Integration in professionelle Tools.

- Am besten für fotorealistische Konsistenz beim Verbraucher: Nano-Banane – Das Gemini-Bild-Upgrade von Google glänzt durch natürliche, sequenzielle Porträtbearbeitungen und eine zugängliche UX.

- Beste mobile/Editor-Erfahrung: Flux Kontext – großartige Gesprächsbearbeitungen am Telefon mit geringer Reibung.

- Wenn Sie an chirurgischen Textbearbeitungen und zwei-/mehrsprachiger Bearbeitung messen, ist Qwen-Image-Edit** der Top-Spezialist und eine ausgezeichnete Wahl, wenn es auf Textgenauigkeit in Bildern ankommt.

Erste Schritte

CometAPI ist eine einheitliche API-Plattform, die über 500 KI-Modelle führender Anbieter – wie die GPT-Reihe von OpenAI, Gemini von Google, Claude von Anthropic, Midjourney, Suno und weitere – in einer einzigen, entwicklerfreundlichen Oberfläche vereint. Durch konsistente Authentifizierung, Anforderungsformatierung und Antwortverarbeitung vereinfacht CometAPI die Integration von KI-Funktionen in Ihre Anwendungen erheblich. Ob Sie Chatbots, Bildgeneratoren, Musikkomponisten oder datengesteuerte Analyse-Pipelines entwickeln – CometAPI ermöglicht Ihnen schnellere Iterationen, Kostenkontrolle und Herstellerunabhängigkeit – und gleichzeitig die neuesten Erkenntnisse des KI-Ökosystems zu nutzen.

Entwickler können zugreifen GPT-Bild-1, FLUX.1 Kontext kombiniert mit einem nachhaltigen Materialprofil. Gemini 2.5 Flash-Image Über CometAPI sind die neuesten Modellversionen zum Veröffentlichungsdatum des Artikels aufgeführt. Erkunden Sie zunächst die Funktionen des Modells im Spielplatz und konsultieren Sie die API-Leitfaden Für detaillierte Anweisungen. Stellen Sie vor dem Zugriff sicher, dass Sie sich bei CometAPI angemeldet und den API-Schlüssel erhalten haben. CometAPI bieten einen Preis weit unter dem offiziellen Preis an, um Ihnen bei der Integration zu helfen.

Die neueste Integration Qwen-Bild-Bearbeiten wird bald auf CometAPI erscheinen, also bleiben Sie dran! Bereit, mit der Bildbearbeitung zu beginnen? → Melden Sie sich noch heute für CometAPI an !

Preis in CometAPI

| Modell | GPT-Bild-1 | Gemini-2.5-Flash-Image | FLUX.1 Kontext |

| Preis | Eingabe-Token 8.00 $; Ausgabe-Token 32.00 $ | $0.03120 | Flux Kontext Pro: 0.09600 $ flux-kontext-max: $0.19200 |