La Inteligencia Artificial (IA) ha revolucionado numerosas industrias, y una de sus aplicaciones más fascinantes es la generación de imágenes. Desde la creación de rostros humanos realistas hasta la producción de obras de arte surrealistas, la capacidad de generar imágenes mediante IA ha abierto nuevos caminos en el arte, el diseño y la tecnología. Este artículo profundiza en los mecanismos que subyacen a las imágenes generadas por IA, los modelos que las impulsan y las implicaciones más amplias de esta tecnología.

Comprender los conceptos básicos: ¿cómo funciona la generación de imágenes con IA?

¿Qué son los modelos generativos?

Los modelos generativos son una clase de algoritmos de IA que pueden crear nuevas instancias de datos similares a los datos de entrenamiento. En el contexto de la generación de imágenes, estos modelos aprenden patrones de imágenes existentes y utilizan este conocimiento para producir nuevas imágenes similares.

El papel de las redes neuronales

En el corazón de la generación de imágenes con IA se encuentran las redes neuronales, en particular los modelos de aprendizaje profundo como las redes neuronales convolucionales (CNN). Las CNN están diseñadas para procesar datos con una topología de cuadrícula, lo que las hace ideales para el análisis y la generación de imágenes. Funcionan detectando patrones como bordes, texturas y formas, esenciales para comprender y recrear imágenes.

Modelos de IA clave en la generación de imágenes de IA

Redes Adversarias Generativas (GAN)

Introducidas por Ian Goodfellow en 2014, las GAN constan de dos redes neuronales: un generador y un discriminador. El generador crea imágenes, mientras que el discriminador las evalúa comparándolas con imágenes reales. Mediante este proceso antagónico, el generador mejora su salida para producir imágenes cada vez más realistas.

EstiloGAN

Desarrollado por NVIDIA, StyleGAN es una variante de GAN conocida por generar rostros humanos de alta calidad. Introduce una arquitectura de generador basada en estilos, que permite controlar diferentes niveles de detalle en la imagen. StyleGAN2 y StyleGAN3 mejoraron aún más la calidad de la imagen y solucionaron problemas como la adherencia de texturas.

Modelos de difusión

Los modelos de difusión generan imágenes partiendo de ruido aleatorio y refinándolo gradualmente para obtener el resultado deseado. Han ganado popularidad gracias a su capacidad para producir imágenes de alta calidad y su flexibilidad en diversas aplicaciones.

Difusión estable

Stable Diffusion es un modelo de difusión de código abierto que permite la generación de texto a imagen. También permite la superposición de imágenes, lo que permite la edición y extensión de imágenes. Su código abierto lo ha hecho ampliamente accesible para desarrolladores y artistas.

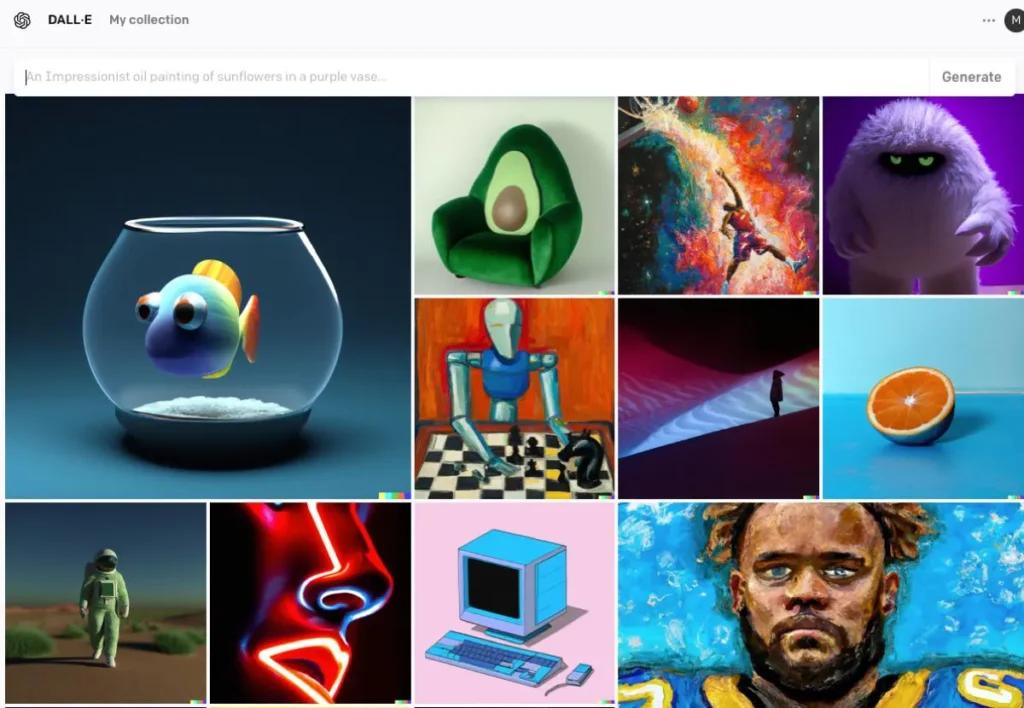

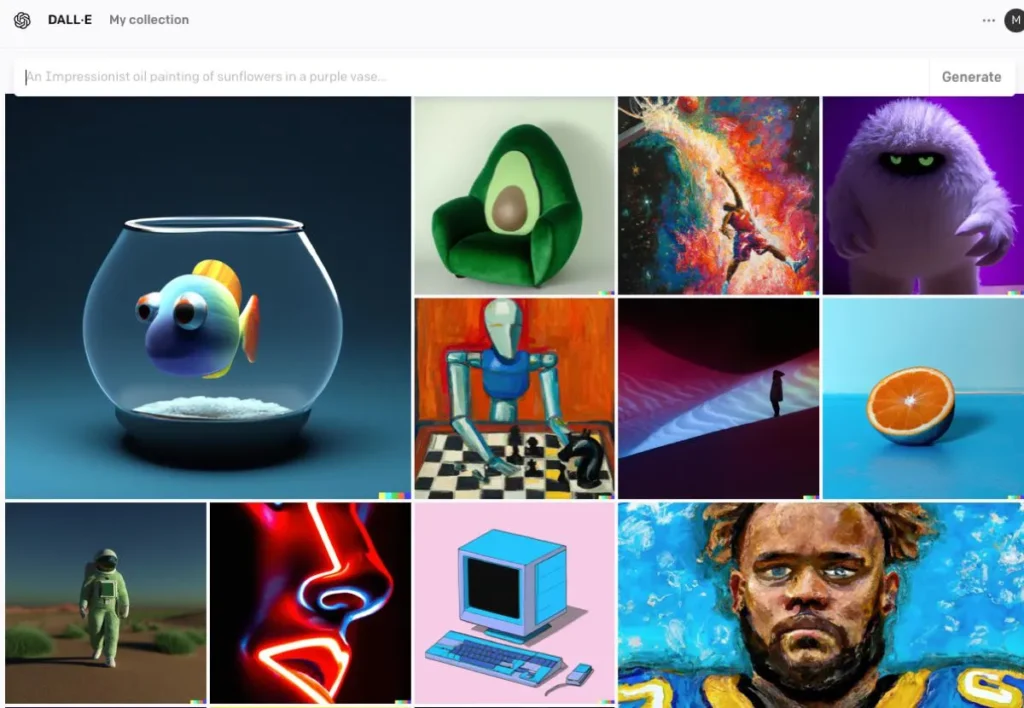

DALL · E

Desarrollado por OpenAI, DALL·E es un modelo basado en transformadores capaz de generar imágenes a partir de descripciones textuales. DALL·E 2 y DALL·E 3 han mejorado el original, ofreciendo mayor resolución y una alineación imagen-texto más precisa. DALL·E 3 está integrado en ChatGPT para una mejor interacción del usuario.

El proceso de generación de imágenes de IA

Entrenando el modelo

Los modelos de IA requieren un entrenamiento exhaustivo con grandes conjuntos de datos de imágenes. Durante el entrenamiento, el modelo aprende a reconocer patrones y características dentro de las imágenes, lo que le permite generar nuevas imágenes que imitan los datos de entrenamiento.

Generando nuevas imágenes

Una vez entrenado, el modelo puede generar nuevas imágenes mediante:

- Recepción de entrada:Esto podría ser ruido aleatorio (en GAN), un mensaje de texto (en DALL·E) o una imagen existente (para edición). Este paso captura el significado semántico del texto, lo que permite que la IA comprenda el contenido y el contexto.

- Procesamiento de entradaEl modelo procesa la entrada a través de las capas de su red neuronal, aplicando patrones y características aprendidos. A partir del texto codificado, la IA emplea modelos como las Redes Generativas Antagónicas (GAN) o modelos de difusión para crear imágenes. Estos modelos generan imágenes partiendo de ruido aleatorio y refinándolo para que coincida con la descripción textual.

- Refinamiento y EvaluaciónLa imagen generada se refina mediante mecanismos de atención para garantizar la coherencia con el texto. Un modelo discriminador evalúa el realismo y la coherencia de la imagen con la entrada, proporcionando retroalimentación para un mayor refinamiento.

- Salida de imagen:El resultado final es una nueva imagen que refleja las características de los datos de entrenamiento y la entrada específica proporcionada.

Ejemplo de código de generación de imágenes de IA

Aquí se presentan ejemplos prácticos de código Python que demuestran cómo generar imágenes utilizando tres modelos de IA destacados: redes generativas antagónicas (GAN), difusión estable y DALL·E.

Redes generativas antagónicas (GAN) con PyTorch

Las Redes Generativas Antagónicas (GAN) constan de dos redes neuronales (el Generador y el Discriminador) que compiten entre sí para generar nuevas instancias de datos realistas. A continuación, se muestra un ejemplo simplificado con PyTorch para generar imágenes:

pythonimport torch

import torch.nn as nn

# Define the Generator network

class Generator(nn.Module):

def __init__(self):

super(Generator, self).__init__()

self.fc1 = nn.Linear(100, 128)

self.fc2 = nn.Linear(128, 784) # Assuming output image size is 28x28

def forward(self, x):

x = torch.relu(self.fc1(x))

x = torch.tanh(self.fc2(x))

return x

# Instantiate the generator

generator = Generator()

# Generate a random noise vector

noise = torch.randn(1, 100)

# Generate an image

generated_image = generator(noise)

Este código define una red generadora simple que toma un vector de ruido de 100 dimensiones como entrada y produce una salida de 784 dimensiones, que se puede transformar en una imagen de 28×28. tanh La función de activación garantiza que los valores de salida estén en el rango , que es común para los datos de imagen.

Difusión estable con difusores que se adaptan al rostro

Stable Diffusion es un potente modelo de texto a imagen que genera imágenes basadas en descripciones textuales. La cara abrazada. diffusers La biblioteca proporciona una interfaz sencilla para utilizar este modelo:

pythonfrom diffusers import StableDiffusionPipeline

import torch

# Load the pre-trained Stable Diffusion model

pipe = StableDiffusionPipeline.from_pretrained("CompVis/stable-diffusion-v1-4")

pipe = pipe.to("cuda") # Move the model to GPU for faster inference

# Generate an image from a text prompt

prompt = "A serene landscape with mountains and a river"

image = pipe(prompt).images

# Save the generated image

image.save("generated_image.png")

Este script carga el modelo de Difusión Estable y genera una imagen según la solicitud. Asegúrese de tener instaladas las dependencias necesarias y una GPU compatible para un rendimiento óptimo.

DALL·E con API OpenAI

DALL·E es otro modelo de texto a imagen desarrollado por OpenAI. Puedes interactuar con él mediante la API de OpenAI:

pythonimport openai

import requests

from PIL import Image

from io import BytesIO

# Set your OpenAI API key

openai.api_key = "your-api-key"

# Generate an image using DALL·E

response = openai.Image.create(

prompt="A futuristic cityscape at sunset",

n=1,

size="512x512"

)

# Get the URL of the generated image

image_url = response

# Download and display the image

image_response = requests.get(image_url)

image = Image.open(BytesIO(image_response.content))

image.save("dalle_generated_image.png")

Reemplace "your-api-key" Con su clave API de OpenAI. Este script envía un mensaje al modelo DALL·E y recupera la imagen generada. Esta se guarda localmente.

CometAPI también integra API DALL-E 3, también puedes usar la clave de CometAPI para acceder API DALL-E 3, que es más conveniente y rápido que OpenAI.

Para obtener más información sobre el modelo en Comet API, consulte Documento API.

Estos ejemplos ofrecen un punto de partida para generar imágenes con diferentes modelos de IA. Cada modelo tiene sus propias capacidades y requisitos, así que elija el que mejor se adapte a las necesidades de su proyecto.

Conclusión

La generación de imágenes mediante IA se sitúa en la intersección de la tecnología y la creatividad, ofreciendo posibilidades sin precedentes en la creación de contenido visual. Comprender cómo la IA genera imágenes, los modelos involucrados y las implicaciones de esta tecnología es esencial para integrarla en diversos aspectos de la sociedad.

Acceda a la API de imágenes de IA en CometAPI

CometAPI proporciona acceso a más de 500 modelos de IA, incluyendo modelos multimodales de código abierto y especializados para chat, imágenes, código y más. Su principal ventaja radica en simplificar el proceso, tradicionalmente complejo, de integración de IA. Con CometAPI, se puede acceder a herramientas de IA líderes como Claude, OpenAI, Deepseek y Gemini mediante una única suscripción unificada. Puedes usar la API de CometAPI para crear música y material gráfico, generar vídeos y crear tus propios flujos de trabajo.

CometAPI Ofrecemos un precio mucho más bajo que el precio oficial para ayudarte a integrarte API GPT-4o ,API de viaje a mitad de camino API de difusión estable (API de difusión estable XL 1.0) y API de Flux(API FLUX.1 etc) ¡y recibirás $1 en tu cuenta después de registrarte e iniciar sesión!

CometAPI integra lo último API de imágenes GPT-4o .